L'apprentissage automatique et les réseaux de neurones profonds sont capables de reconnaître et d'analyser le «langage du comportement» des animaux d'une manière qui dépasse les capacités humaines

Pour suivre les mouvements des animaux dans l'environnement naturel, les scientifiques se tournent de plus en plus vers les méthodes d'apprentissage automatique (MO). Dans cette vidéo, l'algorithme DeepPoseKit suit le mouvement et l'orientation d'un criquet pèlerin dans un espace confiné pour fournir aux chercheurs des données sur le comportement conjoint des insectes.

Pour suivre les mouvements des animaux dans l'environnement naturel, les scientifiques se tournent de plus en plus vers les méthodes d'apprentissage automatique (MO). Dans cette vidéo, l'algorithme DeepPoseKit suit le mouvement et l'orientation d'un criquet pèlerin dans un espace confiné pour fournir aux chercheurs des données sur le comportement conjoint des insectes.Pour tenter de comprendre ce qui se passe dans la tête des animaux, les neuroscientifiques ont été envoyés de manière inattendue: de regarder directement dans le cerveau vivant pour contrôler les neurones à l'aide de flashs lumineux, créer des appareils complexes et des environnements virtuels.

En 2013, cela a conduit le neuroscientifique

Bob Dattu, ainsi que des collègues de la Harvard Medical School, au supermarché Best Buy, situé dans la même rue que leur laboratoire.

Dans le magasin d'électronique grand public, ils ont trouvé ce qu'ils recherchaient: la Xbox Kinect, un appareil de jeu qui détecte les mouvements des joueurs. Les scientifiques devaient observer les moindres détails des mouvements des souris qu'ils étudiaient, mais aucune des technologies de laboratoire traditionnelles ne pouvait y faire face. Par conséquent, le groupe de Datta s'est tourné vers le jouet afin d'utiliser ses informations en trois dimensions sur les mouvements du corps des animaux pour étudier leur comportement dans l'environnement. Le dispositif leur a en effet donné un nuage de points dans l'espace tridimensionnel, et l'équipe a ensuite analysé les mouvements rythmiques de ces points.

La décision de Datta était peut-être peu orthodoxe à l'époque, mais elle est devenue symbolique de la vague actuelle d'approche automatique transformant la science du comportement. En étudiant le comportement animal de manière plus approfondie et quantitative, les chercheurs espèrent mieux comprendre les états internes non observables qui en sont responsables. "Nous ne savons pas dans quelles conditions potentielles l'animal peut se trouver", a écrit

Adam Calhoun , un post-doctorant étudiant le comportement animal à l'Université de Princeton.

Un autre obstacle se pose lorsque l'on tente de comparer ces états internes d'une activité spécifique dans les circuits neuronaux complexes du cerveau. Bien que des instruments sophistiqués puissent enregistrer le travail de milliers de neurones en même temps, "nous ne comprenons pas la sortie du cerveau", a déclaré Dutta. "Pour comprendre ce codage neuronal dense, vous devez avoir accès à une compréhension plus large du comportement."

Cette vaste compréhension pourrait bientôt succomber à nos tentatives de la comprendre. Sur la base du succès de l'apprentissage automatique, les scientifiques créent des algorithmes qui suivent automatiquement les mouvements des animaux jusqu'à de minuscules changements dans l'angle des ailes d'une mouche ou en pliant le dos d'une souris. Ils créent également des outils qui peuvent trouver des modèles en analysant et en classant automatiquement ces données pour des indices sur les conditions internes des animaux.

Le principal avantage de ces méthodes est qu'elles sont capables de rechercher des motifs invisibles pour les personnes. Dans un

article publié le mois dernier dans la revue Nature Neuroscience, Calhoun, avec les neuroscientifiques de Princeton

Malaya Murty et

Jonathan Pillow , a créé un modèle d'apprentissage automatique qui utilise uniquement des observations comportementales pour déterminer les trois états internes qui déterminent les habitudes d'accouplement des mouches des fruits. En manipulant l'activité cérébrale des mouches, les chercheurs ont ensuite pu déterminer l'ensemble des neurones qui contrôlaient ces conditions.

Les travaux sur le suivi de mouvement et l'analyse comportementale qui ont rendu ces découvertes possibles représentent une révolution technologique dans l'étude du comportement. Il s'ensuit également qu'il s'agit du premier de nombreux succès futurs. Les scientifiques utilisent désormais ces méthodes pour trouver des réponses aux questions de neurobiologie, génétique, évolution et médecine, qui jusqu'à présent semblaient insolubles.

Journaux et répertoires

Depuis des décennies, les scientifiques quantifient le comportement des animaux en laboratoire et en milieu naturel, armés d'un stylo, d'un papier et d'un chronomètre. Ils ont vu leurs sujets expérimentaux dormir, jouer, se procurer de la nourriture et s'accoupler. Ils ont évalué les observations, esquissé des schémas de schémas, élaboré des plateformes organisationnelles pour systématiser et expliquer ces tendances. Les biologistes Nikolaas Tinbergen, Konrad Lorenz et Karl von Frisch ont reçu le

prix Nobel 1973 pour avoir mené indépendamment des expériences similaires avec des poissons, des oiseaux et des insectes.

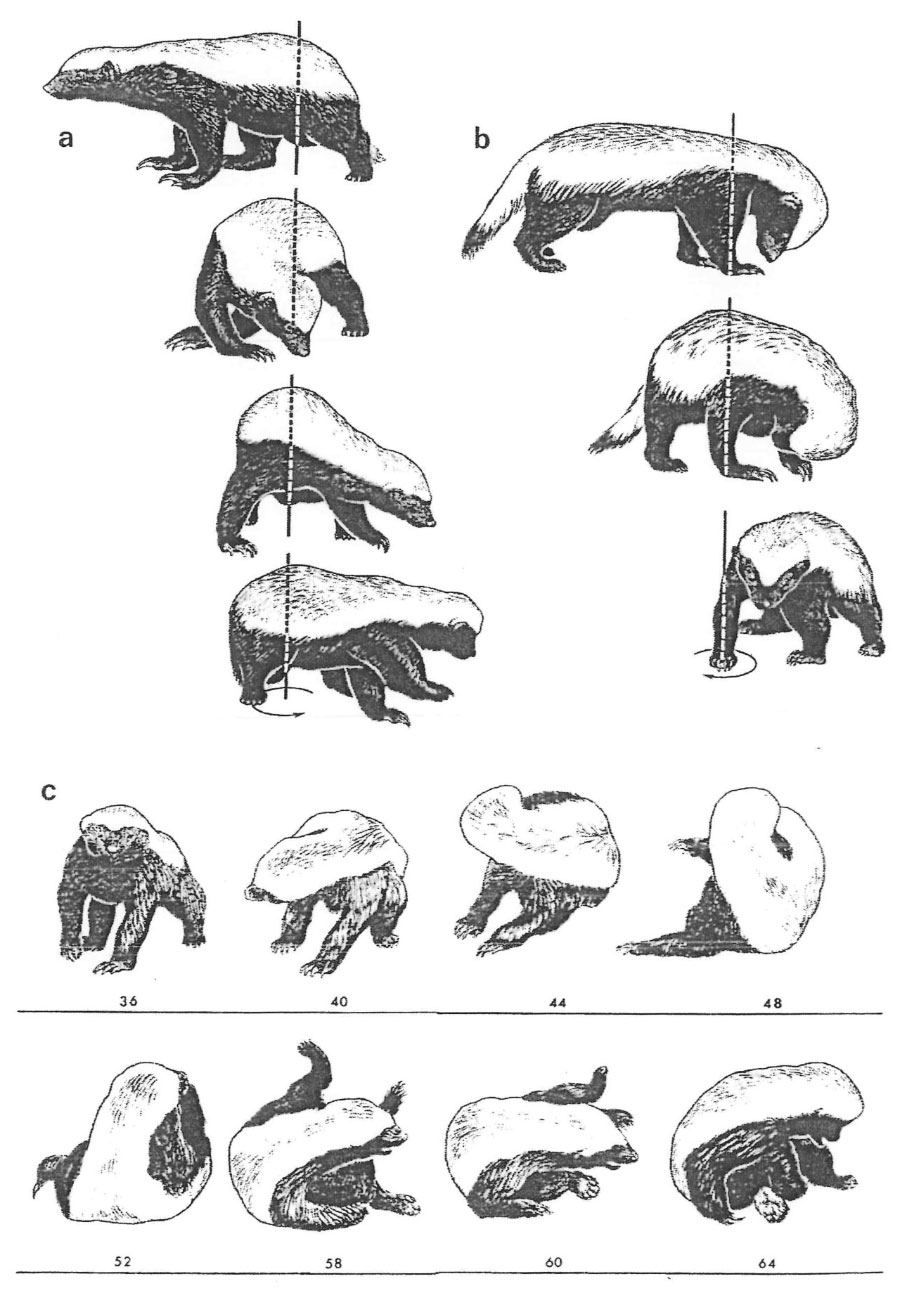

Le zoologiste Ilan Golani a esquissé manuellement le mouvement et le comportement de diverses espèces afin de décrire quantitativement les règles qui régissent le comportement des animaux. Ces chiffres montrent la rotation de tout le corps par le blaireau à miel.

Le zoologiste Ilan Golani a esquissé manuellement le mouvement et le comportement de diverses espèces afin de décrire quantitativement les règles qui régissent le comportement des animaux. Ces chiffres montrent la rotation de tout le corps par le blaireau à miel.De tels catalogues de comportements peuvent être

extrêmement détaillés . Dans une description de 1973 du lavage d'une souris, la nature a décrit le «mouvement difficile des membres antérieurs sous le museau» et les «mouvements larges, synchrones mais asymétriques des membres antérieurs au-dessus de la tête» et a évalué la probabilité de tels gestes dans différentes situations. Les chercheurs devaient tout décrire avec autant de détails, car ils ne savaient pas quel aspect du comportement observé pouvait être important.

Certains scientifiques ont abordé cette question du côté opposé, limitant au minimum la variété des comportements des animaux, les plaçant dans des conditions de laboratoire contrôlées et leur permettant de prendre uniquement les décisions les plus simples avec deux options, comme choisir le virage à droite ou à gauche dans le labyrinthe. Ces simplifications ont parfois été utiles et instructives, mais des restrictions artificielles discréditent également la compréhension des scientifiques du comportement naturel et peuvent entraîner la perte de signaux importants. "La nécessité de comprendre le comportement limite parfaitement la portée de ces études", a déclaré

Ann Kennedy , une étudiante postdoctorale en neurosciences théoriques au California Institute of Technology.

Par conséquent, les scientifiques ont décidé de renouveler ce domaine, "changeant leur pensée vers une approche quantitative", a déclaré

Talmo Pereira , un étudiant diplômé des laboratoires de Murty et

Joshua Shevica à Princeton. Et une étape importante de ce changement a été l'automatisation de la collecte et de l'analyse des données.

Suivre le museau, la colonne vertébrale et la queue

La technologie de capture d'image a toujours été importante pour suivre les postures des animaux en mouvement. Au 19e siècle,

Edward Maybridge a utilisé la chrono-photographie pour analyser la mécanique de la course à cheval et de la danse des gens. Les photographies ont facilité l'analyse de la position, par exemple, des membres ou de la tête de l'animal, et ont rendu ce processus plus précis. Avec l'avènement de la technologie d'enregistrement vidéo, les chercheurs ont pu faire des mesures plus précises - mais elles devaient encore être basées sur des estimations approximatives de la vitesse ou de la position de l'animal. Il était impossible de suivre chaque mouvement en trois dimensions. Et pourtant, beaucoup de travail a dû être fait pour cataloguer manuellement toutes les notes de la vidéo et les saisir dans l'ordinateur - ce processus ne s'est pas beaucoup amélioré par rapport à l'ancienne méthode de croquis dans les cahiers.

Edward Maybridge a utilisé la photographie en accéléré pour étudier la démarche d'un cheval et d'autres animaux en mouvement. Son appareil photo pouvait capturer et capturer des détails inaccessibles à l'œil humain.

Edward Maybridge a utilisé la photographie en accéléré pour étudier la démarche d'un cheval et d'autres animaux en mouvement. Son appareil photo pouvait capturer et capturer des détails inaccessibles à l'œil humain.Dans les années 1980, les chercheurs ont commencé à adapter les algorithmes de vision par ordinateur à leurs fins, qui étaient déjà utilisés pour rechercher des visages et des chemins dans les images, pour résoudre des problèmes tels que le suivi des contours des mouches à la surface. Au cours des décennies suivantes, des systèmes ont été développés pour noter l'emplacement de l'animal dans chaque image de la vidéo, trouver un animal spécifique dans un groupe de plusieurs et même commencer à

déterminer certaines parties du corps et leur orientation.

Néanmoins, l'efficacité de ces programmes laissait beaucoup à désirer. «Parmi eux, il y avait des indices de ce qui pourrait se produire à l'avenir», a déclaré

Ian Cousin , directeur de l'Institut pour l'étude du comportement animal qui porte son nom. Max Planck en Allemagne. «Cependant, des programmes vraiment complexes n'ont pu voir le jour que récemment, grâce au développement du deep learning.»

En utilisant l'apprentissage en profondeur (GO), les chercheurs ont commencé à enseigner aux réseaux de neurones à suivre la position des articulations et de grandes parties du corps de presque tous les animaux - insectes, souris, chauves-souris, poissons - dans chaque image de la vidéo. Il suffit de faire quelques trames étiquetées (dix suffisaient pour certains algorithmes). En conséquence, le programme dessine des points colorés sur le dessus du corps de l'animal, déterminant la position de son nez, de sa queue, de ses oreilles, de ses jambes, de ses pieds, de ses ailes, de sa colonne vertébrale, etc.

Au cours des deux dernières années, le nombre de programmes capables de le faire a considérablement augmenté, grâce non seulement aux progrès de l'apprentissage automatique, mais aussi au travail parallèle de marquage des mouvements humains avec des cinéastes, des animateurs et des experts de l'industrie du jeu.

De nouvelles méthodes peuvent suivre les postures de divers animaux pendant leur interaction. La vidéo montre comment l'algorithme SLEAP marque et suit automatiquement des parties du corps d'une paire de mouches pendant la parade nuptiale (à gauche) et deux souris qui étudient l'environnement.Bien sûr, si le mouvement est enregistré pour les besoins d'Hollywood ou de la Silicon Valley, il est facile pour les gens de porter des costumes spéciaux suspendus avec des marqueurs, que le système peut facilement suivre. Ces données peuvent être utilisées pour construire des modèles détaillés de postures et de mouvements. Cependant, l'option costume n'est pas adaptée à l'étude des animaux.

Il y a cinq ans, Jonathan Whitlock, neuroscientifique à l'Université norvégienne des sciences et de la technologie, a commencé à chercher activement un autre moyen de suivre les souris qu'il avait étudiées. Il a essayé tout ce à quoi il pouvait penser: lui et ses collègues ont rasé les souris et les ont marquées avec de l'encre réfléchissant la lumière infrarouge. Ils ont appliqué une suspension de billes de verre sur le dos des animaux, qui est souvent utilisée dans les marquages routiers réfléchissants. Ils ont peint des joints d'animaux avec de l'encre lumineuse et du vernis. Ils ont essayé beaucoup de choses, mais cela n'a pas fonctionné comme ils le devraient: parfois les marqueurs n'étaient pas assez lumineux pour suivre, parfois ils ennuyaient les souris, perturbant leur comportement.

En conséquence, l'équipe de Whitlock a décidé de coller de minuscules morceaux de ruban réfléchissant à trois points sur le dos de l'animal pour recréer les mouvements de la colonne vertébrale et de mettre un petit casque avec quatre morceaux de ruban supplémentaires pour suivre les mouvements de la tête. "Même cela a été suffisant pour nous ouvrir un tout nouveau monde", a déclaré Whitlock.

www.youtube.com/watch?v=3RaHuybwtFI&feature=youtu.beEn activant certains neurones dans la mouche, les chercheurs l'ont forcée à reculer le long d'un carrousel sphérique. La méthode d'apprentissage en profondeur a mesuré le changement des angles dans les articulations des jambes d'une mouche et a montré le mouvement des jambes, de l'abdomen et des antennes dans un espace en trois dimensions.

Mais de nombreux chercheurs voulaient se débarrasser de toutes sortes de marqueurs et suivre plus de sept points sur le corps des animaux. En combinant les idées de travaux antérieurs avec des animaux et des humains, plusieurs laboratoires ont créé des systèmes faciles à utiliser qui sont largement utilisés aujourd'hui.

Le premier de ces systèmes a fonctionné l'année dernière.

DeepLabCut a été développé par les neuroscientifiques de Harvard

Mackenzie Matis et

Alexander Matis , ayant refait pour cela un réseau de neurones formé pour classer des milliers d'objets. Bientôt, d'autres projets sont rapidement apparus:

LEAP (Leap Estimates Animal Pose), développé par Pereira et d'autres dans les laboratoires de Murty et Shevits; SLEAP, la prochaine version de la même équipe, qui suit la position des parties du corps de plusieurs animaux en interaction;

DeepPoseKit de Kozin, publié il y a quelques mois.

«Elle peut apprendre très rapidement», décrit Morty dans le système LEAP. "En 10-15 minutes, vous pouvez lui apprendre à travailler automatiquement avec toutes les vidéos." D'autres groupes travaillent sur la modélisation des poses dans un espace tridimensionnel plutôt que bidimensionnel, calibrant les mêmes modèles avec plusieurs caméras.

"À l'intérieur, ces technologies peuvent être incroyablement complexes", a déclaré Kuzin, "mais jusqu'à présent, elles sont étonnamment faciles à appliquer à un très large éventail de tâches, du suivi des mouvements des moustaches de la souris au comportement d'une fourmi ou à la formation de bancs de poissons".

Whitlock a découvert que chez les souris qu'il a étudiées, certains mouvements et positions étaient codés dans des parties du cortex, qui participent à des mouvements coordonnés - et, éventuellement, à d'autres activités. "Ces zones du cerveau sont très actives dans la façon dont l'animal tient sa tête", a-t-il déclaré. «Nous n'avions tout simplement pas pris cet aspect du traitement de l'information en écorce auparavant», car les chercheurs n'étaient pas en mesure de suivre les mouvements d'animaux se déplaçant librement.

Représentant schématiquement la posture de l'animal, l'algorithme permet de mieux comprendre son comportement. En fait, tous les aspects mesurables du comportement sont des «changements de posture au fil du temps», a déclaré Whitlock. "Et nous avons appris à lire la pose."

Parce que le logiciel de suivi de posture a facilité la collecte de données, «nous pouvons maintenant passer à d'autres tâches», a déclaré

Benjamin de Beavort , biologiste comportemental à l'Université Harvard. Par exemple: comment définir les éléments constitutifs du comportement et comment les interpréter?

Langage caché

Les tentatives pour répondre à ces questions pendant longtemps dépendaient de l'intuition de l'observateur - d'une "perception impeccable", comme plaisantent les

éthologues (experts en comportement animal). Cependant, l'intuition est sujette aux préjugés, aux problèmes de reproductibilité et aux difficultés de généralisation.

Le zoologiste

Ilyan Golani de l'Université de Tel Aviv a passé la majeure partie des six dernières décennies à chercher un moyen moins aléatoire de décrire et d'analyser le comportement - qui utiliserait des unités de comportement fondamentales, quelque chose comme les atomes en chimie. Il ne voulait pas qualifier ce comportement de «parade nuptiale» ou d '«alimentation». Il voulait que cette caractérisation apparaisse naturellement, à partir d'un ensemble général de règles dérivées de l'anatomie animale. Golani a son propre modèle de l'apparence de ces unités et règles, mais il estime que ce domaine est encore loin de parvenir à un consensus à ce sujet.

D'autres chercheurs, en revanche, sont convaincus que MO et GO sont plus susceptibles de mener ce domaine à un consensus. Mais DeepLabCut, LEAP et d'autres algorithmes avancés de suivi de posture reposent sur la formation des enseignants - ils sont formés pour reconnaître les parties du corps sur la base de données étiquetées manuellement. Les scientifiques espèrent trouver et analyser les éléments de base du comportement en apprenant sans enseignant. Une telle approche, peut-être, sera en mesure de révéler de manière indépendante la structure de comportement invisible pour nous, afin que les gens n'aient pas à imposer chaque étape suivante au système, introduisant des erreurs résultant de biais cachés.

Un exemple intéressant de cette approche est apparu en 2008, lorsque les chercheurs ont identifié quatre unités de base du mouvement des vers qui peuvent être combinées ensemble, recevant presque tous les mouvements disponibles pour cet animal. Cette représentation compacte, appelée "ver propre" [de "propre", c'est-à-dire «Propre» / env. trad.], propose une méthode quantitative pour évaluer la dynamique comportementale.

L’algorithme de séquençage de mouvements créé au laboratoire de Bob Dutta à la Harvard Medical School définit de petites unités, ou «syllabes», dans la dynamique comportementale des souris. Les scientifiques suggèrent que le comportement des souris consiste en de telles syllabes se succédant selon certaines règles "grammaticales".

La vidéo montre six exemples de ces unités comportementales («se pencher et se branler», «courir en avant», «se laver», «se froisser le visage», «l'agression», «tenter de s'échapper»). Chacun d'eux est basé sur le suivi de différentes souris; les points qui apparaissent indiquent le même comportement simple.

Datta a pris cette approche à un tout nouveau niveau en 2013, en adoptant une astuce de la Xbox Kinect, et a rapidement réussi avec elle. Lorsque lui et ses collègues ont examiné les données collectées décrivant les mouvements des souris, ils ont été surpris de la rapidité avec laquelle ils ont pu voir la structure en eux. La dynamique du comportement tridimensionnel des animaux se décompose naturellement en petits segments, d'une durée moyenne d'environ 300 ms. «Et ce ne sont que des données. Je vous montre les données brutes », a déclaré Datta. "Ce n'est qu'une propriété fondamentale du comportement de la souris."

Il a décidé que ces segments étaient très similaires à la façon dont les unités de comportement devraient ressembler à des syllabes composées ensemble par un ensemble de règles ou de grammaire. Lui et l'équipe ont créé un réseau neuronal profond qui définit ces syllabes. Elle cherchait un moyen de diviser l'activité de l'animal en segments afin qu'ils soient le meilleur moyen de prédire le comportement futur. Cet algorithme, appelé Motion Sequencing (MoSeq), a produit des «syllabes», auxquelles les chercheurs ont ensuite donné des noms comme «aller de l'avant» ou «se pencher et se branler» ou «tenter de s'échapper». Dans une expérience typique, la souris a utilisé 40 à 50 de ces syllabes, et seulement quelques-unes d'entre elles correspondaient à ce que les gens avaient un nom.

"Leur algorithme peut isoler des comportements pour lesquels nous n'avons même pas de nom", a déclaré Whitlock.

Les chercheurs tentent maintenant de déterminer l'importance biologique ou environnementale de ces comportements jamais vus auparavant. Ils étudient comment ces éléments comportementaux diffèrent selon les individus, les sexes ou les espèces, comment ils commencent à se rompre avec l'âge ou à la suite d'une maladie, comment ils sont produits pendant l'entraînement ou pendant l'évolution. , , , .

.

,

, , , «» , MoSeq, . « , , — . –

, , ».

, . , , . , , . « , — , — , . ».

, , , . , , .

.

, - Motion Mapper. , , ,

, . , « » - Motion Mapper .

, . , , . , , , , , , .

, Nature Neuroscience, , , , . , «», «», «». , , , , , , . « , », — .

SLEAP. « , , », — .

, , . , , . , , - , , .

«, , », — . , «- ». , « , , , , , . ».

« , , — . – . . , ».