Bonjour, Habr! Au cours de la première semaine de travail de la nouvelle année, il est temps de regarder en arrière et de se souvenir des succès de 2019. L'année écoulée a été marquée par des percées technologiques et de nouveaux problèmes scientifiques. Examinons de plus près les résultats les plus intéressants.

Portrait de trou noir

Au printemps, la collaboration Event Horizon Telescope a présenté au monde la première image d'un trou noir supermassif dans la galaxie M87 voisine. Ce fut un excellent résultat d'un travail gigantesque - pendant plusieurs jours, huit observatoires radio dans le monde, dont l'Antarctique, ont simultanément regardé un trou noir. Les données ont été traitées sur des clusters au MIT et MPIfR , et elles ont été livrées sur des disques durs - il n'est pas réaliste de transférer le volume de pétaoctets sur Internet à partir d'observatoires distants (en particulier de l'Antarctique). Quelques mois supplémentaires ont été consacrés au traitement et à la reconstruction des images. Une bonne histoire sur les détails d'une expérience peut être lue, par exemple, sur Elements ( un , deux ) ou sur N + 1 .

Dans l'image elle-même, nous voyons un disque d'accrétion - une substance chauffée, tournant dans une spirale avant de tomber dans un trou noir. Le point au centre n'est pas le trou noir lui-même, mais plutôt l'ombre de celui-ci: la lumière passant près du trou noir est courbée en raison de la lentille gravitationnelle, de sorte que l'ombre est plusieurs fois plus grande que l'horizon des événements du trou noir.

Le disque d'accrétion de ce trou noir est tourné vers nous par son plan. S'il était situé sur le côté de nous (comme les anneaux de Saturne), nous verrions quelque chose de similaire à un trou noir d'Interstellar. Malheureusement, l'astronomie est une science extrêmement observationnelle: nous n'avons pas la moindre chance d'influencer ces processus grandioses ou même de les regarder sous un angle différent en raison de la grande distance qui les sépare.

Plus de trous noirs sous différents angles

Il existe également un bon article de synthèse sur arXiv sur la simulation d'images BH.

Reste à ajouter que cette image seule ne prouve pas la présence de trous noirs - nous sommes confiants dans leur existence en raison de la masse des autres résultats. Sa valeur est plus susceptible de confirmer nos idées sur ce qui se passe dans les noyaux des galaxies. Et bien sûr, en créant une énorme collaboration internationale qui permet des observations systématiques avec un télescope de la taille de la Terre. Dans un avenir proche, l'inclusion de nouveaux télescopes de longueur d'onde plus courte dans le réseau et l'étude de la dynamique des processus autour des trous noirs dans les noyaux du M87 et de la Voie lactée.

Problèmes constants de Hubble

Notre Univers s'agrandit: les distances entre les galaxies voisines sont en constante augmentation; le taux de cette expansion est déterminé par la constante de Hubble. Ses mesures précises sont la tâche la plus importante pour la cosmologie, et en même temps la tâche est très difficile. Jusqu'à récemment, tout convergeait à une valeur d'environ 70 km / s par mégaparsec. Une bonne précision n'a été atteinte que l'année précédente: une analyse des données du satellite Plank, qui a mesuré l'anisotropie du rayonnement CMB, a conduit à une constante de Hubble de 67,4 ± 0,5 km / s / Mpc. La collaboration du Dark Energy Survey, qui a étudié les fluctuations de la densité de matière dans l'Univers à l'aide d'un réseau de télescopes optiques, a obtenu le même résultat.

Mais 2019 a apporté des surprises. Plusieurs groupes qui ont collecté des statistiques à long terme sur divers objets spatiaux - quasars , céphéides , masques spatiaux - ont convergé à une valeur d'environ 74 km / s / Mpc (points bleus sur le graphique). Contrairement aux résultats de l'année dernière, dans tous ces travaux, la distance aux installations existantes a été mesurée. Les fluctuations du rayonnement relique et la densité de la matière reflètent ce qui s'est passé à l'aube de l'Univers. En conséquence, nous avons une différence de plus de quatre écarts-types entre les valeurs de l'Univers ancien et actuel, ce qui est sans aucun doute intrigant et donne au moins lieu à des discussions sur la nouvelle physique.

Ici, vous pouvez trouver beaucoup de points controversés: par exemple, les distances à de nombreux objets ont été calibrées en utilisant les mêmes bougies standard, donc elles ne peuvent pas être considérées comme indépendantes. La cerise sur le gâteau est une mesure faite par des géantes rouges supermassives (point rouge): elle donne un résultat de compromis de 69,8 km / s / Mpc, mais ironiquement, l'étalonnage des distances à ces géantes rouges est encore moins précis. Maintenant, il y a un débat assez actif dans la communauté sur ce sujet, et la raison de l'écart n'est pas encore claire. Je voudrais croire que dans un proche avenir, le paradoxe commencera à se résoudre.

Rayon de proton

Quelque chose de similaire se produit dans le micromonde: les mesures de la taille d'un proton (plus précisément, son rayon de charge) donnent des résultats différents . Et les écarts ici sont encore plus importants.

En général, il existe deux façons simples de mesurer le rayon d'un proton:

- Bombardement électronique d'un proton: plus l'électron vole près du proton, plus la courbure de son trajet est attrayante. En utilisant le diagramme de diffusion, on peut reconstruire le rayon dans lequel la charge de protons est concentrée.

- Spectroscopie de l'hydrogène. Le noyau d'hydrogène est le proton, et sa taille affecte les niveaux d'énergie auxquels l'électron peut se trouver. En mesurant simultanément l'énergie de deux niveaux, vous pouvez calculer le rayon du noyau.

Les deux méthodes ont donné le même résultat: environ 0,875 femtomètre. En 2010, l'équipe MPQ a proposé de remplacer l'électron de l'atome d'hydrogène par un muon, une particule élémentaire plus lourde aux propriétés similaires. Le muon lourd tourne plus près du proton, donc le rayon du proton a un effet plus fort sur ses niveaux d'énergie. Le résultat de la mesure était inattendu moins - 0,841 fm. Les mesures ont été répétées en 2013, le résultat était le même.

Alors que le monde entier se demandait pourquoi l'hydrogène muon se comportait d'une manière spéciale et s'il y avait une nouvelle physique ici, MPQ a décidé de répéter l'expérience avec de l'hydrogène ordinaire - et a encore obtenu un rayon de proton plus petit! Un an plus tard, en 2018, la spectroscopie d'autres niveaux dans l'hydrogène ordinaire a été répétée à Paris ... et l'ancienne valeur de rayon a été obtenue! Ici, l'accent des discussions s'est déplacé vers la recherche d'erreurs courantes, jusqu'à la prise en compte de la différence de hauteur entre les deux laboratoires: la spectroscopie précise est essentiellement une comparaison avec la norme fréquence / temps bien connue, et selon la théorie générale de la relativité, les flux temporels à Paris et Munich de manière légèrement différente. pour différentes distances au centre de la terre.

L'année dernière m'a déjà fait plaisir avec deux expériences, et même d'un autre continent. Tout d'abord, un groupe de Toronto a répété l'expérience de la spectroscopie à l'hydrogène et a obtenu le même résultat que MPQ. Et bientôt, cela a été confirmé par l'expérience de diffusion d'électrons-protons de la collaboration américaine. Parallèlement à cela, le groupe MPQ a entamé exactement la même expérience que les Français ont menée en 2018 - un test de reproductibilité sans précédent dans la science moderne! Il existe déjà des résultats préliminaires, mais les auteurs ne les ont pas encore divulgués - ils sont seulement intrigants en ce qu'ils seront intéressants. La raison de cet écart est encore inconnue, mais apparemment tout deviendra clair dans un proche avenir.

Supériorité quantique

À l'automne, Nature a publié un article dans lequel l'équipe de Google démontrait une supériorité quantique . Leur puce quantique Sycamore à 53 qubits a pu résoudre un problème spécifique en 200 secondes. Il faudrait 10 000 ans pour le résoudre sur un supercalculateur classique.

La tâche elle-même, sur laquelle le résultat a été montré, s'est avérée assez banale. Un ordinateur quantique diffère d'un ordinateur normal en ce qu'il peut, ahem, effectuer des opérations quantiques inaccessibles aux ordinateurs classiques (merci Cap!). Par conséquent, dans l'expérience, la puce quantique a effectué un ensemble aléatoire d'opérations quantiques, et un ordinateur classique a simulé le même ensemble d'actions.

Une discussion sérieuse s'est déroulée autour du résultat. Par exemple, les chercheurs d'IBM disent qu'un algorithme classique optimisé résoudrait le problème non pas dans des milliers d'années, mais dans quelques jours. La question de la correction d'erreurs est encore plus aiguë: la mémoire quantique est si fragile que la correction d'erreurs logicielle n'y est pas enregistrée, et les mécanismes de correction bien connus du matériel compliquent l'architecture des puces quantiques par ordre de grandeur. Et faire évoluer les puces quantiques de dizaines de qubits à au moins des centaines est bien au-delà de ce qui est actuellement réalisable. Par conséquent, le résultat de Google est très mitigé: oui, nous avons franchi le seuil de l'ère quantique, mais jusqu'où nous pouvons aller de l'avant - et si nous pouvons du tout - reste inconnu.

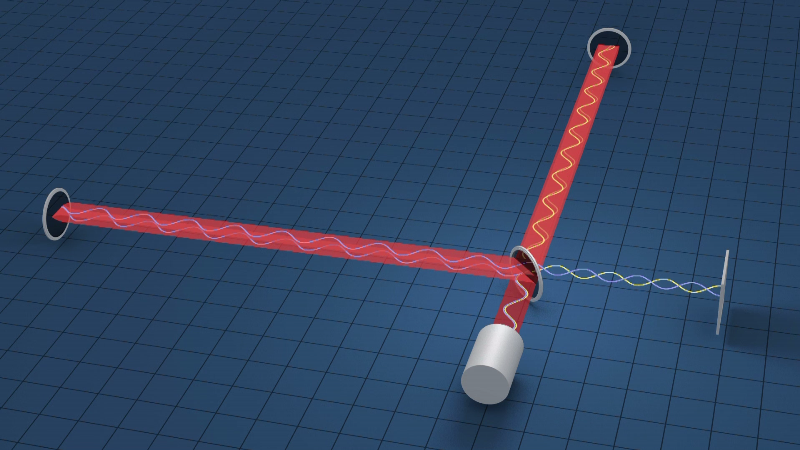

Lumière compressée pour LIGO

Tout le monde a entendu parler de la récente découverte d' ondes gravitationnelles et du prix Nobel 2017 qui a suivi. Il existe désormais trois observatoires suffisamment sensibles des ondes gravitationnelles dans le monde: deux détecteurs LIGO aux États-Unis et VIRGO en Italie. Ce sont des interféromètres laser incroyablement précis : pour atteindre la précision actuelle, des efforts énormes ont été investis dans la mesure du bruit de diverses natures et leur optimisation:

Aujourd'hui, la principale source de bruit est le bruit de tir quantique de la lumière (courbe lilas): il est dû au fait que le laser émet des photons à des moments aléatoires. Un tel bruit peut être traité en utilisant des corrélations induites par la lumière dans un rayon de lumière qui redistribuent le bruit de l'intensité lumineuse dans le bruit de sa phase, ce qui est inoffensif pour notre objectif. Cette technique a déjà été testée sur l'interféromètre allemand GEO600, et l'année dernière elle a finalement été mise en service sur LIGO et VIRGO . Apparemment, il s'agit de la première application de lumière compressée pour résoudre des problèmes pratiques. Maintenant, la sensibilité des détecteurs augmentera considérablement (jusqu'à deux fois dans certaines gammes de fréquences), et nous espérons entendre des phénomènes plus intéressants des coins les plus reculés de l'Univers.

Et c'est aussi un résultat spécial pour Habr - pour lui, nous devons remercier Mikhail Shkaff , qui est directement impliqué dans ce sujet et a écrit de nombreux articles intéressants sur LIGO et pas seulement. Merci et nouveaux succès!

Limite de masse des neutrinos

Les neutrinos restent l'une des particules élémentaires les plus mystérieuses: ils n'interagissent pratiquement pas avec la matière et peuvent facilement traverser la Terre. Nous savons qu'ils ont au moins une certaine masse provenant des oscillations des neutrinos: sur le chemin du Soleil vers nous, une partie du neutrino se transforme en neutrino d'un type différent. La transformation est un processus dynamique, ce qui signifie que le temps s'écoule dans le cadre de référence des neutrinos - c'est-à-dire qu'ils volent plus lentement que la vitesse de la lumière en raison de leur masse.

Mesurer cette masse est beaucoup plus difficile. Sa limite inférieure - environ 9 meV - nous le savons grâce aux oscillations des neutrinos. Le projet KATRIN à Karlsruhe, en Allemagne, a pris la mesure de la limite supérieure. L'idée était d'observer la désintégration radioactive du tritium en hélium-3, un électron et un antineutrino: il est impossible de détecter ce dernier, mais vous pouvez mesurer les vitesses des particules restantes et calculer l'énergie manquante. En pratique, il est plus facile de travailler avec des électrons: les vitesses les plus élevées pouvant être atteintes signifient que toute l'énergie de désintégration est passée dans le neutrino et l'électron. De tels cas sont peu fréquents; par conséquent, le détecteur doit être bien optimisé pour détecter des électrons d'une certaine énergie.

Pour cette raison, le projet KATRIN a pris beaucoup de temps à se préparer, mais il a donné le premier résultat après un mois de fonctionnement: la limite supérieure de l'énergie des neutrinos était de 1,1 eV, ce qui doublait l'estimation précédente. Il est prévu que KATRIN obtienne des statistiques pour encore cinq ans, améliorant la précision à 0,2 eV. Et des expériences plus avancées basées sur la même idée peuvent augmenter la précision de la mesure à 40 meV.

Au lieu d'une conclusion

À mon avis, l'année écoulée s'est avérée très sociale: les réalisations dont il se souvient sont dues aux efforts conjoints de nombreux groupes et à de nouveaux problèmes - les différences entre eux. Le travail d'équipe en science - des expériences de bureau aux collaborations internationales - devient de plus en plus important pour obtenir des résultats significatifs. J'espère que nous mettrons tout en œuvre pour que notre travail soit encore plus productif et que les résultats de l'année à venir ne soient pas moins intéressants.

Basé sur Quanta Magazine , Science et l' American Physical Society .