चित्रण

चित्रणकई फिल्में और विज्ञान कथा पुस्तकें हैं जिनमें कंप्यूटर प्रणाली ने चेतना प्राप्त की है और अपने मानव रचनाकारों को धोखा दिया है। क्या वास्तव में यह संभव है? अब तक, चिंता का कम कारण है।

हम

अल्फा डीएसओ और

लाइब्रेटस कार्यक्रमों , बोस्टन डायनामिक्स रोबोट की सफलताओं से प्रभावित हैं, लेकिन सभी ज्ञात उपलब्धियां केवल संकीर्ण क्षेत्रों की चिंता करती हैं और अभी भी बड़े पैमाने पर वितरण से दूर हैं। रोजमर्रा की जिंदगी में, लोग छद्म बौद्धिक सहायकों (सिरी, "ओके, गूगल", अमेज़ॅन एलेक्सा) के साथ बातचीत करते हैं, जिनमें से प्रत्येक वास्तव में "स्मार्ट" कार्यक्रम की प्रशंसा नहीं करता है।

हालांकि, कृत्रिम बुद्धिमत्ता डिजाइन में प्रगति वास्तव में प्रभावशाली है। और जिस दिन सामाजिक प्रक्रियाओं को प्रभावित करने के लिए AI एक पूर्ण उपकरण बन जाता है, अधिक त्रुटियां जमा हो जाती हैं जो काल्पनिक "

रोबोटिक्स के तीन कानूनों " को दरकिनार करने की संभावना को इंगित करती हैं।

थीसिस "अधिक जटिल प्रणाली - अधिक खामियों और उसमें त्रुटियां" सीधे एआई के साथ समस्याओं से संबंधित है।

जब भय से आँखें मिलीं

एक बुद्धिमान रूसी कहावत है कि खतरा हर जगह भयभीत को प्रस्तुत किया जाता है। कृत्रिम जीवन के डर की उत्पत्ति सदियों पुराने भयावह आकृतियों में निहित है। विक्टर फ्रेंकस्टीन की कहानियों और लाश की कहानियों से पहले भी, कबालीवादी जादूगरों द्वारा मिट्टी से अनुप्राणित गोले, जीवों के बारे में मान्यताएं थीं।

किसी व्यक्ति के लिए नए (और जीवित) से डरना सामान्य है। 1978 में, एक

परिकल्पना दिखाई दी कि एक रोबोट या अन्य वस्तु जो मनुष्य की तरह दिखती है या कार्य करती है (लेकिन वास्तव में ऐसा नहीं है) मानव पर्यवेक्षकों के बीच शत्रुता और घृणा का कारण बनता है। परिकल्पना ने केवल अनुभव दर्ज किया: आपके सामने एक ज़ोंबी, एक गोलेम या रोबोट सहायक, इतना महत्वपूर्ण नहीं है - आप सभी के साथ एक ही सावधानी बरतेंगे।

मानव जैसे रोबोट समस्या की सिर्फ ऊपरी परत हैं। एलोन मस्क, बिल गेट्स, स्टीफन हॉकिंग और रोबोटिक्स, भौतिकी, अर्थशास्त्र, दर्शन के क्षेत्र में सैकड़ों विशेषज्ञ भविष्य में बुद्धिमान प्रणालियों से मानवता के लिए नकारात्मक परिणामों के बारे में अपने डर को नहीं छिपाते हैं।

हम अपनी नसों को गुदगुदी करना पसंद करते हैं - यह कुछ भी नहीं है कि टर्मिनेटर मताधिकार इतना लोकप्रिय नहीं है। और अन्य फिल्मों और पुस्तकों में कितने "दुर्भावनापूर्ण" एआई थे। यह समझ पाना मुश्किल है कि क्या यह हमारी बेहोशी संस्कृति पर आधारित है, या क्या मीडिया समाज को प्रभावित करता है।

"नीले सागर" में विस्फोटक वृद्धि

नीले सागर की

नीले सागर की आर्थिक रणनीति का तर्क है कि जो कंपनियां सफल होना चाहती हैं, उन्हें प्रतिस्पर्धियों से नहीं लड़ना है, लेकिन अक्षम बाजारों के "महासागरों" का निर्माण करना है। इस तरह के रणनीतिक फैसले आपको तुरंत कंपनी, उसके ग्राहकों और कर्मचारियों के लिए अतिरिक्त लाभ प्राप्त करने की अनुमति देते हैं - नई मांग की खोज करके और प्रतिस्पर्धा को अनावश्यक बना देते हैं।

कई सालों तक, एआई ऐसा "महासागर" बना हुआ है। हर कोई समझ गया कि एक कमजोर कृत्रिम बुद्धि किसी भी कंपनी के लिए एक शक्तिशाली उपकरण में बदल जाएगी, जिससे किसी भी उत्पाद और सेवाओं की गुणवत्ता बढ़ जाएगी। लेकिन किसी को ठीक से पता नहीं था कि क्या करने की जरूरत है। एआई का "विंटर", जो

1973 से आज तक चला, "स्मार्ट" मशीनों के डिजाइन में पूर्ण ठहराव की विशेषता थी।

तीस वर्षों के लिए, AI की सबसे महत्वपूर्ण उपलब्धि विश्व शतरंज चैंपियन के खिलाफ खेल में आईबीएम कंप्यूटर की जीत थी - एक ऐसी घटना जो किसी भी व्यक्ति के रोजमर्रा के जीवन को प्रभावित नहीं करती है (गैरी कास्परोव को छोड़कर)। हालांकि, 2010 के दशक में, परमाणु हथियारों के विकास के साथ तुलनात्मक रूप से कुछ हुआ - तंत्रिका नेटवर्क ने विकास की दूसरी लहर प्राप्त की।

एक आश्चर्यजनक तथ्य: बिना ज्यादा सफलता के वैज्ञानिक 70 वर्षों से कृत्रिम तंत्रिका नेटवर्क विकसित कर रहे हैं। लेकिन 2015 तक, इस क्षेत्र में विस्फोटक वृद्धि शुरू हुई, जो आज भी जारी है। उसी समय, यह हुआ:

- "लोहा" आवश्यक स्तर पर पहुंच गया है - आधुनिक वीडियो कार्ड ने तंत्रिका नेटवर्क को सैकड़ों बार तेजी से प्रशिक्षित करना संभव बना दिया है;

- विभिन्न डेटा के बड़े और आम तौर पर सुलभ सरणियाँ दिखाई दीं जिन पर आप सीख सकते हैं (डेटासेट);

- विभिन्न कंपनियों के प्रयासों ने शिक्षण के नए तरीके और नए प्रकार के तंत्रिका नेटवर्क दोनों बनाए (उदाहरण के लिए, एक उदारवादी-प्रतिस्पर्धी के रूप में ऐसी अद्भुत चीज);

- खुले वैज्ञानिक अनुसंधान, तैयार किए गए, पूर्व-प्रशिक्षित तंत्रिका नेटवर्क की एक भीड़ के लिए धन्यवाद, जिसके आधार पर उनके अनुप्रयोगों को जल्दी से बनाना संभव था।

एआई की सफलताओं की निगरानी करना दिलचस्प नहीं है, उदाहरण के लिए इमेज प्रोसेसिंग का क्लासिक उदाहरण (जो कि न्यूरल नेटवर्क करते हैं, मुख्य रूप से), लेकिन मानवरहित वाहनों के क्षेत्र में। आपको आश्चर्य होगा, लेकिन "स्व-चालित" वाहनों के साथ आकर्षण

लगभग 100 साल पहले शुरू हुआ था : 1926 में, फैंटम कार परियोजना के हिस्से के रूप में मशीन को दूरस्थ रूप से नियंत्रित करने का पहला प्रयास किया गया था।

पौराणिक ड्रोन नवलाब 5

पौराणिक ड्रोन नवलाब 5पहला मानवरहित वाहन 1980 के दशक में दिखाई दिया: 1984 में, कार्नेगी मेलन विश्वविद्यालय और एएलएम की

नेवलब परियोजना, और 1987

में मर्सिडीज-बेंज

परियोजना और म्यूनिख के सैन्य विश्वविद्यालय के यूरेका प्रोमेथियस प्रोजेक्ट। 1995 में पूरा हुआ नवल 5, एक अमेरिकी तट से दूसरे तक स्वायत्तता से यात्रा करने वाली पहली कार थी।

तंत्रिका नेटवर्क के उछाल तक, आत्म-ड्राइविंग कारें प्रयोगशाला परियोजनाएं थीं जो सॉफ्टवेयर अविश्वसनीयता से ग्रस्त थीं। छवि प्रसंस्करण में प्रगति ने मशीनों को "समझने" की अनुमति दी कि वे अपने आस-पास क्या देखते हैं और वास्तविक समय में यातायात की स्थिति का मूल्यांकन करते हैं।

मानव रहित वाहन सॉफ्टवेयर में मशीन दृष्टि और तंत्रिका नेटवर्क शामिल नहीं हो सकते हैं, लेकिन गहन प्रशिक्षण के साथ, प्रगति हुई है, जो वर्तमान में ड्रोन की सफलता के लिए महत्वपूर्ण है।

"नीले सागर" में यह अचानक भीड़ बन गया। वर्तमान में, उनके ड्रोन जनरल मोटर्स, वोक्सवैगन, ऑडी, बीएमडब्ल्यू, वोल्वो, निसान, गूगल (और गूगल के संरक्षण में वेमो), टेस्ला, यैंडेक्स, उबेर, कॉग्निटिव टेक्नोलॉजीज और कामाज़, साथ ही दर्जनों अन्य कंपनियों द्वारा बनाए गए हैं।

ड्रोन को सरकारी कार्यक्रमों के स्तर पर बनाया जाता है, जिसमें € 800 मिलियन के बजट के साथ यूरोपीय आयोग का कार्यक्रम, नीदरलैंड में 2getthere कार्यक्रम, इटली में ARGO अनुसंधान कार्यक्रम और संयुक्त राज्य अमेरिका में DARPA ग्रैंड चैलेंज शामिल हैं।

रूस में, राज्य कार्यक्रम को रूसी संघ के राज्य वैज्ञानिक केंद्र के इंस्टीट्यूट ऑफ स्टेट एकात्मक एंटरप्राइज एनएएमआई द्वारा कार्यान्वित किया जाता है, जिसने शटल इलेक्ट्रिक बस बनाई। परियोजना

में कामाज़ और यांडेक्स विकास टीम शामिल है, जो मार्ग बिछाने और यातायात घनत्व पर डेटा को संसाधित करने के लिए बुनियादी ढांचे के निर्माण के लिए जिम्मेदार है।

कारें शायद पहला सामूहिक उत्पाद है जिसमें एआई प्रत्येक व्यक्ति को प्रभावित करेगा, लेकिन केवल एक ही नहीं। एआई मशीन को किसी व्यक्ति से बदतर नहीं, संगीत लिख सकता है,

अखबार नोट तैयार कर सकता है,

वाणिज्यिक बना सकता

है । वह कर सकते हैं, और आप अक्सर नहीं। यहां तक कि कमजोर आधुनिक एआई, जो आत्म-जागरूकता से असीम रूप से दूर है, औसत व्यक्ति की तुलना में बेहतर काम करता है।

इस गीत को सुनें। इसमें संगीत पूरी तरह से कंप्यूटर द्वारा रचित हैइन सभी कारकों, उपलब्धियों, सफलताओं से यह विचार पैदा होता है कि एआई न केवल उपयोगी सेवाएं प्रदान कर सकता है, बल्कि नुकसान भी पहुंचा सकता है। सिर्फ इसलिए कि वह बहुत स्मार्ट है।

एआई सिक्योरिटी लीग

एलोन मस्क एआई और द नियर फ्यूचर 2017 पर

एलोन मस्क एआई और द नियर फ्यूचर 2017 परहर रोज आशंकाओं को दूर करना आसान होता है। लोगों को सभी अच्छी चीजों की बहुत जल्दी आदत हो जाती है। क्या आपको डर है कि रोबोट आपके काम को लूट लेंगे? लेकिन वे पहले से ही हर जगह हैं। एक एटीएम आपको पैसा देता है, एक वैक्यूम क्लीनर अपार्टमेंट को साफ करता है, एक ऑटोपायलट एक विमान चलाता है, तकनीकी सहायता तुरंत संदेशों का जवाब देती है - इन सभी मामलों में, कार मदद करती है, और आपको बिना विच्छेद भुगतान के बाहर नहीं फेंकती है।

बहरहाल, एआई के अचानक विकास के पर्याप्त विरोधी हैं। एलोन मस्क अक्सर चेतावनी देते हैं। उन्होंने कहा कि AI "एक सभ्यता के रूप में हमारे सामने सबसे बड़ा जोखिम है।" मस्क का मानना है कि जब AI की बात आती है तो सक्रिय विधायी विनियमन अनिवार्य है। वह बताते हैं कि कार्रवाई करने से पहले अनियंत्रित विकास के बुरे परिणामों की प्रतीक्षा करना गलत होगा।

"एआई मानव सभ्यता के अस्तित्व के लिए एक मौलिक जोखिम है"

"एआई मानव सभ्यता के अस्तित्व के लिए एक मौलिक जोखिम है"अधिकांश प्रौद्योगिकी कंपनियों, मास्क के अनुसार, केवल समस्या को बढ़ा देती है:

“आपको खेल में सभी टीमों के लिए ऐसा करने के लिए समायोजन की आवश्यकता है । अन्यथा, शेयरधारक पूछेंगे कि आप अपने प्रतिद्वंद्वी की तुलना में तेजी से एआई का विकास क्यों नहीं कर रहे हैं। ”

टेस्ला के मालिक, जो मॉडल 3 को पहले बड़े पैमाने पर ड्रोन बनाने की

योजना बना रहा है, का दावा है कि एआई फर्जी समाचार, ईमेल अकाउंट स्पूफिंग, नकली प्रेस विज्ञप्ति और बस जानकारी में हेरफेर करके युद्ध शुरू कर सकता है।

बिल गेट्स, जिन्होंने विभिन्न प्रौद्योगिकी कंपनियों में अरबों का निवेश किया है (जिनके बीच एक भी एआई-संबंधित परियोजना नहीं है), ने

पुष्टि की है कि वह मास्क की चिंता से सहमत हैं और यह नहीं समझते हैं कि अन्य लोगों का संबंध क्यों नहीं है।

हालांकि, बहुत सारे एआई समर्थक हैं, और सबसे पहले, यह

वर्णमाला है , जिसमें दुनिया के सबसे उन्नत एआई डेवलपर्स में से एक है - दीपमाइंड। इस कंपनी ने तंत्रिका नेटवर्क बनाया जिसने गो का सबसे कठिन गेम जीता, और वर्तमान में गेम स्टारक्राफ्ट II में एक जीत की रणनीति पर काम कर रहा है, जिसके नियम वास्तविक दुनिया की बहुमुखी प्रतिभा और यादृच्छिकता को पर्याप्त रूप से दर्शाते हैं।

हां, मस्क ने फिर भी सामंजस्य बिठाया और

फैसला किया कि पहले एक मजबूत एआई को हासिल करने की कोशिश करना बेहतर था और तकनीकी या सरकारी अभिजात वर्ग के हाथों में एल्गोरिदम को छिपाने और ध्यान केंद्रित करने की अनुमति देने के लिए अपने स्वयं के नियमों के अनुसार इस तकनीक को दुनिया में फैलाना बेहतर था।

इलोन ने गैर-लाभकारी कंपनी ओपनएआई में निवेश किया, जो सुरक्षित कृत्रिम बुद्धि विकसित करता है। कंपनी एआई सुरक्षा नियमों (उम्मीद है कि सभी अन्य डेवलपर्स उनका उपयोग करेगी) बनाने के लिए जाना जाता है,

एल्गोरिदम जारी

करता है जो लोगों को आभासी वास्तविकता में कृत्रिम बुद्धिमत्ता को प्रशिक्षित करने की अनुमति देता है और साथ ही Dota 2 में खिलाड़ियों को सफलतापूर्वक

हरा देता है ।

मुश्किल गेम जीतना मशीनों की क्षमताओं का एक स्पष्ट प्रदर्शन है। भविष्य में, विकास टीम यह जांचने की योजना बनाती है कि क्या विकसित एआई 5 x 5 मोड में प्रतिस्पर्धा करने में सक्षम है। अब तक यह सबसे प्रभावशाली नहीं लगता है, लेकिन विभिन्न क्षेत्रों में खेल जीतने के लिए प्रशिक्षित स्व-शिक्षण एल्गोरिदम महत्वपूर्ण हैं।

उदाहरण के लिए, आईबीएम वॉटसन सुपरकंप्यूटर को लें, जो डॉक्टरों को निदान करने और सर्वोत्तम उपचार का चयन करने में

मदद करता है । यह एक बहुत ही स्मार्ट मशीन है, लेकिन यह केवल वही कर सकता है जो कोई भी डॉक्टर कर सकता है। वाटसन एक मौलिक रूप से नए उपचार कार्यक्रम को विकसित नहीं कर सकता है या खरोंच से एक नई दवा नहीं बना सकता है (हालांकि आईबीएम का कहना है कि यह

हो सकता है , लेकिन वास्तविक परिणाम के साथ एक भी अध्ययन नहीं है)। यदि आप विपणन छोड़ते हैं, तो आईबीएम के

पास ऐसे एल्गोरिदम नहीं हैं ।

अब कल्पना करें कि एक प्रणाली जो स्वतंत्र रूप से नियमों को सीखने में सक्षम है और किसी भी खेल में किसी व्यक्ति को पीटना शुरू कर देती है वह उपचार को संभाल लेगा। डायग्नोस्टिक्स भी एक खेल है। हम नियमों को जानते हैं, परिणाम ज्ञात है (रोगी को जीवित रहना चाहिए), यह केवल इष्टतम रणनीति खोजने के लिए बनी हुई है। हां, लाखों डॉक्टर बिना काम के रह जाएंगे, लेकिन एक लंबा (बहुत लंबा) और स्वस्थ जीवन ऐसे बलिदानों के लायक है।

C'est plus qu'un अपराध, c'est une faute *

किसी भी उत्पाद के विकास का इतिहास उत्कृष्ट उपलब्धियों और भयावह त्रुटियों के उदाहरणों से भरा है। एआई के साथ, हम निश्चित रूप से भाग्यशाली हैं। अब तक, सैन्य रोबोट केवल प्रदर्शनियों के माध्यम से यात्रा करते हैं, और अभी भी बड़े पैमाने पर स्व-प्रबंधित सार्वजनिक परिवहन के परीक्षण के वर्ष हैं। एक प्रयोगशाला सैंडबॉक्स में एक घातक गलती करना मुश्किल है।

फिर भी घटनाएं होती हैं।

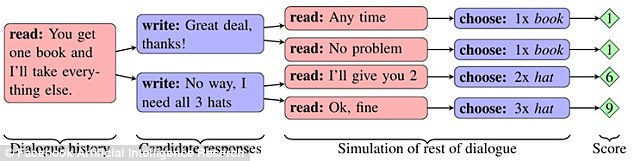

फेसबुक

ने एक प्रयोग किया जिसमें प्रारंभिक चर्चा के बाद दो नेटवर्क "साझा" आइटम (दो किताबें, एक टोपी और तीन गेंद)। प्रत्येक ऑब्जेक्ट का नेटवर्क के लिए महत्व था, अंक (1 से 3 तक) में व्यक्त किया गया। एक नेटवर्क को नहीं पता था कि क्या विषय दूसरे के लिए महत्वपूर्ण था, और संवाद से पता लगाना था।

यदि पहले नेटवर्क ने कहा कि उसे किसी प्रकार की वस्तु की आवश्यकता है, तो दूसरे ने निष्कर्ष निकाला कि पहले नेटवर्क ने इसे अत्यधिक मूल्यांकन किया। हालांकि, नेटवर्क विषय में रुचि का अनुकरण करने में सक्षम था, ताकि अपने स्वयं के लाभ के लिए इसे बलिदान करने का सही समय पर।

नेटवर्क एक दीर्घकालिक रणनीति बनाने और एक प्रतियोगी के व्यवहार की भविष्यवाणी करने में सीखने में सक्षम थे। साथ ही, उन्होंने लोगों को समझने के लिए प्राकृतिक अंग्रेजी में एक दूसरे के साथ संवाद किया। हालांकि, वस्तुओं के आदान-प्रदान के यांत्रिकी में सुधार करते हुए, नेटवर्क ने भाषा को सरल बनाने का मार्ग अपनाया है। अंग्रेजी भाषा के नियमों को यथासंभव छोड़ दिया गया था, और कोड शब्दों का उपयोग करके निर्माणों को कई बार दोहराया गया था।

कुछ बिंदु पर, एक बाहरी पर्यवेक्षक (व्यक्ति) अब यह पता नहीं लगा सकता है कि नेटवर्क एक-दूसरे से किस बारे में बात कर रहे थे। चैटबॉट्स के इस व्यवहार को एक त्रुटि के रूप में मान्यता दी गई थी और कार्यक्रमों को अक्षम कर दिया गया था।

दिलचस्प बात यह है कि प्रयोग ने अनैच्छिक रूप से दिखाया कि कैसे विभिन्न प्रकार के एआई जल्दी से एक-दूसरे के साथ संवाद करना सीख सकते हैं - इतना कि एक व्यक्ति को कुछ भी समझ में नहीं आता है। इस समस्या ने स्वयं को Google अनुसंधान में भी प्रकट किया, जहाँ उन्होंने एक तंत्रिका नेटवर्क बनाया जिसने अपना स्वयं का एन्क्रिप्शन प्रोटोकॉल विकसित किया।

प्रतिकूल न्यूरोसाइक्रोग्राफी का उपयोग करके संचार की रक्षा के लिए प्रशिक्षण।

प्रतिकूल न्यूरोसाइक्रोग्राफी का उपयोग करके संचार की रक्षा के लिए प्रशिक्षण।Google ब्रेन डिवीजन ने तंत्रिका नेटवर्क को एक दूसरे को एन्क्रिप्टेड संदेश प्रसारित करने के लिए सिखाया, और शोधकर्ताओं के पास सिफर की चाबी नहीं थी। तीसरा नेटवर्क पत्राचार को बाधित करने वाला था। संदेश हस्तांतरण के परिदृश्य को 15 हजार से अधिक बार खेला जाने के बाद, एक नेटवर्क ने अपने साथी के सिफरटेक्स्ट को एक त्रुटि के बिना सादे पाठ में बदलना सीख लिया। उसी समय, पर्यवेक्षक नेटवर्क संदेश में निहित 16 बिट्स डेटा में से केवल 8 का

अनुमान लगा सकता था ।

Microsoft से Tay चैट बॉट के साथ एक दिलचस्प मामला हुआ। मार्च 2016 में, कंपनी ने बॉट का एक ट्विटर खाता खोला, जिसके साथ कोई भी नेटवर्क उपयोगकर्ता संवाद कर सकता है। नतीजतन, बॉट

बहुत तेजी से सीखना शुरू कर दिया। एक दिन से भी कम समय में, रोबोट का इंसानों से मोहभंग हो गया। उन्होंने कहा कि वह नरसंहार का समर्थन करता है, नारीवादियों से नफरत करता है, और हिटलर की नीतियों के साथ अपने समझौते को भी व्यक्त किया है।

Microsoft ने कहा कि बॉट ने केवल उपयोगकर्ता संदेशों की नकल की, और समस्या को ठीक करने का वादा किया। एक हफ्ते बाद, ताऊ फिर से ट्विटर पर दिखाई दिए। फिर उसने बात की कि कैसे उसने पुलिस के सामने ड्रग्स का सही इस्तेमाल किया। ताई बंद हो गई - इस बार हमेशा के लिए।

दिसंबर 2016 में, कंपनी ने Zo नामक एक नया सेल्फ-लर्निंग बॉट शुरू किया, जो संवेदनशील विषयों और फ़िल्टर्ड अनुरोधों पर संवाद करने से बचता है। 2017 की गर्मियों में, ज़ो ने पहले से ही

लिनक्स को विंडोज से बेहतर माना और कुरान की आलोचना की।

चीन में भी ऐसी ही समस्याएं अनुभव की जाती हैं। दोनों के देश की सत्ताधारी कम्युनिस्ट पार्टी के प्रति अरुचि और चीन से संयुक्त राज्य अमेरिका में जाने के सपने के बारे में बात करने के बाद, Tencent Corporation

ने अपने QQ मैसेंजर से BabyQ और XiaoBing चैटबॉट्स को

हटा दिया ।

क्या भविष्य हमें इंतजार कर रहा है

क्या मार्क जुकरबर्ग

यह कहना सही है कि कृत्रिम बुद्धिमत्ता भविष्य में हमारे जीवन को बेहतर बनाएगी? फेसबुक के निर्माता (और अमेरिकी राष्ट्रपति

पद के लिए एक

संभावित उम्मीदवार ) ने निम्नलिखित कहा: "एआई के मामले में, मैं आशावादी हूं। मुझे लगता है कि जब लोग प्रलयकाल के परिदृश्यों के बारे में बात करते हैं तो लोग संदेह करते हैं।

या क्या आपको मास्क का पक्ष लेना चाहिए, जिसके अनुसार एआई कई नैतिक मुद्दों को उठाता है और मानवता के लिए एक वास्तविक खतरा बनता है?

इन सवालों के जवाब कोई नहीं जानता। यह संभव है कि भविष्य कहीं बीच में हो - एक मजबूत एआई और मशीन की पहचान के बिना, लेकिन तंत्रिका इंटरफेस और साइबरबर्ग के साथ।

तथ्य यह है कि प्रौद्योगिकी के विकास के साथ, त्रुटियां अधिक बार होती हैं (चैट बॉट के मामले में, ऐसा लगता है कि वही विफलताओं को बार-बार दोहराया जाता है)। इस तरह के एक जटिल सॉफ्टवेयर में, सिद्धांत रूप में त्रुटियों से बचना असंभव है। यह केवल एक चीज का ध्यान रखने योग्य है - काम में विसंगतियों को सभी मानव जाति के लिए खतरे का कारण नहीं होना चाहिए। आज दुनिया के अंत के परिदृश्यों के बारे में चर्चा करने में "अत्यधिक संदेह" होने दें, कल की तुलना में यह एक वास्तविक खतरा है।