हम में से प्रत्येक ग्रंथों को अपने तरीके से मानता है, चाहे वह इंटरनेट, कविता या क्लासिक उपन्यास पर समाचार हो। वही एल्गोरिदम और मशीन सीखने के तरीकों पर लागू होता है, जो एक नियम के रूप में, एक बहुआयामी वेक्टर अंतरिक्ष के रूप में, गणितीय रूप में ग्रंथों को देखता है।

लेख Word2Vec बहुआयामी वेक्टर शब्दों के प्रतिनिधित्व द्वारा गणना टी-एसएनई का उपयोग करके विज़ुअलाइज़ेशन के लिए समर्पित है। विज़ुअलाइज़ेशन Word2Vec के सिद्धांत को बेहतर ढंग से समझने में मदद करेगा और तंत्रिका नेटवर्क और अन्य मशीन लर्निंग एल्गोरिदम में आगे उपयोग करने से पहले शब्द वैक्टर के बीच संबंध की व्याख्या कैसे करें। लेख विज़ुअलाइज़ेशन पर केंद्रित है, आगे के शोध और डेटा विश्लेषण पर विचार नहीं किया जाता है। डेटा स्रोत के रूप में, हम Google समाचार और क्लासिक कार्यों के लेखों का उपयोग एल.एन. टालस्टाय। हम बृहस्पति नोटबुक में पायथन में कोड लिखेंगे।

टी-वितरित स्टोचैस्टिक पड़ोसी एंबेडिंग

टी-एसएनई एक मशीन लर्निंग एल्गोरिदम है जो डेटा के लिए विज़ुअलाइज़ेशन पर आधारित है जो कि नेलिनियर डायमेंशनल रिडक्शन विधि पर आधारित है, जिसे मूल लेख [1] और

हैबे पर विस्तार से वर्णित किया गया है। टी-एसएनई ऑपरेशन का मूल सिद्धांत उनके सापेक्ष स्थिति को बनाए रखते हुए बिंदुओं के बीच युग्म-दूरी को कम करना है। दूसरे शब्दों में, एल्गोरिथ्म बिंदुओं के पड़ोस की संरचना को बनाए रखते हुए बहुआयामी डेटा को निचले आयाम के स्थान पर ले जाता है।

शब्द और Word2Vec के वेक्टर प्रतिनिधित्व

सबसे पहले, हमें शब्दों को वेक्टर रूप में प्रस्तुत करने की आवश्यकता है। इस कार्य के लिए, मैंने Word2Vec वितरण शब्दार्थ उपयोगिता को चुना, जिसे वेक्टर अंतरिक्ष में शब्दों के अर्थ अर्थ को प्रदर्शित करने के लिए डिज़ाइन किया गया है। Word2Vec शब्दों के बीच संबंधों को यह मानकर चलता है कि शब्द संबंधी शब्द समान संदर्भों में पाए जाते हैं। आप मूल लेख [2] में Word2Vec के बारे में और साथ ही

यहाँ और

यहाँ पढ़ सकते हैं।

इनपुट के रूप में, हम Google समाचार और L.N के उपन्यासों से लेख लेते हैं। टालस्टाय। पहले मामले में, हम

प्रोजेक्ट पृष्ठ पर Google द्वारा प्रकाशित Google समाचार डेटासेट (लगभग 100 बिलियन शब्द) पर पूर्व-प्रशिक्षित वैक्टर का उपयोग करेंगे।

import gensim model = gensim.models.KeyedVectors.load_word2vec_format('GoogleNews-vectors-negative300.bin', binary=True)

जेनसिम पुस्तकालय [3] का उपयोग करते हुए पूर्व-प्रशिक्षित वैक्टर के अलावा, हम एल.एन. के ग्रंथों में एक और मॉडल को प्रशिक्षित करेंगे। टालस्टाय। चूंकि Word2Vec इनपुट के रूप में वाक्यों की एक सरणी को स्वीकार करता है, इसलिए हम पाठ को स्वचालित रूप से वाक्यों में विभाजित करने के लिए NLTK पैकेज से पूर्व प्रशिक्षित पंकट सेंटेंस टोकनलाइज़र मॉडल का उपयोग करते हैं। रूसी भाषा का मॉडल

यहां से डाउनलोड किया जा सकता

है ।

import re import codecs def preprocess_text(text): text = re.sub('[^a-zA-Z--1-9]+', ' ', text) text = re.sub(' +', ' ', text) return text.strip() def prepare_for_w2v(filename_from, filename_to, lang): raw_text = codecs.open(filename_from, "r", encoding='windows-1251').read() with open(filename_to, 'w', encoding='utf-8') as f: for sentence in nltk.sent_tokenize(raw_text, lang): print(preprocess_text(sentence.lower()), file=f)

अगला, Gensim लाइब्रेरी का उपयोग करते हुए, हम Word2Vec मॉडल को निम्नलिखित मापदंडों के साथ प्रशिक्षित करेंगे:

- आकार = 200 - विशेषता स्थान का आयाम;

- window = 5 - एल्गोरिथ्म का विश्लेषण करने वाले संदर्भ से शब्दों की संख्या;

- min_count = 5 - शब्द कम से कम पांच बार होना चाहिए ताकि मॉडल इसे ध्यान में रखे ।

import multiprocessing from gensim.models import Word2Vec def train_word2vec(filename): data = gensim.models.word2vec.LineSentence(filename) return Word2Vec(data, size=200, window=5, min_count=5, workers=multiprocessing.cpu_count())

टी-एसएनई का उपयोग करते हुए शब्दों के वेक्टर प्रतिनिधित्व का दृश्य

टी-एसएनई एक बहुआयामी अंतरिक्ष में वस्तुओं के बीच समानता की कल्पना के लिए बेहद उपयोगी है। जैसे-जैसे डेटा की मात्रा बढ़ती है, दृश्य ग्राफ बनाना अधिक से अधिक कठिन हो जाता है, इसलिए व्यवहार में संबंधित शब्दों को आगे के विज़ुअलाइज़ेशन के लिए समूहों में जोड़ा जाता है। उदाहरण के लिए Google समाचार पर पहले से प्रशिक्षित वर्ड 2 वीईसी मॉडल के एक शब्दकोश के कुछ शब्दों को लें।

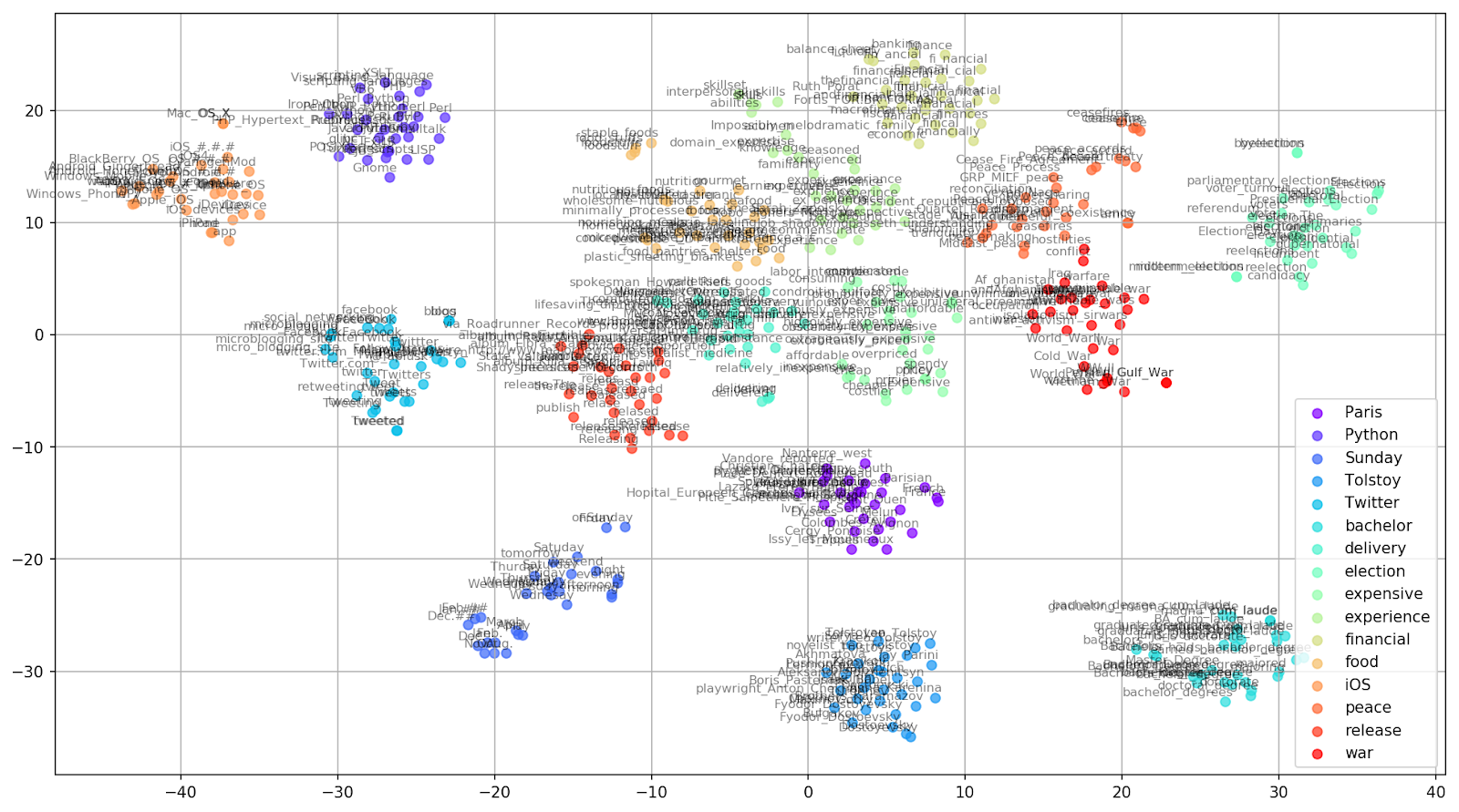

keys = ['Paris', 'Python', 'Sunday', 'Tolstoy', 'Twitter', 'bachelor', 'delivery', 'election', 'expensive', 'experience', 'financial', 'food', 'iOS', 'peace', 'release', 'war'] embedding_clusters = [] word_clusters = [] for word in keys: embeddings = [] words = [] for similar_word, _ in model.most_similar(word, topn=30): words.append(similar_word) embeddings.append(model[similar_word]) embedding_clusters.append(embeddings) word_clusters.append(words)

चित्र 1. Google समाचार से समान शब्दों के समूह अलग-अलग preplexity मानों के साथ।

चित्र 1. Google समाचार से समान शब्दों के समूह अलग-अलग preplexity मानों के साथ।अगला, हम लेख के सबसे उल्लेखनीय टुकड़े, टी-एसएनई कॉन्फ़िगरेशन की ओर मुड़ते हैं। यहां, सबसे पहले, आपको निम्नलिखित हाइपरपैरामीटर पर ध्यान देना चाहिए:

- n_compenders - घटकों की संख्या, अर्थात्, मूल्य स्थान का आयाम;

- perplexity - perplexity, t-SNE में जिसका मूल्य पड़ोसियों की प्रभावी संख्या के बराबर हो सकता है। यह निकटतम पड़ोसियों की संख्या से संबंधित है, जिसका उपयोग किस्मों के आधार पर सीखने वाले अन्य मॉडलों में किया जाता है (ऊपर चित्र देखें)। इसके मूल्य की सिफारिश की जाती है [१] जिसे ५-५० की सीमा में रखा जाना है;

- init - वैक्टर के प्रारंभिक प्रारंभिक प्रकार।

tsne_model_en_2d = TSNE(perplexity=15, n_components=2, init='pca', n_iter=3500, random_state=32) embedding_clusters = np.array(embedding_clusters) n, m, k = embedding_clusters.shape embeddings_en_2d = np.array(tsne_model_en_2d.fit_transform(embedding_clusters.reshape(n * m, k))).reshape(n, m, 2)

नीचे Matplotlib का उपयोग करके द्वि-आयामी ग्राफ़ बनाने के लिए एक स्क्रिप्ट है, जो Pyon में डेटा की कल्पना करने के लिए सबसे लोकप्रिय पुस्तकालयों में से एक है।

चित्र 2. Google समाचार से समान शब्दों के समूह (उपसर्ग = 15)।

चित्र 2. Google समाचार से समान शब्दों के समूह (उपसर्ग = 15)। from sklearn.manifold import TSNE import matplotlib.pyplot as plt import matplotlib.cm as cm import numpy as np % matplotlib inline def tsne_plot_similar_words(labels, embedding_clusters, word_clusters, a=0.7): plt.figure(figsize=(16, 9)) colors = cm.rainbow(np.linspace(0, 1, len(labels))) for label, embeddings, words, color in zip(labels, embedding_clusters, word_clusters, colors): x = embeddings[:,0] y = embeddings[:,1] plt.scatter(x, y, c=color, alpha=a, label=label) for i, word in enumerate(words): plt.annotate(word, alpha=0.5, xy=(x[i], y[i]), xytext=(5, 2), textcoords='offset points', ha='right', va='bottom', size=8) plt.legend(loc=4) plt.grid(True) plt.savefig("f/.png", format='png', dpi=150, bbox_inches='tight') plt.show() tsne_plot_similar_words(keys, embeddings_en_2d, word_clusters)

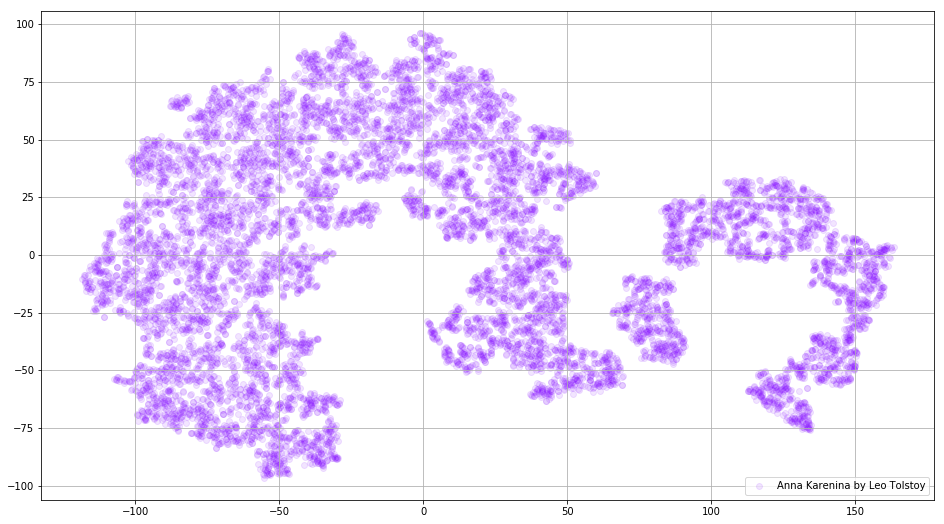

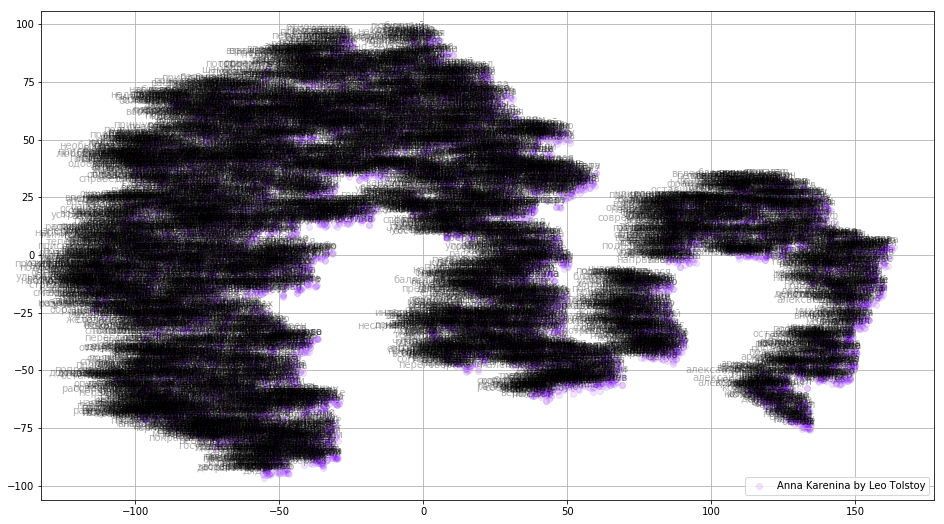

कभी-कभी शब्दों के अलग-अलग समूहों को नहीं, बल्कि पूरे शब्दकोश को बनाना आवश्यक होता है। इस उद्देश्य के लिए, हम अन्ना कारेनिना का विश्लेषण करें, जो जुनून, विश्वासघात, त्रासदी और प्रायश्चित की महान कहानी है।

prepare_for_w2v('data/Anna Karenina by Leo Tolstoy (ru).txt', 'train_anna_karenina_ru.txt', 'russian') model_ak = train_word2vec('train_anna_karenina_ru.txt') words = [] embeddings = [] for word in list(model_ak.wv.vocab): embeddings.append(model_ak.wv[word]) words.append(word) tsne_ak_2d = TSNE(n_components=2, init='pca', n_iter=3500, random_state=32) embeddings_ak_2d = tsne_ak_2d.fit_transform(embeddings)

def tsne_plot_2d(label, embeddings, words=[], a=1): plt.figure(figsize=(16, 9)) colors = cm.rainbow(np.linspace(0, 1, 1)) x = embeddings[:,0] y = embeddings[:,1] plt.scatter(x, y, c=colors, alpha=a, label=label) for i, word in enumerate(words): plt.annotate(word, alpha=0.3, xy=(x[i], y[i]), xytext=(5, 2), textcoords='offset points', ha='right', va='bottom', size=10) plt.legend(loc=4) plt.grid(True) plt.savefig("hhh.png", format='png', dpi=150, bbox_inches='tight') plt.show() tsne_plot_2d('Anna Karenina by Leo Tolstoy', embeddings_ak_2d, a=0.1)

चित्रा 3. वर्ड 2 वीईसी-मॉडल के शब्दकोश का विज़ुअलाइज़ेशन, उपन्यास "अन्ना कारिनाना" पर प्रशिक्षित।

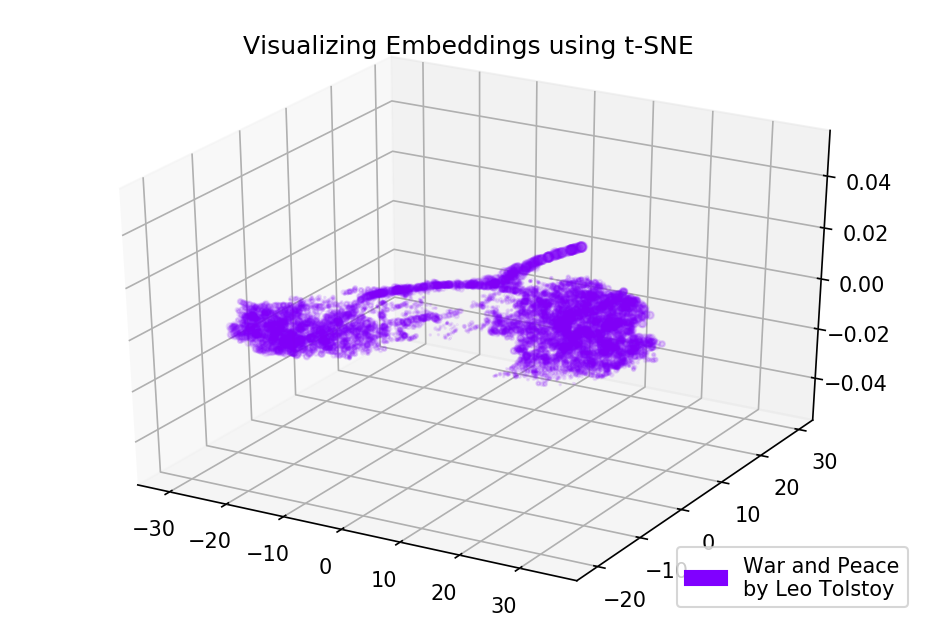

चित्रा 3. वर्ड 2 वीईसी-मॉडल के शब्दकोश का विज़ुअलाइज़ेशन, उपन्यास "अन्ना कारिनाना" पर प्रशिक्षित।यदि हम त्रि-आयामी अंतरिक्ष का उपयोग करते हैं तो चित्र और भी अधिक जानकारीपूर्ण बन सकता है। विश्व साहित्य के प्रमुख उपन्यासों में से एक, वॉर एंड पीस पर एक नज़र।

prepare_for_w2v('data/War and Peace by Leo Tolstoy (ru).txt', 'train_war_and_peace_ru.txt', 'russian') model_wp = train_word2vec('train_war_and_peace_ru.txt') words_wp = [] embeddings_wp = [] for word in list(model_wp.wv.vocab): embeddings_wp.append(model_wp.wv[word]) words_wp.append(word) tsne_wp_3d = TSNE(perplexity=30, n_components=3, init='pca', n_iter=3500, random_state=12) embeddings_wp_3d = tsne_wp_3d.fit_transform(embeddings_wp)

from mpl_toolkits.mplot3d import Axes3D def tsne_plot_3d(title, label, embeddings, a=1): fig = plt.figure() ax = Axes3D(fig) colors = cm.rainbow(np.linspace(0, 1, 1)) plt.scatter(embeddings[:, 0], embeddings[:, 1], embeddings[:, 2], c=colors, alpha=a, label=label) plt.legend(loc=4) plt.title(title) plt.show() tsne_plot_3d('Visualizing Embeddings using t-SNE', 'War and Peace', embeddings_wp_3d, a=0.1)

चित्र 4. शब्द "युद्ध और शांति" पर प्रशिक्षित शब्द Word2Vec- मॉडल का विज़ुअलाइज़ेशन।

चित्र 4. शब्द "युद्ध और शांति" पर प्रशिक्षित शब्द Word2Vec- मॉडल का विज़ुअलाइज़ेशन।स्रोत कोड

कोड

GitHub पर उपलब्ध

है । वहाँ आप एनिमेशन प्रदान करने के लिए कोड पा सकते हैं।

सूत्रों का कहना है

- Maaten L., Hinton G. Visualizing डेटा का उपयोग करके t-SNE // जर्नल ऑफ़ मशीन लर्निंग रिसर्च। - 2008. - टी। 9. - एस। 2579-2605।

- वितरित शब्द और वाक्यांश और उनकी संरचना का प्रतिनिधित्व // तंत्रिका सूचना प्रसंस्करण प्रणालियों में अग्रिम । - 2013 ।-- एस। 3111-3119।

- Rehurek R., Sojka P. बड़े कॉर्पोरा के साथ विषय मॉडलिंग के लिए सॉफ्टवेयर ढांचा // एनएलपी फ्रेमवर्क के लिए नई चुनौतियों पर LREC 2010 कार्यशाला की कार्यवाही में। - 2010।