मशीन लर्निंग अधिक सुलभ हो रही है, इस तकनीक को "ऑफ-द-शेल्फ घटकों" का उपयोग करने के लिए अधिक अवसर हैं। उदाहरण के लिए, स्थानांतरण लर्निंग आपको एक समस्या को हल करने में प्राप्त अनुभव का उपयोग करने की अनुमति देता है, दूसरी समस्या। तंत्रिका नेटवर्क को पहले बड़ी मात्रा में डेटा, फिर लक्ष्य सेट पर प्रशिक्षित किया जाता है।

इस लेख में मैं आपको बताऊंगा कि भोजन के साथ छवियों की मान्यता के उदाहरण का उपयोग करके स्थानांतरण अधिगम विधि का उपयोग कैसे करें। मैं

डेवलपर कार्यशाला के

लिए मशीन लर्निंग और न्यूरल नेटवर्क पर अन्य मशीन लर्निंग टूल्स के बारे में बात करूंगा।

यदि हमें छवि पहचान के कार्य का सामना करना पड़ता है, तो आप तैयार सेवा का उपयोग कर सकते हैं। हालांकि, यदि आपको अपने स्वयं के डेटा सेट पर मॉडल को प्रशिक्षित करने की आवश्यकता है, तो आपको इसे स्वयं करना होगा।

छवि वर्गीकरण के रूप में ऐसे विशिष्ट कार्यों के लिए, आप तैयार आर्किटेक्चर (एलेक्सनेट, वीजीजी, इंसेप्शन, रेसनेट, आदि) का उपयोग कर सकते हैं और अपने डेटा पर तंत्रिका नेटवर्क को प्रशिक्षित कर सकते हैं। इस तरह के नेटवर्क का कार्यान्वयन विभिन्न रूपरेखाओं का उपयोग करके पहले से ही मौजूद है, इसलिए इस स्तर पर आप इसके संचालन के सिद्धांत में गहराई से बिना, एक ब्लैक बॉक्स के रूप में उपयोग कर सकते हैं।

हालांकि, गहन तंत्रिका नेटवर्क सीखने की अभिसरण के लिए बड़ी मात्रा में डेटा की मांग कर रहे हैं। और अक्सर हमारे विशेष कार्य में तंत्रिका नेटवर्क की सभी परतों को ठीक से प्रशिक्षित करने के लिए पर्याप्त डेटा नहीं होता है। स्थानांतरण लर्निंग इस समस्या को हल करता है।

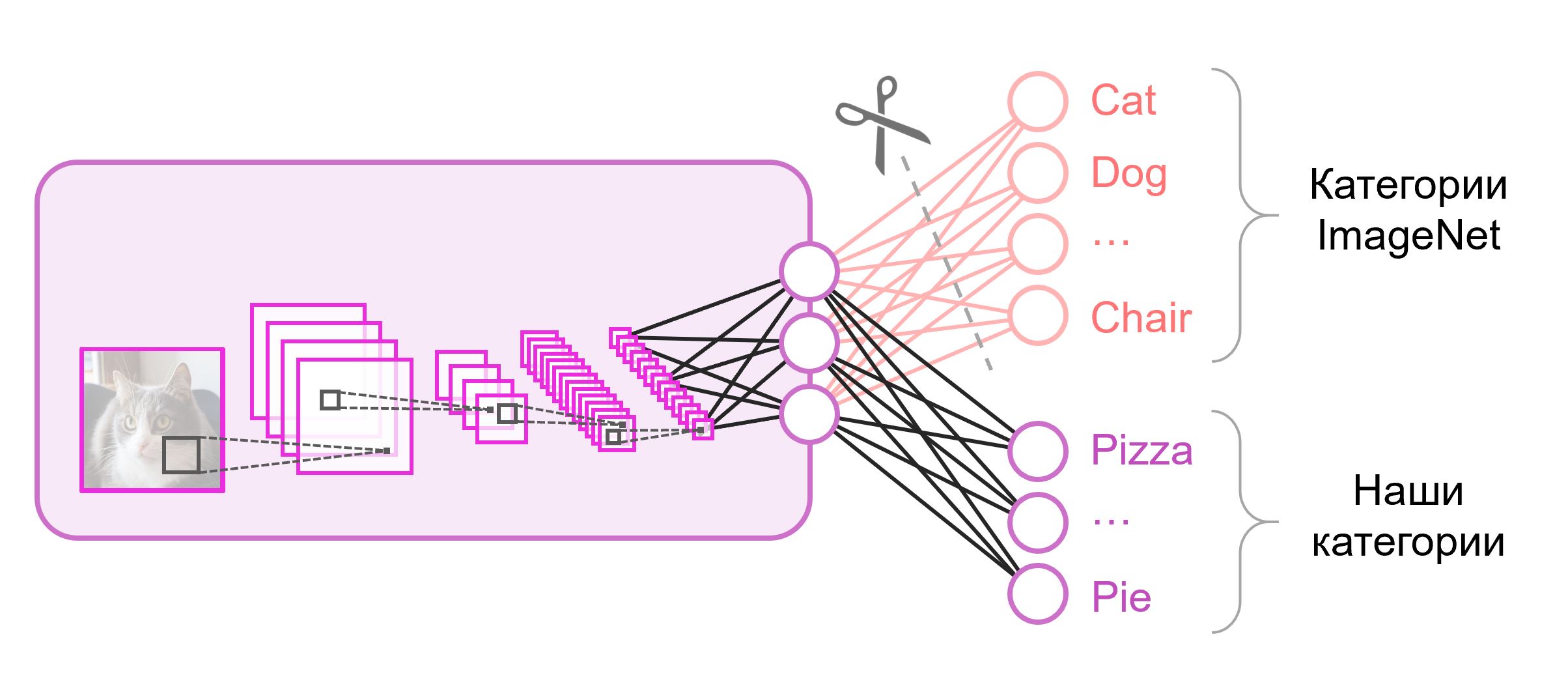

छवि वर्गीकरण के लिए स्थानांतरण सीखना

वर्गीकरण के लिए उपयोग किए जाने वाले तंत्रिका नेटवर्क में आमतौर पर अंतिम परत में

N आउटपुट न्यूरॉन्स होते हैं, जहां

N कक्षाओं की संख्या होती है। इस तरह के एक आउटपुट वेक्टर को एक वर्ग से संबंधित संभावनाओं की एक सेट के रूप में माना जाता है। भोजन छवियों को पहचानने के हमारे कार्य में, कक्षाओं की संख्या मूल डेटासेट से भिन्न हो सकती है। इस मामले में, हमें इस अंतिम परत को पूरी तरह से बाहर फेंकना होगा और एक नई संख्या में डालना होगा, जिसमें आउटपुट न्यूरॉन्स की सही संख्या होगी

अक्सर वर्गीकरण नेटवर्क के अंत में, एक पूरी तरह से जुड़ी परत का उपयोग किया जाता है। चूंकि हमने इस परत को बदल दिया है, इसलिए इसके लिए पूर्व प्रशिक्षित भार का उपयोग करना काम नहीं करेगा। यादृच्छिक मूल्यों के साथ अपने वजन को शुरू करते हुए, आपको उसे खरोंच से प्रशिक्षित करना होगा। हम पूर्व-प्रशिक्षित स्नैपशॉट से अन्य सभी परतों के लिए भार लोड करते हैं।

मॉडल को आगे के प्रशिक्षण के लिए विभिन्न रणनीतियाँ हैं। हम निम्नलिखित का उपयोग करेंगे: हम पूरे नेटवर्क को अंत से अंत (

एंड-टू-एंड )

तक प्रशिक्षित करेंगे, और हम पूर्व-प्रशिक्षित भार को ठीक नहीं करेंगे ताकि उन्हें थोड़ा समायोजित करने और हमारे डेटा को समायोजित करने की अनुमति मिल सके। इस प्रक्रिया को

फाइन-ट्यूनिंग कहा जाता

है ।

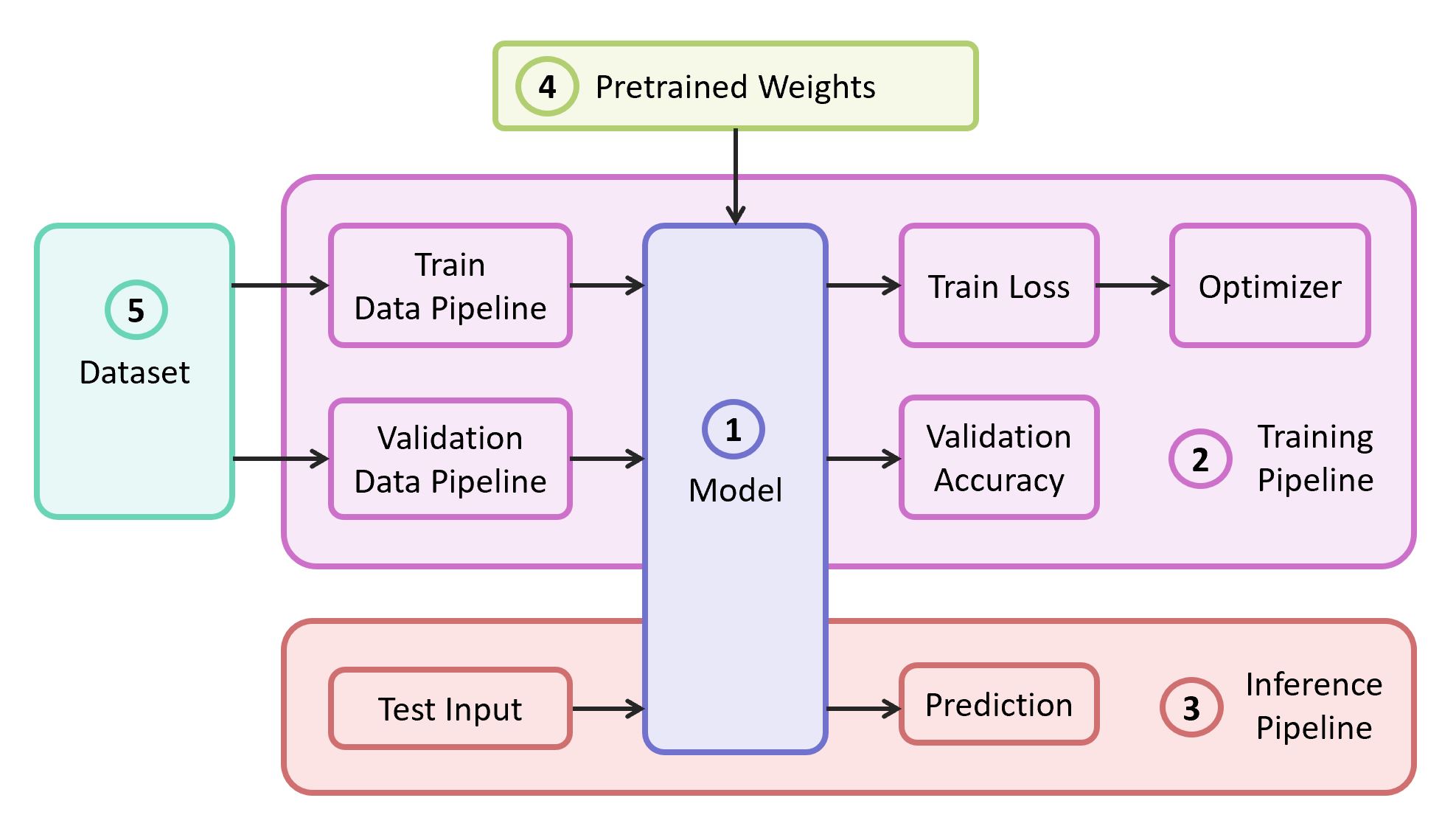

संरचनात्मक घटक

समस्या को हल करने के लिए, हमें निम्नलिखित घटकों की आवश्यकता है:

- तंत्रिका नेटवर्क मॉडल का विवरण

- लर्निंग पाइप लाइन

- हस्तक्षेप पाइपलाइन

- इस मॉडल के लिए पहले से प्रशिक्षित वजन

- प्रशिक्षण और सत्यापन के लिए डेटा

हमारे उदाहरण में, मैं

अपने स्वयं के भंडार से घटकों (1), (2) और (3) को ले

जाऊंगा , जिसमें सबसे हल्का कोड होता है - आप चाहें तो आसानी से इसका पता लगा सकते हैं। हमारा उदाहरण लोकप्रिय

TensorFlow ढांचे पर लागू किया जाएगा। चयनित ढांचे के लिए उपयुक्त पूर्व प्रशिक्षित भार (4) पाया जा सकता है यदि वे शास्त्रीय वास्तुशिल्प में से एक के अनुरूप हों। प्रदर्शन के लिए एक डेटासेट (5) के रूप में मैं

फ़ूड -१० ले लूंगा।

आदर्श

एक मॉडल के रूप में, हम क्लासिक

वीजीजी न्यूरल नेटवर्क (अधिक सटीक,

वीजीजी 19 ) का उपयोग करते हैं। कुछ नुकसान के बावजूद, यह मॉडल काफी उच्च गुणवत्ता प्रदर्शित करता है। इसके अलावा, विश्लेषण करना आसान है। TensorFlow स्लिम पर, मॉडल विवरण काफी कॉम्पैक्ट दिखता है:

import tensorflow as tf import tensorflow.contrib.slim as slim def vgg_19(inputs, num_classes, is_training, scope='vgg_19', weight_decay=0.0005): with slim.arg_scope([slim.conv2d], activation_fn=tf.nn.relu, weights_regularizer=slim.l2_regularizer(weight_decay), biases_initializer=tf.zeros_initializer(), padding='SAME'): with tf.variable_scope(scope, 'vgg_19', [inputs]): net = slim.repeat(inputs, 2, slim.conv2d, 64, [3, 3], scope='conv1') net = slim.max_pool2d(net, [2, 2], scope='pool1') net = slim.repeat(net, 2, slim.conv2d, 128, [3, 3], scope='conv2') net = slim.max_pool2d(net, [2, 2], scope='pool2') net = slim.repeat(net, 4, slim.conv2d, 256, [3, 3], scope='conv3') net = slim.max_pool2d(net, [2, 2], scope='pool3') net = slim.repeat(net, 4, slim.conv2d, 512, [3, 3], scope='conv4') net = slim.max_pool2d(net, [2, 2], scope='pool4') net = slim.repeat(net, 4, slim.conv2d, 512, [3, 3], scope='conv5') net = slim.max_pool2d(net, [2, 2], scope='pool5')

इमेजनेट पर प्रशिक्षित वीजीजी 19 के लिए वेट और टेन्सरफ्लो के साथ संगत,

प्री-प्रशिक्षित मॉडल सेक्शन से गिटहब पर रिपॉजिटरी से डाउनलोड किया गया है।

mkdir data && cd data wget http://download.tensorflow.org/models/vgg_19_2016_08_28.tar.gz tar -xzf vgg_19_2016_08_28.tar.gz

डाटासेट

प्रशिक्षण और सत्यापन नमूने के रूप में, हम सार्वजनिक

खाद्य -१०१ डेटासेट का उपयोग करेंगे, जिसमें १० हजार से अधिक खाद्य चित्र हैं, जो १०१ श्रेणियों में विभाजित हैं।

डेटासेट डाउनलोड और अनपैक करें:

cd data wget http://data.vision.ee.ethz.ch/cvl/food-101.tar.gz tar -xzf food-101.tar.gz

हमारे प्रशिक्षण में डेटा पाइपलाइन इस तरह से डिज़ाइन की गई है कि डेटासेट से हमें निम्नलिखित को पार्स करने की आवश्यकता है:

- वर्गों की सूची (श्रेणियां)

- ट्यूटोरियल: चित्रों के लिए रास्तों की सूची और सही उत्तरों की सूची

- सत्यापन सेट: चित्रों के लिए रास्तों की सूची और सही उत्तरों की सूची

यदि आपका डेटासेट, तो

ट्रेन और

सत्यापन के लिए आपको सेट को स्वयं तोड़ने की आवश्यकता है। फ़ूड -१० में पहले से ही ऐसा विभाजन है, और यह जानकारी

meta डायरेक्टरी में संग्रहीत है।

DATASET_ROOT = 'data/food-101/' train_data, val_data, classes = data.food101(DATASET_ROOT) num_classes = len(classes)

डेटा प्रोसेसिंग के लिए ज़िम्मेदार सभी सहायक फ़ंक्शंस को एक अलग

data.py फ़ाइल में ले जाया जाता है:

data.py from os.path import join as opj import tensorflow as tf def parse_ds_subset(img_root, list_fpath, classes): ''' Parse a meta file with image paths and labels -> img_root: path to the root of image folders -> list_fpath: path to the file with the list (eg train.txt) -> classes: list of class names <- (list_of_img_paths, integer_labels) ''' fpaths = [] labels = [] with open(list_fpath, 'r') as f: for line in f: class_name, image_id = line.strip().split('/') fpaths.append(opj(img_root, class_name, image_id+'.jpg')) labels.append(classes.index(class_name)) return fpaths, labels def food101(dataset_root): ''' Get lists of train and validation examples for Food-101 dataset -> dataset_root: root of the Food-101 dataset <- ((train_fpaths, train_labels), (val_fpaths, val_labels), classes) ''' img_root = opj(dataset_root, 'images') train_list_fpath = opj(dataset_root, 'meta', 'train.txt') test_list_fpath = opj(dataset_root, 'meta', 'test.txt') classes_list_fpath = opj(dataset_root, 'meta', 'classes.txt') with open(classes_list_fpath, 'r') as f: classes = [line.strip() for line in f] train_data = parse_ds_subset(img_root, train_list_fpath, classes) val_data = parse_ds_subset(img_root, test_list_fpath, classes) return train_data, val_data, classes def imread_and_crop(fpath, inp_size, margin=0, random_crop=False): ''' Construct TF graph for image preparation: Read the file, crop and resize -> fpath: path to the JPEG image file (TF node) -> inp_size: size of the network input (eg 224) -> margin: cropping margin -> random_crop: perform random crop or central crop <- prepared image (TF node) ''' data = tf.read_file(fpath) img = tf.image.decode_jpeg(data, channels=3) img = tf.image.convert_image_dtype(img, dtype=tf.float32) shape = tf.shape(img) crop_size = tf.minimum(shape[0], shape[1]) - 2 * margin if random_crop: img = tf.random_crop(img, (crop_size, crop_size, 3)) else:

मॉडल प्रशिक्षण

मॉडल प्रशिक्षण कोड में निम्नलिखित चरण होते हैं:

- बिल्डिंग ट्रेन / सत्यापन डेटा पाइपलाइन

- बिल्डिंग ट्रेन / सत्यापन ग्राफ (नेटवर्क)

- ट्रेन ग्राफ पर नुकसान के वर्गीकरण समारोह ( क्रॉस एन्ट्रापी लॉस ) को संलग्न करना

- प्रशिक्षण के दौरान सत्यापन नमूने पर भविष्यवाणियों की सटीकता की गणना करने के लिए आवश्यक कोड

- स्नैपशॉट से पूर्व प्रशिक्षित तराजू लोड करने के लिए तर्क

- प्रशिक्षण के लिए विभिन्न संरचनाओं का निर्माण

- स्वयं सीखने का चक्र (पुनरावृत्ति अनुकूलन)

ग्राफ की अंतिम परत को आवश्यक संख्या में न्यूरॉन्स के साथ बनाया गया है और इसे पूर्व-प्रशिक्षित स्नैपशॉट से लोड किए गए मापदंडों की सूची से बाहर रखा गया है।

मॉडल प्रशिक्षण कोड import numpy as np import tensorflow as tf import tensorflow.contrib.slim as slim tf.logging.set_verbosity(tf.logging.INFO) import model import data

प्रशिक्षण शुरू करने के बाद, आप TensorBoard उपयोगिता का उपयोग करके इसकी प्रगति को देख सकते हैं, जो TensorFlow के साथ बंडल में आता है और विभिन्न मैट्रिक्स और अन्य मापदंडों की कल्पना करने के लिए कार्य करता है।

tensorboard --logdir checkpoints/

TensorBoard में प्रशिक्षण के अंत में, हम एक लगभग सही तस्वीर देखते हैं:

ट्रेन की कमी में

कमी और वैधता

सटीकता में वृद्धि

नतीजतन, हमें

checkpoints/vgg19_food में सहेजे गए स्नैपशॉट

checkpoints/vgg19_food , जिसका उपयोग हम अपने मॉडल (

checkpoints/vgg19_food के परीक्षण के दौरान करेंगे।

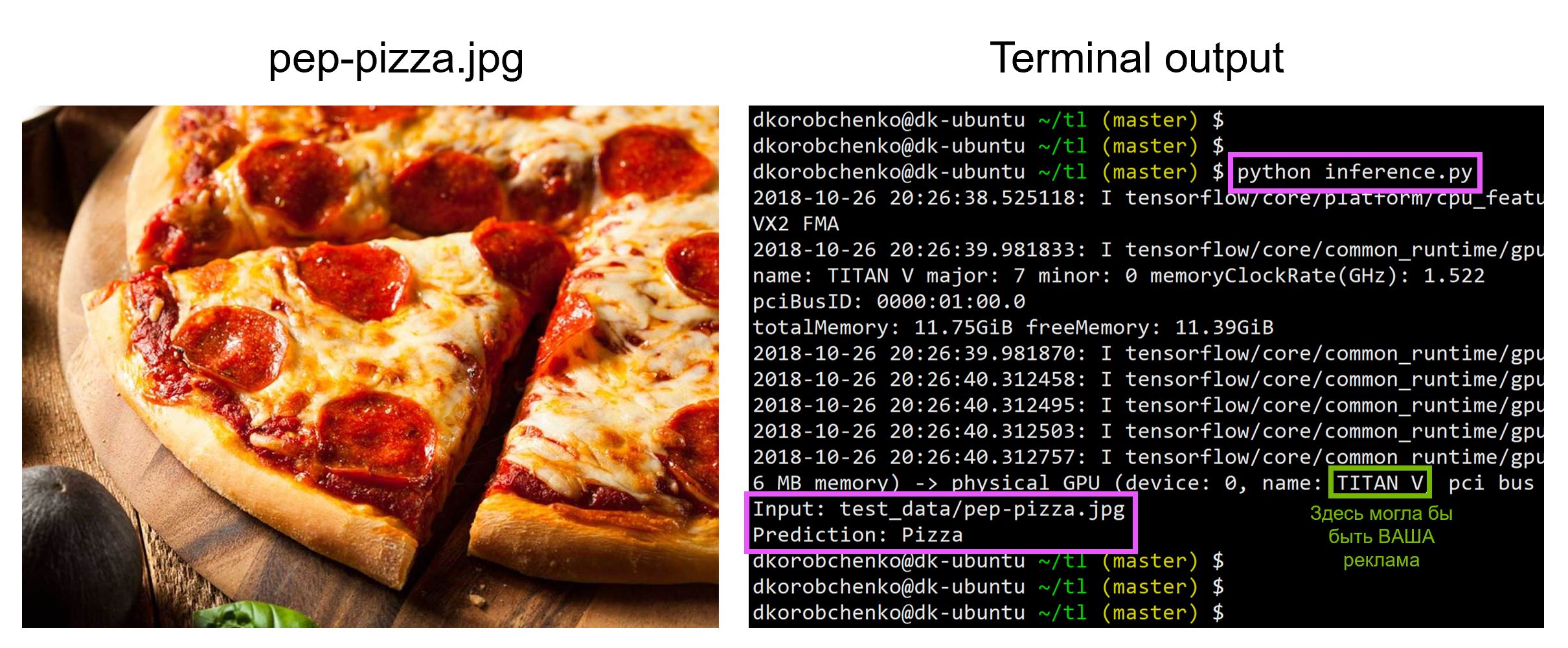

मॉडल परीक्षण

अब हमारे मॉडल का परीक्षण करें। ऐसा करने के लिए:

- हम विशेष रूप से अनुमान के लिए डिज़ाइन किया गया एक नया ग्राफ

is_training=False ( is_training=False ) - एक स्नैपशॉट से भार प्रशिक्षित भार

- डाउनलोड करें और इनपुट परीक्षण छवि को प्रीप्रोसेस करें।

- चलो तंत्रिका नेटवर्क के माध्यम से छवि को ड्राइव करें और भविष्यवाणी प्राप्त करें

inference.py import sys import numpy as np import imageio from skimage.transform import resize import tensorflow as tf import model

पुस्तकालयों के सभी आवश्यक संस्करणों के साथ डॉक कंटेनर बनाने और चलाने के लिए संसाधनों सहित सभी कोड,

इस भंडार में है - लेख पढ़ने के समय, रिपॉजिटरी के कोड में अपडेट हो सकते हैं।

कार्यशाला में

"मशीन लर्निंग और डेवलपर्स के लिए तंत्रिका नेटवर्क" मैं मशीन सीखने के अन्य कार्यों का विश्लेषण करेगा, और छात्र गहन सत्र के अंत तक अपनी परियोजनाओं को प्रस्तुत करेंगे।