हमने ओपनएआई में पाया कि ढाल शोर स्केल, एक सरल सांख्यिकीय पद्धति, कार्यों की एक विस्तृत श्रृंखला में तटस्थ नेटवर्क सीखने की समानांतरता की भविष्यवाणी करती है। चूंकि ढाल आमतौर पर अधिक जटिल कार्यों के लिए noisier हो जाता है, एक साथ प्रसंस्करण के लिए उपलब्ध पैकेट के आकार में वृद्धि भविष्य में उपयोगी साबित होगी, और एआई सिस्टम की संभावित सीमाओं में से एक को समाप्त कर देगी। सामान्य स्थिति में, ये परिणाम दर्शाते हैं कि तंत्रिका नेटवर्क के प्रशिक्षण को एक रहस्यमय कला नहीं माना जाना चाहिए, और इसे सटीकता और व्यवस्थित रूप दिया जा सकता है।

पिछले कुछ वर्षों में, एआई शोधकर्ता कई कंप्यूटरों में डेटा के बड़े पैकेटों को तोड़कर, डेटा को समानांतर करके तंत्रिका नेटवर्क सीखने में तेजी लाने में तेजी से सफल रहे हैं। शोधकर्ताओं ने

छवि वर्गीकरण और

भाषा मॉडलिंग के लिए हजारों इकाइयों का सफलतापूर्वक उपयोग किया

है , और यहां तक कि लाखों

सुदृढीकरण सीखने वाले एजेंटों के लिए भी जिन्होंने डोटा 2 खेला है। ऐसे बड़े पैकेज हमें कंप्यूटिंग शक्ति की मात्रा बढ़ाने की अनुमति देते हैं जो प्रभावी रूप से एक मॉडल को सिखाने में शामिल हैं, और एक हैं एआई

प्रशिक्षण में वृद्धि ड्राइविंग बलों की। हालांकि, डेटा पैकेट के साथ, जो बहुत बड़े हैं, एल्गोरिथम रिटर्न में तेजी से कमी है, और यह स्पष्ट नहीं है कि ये प्रतिबंध कुछ कार्यों के लिए बड़ा और दूसरों के लिए छोटा क्यों है।

विभिन्न समस्याओं के लिए महत्वपूर्ण डेटा पैकेट के आकार भिन्नता के अधिकांश (r 2 = 80%) के लिए, प्रशिक्षण दृष्टिकोण पर औसत ग्रेडेड शोर स्केलिंग, परिमाण के छह आदेशों से भिन्न होता है। पैकेज का आकार छवियों की संख्या, टोकन (भाषा मॉडल के लिए) या टिप्पणियों (खेल के लिए) में मापा जाता है।

विभिन्न समस्याओं के लिए महत्वपूर्ण डेटा पैकेट के आकार भिन्नता के अधिकांश (r 2 = 80%) के लिए, प्रशिक्षण दृष्टिकोण पर औसत ग्रेडेड शोर स्केलिंग, परिमाण के छह आदेशों से भिन्न होता है। पैकेज का आकार छवियों की संख्या, टोकन (भाषा मॉडल के लिए) या टिप्पणियों (खेल के लिए) में मापा जाता है।हमने पाया कि ढाल के शोर के पैमाने को मापकर, सरल आँकड़े जो कि नेटवर्क के ग्रेडिएंट में सिग्नल-टू-शोर अनुपात को निर्धारित करते हैं, हम अधिकतम पैकेट आकार का अनुमान लगा सकते हैं। स्वाभाविक रूप से, शोर पैमाने मॉडल के दृष्टिकोण से डेटा की भिन्नता को मापता है (प्रशिक्षण के एक विशेष चरण में)। जब शोर पैमाना छोटा होता है, तो बड़ी मात्रा में डेटा पर समानांतर सीखना जल्दी से बेमानी हो जाता है, और जब यह बड़ा होता है, तो हम बड़े डेटा सेट पर बहुत कुछ सीख सकते हैं।

इस तरह के आंकड़े व्यापक रूप से

नमूने के आकार को

निर्धारित करने के

लिए उपयोग किए जाते हैं, और इसे

गहन सीखने में

उपयोग करने का

सुझाव दिया गया था, लेकिन यह तंत्रिका नेटवर्क के आधुनिक प्रशिक्षण के लिए व्यवस्थित रूप से उपयोग नहीं किया गया था। हमने उपर्युक्त ग्राफ में दर्शाए गए मशीन लर्निंग कार्यों की एक विस्तृत श्रृंखला के लिए इस भविष्यवाणी की पुष्टि की है, जिसमें पैटर्न मान्यता, भाषा मॉडलिंग, अटारी और डोटा गेम्स शामिल हैं। विशेष रूप से, हमने विभिन्न आकारों के डेटा पैकेटों पर (इनमें से प्रत्येक के लिए सीखने की गति को समायोजित करते हुए), और शोर पैमाने द्वारा भविष्यवाणी के साथ सीखने के त्वरण की तुलना करने के लिए डिज़ाइन किए गए तंत्रिका नेटवर्क को प्रशिक्षित किया। चूंकि बड़े डेटा पैकेट के लिए अक्सर सावधानीपूर्वक और महंगे समायोजन की आवश्यकता होती है या प्रशिक्षण को प्रभावी बनाने के लिए सीखने की गति का एक विशेष शेड्यूल होता है, अग्रिम में ऊपरी सीमा को जानते हुए, आप नए मॉडल का प्रशिक्षण लेते समय एक महत्वपूर्ण लाभ प्राप्त कर सकते हैं।

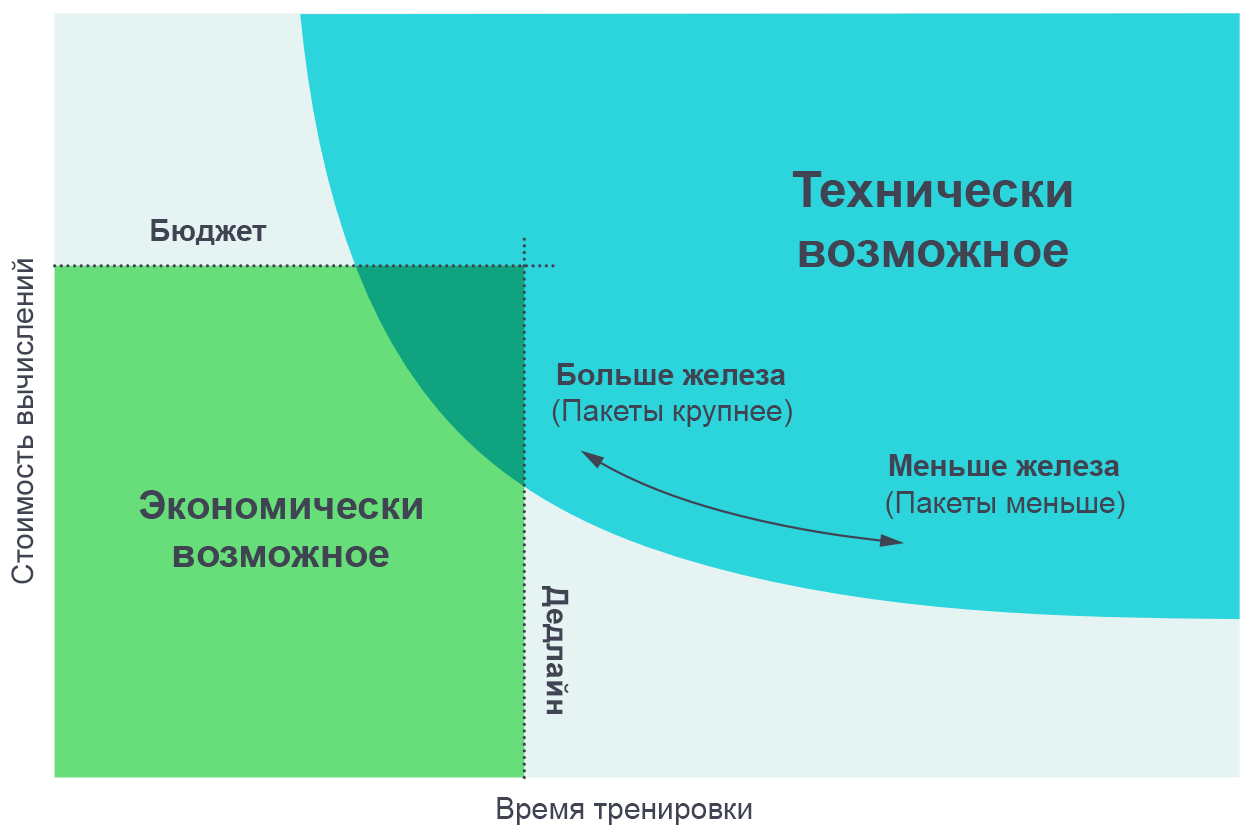

हमने इन प्रयोगों के परिणामों को वास्तविक प्रशिक्षण समय और प्रशिक्षण के लिए आवश्यक गणना की कुल मात्रा (पैसे में इसकी लागत के अनुपात में) के बीच एक समझौते के रूप में कल्पना करना उपयोगी पाया। बहुत छोटे डेटा पैकेटों पर, पैकेट के आकार को दोगुना करने से अतिरिक्त कंप्यूटिंग शक्ति के उपयोग के बिना प्रशिक्षण को दो बार तेज करने की अनुमति मिलती है (हम दो बार कई व्यक्तिगत थ्रेड्स चलाते हैं जो दो बार जितनी तेजी से काम करते हैं)। बहुत बड़े डेटा मॉकअप पर, समानांतरकरण सीखने को गति नहीं देता है। मध्य में वक्र झुकता है, और ढाल शोर पैमाने पर भविष्यवाणी करता है जहां बिल्कुल मोड़ होता है।

समानांतर प्रक्रियाओं की संख्या बढ़ाने से आप उचित समय में अधिक जटिल मॉडल को प्रशिक्षित कर सकते हैं। Pareto बॉर्डर आरेख एल्गोरिदम और तराजू की तुलना की कल्पना करने का सबसे सहज तरीका है।

समानांतर प्रक्रियाओं की संख्या बढ़ाने से आप उचित समय में अधिक जटिल मॉडल को प्रशिक्षित कर सकते हैं। Pareto बॉर्डर आरेख एल्गोरिदम और तराजू की तुलना की कल्पना करने का सबसे सहज तरीका है।हम इन कर्व्स को एक टास्क (जैसे अटारी के बीम राइडर गेम में 1000 पॉइंट्स) पर एक गोल असाइन करके प्राप्त करते हैं और यह देखते हुए कि विभिन्न पैकेट साइज़ पर इस लक्ष्य को प्राप्त करने के लिए एक न्यूरल नेटवर्क को प्रशिक्षित करने में कितना समय लगता है। परिणाम हमारे मॉडल की भविष्यवाणियों के साथ बहुत सटीक रूप से मेल खाते हैं, जो हमारे द्वारा निर्धारित लक्ष्यों के विभिन्न मूल्यों को ध्यान में रखते हैं।

[

मूल लेख वाला पृष्ठ किसी दिए गए लक्ष्य को प्राप्त करने के लिए आवश्यक अनुभव और प्रशिक्षण समय के बीच एक समझौता का इंटरैक्टिव रेखांकन प्रस्तुत करता है ]

ढाल शोर पैमाने के पैटर्न

हम धीरे-धीरे शोर के पैमाने में कई पैटर्न में आए, जिसके आधार पर हम एआई प्रशिक्षण के भविष्य के बारे में धारणा बना सकते हैं।

सबसे पहले, सीखने की प्रक्रिया में हमारे प्रयोगों में, शोर का पैमाना आमतौर पर परिमाण या अधिक के क्रम से बढ़ता है। जाहिर है, इसका मतलब है कि नेटवर्क प्रशिक्षण की शुरुआत में समस्या की अधिक "स्पष्ट" विशेषताओं को सीखता है, और फिर छोटे विवरणों का अध्ययन करता है। उदाहरण के लिए, छवियों को वर्गीकृत करने के कार्य में, एक तंत्रिका नेटवर्क पहले छोटे पैमाने पर सुविधाओं की पहचान करना सीख सकता है, जैसे कि ज्यादातर छवियों पर दिखाए गए किनारों या बनावट, और बाद में इन छोटी चीजों की एक साथ तुलना करें, बिल्लियों या कुत्तों की तरह अधिक सामान्य अवधारणाएं बनाएं। चेहरे और बनावट की पूरी विविधता का अंदाजा लगाने के लिए, तंत्रिका नेटवर्क को कम संख्या में चित्र देखने की आवश्यकता होती है, इसलिए शोर का पैमाना छोटा होता है; जैसे ही नेटवर्क बड़ी वस्तुओं के बारे में अधिक जानता है, यह डुप्लिकेट डेटा पर विचार किए बिना एक ही समय में बहुत अधिक छवियों को संसाधित करने में सक्षम होगा।

हमने कुछ

प्रारंभिक संकेत देखे कि एक समान प्रभाव समान डेटा सेट से निपटने वाले अन्य मॉडलों पर भी काम करता है - अधिक शक्तिशाली मॉडल के लिए, ढाल शोर पैमाने अधिक है, लेकिन केवल इसलिए कि उनके पास कम नुकसान है। इसलिए, कुछ सबूत हैं कि प्रशिक्षण के दौरान शोर के पैमाने को बढ़ाना सिर्फ अभिसरण की एक कलाकृति नहीं है, बल्कि मॉडल में सुधार के कारण है। यदि ऐसा है, तो हम उम्मीद कर सकते हैं कि भविष्य में, बेहतर मॉडल में बड़े पैमाने पर शोर होगा और समानांतर रूप से बेहतर होगा।

दूसरे, ऐसे कार्य जो वस्तुनिष्ठ रूप से अधिक जटिल हैं, वे समानांतरकरण के लिए बेहतर हैं। एक शिक्षक के साथ शिक्षण के संदर्भ में, MNIST से SVHN और ImageNet में संक्रमण में स्पष्ट प्रगति देखी जाती है। सुदृढीकरण प्रशिक्षण के संदर्भ में, अटारी पोंग से

डोटा 1 वी 1 और

डोटा 5 वी 5 तक के संक्रमण में स्पष्ट प्रगति देखी जाती है, और इष्टतम डेटा पैकेट का आकार 10,000 गुना भिन्न होता है। इसलिए, जैसा कि एआई तेजी से जटिल कार्यों के साथ सामना करता है, यह उम्मीद की जाती है कि मॉडल तेजी से बड़े डेटा सेट के साथ सामना करेंगे।

परिणाम

डेटा समानांतरकरण की डिग्री एआई क्षमताओं के विकास की गति को गंभीरता से प्रभावित करती है। त्वरित सीखने से अधिक सक्षम मॉडल बनाने और अनुसंधान में तेजी लाने में मदद मिलती है, जिससे आप प्रत्येक पुनरावृत्ति के समय को छोटा कर सकते हैं।

पहले के एक अध्ययन में, "

एआई और गणना "

, हमने देखा कि हर 3.5 महीने में सबसे बड़े मॉडल को प्रशिक्षित करने के लिए गणना दोगुनी है, और यह ध्यान दिया कि यह प्रवृत्ति अर्थशास्त्र के समानांतर है (गणना पर पैसा खर्च करने की इच्छा) और सीखने को समानांतर करने के लिए एल्गोरिदमिक क्षमताएं। । अंतिम कारक (एल्गोरिदमिक समांतरिकीयता) की भविष्यवाणी करना अधिक कठिन है, और इसकी सीमाओं का अभी तक पूरी तरह से अध्ययन नहीं किया गया है, लेकिन हमारे वर्तमान परिणाम इसकी व्यवस्थितता और संख्यात्मक अभिव्यक्ति में एक कदम आगे का प्रतिनिधित्व करते हैं। विशेष रूप से, हमारे पास सबूत है कि किसी ज्ञात कार्य के उद्देश्य से अधिक जटिल कार्य, या अधिक शक्तिशाली मॉडल डेटा के साथ अधिक समानांतर काम करने की अनुमति देंगे। यह सीखने से संबंधित कंप्यूटिंग की घातीय वृद्धि का समर्थन करने वाला एक प्रमुख कारक होगा। और हम समानांतर मॉडल के क्षेत्र में

हाल के घटनाक्रमों पर भी विचार नहीं करते हैं, जो हमें मौजूदा समानांतर उत्पादन प्रसंस्करण में जोड़कर समानांतरकरण को और बढ़ाने की अनुमति दे सकता है।

प्रशिक्षण कंप्यूटिंग के क्षेत्र में निरंतर वृद्धि और इसके पूर्वानुमान योग्य एल्गोरिथम बेस अगले कुछ वर्षों में एआई की क्षमताओं में विस्फोटक वृद्धि की संभावना की बात करते हैं, और इस तरह के सिस्टम

के सुरक्षित और

जिम्मेदार उपयोग के प्रारंभिक

अध्ययन की आवश्यकता पर जोर देते हैं। एआई पॉलिसी बनाने में मुख्य कठिनाई यह तय करना होगा कि भविष्य के एआई सिस्टम की विशेषताओं का अनुमान लगाने के लिए इस तरह के उपायों का उपयोग कैसे किया जा सकता है, और इस ज्ञान का उपयोग उन नियमों को बनाने के लिए किया जाता है जो समाज को अपने उपयोगी गुणों को अधिकतम करने और इन प्रौद्योगिकियों के नुकसान को कम करने की अनुमति देते हैं।

OpenAI ने AI के भविष्य की भविष्यवाणी करने के लिए कठोर विश्लेषण करने की योजना बनाई है, और इस विश्लेषण द्वारा उठाए गए चुनौतियों का लगातार सामना करता है।