हमने पुराने पत्रों को छांटा और 2002 में "इंटरनेट की दुनिया" पत्रिका के लिए इल्या सेगालोविच द्वारा लिखित एक लेख आया। इसमें, वह दुनिया के आश्चर्यों के साथ इंटरनेट और खोज इंजनों की तुलना करता है, खोज प्रौद्योगिकियों पर प्रतिबिंबित करता है और अपने इतिहास को याद करता है। कार्यभार के बावजूद, इलिया ने रिकॉर्ड समय में एक लेख लिखा और यहां तक कि शब्दों की पर्याप्त विस्तृत शब्दावली प्रदान की, जो आज पढ़ने के लिए विशेष रूप से दिलचस्प है। हम लेख के साथ पत्रिका के एक इलेक्ट्रॉनिक संस्करण को खोजने में असमर्थ थे, इसलिए आज हम इसे अपने ब्लॉग पर प्रकाशित करते हैं, जिसमें से पहला लेखक, इल्या था।

दुनिया में सैकड़ों

खोज इंजन लिखे गए हैं, और यदि आप विभिन्न कार्यक्रमों में कार्यान्वित खोज कार्यों की गणना करते हैं, तो आपको हजारों का ध्यान रखने की आवश्यकता है। और कोई फर्क नहीं पड़ता कि खोज प्रक्रिया कैसे कार्यान्वित की जाती है, कोई फर्क नहीं पड़ता कि यह किस गणितीय मॉडल पर आधारित है, खोज को लागू करने वाले विचार और कार्यक्रम काफी सरल हैं। हालांकि यह सादगी, जाहिरा तौर पर, श्रेणी के अंतर्गत आती है, जिसमें वे कहते हैं "सरल लेकिन काम करता है।" एक तरह से या किसी अन्य, लेकिन यह खोज इंजन था जो दुनिया के दो नए आश्चर्यों में से एक बन गया, जिससे होमो सेपियन्स को जानकारी तक असीमित और त्वरित पहुंच प्रदान की गई। पहला चमत्कार, जाहिर है, सार्वभौमिक संचार की अपनी क्षमताओं के साथ, इंटरनेट को ऐसा माना जा सकता है।

ऐतिहासिक खोज इंजन

व्यापक धारणा है कि कार्यक्रमों की प्रत्येक नई पीढ़ी पिछले की तुलना में अधिक परिपूर्ण है। कहते हैं, पहले सब कुछ अपूर्ण था, लेकिन अब लगभग हर जगह

कृत्रिम बुद्धिमत्ता राज करती है। एक और चरम बिंदु यह है कि "नया सब कुछ अच्छी तरह से पुराना है।" मुझे लगता है कि खोज इंजन के संबंध में, सच्चाई कहीं न कहीं निहित है।

लेकिन हाल के वर्षों में वास्तव में क्या बदल गया है? एल्गोरिदम या डेटा संरचना नहीं, गणितीय मॉडल नहीं। हालाँकि वे भी। सिस्टम का उपयोग करने का प्रतिमान बदल गया है। सीधे शब्दों में कहें, एक गृहिणी, एक सस्ता लोहे की तलाश में, और कार मैकेनिक खोजने की उम्मीद में एक सहायक बोर्डिंग स्कूल के स्नातक ने स्क्रीन पर खोज लाइन के साथ हुक दिया। पूर्व-इंटरनेट युग में असंभव कारक की उपस्थिति के अलावा - खोज इंजनों की कुल मांग का एक कारक - एक जोड़ी अधिक परिवर्तन स्पष्ट है। सबसे पहले, यह स्पष्ट हो गया कि लोग न केवल "शब्दों के साथ सोचते हैं", बल्कि "शब्दों के लिए भी देखें।" सिस्टम की प्रतिक्रिया में, वे क्वेरी स्ट्रिंग में टाइप किए गए शब्द को देखने की उम्मीद करते हैं। और दूसरा: "साधक को फिर से सिखाना", "तलाश करने के लिए फिर से पकड़ना" मुश्किल है, ठीक वैसे ही जैसे बोलने या लिखने के लिए मुकरना मुश्किल है। 60 और 80 के दशक के सपने प्रश्नों की पुनरावृत्ति के बारे में, प्राकृतिक भाषा को समझने के बारे में, अर्थ द्वारा खोज के बारे में, एक प्रश्न के सुसंगत उत्तर को उत्पन्न करने के बारे में शायद ही अब वास्तविकता की क्रूर परीक्षा खड़ी हो सकती है।

एल्गोरिथम + डेटा संरचना = खोज इंजन

किसी भी कार्यक्रम की तरह, खोज इंजन डेटा संरचनाओं के साथ संचालित होता है और एक एल्गोरिथ्म को निष्पादित करता है। एल्गोरिदम की विविधता बहुत बड़ी नहीं है, लेकिन यह है। क्वांटम कंप्यूटरों के अलावा, जो हमें खोज की "एल्गोरिथम जटिलता" में एक जादुई सफलता का वादा करते हैं, और जिसके बारे में लेखक लगभग कुछ भी नहीं जानता है, खोज एल्गोरिदम की चार कक्षाएं हैं। चार एल्गोरिदम में से तीन को "इंडेक्सिंग" की आवश्यकता होती है, दस्तावेजों की पूर्व-प्रसंस्करण, जो एक सहायक फ़ाइल बनाती है, दूसरे शब्दों में, एक "इंडेक्स", जिसे खोज को सरल बनाने और गति प्रदान करने के लिए डिज़ाइन किया गया है। ये

उल्टे फाइलें, प्रत्यय पेड़, हस्ताक्षर के एल्गोरिदम हैं। एक पतित मामले में, कोई प्रारंभिक अनुक्रमण कदम नहीं है, और खोज क्रमिक रूप से दस्तावेजों को देखने के द्वारा किया जाता है। ऐसी खोज को

प्रत्यक्ष कहा जाता है।

प्रत्यक्ष खोज

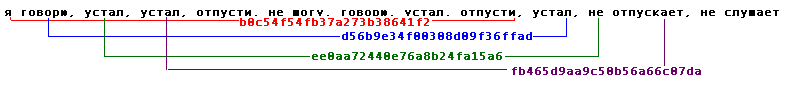

इसका सरलतम संस्करण कई लोगों के लिए जाना जाता है, और ऐसा कोई प्रोग्रामर नहीं है जो अपने जीवन में कम से कम एक बार ऐसा कोड नहीं लिखेगा:

अपनी स्पष्ट सादगी के बावजूद, प्रत्यक्ष खोज पिछले 30 वर्षों में गहन रूप से विकसित हो रही है। कई विचारों को आगे रखा गया है जो कई बार खोज समय को कम करते हैं। इन एल्गोरिदम को विभिन्न प्रकार के साहित्य में विस्तार से वर्णित किया गया है, उनके सारांश और तुलनाएं हैं। प्रत्यक्ष खोज विधियों की अच्छी समीक्षा

सेडगविक या

कॉर्मेन जैसी पाठ्यपुस्तकों में मिल

सकती है । यह ध्यान में रखा जाना चाहिए कि नए एल्गोरिदम और उनके बेहतर विकल्प लगातार दिखाई देते हैं।

यद्यपि सभी ग्रंथों को सीधे देखना एक धीमा काम है, लेकिन आपको यह नहीं सोचना चाहिए कि इंटरनेट पर प्रत्यक्ष खोज एल्गोरिदम का उपयोग नहीं किया जाता है। नॉर्वेजियन खोज इंजन फास्ट (www.fastsearch.com) ने एक

चिप का उपयोग किया जो सरल नियमित अभिव्यक्तियों के प्रत्यक्ष खोज तर्क को लागू करता है, और इनमें से 256 चिप्स को एक बोर्ड पर रखा गया है। इसने फास्ट को समय की प्रति यूनिट काफी अनुरोधों की सेवा देने की अनुमति दी।

इसके अलावा, कई प्रोग्राम हैं जो ब्लॉक के अंदर और डायरेक्ट डायरेक्ट सर्च के साथ टेक्स्ट के ब्लॉक को खोजने के लिए इंडेक्स सर्च को जोड़ते हैं। उदाहरण के लिए, रनैट पर

झलक बहुत लोकप्रिय है।

सामान्य तौर पर, प्रत्यक्ष एल्गोरिदम में मौलिक रूप से विशिष्ट विशेषताओं के साथ जीत होती है। उदाहरण के लिए, अनुमानित और अस्पष्ट खोज के लिए असीमित संभावनाएं। वास्तव में, कोई भी अनुक्रमण हमेशा शर्तों के सरलीकरण और सामान्यीकरण से जुड़ा होता है, और, परिणामस्वरूप, सूचना के नुकसान के साथ। प्रत्यक्ष खोज बिना किसी विकृति के सीधे मूल दस्तावेजों पर काम करती है।

उल्टे फ़ाइल

यह सरल डेटा संरचना, अपने रहस्यमय विदेशी नाम के बावजूद, सहज रूप से किसी भी साक्षर व्यक्ति और किसी भी डेटाबेस प्रोग्रामर से परिचित है, जिसने पूर्ण-पाठ खोज से भी निपटा नहीं है। "सहमति" के अनुसार, लोगों की पहली श्रेणी को पता है कि - वर्णानुक्रम में एक पाठ या एक लेखक से संबंधित शब्दों की विस्तृत सूची का आदेश दिया गया है (उदाहरण के लिए, "ए। एस। पुश्किन द्वारा छंदों की सहमति", "एफ-एम। डस्टोव्स्की द्वारा पत्रकारिता का शब्दकोश-संयोजन") )। जब भी वे "कुंजी क्षेत्र द्वारा डेटाबेस इंडेक्स" का निर्माण या उपयोग करते हैं, तो एक फॉर्म या किसी अन्य उल्टे सूची के साथ दूसरा सौदा।

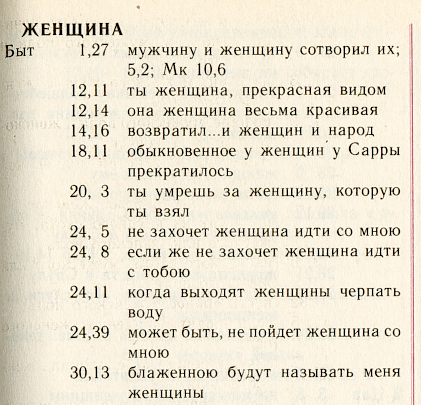

हम इस संरचना का वर्णन अद्भुत रूसी सहमति -

"सिम्फनी" की मदद से करेंगे, जो बाइबिल के धर्मसभा अनुवाद के पाठ पर मॉस्को पैट्रिआर्क द्वारा जारी की गई है।

यह शब्दों की एक वर्णमाला सूची है। प्रत्येक शब्द के लिए, सभी "स्थिति" जिसमें यह शब्द होता है सूचीबद्ध हैं। खोज एल्गोरिथ्म में सही शब्द ढूंढना और मेमोरी में लोड करना पदों की पहले से ही विस्तारित सूची में शामिल है।

डिस्क स्थान को बचाने और खोज को गति देने के लिए, आमतौर पर दो चालों का सहारा लेते हैं। सबसे पहले, आप स्थिति के विवरण पर खुद को बचा सकते हैं। वास्तव में, इस तरह की अधिक विस्तृत स्थिति सेट की जाती है, उदाहरण के लिए, "सिम्फनी" के मामले में यह "पुस्तक + अध्याय + कविता" है, उल्टे फ़ाइल को संग्रहीत करने के लिए अधिक स्थान की आवश्यकता होगी।

सबसे विस्तृत संस्करण में, उल्टे फ़ाइल में आप शब्द संख्या, और पाठ की शुरुआत से बाइट्स में ऑफसेट स्टोर कर सकते हैं, और फ़ॉन्ट का रंग और आकार, और बहुत कुछ। अधिक बार, वे केवल दस्तावेज़ की संख्या, कहते हैं, बाइबिल की एक पुस्तक, और इस शब्द के उपयोग की संख्या को इंगित करते हैं। यह एक सरलीकृत संरचना है जिसे सूचना पुनर्प्राप्ति के शास्त्रीय सिद्धांत - सूचना पुनर्प्राप्ति (आईआर) में मौलिक माना जाता है।

दूसरा (पहले से असंबंधित) संपीड़न विधि: पतों के आरोही क्रम में प्रत्येक शब्द के लिए पदों की व्यवस्था करने के लिए और प्रत्येक स्थिति के लिए अपना पूरा पता नहीं, बल्कि पिछले एक से अंतर। इस सूची में हमारे पृष्ठ के लिए यह सूची कैसी दिखेगी यह हमें अध्याय संख्या तक की स्थिति याद है:

: [.1],[+11],[0],[+2],[+4],[+2],[+4],..इसके अलावा, कुछ सरल पैकिंग विधि को पते के भंडारण की विधि पर लगाया जाता है: क्यों एक छोटे से पूर्णांक के लिए बाइट्स की एक निश्चित "विशाल" संख्या आवंटित करें, क्योंकि आप इसके लिए लगभग बाइट्स आवंटित कर सकते हैं जैसे कि यह योग्य है। यहां गोलम कोड या लोकप्रिय पर्ल भाषा के अंतर्निहित फ़ंक्शन का उल्लेख करना उचित है:

pack(“w”) ।

साहित्य में, व्यापक रेंज के पैकेजिंग एल्गोरिदम का एक भारी तोपखाने भी है: अंकगणित, हफमैन, एलजेडडब्ल्यू, आदि। इस क्षेत्र में प्रगति निरंतर है। व्यवहार में, उन्हें शायद ही कभी खोज इंजन में उपयोग किया जाता है: लाभ छोटा है, और प्रोसेसर शक्ति को अक्षम रूप से खर्च किया जाता है।

सभी वर्णित ट्रिक्स के परिणामस्वरूप, उल्टे फ़ाइल का आकार, एक नियम के रूप में, स्रोत पाठ के आकार का 7 से 30 प्रतिशत तक है, पते के विवरण के आधार पर।

लाल किताब में सूचीबद्ध

उल्टे और सीधे खोज एल्गोरिदम और डेटा संरचनाओं के अलावा अन्य प्रस्तावित। सबसे पहले, ये प्रत्यय वृक्ष हैं (

मैनर और

गोननेट द्वारा पुस्तकें देखें), साथ ही साथ

हस्ताक्षर भी ।

उनमें से सबसे पहले इंटरनेट पर कार्य किया, खोज प्रणाली

OpenText का एक पेटेंट एल्गोरिथ्म है। मैं घरेलू खोज इंजनों में प्रत्यय सूचकांक में आया हूं।

दूसरा - हस्ताक्षर विधि - अपने शब्दों के

हैश मूल्यों की तालिकाओं को ब्लॉक करने के लिए एक दस्तावेज़ रूपांतरण है - खोज के दौरान "हस्ताक्षर" और "हस्ताक्षर" के अनुक्रमिक देखने।

न तो विधि को व्यापक रूप से अपनाया गया था, और इसलिए इस छोटे लेख में विस्तृत चर्चा के लायक नहीं थे।

गणितीय मॉडल

5 में से 3 सर्च इंजन और मॉड्यूल बिना किसी गणितीय मॉडल के काम करते हैं। अधिक सटीक रूप से, उनके डेवलपर्स ने खुद को एक अमूर्त मॉडल को लागू करने का कार्य निर्धारित नहीं किया है और / या इसके अस्तित्व से अनजान हैं। यहां सिद्धांत सरल है: यदि केवल कार्यक्रम कुछ पाता है। किसी भी तरह। और फिर उपयोगकर्ता यह पता लगाएगा।

हालाँकि, जैसे ही यह खोज की गुणवत्ता में सुधार करने की बात आती है, बड़ी मात्रा में जानकारी के बारे में, उपयोगकर्ता के प्रश्नों के प्रवाह के बारे में, आनुभविक रूप से चिपकाए गए गुणांक के अलावा, यह किसी प्रकार के सरल जैविक तंत्र के साथ काम करने के लिए उपयोगी साबित होता है।

खोज मॉडल वास्तविकता का एक निश्चित सरलीकरण है, जिसके आधार पर एक सूत्र प्राप्त किया जाता है (जिसे अब किसी की आवश्यकता नहीं है), जो कार्यक्रम को निर्णय लेने की अनुमति देता है: किस दस्तावेज़ को माना जाता है और इसे कैसे रैंक किया जाए। मॉडल को अपनाने के बाद, गुणांक अक्सर भौतिक अर्थ प्राप्त करते हैं और खुद डेवलपर के लिए अधिक समझने योग्य हो जाते हैं, और उन्हें चुनना अधिक दिलचस्प हो जाता है।

पारंपरिक सूचना पुनर्प्राप्ति (IR) के मॉडल की पूरी विविधता को आमतौर पर तीन प्रकारों में विभाजित किया जाता है: सेट-थियेट्रिक (बुलियन, फ़ज़ी सेट, विस्तारित बुलियन),

बीजीय (वेक्टर, सामान्यीकृत वेक्टर, अव्यक्त-अर्थ, तंत्रिका नेटवर्क) और संभाव्य।

मॉडल का बूलियन परिवार, वास्तव में, पहला प्रोग्रामर के दिमाग में आता है जो पूर्ण-पाठ खोज को लागू करता है। एक शब्द है - एक दस्तावेज़ को माना जाता है, नहीं - नहीं मिला। दरअसल, शास्त्रीय बूलियन मॉडल एक पुल है जो खोज और डेटा हेरफेर के सिद्धांत के साथ सूचना पुनर्प्राप्ति के सिद्धांत को जोड़ता है।

बूलियन मॉडल की आलोचना, काफी निष्पक्ष है, रैंकिंग के लिए अपनी चरम कठोरता और अविवेकीता में शामिल है। इसलिए, 1957 में, जॉइस और नीडम (जॉइस और नीडम)

ने शब्दों की आवृत्ति विशेषताओं को ध्यान में रखते हुए

सुझाव दिया कि "... तुलना ऑपरेशन वैक्टर के बीच की दूरी का अनुपात होगा ..."।

खोज मॉडल SMART (Salton's Magical Automatic Retriever of Text) में सूचना पुनर्प्राप्ति के विज्ञान के संस्थापक पिता जेरार्ड सैलटन (गेरार्ड सैलटन) द्वारा 1968 में

वेक्टर मॉडल को सफलतापूर्वक लागू किया गया था। इस मॉडल में रैंकिंग एक प्राकृतिक सांख्यिकीय अवलोकन पर आधारित है जो किसी दस्तावेज़ (टर्म) में किसी शब्द की स्थानीय आवृत्ति जितनी अधिक होती है और एक संग्रह (IDF) में एक शब्द के "दुर्लभ" (

दस्तावेज़ों में वापसी घटना ), शब्द के संबंध में इस दस्तावेज़ का वजन जितना अधिक होता है। ।

* जेरार्ड सैलटन (साहलमैन) 1927-1995। वह सेल्टन है, वह ज़ाल्टन है और यहाँ तक कि ज़ालमान भी, वह गेरार्ड, जेरार्ड, जेरार्ड या यहाँ तक कि जेराल्ड है, जो अनुवादक और किए गए टाइपो के स्वाद पर निर्भर करता है।

http://www.cs.cornell.edu/Info/Department/Annual95/Faculty/Salton.html

http://www.informatik.uni-trier.de/~ley/db/indices/a-tree/s/Salton:Gerald.html

http://www.cs.virginia.edu/~clv2m/salton.txt

शब्द विशिष्टता के बारे में एक

लेख में 1972 में करेन स्पार्क-जोन्स (करेन स्पार्क-जोन्स) द्वारा आईडीएफ पदनाम पेश किया गया था। अब से, पदनाम TF * IDF का व्यापक रूप से वेक्टर मॉडल के पर्याय के रूप में उपयोग किया जाता है।

अंत में, 1977 में, रॉबर्टसन और स्पार्क-जोन्स (

रॉबर्टसन और स्पार्क-जोन्स) ने एक

संभावित मॉडल (1960 में वापस

प्रस्तावित ) को लागू किया, जिसने पूरे परिवार की नींव भी रखी। इस मॉडल में

प्रासंगिकता इस संभावना के रूप में मानी जाती है कि यह दस्तावेज़ उपयोगकर्ता के लिए दिलचस्पी का हो सकता है। यह उपयोगकर्ता द्वारा चयनित प्रासंगिक दस्तावेजों के पहले से ही मौजूद प्रारंभिक सेट की उपस्थिति या कुछ सरलीकृत धारणा के तहत स्वचालित रूप से प्राप्त होता है। प्रत्येक बाद के दस्तावेज़ के लिए प्रासंगिक होने की संभावना को संग्रह के बाकी "अप्रासंगिक" भाग के प्रासंगिक सेट में शर्तों की घटना के अनुपात के आधार पर गणना की जाती है। यद्यपि संभाव्य मॉडल में कुछ सैद्धांतिक लाभ होता है, क्योंकि वे "प्रासंगिक होने की संभावना" के अवरोही क्रम में दस्तावेजों की व्यवस्था करते हैं, व्यवहार में उन्हें बहुत अधिक वितरण नहीं मिला है।

मैं विवरण में नहीं जा रहा हूं और प्रत्येक मॉडल के लिए भारी सूत्र लिखूंगा। उनका सारांश, चर्चा के साथ,

"आधुनिक सूचना खोज" पुस्तक में एक संक्षिप्त रूप में 35 पृष्ठ लेता है। केवल यह ध्यान रखना महत्वपूर्ण है कि प्रत्येक परिवार में सबसे सरल मॉडल स्वतंत्रता शब्द की धारणा से आगे बढ़ता है और इसकी एक साधारण फ़िल्टरिंग स्थिति होती है: जिन दस्तावेज़ों में क्वेरी शब्द नहीं होते हैं, वे कभी नहीं मिलते हैं। प्रत्येक परिवार के उन्नत ("वैकल्पिक") मॉडल क्वेरी शब्द को स्वतंत्र नहीं मानते हैं, लेकिन, इसके अलावा, आपको उन दस्तावेज़ों को खोजने की अनुमति देता है जिनमें क्वेरी से एक भी शब्द नहीं है।

"समझ से" खोजें

उन दस्तावेजों को खोजने और रैंक करने की क्षमता जिसमें क्वेरी से शब्द नहीं होते हैं, उन्हें अक्सर कृत्रिम बुद्धिमत्ता का संकेत या अर्थ द्वारा खोज माना जाता है और एक प्राथमिकता मॉडल के फायदे से संबंधित होती है। यह है या नहीं, इस सवाल का जवाब हम इस लेख के दायरे से बाहर छोड़ देंगे।

उदाहरण के लिए, मैं केवल एक का वर्णन करूंगा, शायद सबसे लोकप्रिय मॉडल जो अर्थ द्वारा काम करता है। सूचना पुनर्प्राप्ति के सिद्धांत में, इस मॉडल को

अव्यक्त-अर्थ इंडेक्सिंग (दूसरे शब्दों में, छिपे हुए अर्थों को प्रकट करना) कहा जाता है। यह बीजगणितीय मॉडल दस्तावेजों के साथ एक आयताकार मैट्रिक्स सहयोगी शब्दों के एकवचन अपघटन पर आधारित है। मैट्रिक्स का तत्व एक आवृत्ति प्रतिक्रिया है, जो शब्द और दस्तावेज़ के कनेक्शन की डिग्री को दर्शाता है, उदाहरण के लिए, TF * IDF। मूल मिलियन-आयामी मैट्रिक्स के बजाय,

फर्नेस और

डियरवेस्टर विधि के लेखकों

ने अपने विलक्षण अपघटन के पहले

मुख्य घटकों के अनुरूप

50-150 "छिपे हुए अर्थ" का उपयोग

करने का सुझाव दिया।

एक वास्तविक मैट्रिक्स के एक विलक्षण अपघटन आकार के एम * n आकार के किसी भी अपघटन को कहा जाता है ए = यूएसवी, जहां यू आकार का ऑर्थोगोनल मैट्रिक्स है एम * एम, वी आकार का ऑर्थोगोनल मैट्रिक्स है n / n, S आकार का विकर्ण मैट्रिक्स है * n, जिनमें से तत्व हैं Ij = 0 अगर मैं j के बराबर नहीं हूँ , और s ii = s i > = 0. मात्रा si को मैट्रिक्स की एकवचन संख्या कहा जाता है और मैट्रिक्स AA T के संबंधित आइगेनवैल्यूज़ के वर्गाकार जड़ों के अंकगणितीय मानों के बराबर हैं । अंग्रेजी साहित्य में, एकवचन अपघटन को आमतौर पर SVD अपघटन कहा जाता है।

यह

एक लंबे समय से पहले

साबित हो गया था कि अगर हम पहले k एकवचन संख्या को ध्यान में रखते हैं (शेष को शून्य के बराबर करते हैं), तो हमें रैंक k के प्रारंभिक मैट्रिक्स का निकटतम संभव अनुमान प्राप्त होता है (एक अर्थ में, इसकी "रैंक k की निकटतम अर्थ संबंधी व्याख्या")। रैंक को कम करके, हम अप्रासंगिक विवरणों को फ़िल्टर करते हैं; बढ़ते हुए, हम वास्तविक डेटा की संरचना की सभी बारीकियों को प्रतिबिंबित करने का प्रयास करते हैं।

समान दस्तावेजों को खोजने या खोजने के कार्यों

को बहुत सरल किया गया है, क्योंकि प्रत्येक शब्द और प्रत्येक दस्तावेज़ k के अर्थ के अपेक्षाकृत छोटे वेक्टर (संबंधित मेट्रिक्स की पंक्तियों और स्तंभों) से जुड़ा हुआ है। हालांकि, "अर्थ", या

किसी अन्य कारण से कम अर्थपूर्णता के कारण, खोज के लिए माथे में एलएसआई का उपयोग अभी तक व्यापक नहीं हुआ है। यद्यपि सहायक उद्देश्यों के लिए (स्वचालित फ़िल्टरिंग, वर्गीकरण, संग्रह को अलग करना, अन्य मॉडलों के लिए आयामों का प्रारंभिक कम होना), यह विधि अनुप्रयोग खोजने में लगती है।

गुणवत्ता का आकलन

संगतता जाँच से पता चला है कि किन्हीं भी दो एसेज़रों के बीच प्रासंगिक दस्तावेज़ों का ओवरलैप औसतन 40% के क्रम पर है ... क्रॉस-एसेसर रिकॉल और लगभग 65% की परिशुद्धता ... यह 65% की पुनर्प्राप्ति प्रणाली के प्रदर्शन पर एक व्यावहारिक ऊपरी सीमा का मतलब है ...

डोना हरमन

हमने TREC से जो सीखा है, और नहीं सीखा है

अनुवाद", एक स्थिरता जांच से पता चला है कि किसी भी दो मूल्यांकनकर्ताओं के बीच प्रासंगिक दस्तावेजों का ओवरलैप औसतन लगभग 40% है ... मूल्यांकनकर्ताओं के बीच की सटीकता और पूर्णता लगभग 65% है ... यह 65% के क्षेत्र में खोज की गुणवत्ता पर एक व्यावहारिक ऊपरी सीमा लगाता है ..."

मॉडल जो भी हो, खोज इंजन को "ट्यूनिंग" की आवश्यकता होती है - मापदंडों की खोज और ट्यूनिंग की गुणवत्ता का आकलन। गुणवत्ता मूल्यांकन खोज सिद्धांत के लिए एक विचार मौलिक है। इसके लिए यह गुणवत्ता मूल्यांकन के लिए धन्यवाद है कि हम किसी विशेष मॉडल की प्रयोज्यता या अनुपयुक्तता के बारे में बात कर सकते हैं और यहां तक कि उनके सैद्धांतिक पहलुओं पर भी चर्चा कर सकते हैं।

विशेष रूप से, खोज गुणवत्ता की प्राकृतिक सीमाओं में से एक एपिग्राफ में किया गया अवलोकन है: दो "मूल्यांकनकर्ता" (प्रासंगिकता पर फैसला जारी करने वाले विशेषज्ञ) की राय औसतन एक दूसरे के साथ बहुत बड़े पैमाने पर मेल नहीं खाती है! इसका अर्थ खोज गुणवत्ता की प्राकृतिक ऊपरी सीमा भी है, क्योंकि मूल्यांकनकर्ता की राय के साथ तुलना करके गुणवत्ता को मापा जाता है।

आमतौर पर, खोज की गुणवत्ता का आकलन करने के लिए दो मापदंडों को मापा जाता है:

- परिशुद्धता - एक खोज इंजन प्रतिक्रिया में प्रासंगिक सामग्री का अनुपात

- पूर्णता (रीकॉल) - प्रासंगिक संग्रह दस्तावेजों की कुल संख्या में पाए गए प्रासंगिक दस्तावेजों का अनुपात

इन मापदंडों का उपयोग किया गया था और अमेरिकन इंस्टीट्यूट ऑफ स्टैंडर्ड (एनआईएसटी) द्वारा बनाए गए पाठ पुनर्प्राप्ति मूल्यांकन सम्मेलन (टीआरईसी)

* के ढांचे में चुनिंदा मॉडल और उनके मापदंडों के लिए एक नियमित आधार पर उपयोग किया जाता है। 1992 में शुरू, 25 समूहों का एक संघ, अपने अस्तित्व के 12 साल तक, सम्मेलन ने महत्वपूर्ण सामग्री जमा की है, जिस पर खोज इंजन अभी भी सम्मानित हैं। प्रत्येक नियमित सम्मेलन के लिए, ब्याज के प्रत्येक क्षेत्र में नई सामग्री (तथाकथित "ट्रैक") तैयार की जा रही है। "ट्रैक" में दस्तावेजों और अनुरोधों का संग्रह शामिल है। मैं उदाहरण दूंगा:

- सभी सम्मेलनों में यादृच्छिक अनुरोधों (

तदर्थ ) को ट्रैक करें

- बहुभाषी खोज

- रूटिंग और फ़िल्टरिंग

- उच्च परिशुद्धता खोज (एक ही जवाब के साथ, समय पर प्रदर्शन)

- उपयोगकर्ता सहभागिता

- प्राकृतिक भाषा "पथ"

- "सवालों के जवाब"

- "गंदे" (बस स्कैन किए गए) ग्रंथों में खोजें

- वॉयस सर्च

- एक बहुत बड़े मामले में खोजें (20GB, 100GB, आदि)

WEB वाहिनी (हाल के सम्मेलनों में, इसे .gov डोमेन के लिए चयन द्वारा दर्शाया गया है)

- वितरित खोज और विभिन्न प्रणालियों से खोज परिणामों को मर्ज करना

* सम्मेलन सामग्री सार्वजनिक रूप से trec.nist.gov/pubs.html पर उपलब्ध हैं।खोज ही नहीं

जैसा कि TREC "रास्तों" से देखा जा सकता है, कई कार्यों को खोज के साथ निकटता से जोड़ा जाता है, या तो एक सामान्य विचारधारा (वर्गीकरण, रूटिंग, फ़िल्टरिंग, एनोटेशन) को साझा करते हैं, या खोज प्रक्रिया का एक अभिन्न अंग होने के नाते (क्लस्टरिंग के परिणाम, विस्तार और संकीर्णता प्रश्नों, प्रतिक्रिया, "क्वेरी-निर्भर" एनोटेशन, खोज इंटरफ़ेस और क्वेरी भाषाएँ)। एक भी खोज इंजन नहीं है जो कम से कम इन कार्यों में से एक में हल नहीं करना होगा।

अक्सर खोज इंजनों की प्रतियोगिता में एक या दूसरे अतिरिक्त संपत्ति की उपस्थिति एक निर्णायक तर्क है। उदाहरण के लिए, संक्षिप्त एनोटेशन जिसमें एक दस्तावेज के जानकारीपूर्ण उद्धरण शामिल होते हैं, जिसके साथ कुछ खोज इंजन अपने काम के परिणामों के साथ उन्हें प्रतियोगिता से आधा कदम आगे रहने में मदद करते हैं।

सभी कार्यों और उन्हें हल करने के तरीके के बारे में बताना असंभव है। उदाहरण के लिए, "क्वेरी एक्सटेंशन" पर विचार करें, जो आमतौर पर संबंधित शब्दों की खोज में संलग्न होकर किया जाता है। इस समस्या का समाधान दो रूपों में संभव है - स्थानीय (गतिशील) और वैश्विक (स्थिर)। स्थानीय तकनीशियन क्वेरी टेक्स्ट पर भरोसा करते हैं और केवल उस पर पाए गए दस्तावेजों का विश्लेषण करते हैं। ग्लोबल "एक्सटेंशन" थिसौरी के साथ काम कर सकता है, एक प्राथमिकता (भाषाई) दोनों और दस्तावेजों के संग्रह में स्वचालित रूप से बनाया गया है। आम तौर पर स्वीकार किए जाते हैं राय के अनुसार, thesauri के माध्यम से वैश्विक क्वेरी संशोधनों अक्षमता, खोज की सटीकता को कम करने। एक और अधिक सफल वैश्विक दृष्टिकोण WEB निर्देशिकाओं जैसे मैन्युअल रूप से निर्मित स्थैतिक वर्गीकरण पर आधारित है। इस दृष्टिकोण का व्यापक रूप से इंटरनेट खोज इंजन में संकीर्णता या क्वेरी विस्तार के संचालन में उपयोग किया जाता है।

अक्सर, अतिरिक्त सुविधाओं का कार्यान्वयन खोज के रूप में समान या बहुत समान सिद्धांतों और मॉडल पर आधारित होता है। , , , ( – TF*IDF), .

(relevance feedback),

() , .

, ,

«Term Vector Database» , «» ( ).

, . . , (, , ), . , (,

) , . , , :

—

—

( ): ,

— (

- )

—

(,

):

«», ,

— () (, )

—

:

—

,

. - (LSI, ), - , .

“Things that work well on TREC often do not produce good results on the web… Some argue that on the web, users should specify more accurately what they want and add more words to their query. We disagree vehemently with this position. If a user issues a query like «Bill Clinton» they should get reasonable results since there is a enormous amount of high quality information available on this topic”

Sergei Brin, Larry Page

The Anatomy of a Large-Scale Hypertextual Web Search Engine

अनुवाद«, TREC, … , , , . . « », , ...»

«I was struck when a Google person told me at SIGIR that the most recent Google ranking algorithm completely ignores anything discovered at TREC, because all the good Ad Hoc ranking algorithms developed over the 10 years of TREC get trashed by spam»

Mark Sanderson

अनुवाद« , - Google , TREC, , « » ...»

, : ?

, , , - , ( , . .) .

(off-page) , ́ , . , , , , – .

C , -. , «» , .

, ,

, « » , , .

, , , , , . (

– ), . .

.

. , 1999-2000 . ( ) , .

( ) , . ,

. 1998 .

, , . 1998

PageRank – , , . , (, , 80- ), .

, PageRank, ( , ) –

HITS ,

- . , (. . ) , .

, , , . , , : , . . , : (,

www.teoma.com ), ..,

.

.

, . , Google Fast, . : «» , , 100 , 30% – . .

, , : , .. , , , « ».

. : ; – .

– , , , . . : , , , , . . , .

, , , : , , .

, , . - .

Udi Manber ( ) ( agrep) 1994

, Andrei Broder ( ) 1997-

«» ( shingles, «», «»). .

(

). , , , . (, , 9) , , , 25. , . , – , , , , ( ) : ! 25 !

, , .. : « » ! . ( ; , 0%; .)

,

,

- ,

. , (

), -.

. , . .

, , . , 1997 ( Inktomi) 32- (Linux, Solaris, FreeBSD, Win32) . AltaVista, «» 64- Alpha.

(, , c)

. . , , , , . Pruning ( . , ) , . pruning, , .

– , , . , .

, (, - )

. , , , , : , .

, , , . , , , . , , , 2-4 , , , , . .

(assesor, ) – , , .

(boolean, , , ) – , , .

– , , – .

– , .

(off-page, ) – , , .

(doorways, hallways) – , ( ). .

(tagging, part of speech disambiguation, ) – c ; « ».

(duplicates) – , , ; (near duplicates, -), , .

– , , .

(inverted file, , , ) – , , , .

(index, ) – . .

(citation index) – () , , , .

(indexing, ) – ( ) – , .

(Information Retrieval, IR) – , . , . , . « », , . , , (), , , .

(cloaking) – , ( ) , , .

– . .

- – , . .

(lemmatization, ) – , .

– . .

– , .

(inverted document frequency, IDF, , ) – ( ); «» , , .

– , , , , . – , .

– . .

– , () .

– , , .

(similar document search) – , , .

(search engine, SE, - , , , , «», «») – , , .

(query, ) – .

(polysemy, homography, , , ) — .

(recall, ) – , , .

- (near-duplicates, ) – . .

(pruning) – .

– , ( ).

- – . .

(term specificity, term discriminating power, , ) – . , . , .

(regualr expression, pattern, «», «», «») – , , , . . – , .

(relevance, relevancy) – .

(signature, ) – - . - .

(inflection) – , , (), . , . (declension), – (conjugation).

(derivation) – . , .

– . .

(spam, , ) – .

– . PageRank .

– .

- (stop-words) – , , / .

, (suffix trees, suffix arrays, PAT-arrays) – , , (trie). «», ( ) . , – , . , , .

(tokenization, lexical analysis, , ) – , , , , .

(precision) — .

- (hash-value) – - (hash-function), (, ) .

() (document frequency, , ) – , .

(term frequency, TF) – .

– (shingle) – - .

PageRank – () , — . .

TF*IDF – ; , – .

Modern Information Retrieval

Baezo-Yates R. and Ribeiro-Neto B.

ACM Press Addison Wesley, 1999

The Connectivity Server: fast access to linkage information on the Web

K. Bharat, A. Broder, M. Henzinger, P. Kumara, and S. Venkatasubramanian

WWW7, 1998

http://www7.scu.edu.au/programme/fullpapers/1938/com1938.htm

The Anatomy of a Large-Scale Hypertextual Web Search Engine

S.Brin and L. Page

WWW7, 1998

http://www7.scu.edu.au/programme/fullpapers/1921/com1921.htm

Syntactic Clustering of the Web

Andrei Z. Broder, Steven C. Glassman, Mark S. Manasse

WWW6, 1997

Indexing by Latent Semantic Analysis

S. Deerwester, ST Dumais, GW Furnas, TK Landauer, R. Harshman

JASIS, 1990

http://citeseer.nj.nec.com/deerwester90indexing.html

The approximation of one matrix by another of lower rank

C. Eckart, G. Young

Psychometrika, 1936

Description and performance analysis of signature file methods

C. Faloutsos, S. Christodoulakis

ACM TOIS 1987

FAST PMC — The Pattern Matching Chip

http://www.fast.no/product/fastpmc.html

www.idi.ntnu.no/grupper/KS-grp/microarray/slides/heggebo.pdf ( , web.archive.org – . .)

Information retrieval using a Singular Value Decomposition Model of Latent Semantic Structure

GW Furnas, S. Deerwester, ST Dumais, TK Landauer, RA Harshman, LA Streeter, and KE Lochbaum

ACM SIGIR, 1988

Glimpse, Webglimpse, Unix-based search software…

http://webglimpse.org

Examples of PAT applied to the Oxford English Dictionary

Gonnet G.

University of Waterloo, 1987

What we have learned, and not learned, from TREC

Donna Harman

http://irsg.eu.org/irsg2000online/papers/harman.htm

The Thesaurus Approach to Information Retrieval

T. Joyce and RM Needham

American Documentation, 1958

Authoritative Sources in a Hyperlinked Environment

Jon M. Kleinberg

JACM, 1998

http://citeseer.nj.nec.com/87928.html

An efficient method to detect duplicates of Web documents with the use of inverted index

S. Ilyinsky, M. Kuzmin, A. Melkov, I. Segalovich

WWW2002, 2002

Suffix Arrays: A New Method for On-line String Searches

U. Manber, G. Myers

1st ACM-SIAM Symposium on Discrete Algorithms, 1990

Finding similar files in a large file system

U. Manber

USENIX Conference, 1994

ME Maron and JL Kuhns

On relevance, probabilistic indexing and information retrieval

Journal of the ACM, 1960

Open Text Corporation

http://www.opentext.com

SE Robertson and Sparck Jones K.

Relevance Weighting of Search Terms

JASIS, 1976

Algorithms in C++, Robert Sedgewick

Addison-Wesley, 1992

A Statistical Interpretation of Term Specificity and Its Application in Retrieval

Karen Sparck Jones

Journal of Documentation, 1972

The Term Vector Database: fast access to indexing terms for Web pages

R. Stata, K. Bharat, F. Maghoul

WWW9, 2000

http://www9.org/w9cdrom/159/159.html

Natural Language Information Retrieval

Tomek Strzalkowski (ed.)

Kluwer Academic Publishers, 1999

: , . , . , .

, 2000

https://www.ozon.ru/context/detail/id/33769775/

- . .. , .., ..

- , 1995