Algoritma DeepStereo menempelkan gambar Google Street View menjadi video yang halus

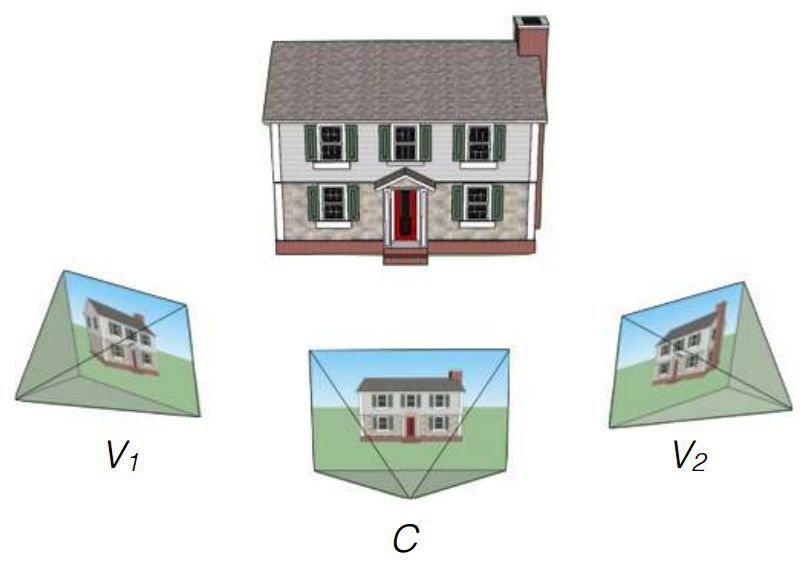

Peneliti Google John Flynn, Ivan Nyulander, James Philbin dan Noah Sneyvli menciptakan algoritma yang mampu menggabungkan gambar dari layanan tampilan Street View menjadi video yang halus dengan artefak yang hampir tidak terlihat. Algoritma ini disebut DeepStereo, contoh operasinya disajikan di atas. Kemungkinan penggunaan teknologi yang dibuat meliputi penciptaan animasi sederhana, pemrosesan gambar, bioskop dan realitas virtual.Tidak selalu mungkin untuk secara memadai mengevaluasi tempat tertentu hanya dengan peta atau foto digital. Lihatlah jalan dari ketinggian tepat di atas ketinggian manusia, membantu layanan seperti Google Street View. Tapi ini adalah foto yang terpaku pada panorama, bukan video.Jika Anda perlu membuat animasi untuk bergerak maju dari pemotretan individual, maka keputusan untuk kehilangan urutan gambar tidak akan berfungsi - itu akan berubah menjadi terlalu cepat, karena gambar akan berubah pada frekuensi setidaknya 24 frame per detik. Jika Anda berkendara di sepanjang jalan lebar atau datar yang lebar, Anda dapat membuat animasi yang bagus dalam gaya gerak lambat. Tetapi Google Street View memiliki panorama museum dan jalan-jalan berornamen - selisih waktu dari perubahan kerangka cepat tidak akan berfungsi di sini. Perlu gambar yang hilang di antara pemotretan. Algoritma yang dibuat terlibat dalam hal ini.Tim peneliti menggunakan pengetahuan luas perusahaan dalam melatih algoritma. Pada input ada satu set gambar dari beberapa titik, dan tujuannya adalah untuk membuat bingkai baru dari titik lain. Solusi tepat untuk masalah ini memerlukan pembangunan model lingkungan 3D, yang paling sering tidak mungkin karena kendala. Tantangannya bukanlah hal baru. Beberapa metode sebelumnya memiliki masalah yang menyebabkan kesenjangan di dekat penghalang, alias dan kabur. Kesulitan tertentu disebabkan oleh pohon dan benda lain yang elemen individualnya mungkin mengaburkan pandangan. Metode baru Flynn menggunakan pelatihan visi komputer sehingga ia dapat memahami benda apa yang harus ada dalam bingkai yang hilang. Untuk pelatihan, set gambar dari mobil yang bergerak digunakan. Para peneliti mengatakan bahwa volume dasar untuk pelatihan berjumlah 100 ribu set gambar.Kemudian, pengujian dilakukan menggunakan urutan tiga pemotretan dari Google Street View. Algoritma itu terpaksa memproses dua gambar ekstrem dan menghadirkan varian menengah. Perbandingan dengan yang asli diizinkan untuk mengevaluasi pekerjaan.Hasil akhir dari tim DeepStereo panggilan dipercaya. Sepintas, tidak begitu mudah dibedakan dari fotografi sungguhan. Artefak penting termasuk sedikit kehilangan resolusi dan hilangnya struktur halus di latar depan. Objek dengan struktur kompleks yang tumpang tindih detailnya sendiri mungkin tampak buram. Algoritma ini juga tidak dapat membuat permukaan yang tidak ada dalam gambar aslinya. Benda bergerak (pejalan kaki, mobil) sengaja dikaburkan untuk menciptakan efek gerakan.Diperlukan kekuatan komputasi yang mengesankan untuk rendering. Untuk membuat hanya satu gambar dengan resolusi 512 × 512 piksel, diperlukan sekitar 12 menit pengoperasian sistem multi-inti dengan karakteristik teknis yang tidak disebutkan namanya. Membuat gambar dengan resolusi lebih tinggi membutuhkan terlalu banyak RAM. Para peneliti mengungkapkan harapan mereka untuk mengoptimalkan algoritma dengan kemungkinan mengurangi waktu rendering menjadi beberapa menit atau bahkan detik saat menggunakan prosesor kartu video. Di masa depan, dengan penyempurnaan yang signifikan, fungsi algoritme pada GPU dimungkinkan bahkan dalam waktu nyata.Berdasarkan teks penelitian dan Tinjauan Teknologi MIT . arXiv: 1506.06825 [cs.CV]

Metode baru Flynn menggunakan pelatihan visi komputer sehingga ia dapat memahami benda apa yang harus ada dalam bingkai yang hilang. Untuk pelatihan, set gambar dari mobil yang bergerak digunakan. Para peneliti mengatakan bahwa volume dasar untuk pelatihan berjumlah 100 ribu set gambar.Kemudian, pengujian dilakukan menggunakan urutan tiga pemotretan dari Google Street View. Algoritma itu terpaksa memproses dua gambar ekstrem dan menghadirkan varian menengah. Perbandingan dengan yang asli diizinkan untuk mengevaluasi pekerjaan.Hasil akhir dari tim DeepStereo panggilan dipercaya. Sepintas, tidak begitu mudah dibedakan dari fotografi sungguhan. Artefak penting termasuk sedikit kehilangan resolusi dan hilangnya struktur halus di latar depan. Objek dengan struktur kompleks yang tumpang tindih detailnya sendiri mungkin tampak buram. Algoritma ini juga tidak dapat membuat permukaan yang tidak ada dalam gambar aslinya. Benda bergerak (pejalan kaki, mobil) sengaja dikaburkan untuk menciptakan efek gerakan.Diperlukan kekuatan komputasi yang mengesankan untuk rendering. Untuk membuat hanya satu gambar dengan resolusi 512 × 512 piksel, diperlukan sekitar 12 menit pengoperasian sistem multi-inti dengan karakteristik teknis yang tidak disebutkan namanya. Membuat gambar dengan resolusi lebih tinggi membutuhkan terlalu banyak RAM. Para peneliti mengungkapkan harapan mereka untuk mengoptimalkan algoritma dengan kemungkinan mengurangi waktu rendering menjadi beberapa menit atau bahkan detik saat menggunakan prosesor kartu video. Di masa depan, dengan penyempurnaan yang signifikan, fungsi algoritme pada GPU dimungkinkan bahkan dalam waktu nyata.Berdasarkan teks penelitian dan Tinjauan Teknologi MIT . arXiv: 1506.06825 [cs.CV] Source: https://habr.com/ru/post/id381787/

All Articles