Intel IoT Roadshow atau Virtual Reality di Dunia Nyata

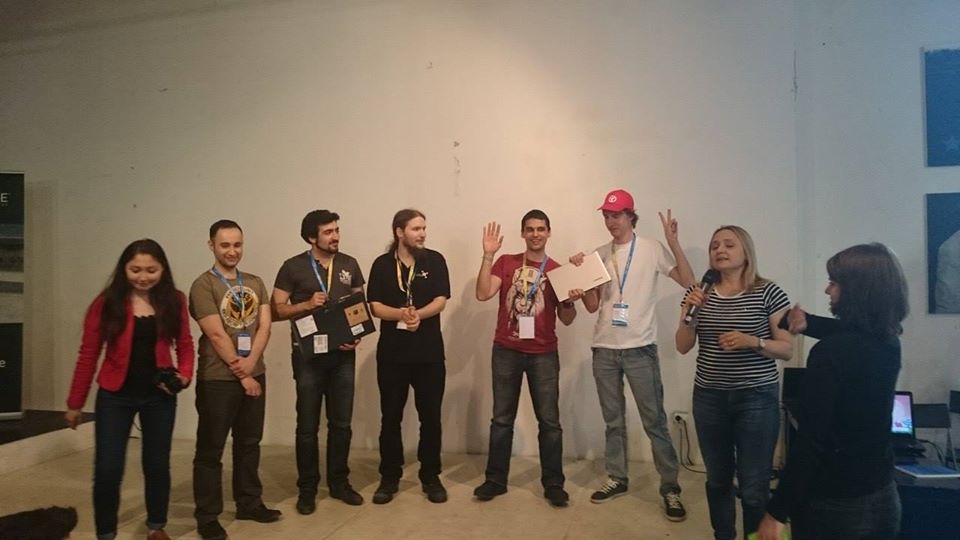

Dari 27 Juni hingga 28 Juni 2015, hackathon diselenggarakan oleh Intel, tempat proyek SenseDrive menempati posisi kedua. Selama presentasi, tim kami melihat sedikit ke masa depan dan menunjukkan bagaimana memperluas kapabilitas manusia dengan terjun ke ruang virtual yang terhubung ke Internet.

Sedikit latar belakang

Semuanya dimulai dengan konferensi DevCon 2015 , di mana saya pertama kali berkenalan dengan kemampuan teknologi RealSense , dan pada malam hari hackathon saya beruntung mengevaluasi kemampuan kamera dan RealSense SDK. Keinginan pertama saya adalah menghubungkan kamera ke kacamata realitas virtual untuk melihat tangan "virtual" saya. Namun, saya tidak dapat menemukan programmer Unity gratis dan desainer 3D di hackathon itu. Oleh karena itu, bekerja sama dengan seorang pria dari Vietnam, kami berhasil mempelajari SDK dan fitur-fitur bekerja dengan kamera dengan cukup baik untuk menunjukkan program sederhana yang membantu programmer melakukan pengisian daya mata dan memastikan bahwa programmer tidak "membodohi" tentang hal itu. Saya juga belajar bahwa dalam seminggu di St. Petersburg akan ada hackathon lain yang menggunakan teknologi ini.Jadi, sekarang saya sudah punya satu minggu untuk persiapan. Saya tertarik dengan ide saya oleh kolega Dmitry Postilgu, yang membuat sketsa antarmuka hands-free tiga dimensi untuk Windows Phone di Unity. Dan saat ini saya sedang mengembangkan kemampuan untuk mentransfer data pada posisi tangan di smartphone.Tugas ini tidak sepele, karena RealSense membutuhkan prosesor yang sangat kuat dan USB 3.0, yang karena alasan yang jelas tidak ada di smartphone kami. Saya harus menulis plug-in untuk Unity, yang menyebarkan server di telepon dan aplikasi klien untuk PC yang mentransfer paket data yang diproses ke telepon, yang memungkinkan kami untuk "menghubungkan" beberapa kamera ke kacamata virtual masa depan sekaligus untuk lebih akurat menentukan posisi tangan.Hasilnya adalah arsitektur yang cukup fleksibel di mana tidak ada perbedaan nyata untuk Unity: apakah data dari kamera berjalan lurus (untuk kasus ketika aplikasi dikerahkan pada PC) atau melalui WiFi (untuk kasus ketika aplikasi dikerahkan pada smartphone). Ke depan, arsitektur inilah yang menyelamatkan kami selama presentasi di hackathon terakhir.Minggu ternyata menjadi waktu yang sangat singkat untuk memiliki waktu untuk membuat prototipe tangan virtual, karena kami terlibat dalam proyek di waktu luang kami dari pekerjaan utama. Mereka menulis proyek bahkan di malam hari, saat bepergian dengan kereta api dari Minsk ke St. Petersburg. Sebagai hasilnya, kami menempati posisi pertama .

Juga di hackathon kedua, saya mengetahui tentang Intel IoT Roadshow yang akan datang dalam sebulan dan bertemu Maxim Massalsky dari Robot Kitchen- Laboratorium Minsk untuk Robotika. Dengan dia, kami memutuskan untuk akhirnya menyatukan dunia virtual dan nyata.Untuk mendemonstrasikan kemampuan ini, Maxim merakit robot dengan kamera bergerak, yang kami sambungkan ke papan Intel Edison dengan hackoton. Maxim meluncurkan WiFi dan menyiarkan aliran video dari kamera robot ke jaringan. Kami mengembangkan sistem perintah kontrol dan ternyata menjadi robot tempat Anda dapat "bergerak" dari realitas virtual.Robot menyiarkan apa yang dilihatnya melalui kamera video: aliran dari kamera diluncurkan pada Intel Edison langsung ke kacamata virtual, dan realitas virtual mentransfer posisi kepala dan perintah dari “tuas kontrol” virtual ke robot. Kami berhasil membuat "efek kehadiran" di kacamata pengguna di bilik kontrol avatar robot. Pada saat yang sama, pengguna tidak hanya dapat menggunakan tangannya (tanpa mouse, keyboard, atau kabel apa pun) untuk menunjukkan ke mana robot harus pergi, tetapi juga memutar kepalanya ke samping, sementara robot dengan patuh melakukan hal yang sama dengan memutar kameranya.Avatar robot memang bagus, tetapi tidak sepenuhnya jelas apa gunanya. Karena itu, satu robot tidak cukup untuk kami. Bahkan sebelum hackathon, kami mengadakan sesi brainstorming kecil untuk memunculkan cara yang lebih baik dan lebih jelas menyampaikan manfaat teknologi kepada juri. Tidak perlu mencari contoh untuk waktu yang lama, ada banyak dari mereka (beberapa dari mereka dapat Anda temukan dalam deskripsi proyek), tetapi tidak banyak yang dapat dilakukan dalam 24 jam, jadi diputuskan untuk memilih dua jenis:

Juga di hackathon kedua, saya mengetahui tentang Intel IoT Roadshow yang akan datang dalam sebulan dan bertemu Maxim Massalsky dari Robot Kitchen- Laboratorium Minsk untuk Robotika. Dengan dia, kami memutuskan untuk akhirnya menyatukan dunia virtual dan nyata.Untuk mendemonstrasikan kemampuan ini, Maxim merakit robot dengan kamera bergerak, yang kami sambungkan ke papan Intel Edison dengan hackoton. Maxim meluncurkan WiFi dan menyiarkan aliran video dari kamera robot ke jaringan. Kami mengembangkan sistem perintah kontrol dan ternyata menjadi robot tempat Anda dapat "bergerak" dari realitas virtual.Robot menyiarkan apa yang dilihatnya melalui kamera video: aliran dari kamera diluncurkan pada Intel Edison langsung ke kacamata virtual, dan realitas virtual mentransfer posisi kepala dan perintah dari “tuas kontrol” virtual ke robot. Kami berhasil membuat "efek kehadiran" di kacamata pengguna di bilik kontrol avatar robot. Pada saat yang sama, pengguna tidak hanya dapat menggunakan tangannya (tanpa mouse, keyboard, atau kabel apa pun) untuk menunjukkan ke mana robot harus pergi, tetapi juga memutar kepalanya ke samping, sementara robot dengan patuh melakukan hal yang sama dengan memutar kameranya.Avatar robot memang bagus, tetapi tidak sepenuhnya jelas apa gunanya. Karena itu, satu robot tidak cukup untuk kami. Bahkan sebelum hackathon, kami mengadakan sesi brainstorming kecil untuk memunculkan cara yang lebih baik dan lebih jelas menyampaikan manfaat teknologi kepada juri. Tidak perlu mencari contoh untuk waktu yang lama, ada banyak dari mereka (beberapa dari mereka dapat Anda temukan dalam deskripsi proyek), tetapi tidak banyak yang dapat dilakukan dalam 24 jam, jadi diputuskan untuk memilih dua jenis:- Mematikan alat listrik (toh, tidak ada yang mau rumahnya terbakar karena setrika atau kompor dihentikan dengan tergesa-gesa ketika dinyalakan);

- . , , , :) , , … , - .

Pepatah Maxim membawa beberapa servos dan relay, sisanya diputuskan untuk melihat di tempat.Sebagai alat listrik yang bisa membakar apartemen, kami menggunakan ketel listrik. Evgeny Tkachevsky, seorang pria dari Video Wings , yang tertarik dengan proyek kami dan membantu membawa ketel dari rumah pada pagi hari kedua, membantu kami dalam hal ini .Pengumpan kucing dirancang di atas kertas di kereta dalam perjalanan ke St. Petersburg, model komputer ditarik dan dicetak pada printer 3D segera setelah tiba. Tetapi dengan mencari kucing itu, semuanya menjadi lebih rumit. Tidak ada kucing di sekitar lokasi, jadi kami meminjam boneka beruang mainan dari salah satu pakar Intel. Saya harus mengatakan bahwa proyek tersebut menarik minat bahkan pada tahap pengujian. Tetap saja, tidak setiap hari Anda melihat seorang programmer dengan mata tertutup dalam kotak putih, melambaikan tangannya di depan laptop dan berdiri di samping dudukan robot, memutar roda bolak-balik dan melambaikan kepalanya ... Beberapa penonton bahkan cukup beruntung untuk menguji diri mereka sebagai pengemudi robot.

Saya harus mengatakan bahwa proyek tersebut menarik minat bahkan pada tahap pengujian. Tetap saja, tidak setiap hari Anda melihat seorang programmer dengan mata tertutup dalam kotak putih, melambaikan tangannya di depan laptop dan berdiri di samping dudukan robot, memutar roda bolak-balik dan melambaikan kepalanya ... Beberapa penonton bahkan cukup beruntung untuk menguji diri mereka sebagai pengemudi robot.

Presentasi

Sayangnya, pada saat presentasi, Internet berjalan sepenuhnya, tidak mungkin lagi untuk berbicara tentang transfer data tentang posisi tangan, dan terlebih lagi tentang penyiaran video streaming dari kamera robot. Dalam detik-detik terakhir sebelum rilis, diputuskan untuk membongkar aliran data sebanyak mungkin, hanya menyisakan perintah kontrol robot dan sepenuhnya melepaskan kacamata virtual. Kami harus menunjukkan versi PC dari proyek tersebut, di mana tidak mungkin untuk menoleh dan melihat melalui mata robot. Kami hanya bisa mengendalikan robot, teko dan pengumpan dengan bantuan tangan virtual, mengamati dari balik bahu pergerakan robot, ketel mati dan pakan tumpah. Dan akhirnya, bagi mereka yang ingin, kami menawarkan untuk mengukur kacamata dan merasakan setidaknya untuk sesaat diri kita di dunia maya.

Kenapa harus virtual reality?

Sayangnya, karena kesulitan teknis, kami tidak dapat menyampaikan gagasan utama proyek - bagaimana perbedaan kontrol dari dunia maya dengan hanya mengklik tombol di layar dengan mouse . Dan semuanya sangat sederhana, lebih mudah bagi seseorang untuk mengklik mouse, seseorang untuk menyodokkan jari di layar, seseorang untuk menulis di konsol, realitas virtual memungkinkan untuk berinteraksi dengan dunia nyata menggunakan tindakan dan gerakan yang akrab dengan tubuh manusia, yang memungkinkan Anda untuk melakukan beberapa tindakan sekaligus akrab bagi seseorang. Misalnya, dalam implementasi saat ini, Anda dapat membuat robot lurus dengan satu tangan, putar sedikit ke kanan dengan yang lain, dan putar kepala Anda dan lihat apa yang terjadi di sebelah kiri. Tentunya, banyak pengendara harus memegang kemudi dengan satu tangan, berbicara di telepon dengan yang lain dan secara berkala melihat ke samping untuk melihat apakah ada pejalan kaki yang melongo di tikungan. Itu sama di sini. Nah, sebagai bonus di dunia maya, seseorang bisa memiliki "di luar kemampuan" seperti pahlawan super. Sebagai contoh, untuk beralih dari robot ke ketel atau pengumpan, saya membuat lintasan dengan tangan saya, yang mengarah pada pergerakan benda tiga dimensi di dunia ini, seperti Jedi ... Ada ide untuk melepaskan bola api dari tangan saya dan dengan demikian mematikan robot, tetapi memutuskan bahwa itu terlalu banyak.Apakah ini bukan kebebasan? Kebebasan bergerak, kebebasan berpikir, kebebasan bertindak, kebebasan fantasi ...Tapi itu belum semuanya. Tidak selalu nyaman bagi seseorang untuk mengendalikan beberapa objek kompleks sendirian. Implementasi proyek saat ini memungkinkan beberapa orang untuk secara bersamaan mengelola beberapa bagian dari perangkat yang sama. Anda tidak perlu pergi jauh untuk contoh. Dua pengguna dapat terhubung ke tangki robot, satu akan mengontrol pergerakan tangki di permukaan, dan yang kedua pada saat ini akan memutar menara tangki dan memiliki akses untuk mengontrol moncong. Bayangkan saja seperti apa game tank pertempuran dengan implementasinya ?!Dari sudut pandang produksi, sekarang tidak perlu menghabiskan banyak uang untuk pembuatan keyboard yang sesuai, mouse, joystick atau manipulator lainnya. Cukup menggambar panel kontrol dan memuatnya ke dunia virtual. Dan bagaimana tampilannya akan tergantung hanya pada imajinasi dan kebutuhan spesifik.

Misalnya, dalam implementasi saat ini, Anda dapat membuat robot lurus dengan satu tangan, putar sedikit ke kanan dengan yang lain, dan putar kepala Anda dan lihat apa yang terjadi di sebelah kiri. Tentunya, banyak pengendara harus memegang kemudi dengan satu tangan, berbicara di telepon dengan yang lain dan secara berkala melihat ke samping untuk melihat apakah ada pejalan kaki yang melongo di tikungan. Itu sama di sini. Nah, sebagai bonus di dunia maya, seseorang bisa memiliki "di luar kemampuan" seperti pahlawan super. Sebagai contoh, untuk beralih dari robot ke ketel atau pengumpan, saya membuat lintasan dengan tangan saya, yang mengarah pada pergerakan benda tiga dimensi di dunia ini, seperti Jedi ... Ada ide untuk melepaskan bola api dari tangan saya dan dengan demikian mematikan robot, tetapi memutuskan bahwa itu terlalu banyak.Apakah ini bukan kebebasan? Kebebasan bergerak, kebebasan berpikir, kebebasan bertindak, kebebasan fantasi ...Tapi itu belum semuanya. Tidak selalu nyaman bagi seseorang untuk mengendalikan beberapa objek kompleks sendirian. Implementasi proyek saat ini memungkinkan beberapa orang untuk secara bersamaan mengelola beberapa bagian dari perangkat yang sama. Anda tidak perlu pergi jauh untuk contoh. Dua pengguna dapat terhubung ke tangki robot, satu akan mengontrol pergerakan tangki di permukaan, dan yang kedua pada saat ini akan memutar menara tangki dan memiliki akses untuk mengontrol moncong. Bayangkan saja seperti apa game tank pertempuran dengan implementasinya ?!Dari sudut pandang produksi, sekarang tidak perlu menghabiskan banyak uang untuk pembuatan keyboard yang sesuai, mouse, joystick atau manipulator lainnya. Cukup menggambar panel kontrol dan memuatnya ke dunia virtual. Dan bagaimana tampilannya akan tergantung hanya pada imajinasi dan kebutuhan spesifik.Apa berikutnya?

Di hackathon, tujuan kami adalah untuk menunjukkan kemungkinan yang ditawarkan oleh simbiosis Internet benda, robot, dan realitas virtual. Sekarang kita berada pada tahap mengarahkan proyek dan sementara bidang-bidang berikut menjulang:- Pengembangan robot dikendalikan secara simultan oleh beberapa orang, prototipe robot tangki;

- Menambahkan dukungan untuk platform Android dan iOS dalam proyek saat ini;

- Pengembangan avatar robot lengkap, mampu mengambil item dan menyiarkan gambar stereo dari dua mata;

- Mengembangkan protokol dan SDK lengkap untuk menghubungkan ke Internet hal-hal dan realitas virtual. Ini akan memungkinkan siapa saja yang ingin dengan mudah menghubungkan gadget elektronik mereka dengan realitas virtual dan sebagai hasilnya akan memperluas jangkauan kacamata;

- Pengembangan kacamata virtual Anda sendiri;

- Menambahkan antarmuka saraf, yang akan memungkinkan orang untuk tidak hanya mengendalikan berbagai hal dengan bantuan gerakan tubuh, tetapi juga dengan kekuatan pikiran. Pada hackathon terakhir ada beberapa proyek yang menggunakan antarmuka yang sama dan mungkin kita dapat menggabungkan upaya kami untuk kepentingan kemanusiaan.

Source: https://habr.com/ru/post/id382109/

All Articles