Tur pusat data Swedia Swedia dekat Lingkaran Arktik

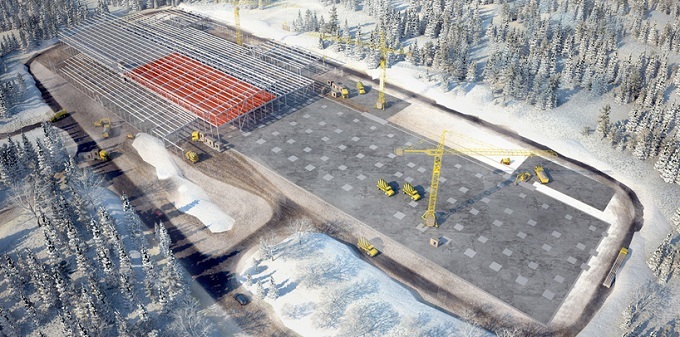

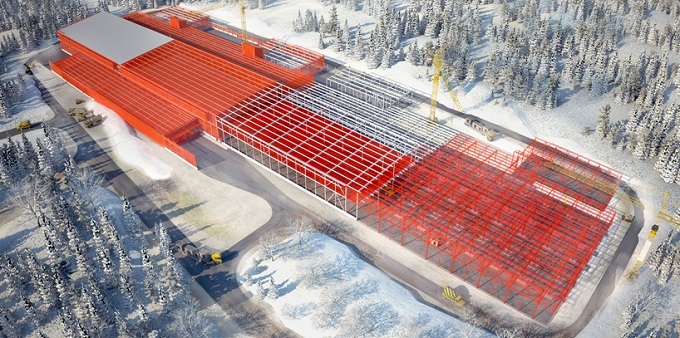

Sedikit selatan dari Lingkaran Arktik, di tengah hutan di pinggiran kota Swedia Luleå, adalah peternakan server - pusat data hypermount Facebook. Fasad bangunan raksasa dibingkai oleh ribuan panel logam persegi panjang, sementara itu sendiri tampak seperti pesawat ruang angkasa yang nyata. Peternakan server perusahaan di Lulea sangat besar. Luasnya 300 meter dan panjang 100 meter, yang kira-kira sesuai dengan ukuran empat lapangan sepak bola. Menariknya, proyek pusat data Facebook di Swedia pada satu titik ternyata sangat dekat dengan kegagalan.Salah satu ahli ekologi setempat mengatakan bahwa pusat data baru dapat membahayakan burung, termasuk burung pelatuk Swedia yang berjari tiga yang bersarang di dekat kampus. Tetapi pejabat dari kotamadya Lulea menolak keberatan tersebut. Proyek Facebook terlihat terlalu menarik, melibatkan investasi ratusan juta dolar dalam konstruksi dan penciptaan banyak pekerjaan.

Menariknya, proyek pusat data Facebook di Swedia pada satu titik ternyata sangat dekat dengan kegagalan.Salah satu ahli ekologi setempat mengatakan bahwa pusat data baru dapat membahayakan burung, termasuk burung pelatuk Swedia yang berjari tiga yang bersarang di dekat kampus. Tetapi pejabat dari kotamadya Lulea menolak keberatan tersebut. Proyek Facebook terlihat terlalu menarik, melibatkan investasi ratusan juta dolar dalam konstruksi dan penciptaan banyak pekerjaan. Farm server Facebook adalah salah satu fasilitas komputasi paling hemat energi dalam sejarah manusia. Sekitar satu abad yang lalu, Swedia memulai pembangunan banyak pembangkit listrik tenaga air untuk mengatur pasokan listrik dari industri baja dan pulp serta kertasnya. Pembangkit listrik tenaga air seperti itu muncul di Lulea. Sekarang mereka digunakan untuk menyalakan pusat data Facebook, yang, omong-omong, mengkonsumsi jumlah listrik yang sama dengan pabrik baja. Menurut insinyur Facebook, tujuan perusahaan adalah untuk menyediakan 50% daya ke pusat data melalui sumber energi ramah lingkungan dan terbarukan pada tahun 2018. Dan kampus Swedia secara signifikan telah membawa Facebook ke tingkat itu. Kampus ini juga memiliki tiga generator diesel berbentuk persegi yang kuat,yang akan diperlukan jika terjadi gangguan yang tidak mungkin dalam pengoperasian jaringan listrik pusat."Begitu banyak pembangkit listrik tenaga air yang terhubung ke jaringan regional sehingga generator sama sekali tidak diperlukan," kata Jay Park, direktur pengembangan infrastruktur Facebook. Menurut Park, saat menghubungkan gardu ke pusat data baru, insinyur Facebook menggunakan skema redundansi 2N, yaitu listrik berasal dari jaringan independen menggunakan berbagai rute. Dalam kasus pertama, kabel bawah tanah digunakan, sedangkan pada yang kedua - saluran listrik overhead.

Farm server Facebook adalah salah satu fasilitas komputasi paling hemat energi dalam sejarah manusia. Sekitar satu abad yang lalu, Swedia memulai pembangunan banyak pembangkit listrik tenaga air untuk mengatur pasokan listrik dari industri baja dan pulp serta kertasnya. Pembangkit listrik tenaga air seperti itu muncul di Lulea. Sekarang mereka digunakan untuk menyalakan pusat data Facebook, yang, omong-omong, mengkonsumsi jumlah listrik yang sama dengan pabrik baja. Menurut insinyur Facebook, tujuan perusahaan adalah untuk menyediakan 50% daya ke pusat data melalui sumber energi ramah lingkungan dan terbarukan pada tahun 2018. Dan kampus Swedia secara signifikan telah membawa Facebook ke tingkat itu. Kampus ini juga memiliki tiga generator diesel berbentuk persegi yang kuat,yang akan diperlukan jika terjadi gangguan yang tidak mungkin dalam pengoperasian jaringan listrik pusat."Begitu banyak pembangkit listrik tenaga air yang terhubung ke jaringan regional sehingga generator sama sekali tidak diperlukan," kata Jay Park, direktur pengembangan infrastruktur Facebook. Menurut Park, saat menghubungkan gardu ke pusat data baru, insinyur Facebook menggunakan skema redundansi 2N, yaitu listrik berasal dari jaringan independen menggunakan berbagai rute. Dalam kasus pertama, kabel bawah tanah digunakan, sedangkan pada yang kedua - saluran listrik overhead.

Server farm membantu Facebook memproses sekitar 350 juta foto, 4,5 miliar suka, dan 10 miliar pesan per hari. Perusahaan mulai membangun pusat data Swedia untuk meningkatkan kualitas layanan bagi pengguna Eropa yang menghasilkan lebih banyak dan lebih banyak data elektronik. Pada saat yang sama, ada kemungkinan besar bahwa jika Anda mengunggah selfie di London atau mempublikasikan pembaruan status di Paris, data Anda akan disimpan di Lulea. Dalam pusat data tipikal, satu setengah hingga dua watt peralatan elektromekanis dan sistem pendingin jatuh pada setiap watt beban IT, pusat data Luleå bekerja berkali-kali lebih efisien: koefisien PUE-nya adalah 1,04.

Server farm membantu Facebook memproses sekitar 350 juta foto, 4,5 miliar suka, dan 10 miliar pesan per hari. Perusahaan mulai membangun pusat data Swedia untuk meningkatkan kualitas layanan bagi pengguna Eropa yang menghasilkan lebih banyak dan lebih banyak data elektronik. Pada saat yang sama, ada kemungkinan besar bahwa jika Anda mengunggah selfie di London atau mempublikasikan pembaruan status di Paris, data Anda akan disimpan di Lulea. Dalam pusat data tipikal, satu setengah hingga dua watt peralatan elektromekanis dan sistem pendingin jatuh pada setiap watt beban IT, pusat data Luleå bekerja berkali-kali lebih efisien: koefisien PUE-nya adalah 1,04.Konsep sasis

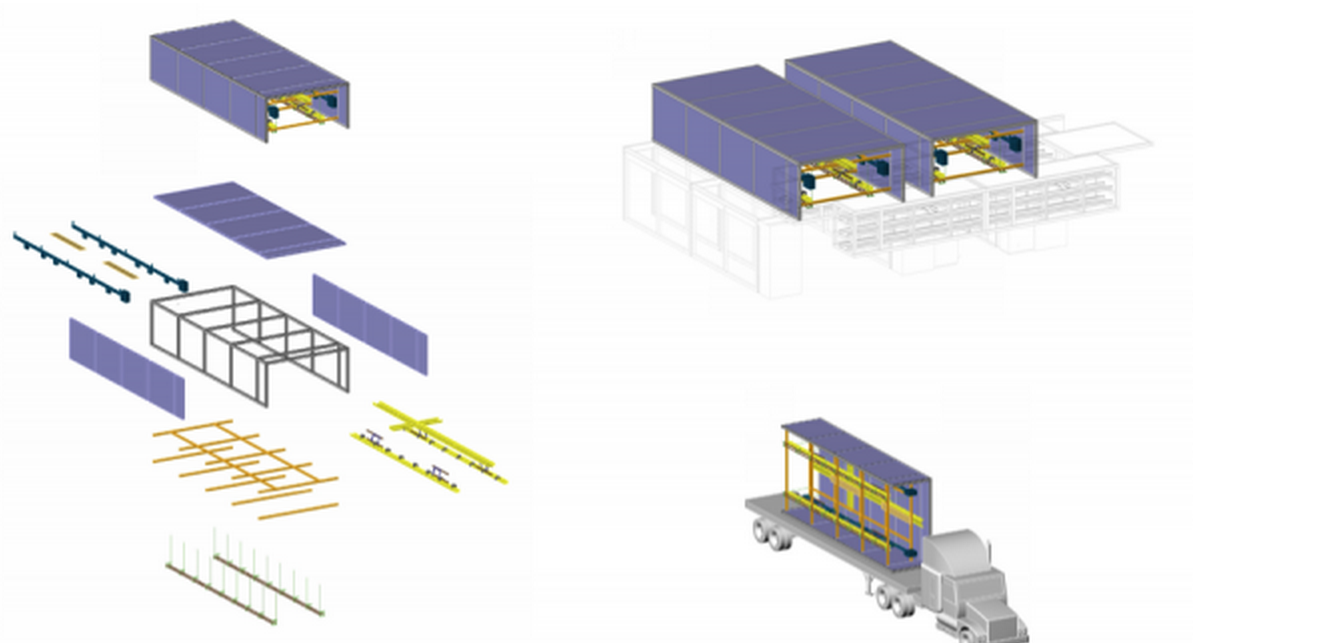

Facebook membangun server farm, mengulang konsep "sasis". Dengan menggunakan tip dari berbagai industri di mana otomasi dan standardisasi produksi banyak digunakan, kami berhasil membentuk visi gagasan dan mengimplementasikan "sasis" - dasar (dalam hal ini, kerangka baja dengan ukuran perkiraan 3,6 m kali 12,2 m) dan menggunakan jalur perakitan untuk yang dikirimkan ke tempat pelaksanaan benda kerja. Insinyur desain Marco Magarelli untuk pembangunan pusat data untuk Facebook:

Insinyur desain Marco Magarelli untuk pembangunan pusat data untuk Facebook:, : , , - . «» , . «», . , .

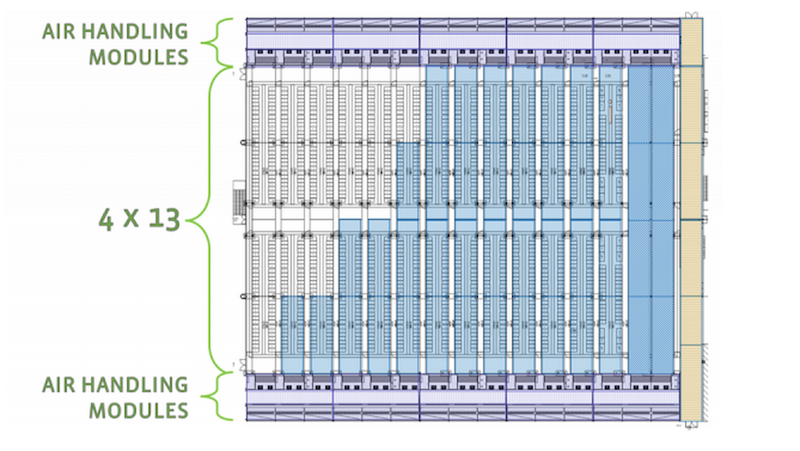

Setelah perakitan, sasis dimasukkan ke tubuh dan diangkut langsung ke server peternakan itu sendiri. Di gedung yang sama, rakitan yang dikirim dipasang di tiang beton yang disiapkan. Dua sasis yang terhubung membentuk jalur 18 meter. Ruang mesin pusat data biasa akan menampung 52 sasis, sehingga membentuk 13 koridor, termasuk yang ditujukan untuk rakitan server pendingin.

Dua sasis yang terhubung membentuk jalur 18 meter. Ruang mesin pusat data biasa akan menampung 52 sasis, sehingga membentuk 13 koridor, termasuk yang ditujukan untuk rakitan server pendingin. Efisiensi tinggi dan ramah lingkungan dari pusat data karena lokasinya. Operator Swedia memiliki listrik murah yang dihasilkan oleh pembangkit listrik tenaga air yang andal, serta iklim dingin, yang dapat dibungkus oleh spesialis IT. Hal ini disebabkan, antara lain, karena suhu rendah di wilayah tersebut (di musim dingin, termometer menjaga rata-rata sekitar -20 C). Alih-alih menghabiskan uang untuk pendingin udara yang sangat besar energi untuk mendinginkan puluhan ribu server di Lulea, insinyur Facebook menggunakan udara luar untuk menjalankannya di pusat data setelah jam kerja setelah udara disaring dan dioptimalkan untuk suhu dan kelembaban, yang mendinginkan sistem server. Pusat data baru berfungsi sebagai satu mekanisme besar.Di dalamnya ada koridor panjang, banyak server dengan lampu berkedip dan dengungan penggemar raksasa.

Efisiensi tinggi dan ramah lingkungan dari pusat data karena lokasinya. Operator Swedia memiliki listrik murah yang dihasilkan oleh pembangkit listrik tenaga air yang andal, serta iklim dingin, yang dapat dibungkus oleh spesialis IT. Hal ini disebabkan, antara lain, karena suhu rendah di wilayah tersebut (di musim dingin, termometer menjaga rata-rata sekitar -20 C). Alih-alih menghabiskan uang untuk pendingin udara yang sangat besar energi untuk mendinginkan puluhan ribu server di Lulea, insinyur Facebook menggunakan udara luar untuk menjalankannya di pusat data setelah jam kerja setelah udara disaring dan dioptimalkan untuk suhu dan kelembaban, yang mendinginkan sistem server. Pusat data baru berfungsi sebagai satu mekanisme besar.Di dalamnya ada koridor panjang, banyak server dengan lampu berkedip dan dengungan penggemar raksasa.

Lokasi geografis yang baik akan memungkinkan delapan bulan dalam setahun untuk mendinginkan pusat data utara ini semata-mata karena udara luar, yang membuatnya lebih murah untuk dirawat dengan rata-rata 40% dibandingkan dengan pusat data yang sama di Amerika Serikat. Faktor penting untuk investasi Facebook adalah fakta bahwa untuk pembangunan pusat datanya, perusahaan Amerika menerima subsidi dari Uni Eropa sebesar 10 juta pound, di samping itu, di sinilah harga listrik terendah ditawarkan di seluruh Eropa.

Insinyur Facebook menyederhanakan desain server dengan menghilangkan penggunaan sejumlah komponen standar, seperti slot memori tambahan, kabel, dan kotak plastik pelindung. Server-server ini, dengan motherboard yang tidak terlindungi, ditempatkan di dalam rak berukuran standar kulkas.

Insinyur Facebook menyederhanakan desain server dengan menghilangkan penggunaan sejumlah komponen standar, seperti slot memori tambahan, kabel, dan kotak plastik pelindung. Server-server ini, dengan motherboard yang tidak terlindungi, ditempatkan di dalam rak berukuran standar kulkas.

Para ahli yakin bahwa desain ini memungkinkan Anda untuk mengintensifkan aliran udara yang melewati setiap server. Pengoperasian yang efektif dari sistem komputasi semacam itu membutuhkan kapasitas pendinginan yang lebih sedikit, karena karena berkurangnya jumlah komponen, mereka mengeluarkan lebih sedikit energi termal daripada analog standar. Dan selain itu, mesin Facebook dapat berfungsi pada suhu tinggi.

Para ahli yakin bahwa desain ini memungkinkan Anda untuk mengintensifkan aliran udara yang melewati setiap server. Pengoperasian yang efektif dari sistem komputasi semacam itu membutuhkan kapasitas pendinginan yang lebih sedikit, karena karena berkurangnya jumlah komponen, mereka mengeluarkan lebih sedikit energi termal daripada analog standar. Dan selain itu, mesin Facebook dapat berfungsi pada suhu tinggi.

Ketika para insinyur Facebook mulai membawa ide-ide mereka ke "publik", sebagian besar pakar di bidang pusat data masih skeptis, terutama mengenai pengoperasian sistem server pada suhu tinggi. Tetapi, seperti yang mereka katakan, waktu telah menempatkan segalanya pada tempatnya. Pada saat yang sama, peningkatan lebih lanjut dari sistem infrastruktur oleh peserta inisiatif Open Compute Project (selain proyek Facebook dikembangkan oleh banyak produsen perangkat keras dan microchip, penyedia hosting dan colocation, serta organisasi perbankan yang jauh dari segmen TI) memungkinkan untuk menggunakannya jauh dari Kutub Utara. Pusat data utama berikutnya Facebook, diputuskan untuk dibangun di Iowa (AS), di mana iklimnya sedang. Seperti di Swedia, ada lebih dari cukup listrik murah dari sumber terbarukan (di Iowa, peternakan angin berperan sebagai pembangkit listrik tenaga air).Perusahaan juga mulai mengembangkan sistem penyimpanan dan peralatan jaringannya sendiri.

Ketika para insinyur Facebook mulai membawa ide-ide mereka ke "publik", sebagian besar pakar di bidang pusat data masih skeptis, terutama mengenai pengoperasian sistem server pada suhu tinggi. Tetapi, seperti yang mereka katakan, waktu telah menempatkan segalanya pada tempatnya. Pada saat yang sama, peningkatan lebih lanjut dari sistem infrastruktur oleh peserta inisiatif Open Compute Project (selain proyek Facebook dikembangkan oleh banyak produsen perangkat keras dan microchip, penyedia hosting dan colocation, serta organisasi perbankan yang jauh dari segmen TI) memungkinkan untuk menggunakannya jauh dari Kutub Utara. Pusat data utama berikutnya Facebook, diputuskan untuk dibangun di Iowa (AS), di mana iklimnya sedang. Seperti di Swedia, ada lebih dari cukup listrik murah dari sumber terbarukan (di Iowa, peternakan angin berperan sebagai pembangkit listrik tenaga air).Perusahaan juga mulai mengembangkan sistem penyimpanan dan peralatan jaringannya sendiri.

HP dengan cepat merespons inisiatif jejaring sosial dengan meluncurkan penjualan microserver bernama Moonshot , yang tanpa kelebihan, dilengkapi dengan chip berdaya rendah dan ditandai dengan efisiensi energi yang tinggi. Rilis Moonshot adalah perubahan paling radikal dalam lini produk server farm yang dilakukan oleh perusahaan AS dalam beberapa tahun terakhir. HP juga bekerja pada mekanisme untuk meningkatkan efisiensi energi server melalui pendinginan air.Menurut kepemimpinan raksasa jaringan, hanya beberapa perusahaan yang ingin berurusan dengan sistem khusus yang dirancang terutama untuk memenuhi kebutuhan perusahaan Internet besar yang memiliki pusat data yang sangat besar. Menurut juru bicara Cisco David McCulloch, raksasa jaringan itu tidak melihat tren baru sebagai ancaman bagi bisnisnya. Enam tahun lalu, vendor besar AS lainnya, Dell, menciptakan tim insinyur khusus untuk merancang sistem komputer tanpa "embel-embel" yang diakuisisi oleh perusahaan internet. Sejak itu, pendapatan Dell telah tumbuh secara signifikan. Ini menunjukkan bahwa vendor telah memilih arah yang tepat untuk pengembangan bisnisnya.Sementara perangkat keras khusus yang dikembangkan dalam dinding raksasa web Google dan Amazon hanya dapat diakses oleh operator pusat data perusahaan-perusahaan ini, keterbukaan Facebook dan keinginan jejaring sosial untuk berbagi praktik terbaik mereka telah menjadi alasan meningkatnya minat pusat data tidak hanya dari perusahaan Internet lainnya - bahkan usaha kecil dan menengah secara aktif tertarik pada perkembangan jejaring sosial di bidang peningkatan efisiensi pusat data. Facebook telah menciptakan petunjuk langkah demi langkah untuk membuat server server hyper-scale, yang dapat digunakan oleh perusahaan mana pun dengan cukup jam kerja dan uang.

HP dengan cepat merespons inisiatif jejaring sosial dengan meluncurkan penjualan microserver bernama Moonshot , yang tanpa kelebihan, dilengkapi dengan chip berdaya rendah dan ditandai dengan efisiensi energi yang tinggi. Rilis Moonshot adalah perubahan paling radikal dalam lini produk server farm yang dilakukan oleh perusahaan AS dalam beberapa tahun terakhir. HP juga bekerja pada mekanisme untuk meningkatkan efisiensi energi server melalui pendinginan air.Menurut kepemimpinan raksasa jaringan, hanya beberapa perusahaan yang ingin berurusan dengan sistem khusus yang dirancang terutama untuk memenuhi kebutuhan perusahaan Internet besar yang memiliki pusat data yang sangat besar. Menurut juru bicara Cisco David McCulloch, raksasa jaringan itu tidak melihat tren baru sebagai ancaman bagi bisnisnya. Enam tahun lalu, vendor besar AS lainnya, Dell, menciptakan tim insinyur khusus untuk merancang sistem komputer tanpa "embel-embel" yang diakuisisi oleh perusahaan internet. Sejak itu, pendapatan Dell telah tumbuh secara signifikan. Ini menunjukkan bahwa vendor telah memilih arah yang tepat untuk pengembangan bisnisnya.Sementara perangkat keras khusus yang dikembangkan dalam dinding raksasa web Google dan Amazon hanya dapat diakses oleh operator pusat data perusahaan-perusahaan ini, keterbukaan Facebook dan keinginan jejaring sosial untuk berbagi praktik terbaik mereka telah menjadi alasan meningkatnya minat pusat data tidak hanya dari perusahaan Internet lainnya - bahkan usaha kecil dan menengah secara aktif tertarik pada perkembangan jejaring sosial di bidang peningkatan efisiensi pusat data. Facebook telah menciptakan petunjuk langkah demi langkah untuk membuat server server hyper-scale, yang dapat digunakan oleh perusahaan mana pun dengan cukup jam kerja dan uang.

Manajer puncak Facebook Frank FrankovskyDewan direksi dari organisasi nirlaba Open Compute Project Foundation, yang dipimpin oleh manajer puncak Facebook Frank Frankovskii, termasuk kepala raksasa seperti itu dari dunia teknologi tinggi dan keuangan masing-masing seperti Intel dan Goldman Sachs. Pada saat yang sama, banyak produsen perangkat keras besar Asia seperti Quanta Computer dan Tyan Computer sudah mulai menjual sistem server berdasarkan spesifikasi yang dibuat oleh anggota Open Compute Project. Inisiatif media sosial ternyata sangat populer.

Manajer puncak Facebook Frank FrankovskyDewan direksi dari organisasi nirlaba Open Compute Project Foundation, yang dipimpin oleh manajer puncak Facebook Frank Frankovskii, termasuk kepala raksasa seperti itu dari dunia teknologi tinggi dan keuangan masing-masing seperti Intel dan Goldman Sachs. Pada saat yang sama, banyak produsen perangkat keras besar Asia seperti Quanta Computer dan Tyan Computer sudah mulai menjual sistem server berdasarkan spesifikasi yang dibuat oleh anggota Open Compute Project. Inisiatif media sosial ternyata sangat populer.Kampus server pertanian

Pagar panjang telah diletakkan di sekeliling kampus pusat data, yang sebenarnya didirikan untuk mencegah rusa lokal masuk ke dalam kampus.Di dalam gedung, budaya Swedia bercampur dengan orang Amerika. Di pintu masuk, Anda dapat melihat gambar-gambar rusa berwarna-warni yang berdekatan dengan logo dan jam tangan Facebook, yang menunjukkan waktu di kampus perusahaan lain di negara bagian North Carolina, Iowa, dan Oregon di AS. Sebagian besar dari satu setengah ratus staf kampus Swedia adalah penduduk setempat. Para karyawan mulai bekerja dengan mobil salju dan sepeda yang dihiasi dengan logo Facebook. Mereka juga sering menghabiskan waktu bersama, misalnya mengatur memancing di atas es.

Sebagian besar dari satu setengah ratus staf kampus Swedia adalah penduduk setempat. Para karyawan mulai bekerja dengan mobil salju dan sepeda yang dihiasi dengan logo Facebook. Mereka juga sering menghabiskan waktu bersama, misalnya mengatur memancing di atas es.

Source: https://habr.com/ru/post/id387823/

All Articles