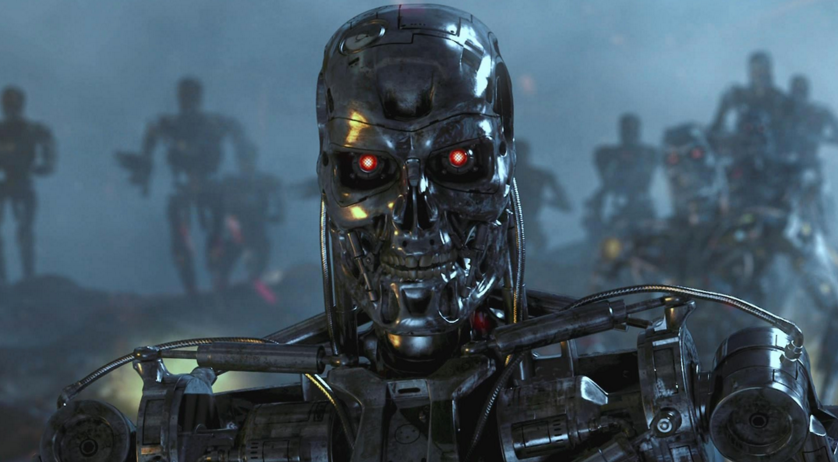

Apa yang bisa menjadi senjata otonom yang berbahaya

Sebagaimantan karyawan Pentagon yang berpartisipasi dalam pengembangan strategi untuk penggunaan senjata otonom, mengisyaratkan bahwa dalam kondisi nyata itu tidak dapat dikendalikan dan ada kemungkinan peretasan, penggantian dan manipulasi oleh musuh.Baru-baru ini, sensor murah dan teknologi kecerdasan buatan baru menjadi lebih praktis, yang memungkinkan untuk menggunakannya dalam pengembangan sistem senjata otonom. Hantu dari apa yang disebut "robot pembunuh" telah memprovokasi gerakan protes dan diskusi internasional di PBB untuk membatasi pengembangan dan implementasi sistem semacam itu, lapor nytimes.com.Laporan itu ditulis oleh Paul Sherry, yang menjalankan program Perang Masa Depan di Pusat Keamanan Amerika Baru (Washington, Columbia). Dari 2008 hingga 2013, Sherry bekerja di kantor Sekretaris Pertahanan AS, di mana ia membantu mengembangkan strategi untuk penggunaan senjata otonom. Pada 2012, ia menjadi salah satu penulis arahan Kementerian Pertahanan, yang menetapkan kebijakan militer tentang penggunaan sistem semacam itu.Dalam sebuah laporan berjudul "Senjata otonom dan risiko operasional", yang diterbitkan pada hari Senin, Sherry memperingatkan tentang sejumlah risiko nyata yang terkait dengan sistem senjata yang sepenuhnya otonom. Ini kontras dengan sistem yang sepenuhnya otomatis yang dapat membunuh tanpa campur tangan manusia terhadap senjata yang “membuat orang-orang mengetahui” dalam proses memilih dan mengenai target (yaitu, operator digunakan).Sherry, yang bertugas di Angkatan Darat A.S. sebagai ranger dan berpartisipasi dalam operasi di Irak dan Afghanistan, berfokus pada jenis kesalahan potensial yang dapat terjadi dalam sistem yang sepenuhnya otomatis. Untuk menyoroti implikasi militer, laporan itu mencantumkan kegagalan yang terjadi dalam sistem militer dan komersial dengan otomatisasi tingkat tinggi."Siapa pun yang pernah menyerah pada dukungan telepon otomatis untuk saluran bantuan, jam alarm secara keliru diatur ke" malam "alih-alih" pagi "dan seterusnya, telah mengalami masalah" kerapuhan "yang ada dalam sistem otomatis," tulis Sherry.Dasar dari laporannya adalah bahwa sistem senjata otonom tidak memiliki "fleksibilitas", yaitu dalam proses melakukan sistem tugas seperti itu dapat terjadi kesalahan yang bisa dihindari orang.Senjata yang sepenuhnya otonom mulai muncul di gudang senjata militer berbagai negara. Sebagai contoh, Korea Selatan memasang menara otomatis di sepanjang zona demiliterisasi dengan Korea Utara, dan di Israel ada kendaraan udara tak berawak yang beroperasi, yang diprogram untuk menyerang sistem radar musuh ketika terdeteksi.Militer AS tidak menggunakan senjata otonom. Namun, tahun ini Departemen Pertahanan meminta hampir $ 1 miliar untuk produksi senjata oleh Lockheed Martin Long Range Anti-Ship Missile, yang digambarkan sebagai "semi-otonom." Meskipun operator pertama akan memilih target, tetapi kontak luar dengan orang tersebut, secara otomatis akan mengidentifikasi dan menyerang pasukan musuh.Fokusnya adalah pada sejumlah kejutan dalam perilaku sistem komputer, seperti crash dan kesalahan, serta interaksi yang tidak terduga dengan lingkungan."Selama tes pertama mereka di Samudra Pasifik, sistem komputer Y2K benar-benar gagal dalam delapan pejuang F-22 saat mereka melewati garis tanggal."Kata laporan itu. “Semua sistem komputer terpasang gagal, dan hasilnya hampir menjadi bencana besar - hilangnya pesawat terbang. Meskipun keberadaan garis tanggal telah lama diketahui, hasil berinteraksi dengan perangkat lunak belum sepenuhnya diuji. "Sebagai alternatif dari senjata yang sepenuhnya otonom, laporan tersebut mengadvokasi apa yang disebut "Centaur Warfighting" (Senjata Gabungan? Faktanya, permainan kata-kata yang tidak dapat diterjemahkan. Approx.). Istilah "centaur" telah digunakan untuk menggambarkan sistem di mana orang dan komputer bekerja dengan erat. Dalam catur, misalnya, tim yang menggunakan orang dan program kecerdasan buatan mendominasi persaingan melawan tim yang hanya menggunakan kecerdasan buatan.Namun, dalam sebuah wawancara telepon, Sherry mengakui bahwa hanya operator, "menekan tombol" tidak cukup. "Memiliki orang yang" diberitahu "tentang tindakan mesin saja tidak cukup," katanya. "Mereka (orang) tidak bisa hanya menjadi bagian dari algoritma operasi sistem. Seseorang harus berpartisipasi aktif dalam pengambilan keputusan. ”

Sebagaimantan karyawan Pentagon yang berpartisipasi dalam pengembangan strategi untuk penggunaan senjata otonom, mengisyaratkan bahwa dalam kondisi nyata itu tidak dapat dikendalikan dan ada kemungkinan peretasan, penggantian dan manipulasi oleh musuh.Baru-baru ini, sensor murah dan teknologi kecerdasan buatan baru menjadi lebih praktis, yang memungkinkan untuk menggunakannya dalam pengembangan sistem senjata otonom. Hantu dari apa yang disebut "robot pembunuh" telah memprovokasi gerakan protes dan diskusi internasional di PBB untuk membatasi pengembangan dan implementasi sistem semacam itu, lapor nytimes.com.Laporan itu ditulis oleh Paul Sherry, yang menjalankan program Perang Masa Depan di Pusat Keamanan Amerika Baru (Washington, Columbia). Dari 2008 hingga 2013, Sherry bekerja di kantor Sekretaris Pertahanan AS, di mana ia membantu mengembangkan strategi untuk penggunaan senjata otonom. Pada 2012, ia menjadi salah satu penulis arahan Kementerian Pertahanan, yang menetapkan kebijakan militer tentang penggunaan sistem semacam itu.Dalam sebuah laporan berjudul "Senjata otonom dan risiko operasional", yang diterbitkan pada hari Senin, Sherry memperingatkan tentang sejumlah risiko nyata yang terkait dengan sistem senjata yang sepenuhnya otonom. Ini kontras dengan sistem yang sepenuhnya otomatis yang dapat membunuh tanpa campur tangan manusia terhadap senjata yang “membuat orang-orang mengetahui” dalam proses memilih dan mengenai target (yaitu, operator digunakan).Sherry, yang bertugas di Angkatan Darat A.S. sebagai ranger dan berpartisipasi dalam operasi di Irak dan Afghanistan, berfokus pada jenis kesalahan potensial yang dapat terjadi dalam sistem yang sepenuhnya otomatis. Untuk menyoroti implikasi militer, laporan itu mencantumkan kegagalan yang terjadi dalam sistem militer dan komersial dengan otomatisasi tingkat tinggi."Siapa pun yang pernah menyerah pada dukungan telepon otomatis untuk saluran bantuan, jam alarm secara keliru diatur ke" malam "alih-alih" pagi "dan seterusnya, telah mengalami masalah" kerapuhan "yang ada dalam sistem otomatis," tulis Sherry.Dasar dari laporannya adalah bahwa sistem senjata otonom tidak memiliki "fleksibilitas", yaitu dalam proses melakukan sistem tugas seperti itu dapat terjadi kesalahan yang bisa dihindari orang.Senjata yang sepenuhnya otonom mulai muncul di gudang senjata militer berbagai negara. Sebagai contoh, Korea Selatan memasang menara otomatis di sepanjang zona demiliterisasi dengan Korea Utara, dan di Israel ada kendaraan udara tak berawak yang beroperasi, yang diprogram untuk menyerang sistem radar musuh ketika terdeteksi.Militer AS tidak menggunakan senjata otonom. Namun, tahun ini Departemen Pertahanan meminta hampir $ 1 miliar untuk produksi senjata oleh Lockheed Martin Long Range Anti-Ship Missile, yang digambarkan sebagai "semi-otonom." Meskipun operator pertama akan memilih target, tetapi kontak luar dengan orang tersebut, secara otomatis akan mengidentifikasi dan menyerang pasukan musuh.Fokusnya adalah pada sejumlah kejutan dalam perilaku sistem komputer, seperti crash dan kesalahan, serta interaksi yang tidak terduga dengan lingkungan."Selama tes pertama mereka di Samudra Pasifik, sistem komputer Y2K benar-benar gagal dalam delapan pejuang F-22 saat mereka melewati garis tanggal."Kata laporan itu. “Semua sistem komputer terpasang gagal, dan hasilnya hampir menjadi bencana besar - hilangnya pesawat terbang. Meskipun keberadaan garis tanggal telah lama diketahui, hasil berinteraksi dengan perangkat lunak belum sepenuhnya diuji. "Sebagai alternatif dari senjata yang sepenuhnya otonom, laporan tersebut mengadvokasi apa yang disebut "Centaur Warfighting" (Senjata Gabungan? Faktanya, permainan kata-kata yang tidak dapat diterjemahkan. Approx.). Istilah "centaur" telah digunakan untuk menggambarkan sistem di mana orang dan komputer bekerja dengan erat. Dalam catur, misalnya, tim yang menggunakan orang dan program kecerdasan buatan mendominasi persaingan melawan tim yang hanya menggunakan kecerdasan buatan.Namun, dalam sebuah wawancara telepon, Sherry mengakui bahwa hanya operator, "menekan tombol" tidak cukup. "Memiliki orang yang" diberitahu "tentang tindakan mesin saja tidak cukup," katanya. "Mereka (orang) tidak bisa hanya menjadi bagian dari algoritma operasi sistem. Seseorang harus berpartisipasi aktif dalam pengambilan keputusan. ”Source: https://habr.com/ru/post/id391285/

All Articles