Para editor Kamus Oxford memilih kata "pasca-kebenaran"

sebagai kata "

2016 yang terhormat". Istilah ini menggambarkan keadaan di mana fakta objektif kurang penting untuk pembentukan opini publik daripada daya tarik emosi dan kepercayaan pribadi.

Frekuensi yang sangat tinggi untuk menggunakan kata ini diamati dalam publikasi berbahasa Inggris setelah pemilihan presiden AS sehubungan dengan penyebaran sejumlah besar berita palsu, setelah itu kebenarannya sendiri tidak terlalu menjadi masalah.

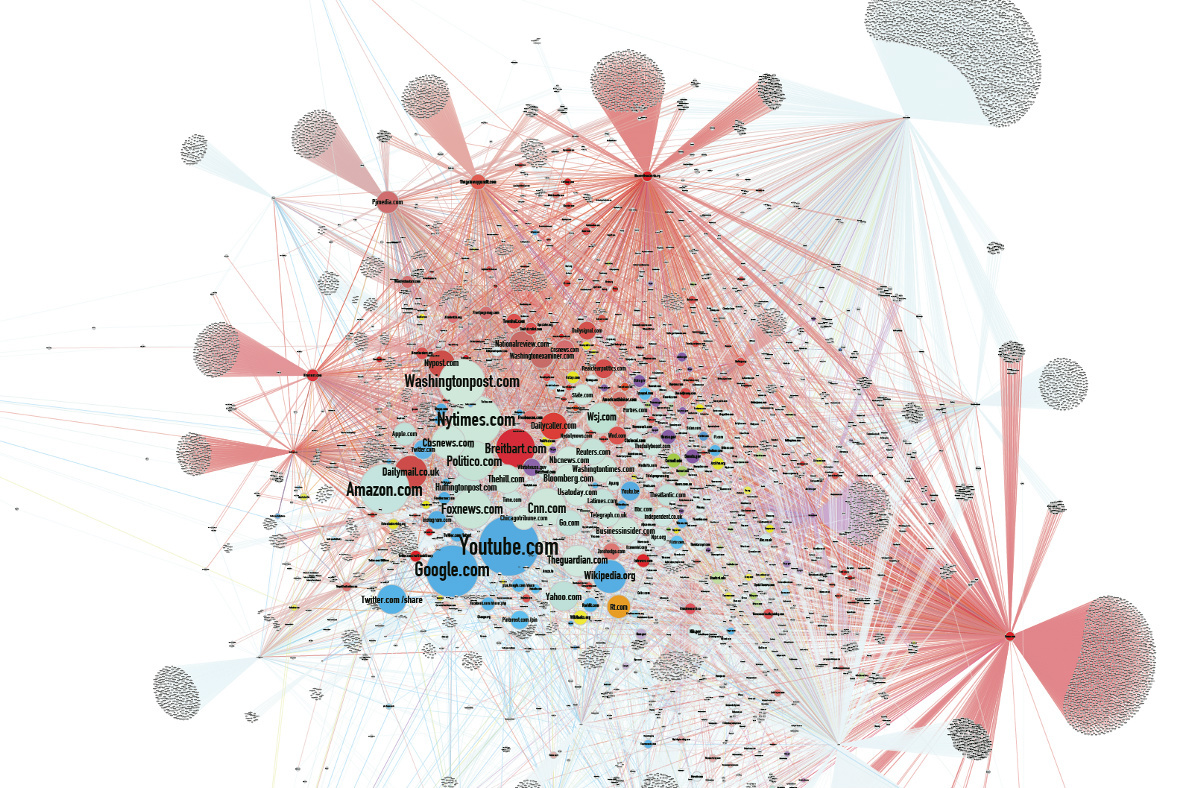

Menurut beberapa analis, penyebaran berita fitnah palsu adalah salah satu alasan kekalahan Hillary Clinton dalam pemilihan. Umpan algoritmik Facebook

telah menjadi salah satu sumber utama berita palsu.

Terhadap latar belakang ini, berita dari pengembang di bidang kecerdasan buatan hampir tanpa disadari. Kita sudah terbiasa dengan fakta bahwa jaringan saraf menggambar, membuat foto seseorang sesuai dengan deskripsi verbal, dan menghasilkan musik. Mereka melakukan lebih banyak dan lebih banyak, dan setiap kali mereka melakukan lebih baik. Tetapi hal yang paling menarik adalah bahwa mesin belajar membuat tipuan.

Pengaruh palsu

Selama pemilihan AS, jumlah repost berita palsu di jejaring sosial melebihi jumlah repost pesan kebenaran, karena pemalsuannya lebih sesuai dengan harapan atau lebih menarik. Setelah pemilihan, Facebook menyewa checker independen untuk menandai pesan yang tidak diverifikasi untuk memperingatkan pengguna.

Kombinasi peningkatan polarisasi politik masyarakat dan kecenderungan untuk membaca terutama judul memberikan efek kumulatif. Berita palsu juga sering disebarluaskan melalui situs berita palsu, informasi yang darinya sering jatuh ke media arus utama, yang berupaya menarik lalu lintas pengguna. Dan tidak ada yang menarik traffic seperti headline yang menarik.

Namun pada kenyataannya, pengaruh palsu tidak terbatas pada bidang politik saja. Ada banyak contoh yang menunjukkan dampak berita palsu pada masyarakat.

Sebuah perusahaan produksi video Australia telah merilis

video viral palsu selama dua tahun, memperoleh ratusan juta penayangan.

Dalam sebuah

kepalsuan yang dipikirkan matang-matang tentang Stalin, yang wajahnya diduga muncul di metro Moskow, mereka bahkan percaya pada 1 April.

Pada tahun 1992, jutawan Ilya Medkov mulai membayar kantor berita besar di Rusia dan CIS (termasuk RIA Novosti, Interfax, ITAR-TASS). ITAR-TASS mengeluarkan

pesan palsu kepada media tentang kecelakaan di PLTN Leningrad pada Januari 1993. Akibatnya, saham perusahaan Skandinavia terkemuka jatuh harga, dan sebelum bantahan media muncul, agen Medkov membeli saham perusahaan Swedia, Finlandia, dan Norwegia yang paling menguntungkan.

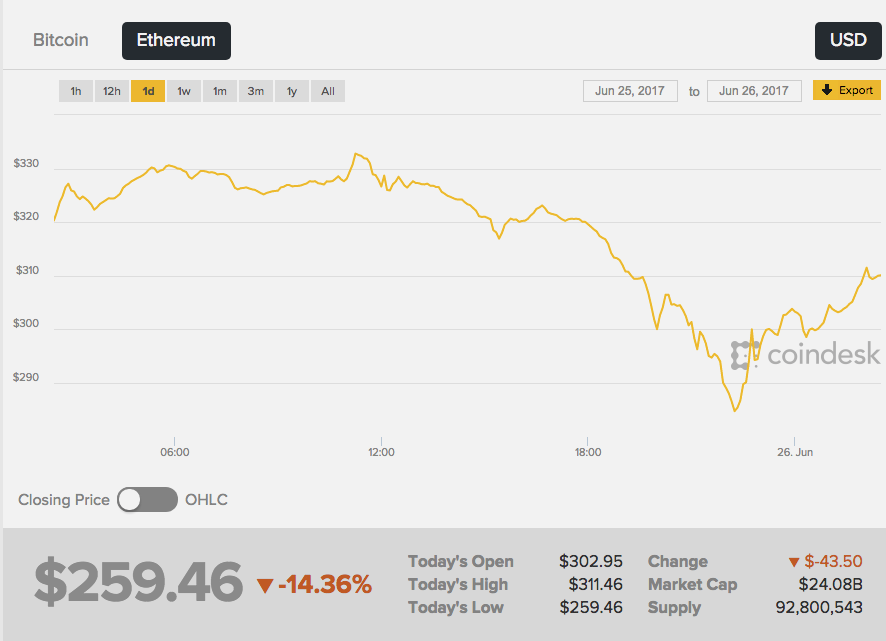

Pada tanggal 26 Juni 2017, laju kapitalisasi cryptocurrency Ethereum kedua turun tajam - pertukaran bereaksi terhadap rumor yang muncul di jaringan tentang kematian tragis pencipta Ether, Vitaliy Buterin. Selain itu, "berita mendesak" pertama kali muncul di papan gambar 4chan anonim - dan sumber ini, terus terang, bukan yang paling dapat diandalkan.

Wikipedia menulis bahwa “Vitalik

adalah seorang programmer Rusia,” dan kemudian pers kuning menerima berita itu. Akibatnya, tingkat eter

turun 13%, dari sekitar $ 289 menjadi $ 252. Kursus mulai tumbuh segera setelah penolakan berita dari Vitali sendiri.

Tidak ada bukti bahwa seseorang dengan sengaja membuat uang palsu untuk mendapatkan untung pada perbedaan tingkat mata uang kripto. Tidak dapat disangkal hanya bahwa berita fiksi tanpa fakta tunggal yang dikonfirmasi memiliki efek yang kuat pada orang-orang.

Peniruan realitas

Penyanyi Prancis Francoise Ardi dalam video itu akan mengulangi pidato Kellianne Conway, penasihat Presiden AS Donald Trump, yang menjadi terkenal setelah berbicara tentang "fakta-fakta alternatif." Yang menarik di sini adalah Ardi sebenarnya berusia 73 tahun, dan dalam video itu dia terlihat seperti berusia dua puluh tahun.

Roller Alternative Face v1.1

dibuat oleh artis-aktris Jerman Mario Klingeman. Dia mengambil wawancara audio Conway dan video musik lama Arde. Dan kemudian dia menggunakan generative neural network (GAN), yang membuat konten video unik dari banyak bingkai klip penyanyi yang berbeda, dan melapis trek audio dengan komentar oleh Conway.

Dalam hal ini, yang palsu mudah dikenali, tetapi Anda dapat melangkah lebih jauh - membuat perubahan pada file audio. Orang akan percaya rekaman gambar dan suara lebih dari sekadar teks. Tetapi bagaimana cara memalsukan suara manusia?

Sistem GAN dapat mempelajari karakteristik statistik dari rekaman audio, dan kemudian mereproduksinya dalam konteks berbeda yang akurat untuk milidetik. Cukup dengan memasukkan teks yang harus direproduksi oleh jaringan saraf, dan Anda akan mendapatkan pernyataan yang masuk akal.

Startup Kanada, Lyrebird, telah menerbitkan algoritme sendiri yang dapat mensimulasikan suara siapa pun berdasarkan file suara dengan durasi satu menit. Untuk menunjukkan kemungkinan, perusahaan

memposting percakapan antara Obama, Trump dan Clinton - semua pahlawan, tentu saja, palsu.

DeepMind, Institut Baidu untuk Pembelajaran Jauh dan Institut Montreal untuk Studi Algoritma (MILA) sudah bekerja pada algoritma text-to-speech yang sangat realistis.

Hasilnya belum sempurna, Anda dapat dengan cepat membedakan suara yang diciptakan kembali dari aslinya, tetapi kesamaan dirasakan. Selain itu, dalam suara, jaringan mengubah emosi, menambah kemarahan atau kesedihan tergantung pada situasi.

Generasi gambar

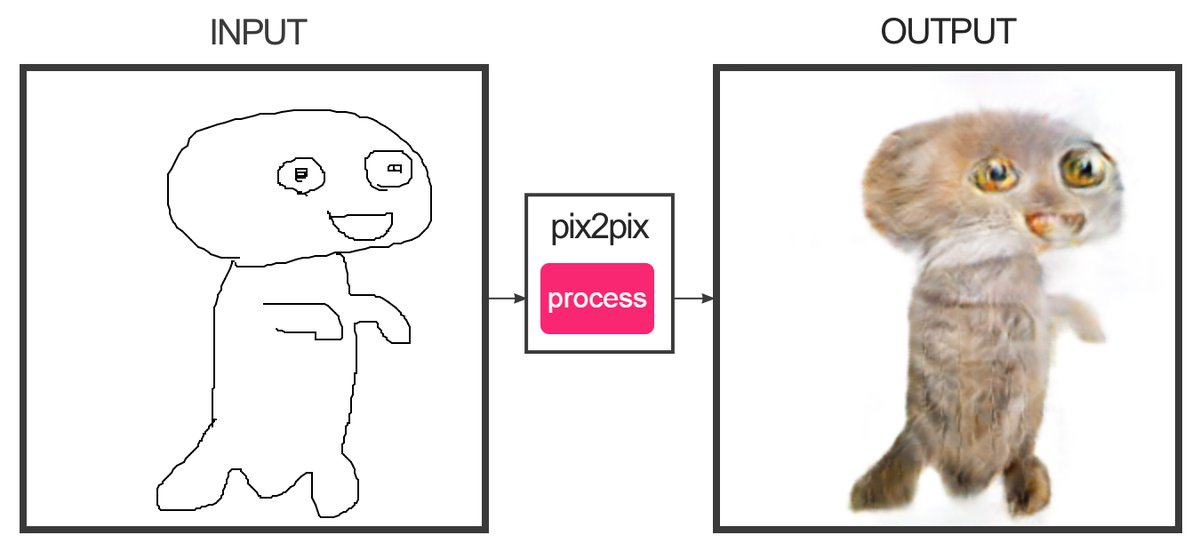

Pengembang Christopher Hesse menciptakan

layanan yang, dengan bantuan pembelajaran mesin, dapat "menggambar" sketsa yang terdiri dari beberapa garis untuk foto berwarna. Ya, ini adalah situs yang menarik kucing. Stempel berubah begitu-begitu - sulit untuk membingungkan mereka dengan yang asli.

Programmer Alexa Jolikier Martino mampu

membuat kucing yang persis seperti yang asli. Untuk melakukan ini, ia menggunakan DCGAN - Deep Convolutional Generative Adversarial Networks (jaringan kompetitif konvolusional mendalam generatif). DCGAN mampu menciptakan gambar-gambar fotorealistik yang unik dengan menggabungkan dua jaringan saraf yang dalam yang saling bersaing.

Jaringan pertama (menghasilkan) menerima nilai-nilai variabel pada input, dan pada output itu memberikan nilai-nilai fungsi variabel-variabel ini, yang harus "meyakinkan" jaringan kedua (membedakan, atau membedakan) bahwa hasil dari jaringan pertama tidak dapat dibedakan dari standar. Sebagai sampel dalam karya Joliker-Martino, database sepuluh ribu potret kucing digunakan.

Menggunakan metode DCGAN, dimungkinkan untuk membuat gambar palsu yang tidak dapat dianggap palsu tanpa jaringan saraf lain.

Kombinasi Konten

Di University of Washington, mereka

mengembangkan algoritma yang memungkinkan Anda overlay audio pada video seseorang dengan sinkronisasi bibir yang akurat. Algoritma dilatih pada 17 jam pesan video Barack Obama. Jaringan saraf dilatih untuk mensimulasikan gerakan bibir Obama sedemikian rupa untuk memperbaiki gerakan mereka dengan meniru pengucapan kata-kata yang tepat. Sejauh ini, Anda hanya dapat membuat video dengan kata-kata yang benar-benar dikatakan orang tersebut.

Sekarang lihat operasi algoritma, yang

memungkinkan Anda untuk mengubah ekspresi wajah orang lain dengan cepat menjadi ekspresi wajah Anda sendiri. Dalam video dengan Trump (masih ada demonstrasi tentang Bush, Putin dan Obama), kelengkungan orang tersebut dipaksakan di studio, dan hasilnya adalah Trump yang pemarah. Algoritma ini digunakan dalam Face2Face. Teknologi yang dibuat pada prinsipnya mirip dengan bot

Smile Vector , yang menambahkan senyum pada orang-orang di foto.

Dengan demikian, sekarang mungkin untuk membuat video yang realistis di mana orang terkenal berbicara fakta fiksi. Pidato dapat dipotong dari pidato sebelumnya sehingga dapat menulis pesan apa pun. Tetapi dalam waktu dekat bahkan trik semacam itu akan berubah menjadi berlebihan - jaringan akan menempatkan teks apa pun ke dalam mulut karakter palsu dengan sangat tepat.

Konsekuensinya

Dari sudut pandang praktis, semua teknologi ini memungkinkan Anda melakukan banyak hal baik. Misalnya, Anda dapat meningkatkan kualitas konferensi video dengan mensintesis frame yang hilang jika mereka keluar dari aliran video. Dan bahkan mensintesis seluruh kata yang hilang, memberikan komunikasi yang sangat baik di tempat dengan level sinyal apa pun.

Dimungkinkan untuk "mendigitalkan" aktor sepenuhnya dan menambahkan salinan realistisnya ke film dan game.

Tapi apa yang akan terjadi pada berita?

Sangat mungkin bahwa di tahun-tahun mendatang, generasi palsu akan mencapai tingkat yang baru. Ada cara baru untuk bertarung. Misalnya, jika Anda mengkorelasikan foto dengan kondisi yang diketahui di area tersebut (kecepatan angin, kemiringan bayangan, tingkat cahaya, dll.), Maka data ini akan membantu mengidentifikasi foto palsu.

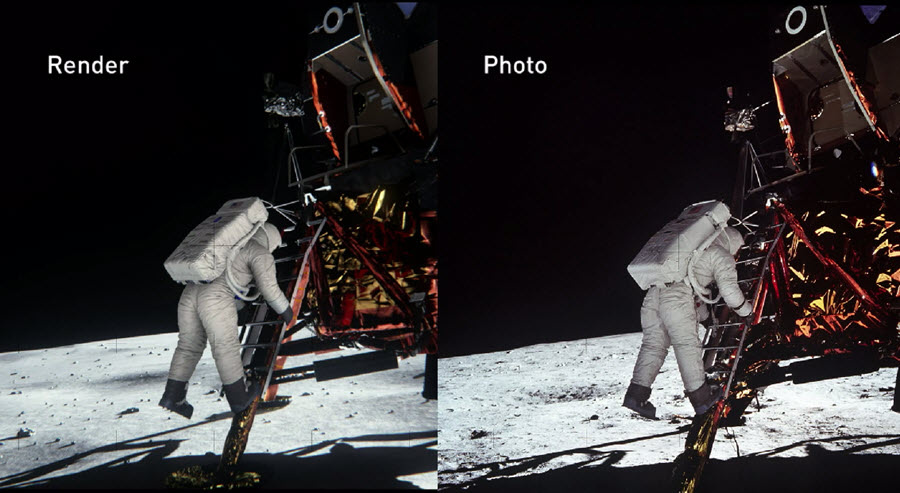

Pada 2014, para insinyur NVIDIA merekonstruksi adegan pendaratan di bulan seakurat mungkin, berdasarkan bukti dokumenter sejak saat itu. Dalam hal ini, semua sifat fisik dan optik dari objek diperhitungkan untuk mengetahui bagaimana cahaya dipantulkan dari berbagai bahan dan berperilaku secara real time. Hasilnya, mereka dapat

memverifikasi keaslian foto NASA dengan

andal .

NVIDIA mengonfirmasi bahwa dengan persiapan yang tepat, seseorang dapat membuktikan keaslian (atau sanggahan) dari karya foto paling rumit yang dibuat puluhan tahun yang lalu.

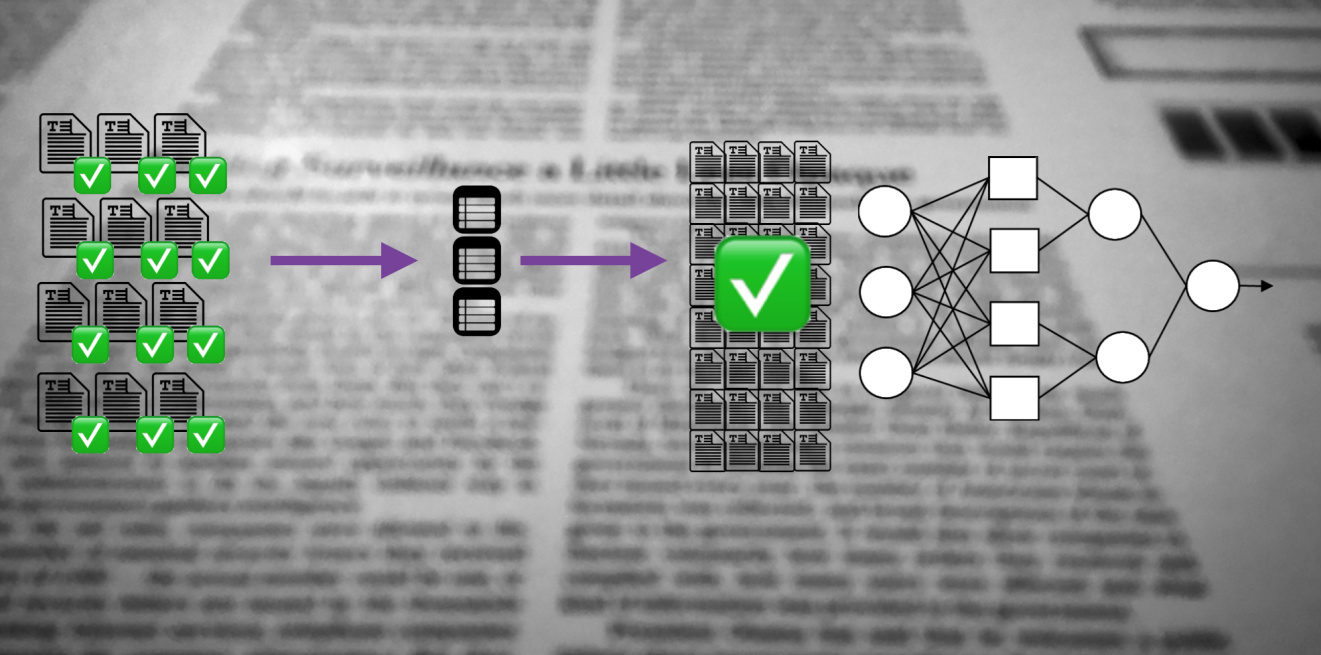

Tahun lalu, Badan Proyek Penelitian Canggih Pertahanan Amerika Serikat (DARPA) meluncurkan proyek empat tahun untuk menciptakan sistem

Media Forensik terbuka yang dapat mengidentifikasi foto-foto yang telah diproses atau terdistorsi dengan satu atau lain cara.

Jaringan saraf tidak hanya akan dapat mengubah konten asli, tetapi juga untuk mengidentifikasi palsu dengan kualitas terbaik. Siapa yang pada akhirnya akan menang dalam perlombaan teknologi ini akan menunjukkan waktu.