Sistem Artificial Intelligence (AI) mulai berkembang. Dalam hal ini, pengacara dan anggota parlemen membahas masalah bagaimana sistem seperti itu harus diatur, siapa yang akan bertanggung jawab atas tindakan mereka. Masalah ini memerlukan studi yang cermat dan pendekatan yang seimbang, karena sistem AI mampu menghasilkan data dalam jumlah besar dan digunakan dalam aplikasi dengan fungsi berbeda - dari sistem medis dan autopilot di dalam mobil hingga memprediksi kejahatan dan menghitung potensi penjahat. Pada saat yang sama, para ilmuwan berusaha untuk menciptakan "AI kuat" yang mampu beralasan, dan muncul pertanyaan tentang bagaimana menentukan keberadaan niat dalam tindakannya - atau untuk mengenali tindakan sebagai tidak disengaja.

Ada banyak cara untuk membawa sistem AI ke akuntabilitas dan tanggung jawab, beberapa penelitian telah diterbitkan tentang topik ini. Dalam sebuah

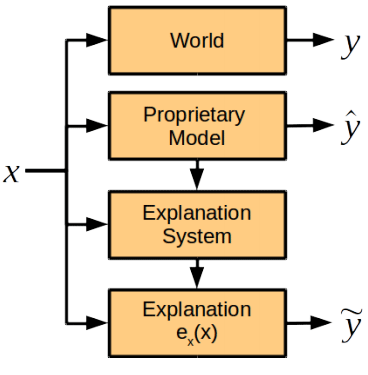

makalah penelitian baru, ilmu komputer, pakar ilmu kognitif dan pengacara dari Universitas Harvard dan Cambridge (AS) membahas satu komponen sistem pertanggungjawaban AI di masa depan, yaitu peran catatan penjelasan dari AI, yaitu penilaian tentang bagaimana sistem kecerdasan buatan menjelaskan tindakannya. . Para ilmuwan sampai pada kesimpulan bahwa modul untuk menjelaskan tindakan harus dipisahkan dari sistem AI umum.

Para penulis karya ilmiah menggambarkan semua masalah yang muncul ketika mencoba meminta sistem AI untuk penjelasan tindakannya.

Pertama, kesempatan seperti itu harus diberikan pada tahap pengembangan sistem, jika tidak AI dapat menolak atau tidak akan dapat menjelaskan tindakannya.

Kedua, sistem AI memproses sejumlah besar data menggunakan algoritme kepemilikan yang kompleks atau metode yang dikembangkan sendiri dalam proses pembelajaran. Jadi, ketika mencoba menjelaskan tindakannya dengan cara yang paling lengkap, dia dapat menghasilkan terlalu banyak data yang tidak dapat dipahami oleh seseorang. Atau - seperti ekstrem lainnya - akan memberikan model yang terlalu sederhana yang tidak akan mencerminkan niat sebenarnya AI dan motif tindakan. Selain itu, algoritme operasi sistem AI dapat menjadi kekayaan intelektual perusahaan yang sedang berkembang, sehingga perlu menyediakan metode kompilasi catatan penjelasan untuk menetapkan penyebab tindakan sistem, tetapi tidak memberikan algoritma yang mendasarinya.

Para peneliti percaya bahwa penjelasan dimungkinkan tanpa mengungkapkan algoritma dan aturan yang mendasari fungsi sistem AI. Jika terjadi insiden, sistem harus memberikan jawaban atas pertanyaan-pertanyaan berikut:

- Apa faktor utama yang mempengaruhi keputusan?

- Apakah perubahan dalam faktor tertentu menyebabkan perubahan dalam keputusan?

- Mengapa dua kasus serupa mengarah pada solusi yang berbeda?

Jawaban untuk pertanyaan semacam itu tidak selalu membutuhkan pengungkapan rahasia kepemilikan dan algoritma sistem internal, tetapi pada saat yang sama mereka akan memberikan pemahaman yang jelas tentang motifnya.

Para ilmuwan berpendapat dalam kasus-kasus mana perlu meminta AI untuk menjelaskan tindakannya. Faktanya, ini diperlukan dalam kasus di mana manfaat penjelasan melebihi harga kwitansi: “Kami percaya bahwa ada tiga kondisi untuk situasi di mana perusahaan menganggap perlu untuk mendapatkan penjelasan dari pembuat keputusan. Ini adalah alasan moral, sosial atau hukum, ”jelas Finale Doshi-Velez, penulis utama makalah ini.

Pada saat yang sama, seseorang seharusnya tidak menuntut penjelasan dari AI secara harfiah dalam setiap situasi. Sebagaimana disebutkan di atas, ini meningkatkan risiko mengeluarkan rahasia dagang dan menempatkan beban tambahan pada pengembang sistem AI. Dengan kata lain, akuntabilitas AI yang konstan kepada manusia akan menghambat pengembangan sistem ini, termasuk di bidang yang penting bagi manusia.

Berbeda dengan kepercayaan luas bahwa sistem AI adalah kotak hitam, yang penyebabnya tidak dapat dipahami manusia, para penulis karya ilmiah yakin bahwa modul yang berfungsi normal untuk menjelaskan tindakan AI dapat dikembangkan. Modul ini akan diintegrasikan ke dalam sistem, tetapi bekerja secara independen dari algoritma pengambilan keputusan dan tidak mematuhinya.

Para ilmuwan percaya bahwa ada beberapa poin dalam penjelasan tentang tindakan yang mudah dilakukan orang dan sulit untuk mesin, dan sebaliknya.

Perbandingan kemampuan manusia dan AI untuk menjelaskan | Bung | AI |

|---|

| Manfaatnya | Dapat menjelaskan tindakan posterior | Reproduksibilitas, kurangnya tekanan sosial |

| Kekurangan | Mungkin tidak akurat dan tidak dapat diandalkan, merasakan tekanan sosial | Membutuhkan pemrograman pendahuluan dari modul penjelasan, taksonomi tambahan dan perluasan sistem penyimpanan |

Namun, kelompok ahli merekomendasikan bahwa pengaturan pertama kali untuk sistem AI adalah standar yang sama untuk menjelaskan tindakan mereka yang ditetapkan untuk orang saat ini (standar ini dijabarkan dalam hukum AS: khususnya, diperlukan penjelasan dalam kasus pertanggungjawaban yang ketat, perceraian dan diskriminasi, untuk membuat keputusan administratif dan dari hakim dan juri untuk menjelaskan keputusan mereka - walaupun tingkat detail dari catatan penjelasan sangat berbeda dalam setiap kasus).

Tetapi jika alasan untuk tindakan AI melampaui pemahaman manusia, maka untuk menjelaskan AI di masa depan, standar lain dapat dikembangkan untuk catatan penjelasan mereka, kata para ilmuwan.

Artikel ilmiah ini

diterbitkan pada 3 November 2017 di situs preprint arXiv.org (arXiv: 1711.01134v1).