Pada Mei 2017, peneliti Google Brain memperkenalkan proyek

AutoML , yang mengotomatiskan desain model pembelajaran mesin. Eksperimen AutoML menunjukkan bahwa sistem ini dapat menghasilkan jaringan saraf kecil dengan kinerja sangat baik - cukup sebanding dengan jaringan saraf yang dirancang dan dilatih oleh para ahli manusia. Namun, pada awalnya AutoML terbatas pada set data ilmiah kecil seperti CIFAR-10 dan Penn Treebank.

Insinyur Google bertanya-tanya - bagaimana jika kita menempatkan tugas yang lebih serius untuk generator AI? Apakah sistem AI ini mampu menghasilkan AI lain yang akan lebih baik daripada AI buatan manusia dalam beberapa tugas penting seperti mengklasifikasikan objek dari

ImageNet - kumpulan data skala besar paling terkenal dalam visi mesin? Jadi ada jaringan saraf

NASNet , yang diciptakan hampir tanpa campur tangan manusia.

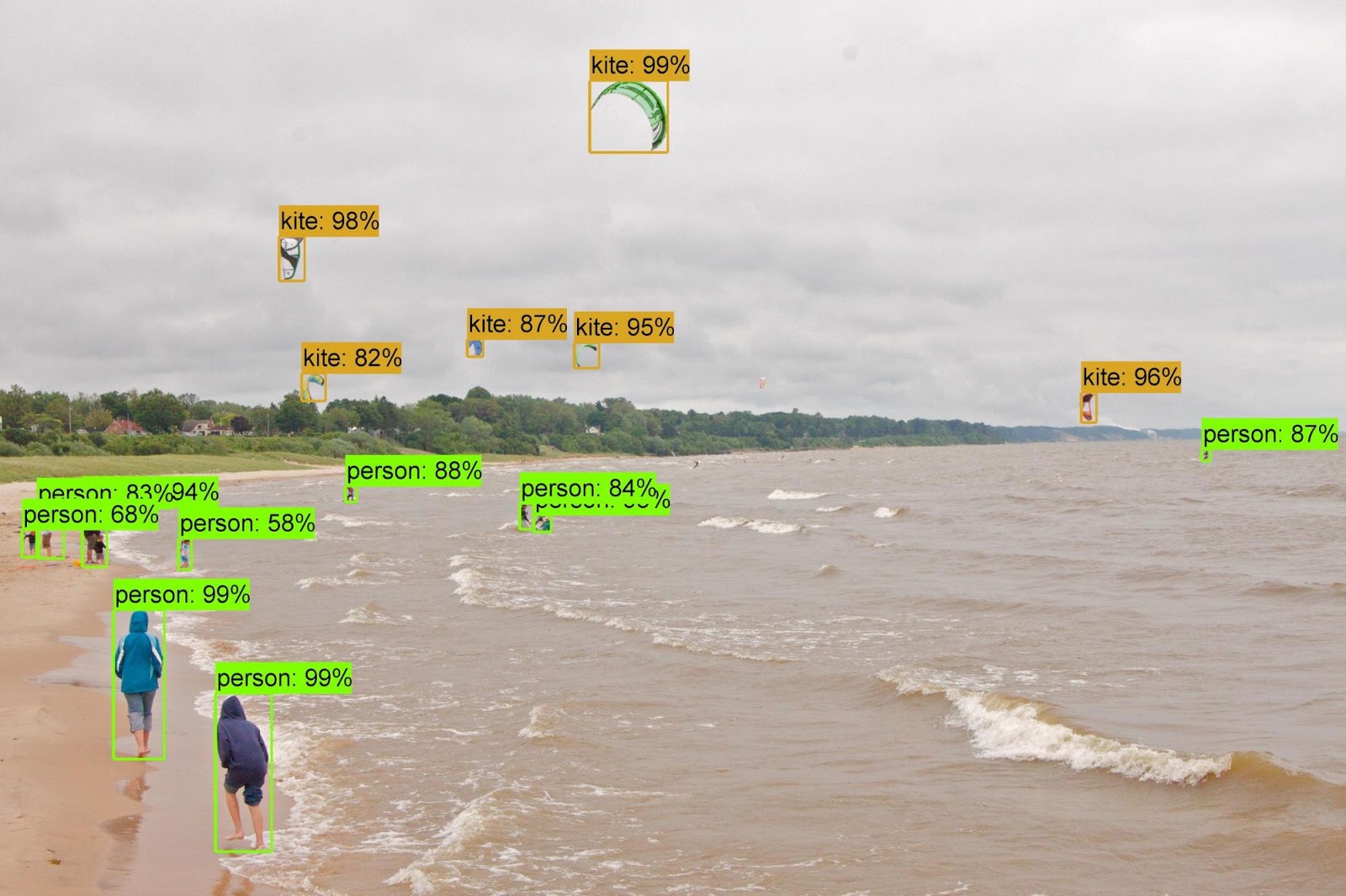

Ternyata, AI berupaya dengan desain dan pelatihan jaringan saraf tidak lebih buruk dari manusia. Tugas mengklasifikasikan objek dari dataset ImageNet dan mendefinisikan objek dari dataset

COCO adalah bagian dari proyek

Arsitektur yang Dapat Dipindahtangankan untuk proyek

Pengenalan Gambar yang Dapat Dikukur .

Pengembang proyek AutoML

mengatakan bahwa tugas tersebut ternyata tidak sepele, karena set data baru beberapa urutan besarnya lebih besar dari yang sebelumnya yang digunakan sistem untuk bekerja dengannya. Saya harus mengubah beberapa algoritma AutoML, termasuk mendesain ulang ruang pencarian sehingga AutoML dapat menemukan layer terbaik dan menduplikasinya berkali-kali sebelum membuat versi final dari jaringan saraf. Selain itu, para pengembang mengeksplorasi opsi untuk arsitektur jaringan saraf untuk CIFAR-10 - dan secara manual mentransfer arsitektur yang paling sukses ke tugas ImageNet dan COCO.

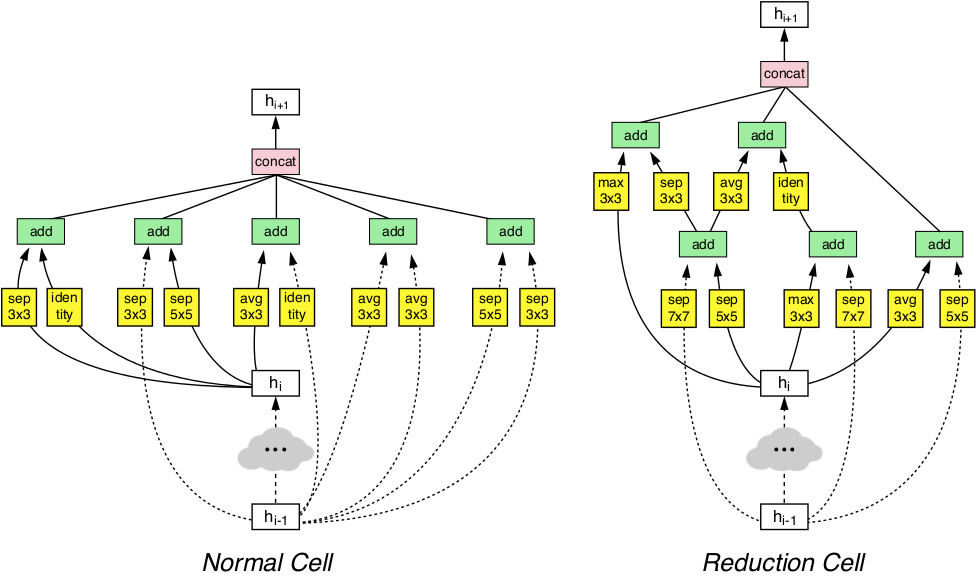

Berkat manipulasi ini, sistem AutoML mampu mendeteksi lapisan paling efisien dari jaringan saraf yang bekerja dengan baik untuk CIFAR-10 dan pada saat yang sama dilakukan dengan baik dalam tugas-tugas ImageNet dan COCO. Dua lapisan yang ditemukan ini digabungkan untuk membentuk arsitektur inovatif yang disebut NASNet.

Arsitektur NASNet terdiri dari dua jenis lapisan: lapisan normal (kiri) dan lapisan reduksi (kanan). Dua lapisan ini dirancang oleh generator AutoML.

Arsitektur NASNet terdiri dari dua jenis lapisan: lapisan normal (kiri) dan lapisan reduksi (kanan). Dua lapisan ini dirancang oleh generator AutoML.Benchmark telah menunjukkan bahwa AI yang dihasilkan secara otomatis melampaui semua sistem visi mesin lainnya yang dibuat dan dilatih oleh para ahli manusia dalam klasifikasi dan definisi objek.

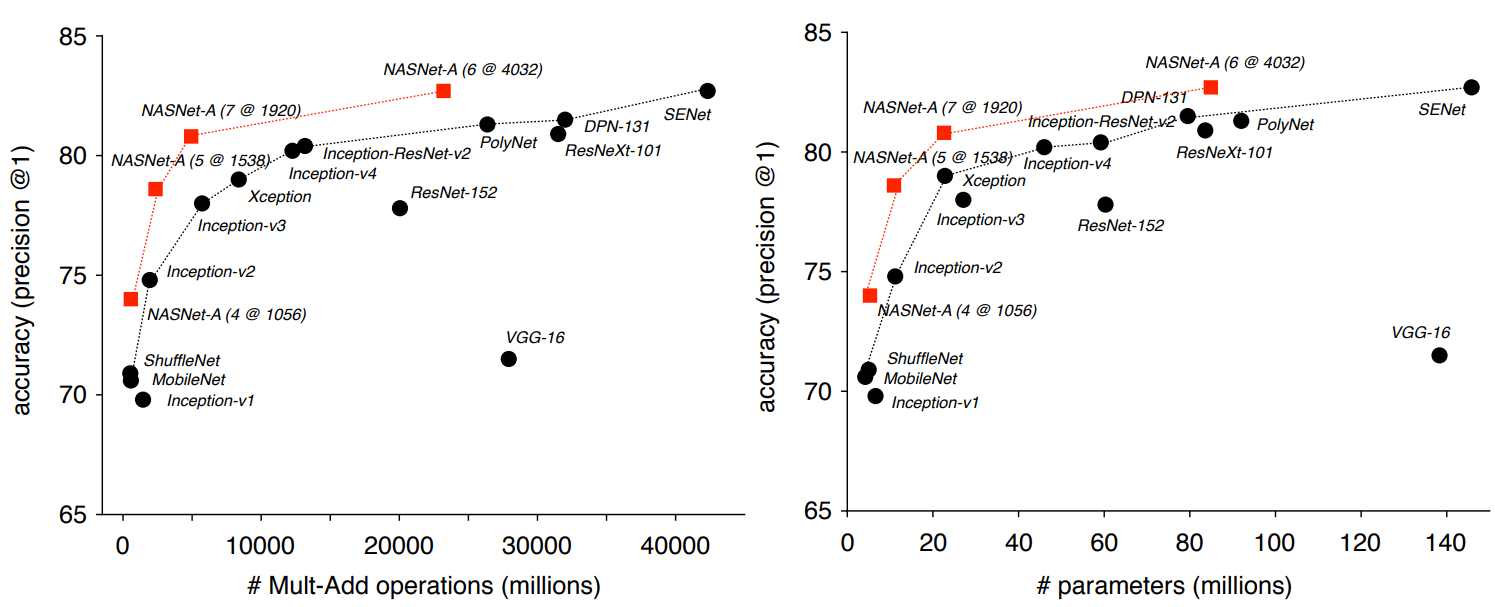

Jadi, dalam tugas klasifikasi berdasarkan ImageNet, jaringan saraf NASNet menunjukkan akurasi prediksi 82,7% pada set tes. Hasil ini lebih tinggi dari semua model visi mesin yang dirancang sebelumnya dari keluarga Inception. Sistem NASNet menunjukkan hasil setidaknya 1,2 poin lebih tinggi dari semua jaringan saraf penglihatan mesin yang diketahui, termasuk hasil terbaru dari karya-karya yang belum diterbitkan dalam pers ilmiah, tetapi sudah diposting di situs pracetak arXiv.org.

Para peneliti menekankan bahwa NASNet dapat ditingkatkan dan, karenanya, disesuaikan untuk bekerja pada sistem dengan sumber daya komputasi yang lemah tanpa kehilangan banyak keakuratan. Jaringan saraf dapat bekerja bahkan pada ponsel dengan CPU yang lemah dengan sumber daya memori terbatas. Para penulis mengatakan bahwa versi miniatur NASNet menunjukkan akurasi 74%, yang merupakan 3,1 poin persentase lebih baik daripada jaringan saraf yang dikenal berkualitas tinggi untuk platform mobile.

Ketika atribut yang diperoleh dari pengelompokan ImageNet dipindahkan ke pengenalan objek dan dikombinasikan dengan

kerangka kerja Faster-RCNN , sistem menunjukkan hasil terbaik dalam masalah pengenalan objek COCO baik dalam model besar maupun dalam versi yang dikurangi untuk platform seluler. Model besar menunjukkan hasil 43,1% peta, yang merupakan 4 poin persentase lebih baik dari pesaing terdekat.

Para penulis membuka kode sumber untuk NASNet di repositori

Slim dan

Object Detection untuk TensorFlow, sehingga semua orang dapat mengalami jaringan saraf baru dalam pekerjaan mereka sendiri.

Artikel ilmiah ini

diterbitkan pada 1 Desember 2017 di situs pracetak arXiv.org (arXiv: 1707.07012v3, versi ketiga).