Saat ini, CERN adalah salah satu pengguna Kubernetes terbesar di dunia. Menurut statistik baru-baru ini, 210 cluster K8 Eropa telah diluncurkan dalam organisasi Eropa di belakang Large Hadron Collider (LHC) dan sejumlah proyek penelitian terkenal lainnya, melayani ratusan ribu tugas secara bersamaan. Kisah sukses ini tentang mereka.

Kontainer CERN: mulai

Bagi mereka yang paling tidak terbiasa dengan kegiatan CERN, bukan rahasia lagi bahwa banyak perhatian diberikan pada organisasi ini untuk teknologi informasi yang relevan: ingatlah bahwa ini adalah tempat kelahiran World Wide Web, dan di antara kelebihan terbaru Anda dapat mengingat sistem grid (termasuk

LHC Computing Grid ),

sirkuit terintegrasi khusus,

distribusi Scientific Linux, dan bahkan

lisensi perangkat keras terbuka

sendiri . Sebagai aturan, proyek-proyek ini, apakah itu perangkat lunak atau perangkat keras, terhubung dengan gagasan utama CERN-LHC. Ini juga berlaku untuk infrastruktur TI CERN, yang sebagian besar melayani kebutuhannya sendiri.

Di pusat data CERN di Jenewa

Di pusat data CERN di JenewaInformasi paling awal yang tersedia untuk umum tentang penggunaan praktis wadah dalam infrastruktur organisasi, yang ditemukan, berasal dari April 2016. Sebagai bagian dari laporan "internal" oleh

Containers dan Orchestration di CERN Cloud , karyawan CERN berbicara tentang bagaimana mereka menggunakan OpenStack Magnum

(komponen OpenStack untuk bekerja dengan mesin orkestra wadah) untuk memberikan dukungan untuk kontainer di cloud mereka (CERN Cloud) dan orkestrasi mereka. Sudah menyebut Kubernetes, para insinyur bertujuan untuk mandiri dari instrumen orkestrasi yang dipilih, mendukung opsi lain: Docker Swarm dan Mesos.

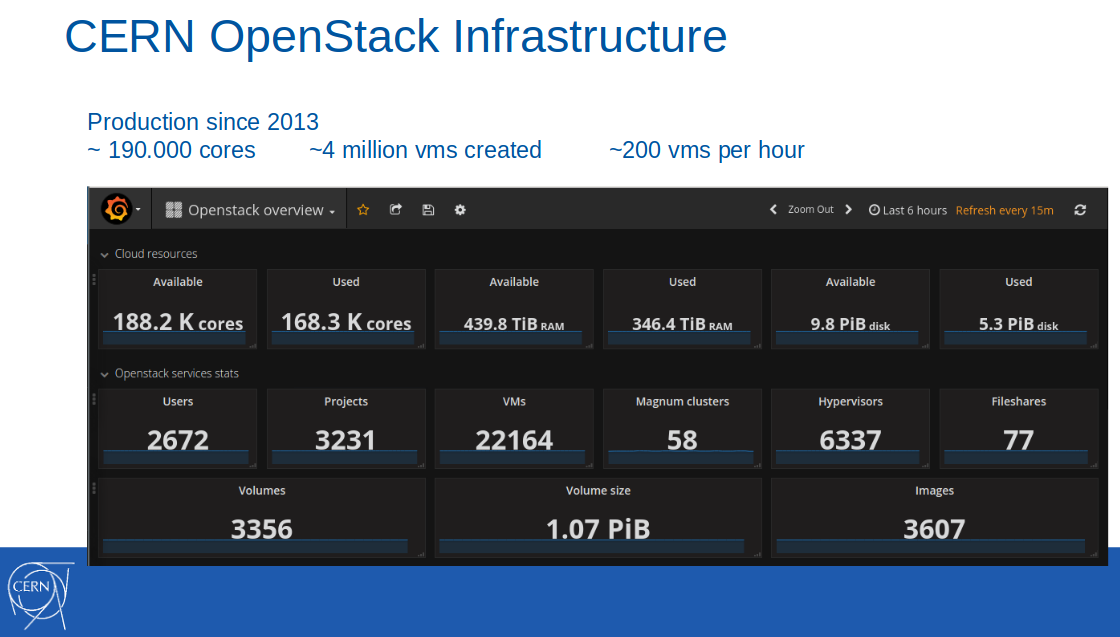

Catatan : Cloud OpenStack sendiri diperkenalkan ke infrastruktur produksi CERN beberapa tahun sebelumnya, pada 2013. Pada Februari 2017, 188 ribu core, 440 TB RAM tersedia di cloud ini, 4 juta mesin virtual diciptakan (22.000 di antaranya aktif).

Pada saat itu, dukungan kontainer dalam format Containers-as-a-Service diposisikan sebagai layanan percontohan dan digunakan dalam sepuluh proyek TI organisasi. Di antara skenario aplikasi, integrasi berkelanjutan dengan GitLab CI dipanggil untuk membangun dan meluncurkan aplikasi dalam wadah Docker.

Dari presentasi hingga laporan CERN 8 April 2016

Dari presentasi hingga laporan CERN 8 April 2016Peluncuran layanan ini dalam produksi diharapkan pada kuartal ketiga 2016.

Catatan : Perlu dicatat secara terpisah bahwa karyawan CERN selalu menerapkan praktik terbaik mereka ke hulu proyek Open Source yang digunakan, termasuk dan banyak komponen OpenStack, yang dalam hal ini adalah Magnum, puppet-magnum, Rally, dll.Jutaan permintaan per detik dengan Kubernetes

Pada Juni tahun yang sama (2016) tahun, layanan di CERN masih

memiliki status pra-produksi:

"Kami secara bertahap bergerak menuju mode produksi penuh untuk memasukkan Containers-as-a-Service dalam serangkaian standar layanan TI yang tersedia di CERN."

Dan kemudian, terinspirasi oleh

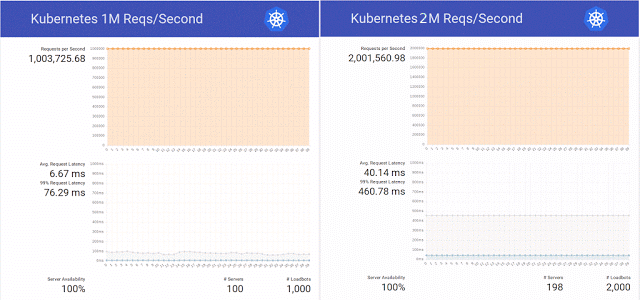

publikasi di blog Kubernetes tentang melayani 1 juta permintaan HTTP per detik tanpa downtime selama pembaruan layanan di K8, para insinyur dari organisasi ilmiah memutuskan untuk mengulangi keberhasilan ini dalam cluster mereka pada OpenStack Magnum, Kubernetes 1.2 dan basis perangkat keras dari 800 core CPU.

Selain itu, mereka memutuskan untuk tidak membatasi diri pada pengulangan sederhana percobaan dan berhasil meningkatkan jumlah permintaan menjadi 2 juta per detik, secara bersamaan menyiapkan beberapa tambalan untuk OpenStack Magnum yang sama dan melakukan tes dengan jumlah node yang berbeda dalam cluster (300, 500 dan 1000).

Merangkum hasil pengujian ini, para insinyur kembali mencatat bahwa "ada juga Swarm dan Mesos, dan kami berencana untuk melakukan tes pada mereka segera." Apakah masalah ini telah mencapai tes ini, Internet tidak diketahui, tetapi pada akhir tahun itu, percobaan dengan Kubernetes

dilanjutkan - dengan 10 juta permintaan per detik. Hasilnya cukup positif, tetapi terbatas pada tanda sukses lebih dari 7 juta - karena masalah jaringan yang tidak terkait dengan OpenStack.

Insinyur yang berspesialisasi dalam OpenStack Heat dan Magnum juga mengukur bahwa butuh 23 menit untuk menskala cluster dari 1 hingga 1000 node, mengevaluasinya sebagai hasil yang baik

(lihat juga Menuju 10.000 Kontainer pada presentasi OpenStack di OpenStack Summit Barcelona 2016) .

Kontainer di CERN: transisi ke produksi

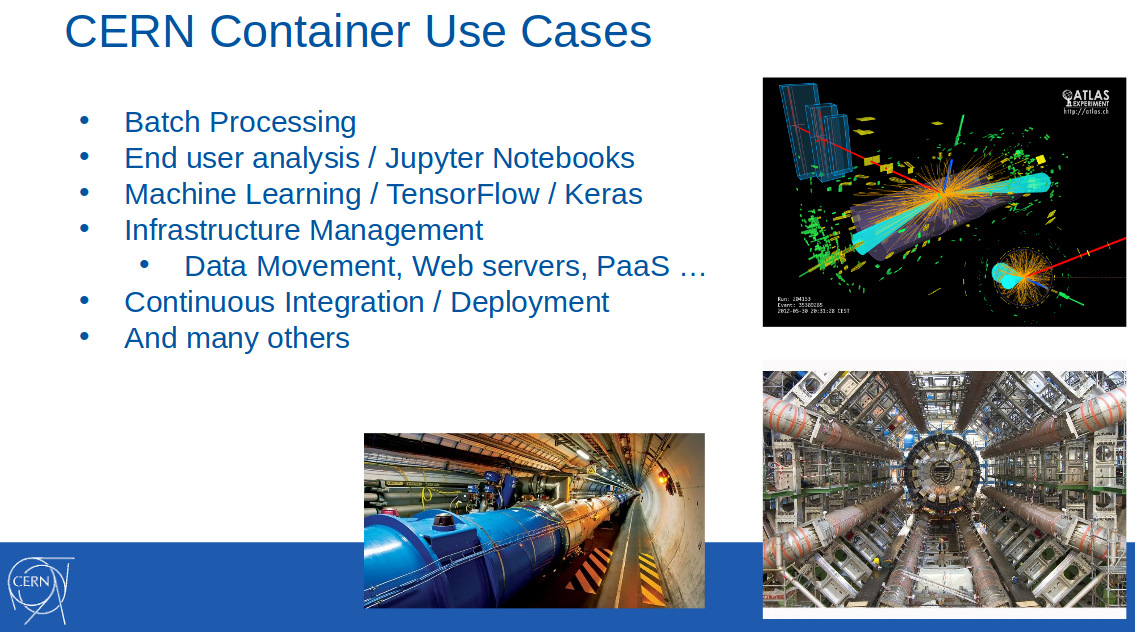

Pada bulan Februari tahun berikutnya (2017), kontainer di CERN sudah banyak digunakan untuk menyelesaikan masalah dari berbagai bidang: pemrosesan batch, pembelajaran mesin, manajemen infrastruktur, penyebaran berkelanjutan ... Ini diumumkan dalam laporan “

OpenStack Magnum di CERN. Menskalakan cluster kontainer ke ribuan node "(

video ) di FOSDEM 2017:

Juga dilaporkan bahwa penggunaan Magnum di CERN memasuki fase produksi pada Oktober 2016, dan sekali lagi menekankan dukungan tiga instrumen untuk orkestrasi: Kubernetes, Docker Swarm dan Mesos. Mengapa itu sangat penting,

dijelaskan pada salah satu pidatonya (OpenStack Summit di Boston, Mei 2017) Ricardo Rocha dari departemen TI CERN:

“Magnum juga memungkinkan kami memilih mesin kontainer, yang sangat berharga bagi kami. Sekelompok orang yang menganjurkan Kubernet bekerja di organisasi, tetapi ada juga yang sudah menggunakan Mesos, dan beberapa bahkan bekerja dengan Docker biasa, ingin terus mengandalkan API Docker, dan Swarm memiliki potensi besar di sini. Kami ingin mencapai kemudahan penggunaan, bukan mengharuskan orang untuk memahami pola yang rumit untuk mengkonfigurasi cluster mereka. "

Pada saat itu, CERN menggunakan sekitar 40 cluster dengan Kubernetes, 20 dengan Docker Swarm, dan 5 dengan Mesosphere DC / OS.

Setahun kemudian, pada Mei 2018, situasinya telah berubah secara signifikan. Dari

CERN Experiences dengan presentasi Multi-Cloud Federated Kubernetes (

video ) oleh Ricardo dan rekannya (Clenimar Filemon) di KubeCon Europe 2018, detail baru tentang penggunaan Kubernet menjadi dikenal. Sekarang ini bukan hanya salah satu alat orkestrasi wadah yang tersedia untuk pengguna organisasi ilmiah, tetapi juga teknologi penting untuk seluruh infrastruktur, yang memungkinkan - berkat federasi - untuk secara signifikan memperluas cloud komputasi dengan menambahkan sumber daya pihak ketiga (GKE, AKS, Amazon, Oracle ...) ke kapasitasnya sendiri.

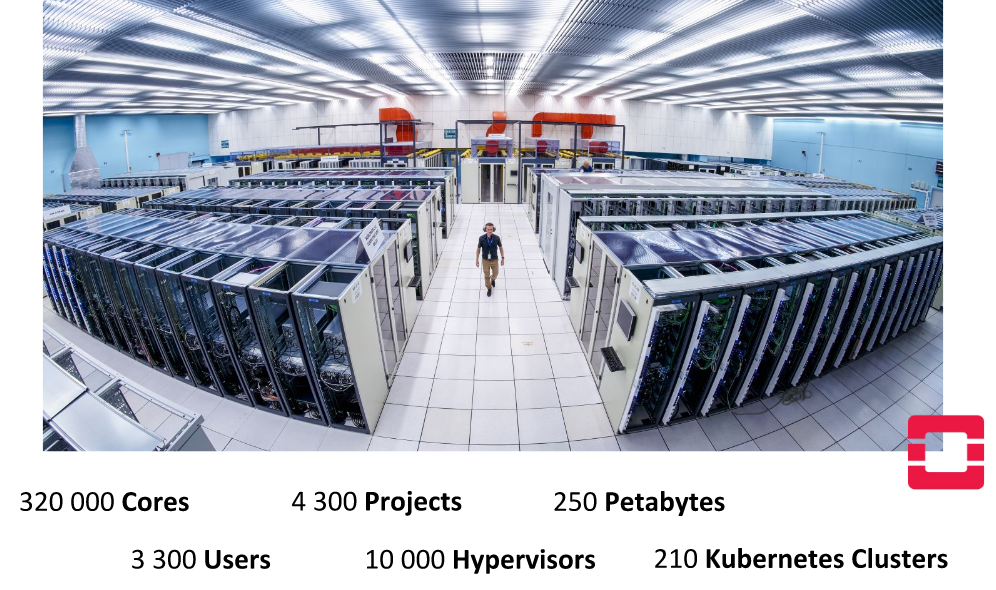

Catatan : Federasi di Kubernetes adalah mekanisme khusus yang menyederhanakan pengelolaan beberapa kluster dengan menyinkronkan sumber daya yang berada di dalamnya dan secara otomatis mendeteksi layanan di semua kluster. Sebuah kasus aktual dari aplikasinya bekerja dengan berbagai kluster Kubernet yang didistribusikan di berbagai penyedia (pusat data mereka, layanan cloud pihak ketiga).Seperti yang dapat Anda lihat dari slide ini, yang menunjukkan beberapa karakteristik kuantitatif dari pusat data CERN di Jenewa ...

... infrastruktur internal organisasi telah berkembang pesat. Sebagai contoh, jumlah core yang tersedia untuk tahun ini hampir dua kali lipat - sudah mencapai 320 ribu. Para insinyur melangkah lebih jauh dan menggabungkan beberapa pusat data mereka, setelah mencapai ketersediaan 700 ribu core di cloud CERN, yang terlibat dalam pelaksanaan paralel 400 ribu tugas (untuk rekonstruksi acara, kalibrasi detektor, simulasi, analisis data, dll.) ...

Tetapi dalam konteks artikel ini, fakta bahwa sudah ada 210 cluster Kubernetes, yang ukurannya sangat bervariasi (dari 10 hingga 1000 node), lebih menarik.

Federasi dengan Kubernetes

Namun, kapasitas internal CERN tidak selalu cukup - misalnya, untuk periode ledakan beban yang tajam: sebelum konferensi internasional besar-besaran tentang fisika dan dalam kasus kampanye besar untuk rekonstruksi eksperimen. Kasus penggunaan yang nyata yang membutuhkan sumber daya besar adalah Layanan Batch CERN, yang menyumbang sekitar 80% dari sumber daya komputasi organisasi.

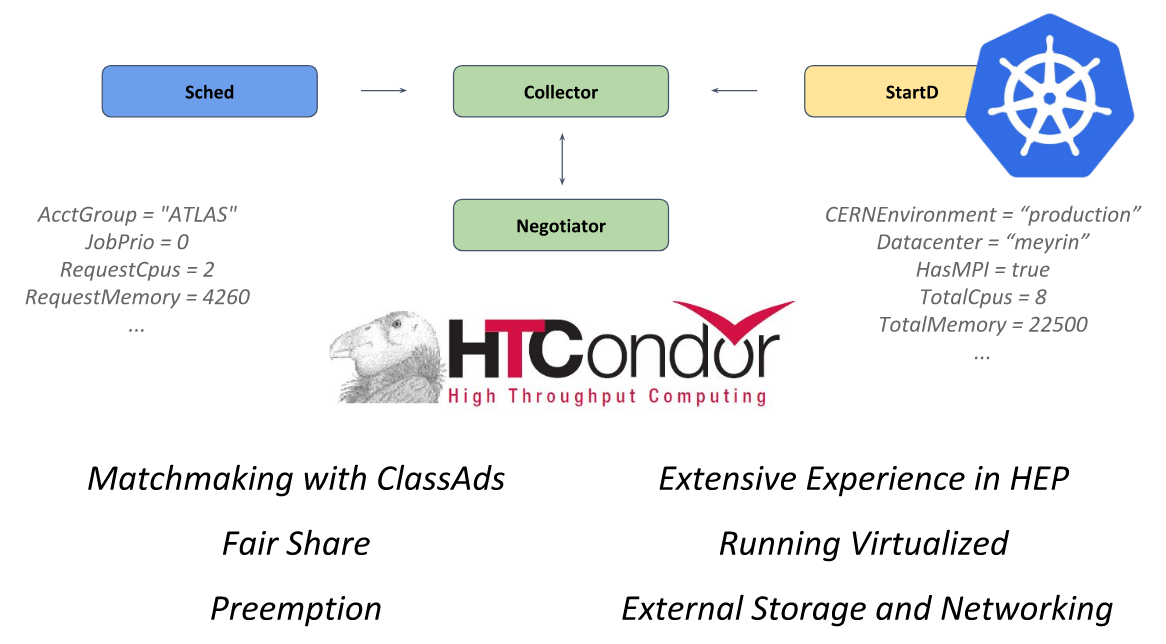

Di jantung dari sistem ini adalah kerangka kerja sumber terbuka

HTCondor , yang dirancang untuk memecahkan masalah kategori HTC (komputasi throughput tinggi). Daemon StartD bertanggung jawab untuk perhitungan di dalamnya, yang dimulai pada setiap node dan bertanggung jawab untuk memulai beban kerja di atasnya. Dialah yang kemas di CERN dengan tujuan meluncurkan di Kubernetes dan federasi lebih lanjut.

HTCondor dari presentasi CERN di KubeCon Europe 2018

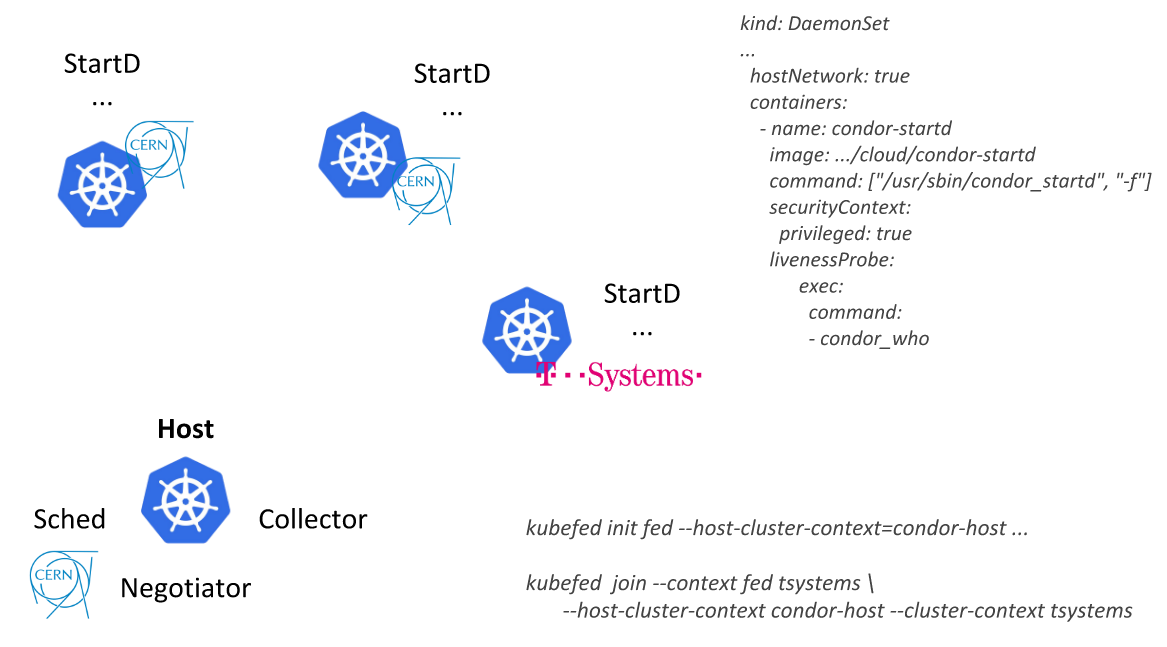

HTCondor dari presentasi CERN di KubeCon Europe 2018Mengikuti jalur ini, para insinyur CERN dapat mendeskripsikan satu sumber daya tunggal (

DaemonSet dengan sebuah wadah tempat StartD diluncurkan dari HTCondor) dan menyebarkannya pada node semua kluster Kubernet federasi: pertama sebagai bagian dari pusat data, dan kemudian menghubungkan penyedia eksternal (cloud publik) dari T-Systems dan perusahaan lain):

Aplikasi lain adalah platform analitik berbasis

REANA ,

RECAST, dan

Yadage . Tidak seperti Layanan Batch CERN, yang merupakan perangkat lunak "mapan" dalam organisasi, ini adalah pengembangan baru, yang segera mempertimbangkan spesifikasi aplikasi bersama dengan Kubernetes. Alur kerja dalam sistem ini diimplementasikan sedemikian rupa sehingga setiap langkah dikonversi menjadi

Job for Kubernetes.

Jika awalnya semua tugas ini dijalankan pada satu cluster, maka seiring waktu, permintaan tumbuh dan "hari ini adalah federasi use case terbaik kami di Kubernetes." Tonton video pendek dengan peragaannya dalam

fragmen pidato Ricardo Rocha ini.

PS

Informasi tambahan tentang sejauh mana penggunaan TI di CERN dapat ditemukan di

situs web organisasi .

Artikel lain dari siklus