Setahun yang lalu, saya

membuat pusat data dari tumpukan Intel NUC . Ada sistem penyimpanan perangkat lunak yang tidak bisa dihancurkan wanita pembersih itu, beberapa kali clusternya runtuh.

Dan sekarang kami memutuskan untuk menjalankan vSAN pada beberapa server dalam konfigurasi yang sangat baik untuk sepenuhnya mengevaluasi kinerja dan toleransi kesalahan dari solusi. Tentu saja, kami memiliki sejumlah implementasi yang berhasil dalam produksi untuk pelanggan kami, di mana vSAN berhasil menyelesaikan tugas yang ditetapkan, tetapi tidak mungkin untuk melakukan pengujian komprehensif. Sebenarnya, saya ingin membagikan hasil tes hari ini.

Kami akan menyiksa penyimpanan dengan memuat, menjatuhkannya dan dengan segala cara menguji toleransi kesalahan. Untuk lebih jelasnya, saya mengundang semua orang ke kucing.

Apa itu VMware vSAN secara umum dan mengapa kita memasukinya?

Ada cluster server reguler untuk mesin virtual. Ini memiliki banyak komponen independen, hypervisor berjalan langsung pada perangkat keras, dan penyimpanan dikonfigurasi secara terpisah berdasarkan DAS, NAS atau SAN. Data lambat pada HDD, data panas pada SSD. Semuanya akrab. Namun di sini muncul masalah penyebaran dan administrasi kebun binatang ini. Ini menjadi sangat menyenangkan dalam situasi di mana elemen individu dari sistem dari vendor yang berbeda. Jika terjadi masalah, docking tiket untuk dukungan teknis dari berbagai produsen memiliki suasana tersendiri.

Ada potongan-potongan besi yang terpisah yang dari sudut pandang server terlihat seperti cakram untuk merekam.

Dan ada sistem hyperconverged. Di dalamnya, Anda diberikan unit universal yang membuat seluruh sakit kepala dari interaksi jaringan, disk, prosesor, memori dan mesin-mesin virtual yang berputar pada mereka. Semua data mengalir ke satu panel kontrol, dan jika perlu, Anda cukup menambahkan beberapa unit lagi untuk mengimbangi peningkatan beban. Administrasi sangat disederhanakan dan terstandarisasi.

VMware vSAN hanya merujuk pada solusi yang digunakan

infrastruktur terkonvergensi. Fitur utama dari produk ini adalah integrasi yang erat dengan platform virtualisasi VMware vSphere, yang merupakan pemimpin di antara solusi virtualisasi yang memungkinkan Anda untuk menggunakan penyimpanan perangkat lunak untuk mesin virtual pada server virtualisasi dalam hitungan menit. vSAN secara langsung mengendalikan operasi I / O pada level rendah, mendistribusikan beban secara optimal, melakukan caching operasi baca / tulis dan melakukan lebih banyak lagi dengan beban minimal pada memori dan prosesor. Transparansi sistem sedikit berkurang, tetapi sebagai hasilnya, semuanya berfungsi, seperti yang mereka katakan, secara otomatis vSAN dapat dikonfigurasi sebagai penyimpanan hybrid dan dalam bentuk versi semua-flash. Itu diskalakan secara horizontal dengan menambahkan node baru ke cluster, dan secara vertikal, meningkatkan jumlah disk di node individu. Mengelola dengan klien web vSphere sendiri sangat nyaman karena integrasi yang erat dengan produk lain.

Kami menetapkan konfigurasi all-flash yang bersih, yang seharusnya optimal dalam hal harga dan kinerja. Jelas bahwa kapasitas total sedikit lebih rendah dibandingkan dengan konfigurasi hibrid menggunakan disk magnetik, tetapi di sini kami memutuskan untuk memeriksa bagaimana ini sebagian dapat dielakkan menggunakan pengkodean penghapusan, serta deduplikasi dan kompresi dengan cepat. Akibatnya, efisiensi penyimpanan menjadi lebih dekat dengan solusi hybrid, tetapi secara signifikan lebih cepat dengan overhead yang minimal.

Cara menguji

Untuk menguji kinerja, kami menggunakan perangkat lunak

HCIBench v1.6.6 , yang mengotomatiskan proses pembuatan banyak mesin virtual dan kemudian menyusun hasilnya. Pengujian kinerja itu sendiri dilakukan dengan menggunakan perangkat lunak Vdbench, salah satu perangkat lunak pengujian beban sintetis paling populer. Besi berada di opsi konfigurasi berikut:

- All-flash - 2 grup disk: SSD 1xNVMe Samsung PM1725 800 GB + 3xSATA

- SSD Toshiba HK4E 1.6 TB.

- All-flash - 1 grup disk: SSD 1xNVMe Samsung PM1725 800 GB + SSD 6xSATA Toshiba HK4E 1.6 TB.

- All-flash - 1 grup disk: SSD 1xNVMe Samsung PM1725 800GB + SSD 6xSATA Toshiba HK4E 1,6 TB + Efisiensi Ruang (deduplikasi dan kompresi).

- All-flash - 1 grup disk: 1xNVMe SSD Samsung PM1725 800GB + 6xSATA SSD Toshiba HK4E 1,6 TB + Coding Penghapusan (RAID 5/6).

- All-flash - 1 grup disk: SSD 1xNVMe Samsung PM1725 800GB + SSD 6xSATA Toshiba HK4E 1,6 TB + Pengkodean Penghapusan (RAID 5/6) + Efisiensi Ruang (deduplikasi dan kompresi).

Selama pengujian, kami meniru tiga volume berbeda dari data aktif yang digunakan oleh aplikasi: 1 TB (250 GB per server), 2 TB (500 GB per server) dan 4 TB (masing-masing 1 TB).

Untuk setiap konfigurasi, serangkaian pengujian yang sama dilakukan dengan profil pemuatan berikut:

- 0 baca / 100 tulis, secara acak 50%, ukuran blok - 4k.

- 30 baca / 70 tulis, secara acak 50%, ukuran blok - 4k.

- 70 baca / 30 tulis, secara acak 50%, ukuran blok - 4k.

- 100 baca / 0 tulis, secara acak 50%, ukuran blok - 4k.

Opsi pertama dan keempat diperlukan untuk memahami bagaimana sistem akan berperilaku di bawah beban maksimum dan minimum. Tetapi yang kedua dan ketiga sedekat mungkin dengan kasus penggunaan khas yang nyata: misalnya, 30 read / 70 write - VDI. Beban yang saya temui dalam produksi sangat dekat dengan mereka. Dalam prosesnya, kami menguji efektivitas mekanisme manajemen data vSAN.

Secara umum, sistem terbukti sangat baik. Berdasarkan hasil tes, kami menyadari bahwa kami dapat mengandalkan kinerja di wilayah 20 ribu IOPS per node. Untuk tugas-tugas biasa dan sarat muatan, ini adalah indikator yang baik dengan memperhitungkan penundaan akun 5 ms. Di bawah ini saya memberikan grafik dengan hasil:

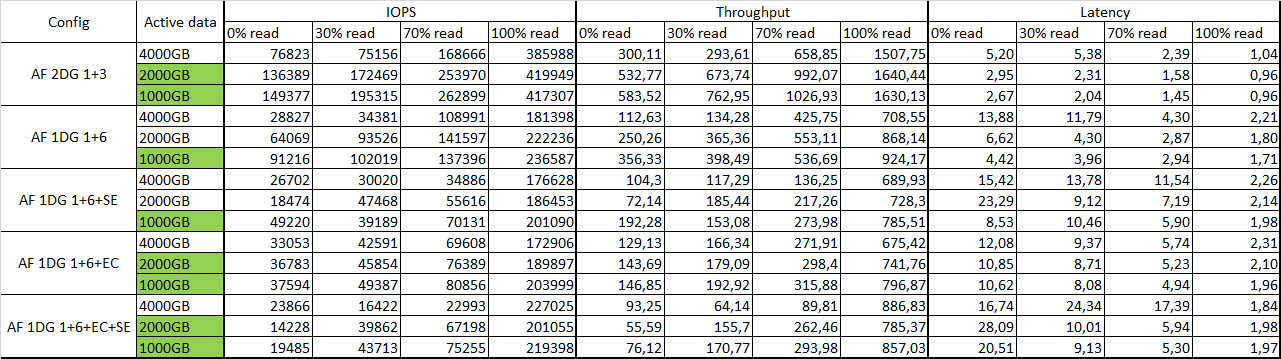

Tabel ringkasan dengan hasil tes:

Warna hijau menunjukkan data aktif yang sepenuhnya di-cache.

Toleransi kesalahan

Saya memotong satu simpul demi simpul, terlepas dari kemarahan mesin, dan melihat reaksi sistem secara keseluruhan. Setelah melepaskan node pertama, tidak ada yang terjadi sama sekali, kecuali penurunan kecil dalam kinerja, sekitar 10-15%. Saya mengeluarkan node kedua - beberapa mesin virtual ditutup, tetapi sisanya terus bekerja dengan sedikit penurunan kinerja. Secara keseluruhan survivability senang. Restart semua node - sistem berpikir sedikit dan disinkronkan lagi tanpa masalah, semua mesin virtual dimulai tanpa masalah. Seperti pada suatu waktu di NUC. Integritas data juga tidak terpengaruh, yang sangat menyenangkan.

Kesan umum

Software Defined Storage Systems (SDS) sudah merupakan teknologi yang matang.

Saat ini, salah satu faktor penghenti utama yang menghalangi implementasi vSAN adalah biaya lisensi yang agak tinggi dalam rubel. Jika Anda membuat infrastruktur dari awal, mungkin ternyata sistem penyimpanan tradisional dalam konfigurasi yang sama harganya hampir sama. Tetapi akan kurang fleksibel baik dalam hal administrasi dan skala. Jadi hari ini, ketika memilih solusi untuk menyimpan data mesin virtual pada platform virtualisasi vSphere, sangat baik untuk mempertimbangkan semua pro dan kontra dari menggunakan solusi tradisional dan menerapkan teknologi penyimpanan yang ditentukan perangkat lunak.

Anda dapat membangun solusi pada Ceph atau GlusterFS yang sama, tetapi ketika bekerja dengan infrastruktur VMware, integrasi erat vSAN dengan komponen individual, serta kemudahan administrasi, penyebaran, dan kinerja yang jauh lebih besar, terutama pada sejumlah kecil node, menawan. Karena itu, jika Anda sudah bekerja pada infrastruktur VMware, maka akan lebih mudah bagi Anda untuk menggunakan. Anda benar-benar melakukan selusin klik dan mendapatkan SDS yang berfungsi di luar kotak.

Motivasi lain untuk menggunakan vSAN adalah menggunakannya untuk cabang, yang memungkinkan Anda untuk merefleksikan node di unit jarak jauh dengan host saksi di pusat data. Konfigurasi ini menyediakan penyimpanan yang tahan terhadap kesalahan untuk mesin virtual dengan semua teknologi dan kinerja vSAN hanya pada dua node. Omong-omong, untuk menggunakan vSAN ada skema lisensi terpisah untuk jumlah mesin virtual, yang memungkinkan untuk mengurangi biaya dibandingkan dengan skema lisensi vSAN tradisional untuk prosesor.

Secara arsitektur, solusi ini membutuhkan 10 Gb Ethernet dengan dua tautan per node untuk distribusi lalu lintas yang memadai saat menggunakan solusi all-flash. Dibandingkan dengan sistem tradisional, Anda menghemat ruang rak dan menghemat jaringan SAN dengan menghilangkan Fibre Channel demi standar Ethernet yang lebih universal. Untuk memastikan toleransi kesalahan, setidaknya diperlukan tiga node, pada dua replika objek dengan data yang akan disimpan, dan pada objek saksi ketiga untuk data ini, memecahkan masalah otak terpisah.

Sekarang beberapa pertanyaan untuk Anda:

- Ketika Anda memutuskan sistem penyimpanan, kriteria apa yang paling penting bagi Anda?

- Apa faktor penghenti yang Anda lihat di jalur penerapan sistem penyimpanan yang ditentukan perangkat lunak?

- Sistem penyimpanan apa yang ditentukan oleh perangkat lunak yang pada dasarnya Anda pertimbangkan sebagai opsi untuk implementasi?

UPD: Saya benar-benar lupa menulis konfigurasi dudukan dan memuat parameter:

1. Deskripsi besi. Sebagai contoh:

Server - 4xDellR630, masing-masing:

• 2xE5-2680v4

• RAM 128GB

• 2x10GbE

• 2x1GbE untuk manajemen / Jaringan VM

• Dell HBA330

Konfigurasi Penyimpanan # 1:

2xPM1725 800GB

6xToshiba HK4E 1.6TB

Konfigurasi Penyimpanan # 2:

1xPM1725 800GB

6xToshiba HK4E 1.6TB

2. Deskripsi versi perangkat lunak:

vSphere 6.5U1 (7967591) (vSAN 6.6.1), yaitu tambalan setelah Meltdown / Spectre

vCenter 6.5U1g

Driver dan FW terbaru yang didukung oleh vSAN dan ESXi untuk semua komponen

LACP untuk lalu lintas vSAN dan vMotion (dengan saham / batas / reservasi NIOC diaktifkan)

Semua pengaturan lainnya adalah default

3. Parameter beban:

• HCIBench 1.6.6

• Oracle Vdbench - 04/05/06

• 40VM per cluster (10 per node)

• 10 vmdk per VM

• Ukuran 10GB dari vmdk dan persentase set beban kerja 100/50/25%

• Waktu pemanasan-1800sec (0,5 jam), Waktu tes 3600 (1 jam)

• 1 utas per vmdk