Beberapa bulan yang lalu, ketika mengerjakan proyek berikutnya, orang-orang dari laboratorium penelitian kami mempelajari disk NVMe dan solusi perangkat lunak untuk menemukan opsi terbaik untuk merakit array perangkat lunak.

Hasil tes kemudian secara mengejutkan mengecewakan - potensi kecepatan besar dari disk NVMe sama sekali tidak berkorelasi dengan kinerja yang ditunjukkan dari produk perangkat lunak yang ada.

Pengembang kami tidak menyukainya. Dan mereka memutuskan untuk menulis produk mereka ... Sebuah produk yang kemudian dipasarkan dengan penuh kegembiraan dengan nama RAIDIX ERA.

Saat ini, lebih dari selusin perusahaan memproduksi server yang disesuaikan untuk menggunakan drive NVMe. Pasar untuk produk yang mendukung dan mengembangkan teknologi ini memiliki potensi yang sangat besar. Dalam laporan analitik G2M, angka yang cukup meyakinkan disajikan meyakinkan bahwa protokol transfer data ini akan mendominasi dalam waktu dekat.

Bagan dari Laporan G2M

Bagan dari Laporan G2MSaat ini, salah satu pemimpin dalam produksi komponen NVMe adalah Intel. Pada peralatan mereka kami melakukan tes untuk menilai kemampuan produk perangkat lunak yang ada untuk mengelola perangkat keras yang "inovatif".

Bersama dengan mitra kami, Promobit (produsen server dan sistem penyimpanan data di bawah merek dagang BITBLAZE), kami menyelenggarakan pengujian drive NVMe Intel dan perangkat lunak umum untuk mengelola perangkat tersebut. Pengujian dilakukan sesuai dengan metode SNIA.

Pada artikel ini kami akan berbagi angka yang diperoleh selama pengujian sistem perangkat keras Intel NVMe, array perangkat lunak dari MDRAID, Zvol di atas ZFS RAIDZ2 dan, pada kenyataannya, pengembangan baru kami.

Konfigurasi perangkat keras

Untuk dasar platform pengujian, kami mengambil sistem server Intel Server System R2224WFTZS. Ini memiliki 2 soket untuk menginstal prosesor Intel Xeon Scalable dan 12 saluran memori (total 24 DIMM) DDR 4 dengan frekuensi hingga 2666 MHz.

Informasi lebih lanjut tentang platform server dapat ditemukan

di situs web pabrikan .

Semua NVMe-drive terhubung melalui 3 backplanes

F2U8X25S3PHS .

Secara total, kami mendapatkan 12 NVMe-drive INTEL SSDPD2MD800G4 dengan firmware CVEK6256004E1P0BGN dalam sistem.

Platform server dilengkapi dengan dua prosesor Intel® Xeon® Gold 6130 CPU @ 2.10GHz dengan Hyper-Threading diaktifkan, memungkinkan dua utas diluncurkan dari masing-masing inti. Jadi, pada output kami menerima 64 utas komputasi.

Persiapan ujian

Semua tes dalam artikel ini dilakukan sesuai dengan spesifikasi metodologi SNIA SSS PTSe v 1.1. Termasuk, persiapan awal penyimpanan dilakukan untuk mendapatkan hasil yang stabil dan jujur.

SNIA memungkinkan pengguna untuk mengatur parameter untuk jumlah utas dan kedalaman antrian, jadi kami menetapkan 64/32, memiliki 64 utas komputasi pada 32 inti.

Setiap tes dilakukan dalam 16 putaran untuk membawa sistem ke level indikator yang stabil dan mengeluarkan nilai acak.

Sebelum memulai tes, kami membuat persiapan awal sistem:

- Menginstal versi kernel 4.11 pada CentOS 7.4.

- Matikan C-STATES dan P-STATES.

- Jalankan utilitas tuned-adm dan atur profil kinerja latensi.

Pengujian setiap produk dan barang dilakukan dengan tahapan sebagai berikut:

Persiapan perangkat sesuai dengan spesifikasi SNIA (tergantung dan tidak tergantung pada jenis beban).

- Tes IOps dalam blok 4k, 8k, 16k, 32k, 64k, 128k, 1m dengan variasi kombinasi baca / tulis 0/100, 5/95, 35/65, 50/50, 65/35, 95/5, 100/0 .

- Tes latensi dengan blok 4k, 8k, 16k dengan variasi kombinasi baca / tulis 0/100, 65/35 dan 100/0. Jumlah utas dan kedalaman antrian adalah 1-1. Hasil dicatat sebagai penundaan rata-rata dan maksimum.

- Tes uji coba dengan blok 128k dan 1M, di 64 baris dari 8 tim.

Kami mulai dengan menguji kinerja, latensi, dan keluaran platform perangkat keras. Ini memungkinkan kami untuk mengevaluasi potensi peralatan yang diusulkan dan membandingkan dengan kemampuan solusi perangkat lunak yang diterapkan.

Uji 1. Pengujian Perangkat Keras

Untuk memulainya, kami memutuskan untuk melihat apa yang dapat dilakukan oleh satu drive NVMe Intel DCM D3700.

Dalam spesifikasi, pabrikan menyatakan parameter kinerja berikut:

Baca Acak (Rentang 100%) 450.000 IOPS

Penulisan Acak (Rentang 100%) 88000 IOPS

Uji 1.1 Satu drive NVMe. Tes IOPS

Hasil Kinerja (IOps) dalam bentuk tabel. Baca / Tulis Campuran%.

| Ukuran blok | R0% / W100% | R5% / W95% | R35% / W65% | R50% / W50% | R65% / W35% | R95% / W5% | R100% / W0% |

|---|

| 4k | 84017.8 | 91393.8 | 117271.6 | 133059.4 | 175086.8 | 281131.2 | 390969.2 |

| 8rb | 42602.6 | 45735.8 | 58980.2 | 67321.4 | 101357.2 | 171316.8 | 216551.4 |

| 16k | 21618.8 | 22834.8 | 29703.6 | 33821.2 | 52552.6 | 89731.2 | 108347 |

| 32rb | 10929.4 | 11322 | 14787 | 16811 | 26577.6 | 47185.2 | 50670.8 |

| 64rb | 5494.4 | 5671.6 | 7342.6 | 8285.8 | 13130.2 | 23884 | 27249.2 |

| 128rb | 2748.4 | 2805.2 | 3617.8 | 4295.2 | 6506.6 | 11997.6 | 13631 |

| 1 m | 351.6 | 354.8 | 451.2 | 684.8 | 830.2 | 1574.4 | 1702.8 |

Hasil Kinerja (IOps) dalam bentuk grafis. Baca / Tulis Campuran%.

Pada tahap ini, kami mendapat hasil yang tidak cukup mencapai yang pabrik. Kemungkinan besar, NUMA (skema implementasi memori komputer yang digunakan dalam sistem multiprosesor, ketika waktu akses ke memori ditentukan oleh lokasinya relatif terhadap prosesor) memainkan perannya, tetapi untuk saat ini kami tidak akan memperhatikannya.

Uji 1.2 Satu drive NVMe. Tes Keterlambatan

Rata-rata waktu respons (ms) dalam bentuk tabel. Baca / Tulis Campuran%.

| Ukuran blok | R0% / W100% | R65% / W35% | R100% / W0% |

|---|

| 4k | 0,02719 | 0,072134 | 0,099402 |

| 8rb | 0,029864 | 0,093092 | 0,121582 |

| 16k | 0,046726 | 0,137016 | 0,16405 |

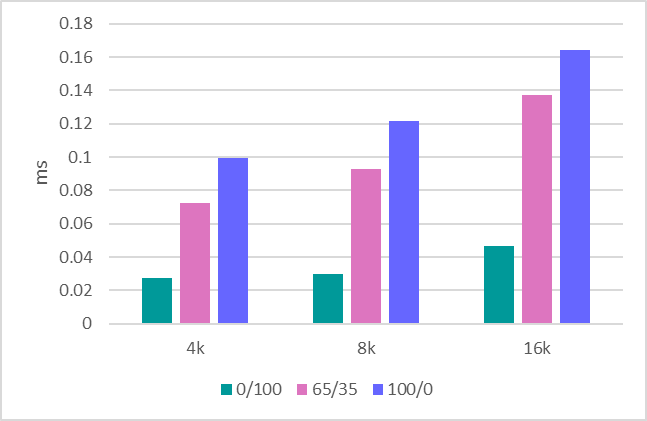

Rata-rata waktu respons (ms) dalam bentuk grafis. Baca / Tulis Campuran%.

Waktu respons maksimum

Waktu respons maksimum (ms) dalam bentuk tabel. Baca / Tulis Campuran%.

| Ukuran blok | R0% / W100% | R65% / W35% | R100% / W0% |

|---|

| 4k | 6.9856 | 4.7147 | 1.5098 |

| 8rb | 7.0004 | 4.3118 | 1.4086 |

| 16k | 7.0068 | 4.6445 | 1.1064 |

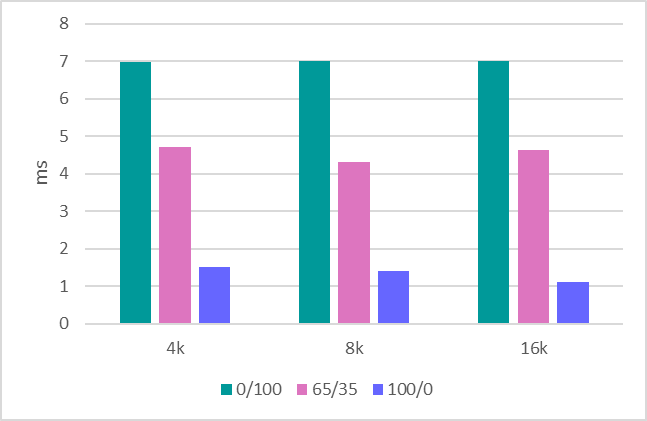

Waktu respons maksimum (md) dalam bentuk grafis. Baca / Tulis Campuran%.

Uji 1.3 Throughput

Langkah terakhir adalah mengevaluasi throughput. Berikut adalah indikator-indikator berikut:

Rekaman berurutan 1MB - 634 MBps.

Baca sekuensial 1MB - 1707 MBps.

Rekaman berurutan 128Kb - 620 MBps.

Baca berurutan 128Kb - 1704 MBps.

Setelah berurusan dengan satu drive, kami melanjutkan untuk mengevaluasi seluruh platform, yang terdiri dari 12 drive.

Uji 1.4 Sistem dalam 12 drive. Tes IOPS

Di sini, keputusan yang kuat dibuat untuk menghemat waktu dan menunjukkan hasil hanya untuk bekerja dengan blok 4k, yang sejauh ini merupakan skenario paling umum dan indikatif untuk mengevaluasi kinerja.

Hasil Kinerja (IOps) dalam bentuk tabel. Baca / Tulis Campuran%.

| Ukuran blok | R0% / W100% | R5% / W95% | R35% / W65% | R50% / W50% | R65% / W35% | R95% / W5% | R100% / W0% |

|---|

| 4k | 1363078.6 | 1562345 | 1944105 | 2047612 | 2176476 | 3441311 | 4202364 |

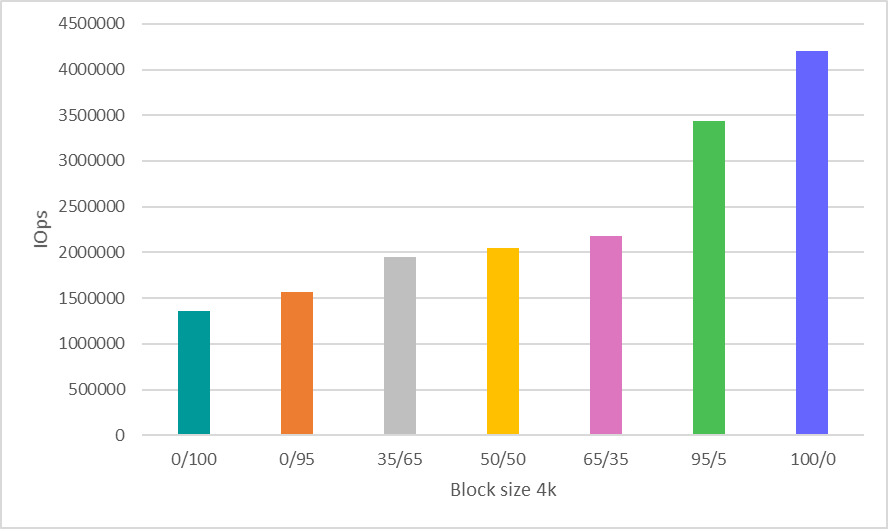

Hasil Kinerja (IOps) dalam bentuk grafis. Baca / Tulis Campuran%.

Tes 1.5 Sistem dalam 12 drive. Tes bandwidth

Rekaman berurutan 1MB - 8612 MBps.

Baca sekuensial 1MB - 20481 MBps.

Rekaman berurutan 128Kb - 7500 MBps.

Baca berurutan 128Kb - 20400 MBps.

Kami akan melihat indikator kinerja perangkat keras yang diperoleh lagi di akhir artikel, membandingkannya dengan jumlah perangkat lunak yang diuji di atasnya.

Tes 2: Menguji MDRAID

Ketika kita berbicara tentang susunan perangkat lunak, MDRAID datang ke pikiran pertama. Ingatlah bahwa ini adalah perangkat lunak dasar RAID untuk Linux, yang didistribusikan secara gratis.

Mari kita lihat bagaimana MDRAID menangani sistem 12-disk yang diusulkan dengan level array RAID 0. Kita semua mengerti bahwa membangun RAID 0 pada drive 12 membutuhkan keberanian khusus, tetapi sekarang kita membutuhkan level array ini untuk menunjukkan kemampuan maksimal dari solusi ini.

Tes 2.1 MDRAID. RAID 0. Tes IOPS

Hasil Kinerja (IOps) dalam bentuk tabel. Baca / Tulis Campuran%.

| Ukuran blok | R0% / W100% | R5% / W95% | R35% / W65% | R50% / W50% | R65% / W35% | R95% / W5% | R100% / W0% |

|---|

| 4k | 1010396 | 1049306.6 | 1312401.4 | 1459698.6 | 1932776.8 | 2692752.8 | 2963943.6 |

| 8rb | 513627.8 | 527230.4 | 678140 | 771887.8 | 1146340.6 | 1894547.8 | 2526853.2 |

| 16k | 261087.4 | 263638.8 | 343679.2 | 392655.2 | 613912.8 | 1034843.2 | 1288299.6 |

| 32rb | 131198.6 | 130947.4 | 170846.6 | 216039.4 | 309028.2 | 527920.6 | 644774.6 |

| 64rb | 65083.4 | 65099.2 | 85257.2 | 131005.6 | 154839.8 | 268425 | 322739 |

| 128rb | 32550.2 | 32718.2 | 43378.6 | 66999.8 | 78935.8 | 136869.8 | 161015.4 |

| 1 m | 3802 | 3718.4 | 3233.4 | 3467.2 | 3546 | 6150.8 | 8193.2 |

Hasil Kinerja (IOps) dalam bentuk grafis. Baca / Tulis Campuran%.

Tes 2.2 MDRAID. RAID 0. Tes keterlambatan

Rata-rata waktu respons (ms) dalam bentuk tabel. Baca / Tulis Campuran%.

| Ukuran blok | R0% / W100% | R65% / W35% | R100% / W0% |

|---|

| 4k | 0,03015 | 0,067541 | 0.102942 |

| 8rb | 0,03281 | 0,082132 | 0,126008 |

| 16k | 0,050058 | 0,114278 | 0,170798 |

Rata-rata waktu respons (ms) dalam bentuk grafis. Baca / Tulis Campuran%.

Waktu respons maksimum

Waktu respons maksimum (ms) dalam bentuk tabel. Baca / Tulis Campuran%.

| Ukuran blok | R0% / W100% | R65% / W35% | R100% / W0% |

|---|

| 4k | 6.7042 | 3.7257 | 0,8568 |

| 8rb | 6.5918 | 2.2601 | 0,9004 |

| 16k | 6.3466 | 2.7741 | 2.5678 |

Waktu respons maksimum (md) dalam bentuk grafis. Baca / Tulis Campuran%.

Tes 2.3 MDRAID. RAID 0. Tes bandwidth

Penulisan berurutan 1MB - 7820 MBPS.

Baca sekuensial 1MB - 20418 MBPS.

Penulisan berurutan 128Kb - 7622 MBPS.

Baca berurutan 128Kb - 20.380 MBPS.

Tes 2.4 MDRAID. RAID 6. Tes IOPS

Sekarang mari kita lihat apa yang dimiliki sistem ini pada level RAID 6.

Opsi Pembuatan Array

mdadm --create --verbose --chunk 16K / dev / md0 --level = 6 --raid-devices = 12 / dev / nvme0n1 / dev / nvme1n1 / dev / nvme2n1 / dev / nvme3n1 / dev / nvme4n1 / dev / nvme5n1 / dev / nvme8n1 / dev / nvme9n1 / dev / nvme10n1 / dev / nvme11n1 / dev / nvme6n1 / dev / nvme7n1

Volume total array adalah

7450,87 GiB.

Kami memulai pengujian setelah inisialisasi awal dari array RAID.

Hasil Kinerja (IOps) dalam bentuk tabel. Baca / Tulis Campuran%.

| Ukuran blok | R0% / W100% | R5% / W95% | R35% / W65% | R50% / W50% | R65% / W35% | R95% / W5% | R100% / W0% |

|---|

| 4k | 39907.6 | 42849 | 61609.8 | 78167.6 | 108594.6 | 641950.4 | 1902561.6 |

| 8rb | 19474.4 | 20701.6 | 30316.4 | 39737.8 | 57051.6 | 394072.2 | 1875791.4 |

| 16k | 10371.4 | 10979.2 | 16022 | 20992.8 | 29955.6 | 225157.4 | 1267495.6 |

| 32rb | 8505.6 | 8824.8 | 12896 | 16657.8 | 23823 | 173261.8 | 596857.8 |

| 64rb | 5679.4 | 5931 | 8576.2 | 11137.2 | 15906.4 | 109469.6 | 320874.6 |

| 128rb | 3976.8 | 4170.2 | 5974.2 | 7716.6 | 10996 | 68124.4 | 160453.2 |

| 1 m | 768.8 | 811.2 | 1177.8 | 1515 | 2149.6 | 4880.4 | 5499 |

Hasil Kinerja (IOps) dalam bentuk grafis. Baca / Tulis Campuran%.

Tes 2.5 MDRAID. RAID 6. Tes Delay

Rata-rata waktu respons (ms) dalam bentuk tabel. Baca / Tulis Campuran%.

| Ukuran blok | R0% / W100% | R65% / W35% | R100% / W0% |

|---|

| 4k | 0,193702 | 0,145565 | 0,10558 |

| 8rb | 0.266582 | 0,186618 | 0,127142 |

| 16k | 0.426294 | 0,281667 | 0,169504 |

Rata-rata waktu respons (ms) dalam bentuk grafis. Baca / Tulis Campuran%.

Waktu respons maksimum

Waktu respons maksimum (ms) dalam bentuk tabel. Baca / Tulis Campuran%.

| Ukuran blok | R0% / W100% | R65% / W35% | R100% / W0% |

|---|

| 4k | 6.1306 | 4.5416 | 4.2322 |

| 8rb | 6.2474 | 4.5197 | 3.5898 |

| 16k | 5.4074 | 5.5861 | 4.1404 |

Waktu respons maksimum (md) dalam bentuk grafis. Baca / Tulis Campuran%.

Perlu dicatat bahwa di sini MDRAID menunjukkan tingkat keterlambatan yang sangat baik.

Tes 2.6 MDRAID. RAID 6. Tes Bandwidth

Penulisan berurutan 1MB - 890 MBPS.

Baca sekuensial 1MB - 18800 MBPS.

Penulisan berurutan 128Kb - 870 MBPS.

Pembacaan berurutan 128Kb - 10400 MBPS.

Tes 3. Zvol lebih dari ZFS RAIDZ2

ZFS memiliki fungsi pembuatan RAID bawaan dan manajer volume bawaan yang membuat perangkat blok virtual, yang digunakan oleh banyak produsen penyimpanan. Kami juga akan memanfaatkan fitur-fitur ini dengan membuat kumpulan dengan perlindungan RAIDZ2 (analog dengan RAID 6) dan volume blok virtual di atasnya.

Versi 0.79 (ZFS) dikompilasi. Opsi pembuatan array dan volume:

ashift = 12 / kompresi - off / dedup - off / recordsize = 1M / atime = off / cachefile = tidak ada / Jenis RAID = RAIDZ2

ZFS menunjukkan hasil yang sangat baik dengan kumpulan yang baru dibuat. Namun, dengan dubbing berulang, kinerja berkurang secara signifikan.

Pendekatan SNIA baik karena memungkinkan Anda untuk melihat hasil nyata dari pengujian sistem file yang serupa (yang didasarkan pada ZFS) setelah ditimpa berulang pada mereka.

Tes 3.1 ZVOL (ZFS). RAIDZ2. Tes IOps

Hasil Kinerja (IOps) dalam bentuk tabel. Baca / Tulis Campuran%.

| Ukuran blok | R0% / W100% | R5% / W95% | R35% / W65% | R50% / W50% | R65% / W35% | R95% / W5% | R100% / W0% |

|---|

| 4k | 15719.6 | 15147.2 | 14190.2 | 15592.4 | 17965.6 | 44832.2 | 76314.8 |

| 8rb | 15536.2 | 14929.4 | 15140.8 | 16551 | 17898.8 | 44553.4 | 76187.4 |

| 16k | 16696.6 | 15937.2 | 15982.6 | 17350 | 18546.2 | 44895.4 | 75549.4 |

| 32rb | 11859.6 | 10915 | 9698.2 | 10235.4 | 11265 | 26741.8 | 38167.2 |

| 64rb | 7444 | 6440.2 | 6313.2 | 6578.2 | 7465.6 | 14145.8 | 19099 |

| 128rb | 4425.4 | 3785.6 | 4059.8 | 3859.4 | 4246.4 | 7143.4 | 10052.6 |

| 1 m | 772 | 730.2 | 779.6 | 784 | 824.4 | 995.8 | 1514.2 |

Hasil Kinerja (IOps) dalam bentuk grafis. Baca / Tulis Campuran%.

Angka kinerja benar-benar tidak mengesankan. Pada saat yang sama, zvol murni (sebelum menulis ulang) memberikan hasil yang jauh lebih baik (5-6 kali lebih tinggi). Di sini, tes menunjukkan bahwa setelah dubbing pertama, kinerja turun.

Uji 3.2 ZVOL (ZFS). RAIDZ2. Tes Keterlambatan

Rata-rata waktu respons (ms) dalam bentuk tabel. Baca / Tulis Campuran%.

| Ukuran blok | R0% / W100% | R65% / W35% | R100% / W0% |

|---|

| 4k | 0,332824 | 0,255225 | 0,218354 |

| 8rb | 0,3299 | 0.259013 | 0,225514 |

| 16k | 0,139738 | 0,180467 | 0,233332 |

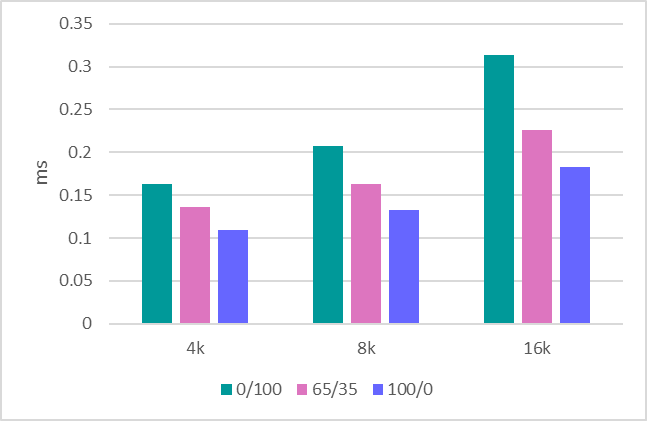

Rata-rata waktu respons (ms) dalam bentuk grafis. Baca / Tulis Campuran%.

Waktu respons maksimum

Waktu respons maksimum (ms) dalam bentuk tabel. Baca / Tulis Campuran%.

| Ukuran blok | R0% / W100% | R65% / W35% | R100% / W0% |

|---|

| 4k | 90,55 | 69.9718 | 84.4018 |

| 8rb | 91.6214 | 86.6109 | 104.7368 |

| 16k | 108.2192 | 86.2194 | 105.658 |

Waktu respons maksimum (md) dalam bentuk grafis. Baca / Tulis Campuran%.

Uji 3.3 ZVOL (ZFS). RAIDZ2. Tes bandwidth

Penulisan berurutan 1MB - 1150 MBPS.

Baca sekuensial 1MB - 5500 MBPS.

Penulisan berurutan 128Kb - 1100 MBPS.

Baca berurutan 128Kb - 5300 MBPS.

Tes 4: RAIDIX ERA

Sekarang mari kita lihat tes produk baru kami - RAIDIX ERA.

Kami menciptakan RAID6. Ukuran garis: 16kb. Setelah inisialisasi selesai, jalankan tes.

Hasil Kinerja (IOps) dalam bentuk tabel. Baca / Tulis Campuran%.

| Ukuran blok | R0% / W100% | R5% / W95% | R35% / W65% | R50% / W50% | R65% / W35% | R95% / W5% | R100% / W0% |

|---|

| 4k | 354887 | 363830 | 486865.6 | 619349.4 | 921403.6 | 2202384.8 | 4073187.8 |

| 8rb | 180914.8 | 185371 | 249927.2 | 320438.8 | 520188.4 | 1413096.4 | 2510729 |

| 16k | 92115.8 | 96327.2 | 130661.2 | 169247.4 | 275446.6 | 763307.4 | 1278465 |

| 32rb | 59994.2 | 61765.2 | 83512.8 | 116562.2 | 167028.8 | 420216.4 | 640418.8 |

| 64rb | 27660.4 | 28229.8 | 38687.6 | 56603.8 | 76976 | 214958.8 | 299137.8 |

| 128rb | 14475.8 | 14730 | 20674.2 | 30358.8 | 40259 | 109258.2 | 160141.8 |

| 1 m | 2892.8 | 3031.8 | 4032.8 | 6331.6 | 7514.8 | 15871 | 19078 |

Hasil Kinerja (IOps) dalam bentuk grafis. Baca / Tulis Campuran%.

Uji 4.2 RAIDIX ERA. RAID 6. Tes Delay

Rata-rata waktu respons (ms) dalam bentuk tabel. Baca / Tulis Campuran%.

| Ukuran blok | R0% / W100% | R65% / W35% | R100% / W0% |

|---|

| 4k | 0,16334 | 0,136397 | 0,10958 |

| 8rb | 0,207056 | 0,163325 | 0,132586 |

| 16k | 0,313774 | 0,225767 | 0.182928 |

Rata-rata waktu respons (ms) dalam bentuk grafis. Baca / Tulis Campuran%.

Waktu respons maksimum

Waktu respons maksimum (ms) dalam bentuk tabel. Baca / Tulis Campuran%.

| Ukuran blok | R0% / W100% | R65% / W35% | R100% / W0% |

|---|

| 4k | 5.371 | 3.4244 | 3.5438 |

| 8rb | 5.243 | 3.7415 | 3.5414 |

| 16k | 7.628 | 4.2891 | 4.0562 |

Waktu respons maksimum (md) dalam bentuk grafis. Baca / Tulis Campuran%.

Penundaan mirip dengan apa yang dihasilkan MDRAID. Tetapi untuk kesimpulan yang lebih akurat, perkiraan penundaan di bawah beban yang lebih serius harus dilakukan.

Tes 4.3 RAIDIX ERA. RAID 6. Tes Bandwidth

Penulisan berurutan 1MB - 8160 MBPS.

Baca sekuensial 1MB - 19700 MBPS.

Penulisan berurutan 128Kb - 6200 MBPS.

Pembacaan berurutan 128Kb - 19700 MBPS.

Kesimpulan

Sebagai hasil dari pengujian, perlu membandingkan angka yang diperoleh dari solusi perangkat lunak dengan apa yang disediakan oleh platform perangkat keras kepada kita.

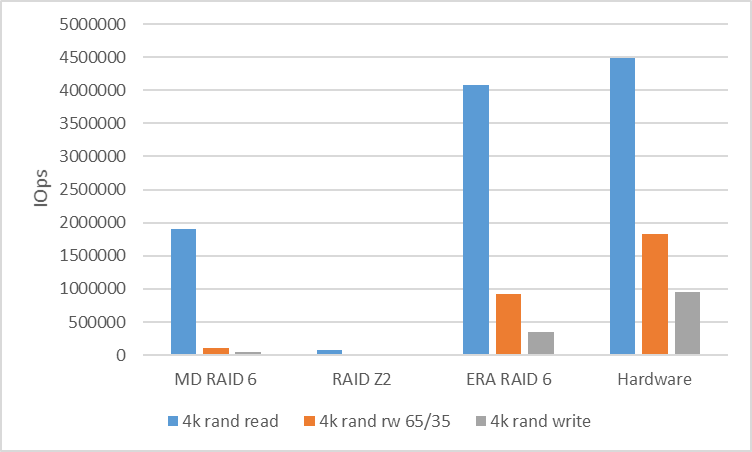

Untuk menganalisis kinerja beban acak, kami akan membandingkan kecepatan RAID 6 (RAIDZ2) saat bekerja dengan blok dalam 4k.

| MD RAID 6 | RAIDZ2 | RAIDIX ERA RAID 6 | Perangkat keras |

|---|

| 4k R100% / W0% | 1902561 | 76314 | 4073187 | 4.494.142 |

| 4k R65% / W35% | 108594 | 17965 | 921403 | 1823432 |

| 4k R0% / W100% | 39907 | 15719 | 354887 | 958054 |

Untuk menganalisis kinerja beban serial, kita akan melihat RAID 6 (RAIDZ2) dengan blok 128k. Di antara utas, kami menggunakan shift 10GB untuk menghilangkan hit cache dan menunjukkan kinerja nyata.

| MD RAID 6 | RAIDZ2 | RAIDIX ERA RAID 6 | Perangkat keras |

|---|

| 128k seq baca | 10400 | 5300 | 19700 | 20.400 |

| 128k seq tulis | 870 | 1100 | 6200 | 7500 |

Apa hasilnya?

Rangkaian RAID perangkat lunak yang populer dan terjangkau untuk bekerja dengan perangkat NVMe tidak dapat menunjukkan kinerja yang melekat pada potensi perangkat keras.

Di sini ada kebutuhan yang sangat jelas untuk perangkat lunak kontrol yang dapat mengacaukan situasi dan menunjukkan bahwa simbiosis pengendalian program dengan drive NVMe bisa sangat produktif dan fleksibel.

Memahami permintaan ini, perusahaan kami menciptakan produk RAIDIX ERA, pengembangan yang berfokus pada penyelesaian masalah berikut:

- Performa baca dan tulis yang tinggi (beberapa juta IOps) pada array dengan Parity dalam mode campuran.

- Kinerja streaming dari 30GBps termasuk selama failover dan pemulihan.

- Dukungan untuk level RAID 5, 6, 7.3.

- Inisialisasi latar belakang dan rekonstruksi.

- Pengaturan fleksibel untuk berbagai jenis beban (sisi pengguna).

Hari ini, kita dapat mengatakan bahwa tugas-tugas ini telah selesai dan produk siap digunakan.

Pada saat yang sama, memahami kepentingan banyak pihak yang berkepentingan dalam teknologi tersebut, kami siap untuk rilis tidak hanya berbayar, tetapi juga

lisensi gratis , yang dapat sepenuhnya digunakan untuk menyelesaikan masalah pada drive NVMe dan SSD.

Baca lebih lanjut tentang RAIDIX ERA

di situs web kami .

UPD Mengurangi pengujian ZFS dengan recordsize dan volblocksize 8k

Tabel Pilihan ZFS

| NAME | PROPERTI | NILAI | SUMBER |

|---|

| tangki | merekam ukuran | 8 rb | lokal |

| tangki | kompresi | off | standar |

| tangki | dedup | off | standar |

| tangki | checksum | off | lokal |

| tangki | volblocksize | - | - |

| tank / raid | merekam ukuran | - | - |

| tank / raid | kompresi | off | lokal |

| tank / raid | dedup | off | standar |

| tank / raid | checksum | off | lokal |

| tank / raid | volblocksize | 8rb | standar |

Rekaman menjadi lebih buruk, pembacaannya lebih baik.

Tetapi semua sama, semua hasilnya secara signifikan lebih buruk daripada solusi lain

| Ukuran blok | R0% / W100% | R5% / W95% | R35% / W65% | R50% / W50% | R65% / W35% | R95% / W5% | R100% / W0% |

|---|

| 4k | 13703.8 | 14399.8 | 20903.8 | 25669 | 31610 | 66955.2 | 140849.8 |

| 8rb | 15126 | 16227.2 | 22393.6 | 27720.2 | 34274.8 | 67008 | 139480.8 |

| 16k | 11111.2 | 11412.4 | 16980.8 | 20812.8 | 24680.2 | 48803.6 | 83710.4 |