Menggunakan arsitektur von Neumann untuk aplikasi dengan kecerdasan buatan tidak efisien. Apa yang akan menggantikannya?

Menggunakan arsitektur yang ada untuk menyelesaikan masalah pembelajaran mesin (MO) dan kecerdasan buatan (AI) menjadi tidak praktis. Energi yang dikonsumsi oleh AI telah tumbuh secara signifikan, dan CPU, bersama dengan GPU, semakin tampaknya menjadi alat yang tidak sesuai untuk pekerjaan ini.

Peserta dalam beberapa simposium sepakat bahwa peluang terbaik untuk perubahan signifikan muncul tanpa adanya fitur bawaan yang harus diseret. Sebagian besar sistem berevolusi secara bertahap dari waktu ke waktu - dan bahkan jika ini memastikan kemajuan yang aman, skema semacam itu tidak memberikan solusi optimal. Ketika sesuatu yang baru muncul, menjadi mungkin untuk melihat hal-hal baru dan memilih arah yang lebih baik daripada apa yang ditawarkan teknologi konvensional. Inilah yang dibahas pada konferensi baru-baru ini, di mana pertanyaan dipelajari apakah struktur logam-oksida-semikonduktor (

CMOS ) pelengkap adalah teknologi dasar terbaik yang layak digunakan untuk membangun aplikasi AI.

An Chen, ditunjuk oleh IBM sebagai Direktur Eksekutif dari Nanoelectronics Research Initiative (NRI), mengatur panggung untuk diskusi. “Selama bertahun-tahun kami telah meneliti teknologi baru dan modern, termasuk mencari alternatif untuk CMOS, terutama karena masalah terkait dengan konsumsi daya dan penskalaan. Setelah bertahun-tahun, sebuah pendapat telah berkembang bahwa kami belum menemukan sesuatu yang lebih baik sebagai dasar untuk membuat rangkaian logika. Saat ini, banyak peneliti berfokus pada AI, dan itu benar-benar menawarkan cara berpikir dan pola baru, dan mereka memiliki produk teknologi baru. Akankah perangkat AI baru memiliki kemampuan untuk menggantikan CMOS? "

AI hari ini

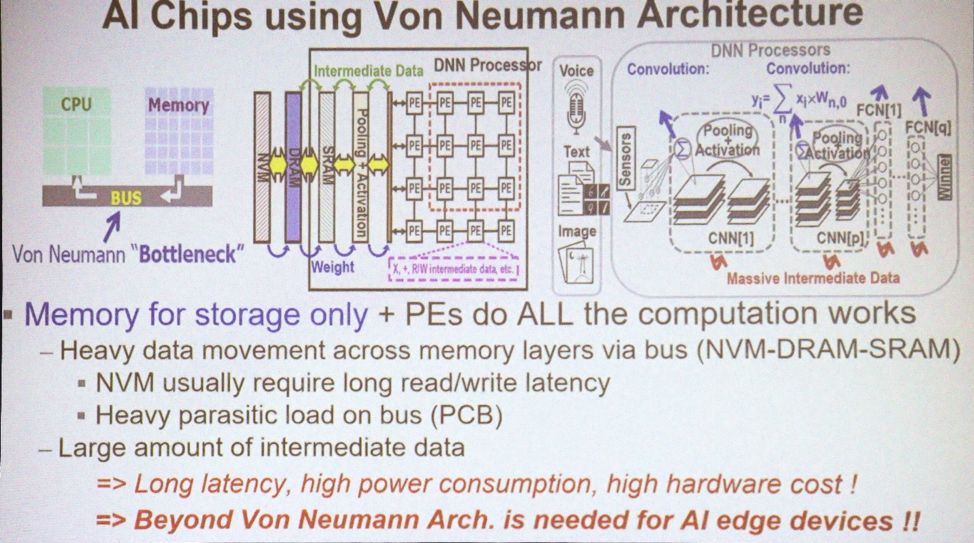

Sebagian besar aplikasi untuk MO dan AI menggunakan arsitektur von Neumann. "Menggunakan memori untuk menyimpan array data, dan CPU melakukan semua perhitungan," jelas Marvin Chen, profesor teknik listrik di Xinhua National University. “Sejumlah besar data bergerak melintasi bus. Saat ini, GPU juga sering digunakan untuk pelatihan mendalam, termasuk konvolusional [jaringan saraf]. Salah satu masalah utama adalah penampilan data perantara yang diperlukan untuk menggambar kesimpulan. Memindahkan data, terutama di luar chip, menghasilkan hilangnya energi dan penundaan. Ini adalah hambatan teknologi. ”

Arsitektur Digunakan untuk AI

Arsitektur Digunakan untuk AIYang Anda butuhkan saat ini adalah menggabungkan pemrosesan data dan memori. "Konsep komputasi dalam memori telah diusulkan oleh para ahli arsitektur komputer selama bertahun-tahun," kata Chen. - Ada beberapa skema untuk SRAM dan memori non-volatile, yang dengannya mereka mencoba menggunakan dan mengimplementasikan konsep tersebut. Idealnya, jika ini berhasil, Anda dapat menghemat sejumlah besar energi dengan menghilangkan pergerakan data antara CPU dan memori. Tapi ini ideal. ”

Tetapi untuk hari ini, kami tidak memiliki perhitungan dalam pikiran. "Kami masih memiliki AI 1.0 menggunakan arsitektur von Neumann, karena perangkat silikon yang menerapkan pemrosesan dalam memori tidak pernah muncul," keluh. Chen "Satu-satunya cara untuk menggunakan TSV 3D dengan cara apa pun adalah menggunakan memori berkecepatan tinggi dengan GPU untuk menyelesaikan masalah bandwidth." Tapi itu masih tetap menjadi penghambat energi dan waktu. "

Apakah akan ada cukup pemrosesan data dalam memori untuk menyelesaikan masalah kehilangan energi? "Otak manusia mengandung seratus miliar neuron dan 10

15 sinapsis," kata Sean Lee, asisten direktur di Taiwan Semiconductor Manufacturing Company. "Sekarang lihat IBM TrueNorth." TrueNorth adalah prosesor multi-inti yang dikembangkan oleh IBM pada tahun 2014. Ini memiliki 4.096 core dan masing-masing memiliki 256 neuron buatan yang dapat diprogram. “Misalkan kita ingin skala dan mereproduksi ukuran otak. Perbedaannya adalah 5 urutan besarnya. Tetapi jika kita langsung menambah jumlahnya dan melipatgandakan TrueNorth, mengonsumsi 65 mW, maka kita mendapatkan mesin dengan konsumsi 65 kW terhadap otak seseorang yang mengonsumsi 25 watt. Konsumsi harus dikurangi dengan beberapa urutan besarnya. "

Lee menawarkan cara lain untuk membayangkan kesempatan ini. "Superkomputer paling efisien hingga saat ini adalah Green500 dari Jepang, mengeluarkan 17 Gflops per watt, atau 1

kegagalan di 59 pJ." Situs web Green500 mengatakan bahwa sistem ZettaScaler-2.2 yang dipasang di Advanced Computing and Communications Center (RIKEN) Jepang mengukur 18,4 Gflops / W selama uji coba Linpack, yang membutuhkan 858 TFlops. “Bandingkan ini dengan

prinsip Landauer , yang menurutnya pada suhu kamar energi switching minimum dari transistor adalah 2,75 zJ [10

-21 J]. Sekali lagi, perbedaannya adalah beberapa urutan besarnya. 59 pJ adalah sekitar 10

-11 terhadap teori rendah sekitar 10

-21 . Kami memiliki bidang besar untuk penelitian. "

Apakah adil membandingkan komputer seperti itu dengan otak? “Setelah memeriksa keberhasilan pelatihan mendalam baru-baru ini, kita akan melihat bahwa dalam kebanyakan kasus orang dan mesin bersaing selama tujuh tahun terakhir berturut-turut,” kata Kaushik Roy, Profesor Teknik Elektro dan Ilmu Komputer Emeritus di Universitas Purdue. "Pada 1997, Deep Blue mengalahkan Kasparov, pada 2011 IBM Watson memenangkan permainan Jeopardy !, dan pada 2016 Alpha Go mengalahkan Lee Sedola. Ini adalah pencapaian terbesar. Tetapi berapa biayanya? Mesin-mesin ini mengkonsumsi 200 hingga 300 kW. Otak manusia mengkonsumsi sekitar 20 watt. Kesenjangan besar. Dari mana datangnya inovasi?

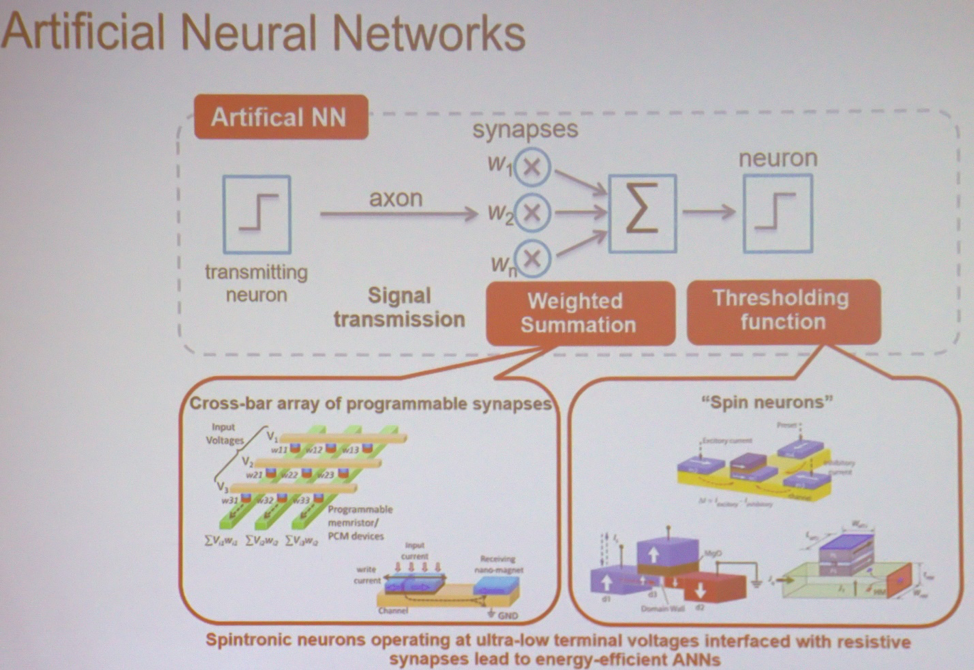

Di jantung sebagian besar aplikasi, MO dan AI adalah perhitungan paling sederhana yang dilakukan dalam skala besar. "Jika Anda mengambil jaringan saraf paling sederhana, maka ia melakukan penjumlahan berbobot, diikuti dengan operasi ambang," jelas Roy. - Ini dapat dilakukan dalam berbagai jenis matriks. Ini bisa berupa perangkat dari spintronics atau memori resistif. Dalam hal ini, tegangan input dan konduktivitas yang dihasilkan akan dikaitkan dengan setiap titik persimpangan. Pada output, Anda mendapatkan jumlah tegangan dikalikan dengan konduktivitas. Ini adalah arus. Kemudian Anda dapat mengambil perangkat serupa yang melakukan operasi ambang batas. Arsitektur dapat dibayangkan sebagai sekelompok node yang terhubung bersama untuk melakukan perhitungan. "

Komponen utama dari jaringan saraf

Komponen utama dari jaringan sarafJenis memori baru

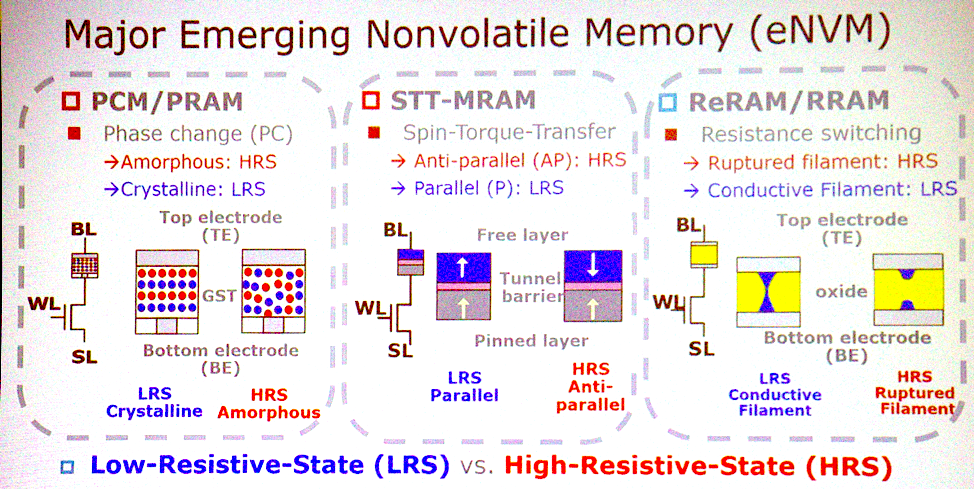

Sebagian besar arsitektur potensial dikaitkan dengan jenis memori non-volatile yang muncul. "Apa karakteristik paling penting?" "Tanya Jeffrey Barr, seorang peneliti di IBM Research. “Saya akan meletakkan memori analog resistif yang tidak mudah menguap, seperti memori dengan perubahan fasa, memristor, dan sebagainya. Idenya adalah bahwa perangkat ini mampu melakukan semua perkalian untuk lapisan jaringan saraf yang terhubung sepenuhnya dalam satu siklus. Pada set prosesor, ini dapat mengambil sejuta siklus jam, dan dalam perangkat analog, ini dapat dilakukan menggunakan fisika yang bekerja di lokasi data. Ada cukup banyak aspek yang sangat menarik dalam hal waktu dan energi untuk ide ini berkembang menjadi sesuatu yang lebih. "

Teknologi memori baru

Teknologi memori baruChen setuju dengan ini. “PCM, STT memiliki tawaran serius untuk menang. Ketiga jenis memori ini adalah kandidat yang baik untuk mengimplementasikan komputasi dalam memori. Mereka mampu operasi logis dasar. Beberapa spesies memiliki masalah dengan keandalan, dan mereka tidak dapat digunakan untuk pelatihan, tetapi mungkin untuk mendapatkan kesimpulan. "

Tetapi mungkin ternyata tidak perlu beralih ke memori ini. "Orang-orang berbicara tentang menggunakan SRAM persis untuk tujuan yang sama," tambah Lee. "Mereka melakukan komputasi analog dengan SRAM." Satu-satunya negatif adalah bahwa SRAM terlalu besar - 6 atau 8 transistor per bit. Oleh karena itu, bukan fakta bahwa kami akan menggunakan teknologi baru ini dalam komputasi analog. "

Transisi ke komputasi analog juga menyiratkan bahwa keakuratan perhitungan tidak lagi menjadi keharusan. "AI mengkhususkan diri, mengklasifikasikan, dan memprediksi," katanya. "Dia membuat keputusan yang bisa kasar." Dalam hal akurasi, kita bisa melepaskan sesuatu. Kita perlu menentukan perhitungan mana yang tahan kesalahan. Kemudian beberapa teknologi dapat diterapkan untuk mengurangi konsumsi daya atau mempercepat komputasi. CMOS probabilistik telah bekerja sejak tahun 2003. Ini termasuk menurunkan tegangan hingga munculnya beberapa kesalahan, yang jumlahnya masih dapat ditoleransi. Saat ini, orang sudah menggunakan teknik perhitungan perkiraan, seperti kuantisasi. Alih-alih angka floating-point 32-bit, Anda akan memiliki bilangan bulat 8-bit. Komputer analog adalah fitur lain yang telah disebutkan. "

Keluar dari lab

Memindahkan teknologi dari laboratorium ke publik bisa jadi menantang. "Terkadang Anda harus mencari alternatif," kata Barr. - Ketika memori flash dua dimensi tidak lepas landas, memori flash tiga dimensi mulai tampak bukan lagi tugas yang sulit. Jika kita terus meningkatkan teknologi yang ada, mendapatkan penggandaan karakteristik di sini, menggandakan di sana, maka perhitungan analog di dalam memori akan ditinggalkan. Tetapi jika peningkatan berikut ini ternyata tidak signifikan, memori analog akan terlihat lebih menarik. Sebagai peneliti, kita harus siap menghadapi peluang baru. ”

Perekonomian sering memperlambat pembangunan, terutama di bidang memori, tetapi Barr mengatakan bahwa ini tidak akan terjadi dalam kasus ini. “Salah satu keunggulan kami adalah bahwa produk ini tidak akan terkait memori. Itu tidak akan menjadi sesuatu dengan perbaikan kecil. Ini bukan produk konsumen. Ini adalah hal yang bersaing dengan GPU. Mereka dijual dengan harga 70 kali lipat dari biaya DRAM yang dikenakan pada mereka, jadi ini jelas merupakan produk non-memori. Dan biaya produk tidak akan jauh berbeda dari memori. Kedengarannya bagus, tetapi ketika Anda membuat keputusan bernilai miliaran dolar, maka semua biaya dan rencana pengembangan produk harus jelas. Untuk mengatasi penghalang ini, kita perlu memberikan prototipe yang mengesankan. "

Penggantian CMOS

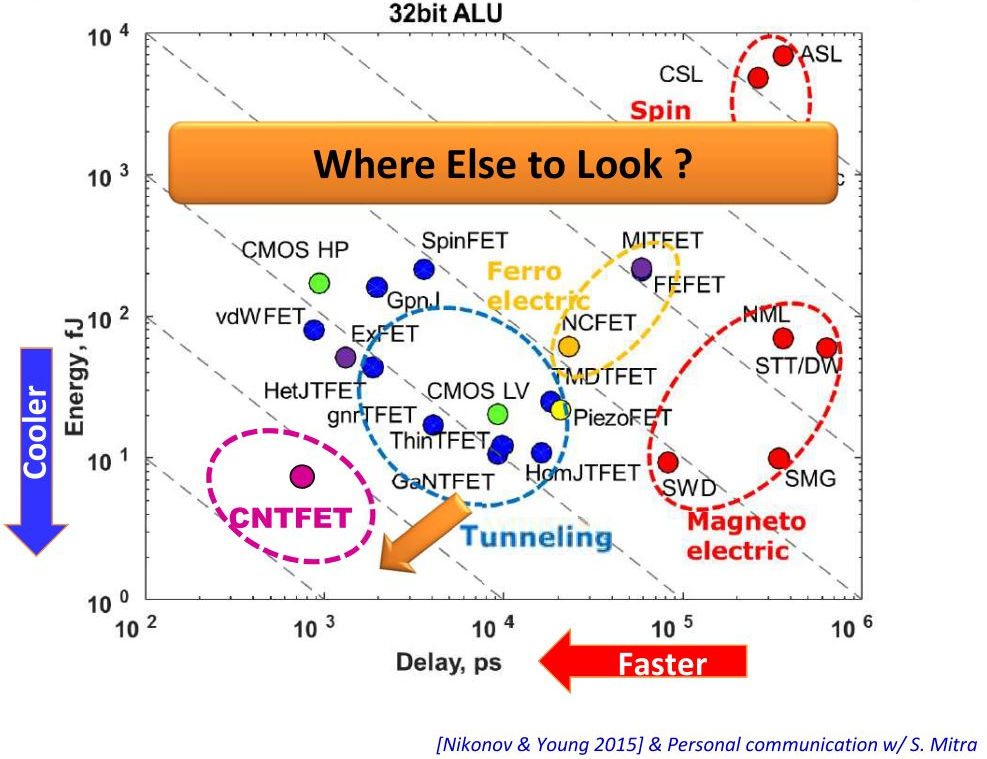

Pemrosesan data dalam memori dapat memberikan manfaat yang mengesankan, tetapi dibutuhkan lebih banyak untuk menerapkan teknologi ini. Bisakah bahan lain selain CMOS membantu dalam hal ini? “Melihat transisi dari CMOS konsumsi rendah ke FET terowongan, kita berbicara tentang pengurangan konsumsi 1-2 kali lipat,” kata Lee. - Kemungkinan lain adalah sirkuit terpadu tiga dimensi. Mereka mengurangi panjang kabel menggunakan TSV. Ini mengurangi konsumsi daya dan latensi. Lihatlah pusat data, mereka semua melepas kabel logam dan menghubungkan optik. "

Vertikal - konsumsi daya, penundaan perangkat horizontal

Vertikal - konsumsi daya, penundaan perangkat horizontalMeskipun Anda dapat mencapai beberapa manfaat ketika pindah ke teknologi yang berbeda, mereka mungkin tidak sepadan. "Akan sangat sulit untuk mengganti CMOS, tetapi beberapa perangkat yang dibahas dapat melengkapi teknologi CMOS sehingga melakukan perhitungan dalam memori," kata Roy. - CMOS dapat mendukung perhitungan dalam memori dalam bentuk analog, mungkin dalam sel 8T. Apakah mungkin untuk membuat arsitektur dengan keunggulan yang jelas dibandingkan CMOS? Jika semuanya dilakukan dengan benar, maka CMOS akan memberi saya efisiensi energi ribuan kali lebih banyak. Tapi itu butuh waktu. "

Jelas, CMOS tidak akan diganti. "Teknologi baru tidak akan menolak yang lama, dan tidak akan dibuat pada media apa pun selain CMOS," simpul Barr.