Selama beberapa minggu, spesialis ilmu komputer Siwei Lyu menonton video deepfake yang dibuat oleh timnya dengan keprihatinan yang menyiksa. Film-film palsu ini dibuat dengan menggunakan algoritma pembelajaran mesin menunjukkan selebriti melakukan hal-hal yang tidak akan mereka lakukan. Anehnya, mereka menakutkan, dan bukan hanya karena dia tahu itu palsu. "Mereka keliru," kenangnya, "tapi sangat sulit untuk menentukan dengan tepat apa yang membuat kesan ini."

Tapi begitu di otaknya muncul memori masa kecil. Seperti banyak anak lain, ia bermain "mengintip" dengan anak-anak. "Saya selalu kalah dalam kompetisi seperti itu," katanya, "karena ketika saya melihat wajah mereka yang tidak berkedip, saya merasa sangat tidak nyaman."

Dia menyadari bahwa film-film palsu ini membuatnya merasa tidak nyaman yang sama: dia memainkan kacamata para bintang film ini, karena mereka tidak membuka atau menutup mata mereka sesering yang dilakukan orang sungguhan.

Untuk mencari tahu alasannya, Luy, seorang profesor di Albany University, dan timnya mempelajari setiap langkah dari perangkat lunak

DeepFake yang menciptakan video-video ini.

Program Deepfake mengambil banyak gambar orang tertentu di pintu masuk - Anda, mantan pacar Anda, Kim Jong-un - sehingga mereka dapat dilihat dari sudut yang berbeda, dengan ekspresi wajah yang berbeda mengatakan kata-kata yang berbeda. Algoritma mempelajari bagaimana karakter ini terlihat, dan kemudian mensintesis pengetahuan yang diperoleh dalam video yang menunjukkan bagaimana orang ini melakukan apa yang tidak pernah dilakukannya.

Pornografi Stephen Colbert mengucapkan kata-kata John Oliver. Presiden

memperingatkan tentang bahaya video palsu.

Video-video ini terlihat meyakinkan selama beberapa detik di layar ponsel, tetapi mereka (belum) sempurna. Mereka dapat dilihat tanda-tanda palsu, misalnya, dengan cara yang aneh, mata terus-menerus terbuka, yang berasal dari kekurangan proses penciptaan mereka. Melihat nyali DeepFake, Lu menyadari bahwa di antara gambar-gambar yang dipelajari program tersebut, tidak ada begitu banyak foto dengan mata tertutup (karena Anda tidak menyimpan selfie di mana Anda berkedip?). "Itu menjadi distorsi," katanya. Jaringan saraf tidak mengerti berkedip. Program mungkin juga kehilangan "sinyal fisiologis lain yang melekat pada orang," kata Luya, yang menggambarkan fenomena ini - bernafas dengan kecepatan normal, atau adanya denyut nadi. Meskipun penelitian ini berfokus pada iklan yang dibuat menggunakan perangkat lunak tertentu, secara umum diterima bahwa bahkan sejumlah besar foto mungkin tidak dapat menggambarkan secara memadai persepsi fisik seseorang, sehingga perangkat lunak yang dilatih pada gambar-gambar ini akan menjadi tidak sempurna.

Pengungkapan tentang berkedip mengungkapkan banyak video palsu. Tetapi beberapa minggu setelah Lu dan timnya memposting draft pekerjaan online, mereka menerima surat anonim yang berisi tautan ke video palsu berikutnya yang diposting di YouTube, di mana bintang-bintang membuka dan menutup mata mereka dalam mode yang lebih normal. Pencipta palsu telah berevolusi.

Dan ini alami. Seperti yang dicatat Lu dalam

sebuah wawancara dengan The Conversation, "kedipan mata dapat ditambahkan ke video deepfake dengan memasukkan gambar dengan mata tertutup dalam database, atau menggunakan video untuk melatih." Mengetahui apa tanda palsu itu, Anda bisa menghindarinya - ini "hanya" masalah teknis. Yang berarti bahwa video palsu akan terlibat dalam perlombaan senjata antara pembuat dan pengenal. Penelitian seperti karya Luy hanya dapat memperumit kehidupan produsen palsu. "Kami sedang berusaha meningkatkan standar," katanya. "Kami ingin mempersulit proses ini, agar lebih memakan waktu."

Karena sekarang ini sangat sederhana. Unduh program, foto selebriti google, beri mereka makan di pintu masuk program. Dia mencerna mereka, belajar dari mereka. Dan meskipun dia belum sepenuhnya mandiri, dengan sedikit bantuan, dia melahirkan dan melahirkan sesuatu yang baru dan tampak sangat nyata.

"Dia sangat buram," kata Lu. Dan dia tidak bermaksud gambar. "Garis ini antara kebenaran dan palsu," katanya.

Ini sekaligus mengganggu dan tidak mengejutkan siapa pun yang telah hidup baru-baru ini dan telah menjelajahi Internet. Tapi ini terutama mengkhawatirkan departemen militer dan intelijen. Secara khusus, itulah sebabnya studi tentang Lu, seperti beberapa karya lain, didanai oleh

program DARPA yang disebut MediFor - Media Forensics [forensik media].

Proyek MediFor diluncurkan pada 2016, ketika agensi memperhatikan peningkatan aktivitas produsen palsu. Proyek ini mencoba untuk membuat sistem otomatis yang mempelajari tiga tingkat tanda-tanda palsu, dan menghasilkan "penilaian realitas" gambar atau video. Pada tingkat pertama, trek digital kotor dicari - noise dari kamera model tertentu atau artefak kompresi. Tingkat kedua adalah fisik: pencahayaan tidak di wajah, pantulan tidak terlihat seperti seharusnya dengan penataan lampu ini. Yang terakhir adalah semantik: membandingkan data dengan informasi nyata yang dikonfirmasi. Jika, misalnya, diklaim bahwa video yang menangkap permainan sepak bola diambil di Central Park pada pukul 2 malam pada hari Selasa, 9 Oktober 2018, apakah kondisi langit bertepatan dengan arsip cuaca? Kumpulkan semua level dan dapatkan penilaian terhadap realitas data. DARPA berharap bahwa pada akhir MediFor akan ada prototipe sistem yang memungkinkan untuk mengatur pemeriksaan skala besar.

Namun, jam terus berdetak (atau apakah itu hanya suara berulang yang dibuat oleh AI yang terlatih pada data yang terkait dengan pelacakan waktu?) "Dalam beberapa tahun, Anda akan dapat menemukan hal seperti pembuatan peristiwa," kata manajer program DARPA Matt Turek. "Bukan hanya satu gambar atau video yang diedit, tetapi beberapa gambar atau klip mencoba menyampaikan pesan yang menarik."

Ilmuwan komputer Juston Moore memiliki gambaran yang lebih jelas tentang masa depan potensial di Laboratorium Nasional Los Alamos. Katakanlah: kami memberi tahu algoritme bahwa kami memerlukan video di mana Moore merampok apotek; kami memperkenalkannya dalam rekaman video sistem keamanan lembaga ini; mengirimnya ke penjara. Dengan kata lain, ia khawatir jika standar untuk memverifikasi bukti tidak (atau tidak bisa) berkembang secara paralel dengan pembuatan palsu, akan mudah untuk menggantikan orang. Dan jika pengadilan tidak dapat mengandalkan data visual, mungkin bukti nyata akan diabaikan.

Kita sampai pada kesimpulan logis bahwa melihat sekali tidak akan lebih baik daripada mendengar seratus kali. "Mungkin saja kita tidak akan mempercayai bukti fotografis," katanya, "tapi aku tidak ingin hidup di dunia seperti itu."

Dunia seperti itu tidak begitu luar biasa. Dan masalahnya, menurut Moore, jauh melampaui penggantian individu. "Algoritma dapat

membuat gambar orang yang bukan milik orang sungguhan, mereka dapat mengubah gambar, mengubah

kuda menjadi zebra ," kata Moore. Mereka dapat

menghapus bagian gambar dan

menghapus objek latar depan

dari video .

Mungkin kita tidak akan bisa menangani kepalsuan lebih cepat daripada yang akan dilakukan. Tapi mungkin itu akan berhasil - dan kesempatan ini memberikan motivasi bagi tim Moore untuk mempelajari metode digital untuk mempelajari bukti. Program Los Alamos, menggabungkan pengetahuan tentang sistem cyber, sistem informasi, biologi teoretis dan biofisika, sekitar setahun lebih muda dari agensi DARPA. Satu pendekatan berfokus pada "kompresibilitas", dalam kasus-kasus di mana gambar tidak mengandung banyak informasi seperti yang terlihat. "Pada dasarnya, kami membangun ide bahwa semua generator gambar AI memiliki serangkaian hal yang dapat mereka buat," kata Moore. "Jadi, bahkan jika gambar itu terlihat agak rumit bagiku atau bagimu, kamu dapat menemukan struktur berulang di dalamnya." Saat mendaur ulang piksel, tidak banyak yang tersisa.

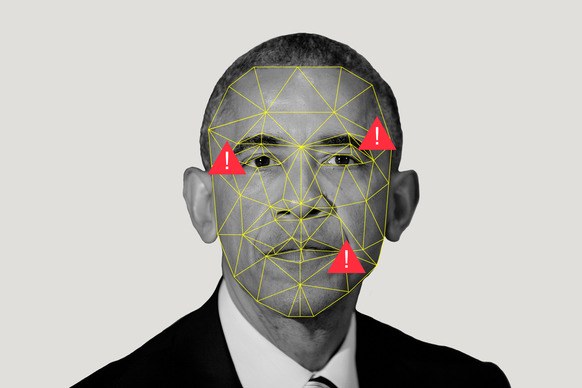

Mereka juga menggunakan algoritma pengkodean yang jarang untuk memainkan game dengan pertandingan. Katakanlah kita memiliki dua koleksi: sekelompok gambar nyata, dan sekelompok gambar AI yang dibuat secara artifisial. Algoritme mempelajari mereka, menciptakan apa yang disebut Moore sebagai "kamus elemen visual", mencatat bahwa gambar buatan memiliki sesuatu yang sama dan gambar nyata memiliki sesuatu yang sama. Jika teman Moore me-retweet gambar Obama, dan Moore menganggap bahwa gambar itu dibuat menggunakan AI, ia akan dapat menjalankannya melalui program dan mencari tahu dari kamus mana ia akan lebih dekat.

Los Alamos, tempat salah satu superkomputer paling kuat di dunia berada, mengunggah sumber daya ke program ini tidak hanya karena seseorang dapat menggantikan Moore melalui perampokan palsu. Misi laboratorium adalah "untuk memecahkan masalah keamanan nasional dengan bantuan keunggulan ilmiah". Tugas utama mereka adalah keselamatan nuklir, memberikan jaminan bahwa bom tidak akan meledak padahal seharusnya tidak, dan meledak ketika mereka seharusnya (tolong jangan), serta bantuan dalam non-proliferasi. Semua ini membutuhkan pengetahuan umum tentang pembelajaran mesin, karena ini membantu, seperti yang dikatakan Moore, "menarik kesimpulan besar dari kumpulan data kecil."

Namun di samping semua ini, bisnis seperti Los Alamos harus dapat mempercayai mata mereka - atau tahu kapan mereka tidak perlu dipercaya. Karena, bagaimana jika Anda melihat gambar satelit tentang bagaimana suatu negara memobilisasi atau menguji senjata nuklir? Bagaimana jika seseorang memalsukan pembacaan sensor?

Ini adalah masa depan yang menakutkan bahwa karya Moore dan Lu idealnya harus dihindari. Tetapi di dunia di mana segala sesuatunya hilang, untuk melihat tidak berarti percaya, tetapi pengukuran absolut bisa saja palsu. Semuanya digital diragukan.

Tapi mungkin "keraguan" adalah kata yang salah. Banyak orang akan mengambil nilai palsu (ingat

foto hiu di Houston?), Terutama jika kontennya sesuai dengan kepercayaan mereka. "Orang akan percaya pada apa yang cenderung mereka yakini," kata Moore.

Kemungkinan ini lebih tinggi untuk masyarakat umum menonton berita daripada di bidang keamanan nasional. Dan untuk mencegah penyebaran informasi yang keliru di antara kita, para simpleton, DARPA menawarkan kolaborasi media sosial dalam upaya untuk membantu pengguna menentukan bahwa kredibilitas video di mana Kim Jong-un menari makaroni agak rendah. Turek menunjukkan bahwa jejaring sosial dapat menyebarkan berita yang menyangkal video secepat video itu sendiri.

Tetapi apakah mereka akan melakukannya? Paparan adalah proses yang

merepotkan (walaupun tidak

seefisien rumor yang dimiliki). Dan orang-orang perlu menunjukkan fakta sebelum mereka dapat mengubah pikiran mereka tentang fiksi.

Tetapi bahkan jika tidak ada yang dapat mengubah pikiran massa tentang kejujuran video, penting bagi orang yang membuat keputusan politik dan hukum - tentang siapa yang mengangkut roket atau membunuh orang - mencoba menggunakan mesin untuk memisahkan kenyataan yang tampak dari tidur AI.