datacenterknowledge.com

datacenterknowledge.comTahun lalu, instalasi penyimpanan berbasis RAIDIX terbesar saat ini dilaksanakan. Sebuah sistem 11 kluster failover digunakan di RIKEN Institute of Computing Sciences (Jepang). Tujuan utama dari sistem ini adalah HPC Infrastructure Storage (HPCI), yang diimplementasikan sebagai bagian dari proyek pertukaran informasi akademik skala besar, Academic Cloud (berdasarkan jaringan SINET).

Karakteristik yang signifikan dari proyek ini adalah volume totalnya 65 PB, di mana volume sistem yang dapat digunakan adalah 51,4 PB. Untuk lebih memahami nilai ini, kami menambahkan bahwa ini adalah 6512 disk masing-masing 10 TB (paling modern pada saat instalasi). Ini banyak sekali.

Pekerjaan pada proyek berlangsung sepanjang tahun, setelah itu pemantauan stabilitas sistem berlanjut selama sekitar satu tahun. Indikator yang diperoleh memenuhi persyaratan yang dinyatakan, dan sekarang kita dapat berbicara tentang keberhasilan catatan ini dan proyek yang signifikan bagi kita.

Superkomputer di RIKEN Institute Computing Center

Untuk industri TIK, RIKEN Institute dikenal terutama karena "K-computer" yang legendaris (dari "kei" Jepang, yang berarti 10 kuadriliun), yang pada saat diluncurkan (Juni 2011) dianggap sebagai superkomputer paling kuat di dunia.

Superkomputer membantu Pusat Ilmu Komputasi dalam implementasi studi skala besar yang kompleks: memungkinkan pemodelan iklim, kondisi cuaca dan perilaku molekuler, menghitung dan menganalisis reaksi dalam fisika nuklir, prediksi gempa, dan banyak lagi. Kapasitas superkomputer juga digunakan untuk penelitian yang lebih “sehari-hari” dan terapan - untuk mencari ladang minyak dan memperkirakan tren di pasar saham.

Perhitungan dan eksperimen semacam itu menghasilkan sejumlah besar data, nilai dan signifikansi yang tidak dapat ditaksir terlalu tinggi. Untuk mendapatkan hasil maksimal dari ini, para ilmuwan Jepang telah mengembangkan konsep untuk ruang informasi tunggal di mana para profesional HPC dari berbagai pusat penelitian akan memiliki akses ke sumber daya HPC yang diterima.

Infrastruktur Komputasi Kinerja Tinggi (HPCI)

HPCI beroperasi berdasarkan SINET (The Science Information Network), jaringan tulang punggung untuk pertukaran data ilmiah antara universitas dan pusat penelitian Jepang. Saat ini, SINET menyatukan sekitar 850 lembaga dan universitas, menciptakan peluang besar untuk pertukaran informasi dalam penelitian yang memengaruhi fisika nuklir, astronomi, geodesi, seismologi, dan ilmu komputer.

HPCI adalah proyek infrastruktur unik yang membentuk sistem pertukaran informasi terpadu dalam bidang komputasi kinerja tinggi antara universitas dan pusat penelitian di Jepang.

Dengan menggabungkan kemampuan superkomputer "K" dan pusat penelitian lainnya dalam bentuk yang dapat diakses, komunitas ilmiah menerima manfaat nyata untuk bekerja dengan data berharga yang dibuat oleh komputasi superkomputer.

Untuk memberikan akses pengguna bersama yang efektif ke lingkungan HPCI, persyaratan tinggi diberlakukan pada penyimpanan untuk kecepatan akses. Dan berkat "hyperproductivity" dari K-komputer, cluster penyimpanan di RIKEN Institute of Computing Sciences dihitung untuk dibuat dengan volume kerja minimal 50 PB.

Infrastruktur proyek HPCI dibangun berdasarkan sistem file Gfarm, yang memungkinkan untuk memberikan kinerja tingkat tinggi dan menggabungkan cluster penyimpanan yang berbeda ke dalam ruang berbagi tunggal.

Sistem File Gfarm

Gfarm adalah sistem file terdistribusi open source yang dikembangkan oleh para insinyur Jepang. Gfarm adalah buah dari pengembangan Institute for Advanced Industrial Science and Technology (AIST), dan nama sistem mengacu pada arsitektur yang digunakan oleh Grid Data Farm.

Sistem file ini menggabungkan sejumlah properti yang tampaknya tidak kompatibel:

- Skalabilitas tinggi dalam volume dan kinerja

- Distribusi jaringan jarak jauh dengan dukungan untuk namespace tunggal untuk beberapa pusat penelitian yang beragam

- Dukungan POSIX API

- Diperlukan kinerja tinggi untuk komputasi paralel

- Keamanan Penyimpanan Data

Gfarm menciptakan sistem file virtual menggunakan sumber daya penyimpanan dari beberapa server. Data didistribusikan oleh server metadata, dan skema distribusi itu sendiri tersembunyi dari pengguna. Saya harus mengatakan bahwa Gfarm tidak hanya terdiri dari cluster penyimpanan, tetapi juga grid komputasi yang menggunakan sumber daya dari server yang sama. Prinsip operasi sistem menyerupai Hadoop: karya yang dikirimkan "diturunkan" ke node tempat data berada.

Arsitektur sistem file asimetris. Peran dialokasikan dengan jelas: Server Penyimpanan, Server Metadata, Klien. Tetapi pada saat yang sama, ketiga peran dapat dilakukan oleh mesin yang sama. Server penyimpanan menyimpan banyak salinan file, dan server metadata beroperasi dalam mode master-slave.

Pekerjaan proyek

Core Micro Systems, mitra strategis dan pemasok eksklusif RAIDIX di Jepang, mengimplementasikan implementasinya di RIKEN Institute of Computing Sciences Center. Untuk melaksanakan proyek, dibutuhkan sekitar 12 bulan kerja yang melelahkan, di mana tidak hanya karyawan Core Micro Systems, tetapi juga spesialis teknis dari tim Reydix mengambil bagian aktif.

Pada saat yang sama, transisi ke sistem penyimpanan lain tampaknya tidak mungkin: sistem yang ada memiliki banyak ikatan teknis, yang mempersulit transisi ke merek baru.

Selama pengujian, pemeriksaan, dan peningkatan yang panjang, RAIDIX telah menunjukkan kinerja dan efisiensi tinggi secara konsisten saat bekerja dengan jumlah data yang mengesankan.

Tentang perbaikan itu perlu diceritakan lebih banyak. Itu diperlukan tidak hanya untuk menciptakan integrasi sistem penyimpanan dengan sistem file Gfarm, tetapi untuk memperluas beberapa karakteristik fungsional perangkat lunak. Misalnya, untuk memenuhi persyaratan yang ditetapkan dari spesifikasi teknis, perlu untuk mengembangkan dan mengimplementasikan teknologi Automatic Write-Through sesegera mungkin.

Penyebaran sistem itu sendiri sistematis. Insinyur dari Core Micro Systems dengan cermat dan akurat melakukan setiap tahap pengujian, secara bertahap meningkatkan skala sistem.

Pada Agustus 2017, fase penyebaran pertama selesai ketika volume sistem mencapai 18 PB. Pada bulan Oktober tahun yang sama, fase kedua dilaksanakan, di mana volume naik ke rekor 51 PB.

Arsitektur Solusi

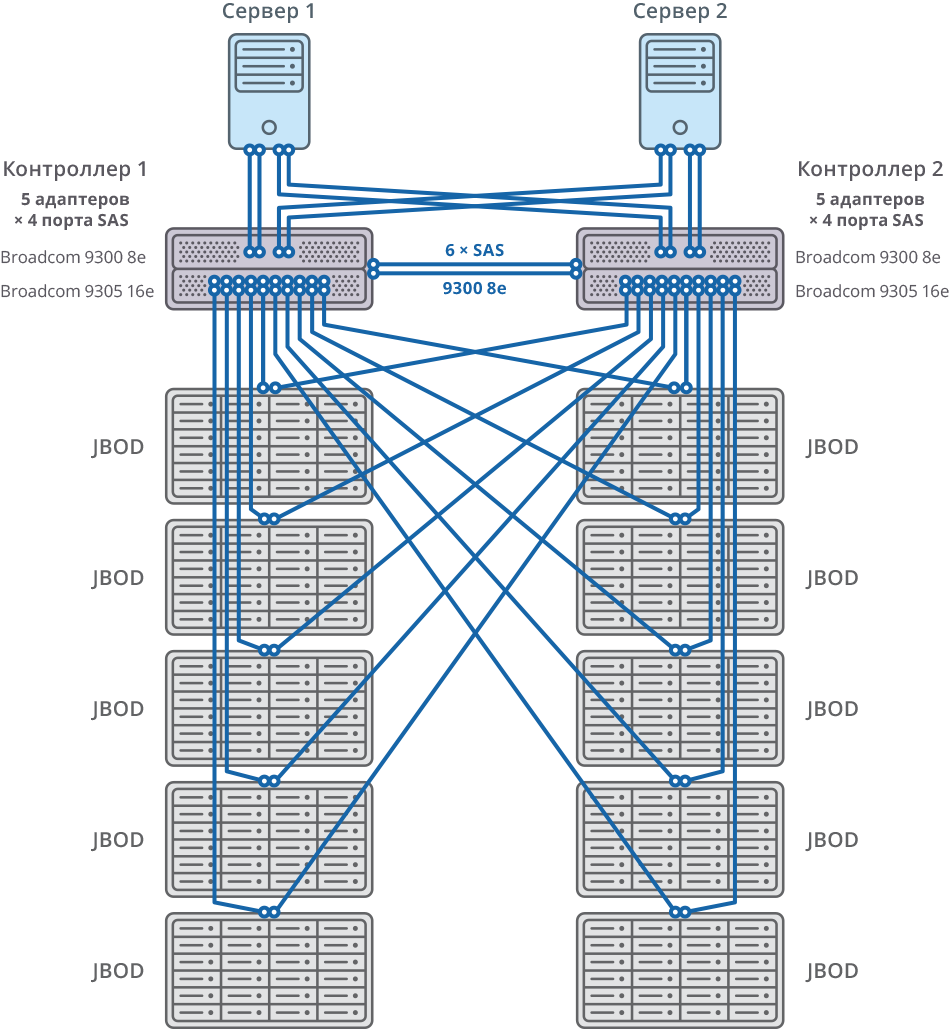

Solusi ini dibuat melalui integrasi sistem penyimpanan RAIDIX dan sistem file terdistribusi Gfarm. Dalam hubungannya dengan Gfarm, kemampuan untuk membuat penyimpanan yang dapat diskalakan menggunakan 11 sistem RAIDIX dual-controller.

Menghubungkan ke server Gfarm adalah melalui 8 x SAS 12G.

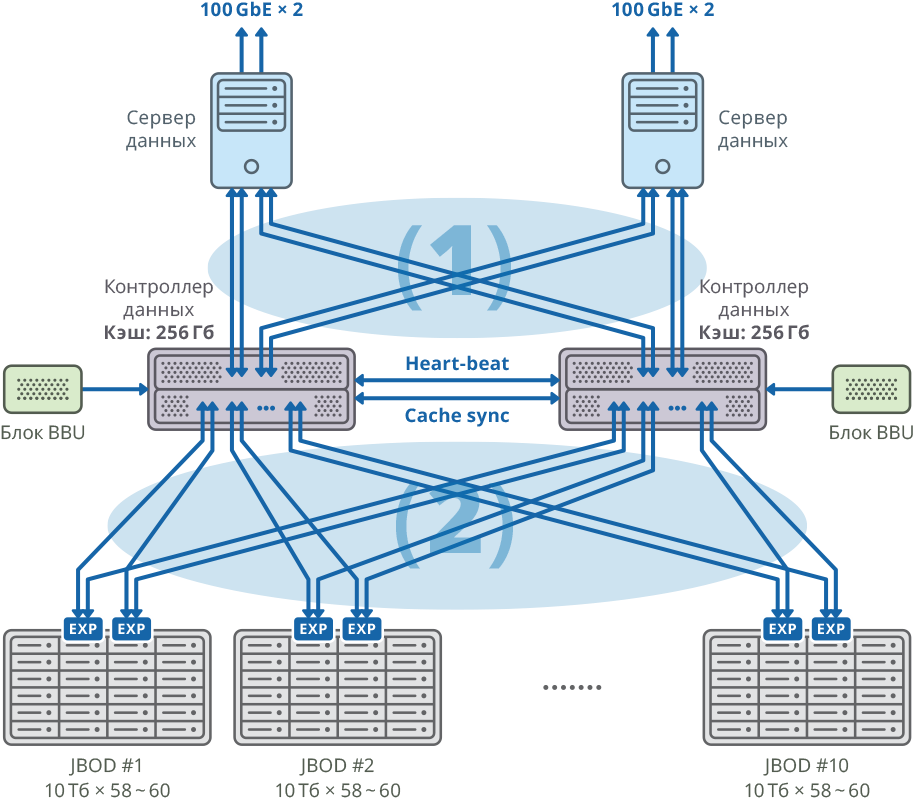

Fig. 1. Gambar cluster dengan server data terpisah untuk setiap node

Fig. 1. Gambar cluster dengan server data terpisah untuk setiap node(1) 48Gbps × 8 koneksi SAN Mesh; bandwidth: 384Gbps

(2) 48Gbps × 40 KAIN koneksi FABRIC; bandwidth: 1920Gbps

Konfigurasi platform pengontrol ganda

| CPU | Intel Xeon E5-2637 - 4pcs |

| Papan induk | Kompatibel dengan model prosesor yang mendukung PCI Express 3.0 x8 / x16 |

| Cache internal | 256 GB untuk setiap node |

| Sasis | 2U |

| Pengontrol SAS untuk menghubungkan rak disk, server dan menulis sinkronisasi cache | Broadcom 9305 16e, 9300 8e |

| HDD | HGST Helium 10TB SAS HDD |

| Sinkronisasi detak jantung | Ethernet 1 GbE |

| Sinkronisasi CacheSync | 6 x SAS 12G |

Kedua node dari kluster failover terhubung ke 10 JBOD (masing-masing 60 disk dengan 10 TB) melalui 20 port SAS 12G untuk setiap node. Pada rak disk ini, 58 10TB array RAID6 dibuat (8 disk data (D) + 2 disk paritas (P)) dan 12 disk dialokasikan untuk "hot swap".

10 JBOD => 58 × RAID6 (8 disk data (D) + 2 disk paritas (P)), LUN dari 580 HDD + 12 HDD untuk “hot swap” (2,06% dari total volume)

592 HDD (10TB SAS / 7.2k HDD) per cluster * HDD: HGST (MTBF: 2 500 000 jam)

Fig. 2. Failover cluster dengan diagram koneksi 10 JBOD

Fig. 2. Failover cluster dengan diagram koneksi 10 JBODSistem umum dan diagram koneksi

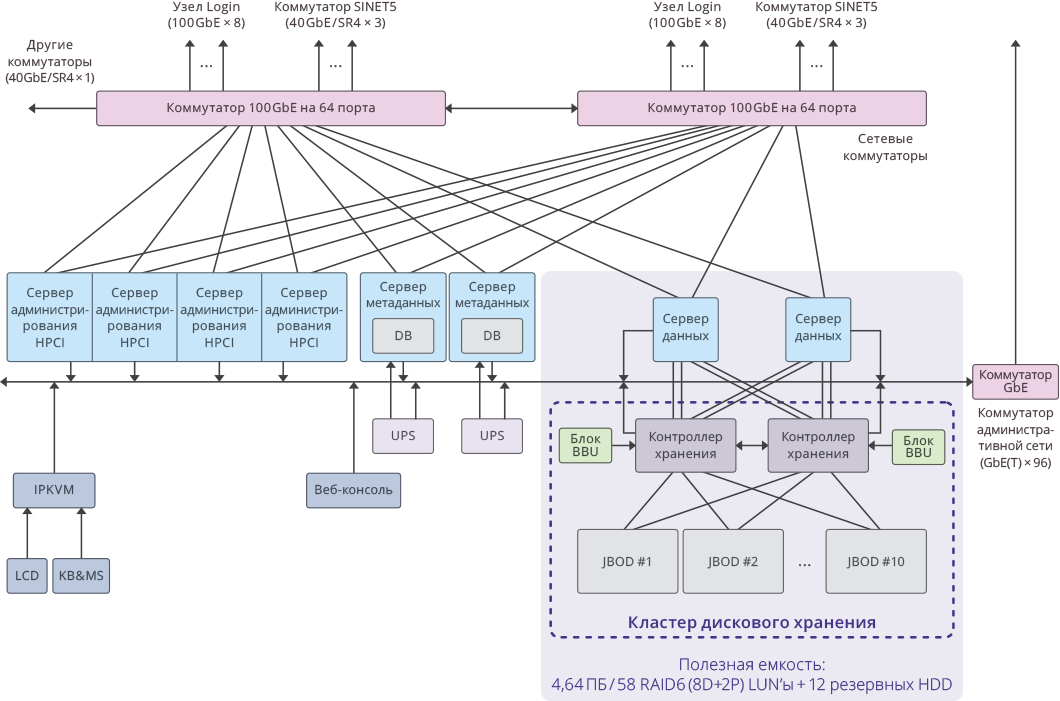

Fig. 3. Gambar satu cluster di dalam sistem HPCI

Fig. 3. Gambar satu cluster di dalam sistem HPCIIndikator proyek utama

Kapasitas yang dapat digunakan per kluster: 4,64 PB ((RAID6 / 8D + 2P) LUN × 58)

Total kapasitas yang dapat digunakan dari keseluruhan sistem: 51,04 PB (4,64 PB × 11 cluster).

Total kapasitas sistem: 65 PB .

Kinerja sistem adalah: 17 GB / s untuk menulis, 22 GB / s untuk membaca.

Kinerja total subsistem disk kluster pada 11 sistem penyimpanan RAIDIX: 250 GB / s .