Halo, Habr! Saya mempersembahkan kepada Anda terjemahan artikel "

Inilah yang bisa diketahui oleh pendeteksi kebohongan AI saat Anda berbohong " oleh Rob Verger.

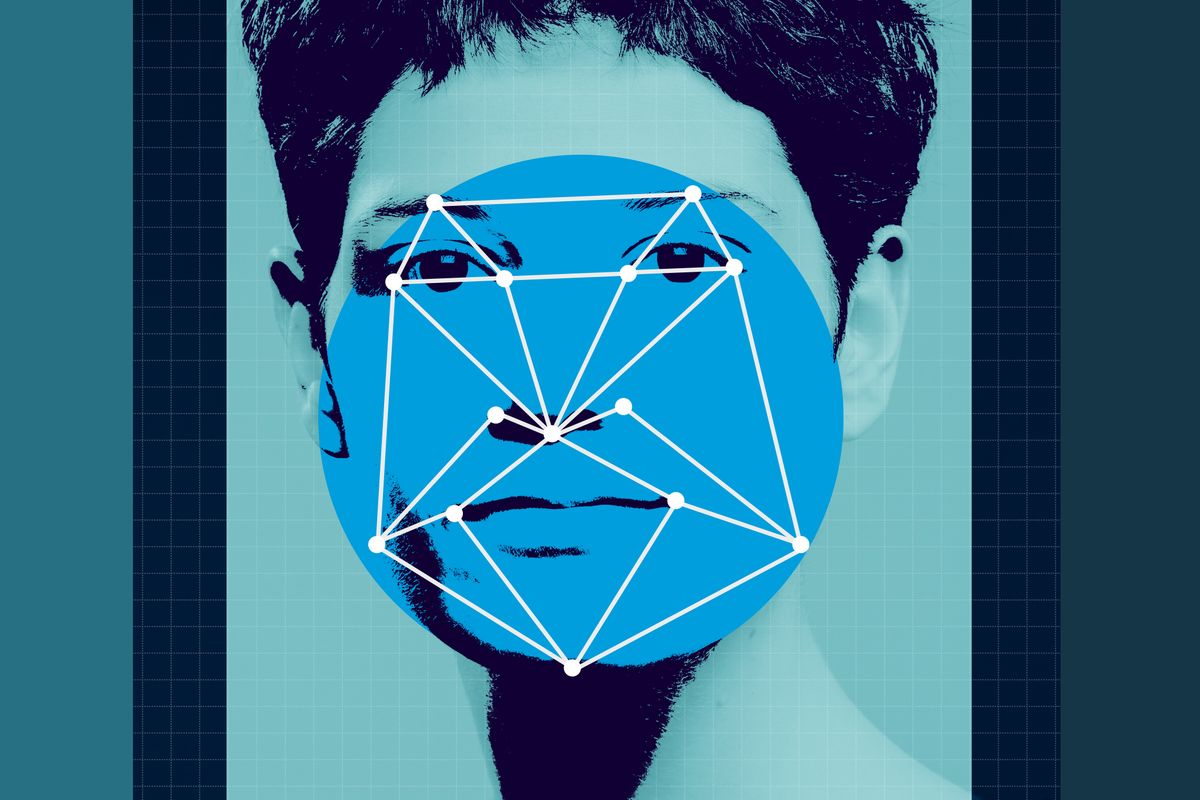

Saat ini, kecerdasan buatan ada di mana-mana - ia menentukan apa yang ada di foto makanan (di situs seperti Yelp), membantu para peneliti dalam mencoba mempercepat proses MRI, dan bahkan dapat mencari tanda-tanda depresi dalam suara seseorang. Tetapi tidak mungkin banyak yang berpikir tentang menggunakan kecerdasan buatan sebagai pendeteksi kebohongan.

Gagasan ini - pendeteksi kebohongan AI - sekarang menjadi berita karena proyek keamanan perbatasan Eropa baru "iBorderCtrl" mencakup teknologi yang berfokus pada "deteksi penipuan". Inisiatif ini mencakup proses dua langkah, dan langkah termasuk "deteksi penipuan" bekerja langsung dari rumah. Menurut Komisi Eropa, protokol dimulai dengan pra-seleksi, di mana wisatawan “menggunakan kamera web untuk menjawab pertanyaan yang diajukan oleh penjaga perbatasan animasi yang dipilih berdasarkan jenis kelamin, etnis, dan bahasa pelancong. Pendekatan unik untuk "mendeteksi penipuan" menganalisis perubahan terkecil dalam ekspresi wajah wisatawan untuk menentukan apakah orang yang diwawancarai berbohong. "

Semua ini terdengar seperti fiksi ilmiah, dan tentu saja mengingatkan sejarah poligraf yang bermasalah. Tetapi kecerdasan buatan semacam itu cukup nyata. Satu-satunya pertanyaan adalah seberapa akuratnya.

Rada Michalcha, seorang profesor ilmu komputer dan teknik di University of Michigan, telah bekerja untuk mendeteksi penipuan selama sekitar sepuluh tahun. Dengan demikian, satu detektor kebohongan AI dan prinsip operasinya dibangun.

Hal pertama yang peneliti lakukan dengan kecerdasan buatan dan kebutuhan pembelajaran mesin adalah data. Dalam hal ini, tim Rada Mikhalcha mulai dengan video kasus-kasus nyata pengadilan. Misalnya, seorang terdakwa dalam persidangan di mana ia dihukum dapat memberikan contoh penipuan; pernyataan saksi juga digunakan sebagai contoh kesaksian yang benar atau salah. (Tentu saja, algoritma pembelajaran mesin secara langsung bergantung pada data yang mereka gunakan, jadi penting untuk diingat bahwa seseorang yang terbukti bersalah melakukan kejahatan mungkin sebenarnya tidak bersalah.)

Sebagai hasilnya, 121 klip video dan transkrip yang sesuai dari apa yang dikatakan digunakan (rasio pernyataan yang salah dan benar kira-kira satu banding satu). Data ini memungkinkan tim untuk membangun pengklasifikasi untuk pembelajaran mesin, yang akhirnya memiliki akurasi 60-75%.

Pola apa yang diperhatikan sistem? “Penggunaan kata ganti. Orang yang mencoba berbohong cenderung jarang menggunakan kata ganti 'I' atau 'we' dan umumnya menyebutkan hal-hal yang berkaitan dengan mereka. Sebaliknya, mereka sering menggunakan kata ganti 'kamu', 'milikmu', 'dia (a)', 'mereka'. ” - menjelaskan Rada Mikhalcha.

Ini bukan satu-satunya atribut linguistik. Orang yang berbohong cenderung menggunakan "kata-kata yang lebih kuat" yang "mengekspresikan kepercayaan diri," kata Rada Mihalcha. Contoh dari kata-kata seperti itu adalah kata-kata seperti "mutlak" dan "sangat", ketika pencerita kebenaran, sebaliknya, menghindar dari jawaban menggunakan kata-kata seperti "mungkin" atau "mungkin".

"Saya percaya bahwa orang-orang yang menipu akan lebih cenderung untuk memperbaiki kebohongan mereka dengan mencoba tampil lebih percaya diri."

Adapun ekspresi wajah, Rada Mikhalcha menekankan bahwa orang yang berbohong lebih cenderung melihat langsung ke mata orang yang mewawancarai mereka. Orang-orang ini juga lebih sering menggunakan dua tangan untuk memberi isyarat daripada satu tangan, karena, menurut asumsi Rada Mikhalch, mereka dengan demikian berusaha tampak lebih meyakinkan. (Tentu saja, ini hanya templat: jika seseorang menatap mata dan gerakan Anda dengan kedua tangan saat berbicara, ini tidak berarti bahwa orang ini berbohong.)

Ini adalah daftar data luar biasa yang dapat dilihat AI segera setelah peneliti memberinya contoh yang dapat digunakannya dan yang dapat dipelajari. Tetapi bahkan Rada Mikhalcha sendiri mengakui bahwa pekerjaannya "tidak sempurna." "Sebagai peneliti, kami sangat gembira bahwa kami dapat mencapai akurasi 75%." Tetapi di sisi lain, ini berarti bahwa probabilitas kesalahan adalah satu dari empat. "Saya tidak berpikir bahwa AI ini dapat digunakan dalam praktik, karena probabilitas kesalahan hingga 25%."

Pada akhirnya, Rada Mihalcha melihat teknologi ini sangat bermanfaat bagi masyarakat. Sebagai contoh, teknologi ini dapat menunjukkan bahwa dia memperhatikan sesuatu yang “tidak biasa” dalam pernyataan seseorang, dan kemudian orang ini mungkin dipertanyakan lagi. Penggunaan AI ini tidak jarang: teknologi yang memperluas apa yang dapat dilakukan orang.