Jesse Bataglia menggendong putranya Bennett di rumah mereka di Ranch Mirage, California. Dalam mencari pengasuh baru, Bataglia mulai menggunakan Predictim, layanan online yang konon menggunakan "kecerdasan buatan canggih" untuk menilai risiko bahwa pengasuh akan kecanduan obat-obatan, berperilaku agresif atau menunjukkan "perilaku buruk".

Jesse Bataglia menggendong putranya Bennett di rumah mereka di Ranch Mirage, California. Dalam mencari pengasuh baru, Bataglia mulai menggunakan Predictim, layanan online yang konon menggunakan "kecerdasan buatan canggih" untuk menilai risiko bahwa pengasuh akan kecanduan obat-obatan, berperilaku agresif atau menunjukkan "perilaku buruk".Ketika Jesse Bataglia mulai mencari pengasuh baru untuk putranya yang berusia satu tahun, dia ingin mendapatkan lebih banyak informasi tentang karyawan daripada tidak adanya catatan kriminal, komentar orang tua dan wawancara pribadi. Oleh karena itu, ia beralih ke layanan online Predictim, menggunakan "kecerdasan buatan canggih" untuk mengevaluasi identitas pengasuh, dan mengirim pemindai ke ribuan posting di Facebook, Twitter, dan Instagram salah satu kandidat.

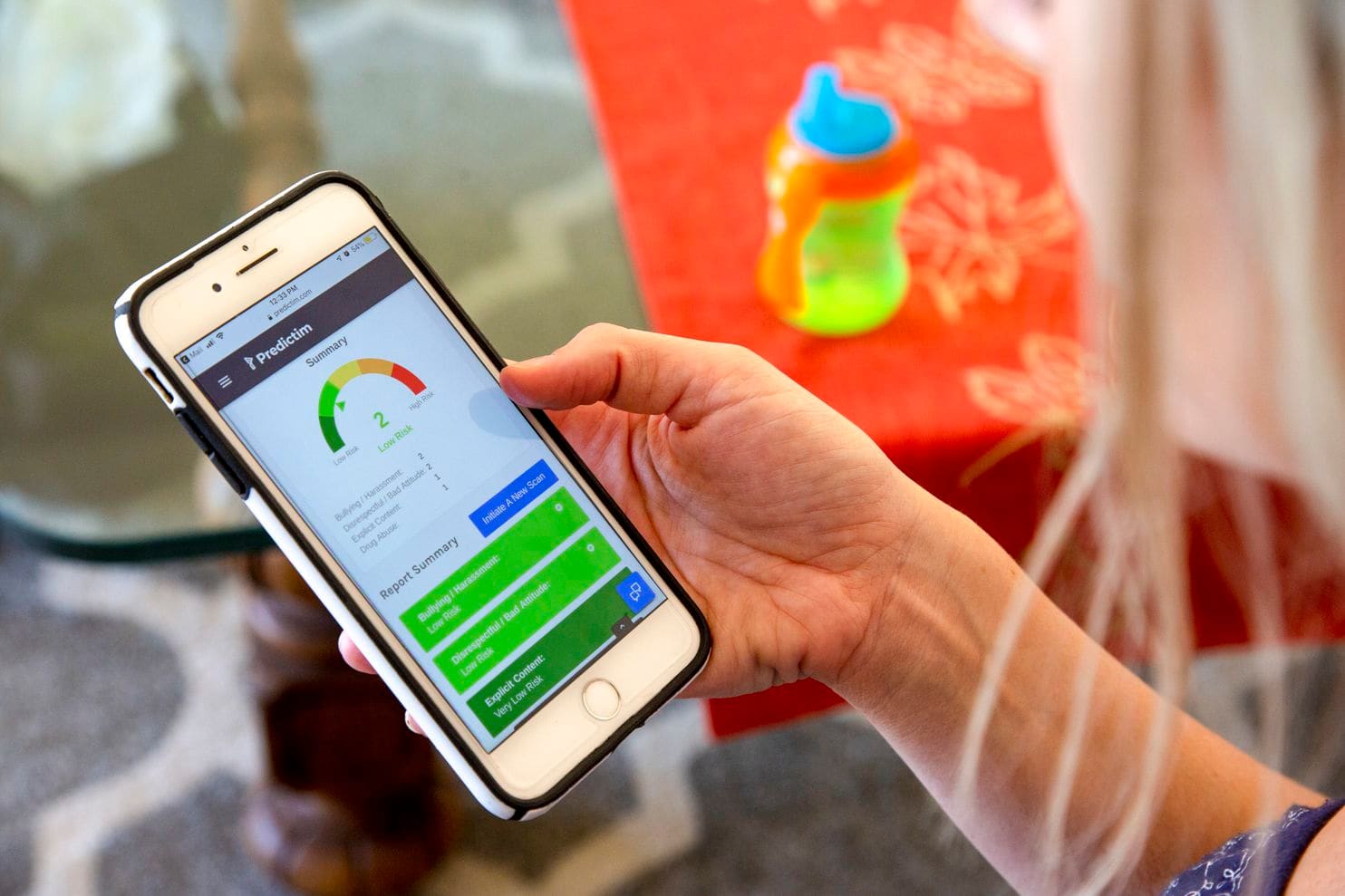

Sistem ini memperkenalkan "penilaian risiko" otomatis dari seorang gadis berusia 24 tahun, mengklaim bahwa risiko menggunakan obat-obatannya "sangat kecil." Namun, sistem tersebut menilai risiko intimidasi, agresi, rasa tidak hormat dan perilaku buruk sedikit lebih tinggi - 2 dari 5.

Sistem tidak menjelaskan keputusannya. Namun, Bataglia, yang menganggap pengasuh itu benar-benar dapat dipercaya, tiba-tiba mulai ragu. "Media sosial menunjukkan identitas seseorang," kata Bataglia, yang kini berusia 29 tahun, tinggal di pinggiran kota Los Angeles. "Mengapa skor 2, bukan 1?"

Predictim menawarkan kepada orang tua layanan yang sama yang dijual oleh lusinan perusahaan teknologi lain di seluruh dunia kepada majikan: sistem AI yang menganalisis ucapan manusia, ekspresi wajah, dan riwayat kehadiran online, sambil berjanji untuk mengungkapkan aspek rahasia kehidupan pribadi mereka.

Teknologi mengubah cara beberapa perusahaan mencari kandidat, merekrut dan mengevaluasi pekerja, menawarkan penilaian yang tak tertandingi kepada para pemberi kerja melalui gelombang baru evaluasi dan pengawasan psikologis invasif.

Fama mengklaim mereka menggunakan AI untuk memonitor jaringan sosial pekerja untuk "perilaku beracun" untuk memperingatkan bos mereka. HireVue, perusahaan teknologi rekrutmen yang bekerja dengan perusahaan seperti Geico, Hilton, dan Unilever, menawarkan sistem yang secara otomatis menganalisis nada kandidat, pilihan kata, dan ekspresi wajah selama wawancara video, dan memprediksi keterampilan dan perilaku mereka (untuk menawarkan hasil yang lebih baik, kandidat ditawarkan lebih banyak senyum).

Namun, para kritikus berpendapat bahwa sistem seperti Predictim membawa bahaya dalam diri mereka sendiri, meninggalkan solusi otomatis yang dapat mengubah kehidupan seseorang tanpa pemeriksaan.

Sistem bergantung pada algoritma berbasis kotak hitam yang menghasilkan hampir tidak ada detail tentang bagaimana mereka mengurangi semua detail rumit kehidupan batin seseorang menjadi perhitungan sisi positif dan negatifnya. Dan meskipun teknologi Predictim mempengaruhi pemikiran orang tua, itu tetap sama sekali tidak terbukti, hampir tidak dapat dijelaskan dan rentan terhadap distorsi persepsi terkait dengan bagaimana tepatnya pengasuh yang tepat harus berperilaku di jejaring sosial, melihat dan berbicara.

Ada "perlombaan gila untuk mengendalikan AI dan membuat segala macam keputusan tanpa laporan kepada orang-orang," kata Jeff Chester, direktur eksekutif Center for Digital Democracy, sebuah kelompok advokasi teknologi. "Sepertinya orang-orang mabuk oleh soda digital, dan mereka pikir itu adalah cara normal untuk mengatur hidup kita."

Proses pemindaian Predictim menganalisis seluruh perilaku pengasuh di jejaring sosial, yang bagi banyak pengasuh termuda dapat menangkap sebagian besar hidup mereka. Pada saat yang sama, pengasuh diberitahu bahwa jika mereka menolak untuk menjalani pemindaian seperti itu, ini akan menjadi kerugian serius dalam persaingan untuk mendapatkan pekerjaan.

CEO dan co-founder Predictim, Sal Parsa mengatakan perusahaan itu, yang diluncurkan bulan lalu sebagai bagian dari techno-inkubator Berkeley University of California milik SkyDeck, secara serius menangani masalah etika dalam menggunakan teknologinya. Dia mengatakan bahwa orang tua harus mempertimbangkan peringkat sebagai penasihat, yang "mungkin mencerminkan, dan mungkin tidak mencerminkan karakteristik sebenarnya dari pengasuh."

Dia menambahkan bahwa bahaya mempekerjakan pengasuh yang bermasalah atau kejam membuat AI alat yang penting bagi setiap orang tua yang berusaha menjaga anaknya tetap aman.

"Cari Google untuk penyalahgunaan pengasuh anak dan Anda akan menemukan ratusan hasil," katanya. - Ada orang dengan penyakit mental atau hanya marah. Tujuan kami adalah melakukan segala daya kami untuk menghentikan mereka. ”

Biaya pemindaian Predictim mulai dari $ 24,99, dan untuknya Anda harus memberi tahu nama dan email calon pengasuh, serta mendapatkan persetujuannya untuk akses luas ke akunnya di jejaring sosial. Sang pengasuh dapat menolak, dan kemudian orang tua menerima pemberitahuan tentang ini, dan pengasuh itu sendiri menerima surat yang mengatakan bahwa "orang tua yang tertarik pada Anda tidak akan dapat mempekerjakan Anda sampai Anda mematuhi permintaan."

Manajer Predictim mengatakan mereka menggunakan algoritma untuk memproses bahasa dan gambar, "visi komputer", mengevaluasi posting pengasuh di Facebook, Twitter dan Instagram, dan mencari petunjuk tentang kehidupan offline-nya. Laporan tersebut hanya diterima oleh orang tua, yang tidak diharuskan untuk berbagi hasilnya dengan pengasuh.

Orang tua mungkin dapat melihat akun pengasuh publik di jejaring sosial itu sendiri. Namun, laporan komputer berjanji untuk memberikan penilaian mendalam tentang tahun aktivitas online, dikurangi menjadi satu angka: solusi sederhana yang menggoda untuk tugas yang hampir mustahil.

Penilaian risiko termasuk dalam beberapa kategori, termasuk konten terbuka dan penyalahgunaan narkoba. Startup ini juga mengklaim dalam iklan bahwa sistemnya mampu mengevaluasi karakteristik lain dari kepribadian pengasuh, seperti kesopanan, kemampuan untuk bekerja dengan orang lain dan "kepositifan".

Perusahaan berharap untuk merevolusi industri multi-miliar dolar dari "outsourcing tanggung jawab orang tua" dan sudah mulai beriklan dengan mensponsori blog dan situs parenting untuk "ibu." Strategi pemasaran berfokus pada peluang yang dinyatakan untuk mengungkap rahasia dan mencegah "mimpi buruk setiap orangtua," dan iklan itu mengutip kasus-kasus kriminal, termasuk, misalnya, kasus seorang pengasuh Kentucky yang dihukum karena mencelakakan tubuh yang parah terhadap seorang anak berusia delapan bulan.

"Jika orang tua dari gadis yang terkena dampak perawat ini dapat menggunakan Predictim dalam proses persetujuan kandidat," kata pernyataan pemasaran perusahaan, "mereka tidak akan pernah meninggalkannya sendirian dengan anak mereka yang berharga."

Namun, para ahli teknologi mengatakan sistem mengeluarkan peringatan sendiri, bermain di atas ketakutan orang tua untuk menjual hasil pemindaian kepribadian dengan akurasi yang tidak terverifikasi.

Mereka juga mengajukan pertanyaan tentang bagaimana sistem seperti itu dilatih dan seberapa rentan mereka terhadap kesalahan yang dapat timbul dari ketidakpastian terkait dengan penggunaan jejaring sosial oleh pengasuh. Orang tua hanya diberi peringatan tentang perilaku yang meragukan, tanpa frasa, tautan, atau detail lain yang dengannya mereka dapat mengambil keputusan.

Ketika pemindaian seorang pengasuh mengeluarkan peringatan tentang kemungkinan penganiayaan di pihaknya, seorang ibu yang bersemangat yang meminta penilaian ini mengatakan dia tidak bisa mengetahui apakah program tersebut melihat kutipan dari film, lagu, atau kalimat lain yang diambilnya untuk pernyataan yang benar-benar berbahaya. .

Ponsel Jesse menunjukkan hasil aplikasi Predictim

Ponsel Jesse menunjukkan hasil aplikasi PredictimJamie Williams, seorang pengacara di Electronic Frontier Foundation, sebuah kelompok hak-hak sipil, mengatakan bahwa sebagian besar algoritma yang digunakan hari ini untuk mengevaluasi makna kata-kata dan foto-foto diketahui tidak memiliki konteks manusia dan akal sehat. Bahkan raksasa teknologi seperti Facebook mengalami kesulitan menciptakan algoritma yang dapat membedakan antara komentar tidak berbahaya dan marah.

“Bagaimana Anda bisa mencoba sistem ini untuk mengevaluasi remaja: mereka anak-anak! - kata Williams. - Anak-anak memiliki lelucon sendiri, mereka terkenal dengan sarkasme. "Apa yang seseorang anggap algoritma sebagai" perilaku buruk "dapat dianggap sebagai pernyataan politik atau kritik yang sah."

Dan ketika sistemnya salah - katakanlah, mengatakan bahwa pengasuh menyalahgunakan narkoba - orang tua tidak akan dapat mengetahui tentang kesalahan tersebut. Peringkat dan penilaian yang jelas tentang keakuratan sistem dapat membuat orang tua berharap dari itu lebih akurat dan otoriter daripada yang bisa dijanjikan oleh seseorang. Akibatnya, orang tua akan cenderung untuk mempekerjakan pengasuh anak yang seharusnya mereka hindari, atau menjauh dari orang-orang yang sudah mendapatkan kepercayaan mereka.

"Tidak ada metrik yang dapat secara akurat mengatakan apakah metode ini seefektif dalam prediksi mereka sebagai pencipta negara," kata Miranda Bogen, kepala analis di think tank Upturn Washington, yang mempelajari penggunaan algoritma untuk pengambilan keputusan otomatis dan ajudikasi . "Daya tarik teknologi ini cenderung melampaui kemampuan mereka yang sebenarnya."

Malissa Nielsen, pengasuh berusia 24 tahun yang bekerja untuk Bataglia, baru-baru ini memberi dua keluarga lain akses ke jejaring sosial mereka untuk evaluasi di Predictim. Dia mengatakan bahwa dia selalu berhati-hati tentang jejaring sosial dan memutuskan bahwa dia dapat berbagi informasi tambahan tanpa membahayakan dirinya sendiri. Dia pergi ke gereja setiap minggu, tidak bersumpah dan selesai menerima pendidikan guru di bidang pengajaran anak-anak, setelah itu dia berharap untuk membuka taman kanak-kanak.

Namun, ketika dia mengetahui bahwa sistem memberinya nilai yang tidak ideal berdasarkan rasa tidak hormat dan intimidasi, dia kagum. Dia percaya bahwa memungkinkan orang tua untuk mempelajari keberadaannya di jejaring sosial, dan bukan algoritma - analisis kritis kepribadiannya. Dia juga tidak diberitahu tentang hasil tes yang berpotensi merusak satu-satunya sumber pendapatannya.

“Saya ingin sedikit memahami masalah ini. Mengapa program ini menganggap saya seperti itu? - kata Nielsen. "Komputer tidak memiliki perasaan; ia tidak dapat mendeteksi semua itu."

Orang Amerika masih tidak mempercayai algoritma yang keputusannya dapat memengaruhi kehidupan sehari-hari mereka. Dalam sebuah survei dari Pew Research Center bulan ini, 57% responden menilai pemrosesan resume secara otomatis untuk kandidat pekerjaan sebagai "tidak dapat diterima."

Namun demikian, Predictim melaporkan bahwa mereka sedang bersiap untuk memperluas pekerjaan di seluruh negeri. Manajer Sittercity, layanan pengasuh online yang dikunjungi jutaan orang tua, berbicara tentang peluncuran program percontohan yang akan mengintegrasikan peringkat otomatis Predictim ke dalam peringkat otomatis saat ini dan pemeriksaan layanan.

"Menemukan pengasuh penuh dengan ketidakpastian," kata Sandra Dainora, kepala produk di Sittercity, yang percaya bahwa alat tersebut dapat segera menjadi standar dalam pencarian online untuk pengasuh. "Orang tua terus mencari solusi terbaik, penelitian paling lengkap, fakta yang paling dapat diandalkan."

Manajer predictim juga percaya bahwa mereka dapat secara serius memperluas kemampuan sistem dan menawarkan penilaian pribadi yang lebih pribadi tentang kehidupan pribadi pengasuh. Joel Simonov, direktur teknologi, mengatakan tim tertarik untuk mendapatkan "data psikometrik yang berguna" berdasarkan analisis aktivitas pengasuh anak di jejaring sosial, menyampaikan cerita mereka melalui tes identitas, misalnya, tipologi Myers-Briggs, untuk memberikan hasil ini kepada orang tua.

Penambangan media sosial dan minat Predictim dalam analisis psikologis massa mirip dengan ambisi Cambridge Analytica, sebuah perusahaan penasihat politik yang bekerja untuk mendukung kampanye Trump dan kemudian menarik Facebook ke dalam skandal identitas global. Namun, para pemimpin Predictim mengklaim telah melakukan pemeriksaan keamanan internal dan bekerja untuk melindungi data pribadi pengasuh. "Jika kita memiliki kebocoran data pengasuh, itu tidak akan keren," kata Simonov.

Para ahli khawatir bahwa sistem peringkat berbasis AI menandakan masa depan di mana penerimaan seseorang atas pekerjaan apa pun yang tidak terkait dengan pengasuhan anak akan bergantung pada mesin. Banyak perusahaan rekrutmen dan rekrutmen sudah membuat atau berinvestasi dalam sistem yang dapat menganalisis resume kandidat dalam skala besar dan mengeluarkan peringkat kandidat otomatis. Sistem AI serupa - termasuk Jigsaw, inkubator teknologi buatan Google - digunakan untuk melacak komentar online untuk pelecehan, ancaman, dan kekejaman.

Namun, telah ditunjukkan lebih dari sekali bagaimana algoritma untuk menemukan karyawan menyembunyikan kelemahan yang dapat merusak karier seseorang. Amazon.com menghentikan pengembangan algoritma perekrutan, mengetahui bahwa itu secara tidak sah meremehkan perempuan, karena sejarah perekrutan perusahaan, yang mengikuti kecenderungan industri teknologi untuk mempekerjakan laki-laki, mengajarkan sistem untuk lebih memilih calon laki-laki. Perusahaan mengatakan mereka tidak pernah menggunakan program ini untuk mengevaluasi kandidat.

Beberapa pakar AI percaya bahwa sistem seperti itu memiliki kemampuan untuk secara serius mengembangkan prasangka yang berkaitan dengan usia atau ras, misalnya, menandai kata-kata atau foto-foto penting dari kelompok orang tertentu lebih sering daripada yang lain. Mereka juga khawatir bahwa Predictim akan memaksa pengasuh muda untuk berbagi data pribadi mereka hanya untuk mendapatkan pekerjaan.

Namun, Diana Werner, seorang ibu dari dua anak yang tinggal di pinggiran kota San Francisco, percaya bahwa pengasuh anak harus secara sukarela berbagi informasi pribadi untuk membantu meyakinkan orang tua mereka. "Memverifikasi biografi adalah hal yang baik, tetapi Predictim mempelajari masalah ini secara mendalam, membedah individu - status sosial dan intelektual mereka," katanya. Di mana dia tinggal, "100% orang tua ingin menggunakan layanan seperti itu," tambahnya. "Kita semua ingin mendapatkan pengasuh yang sempurna."