Jaringan saraf dikenal karena ketidakmampuan memahami mereka - komputer dapat memberikan jawaban yang baik, tetapi tidak dapat menjelaskan apa yang menyebabkan kesimpulan ini. Bin Kim sedang mengembangkan "penerjemah manusia" sehingga jika kecerdasan buatan rusak, kita bisa memahaminya.

Bean Kim, seorang peneliti di Google Brain, sedang mengembangkan cara untuk mempertanyakan sistem pembelajaran mesin tentang keputusannya.

Bean Kim, seorang peneliti di Google Brain, sedang mengembangkan cara untuk mempertanyakan sistem pembelajaran mesin tentang keputusannya.Jika dokter memberi tahu Anda bahwa Anda memerlukan pembedahan, Anda perlu mencari tahu alasannya - dan Anda akan berharap bahwa penjelasannya akan bermakna bagi Anda, bahkan jika Anda belum dilatih sebagai dokter. Pernah Kim, seorang peneliti di Google Brain, percaya bahwa kita harus dapat mengharapkan hal yang sama dari kecerdasan buatan (AI). Dia adalah spesialis dalam pembelajaran mesin "ditafsirkan" (MO), dan ingin membuat AI yang dapat menjelaskan tindakannya kepada siapa pun.

Sejak sepuluh tahun yang lalu, teknologi jaringan saraf di belakang AI mulai menyebar lebih dan lebih, itu mampu mengubah semua proses, dari menyortir email ke menemukan obat baru, berkat kemampuannya untuk belajar dari data dan mencari pola di dalamnya. Tetapi kemampuan ini memiliki tangkapan yang tidak dapat dijelaskan: kompleksitas yang memungkinkan jaringan saraf modern dengan pelatihan mendalam untuk berhasil mempelajari cara mengemudi mobil dan mengenali penipuan dengan asuransi membuat hampir mustahil bagi para ahli untuk memahami prinsip-prinsip pekerjaan mereka. Jika jaringan saraf dilatih untuk mencari pasien yang berisiko kanker hati atau skizofrenia - dan sistem yang disebut "Deep Patient" diluncurkan di Rumah Sakit Mount Sinai di New York pada 2015 - maka tidak ada cara untuk memahami yang mana data fitur jaringan saraf "memperhatikan". "Pengetahuan" ini tersebar di banyak lapisan neuron tiruan, yang masing-masing memiliki koneksi dengan ratusan atau ribuan neuron lain.

Karena semakin banyak industri mencoba untuk mengotomatiskan atau meningkatkan proses pengambilan keputusan mereka menggunakan AI, masalah "kotak hitam" ini tampaknya kurang cacat teknologi, dan lebih banyak cacat mendasar. Sebuah proyek dari DARPA yang disebut XAI (singkatan untuk "AI yang Dapat Dijelaskan", AI yang dapat dijelaskan) secara aktif mengeksplorasi masalah ini, dan interpretabilitas bergerak dari garis depan penelitian di bidang MO yang lebih dekat ke pusatnya. "AI berada pada saat kritis ketika kita, umat manusia, mencoba mencari tahu apakah teknologi ini tepat untuk kita," kata Kim. "Jika kita tidak menyelesaikan masalah interpretabilitas, saya pikir kita tidak akan bisa melanjutkan dengan teknologi ini, dan mungkin kita hanya akan menolaknya."

Kim dan rekan-rekannya di Google Brain baru-baru ini mengembangkan sistem Pengujian dengan Concept Activation Vectors (TCAV), yang ia gambarkan sebagai penerjemah manusia yang memungkinkan pengguna untuk bertanya pada kotak hitam AI pertanyaan tentang seberapa banyak konsep tingkat tinggi tertentu dilibatkan dalam pengambilan keputusan. Misalnya, jika sistem MO dilatih untuk menemukan gambar zebra, seseorang dapat meminta TCAV untuk menggambarkan berapa banyak konsep "garis" yang dibuat untuk proses pengambilan keputusan.

TCAV awalnya diuji pada model yang dilatih untuk mengenali gambar, tetapi juga bekerja dengan model yang dirancang untuk pemrosesan kata atau tugas-tugas tertentu dari visualisasi data, misalnya, grafik EEG. "Ini umum dan sederhana - dapat dihubungkan ke berbagai model," kata Kim.

Quanta berbicara dengan Kim tentang apa arti interpretabilitas, siapa yang membutuhkannya, dan mengapa itu penting.

Anda dalam karier Anda berfokus pada "interpretabilitas" untuk MO. Tapi apa sebenarnya arti istilah ini?

Anda dalam karier Anda berfokus pada "interpretabilitas" untuk MO. Tapi apa sebenarnya arti istilah ini?Interpretabilitas memiliki dua cabang. Salah satunya adalah interpretabilitas untuk sains: jika Anda menganggap jaringan saraf sebagai objek studi, maka Anda dapat melakukan eksperimen ilmiah untuk benar-benar memahami keseluruhan seluk beluk model, alasan reaksinya, dan sebagainya.

Cabang kedua, yang menjadi fokus utama upaya saya, adalah kemampuan menafsirkan untuk menciptakan AI yang mampu menjawab pertanyaan. Anda tidak perlu memahami setiap detail kecil dari model. Tetapi tujuan kami adalah untuk cukup memahami sehingga alat ini dapat digunakan dengan aman.

Tetapi bagaimana seseorang bisa percaya pada suatu sistem, jika seseorang tidak sepenuhnya memahami cara kerjanya?Saya akan memberi Anda analogi. Misalkan di halaman saya ada pohon yang ingin saya tebang. Saya memiliki gergaji mesin untuk ini. Saya tidak mengerti persis bagaimana gergaji mesin bekerja. Tetapi instruksi mengatakan, "Sesuatu yang harus ditangani dengan hati-hati untuk tidak memotong dirimu sendiri." Memiliki instruksi, saya lebih baik menggunakan gergaji daripada gergaji tangan - yang terakhir ini lebih mudah dipahami, tetapi saya harus melihatnya selama lima jam.

Anda mengerti apa artinya "memotong", bahkan jika Anda tidak tahu segalanya tentang mekanisme yang memungkinkan ini terjadi.Ya Tujuan dari cabang kedua dari penafsiran adalah sebagai berikut: dapatkah kita memahami alat yang cukup untuk aman digunakan? Dan kita dapat menciptakan pemahaman ini dengan mengonfirmasi bahwa pengetahuan manusia yang berguna tercermin dalam instrumen.

Tetapi bagaimana "refleksi pengetahuan manusia" membuat kotak hitam AI lebih mudah dipahami?Ini adalah contoh lain. Jika dokter menggunakan model MO untuk membuat diagnosis kanker, dokter perlu mengetahui bahwa model tersebut tidak hanya memilih beberapa korelasi acak dalam data yang tidak kita butuhkan. Salah satu cara untuk memverifikasi ini adalah untuk mengkonfirmasi bahwa model MO melakukan kira-kira hal yang sama yang akan dilakukan dokter. Artinya, untuk menunjukkan bahwa pengetahuan diagnostik dokter tercermin dalam model.

Misalnya, jika seorang dokter mencari contoh sel yang cocok untuk diagnosis kanker, ia akan mencari sesuatu yang disebut "kelenjar bergabung". Dia juga akan mempertimbangkan indikator seperti usia pasien, dan apakah dia telah menjalani kemoterapi di masa lalu. Faktor-faktor ini, atau konsep, akan diperhitungkan oleh seorang dokter yang mencoba mendiagnosis kanker. Jika kita dapat menunjukkan bahwa model MO juga menarik perhatian mereka, maka model itu akan lebih dimengerti, karena itu akan mencerminkan pengetahuan manusia dari dokter.

Inilah yang ditangani TCAV - menunjukkan konsep tingkat tinggi mana yang digunakan model MO untuk pengambilan keputusan?Ya Sebelum ini, metode interpretabilitas hanya menjelaskan apa yang dilakukan jaringan saraf dalam hal "fitur input". Apa artinya ini? Jika Anda memiliki gambar, maka masing-masing pikselnya akan menjadi fitur input.

Yang Lekun (pelopor pembelajaran mendalam, direktur penelitian AI di Facebook), mengatakan bahwa ia menganggap model-model ini sebagai super-interpretable, karena Anda dapat melihat setiap node dari jaringan saraf dan melihat nilai numerik untuk setiap fitur input. Untuk komputer, ini mungkin cocok, tetapi orang berpikir secara berbeda. Saya tidak memberi tahu Anda "Lihat piksel dari 100 hingga 200, nilai RGB-nya adalah 0,2 dan 0,3." Saya berkata, "Ini adalah gambar anjing yang sangat berbulu." Orang berkomunikasi dengan cara ini - melalui konsep.

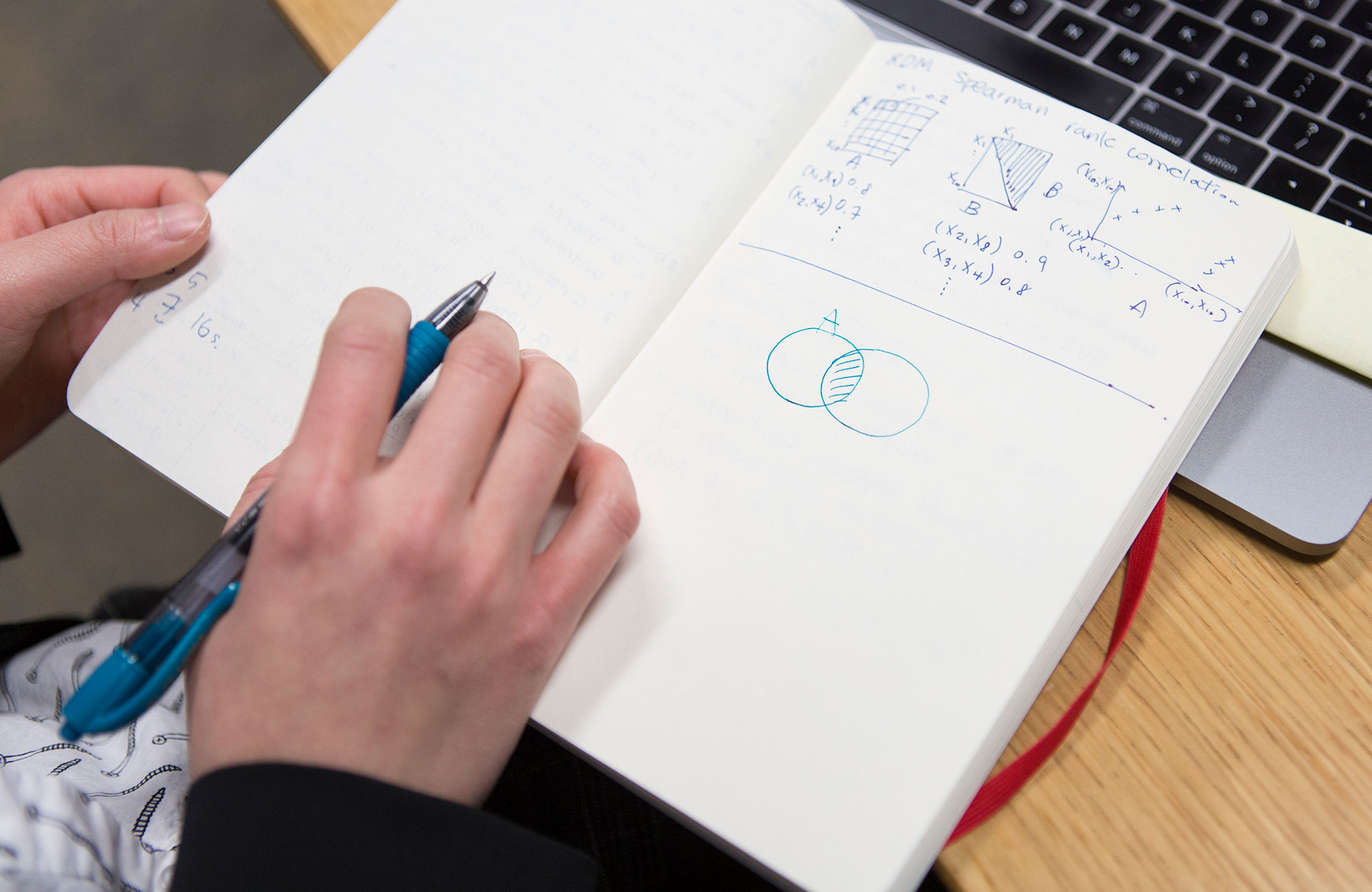

Bagaimana TCAV menerjemahkan antara fitur dan konsep input?Mari kita kembali ke contoh seorang dokter menggunakan model MO, yang telah dilatih untuk mengklasifikasikan gambar sampel sel menurut kanker. Anda, sebagai dokter, perlu mencari tahu seberapa penting konsep "kelenjar bergabung" bagi model untuk membuat prediksi positif untuk kanker. Pertama, Anda mengumpulkan, katakanlah, 20 gambar yang menunjukkan contoh kelenjar yang digabungkan. Kemudian Anda menghubungkan contoh berlabel ini ke model.

Kemudian, TCAV di dalam dirinya melakukan apa yang disebut "Periksa sensitivitas". Ketika kami menambahkan gambar berlabel dari kelenjar yang bergabung ini, seberapa besar kemungkinan prediksi kanker positif meningkat? Jawabannya dapat diperkirakan dengan angka dari 0 hingga 1. Dan ini akan menjadi poin Anda di TCAV. Jika kemungkinan meningkat, konsep ini penting untuk model. Jika tidak, konsep ini tidak penting.

"Konsep" adalah istilah yang tidak jelas. Apakah ada konsep yang tidak akan berfungsi dengan TCAV?Jika Anda tidak dapat menjelaskan konsep menggunakan subset dari kumpulan data Anda, maka itu tidak akan berfungsi. Jika model MO Anda terlatih dalam gambar, maka konsep tersebut harus dinyatakan secara visual. Jika, misalnya, saya ingin mengekspresikan konsep cinta secara visual, itu akan sangat sulit dilakukan.

Kami juga hati-hati memeriksa konsepnya. Kami memiliki prosedur verifikasi statistik yang menolak vektor konsep jika memiliki efek yang setara dengan acak pada model. Jika konsep Anda tidak lulus tes ini, maka TCAV akan berkata, "Saya tidak tahu, konsep ini tidak terlihat seperti sesuatu yang penting bagi model."

Apakah proyek TCAV lebih fokus pada membangun kepercayaan AI daripada menggeneralisasikan pemahamannya?

Apakah proyek TCAV lebih fokus pada membangun kepercayaan AI daripada menggeneralisasikan pemahamannya?Tidak, - dan saya akan menjelaskan alasannya, karena perbedaan ini sangat halus.

Dari banyak penelitian di bidang sains kognitif dan psikologi, kita tahu bahwa orang sangat percaya. Ini berarti bahwa sangat mudah untuk menipu seseorang dengan memaksanya untuk percaya pada sesuatu. Tujuan interpretabilitas MO adalah sebaliknya. Ini terdiri dari memberi tahu seseorang bahwa tidak aman menggunakan sistem tertentu. Tujuannya adalah untuk mengungkap kebenaran. Karena itu, “kepercayaan” bukanlah kata yang tepat.

Jadi tujuan dari interpretabilitas adalah untuk mengungkap potensi kelemahan dalam penalaran AI?Ya persis.

Bagaimana dia bisa mengungkapkan kekurangannya?TCAV dapat digunakan untuk mengajukan pertanyaan kepada model tentang konsep yang tidak terkait dengan bidang penelitian. Kembali ke contoh dokter yang menggunakan AI untuk memprediksi kemungkinan kanker. Dokter mungkin tiba-tiba berpikir: “Rupanya, mesin memberikan prediksi positif untuk keberadaan kanker untuk banyak gambar di mana warnanya sedikit berubah menjadi biru. Kami percaya bahwa faktor ini tidak harus dipertimbangkan. " Dan jika mereka mendapatkan skor TCAV tinggi untuk warna biru, itu berarti bahwa mereka menemukan masalah dalam model MO mereka.

TCAV dirancang untuk digantung pada sistem AI yang ada yang tidak dapat diartikan. Mengapa tidak segera membuat sistem yang diartikan sebagai ganti kotak hitam?Ada cabang studi penafsiran, dengan fokus pada penciptaan model yang awalnya ditafsirkan yang mencerminkan alasan seseorang. Tapi saya pikir begitu: sekarang kita sudah penuh dengan model AI siap pakai yang sudah digunakan untuk memecahkan masalah-masalah penting, dan ketika membuat mereka, kita awalnya tidak memikirkan interpretabilitas. Sangat mudah dimakan. Banyak dari mereka yang bekerja di Google! Anda dapat mengatakan, "Interpretabilitas sangat berguna sehingga kami dapat membuat model lain untuk Anda ganti yang Anda miliki." Baiklah, semoga berhasil.

Lalu apa yang harus dilakukan? Kita masih harus melalui momen penting ini dalam memutuskan apakah teknologi ini bermanfaat bagi kita atau tidak. Oleh karena itu, saya bekerja pada metode interpretabilitas pasca pelatihan. Jika seseorang memberi Anda sebuah model dan Anda tidak dapat mengubahnya, bagaimana Anda mendekati tugas menghasilkan penjelasan tentang perilakunya sehingga Anda dapat menggunakannya dengan aman? Inilah yang dilakukan TCAV.

TCAV memungkinkan orang untuk bertanya kepada AI tentang pentingnya konsep tertentu. Tetapi bagaimana jika kita tidak tahu harus bertanya apa - bagaimana jika kita ingin AI hanya menjelaskan?

TCAV memungkinkan orang untuk bertanya kepada AI tentang pentingnya konsep tertentu. Tetapi bagaimana jika kita tidak tahu harus bertanya apa - bagaimana jika kita ingin AI hanya menjelaskan?Saat ini kami sedang mengerjakan proyek yang dapat secara otomatis menemukan konsep untuk Anda. Kami menyebutnya DTCAV - TCAV pembuka. Tetapi saya berpikir bahwa masalah utama dari interpretabilitas adalah bahwa orang berpartisipasi dalam proses ini, dan bahwa kami mengizinkan orang dan mesin untuk berkomunikasi.

Dalam banyak kasus, ketika bekerja dengan aplikasi yang sangat tergantung, para ahli di bidang tertentu sudah memiliki daftar konsep yang penting bagi mereka. Kami di Google Brain selalu dihadapkan dengan ini dalam aplikasi medis AI. Mereka tidak membutuhkan serangkaian konsep - mereka ingin memberikan model konsep yang menarik bagi mereka. Kami bekerja dengan dokter yang merawat retinopati diabetik, penyakit mata, dan ketika kami memberi tahu dia tentang TCAV, dia sangat senang karena dia sudah memiliki sejumlah hipotesis tentang apa yang dapat dilakukan oleh model, dan sekarang dia dapat memeriksa semua pertanyaan yang muncul. Ini merupakan nilai tambah yang besar, dan cara yang sangat berpusat pada pengguna untuk menerapkan pembelajaran mesin kolaboratif.

Anda berpikir bahwa tanpa interpretabilitas, manusia dapat dengan mudah meninggalkan teknologi AI. Mengingat peluang apa yang dimilikinya, apakah Anda benar-benar mengevaluasi opsi seperti itu nyata?Ya Inilah yang terjadi dengan sistem pakar. Pada 1980-an, kami memutuskan bahwa mereka lebih murah daripada orang dalam memecahkan beberapa masalah. Dan siapa yang menggunakan sistem pakar hari ini? Tidak ada Dan setelah itu musim dingin AI datang.

Sejauh ini, ini tampaknya tidak mungkin, begitu banyak hype dan uang yang diinvestasikan dalam AI. Tetapi dalam jangka panjang, saya berpikir bahwa manusia dapat memutuskan - mungkin karena takut, mungkin karena kurangnya bukti - bahwa teknologi ini tidak cocok untuk kita. Itu mungkin.