“Komputer berkecepatan tinggi tidak dapat bekerja tanpa udara”

Ada momen dalam film Iron Man 2 ketika Tony Stark menonton film lama dari almarhum ayahnya, di mana ia berkata: “Saya dibatasi oleh teknologi waktu saya, tetapi suatu hari Anda dapat mengetahuinya. Dan kemudian Anda akan mengubah dunia. " Ini fantastis, tetapi gagasan yang diungkapkannya cukup nyata. Gagasan para insinyur seringkali jauh di depan waktu mereka. Selalu ada gadget di Star Trek, tetapi seluruh dunia harus bekerja selama beberapa dekade untuk membuat tablet dan e-book.

Konsep pendingin cair sangat cocok dengan kategori ini. Gagasan itu sendiri sudah ada sejak 1960-an, tetapi tetap radikal dibandingkan dengan pilihan yang jauh lebih murah dan lebih aman untuk pendingin udara. Butuh waktu lebih dari 40 tahun hingga pendinginan cairan mulai berkembang pada tahun 2000-an, dan bahkan pada saat itu hak prerogatif penggemar PC yang berusaha untuk membubarkan CPU mereka jauh melampaui batas yang direkomendasikan oleh Intel dan AMD.

Saat ini, sistem pendingin cair semakin populer. Sistem seperti itu untuk PC dapat dibeli dengan harga kurang dari $ 100, dan produksi kerajinan tangan ditujukan untuk aplikasi industri dan pusat data (seperti CoolIT, Asetek, Komputasi Revolusi Hijau, Ebullient) menawarkan pendingin cair () untuk server. ZhO terutama digunakan pada superkomputer, komputasi berkecepatan tinggi, atau situasi lain di mana dibutuhkan sejumlah besar daya komputer, dan prosesor bekerja dengan beban hampir 100%, tetapi opsi seperti itu menjadi lebih umum.

Ada dua jenis ZhO yang populer: pendinginan chip langsung dan pencelupan. Dengan pendinginan langsung, radiator terpasang ke CPU, seperti pendingin standar, tetapi alih-alih dua pipa tersambung ke CPU. Yang satu hadir dengan air dingin, heatsink pendingin yang menyerap panas CPU, dan yang lainnya panas. Kemudian dingin dan kembali ke CPU dalam loop tertutup menyerupai aliran darah.

Selama pendinginan selam, peralatan diisi dengan cairan, yang, jelas, tidak boleh menghantarkan listrik. Pendekatan ini paling mirip dengan kolam pendingin reaktor nuklir. Pendinginan submersible tetap merupakan opsi yang lebih maju, dan membutuhkan pendingin yang lebih mahal daripada koneksi langsung, di mana Anda dapat menggunakan air biasa. Selain itu, selalu ada risiko kebocoran. Oleh karena itu, sejauh ini opsi yang paling populer adalah koneksi langsung.

Sebagai salah satu contoh utama, ambil Alphabet. Ketika perusahaan induk ini untuk Google pada Mei 2018 memperkenalkan prosesor untuk AI TensorFlow 3.0, direktur Sundar Pichai mengatakan bahwa chip ini sangat kuat sehingga "untuk pertama kalinya kami harus memasang pendingin cairan di pusat data." Alphabet harus membayar harga ini untuk peningkatan delapan kali lipat dalam produktivitas.

Di sisi lain, Skybox Datacenters baru-baru ini mengumumkan rencana untuk membuat superkomputer besar dengan 40.000 server dari DownUnder GeoSolutions (DUG), yang dirancang untuk eksplorasi minyak dan gas. Proyek ini akan menghasilkan 250 petaflop daya komputasi, lebih dari yang ada, dan diharapkan server akan didinginkan oleh fluida ketika direndam dalam tangki yang diisi dengan cairan dielektrik.

Bagaimanapun, "pendinginan cair adalah pendinginan masa depan, dan itu akan selalu terjadi," kata Craig Pennington, wakil presiden departemen desain di operator pusat data Equinix. "Tampaknya jelas bahwa ini adalah pendekatan yang tepat, tetapi tidak ada yang menerapkannya."

Bagaimana JO berubah dari seni esoteris saat pergantian komputasi menjadi metode yang hampir diterima secara universal di pusat data modern? Seperti semua teknologi, ini terjadi sebagian sebagai hasil dari evolusi, coba-coba, dan sejumlah besar solusi teknik. Namun, untuk ZhO, pusat data saat ini harus berterima kasih kepada para overclocker awal yang merupakan pahlawan tanpa tanda jasa dari metode ini.

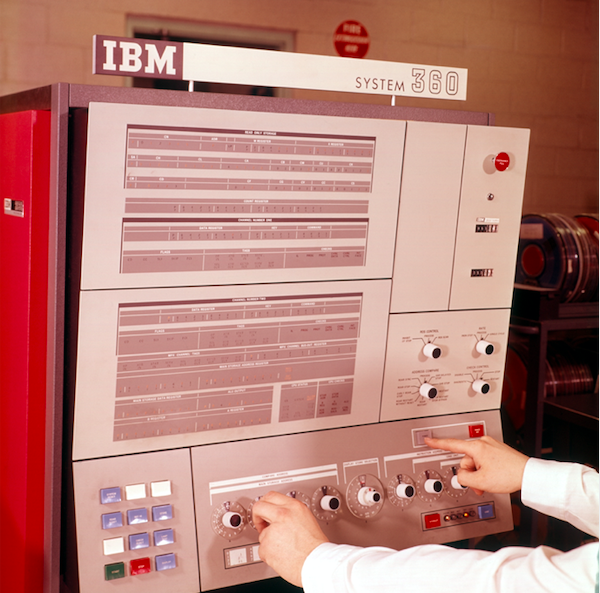

Panel kontrol sistem pemrosesan data IBM System 360

Panel kontrol sistem pemrosesan data IBM System 360Apa yang kami maksud dengan pendingin cair

Pendinginan cairan menjadi ide populer pada tahun 1964 ketika IBM mempelajari masalah pendinginan submersible untuk mainframe System 360. Itu adalah salah satu mainframe perusahaan; Seri 700 dan 7000 ada selama lebih dari sepuluh tahun, dan System / 360 "memulai era kompatibilitas komputer - untuk pertama kalinya memungkinkan berbagai mesin dari lini produk bekerja bersama", saat mereka menulis di IBM. Konsepnya sederhana: air dingin harus mengalir melalui alat yang mendinginkannya ke suhu di bawah suhu kamar, dan kemudian air akan dimasukkan langsung ke dalam sistem. Sirkuit yang digunakan oleh IBM sekarang dikenal sebagai pendinginan kembali ketika heatsink dipasang di belakang mainframe. Perangkat menghisap udara panas dari mainframe dengan kipas, dan kemudian udara ini didinginkan oleh air, seperti radiator yang mendinginkan mesin mobil.

Sejak itu, para insinyur telah menyempurnakan konsep dasar ini, dan dua bentuk VF dominan telah muncul: pencelupan dan kontak langsung. Perendaman adalah apa adanya; Elektronik ada dalam wadah cairan, yang, untuk alasan yang jelas, tidak bisa berupa air. Cairan tidak boleh menghantarkan listrik, yaitu menjadi isolator (perusahaan seperti 3M bahkan secara khusus mengembangkan cairan untuk ini).

Tetapi menyelam memiliki banyak masalah dan kekurangan. Server yang terletak di cairan hanya dapat dicapai dari atas. Karena itu, port eksternal harus ditempatkan di sana. Penempatan server dari lampiran 1U di rak akan menjadi tidak praktis, sehingga server tidak dapat ditempatkan secara berurutan. Dielektrik, dan biasanya mineral, kecil, sangat mahal, dan sulit dibersihkan jika terjadi kebocoran. Hard drive khusus akan diperlukan, dan perubahan pusat data akan membutuhkan investasi yang signifikan. Oleh karena itu, seperti dalam kasus superkomputer yang disebutkan di atas, perendaman lebih baik dilakukan di pusat data baru, daripada mengulangi yang lama.

Kontak langsung JO, sebaliknya, adalah radiator (atau penukar panas) ada pada chip, seperti radiator biasa. Alih-alih kipas, ia menggunakan dua pipa air - satu membawa air dingin untuk pendinginan, dan yang kedua meniup air panas yang dipanaskan melalui kontak dengan radiator. Bentuk ZhO ini menjadi yang paling populer, diadopsi dari produsen seperti HP Enterprise, Dell EMC dan IBM, serta dari produsen lampiran Chatsworth Systems dan Schneider Electric.

Pendinginan langsung menggunakan air, tetapi sangat sensitif terhadap kualitasnya. Air keran tanpa filter tidak boleh digunakan. Lihat saja keran atau kepala pancuran Anda. Tidak ada yang membutuhkan akumulasi kalsium di server. Setidaknya pendinginan langsung membutuhkan air suling murni, dan terkadang campurannya dengan antibeku. Pembuatan pendingin semacam itu adalah ilmu itu sendiri.

Penghubung Intel

Bagaimana kita beralih dari radiator IBM ke sistem pendingin yang modern dan boros? Sekali lagi, terima kasih kepada para overclocker. Pada pergantian abad, pendingin cair mulai mendapatkan popularitas di kalangan overclocker PC dan amatir yang merakit komputer mereka yang ingin meningkatkan kecepatan mereka di luar batas resmi. Namun, itu adalah seni esoteris tanpa desain standar. Semua orang melakukan sesuatu yang berbeda. Orang yang merakit semua ini perlu sedemikian

rupa sehingga perakitan produk IKEA tampak omong kosong. Sebagian besar sistem pendingin bahkan tidak masuk ke dalam selungkup.

Pada awal 2004, situasi mulai berubah karena perubahan internal dalam kebijakan Intel. Seorang insinyur dari Hillsboro, pusat desain Oregon - tempat sebagian besar chip perusahaan dirancang, meskipun bermarkas di Santa Clara, California - telah mengerjakan proyek pendinginan khusus selama beberapa tahun. Proyek ini menelan biaya $ 1 juta bagi perusahaan, dan bertujuan untuk menciptakan pendingin cair untuk prosesor Intel. Sayangnya, Intel akan mematikannya.

Insinyur itu mengharapkan hasil yang berbeda. Untuk menyelamatkan proyek tersebut, ia datang dengan ide ini di Falcon Northwest, sebuah perusahaan yang berbasis di Portland yang membangun add-on game untuk komputer. "Alasannya adalah karena perusahaan berpikir bahwa cairan pendingin mendorong orang untuk melakukan overclock, dan aktivitas ini dilarang pada saat itu," kata Kelt Reeves, presiden Falcon Northwest. Dan dalam posisi ini, Intel memiliki logikanya sendiri. Pada waktu itu, pengecer berprinsip dari Asia menjual PC overclock dengan kedok yang lebih kuat, dan dengan pendingin yang buruk, dan di mata publik, ini entah bagaimana berubah menjadi masalah Intel. Karena itu, perusahaan menentang overclocking.

Namun, insinyur dari Oregon ini percaya bahwa jika ia berhasil menemukan pelanggan dan pasar untuk pendingin seperti itu, maka Intel akan menghasilkan. (Selain itu, produk Intel yang dihasilkan jauh lebih baik dalam kualitas daripada apa yang tersedia di pasar, Reeves memberi tahu kami). Oleh karena itu, setelah beberapa persuasi internal dan negosiasi antara perusahaan, Intel mengizinkan Falcon untuk menjual sistem pendingin - khususnya karena Intel telah menghasilkan ribuan. Satu-satunya yang menarik adalah bahwa Falcon tidak dapat menyebutkan bahwa Intel terlibat. Falcon setuju, dan segera menjadi produsen pertama yang memasok sistem PC all-in-one yang sepenuhnya tertutup.

Reeves mencatat bahwa solusi ZhO canggih ini tidak terlalu ramah pengguna. Falcon harus mengganti kasing agar sesuai dengan radiator, dan menciptakan pelat pendingin untuk air. Namun seiring berjalannya waktu, produsen pendingin, seperti ThermalTake dan Corsair, mempelajari apa yang sedang dilakukan Intel dan mulai melakukan perbaikan yang konsisten. Sejak itu, beberapa produk dan produsen telah muncul, misalnya, CoolIT dan Asetek, yang secara khusus membuat ZhO untuk pusat data. Beberapa produk mereka - misalnya, pipa yang tidak pecah, tidak retak dan tidak bocor dengan jaminan hingga tujuh tahun - pada akhirnya diberikan di bawah lisensi untuk produsen sistem pendingin untuk pengguna akhir, dan pertukaran teknologi semacam itu di kedua arah telah menjadi norma.

Dan ketika pasar ini tumbuh ke arah yang berbeda, bahkan Intel akhirnya berubah pikiran. Sekarang dia mengiklankan kemampuan overclocking untuk prosesor seri K dan X, dan bahkan tidak peduli dengan penjualan pendingin biasa bersama dengan CPU terbaik untuk para gamer.

"ZhO sudah menjadi teknologi yang terbukti - semua orang melakukannya di sisi konsumen," kata Reeves. Intel telah berhenti memasok pendingin biasa dengan CPU paling kuat, karena mereka membutuhkan JO; itu sudah terbukti dan berkat dari Intel telah diterima. Saya tidak berpikir bahwa ada seseorang yang akan mengatakan bahwa solusi lengkap untuk ini tidak cukup dapat diandalkan. "

Pendinginan pendinginan di pusat data. Kotak-kotak diisi dengan cairan dielektrik yang mengalir melalui pipa.

Pendinginan pendinginan di pusat data. Kotak-kotak diisi dengan cairan dielektrik yang mengalir melalui pipa. Pendinginan cairan dari Pusat Data Skybox dengan pencelupan. Penukar panas direndam dengan peralatan komputer, dan cairan dielektrik tidak meninggalkan tangki. Sirkuit air melewati kamar-kamar dan mendekati setiap penukar panas.

Pendinginan cairan dari Pusat Data Skybox dengan pencelupan. Penukar panas direndam dengan peralatan komputer, dan cairan dielektrik tidak meninggalkan tangki. Sirkuit air melewati kamar-kamar dan mendekati setiap penukar panas.Fakta yang mendukung kepraktisan pendinginan cair

Untuk waktu yang lama, pusat data tradisional menyediakan lantai yang ditinggikan dengan bukaan kecil di mana udara dingin naik, dihisap oleh server. Ini disebut CRAC, atau AC ruang komputer. Masalahnya adalah bahwa sekarang tidak cukup untuk meniupkan udara dingin melalui lubang di lantai.

Alasan utama untuk booming baru-baru ini dalam pendingin cair adalah kebutuhan. Prosesor hari ini menjadi terlalu panas, dan server terlalu dekat untuk udara untuk mendinginkan mereka secara efisien, bahkan Google mengatakan. Kapasitas panas air adalah 3300 kali lebih besar dari udara, dan sistem pendingin air mampu memompa 300 liter air per menit, dibandingkan dengan 20 meter kubik udara per menit.

Sederhananya, air dapat mendinginkan lebih efisien dan di ruang yang jauh lebih kecil. Oleh karena itu, setelah bertahun-tahun berusaha mengurangi konsumsi daya, produsen prosesor dapat menyebarkan daya dan memutar tegangan untuk kinerja maksimum - mengetahui bahwa pendingin cair dapat menangani hal ini.

"Kami diminta untuk mendinginkan chip yang konsumsi dayanya akan melampaui 500 watt," kata Jeff Lyon, direktur CoolIT. - Beberapa prosesor yang belum memasuki pasar akan mengkonsumsi masing-masing 300 watt. Semua ini berkembang atas permintaan AI dan pembelajaran mesin. Kecepatan pendinginan tidak cukup. ”

Lyon mengatakan CoolIT sedang mempertimbangkan untuk memperluas sistem pendingin ke chipset, sistem kontrol daya, chip jaringan, dan memori. "Tidak akan ada yang radikal dalam berurusan dengan memori," tambahnya. - Ada opsi RAM dengan kemasan canggih, mengkonsumsi 18 watt per DIMM. DIMM tipikal mengkonsumsi 4-6 watt. Di antara sistem dengan jumlah memori yang besar, kami menemukan server dengan 16 atau bahkan 24 DIMM terpasang, yang berarti banyak panas. ”

Satu per satu, produsen dihadapkan dengan permintaan seperti itu. Equinix mengamati bagaimana kepadatan rata-rata tumbuh dari 5 kW menjadi 7-8 kW, dan sekarang menjadi 15-16 kW, dengan beberapa peralatan sudah menunjukkan kepadatan 40 kW. “Jadi jumlah total udara yang perlu dipompa menjadi terlalu besar. Itu tidak akan terjadi secara instan, tetapi dalam beberapa tahun ke depan akan ada adopsi pendingin cair yang mendasar, ”kata Pennington dari Equinix.

Sedikit tentang pendinginan selam

Pendinginan Revolusi Hijau berfokus pada pendinginan perendaman, dan direkturnya Peter Poulin mengatakan bahwa dari perspektif efisiensi energi, pendinginan perendaman lebih baik daripada pendinginan langsung karena dua alasan. Pertama, penggemar dihapus dari semua server. Hanya ini yang mengurangi konsumsi energi rata-rata 15%. Dan satu klien perusahaan menguranginya hingga 30%.

Ada keuntungan tidak langsung lain untuk menghilangkan penggemar: diam. Terlepas dari kenyataan bahwa server sering menggunakan kipas yang sangat kecil, server sangat berisik, dan berada di pusat data tidak menyenangkan karena panas dan kebisingan. Pendinginan cairan membuat tempat-tempat ini jauh lebih menyenangkan untuk dikerjakan.

Keuntungan lain adalah sangat sedikit energi yang dibutuhkan untuk mendukung sistem pendingin pencelupan. Hanya ada tiga bagian yang bergerak: pompa untuk mengalirkan pendingin, pompa untuk memindahkannya ke menara pendingin, dan kipas menara pendingin. Setelah mengganti udara berpendingin cair, konsumsi listrik dapat turun hingga 5% dari apa yang dihabiskan untuk pendingin udara. "Anda mendapatkan pengurangan besar dalam konsumsi energi, yang memungkinkan Anda melakukan banyak hal lain," kata Poulnin. “Bergantung pada konsumen, pusat data mungkin lebih hemat energi atau mengurangi emisi karbon yang terkait dengan pembangunan pusat data.”

Fakta yang mendukung efisiensi cairan pendingin energi

Konsumsi energi telah lama menjadi perhatian bagi industri pusat data (Badan Perlindungan Lingkungan AS telah melacak angka ini setidaknya selama sepuluh tahun). Pusat data saat ini adalah perusahaan besar yang mengonsumsi sekitar 2% dari seluruh listrik global dan melepaskan CO

2 ke atmosfer seperti industri penerbangan. Karena itu, minat terhadap masalah ini tidak hilang. Untungnya, pendinginan cairan mengurangi tagihan listrik.

Penghematan pertama adalah karena terputusnya AC di pusat data. Yang kedua adalah eliminasi penggemar. Setiap rak server memiliki banyak penggemar yang meniupkan udara, tetapi jumlah mereka dapat dikurangi menjadi sejumlah kecil atau nol, tergantung pada kepadatannya.

Dan dengan teknologi "pendinginan kering", di mana tidak ada pembekuan, Anda dapat mencapai penghematan yang lebih besar. Awalnya, pendingin yang terhubung langsung mengarahkan air melalui kulkas, yang mendinginkannya hingga 15-25 derajat Celcius. Tetapi pada akhirnya, ternyata pendingin cairan, yang melewati air melalui urutan panjang pipa dan kipas, pipa dingin dipanaskan oleh air panas, dan difusi termal alami juga mendinginkan air ke suhu yang cukup.

“Karena proses ini sangat efisien, Anda tidak perlu khawatir tentang pendinginan air hingga suhu rendah,” kata Pennington. - Air hangat masih efektif menghilangkan semua panas dari server. Anda tidak perlu siklus kompresi, Anda bisa menggunakan pendingin kering. "

Pendingin kering juga menghemat air. Pusat data besar yang menggunakan lemari es dapat mengonsumsi jutaan liter air per tahun, tetapi pusat data dengan pendingin kering tidak mengonsumsi air. Ini menghemat energi dan air, yang bisa sangat berguna jika pusat data terletak di dalam kota.

"Kami tidak mengkonsumsi banyak air," kata Pennington. - Jika Anda hati-hati merancang segalanya, Anda mendapatkan sistem tertutup. Air tidak mengalir dan tidak mengalir, Anda hanya perlu menambahkan air setahun sekali untuk menjaga tangki tetap penuh. Anda tidak terus-menerus menambahkan air ke mobil Anda, demikian halnya dengan kami. "

Penerimaan Mengikuti Efektivitas

Satu contoh dunia nyata: Dell, beralih ke pendingin cair, meningkatkan efisiensi energi (

PUE ) sebesar 56%, menurut Brian Payne, wakil presiden manajemen produk dan pemasaran di PowerEdge Dell EMC.

PUE adalah rasio energi yang perlu dihabiskan untuk mendinginkan sistem dengan energi yang diperlukan untuk mengoperasikan sistem [pada kenyataannya, ini adalah rasio total energi yang digunakan oleh pusat data dengan energi yang dihabiskan secara langsung untuk menyalakan infrastruktur / perkiraan IT. perev]. PUE sama dengan 3 berarti bahwa 2 kali lebih banyak energi dihabiskan untuk mendinginkan sistem daripada pada daya sistem, dan PUE = 2 berarti bahwa energi dan pendinginan dikonsumsi secara merata. PUE tidak boleh sama dengan 1, karena pendinginan diperlukan, tetapi operator pusat data terobsesi untuk mencoba membuat angka sedekat mungkin dengan 1.0.Selain meningkatkan PUE, peningkatan daya komputasi yang diterima pelanggan Dell bisa mencapai 23%, dan ini tidak membebani sistem tanpa batas. "Berdasarkan investasi infrastruktur yang diperlukan, kami memperkirakan pengembalian tahunan pada sistem," kata Payne. - Saya akan membandingkan ini dengan pembelian AC yang lebih hemat energi untuk rumah. Anda berinvestasi sedikit, tetapi kemudian seiring waktu Anda merasakan manfaat dari tagihan listrik. ”Sebagai penganut pendingin cairan yang sama sekali berbeda, ambil pusat superkomputer di Ohio, OSC. Cluster ini mempekerjakan 1800 node. Setelah beralih ke JO, seperti yang dikatakan Doug Johnson, kepala arsitek sistem, pusat mencapai PUE = 1,5. OSC menggunakan sirkuit eksternal, sehingga air dikeluarkan dari gedung dan didinginkan hingga suhu sekitar, yang rata-rata 30 ° C di musim panas dan lebih sedikit di musim dingin. Keripik mencapai 70 ° C, dan bahkan jika air memanas hingga 40 ° C, ia masih tetap jauh lebih dingin daripada keripik, dan melayani tujuannya.Seperti banyak pengadopsi awal teknologi baru, untuk OSC itu semua baru. Lima tahun lalu, pusat tidak menggunakan ZhO sama sekali, dan hari ini menempati 25%. Pusat berharap bahwa dalam tiga tahun standar akan tumbuh hingga 75%, dan setelah beberapa tahun mereka akan sepenuhnya beralih ke ZhO. Tetapi bahkan dalam keadaan saat ini, menurut Johnson, mendinginkan pusat membutuhkan empat kali lebih sedikit energi daripada sebelum transisi ke ZhO, dan secara umum, solusi ini mengurangi konsumsi energi total sebesar 2/3. "Saya pikir persentasenya akan meningkat ketika kita mulai mengintegrasikan GPU ke dalam sistem pendingin."Dari sudut pandang klien, perlu waktu dan energi untuk mengevaluasi teknologi baru - itulah sebabnya sebuah perusahaan besar seperti Dell setuju untuk bekerja sama dengan CoolIT untuk mengiklankan ZhO. Tidak mengherankan bahwa di tempat pertama di antara kekhawatiran pelanggan tetap ada kemungkinan kebocoran. Namun, terlepas dari semua fluktuasi itu, ternyata saat ini mereka tidak punya banyak pilihan jika ingin mencapai kinerja terbaik."Selalu ada ketakutan akan kebocoran," kata CoolIT, Lyon. - Situasi telah berubah, dan sekarang tidak ada pilihan lain. Komputer berkecepatan tinggi tidak bisa melakukan itu. "