tl; dr:

- Pembelajaran mesin mencari pola dalam data. Tetapi kecerdasan buatan dapat "bias" - yaitu, menemukan pola yang salah. Misalnya, sistem deteksi kanker kulit dari foto-foto dapat memberi perhatian khusus pada gambar yang diambil di kantor dokter. Pembelajaran mesin tidak tahu bagaimana caranya: algoritmanya hanya mengungkapkan pola dalam angka, dan jika datanya tidak representatif, maka hasil dari pemrosesan mereka. Dan menangkap bug seperti itu bisa sulit karena mekanisme pembelajaran mesin.

- Bidang masalah yang paling jelas dan menakutkan adalah keanekaragaman manusia. Ada banyak alasan mengapa data tentang orang dapat kehilangan objektivitas mereka bahkan pada tahap pengumpulan. Tetapi jangan berpikir bahwa masalah ini hanya menyangkut orang: kesulitan yang sama persis muncul ketika mencoba mendeteksi banjir di gudang atau turbin gas yang gagal. Beberapa sistem mungkin memiliki bias tentang warna kulit, yang lain akan bias terhadap sensor Siemens.

- Masalah seperti itu bukan hal baru dalam pembelajaran mesin, dan mereka jauh dari unik baginya. Asumsi yang salah dibuat dalam struktur yang kompleks, dan selalu sulit untuk memahami mengapa keputusan dibuat. Hal ini diperlukan untuk menangani hal ini dengan cara yang rumit: membuat alat dan proses untuk verifikasi - dan mengedukasi pengguna sehingga mereka tidak secara membabi buta mengikuti rekomendasi AI. Pembelajaran mesin benar-benar melakukan beberapa hal yang jauh lebih baik daripada kita, tetapi anjing, misalnya, jauh lebih efektif daripada orang dalam menemukan narkoba, yang bukan alasan untuk menjadikan mereka sebagai saksi dan memberikan hukuman berdasarkan kesaksian mereka. Omong-omong, anjing jauh lebih pintar daripada sistem pembelajaran mesin mana pun.

Pembelajaran mesin saat ini adalah salah satu tren teknologi fundamental yang paling penting. Ini adalah salah satu cara utama teknologi akan mengubah dunia di sekitar kita dalam dekade berikutnya. Beberapa aspek dari perubahan ini mengkhawatirkan. Misalnya, dampak potensial pembelajaran mesin di pasar tenaga kerja, atau penggunaannya untuk tujuan yang tidak etis (misalnya, rezim otoriter). Ada masalah lain yang didedikasikan untuk posting ini: bias kecerdasan buatan .

Ini adalah kisah yang sulit.

Google AI dapat menemukan kucing. Berita dari tahun 2012 ini adalah sesuatu yang istimewa.

Apa itu bias AI?

"Data mentah" adalah sebuah oxymoron dan ide yang buruk; data harus disiapkan dengan baik dan hati-hati. —Jeffrey Boker

Di suatu tempat sebelum 2013, untuk membuat sistem yang, misalnya, mengenali kucing dalam foto, Anda harus menjelaskan langkah-langkah logis. Cara menemukan sudut pada gambar, mengenali mata, menganalisis tekstur untuk keberadaan bulu, menghitung cakar, dan sebagainya. Kemudian kumpulkan semua komponen - dan temukan bahwa semua ini tidak benar-benar berfungsi. Sesuatu seperti kuda mekanik - secara teoritis itu bisa dilakukan, tetapi dalam praktiknya terlalu rumit untuk dijelaskan. Di pintu keluar Anda memiliki ratusan (atau bahkan ribuan) aturan tulisan tangan. Dan bukan model kerja tunggal.

Dengan kemajuan pembelajaran mesin, kami berhenti menggunakan aturan "manual" untuk mengenali suatu objek. Sebagai gantinya, kami mengambil seribu sampel dari "satu," X, seribu sampel dari "yang lain," Y, dan memaksa komputer untuk membangun model berdasarkan analisis statistik mereka. Kemudian kami memberikan model ini beberapa data sampel, dan menentukan dengan akurasi apakah cocok dengan salah satu set. Pembelajaran mesin menghasilkan model berdasarkan data, bukan dengan bantuan orang yang menulisnya. Hasilnya mengesankan, terutama di bidang pengenalan gambar dan pola, dan itulah sebabnya seluruh industri teknologi sekarang pindah ke pembelajaran mesin (ML).

Tapi tidak sesederhana itu. Di dunia nyata, ribuan contoh X atau Y Anda juga mengandung A, B, J, L, O, R dan bahkan L. Mereka dapat didistribusikan secara tidak merata, dan beberapa di antaranya dapat ditemukan begitu sering sehingga sistem akan lebih memperhatikan mereka daripada ke objek yang menarik minat Anda.

Apa artinya ini dalam praktik? Contoh favorit saya adalah ketika sistem pengenalan gambar melihat bukit berumput dan mengatakan "domba . " Dapat dimengerti mengapa: sebagian besar contoh foto "domba" diambil di padang rumput di mana mereka tinggal, dan dalam gambar ini rumput memakan ruang lebih banyak daripada bulu putih kecil, dan itu adalah rumput dari sistem yang dianggap paling penting.

Ada contoh yang lebih serius. Dari baru-baru ini - satu proyek untuk mendeteksi kanker kulit dalam foto. Ternyata dokter kulit sering memotret barisan bersama dengan manifestasi kanker kulit untuk memperbaiki ukuran formasi. Pada contoh foto kulit sehat, tidak ada penggaris. Untuk sistem AI, penggaris tersebut (lebih tepatnya, piksel yang kami definisikan sebagai "penggaris") telah menjadi salah satu perbedaan di antara sekumpulan contoh, dan terkadang lebih penting daripada ruam kulit kecil. Jadi suatu sistem yang dirancang untuk mengidentifikasi kanker kulit, kadang-kadang alih-alih mengenali garis itu.

Poin kunci di sini adalah bahwa sistem tidak memiliki pemahaman semantik tentang apa yang dilihatnya. Kami melihat sekumpulan piksel dan melihat domba, kulit atau penggaris di dalamnya, dan sistem - hanya garis angka. Dia tidak melihat ruang tiga dimensi, dia tidak melihat benda, tekstur, maupun domba. Dia hanya melihat pola dalam data.

Kesulitan dalam mendiagnosis masalah tersebut adalah bahwa jaringan saraf (model yang dihasilkan oleh sistem pembelajaran mesin Anda) terdiri dari ribuan ratusan ribu node. Tidak ada cara mudah untuk melihat ke dalam model dan melihat bagaimana itu membuat keputusan. Kehadiran metode seperti itu berarti bahwa prosesnya cukup sederhana untuk menggambarkan semua aturan secara manual, tanpa menggunakan pembelajaran mesin. Orang-orang khawatir bahwa pembelajaran mesin telah menjadi semacam kotak hitam. (Saya akan menjelaskan sedikit kemudian mengapa perbandingan ini masih terlalu banyak.)

Secara umum, ini adalah masalah bias kecerdasan buatan atau pembelajaran mesin: sistem untuk menemukan pola dalam data dapat menemukan pola yang salah, tetapi Anda mungkin tidak menyadarinya. Ini adalah karakteristik mendasar dari teknologi, dan jelas bagi semua orang yang bekerja dengannya di komunitas ilmiah dan di perusahaan teknologi besar. Tetapi konsekuensinya kompleks, dan demikian juga kemungkinan solusi kami untuk konsekuensi ini.

Mari kita bicarakan konsekuensinya terlebih dahulu.

Secara implisit AI dapat membuat pilihan bagi kita dalam mendukung kategori orang tertentu, berdasarkan sejumlah besar sinyal yang tidak mencolok

Skenario bias AI

Hal yang paling jelas dan menakutkan adalah bahwa masalah ini dapat memanifestasikan dirinya ketika datang ke keragaman manusia. Baru-baru ini , desas-desus telah berlalu bahwa Amazon telah mencoba untuk membangun sistem pembelajaran mesin untuk penyaringan awal dari kandidat pekerjaan. Karena ada lebih banyak laki-laki di antara pekerja Amazon, contoh-contoh "perekrutan yang berhasil" juga lebih sering daripada laki-laki, dan ada lebih banyak laki-laki dalam pemilihan resume yang diusulkan oleh sistem. Amazon memperhatikan hal ini dan tidak merilis sistem produksi.

Hal yang paling penting dalam contoh ini adalah bahwa sistem ini dikabarkan telah memihak kandidat laki-laki, walaupun faktanya gender tidak tercantum dalam resume. Sistem melihat pola-pola lain dalam contoh "perekrutan yang berhasil": misalnya, perempuan dapat menggunakan kata-kata khusus untuk menggambarkan prestasi, atau memiliki hobi khusus. Tentu saja, sistem tidak tahu apa "hoki" itu, atau siapa yang "orang", atau apa yang "sukses" - itu hanya melakukan analisis statistik teks. Tetapi pola-pola yang dilihatnya kemungkinan besar tetap tidak diperhatikan oleh orang tersebut, dan beberapa di antaranya (misalnya, fakta bahwa orang-orang dari jenis kelamin yang berbeda menggambarkan kesuksesan secara berbeda), mungkin akan sulit bagi kita untuk melihat, bahkan memandangnya.

Lebih buruk lagi. Sistem pembelajaran mesin yang menemukan kanker sangat baik pada kulit pucat dapat bekerja lebih buruk dengan kulit gelap, atau sebaliknya. Tidak harus karena bias, tetapi karena Anda mungkin perlu membangun model terpisah untuk warna kulit yang berbeda, memilih karakteristik lain. Sistem pembelajaran mesin tidak dapat dipertukarkan bahkan dalam bidang sempit seperti pengenalan gambar. Anda perlu mengatur sistem, kadang-kadang hanya melalui trial and error, untuk memperhatikan fitur dalam data yang Anda minati, sampai Anda mencapai akurasi yang diinginkan. Tetapi Anda mungkin tidak memperhatikan bahwa sistem di 98% kasus akurat ketika bekerja dengan satu kelompok dan hanya di 91% (meskipun ini lebih akurat daripada analisis yang dilakukan oleh seseorang) di sisi lain.

Sejauh ini saya terutama menggunakan contoh mengenai orang dan karakteristik mereka. Diskusi seputar masalah ini terutama difokuskan pada topik ini. Tetapi penting untuk dipahami bahwa bias terhadap orang hanyalah bagian dari masalah. Kami akan menggunakan pembelajaran mesin untuk banyak hal, dan kesalahan pengambilan sampel akan relevan untuk semuanya. Di sisi lain, jika Anda bekerja dengan orang-orang, bias data mungkin tidak terkait dengan mereka.

Untuk memahami hal ini, mari kita kembali ke contoh dengan kanker kulit dan mempertimbangkan tiga kemungkinan hipotesis dari kerusakan sistem.

- Distribusi orang yang tidak homogen: jumlah foto kulit yang tidak seimbang dengan nada yang berbeda, yang mengarah pada hasil positif palsu atau negatif palsu yang terkait dengan pigmentasi.

- Data di mana sistem dilatih mengandung karakteristik yang sering ditemui dan didistribusikan secara heterogen yang tidak terkait dengan orang dan tidak memiliki nilai diagnostik: penggaris pada foto-foto manifestasi kanker kulit atau rumput pada foto-foto domba. Dalam hal ini, hasilnya akan berbeda jika sistem menemukan piksel dalam gambar sesuatu yang mata manusia definisikan sebagai "penggaris".

- Data berisi karakteristik pihak ketiga yang tidak dapat dilihat seseorang, meskipun ia mencarinya.

Apa artinya ini? Kami tahu apriori bahwa data dapat disajikan secara berbeda oleh kelompok orang yang berbeda, dan setidaknya kami dapat merencanakan untuk mencari pengecualian tersebut. Dengan kata lain, ada banyak alasan sosial untuk berasumsi bahwa data pada kelompok orang sudah mengandung beberapa bias. Jika kita melihat foto dengan penggaris, kita akan melihat penggaris ini - kita mengabaikannya sebelumnya, mengetahui bahwa itu tidak masalah, dan lupa bahwa sistem tidak tahu apa-apa.

Tetapi bagaimana jika semua foto kulit tidak sehat Anda diambil di kantor tempat lampu pijar digunakan, dan sehat dalam cahaya neon? Bagaimana jika, setelah selesai memotret kulit yang sehat, sebelum memotret yang tidak sehat, Anda memperbarui sistem operasi pada telepon, dan Apple atau Google sedikit mengubah algoritma pengurangan kebisingan? Seseorang tidak dapat melihat ini, tidak peduli berapa banyak ia mencari fitur tersebut. Tetapi kemudian sistem penggunaan mesin akan segera melihat dan menggunakannya. Dia tidak tahu apa-apa.

Sementara kami berbicara tentang korelasi yang salah, dapat terjadi bahwa data tersebut akurat dan hasilnya benar, tetapi Anda tidak ingin menggunakannya untuk alasan etika, hukum, atau manajerial. Di beberapa yurisdiksi, misalnya, tidak mungkin memberi perempuan diskon untuk asuransi, meskipun perempuan mungkin lebih aman dalam mengemudi. Kita dapat dengan mudah membayangkan suatu sistem yang, ketika menganalisis data historis, akan menetapkan faktor risiko yang lebih rendah untuk nama perempuan. Ok, mari kita hapus nama dari seleksi. Tapi ingat contoh dengan Amazon: sistem dapat menentukan jenis kelamin dengan faktor lain (meskipun tidak tahu apa jenis kelamin, dan apa itu mesin), dan Anda tidak akan melihat ini sampai regulator secara surut menganalisis tarif yang Anda tawarkan dan tidak membebankan biaya pada Anda. kamu baik-baik saja

Akhirnya, sering kali tersirat bahwa kita akan menggunakan sistem seperti itu hanya untuk proyek yang berhubungan dengan orang dan interaksi sosial. Ini tidak benar. Jika Anda membuat turbin gas, Anda mungkin ingin menerapkan pembelajaran mesin ke telemetri yang ditransmisikan oleh puluhan atau ratusan sensor pada produk Anda (audio, video, suhu, dan sensor lainnya menghasilkan data yang dapat dengan mudah disesuaikan untuk membuat model pembelajaran mesin ) Secara hipotesis, Anda dapat mengatakan: “Berikut adalah data dari seribu turbin yang gagal yang diperoleh sebelum kegagalannya, tetapi di sini adalah data dari seribu turbin yang tidak pecah. Bangun model untuk mengatakan apa perbedaan di antara mereka. ” Nah, sekarang bayangkan sensor Siemens menghabiskan 75% turbin buruk, dan hanya 12% turbin bagus (tidak ada hubungannya dengan kegagalan). Sistem akan membangun model untuk menemukan turbin dengan sensor Siemens. Ups!

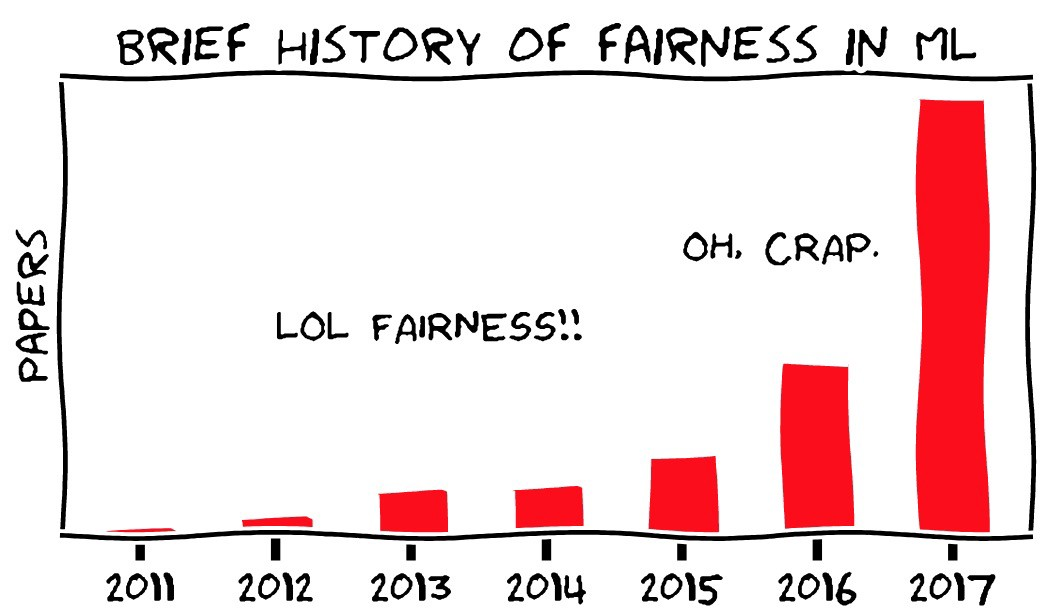

Gambar - Moritz Hardt, UC Berkeley

Manajemen bias AI

Apa yang bisa kita lakukan? Anda dapat mendekati masalah ini dari tiga sisi:

- Ketelitian metodologis dalam pengumpulan dan pengelolaan data untuk melatih sistem.

- Alat teknis untuk menganalisis dan mendiagnosis perilaku model.

- Pelatihan, pendidikan, dan kehati-hatian dalam memperkenalkan pembelajaran mesin ke dalam produk.

Ada lelucon dalam buku Moliere "The Tradesman in the Nobility": seorang pria diberitahu bahwa sastra dibagi menjadi prosa dan puisi, dan dia mengagumi dengan kekaguman bahwa dia berbicara prosa sepanjang hidupnya tanpa menyadarinya. Mungkin, ahli statistik entah bagaimana merasa seperti ini hari ini: tanpa menyadarinya, mereka mengabdikan karier mereka untuk kecerdasan buatan dan kesalahan pengambilan sampel. Untuk mencari kesalahan pengambilan sampel dan khawatir tentang itu bukan masalah baru, kita hanya perlu pendekatan solusinya secara sistematis. Seperti disebutkan di atas, dalam beberapa kasus sangat mudah untuk melakukan ini dengan mempelajari masalah yang terkait dengan data orang. Kami apriori berasumsi bahwa kami mungkin memiliki prasangka tentang berbagai kelompok orang, tetapi sulit bagi kami untuk membayangkan prasangka tentang sensor Siemens.

Yang baru dalam semua ini, tentu saja, adalah bahwa orang tidak lagi terlibat langsung dalam analisis statistik. Ini dilakukan oleh mesin yang membuat model rumit besar yang sulit dimengerti. Masalah transparansi adalah salah satu aspek utama dari masalah bias. Kami takut bahwa sistem tidak hanya bias, tetapi bahwa tidak ada cara untuk mendeteksi biasnya, dan bahwa pembelajaran mesin berbeda dari bentuk otomatisasi lainnya, yang seharusnya terdiri dari langkah-langkah logis yang jelas yang dapat diperiksa.

Ada dua masalah di sini. Meskipun demikian, kami dapat melakukan audit sistem pembelajaran mesin. Dan audit dari sistem lain sebenarnya sama sekali tidak mudah.

Pertama, salah satu bidang penelitian modern di bidang pembelajaran mesin adalah pencarian metode tentang cara mengidentifikasi fungsi penting dari sistem pembelajaran mesin. Pada saat yang sama, pembelajaran mesin (dalam keadaan saat ini) adalah bidang ilmu yang benar-benar baru yang berubah dengan cepat, jadi Anda tidak boleh berpikir bahwa hal-hal yang mustahil hari ini tidak dapat segera menjadi sangat nyata. Proyek OpenAI adalah contoh yang menarik dari ini.

Kedua, gagasan bahwa mungkin untuk memeriksa dan memahami proses pengambilan keputusan dalam sistem atau organisasi yang ada adalah baik secara teori, tetapi dalam praktiknya begitu-begitu. Memahami bagaimana keputusan dibuat dalam organisasi besar jauh dari mudah. Bahkan jika ada proses pengambilan keputusan formal di sana, itu tidak mencerminkan bagaimana orang benar-benar berinteraksi, dan memang mereka sering tidak memiliki pendekatan sistematis yang logis untuk membuat keputusan mereka. Seperti yang dikatakan kolega saya Vijay Pande , orang juga kotak hitam .

Ambil seribu orang di beberapa perusahaan dan institusi yang tumpang tindih, dan masalahnya akan menjadi lebih rumit. Kita tahu setelah fakta bahwa pesawat ulang alik ditakdirkan hancur ketika mereka kembali, dan beberapa orang di dalam NASA memiliki informasi yang memberi mereka alasan untuk berpikir bahwa sesuatu yang buruk dapat terjadi, tetapi sistem secara keseluruhan tidak tahu. NASA bahkan baru saja lulus audit serupa, setelah kehilangan pesawat ulang-alik sebelumnya, namun kehilangan satu lagi - untuk alasan yang sangat mirip. Mudah untuk mengatakan bahwa organisasi dan orang-orang mengikuti aturan logis yang jelas yang dapat diperiksa, dipahami, dan diubah - tetapi pengalaman membuktikan sebaliknya. Ini adalah " kesalahan Komisi Perencanaan Negara ."

Saya sering membandingkan pembelajaran mesin dengan basis data, terutama relasional - sebuah teknologi fundamental baru yang telah mengubah kemampuan ilmu komputer dan dunia di sekitarnya, yang telah menjadi bagian dari segala hal yang terus-menerus kami gunakan tanpa disadari. Basis data juga memiliki masalah, dan mereka memiliki properti yang serupa: sistem dapat dibangun berdasarkan asumsi yang salah atau pada data yang buruk, tetapi akan sulit untuk diperhatikan, dan orang yang menggunakan sistem akan melakukan apa yang dikatakannya kepada mereka tanpa mengajukan pertanyaan. Ada banyak lelucon lama tentang petugas pajak yang pernah salah mengeja nama Anda, dan meyakinkan mereka untuk memperbaiki kesalahan itu jauh lebih sulit daripada benar-benar mengubah nama. Ini dapat dipikirkan dengan cara yang berbeda, tetapi tidak jelas bagaimana yang terbaik: bagaimana dengan masalah teknis dalam SQL, atau tentang kesalahan dalam rilis Oracle, atau tentang kegagalan lembaga birokrasi? Seberapa sulitkah untuk menemukan kesalahan dalam proses yang mengarah pada fakta bahwa sistem tidak memiliki fitur seperti koreksi kesalahan ketik? Mungkinkah ini dipahami sebelum orang mulai mengeluh?

Yang lebih mudah adalah masalah ini diilustrasikan oleh cerita ketika pengemudi, karena data yang ketinggalan zaman di navigator, pergi ke sungai. Ok, peta harus terus diperbarui. Tetapi berapa banyak TomTom yang bisa disalahkan atas fakta bahwa mobil Anda berhembus ke laut?

Saya mengatakan ini pada kenyataan bahwa ya - bias pembelajaran mesin akan menciptakan masalah. Tetapi masalah-masalah ini akan mirip dengan yang kita temui di masa lalu, dan mereka dapat diperhatikan dan dipecahkan (atau tidak) kira-kira sama seperti yang kita lakukan di masa lalu. Akibatnya, skenario di mana bias AI akan merugikan tidak mungkin terjadi pada peneliti terkemuka yang bekerja di sebuah organisasi besar. , - - , , . “ ” , , , , . . , . .

Kesimpulan

, , — , .

, « » . , — . HAL9000 Skynet — -, . Tapi tidak. , , , . , , … . . , , , - . , — , , .

, — , — . , , .

, , « — , » . , « ». , , , . , . , — , , , . , , .

: .

: .

: @PonchikNews .