Istilah Big Data dimanjakan oleh modern berlebihan berlebihan hal-hal baru. Ketika AI memperbudak orang dan blockchain membangun ekonomi yang ideal - begitu banyak data akan membuat Anda mengetahui segalanya tentang semua orang dan melihat masa depan.

Tetapi kenyataan, seperti biasa, lebih membosankan dan pragmatis. Tidak ada keajaiban dalam data besar - seperti tidak ada tempat - hanya ada begitu banyak informasi dan koneksi antara data yang berbeda sehingga terlalu lama untuk memproses dan menganalisis semuanya dengan cara lama.

Metode baru sedang muncul. Profesi baru ada bersama mereka. Dekan

departemen analitik Big Data di GeekBrains, Sergey Shirkin mengatakan kepada profesi apa mereka, di mana mereka dibutuhkan, apa yang perlu mereka lakukan dan apa yang harus mereka lakukan. Alat apa yang digunakan dan berapa biasanya mereka membayar kepada spesialis.

Apa itu Big Data?

Pertanyaan "apa yang memanggil data besar" agak membingungkan. Bahkan dalam jurnal ilmiah, deskripsi berbeda. Di suatu tempat, jutaan pengamatan dianggap sebagai data "biasa", dan di tempat lain ratusan ribu disebut besar, karena masing-masing pengamatan memiliki seribu tanda. Oleh karena itu, mereka memutuskan untuk membagi data menjadi tiga bagian - kecil, sedang dan besar - menurut prinsip paling sederhana: volume yang mereka tempati.

Data kecil beberapa gigabytes. Medium - segalanya tentang satu terabyte. Data besar adalah tentang petabyte. Tapi ini tidak menghilangkan kebingungan. Oleh karena itu, kriterianya bahkan lebih sederhana: semua yang tidak sesuai pada server yang sama adalah data besar.

Data kecil, sedang, dan besar memiliki prinsip operasi yang berbeda. Data besar biasanya disimpan dalam cluster di beberapa server sekaligus. Karena itu, bahkan tindakan sederhana pun lebih rumit.

Misalnya, tugas sederhana adalah menemukan nilai rata-rata suatu kuantitas. Jika ini adalah data kecil, kami cukup menjumlahkan dan membagi berdasarkan kuantitas. Dan dalam data besar kami tidak dapat mengumpulkan semua informasi dari semua server sekaligus. Ini rumit. Seringkali, Anda tidak perlu menarik data ke diri Anda sendiri, tetapi mengirim program terpisah ke setiap server. Setelah pekerjaan program ini, hasil antara terbentuk, dan nilai rata-rata ditentukan oleh mereka.

Sergey Shirkin

Sergey ShirkinApa perusahaan data besar

Yang pertama dengan data besar mulai bekerja operator seluler dan mesin pencari. Mesin pencari menjadi semakin banyak pertanyaan, dan teks lebih berat daripada angka. Bekerja dengan paragraf teks membutuhkan waktu lebih lama daripada dengan transaksi keuangan. Pengguna mengharapkan mesin pencari untuk menyelesaikan permintaan dalam sepersekian detik - itu tidak dapat diterima untuk bekerja bahkan selama setengah menit. Oleh karena itu, mesin pencari pertama kali mulai bekerja dengan paralelisasi ketika bekerja dengan data.

Beberapa saat kemudian, berbagai organisasi keuangan dan ritel bergabung. Transaksi itu sendiri tidak begitu banyak, tetapi data besar muncul karena fakta bahwa ada banyak transaksi.

Jumlah data bertambah sama sekali. Misalnya, bank memiliki banyak data sebelumnya, tetapi mereka tidak selalu membutuhkan prinsip kerja, seperti halnya yang besar. Kemudian bank mulai bekerja lebih banyak dengan data pelanggan. Mereka mulai menghasilkan deposito yang lebih fleksibel, pinjaman, tarif yang berbeda, dan mereka mulai menganalisis transaksi lebih dekat. Ini sudah membutuhkan cara cepat untuk bekerja.

Sekarang bank ingin menganalisis tidak hanya informasi internal, tetapi juga informasi eksternal. Mereka ingin menerima data dari ritel yang sama, mereka ingin tahu apa yang dihabiskan seseorang. Berdasarkan informasi ini, mereka mencoba membuat penawaran komersial.

Sekarang semua informasi terhubung satu sama lain. Ritel, bank, operator telekomunikasi, dan bahkan mesin pencari - semua orang sekarang tertarik pada data masing-masing.

Seharusnya Seorang Spesialis Data Besar

Karena data terletak pada sekelompok server, infrastruktur yang lebih kompleks digunakan untuk bekerja dengannya. Ini menempatkan beban besar pada orang yang bekerja dengannya - sistemnya harus sangat andal.

Membuat satu server dapat diandalkan itu mudah. Tetapi ketika ada beberapa dari mereka, probabilitas jatuh meningkat sebanding dengan jumlah, dan tanggung jawab insinyur data yang bekerja dengan data ini juga tumbuh.

Analis harus memahami bahwa ia selalu dapat menerima data yang tidak lengkap atau bahkan salah. Dia menulis program, percaya pada hasilnya, dan kemudian menemukan bahwa karena jatuhnya satu server dari seribu, bagian dari data terputus, dan semua kesimpulan salah.

Ambil, misalnya, pencarian teks. Katakanlah semua kata disusun dalam urutan abjad pada beberapa server (jika kita berbicara dengan sangat sederhana dan kondisional). Dan salah satu dari mereka terputus, semua kata dalam huruf "K" menghilang. Pencarian berhenti memberi kata "Bioskop". Semua berita berita menghilang, dan analis membuat kesimpulan yang salah bahwa orang tidak lagi tertarik dengan bioskop.

Oleh karena itu, seorang spesialis dalam data besar harus mengetahui prinsip-prinsip pekerjaan dari tingkat terendah - server, ekosistem, perencana tugas - hingga program tingkat tertinggi - perpustakaan pembelajaran mesin, analisis statistik, dan banyak lagi. Dia harus memahami prinsip-prinsip besi, peralatan komputer, dan segala sesuatu yang dikonfigurasikan di atasnya.

Selebihnya, Anda harus mengetahui semuanya sama seperti ketika bekerja dengan data kecil. Kita membutuhkan matematika, kita harus dapat memprogram, dan kita tahu betul algoritma komputasi terdistribusi, untuk dapat menerapkannya pada prinsip-prinsip biasa bekerja dengan data dan pembelajaran mesin.

Alat apa yang digunakan

Karena data disimpan di cluster, infrastruktur khusus diperlukan untuk bekerja dengannya. Ekosistem yang paling populer adalah Hadoop. Banyak sistem yang berbeda dapat bekerja di dalamnya: perpustakaan khusus, perencana, alat untuk pembelajaran mesin, dan banyak lagi. Tetapi pertama-tama, sistem ini diperlukan untuk mengatasi sejumlah besar data karena komputasi terdistribusi.

Sebagai contoh, kami mencari tweet paling populer di antara data yang rusak di seribu server. Di satu server, kami hanya akan membuat tabel dan hanya itu. Di sini kita bisa menyeret semua data ke diri kita sendiri dan menceritakannya kembali. Tetapi ini tidak benar, karena untuk waktu yang sangat lama.

Oleh karena itu, ada Hadoop dengan paradigma Map Reduce dan kerangka kerja Spark. Alih-alih menarik data ke diri mereka sendiri, mereka mengirim bagian program ke data ini. Pekerjaan berjalan paralel, dalam ribuan utas. Kemudian kami mendapatkan pilihan dari ribuan server berdasarkan di mana Anda dapat memilih tweet paling populer.

Mengurangi Peta adalah paradigma lama, Spark lebih baru. Dengan bantuannya, data diekstraksi dari cluster, dan model pembelajaran mesin dibangun di dalamnya.

Profesi apa yang ada di bidang big data

Dua profesi utama adalah analis dan insinyur data.

Analis utamanya bekerja dengan informasi. Dia tertarik pada data tabular, dia terlibat dalam model. Tanggung jawabnya meliputi agregasi, pemurnian, penambahan, dan visualisasi data. Artinya, analis adalah penghubung antara informasi mentah dan bisnis.

Analis memiliki dua bidang kerja utama. Pertama, ia dapat mengubah informasi yang diterima, menarik kesimpulan, dan menyajikannya dengan cara yang dapat dimengerti.

Yang kedua adalah analis mengembangkan aplikasi yang akan bekerja dan menghasilkan hasilnya secara otomatis. Misalnya, buat ramalan di pasar sekuritas setiap hari.

Insinyur data adalah spesialisasi tingkat bawah. Ini adalah orang yang harus memastikan penyimpanan, pemrosesan, dan pengiriman informasi kepada analis. Tetapi di mana ada persediaan dan pembersihan - tanggung jawab mereka mungkin tumpang tindih.

Insinyur data mendapatkan semua kerja keras. Jika sistem gagal, atau salah satu server menghilang dari cluster, itu terhubung. Ini adalah pekerjaan yang sangat bertanggung jawab dan penuh tekanan. Sistem dapat dimatikan pada akhir pekan dan setelah jam kerja, dan insinyur harus mengambil tindakan segera.

Ini adalah dua profesi utama, tetapi ada yang lain. Mereka muncul ketika algoritma komputasi paralel ditambahkan ke tugas yang berkaitan dengan kecerdasan buatan. Misalnya, seorang insinyur NLP. Ini adalah seorang programmer yang terlibat dalam pemrosesan bahasa alami, terutama dalam kasus-kasus di mana Anda tidak hanya perlu menemukan kata-kata, tetapi untuk memahami makna teks. Insinyur semacam itu menulis program untuk chatbot dan sistem percakapan, asisten suara dan pusat panggilan otomatis.

Ada situasi di mana perlu untuk mengklasifikasikan miliaran gambar, membuat moderasi, menyaring kelebihan dan menemukan yang serupa. Profesi ini tumpang tindih dengan visi komputer.

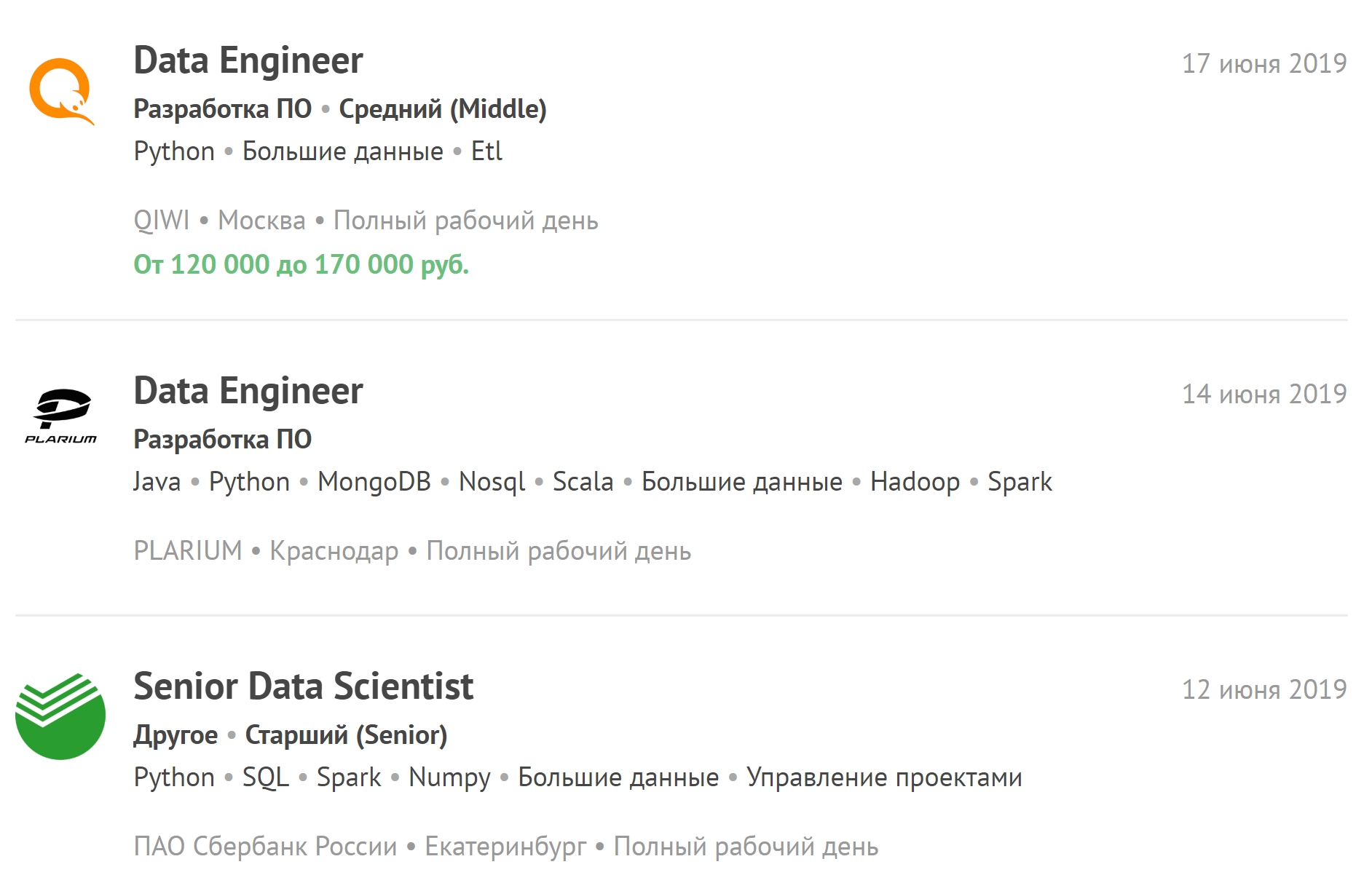

Anda dapat melihat lowongan terbaru terkait data besar dan berlangganan lowongan baru.

Berapa lama pelatihan berlangsung?

Kami telah belajar selama satu setengah tahun. Mereka dibagi menjadi enam bagian. Dalam beberapa, ada penekanan pada pemrograman, yang lain - bekerja dengan database, dan ketiga - pada matematika.

Sebaliknya, misalnya, dari fakultas AI, ada sedikit matematika. Tidak ada penekanan kuat pada analisis matematika dan aljabar linier. Pengetahuan tentang algoritma komputasi terdistribusi lebih dibutuhkan daripada prinsip matanalisis.

Tetapi satu setengah tahun sudah cukup untuk pekerjaan nyata dengan data besar hanya jika orang tersebut memiliki pengalaman dengan data biasa dan secara umum di bidang TI. Siswa yang tersisa setelah lulus disarankan untuk bekerja dengan data kecil dan menengah. Hanya setelah ini spesialis dapat diizinkan untuk bekerja dengan yang besar. Setelah pelatihan, Anda harus bekerja sebagai ilmuwan data - menerapkan pembelajaran mesin pada jumlah data yang berbeda.

Ketika seseorang mendapatkan pekerjaan di perusahaan besar - bahkan jika dia memiliki pengalaman - paling sering dia tidak akan diizinkan untuk pergi ke data besar segera, karena harga kesalahan di sana jauh lebih tinggi. Kesalahan dalam algoritma mungkin tidak terdeteksi dengan segera, dan ini akan menyebabkan kerugian besar.

Gaji apa yang dianggap memadai untuk spesialis pada data besar

Sekarang ada kekurangan personil yang sangat besar di antara para insinyur data. Pekerjaan itu sulit, banyak tanggung jawab jatuh pada seseorang, banyak stres. Karena itu, seorang spesialis dengan pengalaman rata-rata menerima sekitar dua ratus ribu. Junior - dari seratus hingga dua ratus.

Seorang analis data mungkin memiliki gaji awal yang sedikit lebih rendah. Tetapi tidak ada pekerjaan yang melebihi waktu kerja, dan dia tidak akan dipanggil selama jam non-kerja karena kasus darurat.

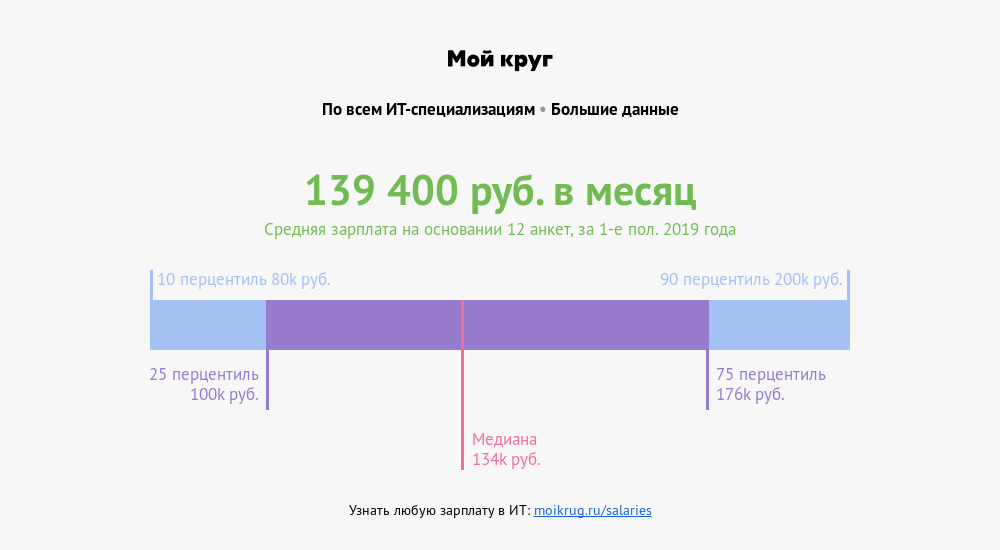

Menurut penggarap gaji "Lingkaran Saya", gaji rata-rata spesialis yang profesinya terkait dengan data besar adalah 139.400 rubel . Seperempat spesialis menghasilkan lebih dari 176.000 rubel. Sepersepuluh - lebih dari 200.000 rubel.

Bagaimana mempersiapkan wawancara

Tidak perlu mempelajari satu subjek saja. Pada wawancara mereka mengajukan pertanyaan tentang statistik, pembelajaran mesin, pemrograman. Mereka mungkin bertanya tentang struktur data, algoritma, dan kasus dari kehidupan nyata: server macet, kecelakaan terjadi - bagaimana cara memperbaikinya? Mungkin ada pertanyaan tentang bidang subjek - sesuatu yang lebih dekat dengan bisnis.

Dan jika seseorang terlalu jauh ke dalam satu matematika, dan selama wawancara tidak melakukan tugas pemrograman yang sederhana, maka kemungkinan menemukan pekerjaan berkurang. Lebih baik memiliki level rata-rata di setiap arah daripada menunjukkan diri Anda dengan baik di satu arah, dan gagal sepenuhnya di yang lain.

Ada daftar pertanyaan yang diajukan pada 80 persen wawancara. Jika ini adalah pembelajaran mesin, mereka pasti akan bertanya tentang gradient descent. Jika statistik - Anda perlu berbicara tentang uji korelasi dan hipotesis. Pemrograman cenderung memberikan tugas kecil dengan kompleksitas sedang. Dan Anda dapat dengan mudah mendapatkan tugas - cukup selesaikan saja.

Di mana mendapatkan pengalaman sendiri

Python dapat ditarik dari

Pitontutyu , bekerja dengan database - di

SQL-EX . Ada tugas-tugas tertentu yang dalam praktiknya mereka pelajari untuk membuat permintaan.

Matematika Tinggi -

Mathprofi . Di sana Anda dapat memperoleh informasi yang jelas tentang analisis matematika, statistik, dan aljabar linier. Dan jika itu buruk dengan kurikulum sekolah, yaitu,

youclever.org .

Komputasi terdistribusi hanya akan berhasil dalam praktek. Pertama, ini membutuhkan infrastruktur, dan kedua, algoritma dapat dengan cepat menjadi usang. Sekarang sesuatu yang baru terus muncul.

Kecenderungan apa yang didiskusikan oleh komunitas

Area lain secara bertahap mendapatkan kekuatan, yang dapat menyebabkan peningkatan cepat dalam jumlah data - Internet of Things (IoT). Data jenis ini berasal dari sensor perangkat yang terhubung dalam jaringan, dan jumlah sensor pada awal dekade berikutnya harus mencapai puluhan miliar.

Perangkatnya sangat berbeda - dari peralatan rumah tangga hingga kendaraan dan mesin industri, arus informasi yang terus menerus yang membutuhkan infrastruktur tambahan dan sejumlah besar spesialis yang berkualifikasi tinggi. Ini berarti bahwa dalam waktu dekat akan ada kekurangan akut insinyur data dan analis data besar.