Kelompok riset Microsoft Research memperkenalkan jaringan saraf kompetitif generatif yang mampu menghasilkan gambar dengan banyak objek berdasarkan deskripsi tekstual. Tidak seperti algoritma teks-ke-gambar serupa sebelumnya yang mampu mereproduksi gambar hanya objek dasar, jaringan saraf ini dapat mengatasi deskripsi kompleks lebih efisien.

Kompleksitas membuat algoritma seperti itu adalah, pertama, bot sebelumnya tidak dapat membuat ulang semua objek dasar dengan kualitas yang baik sesuai dengan deskripsi mereka, dan kedua, itu tidak dapat menganalisis bagaimana beberapa objek dapat saling berhubungan satu sama lain di dalam satu komposisi. Misalnya, untuk membuat gambar sesuai dengan deskripsi "Seorang wanita di helm duduk di atas kuda", jaringan saraf harus secara semantik "memahami" bagaimana masing-masing benda saling berhubungan. Kami berhasil memecahkan masalah ini dengan melatih jaringan saraf berdasarkan set data terbuka COCO yang berisi markup dan segmentasi data untuk lebih dari 1,5 juta objek.

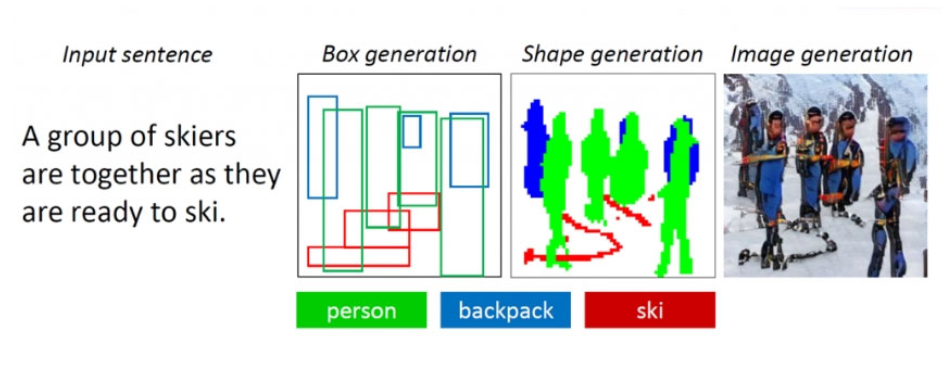

Algoritma ini didasarkan pada jaringan saraf generatif-kompetitif berorientasi objek ObjGAN (Object-driven Attentive Generative Adversarial Newtorks). Dia menganalisis teks, mengekstraksi dari itu kata-kata objek yang perlu ditempatkan pada gambar. Tidak seperti jaringan generatif-permusuhan konvensional yang terdiri dari satu generator yang menciptakan gambar dan satu diskriminator yang mengevaluasi kualitas gambar yang dihasilkan, ObjGAN mengandung dua diskriminator berbeda. Seseorang menganalisis seberapa realistis setiap objek yang direproduksi dan seberapa cocok dengan deskripsi yang ada. Yang kedua menentukan seberapa realistis keseluruhan komposisi dan berhubungan dengan teks.

Pendahulu algoritma ObjGAN adalah AttnGAN, yang juga dikembangkan oleh para peneliti Microsoft. Ia mampu menghasilkan gambar objek dari deskripsi tekstual yang lebih sederhana. Teknologi untuk mengonversi teks menjadi gambar dapat digunakan untuk membantu perancang dan seniman membuat sketsa.

Algoritma ObjGAN tersedia untuk umum di GitHub.

Lebih detail teknis.