Di bawah kucing tentang pendekatan apa yang ditawarkan Huawei ketika mengatur akses memori langsung jarak jauh menggunakan teknologi AI Fabric dan bagaimana ia berbeda dari InfiniBand dan RDMA murni berbasis Ethernet.

Komputasi terdistribusi digunakan dalam berbagai industri. Ini adalah penelitian ilmiah, dan perkembangan teknis seperti pengenalan wajah atau alat pengenalan autopilot, dan industri. Secara umum, analisis data menemukan semakin banyak aplikasi, dan kita dapat mengatakan dengan yakin bahwa dalam waktu dekat ini tidak akan kehilangan popularitas. Faktanya, sekarang kita mengalami transisi dari era cloud computing, di mana faktor yang paling penting adalah aplikasi dan kecepatan penyebaran layanan, ke era monetisasi data, termasuk melalui penggunaan algoritma kecerdasan buatan. Menurut data internal kami (laporan

GIV 2025: Unfolding the Industrial Blueprint of an Intelligent World ), pada tahun 2025, 86% perusahaan akan menggunakan AI dalam pekerjaan mereka. Banyak dari mereka menganggap area ini sebagai utama untuk modernisasi kegiatan dan, mungkin, alat dasar untuk membuat keputusan bisnis di masa depan. Dan ini berarti bahwa masing-masing perusahaan ini akan memerlukan semacam pemrosesan data mentah - kemungkinan besar melalui cluster terdistribusi.

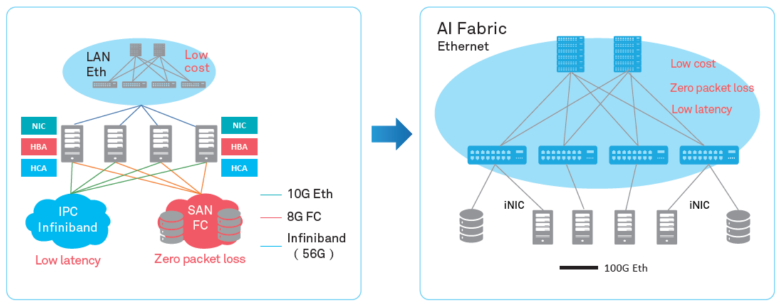

Evolusi arsitektur

Dengan semakin populernya komputasi terdistribusi, volume lalu lintas yang dipertukarkan antara mesin pusat data individu meningkat. Secara tradisional, ketika membahas jaringan, perhatian difokuskan pada pertumbuhan lalu lintas antara pusat data dan pengguna akhir di Internet, dan itu benar-benar berkembang. Tetapi peningkatan lalu lintas horisontal dalam sistem terdistribusi jauh melebihi semua yang dihasilkan pengguna. Menurut Facebook, lalu lintas antara sistem internal mereka berlipat ganda dalam waktu kurang dari setahun.

Dalam upaya untuk mengatasi lalu lintas ini, Anda dapat meningkatkan cluster, tetapi Anda tidak dapat melakukan ini tanpa batas. Oleh karena itu, memprediksi pertumbuhan beban komputasi pada cluster, perlu untuk meningkatkan efisiensi pemrosesan - pertama-tama, untuk menemukan dan menghilangkan hambatan di dalam jaringan terdistribusi ini.

Jika sebelumnya "rantai lemah" dari sistem terdistribusi adalah sumber daya dari masing-masing sistem secara terpisah, sementara terus-menerus mengembangkan jaringan transmisi data bahkan melampaui kebutuhan, hari ini adalah komunikasi jaringan yang merupakan sumber utama masalah. Susunan protokol TCP / IP dan topologi tree yang sudah dikenal tidak lagi sesuai dengan tugas yang diberikan. Oleh karena itu, semakin banyak pusat data meninggalkan yang terpusat dan pindah ke arsitektur CLOS baru yang menyediakan bandwidth yang lebih besar dan skalabilitas klaster yang lebih baik, seperti, misalnya, yang dilakukan Facebook beberapa tahun lalu.

Pada saat yang sama, perlu untuk mengoptimalkan proses pada tingkat yang berbeda - pada tingkat interaksi dua sistem yang terpisah. Pada artikel ini, kami ingin berbicara tentang alat pengoptimalan apa yang disediakan oleh pusat data Huawei Ai Fabric. Ini adalah teknologi milik kami yang mempercepat pertukaran data antar node.

Perubahan Jaringan

"Trik" utama dari Huawei Ai Fabric adalah untuk mengurangi overhead ketika mentransfer paket data antar sistem dalam cluster dengan mengimplementasikan RDMA (Remote Direct Memory Access) - akses langsung ke memori sistem dalam cluster.

RDMA - cara untuk mengurangi penundaan transmisi

RDMA bukan ide baru. Teknologi ini menyediakan pertukaran data langsung antara memori dan antarmuka jaringan, mengurangi latensi dan menghilangkan penyalinan data yang tidak perlu ke buffer. Akarnya kembali ke tahun 1990-an oleh Compaq, Intel dan Microsoft.

Ada tiga jenis keterlambatan pengiriman paket dari satu sistem ke sistem lain:

- karena pemrosesan prosesor diperlukan, misalnya, untuk buffering data di OS dan menghitung jumlah cek;

- karena bus dan saluran transmisi data (secara teknis tidak mungkin untuk meningkatkan bandwidth secara signifikan);

- karena peralatan jaringan.

Untuk mengurangi kerugian di seluruh rantai ini, pada awal 1990-an, diusulkan untuk menggunakan akses langsung ke memori sistem yang berinteraksi - model abstrak Arsitektur Antarmuka Virtual. Gagasan utamanya adalah bahwa aplikasi yang berjalan pada dua sistem yang berinteraksi sepenuhnya mengisi memori lokal mereka dan membangun koneksi P2P untuk transfer data tanpa mempengaruhi OS. Dengan cara ini, penundaan pengiriman paket dapat dikurangi secara signifikan. Selain itu, karena model VIA tidak menyiratkan menempatkan data yang ditransmisikan dalam buffer perantara, itu menghemat sumber daya yang diperlukan untuk operasi penyalinan.

Mengenai model abstrak, VIA RDMA, sebagai teknologi, telah melangkah lebih jauh menuju pemanfaatan sumber daya yang optimal. Secara khusus, itu tidak menunggu buffer diisi untuk membuat koneksi dan memungkinkan koneksi ke beberapa komputer secara bersamaan. Karena itu, teknologi ini dapat mengurangi penundaan transmisi hingga 1 ms, mengurangi beban pada prosesor.

InfiniBand vs Ethernet

Dua implementasi RDMA utama di pasar - protokol transport InfiniBand dan RDMA "murni" berbasis Ethernet, sayangnya bukan tanpa kekurangan.

Protokol transport InfiniBand memiliki mekanisme kontrol pengiriman paket bawaan (perlindungan kehilangan data), tetapi didukung oleh peralatan khusus dan tidak kompatibel dengan Ethernet. Bahkan, penggunaan protokol ini menutup pusat data di satu pemasok peralatan, yang membawa risiko dan kesulitan tertentu dalam hal layanan (karena InfiniBand memiliki pangsa pasar yang kecil, tidak akan mudah menemukan spesialis). Yah, tentu saja, ketika mengimplementasikan protokol, Anda tidak dapat menggunakan peralatan jaringan IP yang ada.

RDMA melalui Ethernet memungkinkan Anda untuk menggunakan peralatan yang ada di jaringan, mendukung jaringan Ethernet, yang berarti akan lebih mudah untuk menemukan spesialis layanan. Dibandingkan dengan Infiniband, ini secara signifikan mengurangi biaya kepemilikan infrastruktur dan menyederhanakan penyebarannya.

Satu-satunya kelemahan serius yang mencegah adopsi RDMA melalui Ethernet secara luas adalah kurangnya perlindungan terhadap kehilangan paket, yang membatasi bandwidth seluruh jaringan. Mekanisme pihak ketiga harus digunakan untuk mengurangi kehilangan paket atau mencegah kemacetan jaringan. Kami bertindak seperti ini, menawarkan algoritma cerdas kami sendiri untuk mengkompensasi kelemahan RDMA melalui Ethernet sambil tetap mempertahankan keunggulannya dalam alat baru - Huawei Ai Fabric.

Huawei AI Fabric - caranya

AI Fabric mengimplementasikan RDMA melalui Ethernet, dilengkapi dengan algoritme manajemen kongesti jaringan cerdasnya sendiri, yang memberikan nol paket loss, bandwidth jaringan tinggi, dan delay transmisi rendah untuk stream RDMA.

Huawei Ai Fabric dibangun berdasarkan standar terbuka dan mendukung berbagai peralatan yang berbeda, yang mengoptimalkan proses implementasi. Namun, beberapa alat tambahan - tambahan atas standar terbuka, memungkinkan untuk meningkatkan efisiensi pertukaran data, yang akan kita bahas dalam publikasi berikutnya - hanya tersedia untuk perangkat yang diproduksi oleh Huawei. Switch seri CloudEngine yang mendukung solusi memiliki chip terintegrasi yang menganalisis karakteristik lalu lintas dan secara dinamis menyesuaikan parameter jaringan, yang memungkinkan penggunaan buffer switch secara lebih efisien. Karakteristik yang dikumpulkan juga digunakan untuk memprediksi pola lalu lintas masa depan.

Untuk siapa ini berguna?

Huawei Ai Fabric memungkinkan Anda mendapatkan keuntungan di dua level.

Di satu sisi, solusi ini memungkinkan pengoptimalan arsitektur pusat data - mengurangi jumlah node (karena pemanfaatan sumber daya yang lebih optimal), menciptakan lingkungan konvergen tanpa pemisahan tradisional menjadi subnet yang terpisah, yang sulit dan mahal untuk dipertahankan di bagian-bagiannya. Dengan menggunakan alat ini, Anda tidak harus memilih subnet terpisah untuk setiap jenis layanan di pengontrol domain (dengan persyaratan jaringannya sendiri). Anda dapat membuat lingkungan tunggal yang menyediakan semua layanan.

Di sisi lain, AI Fabric memungkinkan Anda untuk meningkatkan kecepatan komputasi terdistribusi, terutama di mana Anda sering perlu mengakses memori sistem jarak jauh. Misalnya, pengenalan AI di bidang apa pun menyiratkan periode belajar algoritma, yang dapat mencakup jutaan operasi, sehingga keuntungan keterlambatan pada setiap operasi tersebut akan menghasilkan percepatan proses yang serius.

Efek dari memperkenalkan alat khusus, seperti Huawei Ai Fabric, akan terlihat di pusat data dengan enam atau lebih sakelar. Tetapi semakin besar pusat data, semakin tinggi laba - karena pemanfaatan sumber daya yang optimal, kelompok dengan skala yang sama dengan Ai Fabric akan memberikan kinerja yang lebih tinggi. Sebagai contoh, sebuah cluster 384 node dapat mencapai kinerja cluster "reguler" dari 512 node. Selain itu, solusinya tidak memiliki batasan pada jumlah saklar fisik dalam infrastruktur. Mungkin ada puluhan ribu (jika Anda lupa bahwa proyek biasanya terbatas pada ukuran domain administratif).