Hari ini, Google mengumumkan

draft RFC standar Protokol Pengecualian Robot (REP) , secara bersamaan membuat parser file robots.txt tersedia di bawah Lisensi Apache 2.0. Sampai hari ini, tidak ada standar resmi untuk Protokol Pengecualian Robot (REP) dan robots.txt (ini yang paling dekat dengannya), yang memungkinkan pengembang dan pengguna untuk menafsirkannya dengan cara mereka sendiri. Inisiatif perusahaan bertujuan untuk mengurangi perbedaan antara implementasi.

Draf standar baru dapat dilihat

di situs web IETF , dan repositori tersedia di Github di

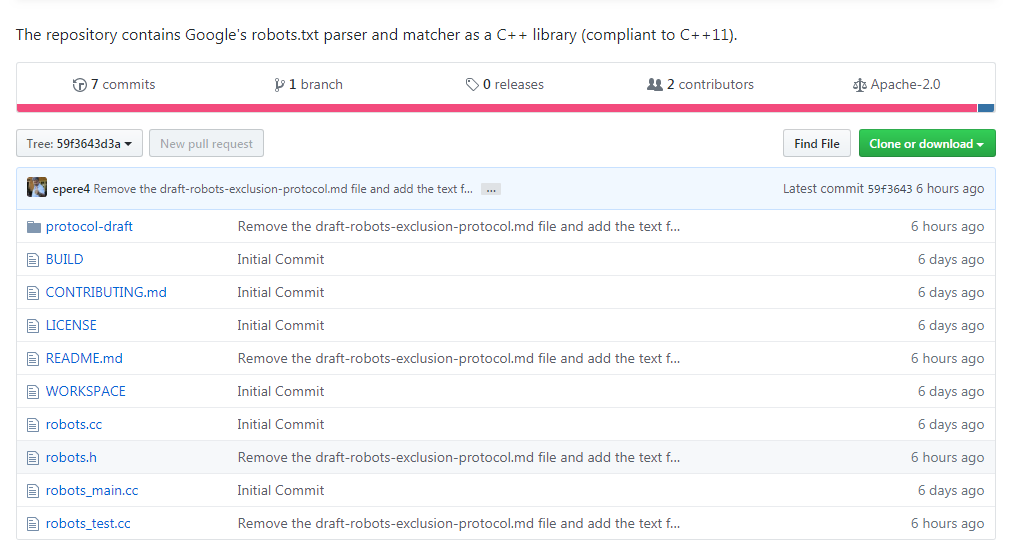

https://github.com/google/robotstxt .

Parser adalah kode sumber yang digunakan Google sebagai bagian dari sistem produksinya (dengan pengecualian suntingan kecil - seperti file header yang dihapus yang hanya digunakan dalam perusahaan) - file robots.txt diuraikan persis seperti yang Googlebot lakukan (termasuk bagaimana dia memperlakukan karakter Unicode dalam pola). Parser ditulis dalam C ++ dan pada dasarnya terdiri dari dua file - Anda memerlukan kompiler yang kompatibel dengan C ++ 11, meskipun kode perpustakaan tanggal kembali ke 90-an, dan Anda akan menemukan pointer "mentah" dan

strbrk di dalamnya . Untuk merakitnya, disarankan untuk menggunakan

Bazel (dukungan CMake direncanakan dalam waktu dekat).

Ide robots.txt dan standar milik Martine Coster, yang menciptakannya pada tahun 1994 -

menurut legenda , alasannya adalah laba-laba pencarian Charles Strauss, yang “menjatuhkan” server api unggun menggunakan serangan DoS. Idenya diambil oleh orang lain dan dengan cepat menjadi standar de facto bagi mereka yang terlibat dalam pengembangan mesin pencari. Mereka yang ingin melakukan parsing kadang-kadang harus membalikkan Googlebot, termasuk Blekko, yang menulis

parser sendiri untuk Perl untuk mesin pencariannya.

Pengurai bukan tanpa saat-saat yang menyenangkan: lihatlah, misalnya,

berapa banyak pekerjaan yang harus diproses .