Salah satu peristiwa utama di bidang linguistik komputer dan pembelajaran mesin pada tahun 2018 adalah

rilis BERT dari Google AI, yang diakui sebagai laporan terbaik tahun ini menurut cabang Amerika Utara dari Association of Computer Linguistics (NACL). Pada artikel ini kita akan berbicara tentang model bahasa ini dan kemampuannya.

Bagi mereka yang belum pernah mendengar, BERT adalah jaringan saraf berdasarkan metode persiapan awal representasi kontekstual kata, yaitu, menggunakan model bahasa dua arah, dan juga memungkinkan Anda untuk menganalisis seluruh kalimat. Dalam hal ini, kata-kata yang datang setelah diberikan dan melalui juga diperhitungkan. Metode ini memungkinkan untuk mendapatkan hasil dengan margin yang canggih dalam berbagai tugas pemrosesan bahasa alami (NLP), tetapi membutuhkan daya komputasi yang besar.

Dari pidato formal hingga percakapan

BERT awalnya diajarkan dalam 104 bahasa Wikipedia (Multilingual). Selain versi multibahasa, Google telah merilis BERT berdasarkan Wikipedia bahasa Inggris dan BERT dalam bahasa Cina.

Dalam sistem saraf dan laboratorium pembelajaran dalam, kami menggunakan BERT untuk meningkatkan komponen NLP DeepPavlov, perpustakaan interaktif open source untuk mengembangkan asisten interaktif virtual dan analisis teks berdasarkan TensorFlow dan Keras. Kami melatih model BERT di Wikipedia Rusia - RuBERT, secara signifikan meningkatkan kualitas model Rusia. Selain itu, mereka mengintegrasikan BERT ke dalam solusi untuk tiga tugas NLP yang populer: klasifikasi teks, penandaan urutan, dan jawaban atas pertanyaan. Anda dapat membaca lebih lanjut tentang model BERT DeepPavlov di publikasi terbaru blog kami:

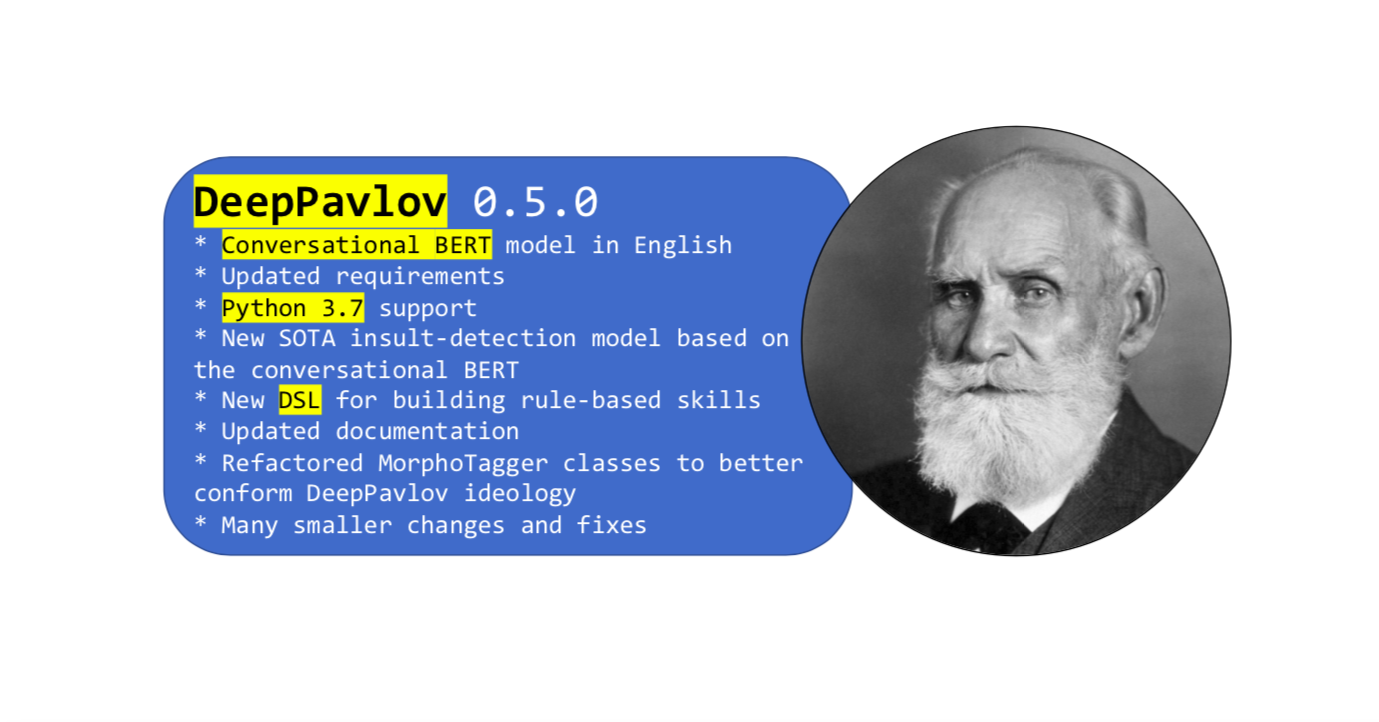

Baru-baru ini, rilis baru perpustakaan

Fitur utama dari pembaruan ini adalah BERT, yang terlatih dalam kosa kata jejaring sosial dalam bahasa Inggris. Bahasa formal Wikipedia berbeda dari bahasa sehari-hari, sementara untuk menyelesaikan beberapa masalah, Anda hanya perlu memilikinya.

Spoken BERT dilatih dalam Bahasa Inggris menggunakan data terbuka dari Twitter, Reddit, DailyDialogues, OpenSubtitles, debat, blog, dan komentar berita Facebook. Data ini digunakan untuk membangun kosakata subtugas bahasa Inggris ke dalam BERT versi bahasa Inggris sebagai inisialisasi untuk BERT yang dapat berbahasa Inggris. Akibatnya, BERT yang diucapkan menunjukkan hasil canggih dalam tugas yang menampilkan data sosial.

Cara menggunakan Conversational BERT di DeepPavlov

Anda dapat menggunakan model

deteksi Penghinaan baru berdasarkan BERT yang diucapkan dalam bahasa Inggris. Atau model berbasis BERT lainnya menggunakan

panduan sederhana dari dokumentasi.

Model

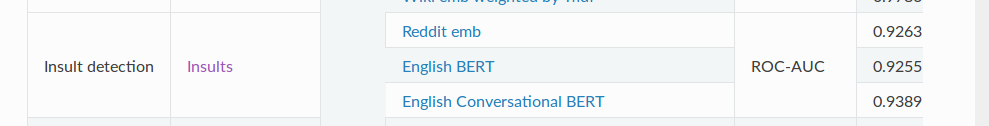

deteksi SOTA

Insult berisi tugas klasifikasi biner untuk mendeteksi penyalahgunaan. Untuk metrik ROC-AUC (pengukuran kinerja untuk tugas klasifikasi pada berbagai pengaturan ambang), model ini menunjukkan nilai 93,89 pada data dibandingkan dengan BERT - 92,55 yang biasa.

Dan akhirnya

Jadi itu hampir semua yang ingin kami ceritakan tentang BERT percakapan kami. Dan jangan lupa bahwa DeepPavlov memiliki

forum - ajukan pertanyaan Anda tentang perpustakaan dan model. Jadilah dalam bisnis!