Pada tahun 1998, ketika database MNIST muncul, perlu waktu berminggu-minggu untuk melatih komputer paling canggih, yang mencapai hasil yang jauh lebih buruk daripada komputer saat ini, yang membutuhkan waktu kurang dari satu jam untuk mendapatkan GPU. Oleh karena itu, MNIST bukan lagi tugas mendorong batas-batas teknologi; kecepatan pelatihan menunjukkan bahwa tugas ini sangat cocok untuk mempelajari teknologi ini. Sementara itu, penelitian melangkah lebih jauh, dan pekerjaan modern mempelajari masalah yang jauh lebih kompleks. Pada bagian ini, saya akan menjelaskan secara singkat beberapa contoh pekerjaan yang sedang berlangsung terkait dengan pengenalan gambar menggunakan jaringan saraf.

Bagian ini berbeda dari buku lainnya. Dalam buku itu, saya fokus pada ide-ide yang mungkin berumur panjang - backpropagation, regularisasi, jaringan convolutional. Saya mencoba menghindari hasil yang dianggap modis pada saat penulisan, yang nilainya jangka panjang tampak meragukan. Dalam sains, hasil seperti itu paling sering berubah menjadi fana, cepat menghilang dan tidak memiliki efek jangka panjang. Mengingat hal ini, orang yang skeptis akan mengatakan: “Tentu saja, kemajuan terbaru dalam pengenalan gambar dapat dianggap sebagai contoh dari perjalanan satu hari seperti itu? Dalam dua atau tiga tahun, semuanya akan berubah. Jadi, apakah hasil ini mungkin menarik bagi sejumlah kecil profesional yang bersaing di latar depan? Kenapa membahasnya sama sekali? ”

Skeptis seperti itu akan benar karena detail kecil dari karya terbaru secara bertahap kehilangan arti penting. Namun, selama beberapa tahun terakhir telah terjadi peningkatan luar biasa dalam memecahkan masalah yang kompleks khususnya pengenalan gambar menggunakan jaringan saraf dalam (GNS). Bayangkan seorang sejarawan bahan penulisan sains tentang visi komputer pada tahun 2100. Mereka akan mendefinisikan 2011-2015 (dan mungkin beberapa tahun setelah itu) sebagai periode terobosan signifikan yang didorong oleh deep convolution networks (GSS). Ini tidak berarti bahwa GOS masih akan digunakan pada tahun 2100, belum lagi detail seperti pengecualian, ReLU, dan banyak lagi. Tetapi ini semua sama artinya bahwa ada transisi penting dalam sejarah gagasan pada saat ini. Ini mirip dengan mengamati penemuan atom, penemuan antibiotik: penemuan dan penemuan proporsi historis. Karena itu, tanpa merinci lebih lanjut, ada baiknya mendapatkan beberapa gagasan tentang penemuan menarik yang dibuat hari ini.

Bekerja 2012 LRMD

Mari saya mulai dengan

karya 2012, yang ditulis oleh sekelompok peneliti dari Stanford dan Google. Saya akan memanggilnya LRMD, dengan huruf pertama dari nama empat penulis pertama. LRMD menggunakan NS untuk mengklasifikasikan gambar dari basis data ImageNet, yang merupakan tugas yang sangat sulit untuk pengenalan pola. Data yang mereka gunakan dari 2011 ImageNet termasuk 16 juta gambar penuh warna, dibagi menjadi 20.000 kategori. Gambar diunduh dari Internet dan diklasifikasikan oleh Mechanical Turk dari Amazon. Inilah beberapa di antaranya:

Mereka termasuk dalam kategori, masing-masing: gondong, jamur akar coklat, susu pasteurisasi, cacing gelang. Jika Anda ingin berlatih, saya sarankan Anda mengunjungi daftar alat-alat tangan dari ImagNet, di mana perbedaan dibuat antara gundukan, perencana akhir, perencana untuk chamfering dan puluhan jenis perencana lainnya, belum lagi kategori lainnya. Saya tidak tahu tentang Anda, tetapi saya tidak dapat membedakan dengan pasti semua alat ini. Ini jelas jauh lebih menantang daripada MNIST! Jaringan LRMD mendapat hasil yang layak pada 15,8% akurasi pengenalan gambar dari ImageNet. Ini mungkin tidak tampak seperti hasil yang mengesankan, tetapi itu adalah peningkatan besar dibandingkan hasil sebelumnya sebesar 9,3%. Lompatan seperti itu menunjukkan bahwa NS dapat menawarkan pendekatan yang efektif untuk tugas-tugas pengenalan gambar yang sangat kompleks, seperti ImageNet.

Bekerja 2012 KSH

Karya LRMD pada 2012 diikuti oleh

karya Krizhevsky, Sutskever dan Hinton (KSH). KSH melatih dan menguji GSS menggunakan subset terbatas data ImagNet. Subset ini didefinisikan oleh kompetisi pembelajaran mesin yang populer - ImageNet Large-Scale Visual Recognition Challenge (ILSVRC). Menggunakan subset ini memberi mereka cara yang nyaman untuk membandingkan pendekatan mereka dengan teknik terkemuka lainnya. Set ILSVRC 2012 berisi sekitar 1,2 juta gambar dari 1000 kategori. Set verifikasi dan konfirmasi masing-masing berisi 150.000 dan 50.000 gambar, dari 1000 kategori yang sama.

Salah satu tantangan kompetisi ILSVRC adalah bahwa banyak gambar dari ImageNet mengandung banyak objek. Misalnya, dalam gambar, Labrador Retriever mengejar bola sepak. T.N. Klasifikasi "benar" dari ILSVRC dapat sesuai dengan label Labrador Retriever. Apakah perlu untuk memilih poin dari algoritma jika menandai gambar seperti bola sepak? Karena ambiguitas seperti itu, algoritma dianggap benar jika klasifikasi ImageNet adalah di antara 5 tebakan algoritma yang paling mungkin mengenai konten gambar. Menurut kriteria ini, dari 5 besar, SSP KSH mencapai akurasi 84,7%, jauh lebih baik daripada lawan sebelumnya, yang mencapai akurasi 73,8%. Menggunakan metrik yang lebih ketat, ketika label harus sama persis dengan yang ditentukan, akurasi KSH mencapai 63,3%.

Ada baiknya menggambarkan secara singkat jaringan KSH, karena mengilhami begitu banyak karya yang mengikuti. Ini juga, seperti yang akan kita lihat, terkait erat dengan jaringan yang kita latih dalam bab ini, meskipun lebih kompleks. KSH menggunakan GSS yang dilatih pada dua GPU. Mereka menggunakan dua GPU karena kartu khusus mereka (NVIDIA GeForce GTX 580) tidak memiliki cukup memori untuk menyimpan seluruh jaringan. Karena itu, mereka membagi jaringan menjadi dua bagian.

Jaringan KSH memiliki 7 lapisan neuron tersembunyi. Lima lapisan tersembunyi pertama bersifat konvolusional (beberapa menggunakan max pooling), dan 2 lapisan berikutnya sepenuhnya terhubung. Lapisan softmax output terdiri dari 1000 neuron yang sesuai dengan 1000 kelas gambar. Berikut ini adalah sketsa jaringan, yang diambil dari karya KSH. Detailnya dijelaskan di bawah ini. Perhatikan bahwa banyak lapisan dibagi menjadi 2 bagian yang sesuai dengan dua GPU.

Di lapisan input ada neuron 3x224x224 yang menunjukkan nilai RGB untuk gambar dengan ukuran 224x224. Ingat bahwa ImageNet berisi gambar dari berbagai resolusi. Ini menimbulkan masalah, karena lapisan jaringan input biasanya berukuran tetap. KSH mengatasinya dengan menskalakan setiap gambar sehingga sisi pendeknya memiliki panjang 256 piksel. Kemudian mereka memotong area 256x256 piksel dari tengah-tengah gambar yang diubah ukurannya. Akhirnya, KSH mengambil potongan gambar 224x224 acak (dan refleksi horizontal) dari 256x256 gambar. Pemotongan acak ini adalah cara memperluas data pelatihan untuk mengurangi pelatihan ulang. Ini khususnya membantu melatih jaringan besar seperti KSH. Dan akhirnya, gambar 224x224 ini digunakan sebagai input ke jaringan. Dalam kebanyakan kasus, gambar yang dipangkas berisi objek utama dari gambar asli.

Kami lolos ke lapisan tersembunyi dari jaringan KSH. Lapisan tersembunyi pertama adalah konvolusional, dengan langkah penarik maksimal. Ini menggunakan bidang reseptif lokal ukuran 11x11, dan langkah 4 piksel. Secara total, 96 kartu fitur diperoleh. Kartu karakter dibagi menjadi dua kelompok yang terdiri dari 48 buah, dengan 48 kartu pertama berada di satu GPU, dan yang kedua di yang lain. Max-pooling pada layer ini dan selanjutnya dilakukan oleh bagian 3x3, tetapi bagian pooling dapat tumpang tindih, dan terletak pada jarak hanya 2 pixel dari satu sama lain.

Lapisan tersembunyi kedua juga convolutional, dengan max pooling. Ini menggunakan bidang reseptif 5x5 lokal, dan memiliki 256 kartu fitur, dibagi menjadi 128 buah untuk setiap GPU. Peta fitur hanya menggunakan 48 saluran masuk, dan tidak semua 96 keluar dari lapisan sebelumnya, seperti biasa. Ini karena setiap kartu fitur menerima input dari GPU tempat kartu itu disimpan. Dalam pengertian ini, jaringan bergerak menjauh dari arsitektur konvolusional yang kami jelaskan sebelumnya dalam bab ini, walaupun, jelas, ide dasarnya tetap sama.

Lapisan ketiga, keempat dan kelima bersifat konvolusional, tetapi tanpa penyatuan maksimal. Parameter mereka: (3) 384 peta fitur, bidang reseptif lokal 3x3, 256 saluran masuk; (4) 384 peta fitur, bidang reseptif lokal 3x3, 192 saluran masuk; (5) 256 kartu fitur, bidang penerima lokal 3x3, 192 saluran masuk. Pada lapisan ketiga, data dipertukarkan antara GPU (seperti yang ditunjukkan pada gambar) sehingga peta fitur dapat menggunakan semua 256 saluran yang masuk.

Lapisan tersembunyi keenam dan ketujuh sepenuhnya terhubung, masing-masing 4096 neuron.

Lapisan output adalah softmax, terdiri dari 1000 unit.

Jaringan KSH memanfaatkan banyak teknik. Alih-alih menggunakan sigmoid atau singgung hiperbolik sebagai fungsi aktivasi, ia menggunakan ReLU, yang sangat mempercepat pembelajaran. Jaringan KSH berisi sekitar 60 juta parameter pelatihan, dan oleh karena itu, bahkan dengan sejumlah besar data pelatihan, itu harus dilatih ulang. Untuk mengatasinya, penulis memperluas pelatihan yang ditetapkan dengan memotong gambar secara acak, seperti dijelaskan di atas. Mereka kemudian menggunakan varian L2-regularisasi dan pengecualian. Jaringan dilatih menggunakan penurunan gradien stokastik berdasarkan momentum dan dengan paket mini.

Ini adalah ikhtisar singkat dari banyak wawasan utama KSH. Saya menghilangkan beberapa detail, mencarinya sendiri di artikel. Anda juga dapat melihat proyek Alex Krizhevsky cuda

-convnet (dan pengikutnya), yang berisi kode yang mengimplementasikan banyak ide yang dijelaskan. Versi jaringan ini

berdasarkan Theano juga telah

dikembangkan . Anda dapat mengenali ide-ide dalam kode yang mirip dengan yang kami kembangkan dalam bab ini, meskipun menggunakan beberapa GPU mempersulit masalah. Kerangka kerja Caffe memiliki versi sendiri dari jaringan KSH, lihat "

model kebun binatang " mereka untuk detailnya.

Kompetisi ILSVRC 2014

Sejak 2012, kemajuannya cukup pesat. Ikuti kompetisi ILSVRC 2014. Seperti pada 2012, peserta harus melatih jaringan untuk 1,2 juta gambar dari 1000 kategori, dan salah satu dari 5 prediksi yang mungkin dalam kategori yang benar adalah kriteria kualitas.

Tim pemenang , yang sebagian besar terdiri dari karyawan Google, menggunakan GSS dengan 22 lapisan neuron. Mereka menamai jaringan mereka GoogLeNet, setelah LeNet-5. Menurut kriteria untuk mencapai lima opsi teratas, GoogLeNet mencapai indikator akurasi 93,33%, yang secara serius meningkatkan hasil pemenang tahun 2013 (Clarifai, dari 88,3%) dan pemenang tahun 2012 (KSH, dari 84,7%).

Seberapa baik akurasi GoogLeNet 93,33%? Pada 2014, tim peneliti menulis

ulasan tentang kompetisi ILSVRC. Salah satu masalah yang dibahas adalah seberapa baik orang dapat mengatasi tugas tersebut. Untuk percobaan, mereka menciptakan sistem yang memungkinkan orang untuk mengklasifikasikan gambar dengan ILSVRC. Sebagai salah satu penulis karya tersebut, Andrei Karpaty, menjelaskan, dalam entri informatif di blog-nya, sangat sulit untuk membawa efektivitas orang ke indikator GoogLeNet:

Tugas menandai gambar dengan lima kategori dari 1000 yang mungkin dengan cepat menjadi sangat sulit, bahkan bagi teman-teman saya di laboratorium yang telah bekerja dengan ILSVRC dan kategorinya selama beberapa waktu. Pertama, kami ingin menyerahkan tugas ke Amazon Mechanical Turk. Kemudian kami memutuskan untuk mencoba mempekerjakan siswa demi uang. Karena itu, saya mengadakan pesta penandaan di antara para ahli di laboratorium saya. Setelah itu, saya mengembangkan antarmuka yang dimodifikasi yang menggunakan prediksi GoogLeNet untuk mengurangi jumlah kategori dari 1000 menjadi 100. Namun demikian, tugasnya sulit - orang melewatkan kategori, memberikan kesalahan urutan 13-15%. Pada akhirnya, saya menyadari bahwa untuk semakin mendekati hasil GoogLeNet, pendekatan yang paling efektif bagi saya adalah duduk dan menjalani proses pembelajaran yang sangat panjang dan proses markup yang menyeluruh. Pada awalnya, penandaan berada pada kecepatan urutan 1 buah per menit, tetapi dipercepat dari waktu ke waktu. Beberapa gambar mudah dikenali, sementara yang lain (misalnya, jenis anjing tertentu, spesies burung atau monyet) memerlukan konsentrasi beberapa menit. Saya sangat pandai membedakan antara ras anjing. Berdasarkan sampel gambar saya, hasil berikut diperoleh: GoogLeNet salah dalam 6,8% kasus; tingkat kesalahan saya adalah 5,1%, yang sekitar 1,7% lebih baik.

Dengan kata lain, ahli, yang bekerja dengan sangat hati-hati, hanya dengan melakukan upaya serius, mampu sedikit melampaui STS. Karpaty melaporkan bahwa pakar kedua, yang terlatih dengan lebih sedikit gambar, berhasil mengurangi kesalahan hanya 12% ketika memilih hingga 5 label per gambar, yang jauh lebih sedikit daripada GoogLeNet.

Hasil luar biasa. Dan sejak dimulainya pekerjaan ini, beberapa tim telah melaporkan perkembangan sistem yang tingkat kesalahannya ketika memilih 5 tag terbaik bahkan kurang dari 5,1%. Terkadang prestasi ini diliput di media sebagai munculnya sistem yang mampu mengenali gambar lebih baik daripada orang. Meskipun hasilnya umumnya mencolok, ada banyak nuansa yang tidak dapat dianggap bahwa visi komputer berfungsi lebih baik pada sistem ini daripada pada manusia. Dalam banyak hal, kompetisi ILSVRC adalah tugas yang sangat terbatas - hasil pencarian gambar pada jaringan terbuka tidak harus sesuai dengan apa yang akan dihadapi program dalam tugas praktis. Dan, tentu saja, kriteria "salah satu dari lima nilai terbaik" cukup palsu. Kami masih memiliki jalan panjang untuk menyelesaikan masalah pengenalan gambar, belum lagi tugas yang lebih umum dari visi komputer. Tapi tetap saja sangat keren untuk melihat berapa banyak kemajuan yang telah dicapai dalam menyelesaikan tugas yang sulit hanya dalam beberapa tahun.

Tugas lainnya

Saya fokus pada ImageNet, namun ada beberapa proyek lain yang menggunakan NS untuk pengenalan gambar. Biarkan saya jelaskan secara singkat beberapa hasil menarik yang diperoleh baru-baru ini, hanya untuk mendapatkan gambaran tentang karya modern.

Satu

set hasil praktis yang menginspirasi diperoleh oleh tim dari Google, yang menerapkan GSS untuk tugas pengenalan pelat alamat di Google Street View. Dalam pekerjaan mereka, mereka melaporkan bagaimana mereka menemukan dan secara otomatis mengenali hampir 100 juta pelat alamat dengan akurasi yang sebanding dengan pekerjaan manusia. Dan sistem mereka cepat: mampu mendekripsi data dari semua gambar Google Street View di Prancis dalam waktu kurang dari satu jam! Mereka menulis: "Mendapatkan dataset baru ini telah secara signifikan meningkatkan kualitas geocoding Google Maps di beberapa negara, terutama di mana tidak ada sumber geocoding lainnya." Kemudian mereka membuat pernyataan yang lebih umum: "Kami percaya bahwa, berkat model ini, kami memecahkan masalah pengenalan optik urutan pendek dengan cara yang berlaku dalam banyak aplikasi praktis."

Mungkin saya menciptakan kesan parade hasil kemenangan dan inspirasi. Tentu saja, laporan yang paling menarik menyangkut hal-hal mendasar yang belum jelas bagi kami. Misalnya, dalam

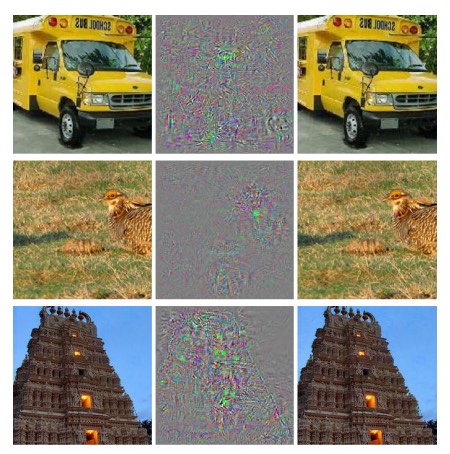

karya 2013 ditunjukkan bahwa Majelis Nasional, pada kenyataannya, memiliki titik buta. Lihatlah gambar-gambar di bawah ini. Di sebelah kiri adalah gambar dari ImageNet, yang diklasifikasikan oleh jaringan peneliti dengan benar. Di sebelah kanan adalah gambar yang sedikit dimodifikasi (di tengah perbedaan ditampilkan), yang jaringannya tidak lagi dapat mengenali dengan benar. Dan penulis menemukan bahwa perubahan "permusuhan" seperti itu dapat dipilih untuk setiap gambar dari database, dan bukan hanya untuk elit.

Hasil yang tidak menyenangkan. Kami menggunakan jaringan berdasarkan kode yang sama dengan jaringan KSH - artinya, jaringan seperti itu yang semakin banyak digunakan. Dan meskipun NS tersebut menghitung, pada prinsipnya, fungsi kontinu, hasil yang serupa menunjukkan bahwa mereka mungkin menghitung fungsi yang hampir terpisah. Lebih buruk lagi, mereka berubah menjadi diskrit dengan cara yang melanggar gagasan intuitif kita tentang perilaku cerdas. Ini masalah. Selain itu, tidak terlalu jelas apa sebenarnya yang menyebabkan diskresi, apa masalahnya: dalam fungsi kerugian? Fungsi aktivasi mana yang digunakan? Dalam arsitektur jaringan? Dalam hal lain? Kami tidak tahu.

Tetapi hasil ini tidak seburuk yang terlihat. Meskipun perubahan permusuhan semacam itu cukup umum, mereka tidak mungkin ditemukan dalam praktik. Seperti yang ditunjukkan dalam pekerjaan:

Keberadaan negatif permusuhan bertentangan dengan kemampuan jaringan untuk mencapai generalisasi yang tinggi. Memang, jika jaringan bisa digeneralisasikan dengan baik, bagaimana bisa tertipu oleh negatif permusuhan seperti tidak dapat dibedakan dari contoh biasa? Penjelasannya adalah bahwa seperangkat negatif kompetitif memiliki probabilitas yang sangat rendah, dan oleh karena itu tidak diamati (atau hampir tidak diamati) dalam kumpulan data pelatihan, bagaimanapun, ia memiliki kepadatan tinggi (kira-kira seperti bilangan rasional), dan oleh karena itu dapat ditemukan untuk hampir semua kasus .

Namun demikian, sangat tidak menyenangkan bahwa kita memahami pekerjaan Majelis Nasional dengan sangat buruk sehingga hasil ini ditemukan baru-baru ini. Tentu saja, keuntungan utama dari hasil seperti itu adalah bahwa mereka merangsang penampilan pekerjaan selanjutnya pada topik ini. Sebuah

karya terbaru pada tahun 2014 menunjukkan bahwa dimungkinkan bagi jaringan yang terlatih untuk membuat gambar yang terlihat seperti white noise bagi seseorang, dan jaringan akan mengklasifikasikannya ke dalam kategori-kategori terkenal dengan tingkat kepercayaan yang tinggi.

Ini adalah demonstrasi lain yang masih harus banyak dipahami dalam karya NS dan dalam penggunaannya untuk pengenalan gambar.Tetapi, meskipun ada hasil yang sama, gambaran keseluruhannya menginspirasi. Kami melihat kemajuan pesat dalam melakukan tes yang sangat kompleks seperti ImageNet. Kami juga melihat kemajuan pesat dalam menyelesaikan masalah dari dunia nyata, seperti mengenali pelat alamat di StreetView. Namun, terlepas dari ilhamnya, tidak cukup hanya dengan mengamati peningkatan kinerja tes kecepatan atau bahkan tugas dunia nyata. Ada fenomena mendasar, esensi yang masih kurang kita pahami, misalnya, keberadaan citra kompetitif. Dan sementara masalah mendasar seperti itu masih terbuka (belum lagi menyelesaikannya), akan terlalu dini untuk berbicara tentang mendekati solusi dari masalah pengenalan gambar. Tetapi pada saat yang sama, masalah seperti itu adalah insentif yang sangat baik untuk pekerjaan lebih lanjut.Pendekatan lain untuk jaringan saraf yang dalam

Dalam buku ini, kami fokus pada satu tugas: klasifikasi angka MNIST. Tugas luar biasa yang membuat kami memahami banyak ide efektif: penurunan gradien stokastik, backpropagation, jaringan konvolusional, regularisasi, dll. Namun, ini juga tugas yang agak sempit. Setelah membaca literatur di jaringan saraf, Anda akan menemukan banyak ide yang tidak kami diskusikan: NS berulang, mesin Boltzmann, model generatif, transfer pelatihan, pembelajaran yang diperkuat, dan seterusnya dan seterusnya! Jaringan saraf adalah area yang luas. Namun, banyak ide penting adalah variasi dari ide-ide yang telah kita bahas, dan mereka cukup mudah dimengerti. Di bagian ini, saya akan sedikit membuka tirai di atas hamparan luas ini. Diskusi mereka tidak akan terperinci dan komprehensif - ini akan sangat mengembang buku ini. Itu akan impresionistis,upaya untuk menunjukkan kekayaan konseptual dari bidang ini, dan untuk menghubungkan beberapa konsep dengan yang telah kita lihat. Dalam teks ini saya akan memberikan beberapa referensi ke sumber lain, seperti materi untuk pelatihan lebih lanjut. Tentu saja, banyak dari mereka akan segera digantikan oleh orang lain, dan Anda mungkin ingin mencari literatur yang lebih baru. Namun demikian, saya percaya bahwa banyak ide dasar akan tetap menarik untuk waktu yang lama mendatang.Jaringan Syaraf Berulang (RNS)

Dalam jaringan propagasi langsung yang kami gunakan, ada satu input yang sepenuhnya menentukan aktivasi semua neuron di lapisan berikutnya. Ini adalah gambar yang sangat statis: semua yang ada di jaringan sudah diperbaiki, dan memiliki karakter yang beku dan kristalin. Tapi misalkan kita membiarkan elemen jaringan berubah secara dinamis. Misalnya, perilaku neuron tersembunyi dapat ditentukan tidak hanya oleh aktivasi di lapisan sebelumnya, tetapi juga oleh aktivasi yang terjadi sebelumnya. Aktivasi neuron sebagian dapat ditentukan oleh aktivasi sebelumnya. Dalam jaringan dengan distribusi langsung, ini jelas tidak terjadi. Atau, mungkin, aktivasi neuron tersembunyi dan keluaran akan ditentukan tidak hanya oleh input saat ini ke jaringan, tetapi juga oleh yang sebelumnya.Jaringan saraf dengan jenis perilaku yang bervariasi waktu ini dikenal sebagai jaringan saraf berulang, atau RNS. Ada banyak cara untuk secara formal memformalkan deskripsi informal dari paragraf sebelumnya. Anda bisa mendapatkan ide tentang mereka dengan membaca artikel Wikipedia . Pada saat penulisan, dalam versi bahasa Inggris artikel, setidaknya 13 model yang berbeda dijelaskan [pada saat terjemahan pada 2019, sudah 18 / sekitar. diterjemahkan.].

Tetapi, jika kita menyisihkan perincian matematis, maka gagasan umum RNS adalah adanya perubahan dinamis dalam jaringan yang terjadi seiring waktu. Dan, tidak mengherankan, mereka sangat berguna untuk menganalisis data atau proses yang berubah seiring waktu. Data dan proses seperti itu muncul secara alami dalam tugas-tugas seperti analisis ucapan atau bahasa alami.Salah satu cara saat ini untuk menggunakan RNS adalah dengan lebih baik mengintegrasikan jaringan saraf dengan metode tradisional mewakili algoritma, dengan konsep-konsep seperti mesin Turing dan bahasa pemrograman umum. Dalam pekerjaan dari 2014RNS dikembangkan, mampu menerima deskripsi huruf demi huruf dari program python yang sangat sederhana, dan memprediksi hasil kerjanya. Secara informal, jaringan sedang belajar untuk "memahami" program python tertentu. Pekerjaan kedua dari tahun 2014 menggunakan RNS sebagai titik awal untuk pengembangan Turing neuromachine (BDC). Ini adalah komputer universal, seluruh struktur yang dapat dilatih menggunakan gradient descent. Mereka melatih BDC mereka untuk membangun algoritma untuk beberapa tugas sederhana, seperti menyortir atau menyalin.Ini, tentu saja, sangat sederhana, model mainan. Mempelajari cara menjalankan program dengan cara cetak seperti python (398345 + 42598) tidak menjadikan jaringan saraf sebagai penerjemah bahasa yang lengkap! Tidak jelas seberapa kuat ide-ide ini nantinya. Kendati demikian, hasilnya cukup menarik. Secara historis, jaringan saraf melakukan pekerjaan yang baik untuk mengenali pola yang tersandung pada pendekatan algoritmik konvensional. Dan sebaliknya, pendekatan algoritmik konvensional melakukan pekerjaan dengan baik dalam memecahkan masalah yang kompleks untuk NS. Saat ini, tidak ada yang mencoba mengimplementasikan server web atau database berbasis NS! Akan luar biasa untuk mengembangkan model terintegrasi yang mengintegrasikan kekuatan NS dan pendekatan algoritmik tradisional. RNS, dan ide-ide yang diilhami oleh mereka, dapat membantu kita melakukan ini.Dalam beberapa tahun terakhir, RNS telah digunakan untuk menyelesaikan banyak masalah lainnya. Mereka sangat berguna dalam pengenalan ucapan. Pendekatan berbasis RNS membuat catatan untuk kualitas pengenalan fonem. Mereka juga digunakan untuk mengembangkan model peningkatan bahasa yang digunakan oleh orang-orang. Model bahasa yang ditingkatkan membantu mengenali ambiguitas dalam ucapan yang terdengar serupa. Model bahasa yang baik dapat memberi tahu kita bahwa frasa "maju hingga tak terbatas" jauh lebih mungkin daripada frasa "maju tanpa anggota tubuh", meskipun terdengar mirip. RNS digunakan untuk mendapatkan catatan prestasi dalam tes bahasa tertentu.Pekerjaan ini adalah bagian dari penggunaan NS yang lebih luas dari semua jenis, bukan hanya RNS, untuk menyelesaikan masalah pengenalan ucapan. Misalnya, pendekatan berbasis GNS telah menunjukkan hasil yang sangat baik dalam mengenali pembicaraan terus menerus dengan kosa kata yang besar. Sistem berbasis GNS lain diimplementasikan dalam OS Android dari Google.Saya berbicara sedikit tentang kemampuan RNC, tetapi tidak menjelaskan bagaimana cara kerjanya. Anda mungkin tidak terkejut mengetahui bahwa banyak ide dari dunia jaringan distribusi langsung juga dapat digunakan di RNS. Secara khusus, kita bisa melatih RNS dengan memodifikasi gradient descent dan back propagation di dahi. Banyak ide lain yang digunakan dalam jaringan distribusi langsung, mulai dari teknik regularisasi hingga konvolusi dan aktivasi serta fungsi biaya, juga akan berguna. Juga, banyak ide yang kami kembangkan sebagai bagian dari buku ini dapat diadaptasi untuk digunakan dalam RNS.Modul Memori Jangka Pendek (DCT) Jangka Panjang

Salah satu masalah RNS adalah bahwa model awal sangat sulit untuk dilatih, lebih rumit daripada GNS. Alasannya adalah masalah gradien tidak stabil, yang kita bahas di bab 5. Ingat bahwa manifestasi biasa dari masalah ini adalah bahwa gradien berkurang sepanjang waktu ketika merambat melalui lapisan dalam arah yang berlawanan. Ini sangat memperlambat pembelajaran lapisan awal. Dalam RNS, masalah ini menjadi lebih buruk, karena gradien merambat tidak hanya dalam arah yang berlawanan sepanjang lapisan, tetapi juga dalam arah yang berlawanan dalam waktu. Jika jaringan bekerja untuk waktu yang agak lama, gradien dapat menjadi sangat tidak stabil dan pada dasarnya akan sangat sulit untuk dipelajari. Untungnya, sebuah ide yang dikenal sebagai modul memori jangka pendek (DCT) jangka panjang dapat dimasukkan dalam RNS . Untuk pertama kalinya, modul diperkenalkanHochreiter dan Schmidguber pada tahun 1997 , khusus untuk membantu menyelesaikan masalah gradien yang tidak stabil. DCT memudahkan untuk mendapatkan hasil yang baik dalam mempelajari RNS, dan banyak karya terbaru (termasuk yang telah saya rujuk) menggunakan DCT atau ide serupa.Jaringan kepercayaan mendalam, model generatif, dan mesin Boltzmann

Saat ini, minat dalam pembelajaran mendalam telah mendapatkan angin kedua pada tahun 2006, setelah publikasi karya ( 1 , 2 ) menjelaskan bagaimana cara mengajarkan jenis khusus NS yang disebut deep trust network (GDS). GDS selama beberapa tahun mempengaruhi bidang penelitian, tetapi kemudian popularitas mereka mulai menurun, dan jaringan distribusi langsung dan NS yang berulang menjadi populer. Meskipun demikian, beberapa sifat GDS membuatnya sangat menarik.Pertama, GDS adalah contoh model generatif. Dalam jaringan distribusi langsung, kami menentukan aktivasi input, dan mereka menentukan aktivasi neuron fitur lebih lanjut di jaringan. Model generatif dapat digunakan dengan cara yang serupa, tetapi Anda dapat mengatur nilai-nilai neuron di dalamnya, dan kemudian menjalankan jaringan "dalam arah yang berlawanan", menghasilkan nilai-nilai aktivasi input. Lebih khusus lagi, GDS yang terlatih pada gambar digit tulisan tangan itu sendiri dapat menghasilkan gambar yang mirip dengan digit tulisan tangan (berpotensi, dan setelah tindakan tertentu). Dengan kata lain, GDM dalam arti tertentu bisa belajar menulis. Dalam pengertian ini, model generatif mirip dengan otak manusia: mereka tidak hanya dapat membaca angka, tetapi juga menuliskannya. Pepatah terkenal Jeffrey Hintonmenyatakan bahwa untuk pengenalan pola, Anda harus terlebih dahulu mempelajari cara membuat gambar.Kedua, mereka mampu belajar tanpa guru dan hampir tanpa guru. Misalnya, saat melatih gambar, GDS dapat mempelajari tanda-tanda yang berguna untuk memahami gambar lain, bahkan jika tidak ada tanda pada gambar pelatihan. Kemampuan untuk belajar tanpa seorang guru sangat menarik baik dari sudut pandang ilmiah mendasar maupun dari sudut pandang praktis - jika itu dapat dibuat untuk bekerja dengan cukup baik.Mengingat semua poin GDS yang menarik ini sebagai model untuk pembelajaran yang mendalam, mengapa popularitas mereka menurun? Sebagian karena kenyataan bahwa model lain, seperti distribusi langsung dan jaringan berulang, telah mencapai hasil yang menakjubkan, khususnya, terobosan dalam bidang pengenalan gambar dan ucapan. Tidak mengherankan bahwa model-model ini telah menerima perhatian seperti itu, dan sangat layak. Namun, kesimpulan yang tidak menyenangkan mengikuti dari ini. Pasar ide sering bekerja sesuai dengan skema “pemenang mendapatkan segalanya”, dan hampir semua perhatian tertuju pada apa yang paling modis di bidang ini sekarang. Mungkin sangat sulit bagi orang untuk mengerjakan ide-ide yang saat ini tidak populer, bahkan jika itu jelas bahwa mereka mungkin memiliki minat jangka panjang. Pendapat pribadi saya adalah bahwa GDS dan model generatif lainnya pantas mendapatkan perhatian lebih dari yang mereka dapatkan.Saya tidak akan terkejut jika GDM atau model serupa pernah melampaui model populer saat ini. Bacaartikel ini untuk pengantar bidang GDM. Artikel ini mungkin juga bermanfaat . Ini tidak sepenuhnya tentang GDM, tetapi memiliki banyak hal berguna tentang mesin Boltzmann terbatas, komponen kunci dari GDM.Ide lain

Apa lagi yang terjadi di bidang Majelis Nasional dan Pertahanan Sipil? Sejumlah besar karya yang menarik. Di antara bidang aktif penelitian adalah penggunaan NS untuk

memproses bahasa alami,

terjemahan mesin , dan aplikasi yang lebih tak terduga, misalnya,

informatika musik . Ada banyak area lainnya. Dalam banyak kasus, setelah membaca buku ini, Anda akan dapat memahami karya terbaru, meskipun, tentu saja, Anda mungkin perlu mengisi beberapa kesenjangan pengetahuan.

Saya akan mengakhiri bagian ini dengan menyebutkan karya yang sangat menarik. Dia menggabungkan jaringan convolutional yang mendalam dengan teknik yang disebut penguatan

pembelajaran untuk

belajar cara bermain video game (dan

artikel lain tentang itu). Idenya adalah menggunakan jaringan konvolusional untuk menyederhanakan data piksel dari layar game, mengubahnya menjadi seperangkat atribut yang lebih sederhana yang kemudian dapat digunakan untuk membuat keputusan tentang tindakan lebih lanjut: "belok kiri", "belok kanan", "tembak", dan dll. Yang sangat menarik adalah bahwa satu jaringan cukup belajar untuk memainkan tujuh video game klasik yang berbeda, di depan para ahli di tiga dari mereka. Ini, tentu saja, terlihat seperti tipuan, dan karya itu diiklankan secara aktif di bawah judul "Bermain Atari Games dengan Belajar Reinforcement". Namun, di balik gloss yang dangkal perlu mempertimbangkan fakta bahwa sistem mengambil data piksel mentah - bahkan tidak tahu aturan permainan - dan atas dasar mereka dilatih untuk membuat keputusan berkualitas baik dalam beberapa situasi yang sangat berbeda dan sangat kompetitif, masing-masing memiliki seperangkat aturan sendiri yang kompleks. Cukup bagus.

Masa depan jaringan saraf

User Intent Interfaces

Dalam sebuah lelucon lama, seorang profesor yang tidak sabar berkata kepada seorang siswa yang bingung: "Jangan dengarkan kata-kataku, dengarkan apa yang kumaksud." Secara historis, komputer sering tidak mengerti, seperti siswa yang bingung, apa artinya pengguna. Namun, situasinya berubah. Saya masih ingat pertama kali saya terkejut ketika saya keliru menulis permintaan ke Google, dan mesin pencari berkata kepada saya, "Apakah maksud Anda [permintaan yang benar]?" Direktur Google Larry Page

pernah menggambarkan mesin pencari yang sempurna sebagai sistem yang memahami dengan tepat apa yang dimaksud permintaan Anda dan memberi Anda apa yang Anda inginkan.

Ini adalah gagasan tentang antarmuka berdasarkan niat pengguna. Di dalamnya, alih-alih menanggapi permintaan pengguna literal, mesin pencari akan menggunakan MO untuk mengambil permintaan pengguna yang tidak jelas, memahami persis apa artinya, dan bertindak atas dasar ini.

Gagasan antarmuka yang didasarkan pada niat pengguna dapat diterapkan lebih luas daripada hanya dalam pencarian. Selama beberapa dekade berikutnya, ribuan perusahaan akan menciptakan produk-produk di mana MO akan digunakan untuk antarmuka pengguna yang dengan tenang terkait dengan tindakan pengguna yang tidak akurat dan menebak niat mereka yang sebenarnya. Kita sudah melihat contoh awal dari antarmuka berbasis maksud seperti itu: Apple Siri; Wolfram Alpha; IBM Watson sistem yang secara otomatis menandai foto dan video, dan banyak lagi.

Kebanyakan dari mereka akan gagal. Pengembangan antarmuka adalah hal yang rumit, dan saya menduga bahwa alih-alih menginspirasi antarmuka, banyak perusahaan akan membuat antarmuka tak bernyawa berdasarkan MO. MO terbaik di dunia tidak akan membantu Anda jika antarmuka Anda payah. Namun, beberapa produk akan berhasil. Seiring waktu, ini akan menyebabkan perubahan serius dalam hubungan kita dengan komputer. Belum lama berselang, misalnya, pada 2005, pengguna menerima begitu saja bahwa berinteraksi dengan komputer membutuhkan akurasi tinggi. Sifat literal komputer berfungsi untuk menyebarkan gagasan bahwa komputer sangat literal; satu-satunya titik koma yang terlupakan dapat sepenuhnya mengubah sifat interaksi dengan komputer. Tetapi saya percaya bahwa dalam beberapa dekade ke depan kita akan mengembangkan beberapa antarmuka yang berhasil berdasarkan niat pengguna, dan ini akan secara radikal mengubah harapan kita ketika bekerja dengan komputer.

Pembelajaran Mesin, Ilmu Data, dan Lingkaran Inovasi Tak Bernoda

Tentu saja, MO tidak hanya digunakan untuk membuat antarmuka berdasarkan niat pengguna. Aplikasi MO lain yang menarik adalah ilmu data, di mana ia digunakan untuk mencari "diketahui tidak dikenal" yang tersembunyi dalam data yang diperoleh. Ini sudah menjadi topik yang fashionable, tentang mana banyak artikel telah ditulis, jadi saya tidak akan membahasnya untuk waktu yang lama. Saya ingin menyebutkan satu konsekuensi dari mode ini, yang tidak sering dicatat: dalam jangka panjang, adalah mungkin bahwa terobosan terbesar di Wilayah Moskow tidak akan menjadi hanya satu terobosan konseptual. Terobosan terbesar adalah bahwa penelitian di bidang MO akan menjadi menguntungkan melalui penggunaan data dalam sains dan bidang lainnya. Jika sebuah perusahaan dapat menginvestasikan dolar dalam penelitian MO dan mendapatkan dolar dan sepuluh sen pendapatan lebih cepat, maka banyak uang akan dituangkan ke wilayah MO. Dengan kata lain, MO adalah mesin yang mendorong kita untuk munculnya beberapa pasar besar dan bidang pertumbuhan teknologi. Akibatnya, tim besar orang yang ahli di bidang ini akan muncul yang akan memiliki akses ke sumber daya yang luar biasa. Ini akan menggerakkan MO lebih jauh, menciptakan lebih banyak pasar dan peluang, yang akan menjadi lingkaran inovasi yang sempurna.

Peran jaringan saraf dan pembelajaran yang mendalam

Saya menggambarkan MO secara umum sebagai cara untuk menciptakan peluang baru untuk pengembangan teknologi. Apa yang akan menjadi peran spesifik Majelis Nasional dan Masyarakat Sipil dalam semua ini?

Untuk menjawab pertanyaan, akan bermanfaat untuk beralih ke riwayat. Pada 1980-an, ada kebangkitan aktif dan optimisme yang menyenangkan terkait dengan jaringan saraf, terutama setelah mempopulerkan propagasi kembali. Tetapi pemulihan mereda, dan pada 1990-an, tongkat MO dipindahkan ke teknologi lain, misalnya, metode vektor dukungan. Hari ini, Majelis Nasional kembali berkuda, mengatur semua jenis catatan, dan menyusul banyak saingan dalam berbagai masalah. Tetapi siapa yang menjamin bahwa besok pendekatan baru tidak akan dikembangkan yang lagi-lagi akan menaungi NA? Atau, mungkin, kemajuan di bidang Majelis Nasional akan mulai macet, dan tidak ada yang akan menggantikan mereka?

Karena itu, jauh lebih mudah untuk memikirkan masa depan Kementerian Pertahanan secara keseluruhan daripada secara khusus tentang Majelis Nasional. Sebagian masalahnya adalah kita sangat kurang memahami Majelis Nasional. Mengapa NS begitu pandai menyusun informasi? Bagaimana mereka menghindari pelatihan ulang dengan sangat baik, mengingat banyaknya pilihan? Mengapa penurunan gradien stokastik bekerja dengan sangat baik? Seberapa baik NS akan bekerja saat menskala dataset? Sebagai contoh, jika kita memperluas basis ImageNet 10 kali, akankah kinerja NS meningkat lebih atau kurang daripada efektivitas teknologi MO lainnya? Semua ini adalah pertanyaan mendasar yang sederhana. Dan sejauh ini kami memiliki pemahaman yang sangat buruk tentang jawaban atas pertanyaan-pertanyaan ini. Dalam hal ini, sulit untuk mengatakan apa peran Majelis Nasional akan bermain di masa depan Wilayah Moskow.

Saya akan membuat satu prediksi: Saya pikir GO tidak akan pergi ke mana pun. Kemampuan untuk mempelajari hierarki konsep, untuk membangun lapisan abstraksi yang berbeda, tampaknya, merupakan hal mendasar bagi pengetahuan dunia. Ini tidak berarti bahwa jaringan GO di masa depan tidak akan secara radikal berbeda dari jaringan saat ini. Kita mungkin menghadapi perubahan besar dalam bagian penyusunnya, arsitektur, atau algoritma pembelajaran. Perubahan ini mungkin berubah menjadi cukup dramatis bagi kita untuk berhenti mempertimbangkan sistem yang dihasilkan sebagai jaringan saraf. Namun, mereka masih akan terlibat dalam pertahanan sipil.

Akankah NS dan GO segera menyebabkan munculnya kecerdasan buatan?

Dalam buku ini, kami fokus pada penggunaan NS dalam memecahkan masalah tertentu, misalnya, klasifikasi gambar. Mari kita memperluas pertanyaan kami: bagaimana dengan komputer berfikir umum? Bisakah Majelis Nasional dan Masyarakat Sipil membantu kita memecahkan masalah menciptakan AI tujuan umum? Dan jika demikian, mengingat kecepatan tinggi kemajuan di bidang pertahanan sipil, akankah kita melihat munculnya AI dalam waktu dekat?

Jawaban terperinci untuk pertanyaan seperti itu akan membutuhkan buku terpisah. Sebagai gantinya, izinkan saya menawarkan kepada Anda satu pengamatan berdasarkan

hukum Conway :

Sistem yang dirancang organisasi terbatas pada desain yang menyalin struktur komunikasi organisasi ini.

Misalnya, hukum Conway menyatakan bahwa tata letak pesawat Boeing 747 akan mencerminkan struktur Boeing dan kontraktornya yang diperluas pada saat model 747 sedang dikembangkan. Atau contoh lain yang sederhana dan konkret: pertimbangkan perusahaan yang mengembangkan perangkat lunak kompleks. Jika panel kontrol perangkat lunak harus terhubung dengan algoritme MO, maka perancang panel harus berkomunikasi dengan pakar MO perusahaan. Hukum Conway hanya memformalkan pengamatan ini.

Untuk pertama kalinya ketika mereka mendengar hukum Conway, banyak orang mengatakan "Apakah ini bukan bukti yang biasa?" Atau "Begitukah?" Saya akan mulai dengan komentar tentang perselingkuhannya. Mari kita pikirkan: bagaimana akuntansi Boeing tercermin dalam model 747? Bagaimana dengan departemen kebersihan? Staf yang memberi makan? Jawabannya adalah bahwa bagian-bagian organisasi ini kemungkinan besar tidak muncul di tempat lain dalam Skema 747 secara eksplisit. Oleh karena itu, Anda perlu memahami bahwa hukum Conway hanya berlaku untuk bagian-bagian organisasi yang terlibat langsung dalam desain dan rekayasa.

Bagaimana dengan komentar tentang banalitas dan bukti? Mungkin memang demikian, tapi saya rasa tidak, karena organisasi sering bekerja untuk menolak hukum Conway. Tim yang mengembangkan produk baru sering meningkat karena jumlah karyawan yang berlebihan, atau, sebaliknya, mereka kekurangan orang dengan pengetahuan kritis. Pikirkan semua produk dengan fitur yang tidak berguna dan rumit. Atau pikirkan produk dengan cacat yang jelas - misalnya, dengan antarmuka pengguna yang mengerikan. Di kedua kelas program, masalah sering muncul karena ketidakcocokan antara tim yang diperlukan untuk merilis produk yang bagus dan tim yang benar-benar berkumpul. Hukum Conway mungkin jelas, tetapi itu tidak berarti bahwa orang tidak dapat mengabaikannya secara teratur.

Hukum Conway berlaku untuk desain dan pembuatan sistem dalam kasus-kasus di mana sejak awal kita membayangkan bagian komponen apa yang akan terdiri dari produk dan bagaimana membuatnya. Itu tidak dapat diterapkan secara langsung untuk pengembangan AI, karena AI belum (belum) tugas seperti itu: kita tidak tahu bagian mana yang terdiri darinya. Kami bahkan tidak yakin pertanyaan dasar apa yang bisa Anda tanyakan. Dengan kata lain, saat ini, AI lebih merupakan masalah sains daripada insinyur. Bayangkan Anda harus mulai mengembangkan 747 tanpa mengetahui apa pun tentang mesin jet atau prinsip aerodinamika. Anda tidak akan tahu ahli mana yang harus dipekerjakan di organisasi Anda. Seperti yang ditulis Werner von Braun, "penelitian dasar adalah apa yang saya lakukan ketika saya tidak tahu apa yang saya lakukan." Apakah ada versi hukum Conway yang berlaku untuk tugas yang lebih terkait dengan sains daripada insinyur?

Untuk menemukan jawaban untuk pertanyaan ini, mari kita ingat sejarah kedokteran. Pada masa-masa awal, obat-obatan adalah domain para praktisi, seperti

Galen atau

Hippocrates , yang mempelajari seluruh tubuh manusia. Tetapi dengan pertumbuhan volume pengetahuan kami, saya harus berspesialisasi. Kami telah menemukan banyak ide mendalam - mengingat teori mikroba penyakit, atau memahami prinsip operasi antibodi, atau fakta bahwa jantung, paru-paru, pembuluh darah dan arteri membentuk sistem kardiovaskular. Gagasan mendalam seperti itu membentuk fondasi untuk disiplin ilmu yang lebih sempit, seperti epidemiologi, imunologi, dan akumulasi bidang yang tumpang tindih terkait dengan sistem kardiovaskular. Beginilah struktur pengetahuan kita membentuk struktur sosial kedokteran. Ini terutama terlihat dalam kasus imunologi: gagasan tentang keberadaan sistem kekebalan yang layak untuk studi terpisah sangat tidak trivial. Jadi kami memiliki seluruh bidang kedokteran - dengan spesialis, konferensi, penghargaan, dan sebagainya - diorganisasikan di sekitar sesuatu yang tidak hanya tidak terlihat, tetapi bahkan mungkin tidak terpisah.

Perkembangan peristiwa seperti itu sering diulang dalam banyak disiplin ilmu yang sudah mapan: tidak hanya dalam kedokteran, tetapi juga dalam fisika, matematika, kimia, dan lain-lain. Daerah dilahirkan monolitik, hanya memiliki sedikit gagasan mendalam. Para ahli pertama mampu mencakup semuanya. Namun seiring waktu, soliditas berubah. Kami menemukan banyak ide baru yang dalam, dan ada terlalu banyak untuk seseorang yang dapat benar-benar menguasai semuanya. Akibatnya, struktur sosial daerah sedang direorganisasi dan dibagi, berkonsentrasi di sekitar ide-ide ini. Alih-alih monolith, kami memiliki bidang yang dibagi dengan bidang yang dibagi oleh bidang - struktur sosial yang kompleks dan rekursif yang merujuk pada dirinya sendiri, yang organisasinya mencerminkan hubungan antara ide-ide yang paling mendalam. Inilah bagaimana struktur pengetahuan kita membentuk organisasi sosial sains. Namun, bentuk sosial ini pada gilirannya membatasi dan membantu menentukan apa yang dapat kita deteksi. Ini adalah analog ilmiah hukum Conway.

Tapi apa hubungannya semua ini dengan pembelajaran yang mendalam atau AI?

Nah, sejak awal pengembangan AI

, telah ada perdebatan bahwa semuanya akan berjalan "tidak terlalu rumit, terima kasih kepada superweapon kami", atau "superweapon tidak akan cukup." Pembelajaran mendalam adalah contoh terbaru dari senjata super yang telah digunakan dalam perselisihan yang saya lihat. Dalam versi awal pertikaian semacam itu, logika digunakan, atau Prolog, atau sistem pakar, atau teknologi lain, yang saat itu paling kuat. Masalah dengan perselisihan seperti itu adalah bahwa mereka tidak memberi Anda kesempatan untuk mengatakan dengan tepat seberapa kuat salah satu kandidat untuk senjata super akan. Tentu saja, kami hanya menghabiskan seluruh bab meninjau bukti bahwa pertahanan sipil dapat menyelesaikan masalah yang sangat kompleks. Jelas terlihat sangat menarik dan menjanjikan. Namun demikian halnya dengan sistem seperti Prolog, atau Eurisko, atau dengan sistem pakar. Karena itu, hanya fakta bahwa seperangkat ide terlihat menjanjikan tidak berarti sesuatu yang istimewa. Bagaimana kita tahu bahwa GO sebenarnya berbeda dari ide-ide awal ini? Apakah ada cara untuk mengukur seberapa kuat dan menjanjikan seperangkat ide? Ini mengikuti dari hukum Conway bahwa kita dapat menggunakan kompleksitas struktur sosial yang terkait dengan ide-ide ini sebagai metrik kasar dan heuristik.

Karena itu, kami punya dua pertanyaan. Pertama, seberapa kuat seperangkat ide yang terkait dengan masyarakat sipil menurut metrik kompleksitas sosial ini? Kedua, seberapa kuat teori yang kita butuhkan untuk menciptakan AI tujuan umum?

Pada pertanyaan pertama: ketika kita melihat pertahanan sipil hari ini, bidang ini terlihat menarik dan berkembang pesat, tetapi relatif monolitik. Ini memiliki beberapa ide mendalam dan beberapa konferensi besar diadakan, beberapa di antaranya tumpang tindih. Pekerjaan di tempat kerja menggunakan serangkaian ide yang sama: penurunan gradien stokastik (atau yang sederajat) untuk mengoptimalkan fungsi biaya. Sangat bagus bahwa ide-ide ini sangat sukses. Apa yang tidak kita amati sejauh ini adalah sejumlah besar area kecil yang berkembang dengan baik, yang masing-masing akan mengeksplorasi ide-ide mendalamnya sendiri, yang akan menggerakkan masyarakat sipil ke berbagai arah. Oleh karena itu, menurut metrik kompleksitas sosial, pembelajaran mendalam, maaf untuk permainan kata-kata, sementara itu tetap merupakan area penelitian yang sangat dangkal. Satu orang masih mampu menguasai sebagian besar gagasan mendalam dari bidang ini.

Pada pertanyaan kedua: berapa banyak ide yang kompleks dan kuat akan dibutuhkan untuk membuat AI? Secara alami, jawabannya adalah: tidak ada yang tahu pasti. Tetapi dalam kata penutup buku ini, saya mempelajari beberapa bukti yang ada tentang hal ini. Saya menyimpulkan bahwa, bahkan menurut perkiraan optimis, penciptaan AI akan membutuhkan banyak, banyak ide mendalam. Menurut hukum Conway, untuk mencapai titik ini, kita harus melihat munculnya banyak disiplin ilmu yang saling terkait, dengan struktur yang kompleks dan tak terduga yang mencerminkan struktur ide terdalam kita. Kami belum mengamati struktur sosial yang sedemikian kompleks saat menggunakan NS dan pertahanan sipil. Oleh karena itu, saya percaya bahwa kita, setidaknya, beberapa dekade lagi dari penggunaan GO untuk mengembangkan AI tujuan umum.

Saya menghabiskan banyak upaya untuk menciptakan argumen spekulatif, yang, mungkin, tampaknya cukup jelas, dan tidak mengarah pada kesimpulan tertentu. Ini pasti akan mengecewakan orang-orang yang mencintai kepastian. Saya bertemu banyak orang daring yang secara terbuka mengumumkan pendapat mereka yang sangat pasti dan percaya diri tentang AI, sering kali didasarkan pada argumen yang goyah dan bukti yang tidak ada. Saya bisa dengan jujur mengatakan: Saya pikir ini terlalu dini untuk menilai. Seperti dalam lelucon lama: jika Anda bertanya kepada seorang ilmuwan berapa banyak lagi yang kita butuhkan untuk menunggu penemuan, dan dia berkata "10 tahun" (atau lebih), maka sebenarnya dia berarti "Saya tidak tahu". Sebelum munculnya AI, seperti dalam kasus fusi nuklir yang terkendali dan beberapa teknologi lainnya, "10 tahun" tetap ada selama lebih dari 60 tahun. Di sisi lain, apa yang pasti kita miliki di bidang pertahanan sipil adalah teknologi yang efektif, yang batasannya belum kita temukan, dan banyak tugas mendasar yang terbuka. Dan itu membuka peluang kreatif luar biasa.