Halo semuanya. Sebelum memulai kursus Pembelajaran Mesin, sedikit lebih dari satu minggu tersisa. Untuk mengantisipasi dimulainya kelas, kami telah menyiapkan terjemahan yang bermanfaat yang akan menarik bagi siswa kami dan semua pembaca blog. Mari kita mulai.

Sudah waktunya untuk menyingkirkan kotak hitam dan membangun iman dalam pembelajaran mesin!Dalam bukunya

"Interpretable Machine Learning", Christoph Molnar dengan sempurna menyoroti esensi dari interpretasi Machine Learning dengan contoh berikut: Bayangkan bahwa Anda adalah seorang ahli Ilmu Data dan di waktu luang Anda mencoba memprediksi ke mana teman-teman Anda akan pergi liburan musim panas berdasarkan data mereka dari facebook dan twitter. Jadi, jika ramalannya benar, maka teman Anda akan menganggap Anda seorang penyihir yang bisa melihat masa depan. Jika prediksi salah, maka itu tidak akan membahayakan apa pun selain reputasi Anda sebagai seorang analis. Sekarang bayangkan itu bukan hanya proyek yang menyenangkan, tetapi investasi tertarik padanya. Katakanlah Anda ingin berinvestasi di real estat tempat teman-teman Anda cenderung santai. Apa yang terjadi jika prediksi model gagal? Anda akan kehilangan uang. Selama model tidak memiliki dampak yang signifikan, interpretabilitasnya tidak terlalu berarti, tetapi ketika ada konsekuensi keuangan atau sosial yang terkait dengan prediksi model, interpretabilitasnya memiliki makna yang sangat berbeda.

Pembelajaran Mesin Dijelaskan

Menafsirkan berarti menjelaskan atau menunjukkan dalam istilah yang dapat dimengerti. Dalam konteks sistem ML, interpretabilitas adalah kemampuan untuk menjelaskan aksinya atau menunjukkannya dalam

bentuk yang dapat dibaca manusia .

Banyak orang menjuluki model pembelajaran mesin “kotak hitam”. Ini berarti bahwa terlepas dari kenyataan bahwa kami dapat memperoleh perkiraan yang akurat dari mereka, kami tidak dapat dengan jelas menjelaskan atau memahami logika kompilasi mereka. Tetapi bagaimana Anda bisa mengekstrak wawasan dari model? Hal-hal apa yang harus diingat dan alat apa yang perlu kita lakukan ini? Ini adalah pertanyaan penting yang muncul di benak ketika datang ke model interpretabilitas.

Pentingnya Interpretabilitas

Pertanyaan yang diajukan beberapa orang adalah,

mengapa tidak hanya senang bahwa kita mendapatkan hasil konkret dari pekerjaan model, mengapa begitu penting untuk mengetahui bagaimana keputusan ini atau itu dibuat? Jawabannya terletak pada kenyataan bahwa model tersebut dapat memiliki dampak tertentu pada peristiwa-peristiwa selanjutnya di dunia nyata. Interpretabilitas akan jauh lebih penting untuk model yang dirancang untuk merekomendasikan film daripada model yang digunakan untuk memprediksi efek obat.

"Masalahnya adalah bahwa hanya satu metrik, seperti akurasi klasifikasi, adalah deskripsi yang tidak memadai dari sebagian besar tugas di dunia nyata." (

Doshi Veles dan Kim 2017 )

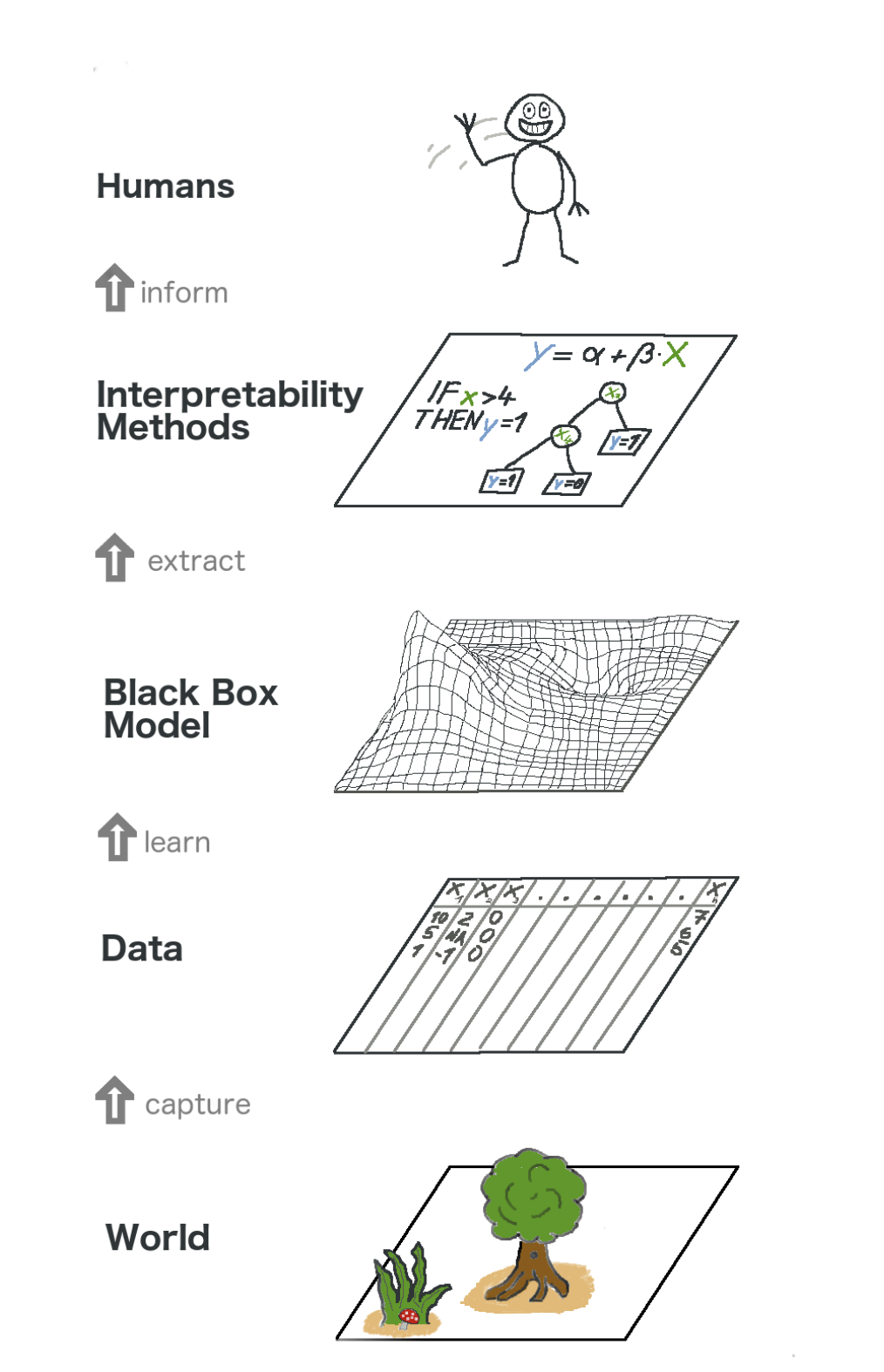

Inilah gambaran besar tentang pembelajaran mesin yang bisa dijelaskan. Dalam arti tertentu, kami menangkap dunia (atau lebih tepatnya, informasi darinya), mengumpulkan data mentah dan menggunakannya untuk prakiraan lebih lanjut. Intinya, interpretabilitas hanyalah lapisan model yang membantu orang memahami keseluruhan proses.

Teks dalam gambar dari bawah ke atas: Dunia -> Mendapatkan informasi -> Data -> Pelatihan -> Model Kotak Hitam -> Ekstrak -> Metode interpretasi -> Orang

Teks dalam gambar dari bawah ke atas: Dunia -> Mendapatkan informasi -> Data -> Pelatihan -> Model Kotak Hitam -> Ekstrak -> Metode interpretasi -> OrangBeberapa

manfaat yang dibawa interpretabilitas adalah:

- Keandalan

- Kenyamanan debugging;

- Informasi tentang fitur teknik;

- Mengelola pengumpulan data untuk karakteristik

- Informasi tentang pengambilan keputusan;

- Membangun kepercayaan.

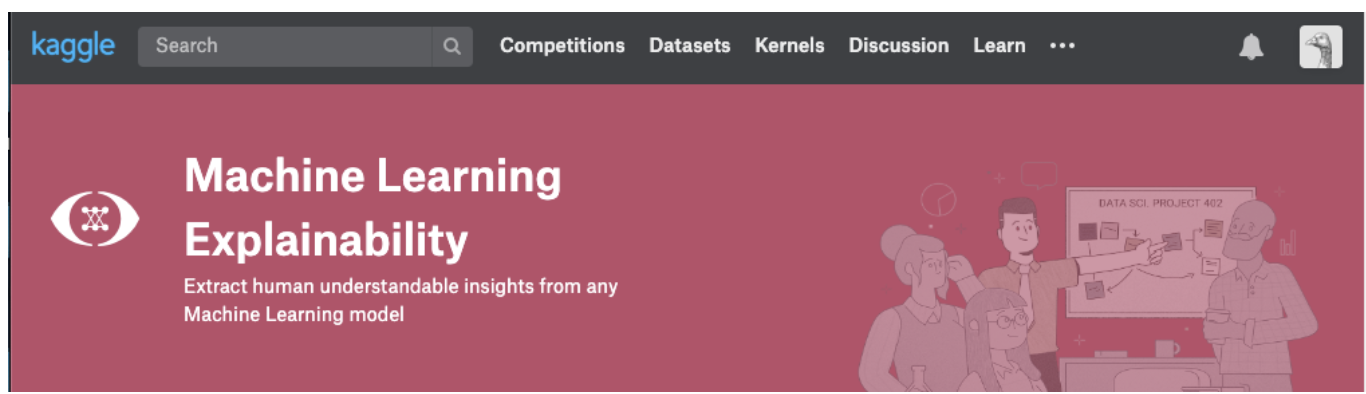

Metode Penafsiran Model

Sebuah teori masuk akal hanya selama kita bisa mempraktikkannya. Jika Anda benar-benar ingin berurusan dengan topik ini, Anda dapat mencoba mengambil kursus Penjelasan Mesin Pembelajaran dari Kaggle. Di dalamnya Anda akan menemukan korelasi yang benar antara teori dan kode untuk memahami konsep dan dapat mempraktikkan konsep interpretabilitas (penjelasan) model untuk kasus nyata.

Klik pada tangkapan layar di bawah ini untuk langsung ke halaman kursus. Jika Anda ingin mendapatkan ikhtisar topik terlebih dahulu, lanjutkan membaca.

Wawasan yang dapat diekstraksi dari model

Untuk memahami model, kita perlu wawasan berikut:

- Fitur terpenting dalam model;

- Untuk setiap perkiraan spesifik model, pengaruh setiap atribut individu pada perkiraan spesifik.

- Pengaruh setiap fitur pada sejumlah besar perkiraan yang mungkin terjadi.

Mari kita bahas beberapa metode yang membantu mengekstrak wawasan di atas dari model:

Pentingnya Permutasi

Fitur apa yang dianggap penting oleh model? Gejala apa yang paling berdampak? Konsep ini disebut pentingnya fitur, dan Permutasi Pentingnya adalah metode yang banyak digunakan untuk menghitung pentingnya fitur. Ini membantu kita melihat pada titik mana model menghasilkan hasil yang tidak terduga, itu membantu kita menunjukkan kepada orang lain bahwa model kita bekerja persis sebagaimana mestinya.

Pentingnya Permutasi berfungsi untuk banyak evaluasi scikit-learning. Idenya sederhana: Mengatur ulang secara acak atau mengacak satu kolom dalam set data validasi, membiarkan semua kolom lainnya utuh. Sebuah tanda dianggap "penting" jika keakuratan model jatuh dan perubahannya menyebabkan peningkatan kesalahan. Di sisi lain, fitur dianggap "tidak penting" jika mengocok nilainya tidak mempengaruhi keakuratan model.

Bagaimana cara kerjanya?

Pertimbangkan model yang memprediksi apakah tim sepak bola akan menerima penghargaan "Man of the Game" atau tidak, berdasarkan parameter tertentu. Penghargaan ini diberikan kepada pemain yang menunjukkan keterampilan permainan terbaik.

Pentingnya Permutasi dihitung setelah pelatihan model. Jadi, mari kita latih dan siapkan model

RandomForestClassifier , yang ditunjuk sebagai

my_model , pada data pelatihan.

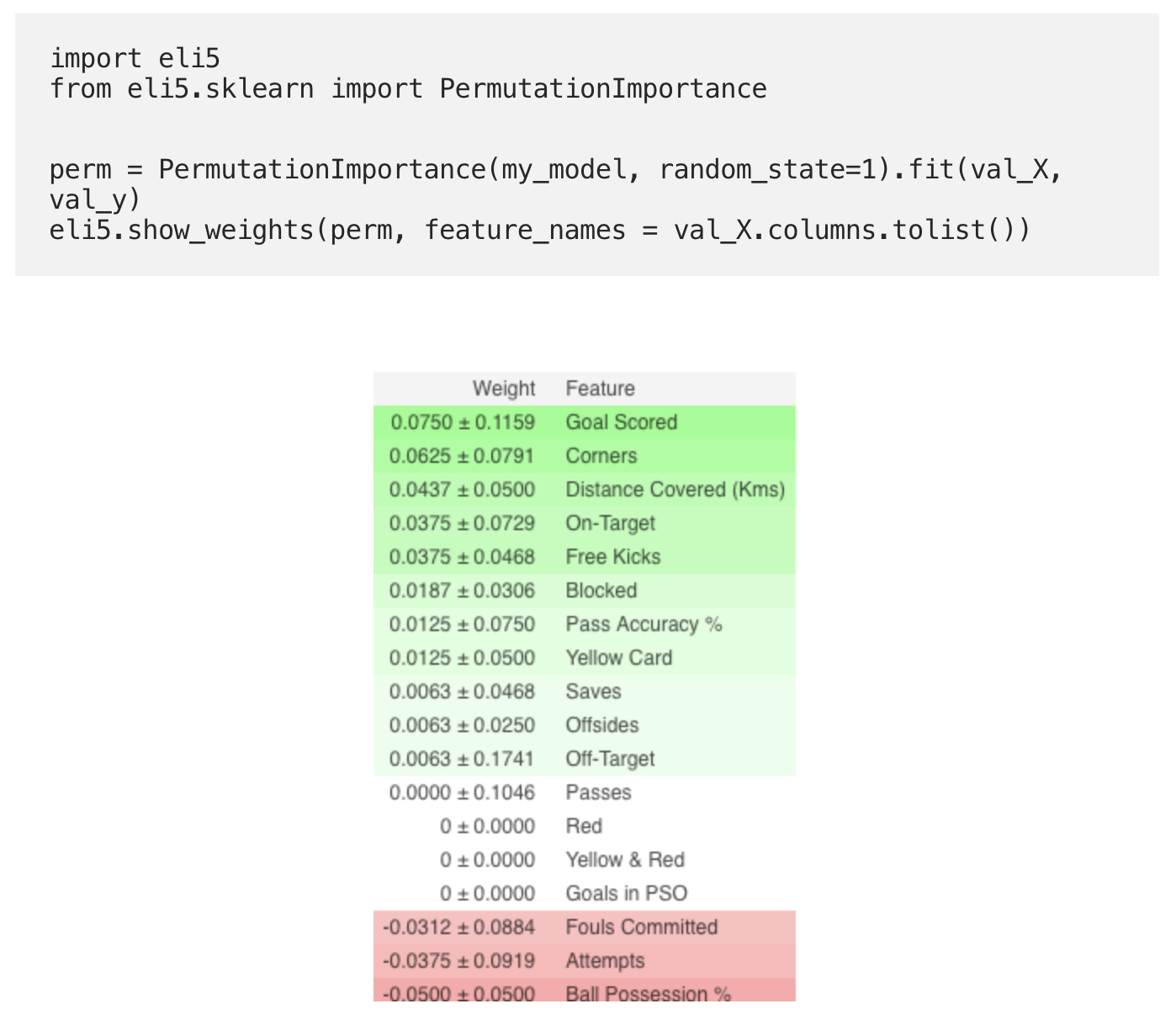

Pentingnya Permutasi dihitung menggunakan perpustakaan

ELI5 . ELI5 adalah pustaka dalam Python yang memungkinkan Anda untuk memvisualisasikan dan men-debug berbagai model pembelajaran mesin menggunakan API terpadu. Ini memiliki dukungan bawaan untuk beberapa kerangka kerja ML dan menyediakan cara untuk menafsirkan model kotak hitam.

Penghitungan dan visualisasi kepentingan menggunakan perpustakaan ELI5:

(Di sini

val_X ,

val_y menunjukkan set validasi, masing-masing)

Interpretasi

- Tanda-tanda di atas adalah yang paling penting, di bawah ini yang paling tidak. Untuk contoh ini, tanda yang paling penting adalah gol yang dicetak.

- Angka setelah ± mencerminkan bagaimana produktivitas telah berubah dari satu permutasi ke permutasi yang lain.

- Beberapa bobot negatif. Hal ini disebabkan oleh fakta bahwa dalam kasus ini ramalan untuk data yang dikocok ternyata lebih akurat daripada data aktual.

Berlatih

Dan sekarang, untuk melihat contoh lengkap dan memeriksa apakah Anda memahami semuanya dengan benar, buka halaman Kaggle menggunakan

tautan .

Jadi bagian pertama dari terjemahan berakhir. Tulis komentar Anda dan untuk bertemu di kursus!

Baca bagian kedua .