Menyadari pentingnya kecerdasan buatan, Intel mengambil langkah lain ke arah itu. Sebulan yang lalu, pada konferensi Hot Chips 2019, perusahaan secara resmi memperkenalkan dua chip khusus yang dirancang untuk pelatihan dan inferensi jaringan saraf. Chip tersebut diberi nama Intel Nervana NNP-

T (Neural Network Processor) dan Intel Nervana NNP-

I . Di bawah potongan Anda akan menemukan karakteristik dan skema produk baru.

Intel Nervana NNP-T (Spring Crest)

Waktu pelatihan jaringan saraf, bersama dengan efisiensi energi, adalah salah satu parameter utama sistem AI, yang menentukan ruang lingkup penerapannya. Kekuatan komputasi yang digunakan dalam model terbesar dan perangkat pelatihan berlipat ganda setiap tiga bulan. Pada saat yang sama, serangkaian perhitungan terbatas digunakan dalam jaringan saraf, terutama konvolusi dan perkalian matriks, yang membuka ruang lingkup besar untuk optimisasi. Idealnya, perangkat yang kita butuhkan harus seimbang dalam hal konsumsi, komunikasi, daya komputasi, dan skalabilitas.

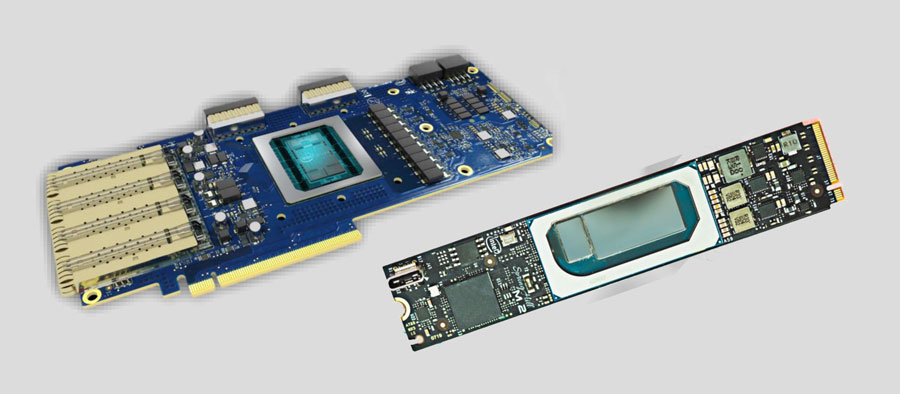

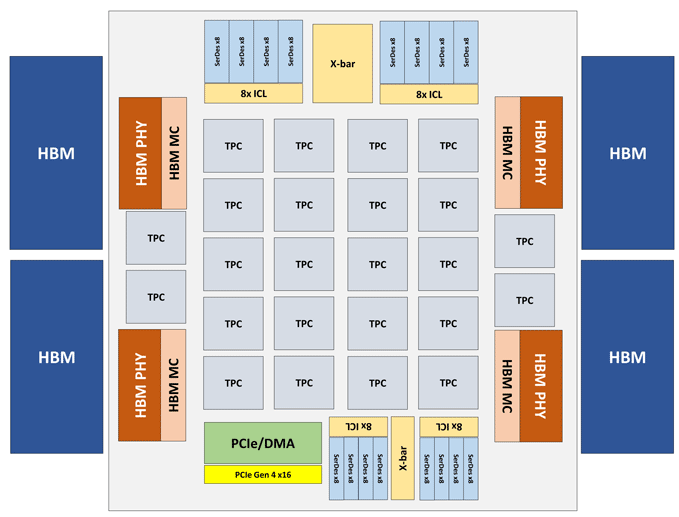

Modul Intel Nervana NNP-T dibuat dalam bentuk kartu PCIe 4.0 x16 atau OAM. Elemen komputasi NNP-T utama adalah Tensor Processing Cluster (TPC) 24-piece, yang memberikan kinerja hingga 119 TOPS. Total 32 GB memori HBM2-2400 terhubung melalui 4 port HBM. Di papan ada juga unit serialisasi / deserialisasi pada 64 baris, SPI, I2C, antarmuka GPIO. Jumlah memori yang didistribusikan pada chip adalah 60 MB (2,5 MB per TPC).

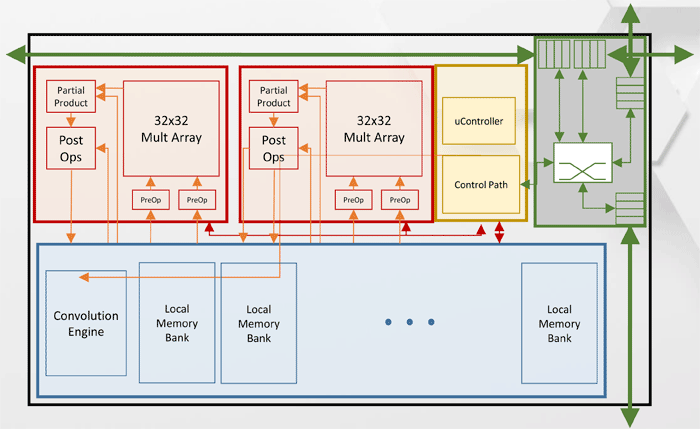

Arsitektur Tensor Processing Cluster (TPC)

Arsitektur Tensor Processing Cluster (TPC)Spesifikasi kinerja Intel Nervana NNP-T lainnya.

Seperti yang Anda lihat dari diagram, setiap TPC memiliki dua inti multiplikasi matriks 32x32 dengan dukungan BFloat16. Operasi lain dilakukan dalam format BFloat16 atau FP32. Secara total, hingga 8 kartu dapat diinstal pada satu host, skalabilitas maksimum - hingga 1024 node.

Intel Nervana NNP-I (Spring Hill)

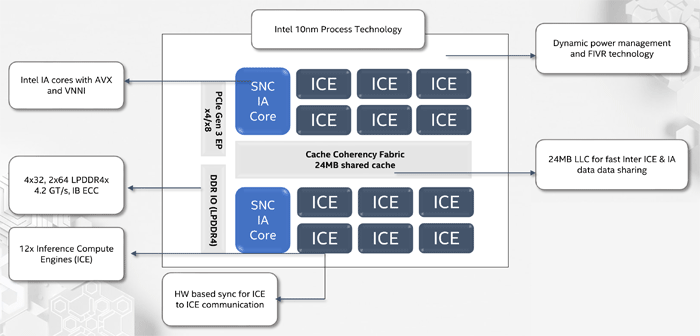

Ketika merancang Intel Nervana NNP-I, tujuannya adalah untuk memberikan efisiensi energi maksimum dengan inferensi pada skala pusat data besar - sekitar 5 TOP / W.

NNP-I adalah SoC, dibuat sesuai dengan teknologi proses 10-nm dan mencakup dua core x86 standar dengan dukungan untuk AVX dan VNNI, serta 12 core Inference Compute Engine (ICE) khusus. Kinerja maksimum adalah 92 TOR, TDP - 50 watt. Jumlah memori internal adalah 75 MB. Secara struktural, perangkat dibuat dalam bentuk kartu ekspansi M.2.

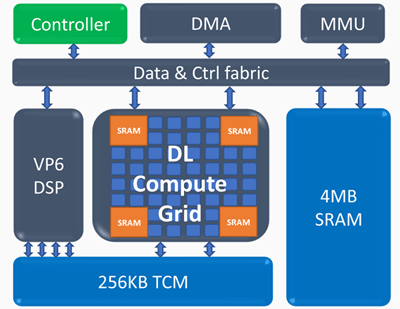

Arsitektur Inference Compute Engine (ICE)

Arsitektur Inference Compute Engine (ICE)Elemen kunci dari Mesin Hitung Inferensi:

Deep Compute Grid Computing- 4k MAC (int8) per siklus

- dukungan terukur untuk FP16, INT8, INT 4/2/1

- sejumlah besar memori internal

- operasi dan pengumpulan nonlinier

Prosesor vektor yang dapat diprogram- kinerja tinggi - 5 VLIW 512 b

- dukungan NN diperpanjang - FP16 / 16b / 8b

Indikator kinerja Intel Nervana NNP-I berikut ini diperoleh: pada jaringan ResNet 50-lapisan, kecepatan 3600 inferensi per detik dicapai dengan konsumsi energi 10 W, yaitu, efisiensi energi adalah 360 gambar per detik dalam hal Watt.