Gagasan kecerdasan buatan telah lama mengkhawatirkan umat manusia. Otomat menerima banyak perhatian dalam mitos-mitos Yunani kuno, dan contoh paling terkenal adalah Pandora wanita buatan, yang diciptakan oleh Zeus. Golem mistis ditemukan dalam budaya Yahudi. Dan boneka karakuri yang luar biasa menempati tempat penting dalam epik Jepang.

Pada abad ke-17, beberapa filsuf merenungkan kemungkinan "menempatkan pikiran" menjadi benda mati. Banyak teori telah dikemukakan. Misalnya, Rene Descartes percaya pada dualisme pikiran dan tubuh. Pandangannya menolak kemungkinan mekanisasi kecerdasan.

Leibniz memiliki pandangan lain. Dia percaya bahwa semua pemikiran manusia dapat direpresentasikan secara matematis menggunakan simbol-simbol elementer. Untuk ini, ia mengusulkan Characteristica Universalis, simbolisme konsep yang diperlukan untuk deskripsi pengetahuan.

Kecerdasan buatan dan otomat telah ditampilkan dalam fiksi sejak jaman dahulu. Contohnya adalah "Frankenstein atau Modern Prometheus" oleh Mary Shelley dan "Rossum Universal Robots" oleh Karel Chapek. Berkat mereka, pada tahun 1921 kata "robot" muncul dalam literatur.

Ini adalah prasyarat filosofis untuk munculnya AI. Sekarang mari kita bicara tentang ilmuwan tertentu dan karya-karya mereka, berkat kecerdasan buatan dari fiksi yang telah menjadi kenyataan. Cerita yang relatif konkret dan faktual mulai relatif baru-baru ini. Tes Turing yang terkenal pertama kali dilakukan pada tahun 1950, tetapi hanya enam tahun kemudian, pada tahun 1956, AI mulai terbentuk sebagai disiplin yang terpisah. Mari kita lihat bagaimana keadaannya.

Langkah pertama

Jumlah makalah ilmiah terkait kecerdasan buatan meningkat tajam pada 1950-an dan 60-an. Namun sebelumnya ada penelitian yang mempengaruhi topik ini. Bertrand Russell dan Alfred North Whitehead menerbitkan The Principles of Mathematics pada tahun 1913. Pada waktu yang hampir bersamaan, George Bull mengajukan hukum pemikirannya . Jadi dasar-dasar logika matematika diletakkan.

Mungkin itu semua bermula pada saat seorang bocah lelaki berusia 15 tahun yang tidak dapat dipahami masuk ke kantor Rudolf Karnap. Karnap kemudian sudah menjadi filsuf berpengaruh dan mengajar di University of Chicago. Ia menerbitkan Sintaks Logika Bahasa. Bocah itu datang tanpa izin, dan menunjukkan kesalahan dalam pekerjaan ini. Rudolph terkejut. Pengunjung itu tidak biasa. Selain itu, dia bahkan tidak memperkenalkan diri, dan segera melarikan diri. Setelah berbulan-bulan mencari, Rudolph akhirnya menemukan tamunya di universitas setempat. Ternyata itu Walter Harry Pitts .

Tiga tahun sebelumnya (ya, pada usia 12), Walter menulis surat kepada Bertrand Russell, menunjukkan masalah yang ditemukan dalam Prinsip-Prinsip tersebut. Russell sangat terkesan sehingga ia mengundang bocah itu untuk lulus sekolah di Universitas Cambridge di Inggris. Walter, meskipun tumbuh dalam keluarga yang disfungsional, tidak berani pindah dari Detroit. Namun, ketika Russell tiba di Chicago untuk memberikan kuliah, Pitts pulang ke rumah untuk belajar bersamanya. Dia tidak menjadi mahasiswa di University of Chicago, tetapi dia rajin menghadiri kuliah. ( Kehidupan Walter Pitts umumnya sangat cerah dan menarik, meskipun durasinya singkat. Saya sarankan membacanya sendiri - kira-kira. Penerjemah ).

Pada tahun 1942, Walter Pitts bertemu dengan Warren McCallock . McCullock mengundang Pitts untuk tinggal di rumahnya. Mereka diyakinkan tentang kebenaran teori Leibniz , yang menyarankan kemungkinan "mekanisasi" pemikiran manusia. Dan mereka mencoba membuat model untuk neurobiologi sistem saraf manusia. Mereka menerbitkan artikel utama mereka yang sama pada tahun 1943, menyebutnya " Kalkulus ide yang logis terkait dengan aktivitas saraf ." Dokumen ini telah memberikan kontribusi yang tak ternilai bagi bidang kecerdasan buatan. Para ilmuwan telah mengusulkan model sederhana yang dikenal sebagai neuron matematika McCullock-Pitts . Dia masih belajar di kursus pembelajaran mesin. Gagasan yang diajukan para ilmuwan adalah dasar dari hampir semua AI modern.

Warren McCallock dan Walter Pitts

Sibernetika Norbert Weiner dan teori informasi Claude Shannon diterbitkan pada tahun 1948. Sibernetika adalah studi tentang "kontrol dan komunikasi dalam organisme hidup dan dalam mesin." Teori informasi adalah pengukuran jumlah informasi, penyimpanan dan pengirimannya. Keduanya bekerja memiliki dampak besar pada AI.

Sibernetika memberikan studi langsung tentang kecerdasan biologis dan mekanik. Dan teori informasi telah mempengaruhi matematika dasar.

Setelah beberapa tahun, Alan Turing melakukan tes Turing . Dia menjelaskan metode untuk menentukan apakah mesin itu pintar. Tes yang disederhanakan adalah sebagai berikut: seseorang berkomunikasi dengan satu komputer dan satu orang. Berdasarkan jawaban mereka atas pertanyaan, ia harus menentukan dengan siapa ia berbicara: seseorang atau program komputer. Tugas program komputer adalah menyesatkan seseorang, memaksanya untuk membuat pilihan yang salah. "

Meskipun tes Turing terlalu terbatas untuk menguji sistem cerdas modern, itu adalah terobosan nyata pada saat itu. Nama Alan Turing menekan pers, membuat industri ini lebih populer.

Tes turing

Pada tahun 1956, sebuah konferensi diadakan di Dartmouth dengan topik mempelajari konsep "mekanisasi" kecerdasan. Nantinya, peserta dalam konferensi ini akan menjadi kepribadian yang luar biasa di bidang AI. Yang paling terkenal adalah Marvin Minsky , yang pada tahun 1951 menciptakan mesin jaringan saraf pertama, SNARC. Ia akan menjadi nama paling terkenal di dunia kecerdasan buatan dalam beberapa dekade mendatang.

Claude Shannon juga menghadiri konferensi. Dan calon pemenang Nobel Herbert A. Simon dan Allen Newell membuat debut mereka dengan " Logic-Theorist " mereka. Selanjutnya, ia akan menyelesaikan 38 dari 52 teorema pertama dalam Russell's Principles of Mathematics.

John McCarthy - juga salah satu pelopor kecerdasan buatan - menciptakan nama "Kecerdasan Buatan." Peserta setuju dengan istilah ini. Ini adalah kelahiran AI.

Pengembangan Industri (1956–1974)

Jaringan semantik

Berkat konferensi ini, minat terhadap AI telah tumbuh, dan banyak perkembangan menarik telah muncul. Pada tahun 1959, Newell dan Simon menciptakan "Common Problem Solver," yang secara teoritis dapat menyelesaikan masalah formal apa pun. Dan James Slagle menciptakan program heuristik SAINT (Symbical Automatic INTegrator) yang memecahkan masalah integrasi simbolik dalam kalkulus. Program-program ini sangat mengesankan.

Setelah membuat tes Turing, kealamian bahasa telah menjadi area penting AI. Program SISWA Daniel Bobrow mampu memecahkan masalah kata di sekolah menengah. Beberapa saat kemudian, konsep jaringan semantik muncul - peta berbagai konsep dan hubungan di antara mereka (seperti pada gambar). Beberapa program yang berhasil telah dibangun di jaringan ini. Pada tahun 1966, Joseph Weisenbaum menciptakan ELIZA. Lawan bicara virtual dapat melakukan percakapan realistis dengan orang-orang.

Sehubungan dengan perkembangan aktif industri AI, para ilmuwan membuat pernyataan yang sangat berani:

- Newell dan Simon, 1958: "Dalam 10 tahun, komputer digital akan menjadi juara catur dunia." Dan "dalam 10 tahun, komputer digital akan menemukan dan membuktikan teorema matematika baru yang penting."

- Simon GA, 1965: "Mesin akan mampu melakukan pekerjaan apa pun yang dapat dilakukan seseorang selama 20 tahun."

- Marvin Minsky, 1967: "Dalam satu generasi ... masalah menciptakan" kecerdasan buatan "akan banyak terpecahkan."

- Marvin Minsky, 1970: "Dalam tiga hingga delapan tahun, kita akan memiliki mesin dengan kecerdasan umum dari orang biasa."

Dengan satu atau lain cara, uang masuk ke industri. Office of Advanced Research Projects (ARPA, yang kemudian berganti nama menjadi DARPA) mengalokasikan $ 2,2 juta untuk tim MIT. Presiden DARPA saat itu memutuskan bahwa mereka harus “membiayai orang, bukan proyek,” dan menciptakan budaya penelitian gratis. Ini memungkinkan para peneliti untuk melakukan proyek apa pun yang mereka anggap benar.

Pendinginan Sementara (1974-1980)

Pada tahun 1969, Marvin Minsky dan Seymour Papert menerbitkan buku Perceptrons mereka . Di dalamnya, mereka menunjukkan keterbatasan mendasar dari perceptrons dan menyoroti ketidakmampuan perceptrons untuk mengendalikan skema dasar XOR. Hal ini menyebabkan pergeseran minat peneliti kecerdasan buatan ke bidang komputasi simbolik, yang berlawanan dengan jaringan saraf.

Pendekatan alternatif AI simbolis memperoleh pertumbuhan eksplosif. Tetapi pendekatan ini tidak membuahkan hasil yang signifikan. Pada 1970-an, menjadi jelas bahwa peneliti AI terlalu optimis tentang AI. Tujuan yang mereka janjikan belum tercapai dan pencapaian mereka tampaknya menjadi masalah masa depan yang sangat jauh.

Para peneliti menyadari bahwa mereka bersandar di dinding. AI diterapkan untuk tugas-tugas sederhana. Tapi skenario sebenarnya terlalu rumit untuk sistem ini. Jumlah kemungkinan yang harus dieksplorasi oleh algoritma ternyata bersifat astronomi. Hal ini menyebabkan masalah ledakan kombinatorial . Dan kemudian muncul pertanyaan klasik "bagaimana membuat komputer pintar". Itu masalah akal sehat .

Semua ini mengarah pada fakta bahwa investor kecewa dengan teknologi. Dengan demikian pendanaan AI telah hilang, dan penelitian telah berhenti. DARPA juga tidak bisa lagi mendukung budaya penelitian peretas karena perubahan undang-undang. Sponsor telah membekukan dana untuk penelitian di bidang kecerdasan buatan. Karena itu, periode 1974-1980. disebut " AI musim dingin ."

Kelahiran kembali

Pada 1981, pemerintah Jepang mulai serius berinvestasi dalam penelitian di bidang kecerdasan buatan. Negara ini mengalokasikan $ 850 juta untuk proyek komputer generasi kelima. Dia bertujuan mengembangkan AI. Komputer yang dituduhkan harus berkomunikasi, menerjemahkan bahasa lain, mengenali gambar. Diharapkan komputer akan menjadi dasar untuk menciptakan perangkat yang dapat mensimulasikan pemikiran.

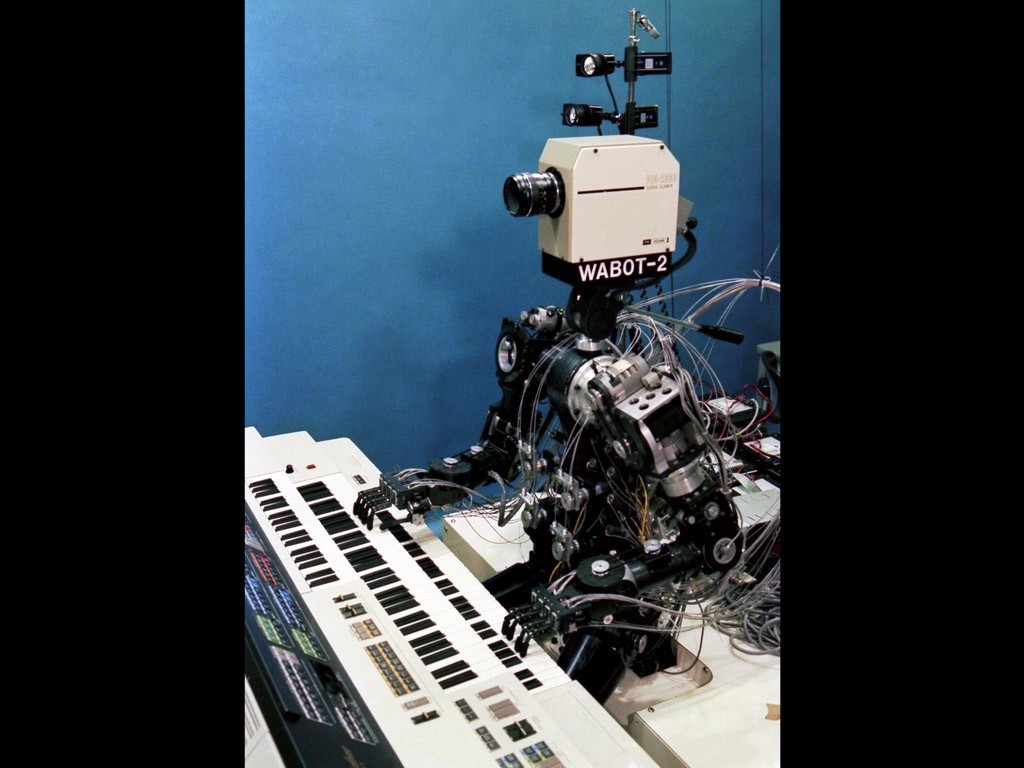

Wabot-2

Penelitian di Jepang tampak menjanjikan. Pada tahun 1980, robot Wabot-2 dikembangkan di Universitas Waseda. Dia dapat berkomunikasi dengan orang-orang, membaca skor musik dan memainkan organ elektronik. Keberhasilan Jepang telah memaksa pemerintah lain dan bisnis swasta untuk mengalihkan pandangan mereka ke arah AI lagi.

Pada titik ini, muncul pertanyaan tentang koneksionisme. Pada tahun 1982, Hopfield menciptakan bentuk baru jaringan saraf yang mampu mempelajari dan memproses informasi. Jeffrey Hinton dan David Rumelhart mempopulerkan pembalikan diri. Teknologi ini sangat fenomenal dan tetap vital dalam pembelajaran mesin hingga hari ini.

AI memperoleh kesuksesan komersial dalam bentuk "sistem pakar". Sistem ini memiliki pengetahuan yang mendalam tentang topik tertentu. Carnegie Mellon University (CMU) meluncurkan sistem pakar yang disebut XCON pada 1980. Itu digunakan di Digital Equipment Corporation. Hingga 1986, perusahaan menghemat $ 40 juta per tahun.

Musim dingin kedua

Revolusi PC telah mengubah arah pengembangan AI

Pada akhir 1980-an, keberhasilan industri AI dibayangi oleh revolusi komputer. Apple dan IBM menghasilkan semakin banyak komputer yang kuat pada saat yang bersamaan. Komputer desktop menjadi lebih murah dan lebih kuat daripada mesin Lisp kecerdasan buatan. Seluruh industri senilai setengah miliar dolar hancur dalam satu malam. Keberhasilan AI dalam sistem pakar seperti mesin XCON telah terbukti terlalu mahal.

Ada masalah dengan sistem pakar. Mereka tidak bisa belajar. Mereka "rapuh" (yaitu, mereka bisa membuat kesalahan serius jika mereka diberi data yang tidak biasa). Ruang lingkup praktis sistem pakar menjadi terbatas. Kepemimpinan DARPA yang baru telah memutuskan bahwa AI bukanlah "gelombang berikutnya." Dan investasi diarahkan ke proyek-proyek yang, dari sudut pandang mereka, harus membawa hasil langsung.

Pada 1991, tujuan proyek komputer di Jepang belum tercapai. Para ilmuwan meremehkan kesulitan yang harus mereka hadapi. Lebih dari 300 perusahaan AI ditutup, bangkrut, atau dibeli pada akhir tahun 1993. Sebenarnya itu adalah akhir dari gelombang pertama penggunaan kecerdasan buatan secara komersial.

Aliran segar

Ketika gema revolusi komputer mulai mereda, orang memiliki kesempatan untuk menggunakan kekuatan komputasi yang besar. Dengan keberadaan komputer di mana-mana, jumlah basis data yang beragam telah bertambah. Itu semua sangat keren dalam hal pengembangan AI.

Teknologi baru memecahkan masalah dan menghilangkan hambatan yang mengganggu ilmuwan. Dengan menggunakan daya komputasi yang meningkat, para peneliti mendorong batas-batas yang mungkin. Dari basis data yang menjadi Big Data, dimungkinkan untuk menggali lebih banyak dan lebih banyak pengetahuan. Kemungkinan untuk penggunaan praktis AI telah menjadi lebih jelas.

Konsep baru yang disebut " agen cerdas " didirikan pada 1990-an. Agen Cerdas (IA) adalah sistem yang secara independen melakukan tugas yang dikeluarkan oleh pengguna untuk jangka waktu yang lama. Ada harapan bahwa suatu hari kita akan dapat mengajar IA untuk berinteraksi satu sama lain. Ini akan mengarah pada penciptaan sistem universal dan lebih "pintar".

Dalam komunitas AI, pendapat berbeda tentang penggunaan matematika di bidang kecerdasan buatan berkeliaran. Beberapa orang berpikir bahwa kecerdasan itu terlalu rumit untuk digambarkan dengan simbol-simbol matematika. Menurut pendapat mereka, orang jarang dibimbing oleh logika ketika membuat keputusan. Lawan mereka keberatan bahwa rantai logis adalah jalan ke depan.

G. Kasparov bermain dengan Deep Blue

Segera, pada tahun 1997, superkomputer IBM Deep Blue mengalahkan Garry Kasparov. Pada saat itu, Kasparov adalah juara catur dunia. Apa, menurut Newell dan Simon, yang seharusnya terjadi pada 1968, akhirnya terjadi pada 1997.

Komputer catur modern jauh lebih kuat daripada siapa pun. Peringkat Elo tertinggi yang pernah dicapai oleh manusia adalah 2.882. Untuk komputer, angka paling umum adalah 3.000 Elo. Tertinggi yang pernah dicatat adalah lebih dari 3.350.

Pada 2005, Stanford mengembangkan robot untuk mengemudi secara otonom. Dia memenangkan DARPA Grand Challenge dengan mengendarai 131 mil (211 km) di sepanjang jalur gurun yang belum dijelajahi.

Berbahaya

Pada bulan Februari 2011, IBM memutuskan untuk menguji IBM Watson dalam kuis Jeopardy. Komputer mampu mengalahkan dua juara terbesar Jeopardy dengan selisih yang signifikan.

Dengan perkembangan Internet dan jejaring sosial yang seperti longsoran salju, jumlah informasi telah bertambah. Perusahaan IT perlu melakukan sesuatu dengan data yang mereka terima. Dan penggunaan AI telah menjadi kebutuhan, bukan hiburan.

Sekarang Google mengurutkan SERP menggunakan Machine Learning. YouTube memilih video yang direkomendasikan menggunakan algoritma ML, merekomendasikan produk Amazon dengan cara yang sama. Umpan berita Facebook dihasilkan oleh komputer pintar. Dan bahkan Tinder menemukan orang menggunakan algoritma ML.

Berkat revolusi komputer, teknologi AI telah menjadi alat yang sangat diperlukan. Dan sekarang manusia melihat ke depan, menunggu penciptaan mesin super. Dan meskipun efek kecerdasan buatan terkadang kontroversial, pengembangan lebih lanjut dari teknologi ini tidak bisa dihindari.

Apa lagi yang berguna untuk dibaca di blog Cloud4Y

→ Komputer akan membuat Anda enak

→ AI membantu mempelajari hewan di Afrika

→ Musim panas hampir berakhir. Hampir tidak ada data yang bocor

→ 4 cara untuk menghemat cadangan di cloud

→ IoT, kabut dan awan: bicara tentang teknologi?

Berlangganan saluran Telegram kami agar tidak ketinggalan artikel lain! Kami menulis tidak lebih dari dua kali seminggu dan hanya untuk bisnis.