O algoritmo DeepStereo cola fotos do Google Street View em vídeo suave

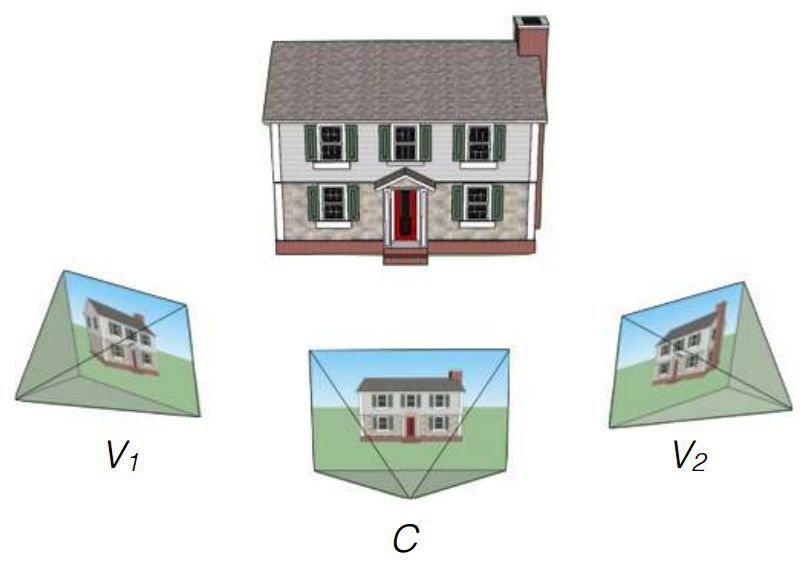

Os pesquisadores do Google John Flynn, Ivan Nyulander, James Filbin e Noah Sneyvli criaram um algoritmo que pode combinar imagens do serviço de exibição panorâmica do Street View em vídeos suaves com artefatos quase imperceptíveis. O algoritmo é chamado DeepStereo, um exemplo de sua operação é apresentado acima. O provável uso da tecnologia criada inclui a criação de animações simples, processamento de imagem, cinema e realidade virtual.Nem sempre é possível avaliar adequadamente um determinado local apenas por mapas ou fotografias digitais. Olhe para a rua de uma altura acima da altura humana e ajude serviços como o Google Street View. Mas essas são fotos coladas no panorama, não vídeos.Se você precisar criar uma animação para avançar a partir de fotos individuais, a decisão de simplesmente perder a sequência de imagens não funcionará - será muito rápida, porque as imagens serão alteradas a uma frequência de pelo menos 24 quadros por segundo. Se você dirige por uma estrada larga ou plana, você pode criar uma boa animação no estilo de câmera lenta. Mas o Google Street View tem panoramas de museus e ruas ornamentadas - o lapso de tempo de uma rápida mudança de quadro não funcionará aqui. Precisa de imagens ausentes entre as fotos. O algoritmo criado está envolvido nisso.A equipe de pesquisadores usou o amplo conhecimento da empresa no treinamento do algoritmo. Na entrada, há um conjunto de imagens de alguns pontos, e o objetivo é criar novos quadros a partir de outros pontos. A solução exata para esse problema requer a construção de um modelo de ambiente 3D, o que geralmente é impossível devido a obstáculos. O desafio não é novo. Alguns métodos anteriores apresentam problemas que levam a lacunas próximas às barreiras, apelidos e desfocagem. Dificuldades particulares são causadas por árvores e outros objetos cujos elementos individuais podem obscurecer a vista. O novo método de Flynn usa treinamento em visão computacional para que ele possa entender quais objetos devem estar nos quadros ausentes. Para o treinamento, foram utilizados conjuntos de imagens de um carro em movimento. Os pesquisadores dizem que o volume da base de treinamento totalizou 100 mil conjuntos de imagens.Em seguida, o teste foi realizado usando sequências de três fotos do Google Street View. O algoritmo foi forçado a processar duas imagens extremas e apresentar uma variante do intermediário. Comparação com o original permitido avaliar o trabalho.O resultado final da equipe DeepStereo é credível. À primeira vista, não é tão fácil distinguir da fotografia real. Artefatos notáveis incluem uma leve perda de resolução e o desaparecimento de estruturas finas em primeiro plano. Objetos com uma estrutura complexa que se sobrepõe a seus próprios detalhes podem parecer borrados. O algoritmo também não é capaz de criar superfícies que não estão nas imagens originais. Objetos em movimento (pedestres, carros) são intencionalmente desfocados para criar um efeito de movimento.É necessário um poder de computação impressionante para a renderização. Para criar apenas uma imagem com uma resolução de 512 × 512 pixels, são necessários aproximadamente 12 minutos de operação de um sistema multinúcleo com características técnicas não nomeadas. Criar imagens de alta resolução requer muita RAM. Os pesquisadores expressam suas esperanças de otimizar o algoritmo com a possibilidade de reduzir o tempo de renderização para vários minutos ou até segundos ao usar processadores de placas de vídeo. No futuro, com refinamento significativo, o funcionamento do algoritmo na GPU é possível mesmo em tempo real.Com base no texto do estudo e na MIT Technology Review . arXiv: 1506.06825 [cs.CV]

O novo método de Flynn usa treinamento em visão computacional para que ele possa entender quais objetos devem estar nos quadros ausentes. Para o treinamento, foram utilizados conjuntos de imagens de um carro em movimento. Os pesquisadores dizem que o volume da base de treinamento totalizou 100 mil conjuntos de imagens.Em seguida, o teste foi realizado usando sequências de três fotos do Google Street View. O algoritmo foi forçado a processar duas imagens extremas e apresentar uma variante do intermediário. Comparação com o original permitido avaliar o trabalho.O resultado final da equipe DeepStereo é credível. À primeira vista, não é tão fácil distinguir da fotografia real. Artefatos notáveis incluem uma leve perda de resolução e o desaparecimento de estruturas finas em primeiro plano. Objetos com uma estrutura complexa que se sobrepõe a seus próprios detalhes podem parecer borrados. O algoritmo também não é capaz de criar superfícies que não estão nas imagens originais. Objetos em movimento (pedestres, carros) são intencionalmente desfocados para criar um efeito de movimento.É necessário um poder de computação impressionante para a renderização. Para criar apenas uma imagem com uma resolução de 512 × 512 pixels, são necessários aproximadamente 12 minutos de operação de um sistema multinúcleo com características técnicas não nomeadas. Criar imagens de alta resolução requer muita RAM. Os pesquisadores expressam suas esperanças de otimizar o algoritmo com a possibilidade de reduzir o tempo de renderização para vários minutos ou até segundos ao usar processadores de placas de vídeo. No futuro, com refinamento significativo, o funcionamento do algoritmo na GPU é possível mesmo em tempo real.Com base no texto do estudo e na MIT Technology Review . arXiv: 1506.06825 [cs.CV] Source: https://habr.com/ru/post/pt381787/

All Articles