Decidimos tentar na prática uma nova tendência na comunidade de TI, a saber, armazenamento definido por software. Pedimos aos nossos maravilhosos fornecedores um campo de testes.Configuração do suporte:

Pedimos aos nossos maravilhosos fornecedores um campo de testes.Configuração do suporte:- 3 servidores SuperMicro X9SCL / X9SCM da seguinte configuração:

- Processador Intel E3-1220V2: 4 núcleos x 3,1 GHz

- RAM - 16 Gb

- Adaptador Adaptec 6405E RAID: SAS de 2x300GB 10K, SSD de 1x180GB - todas as unidades devem ser configuradas no modo JBOD

- 2x500GB SATA 7.4K conectado aos conectores no tapete. placa de circuito

- NIC 2x1GB

Atualmente, existem muitas soluções de SAN virtual, o Starwind VSAN caiu devido a limitações significativas da versão gratuita, o que matou todos os recursos interessantes, o VMWARE VSAN caiu devido a requisitos de hardware e alto custo de propriedade, o que não é ideal para pequenos orçamentos regionais, bem como pelo fato de que aqueles. Os especialistas em VMWARE à margem não recomendam o uso do VSAN para aplicativos críticos para os negócios. Como resultado, escolhemos uma solução da Nutanix e EMC ScaleIO.O ScaleIO é uma SAN virtial definida por software da EMC, pode funcionar no modo livre sem quase nenhuma restrição (escrita na licença para uso que não seja de produção!) - o único fator menos grave é que este sistema não possui mecanismos internos para armazenamento automático de dados ou armazenamento em cache, eu uso discos SSD. concorrentes aos quais o SSD oferece uma vantagem séria na velocidade das máquinas virtuais). Arquitetonicamente, ele se parece muito com o sistema de armazenamento IBM XIV corporativo de ponta - até o tamanho do bloco é o mesmo - 1 MB.Li requisitos mínimos contraditórios em diferentes fontes:- Estes são os requisitos mínimos do sistema para uma implementação do ScaleIO 1.31 e 1.32:

- As soluções ScaleIO 1.31 e 1.32 são suportadas apenas no ESXi 5.5 GA.

- Três servidores ESXi com 100 GB de capacidade livre por servidor

- Rede de 1 gbps

- Quatro discos SATA de 7.200 rpm por nó

No entanto, na prática, para a versão 1.32, essas restrições não foram atendidas.Devido ao fato de que na produção usamos o VMWARE racialmente correto e não gostamos do Hyper-V não ortodoxo, selecionamos a versão de avaliação do VMWARE ESXi 6.0 para implantação como hipervisor. Por uma questão de justiça, note-se que o ScaleIO funciona bem nos seguintes hipervisores XEN, ESXi, Hyper-V; neste último, com a ajuda do Windows 2012 r2, os artesãos contornaram a falta de armazenamento em cache do array SSD usando as ferramentas incorporadas em 2012 R2, que obviamente tiveram um impacto positivo no desempenho do sistema. (existe uma técnica na internet)ESXi appliance VCENTER VMWARE. — ESXi Adaptec 6405E, VMWARE HCL.

Adaptec (Offline-Bundles and VIB) VMWARE VMWARE powercli

— .

VCENTER appliance vmware powercli ScaleIO datastore ScaleIO .ova ( ScaleIO).

ScaleIO.

:

— protection domain storage pool',

— storage pool' (, HDD SSD, )

— , FaultSets, . , ZeroPadding Policy, RAM Cache policy , Spare policy.

ScaleIO SSD ! . SSD , flash-only pool — !

read\write cache RAID , , RAM CACHE, protection domain, ! ( 16GB RAM 1.3GB , )

2 VLAN: management data, 4- ( ) SVM (SVM — ScaleIO Virtual Machine) management IP DATA IP . ( , 10 ).

4 SVM 3- (SVM — ScaleIO Virtual Machine), 8cpu ( 2 : 2 4 vcpu), 12Gb .

SVM node1 — primary mdm, sds, sdc

SVM node2 — secondary mdm, sds, sdc

SVM node3 — tie breaker, sdc

SVM — gateway — ( , , maintenance)

mdm — Meta Data Manager —

sds — ScaleIO data server — RDM VMWARE (raw disk mapping)

sdc — ScaleIO data client — VMWARE . , ScaleIO , SVM.

, SDC , ScaleIO VMWARE LUN datastore, iSCSI.

, VLAN IP SVM. :

Failed: Add SDS device ScaleIO-4c1885e7 to Storage Pool hdds (ScaleIO — Timeout)

. , — retry. , SVM 2 :

Failed: Add SDS device ScaleIO-4c1885eb to Storage Pool hdds (ScaleIO — The SDS is already attached to this MDM)

… , SVM, secondary mdm, - RDM , SDS. .

«deploy scaleio environment» , , , , VLAN IP , .

volume . GUI: GUI dashboard windows, GUI VMWARE, - Gateway. cli — .

— volume GUI VMWARE.

, ! «» . storage pool HDDs ( 6 SAS 3- ) total capacity limit 1.6B ( 6300GB), volume c … . , CLI . SSH MDM SVM — :

ScaleIO-10-1-4-203:~ # scli --query_storage_pool --protection_domain_name pd2 --storage_pool_name hdds

Error: MDM failed command. Status: Invalid session. Please login and try again.

O que?Eu tento no segundo MDM: o erro é algo como não é possível conectar o host local: 6611No gateway, geralmente dizia que não existem comandos desse tipo. Tudo é um estupor! Não está claro como usar a CLI.Estudamos cuidadosamente o guia do usuário no ScaleIO, especialmente sobre os princípios básicos da CLI, e ele diz na parte inferior que você precisa fazer login adicional na CLI e na data do link, como fazê-lo, mas é necessário:ScaleIO-10-1-4-203:~

Enter password:

E depois disso, todas as equipes de CLI começaram a trabalhar maravilhosamente.scli --query_storage_pool --protection_domain_name pd2 --storage_pool_name hdds

Storage Pool hdds (Id: 574711eb00000000) has 0 volumes and

544.0 GB (557056 MB) available for volume allocation

Background device scanner: Disabled

Zero padding is disabled

Spare policy: 34% out of total

Uses RAM Read Cache

RAM Read Cache write handling mode is 'cached'

1.6 TB (1667 GB) total capacity

1.1 TB (1100 GB) unused capacity

567.1 GB (580708 MB) spare capacity

Espere o que? o volume disponível no nosso caso é 544GB ?! Quão? Por quê? É necessária uma explicação da arquitetura de armazenamento aqui (veja a captura de tela): ou seja, volume total do pool de armazenamento bruto denominado HDDs: 1,6 TB menos 567,1 GB de capacidade sobressalente = 1,1 TB de capacidade não utilizada. A capacidade de reposição é determinada pelo parâmetro Política de reposição nas configurações. De acordo com as recomendações da documentação, para proteção completa contra falhas de um nó, é necessário que a Capacidade de Armazenamento seja pelo menos 1 \ N do volume total de todos os discos físicos de todos os nós incluídos no conjunto de armazenamentos, em que N é o número de nós que estão no conjunto (ou seja, e se tivermos 3 nós com discos nesse pool de armazenamento, a capacidade disponível no nosso caso será de 1 \ 3 de 1,6 TB (do volume total), respectivamente 567,1 GB (580708 MB).

ou seja, volume total do pool de armazenamento bruto denominado HDDs: 1,6 TB menos 567,1 GB de capacidade sobressalente = 1,1 TB de capacidade não utilizada. A capacidade de reposição é determinada pelo parâmetro Política de reposição nas configurações. De acordo com as recomendações da documentação, para proteção completa contra falhas de um nó, é necessário que a Capacidade de Armazenamento seja pelo menos 1 \ N do volume total de todos os discos físicos de todos os nós incluídos no conjunto de armazenamentos, em que N é o número de nós que estão no conjunto (ou seja, e se tivermos 3 nós com discos nesse pool de armazenamento, a capacidade disponível no nosso caso será de 1 \ 3 de 1,6 TB (do volume total), respectivamente 567,1 GB (580708 MB)., 1.1TB storage pool volume. ScaleIO 2 , 1.1TB 2 , volume 544.0 GB.

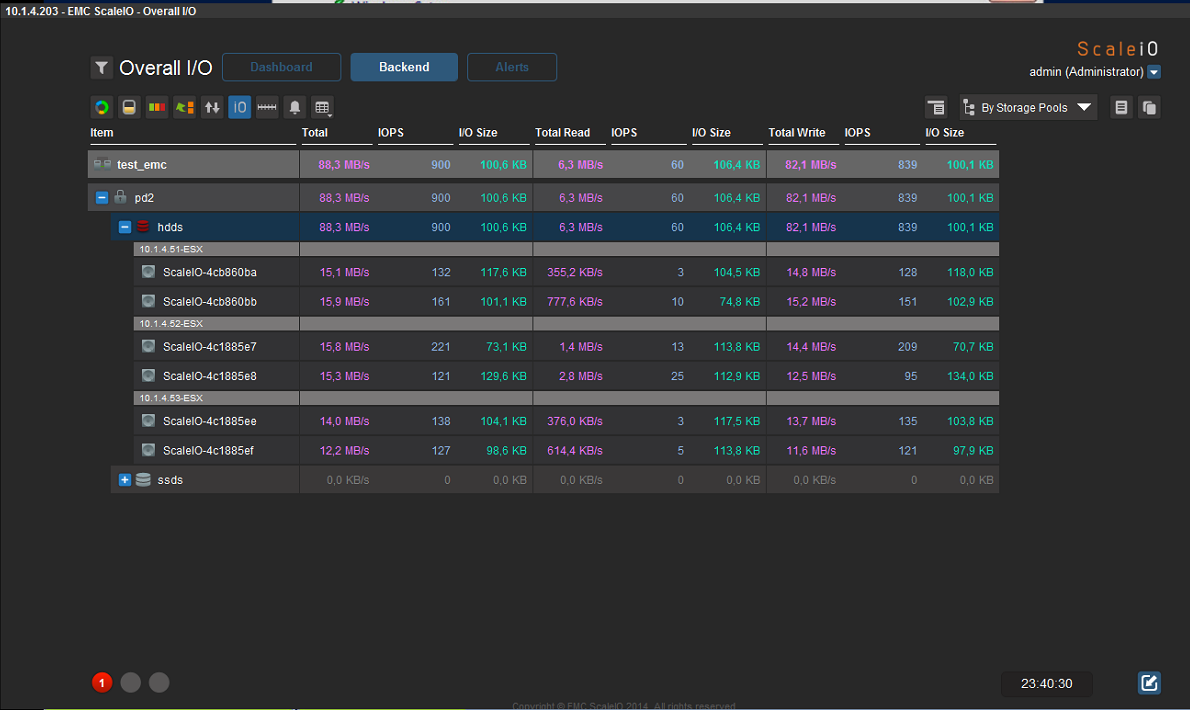

( 85-130\, , , IOPS):

Nutanix Comminity Edition 4.5 — non-commercial

Nutanix Comminity Edition 4.5 — non-commercialNutanix, , … . Nutanix hypervisor ( VMWARE Vcenter) «», NFS high-availability.

, ESXi . Community Edition, :

— 4

— 4 ( SSD, 18 TB (3 x 6 TB HDDs))

— Intel c VT-x 4

— Advanced Host Controller Interface (AHCI) SATA

— LSI IT mode (Nutanix testing shows better performance than IR)

— 16 GB ( 32 GB — 16 )

— SSD 200 GB

— SSD 300GB ( 400,480)

ADAPTEC 6405E SAS Nutanix, SAS ( SATA SSD . ).

: — 8GB ( 8GB, 16, hypervisor KVM (Acropolis) CVM — control virtual machine — !), CVM .

:

— 16

— 2 HDD SATA 500GB

— 1 SSD 500GB

— 24GB + 300GB SSD , .

…

Community Edition — KVM — , VMWARE ESXi.

(CVM — control virtual machine), 2 12 — .

: StorageContainer Replication Factor 2, 50% ( , 3 , 2 SATA 500 , 6 + SSD 2.88 TB 1.44 TB ).

Após a criação, o conjunto de discos é acessível e entregue via NFS: por exemplo, ele se conectou perfeitamente ao cluster VMWARE 5.5 como um armazenamento de dados, respectivamente, o storage vmotion também funciona, embora a velocidade seja muito mais lenta em comparação com o FC 4Gb \ seg (é compreensível com uma conexão de gigabit - era interessante dirigiria em 10G ou infinibanda).Uma máquina ativa de 60 GB do cluster VMWARE foi movida cerca de 24 minutos para o armazenamento da Nutanix. Ele retornou 13 minutos para o armazenamento FC no nível corporativo.Gravando o arquivo iso do servidor Windows na máquina virtual vmware, localizada no armazenamento nutanix via nfs (1Gb / s) - 34MB / s.Não há ferramenta interativa para gerenciar portgroups e vswitch - tudo é feito a partir do cli.: . Nutanix VLAN, . VLAN — , — , GUI ! .

Windows guests CDROM VirtIO ( ( iso ):

fedoraproject.org/wiki/Windows_Virtio_Drivers#Direct_download)

O tempo de instalação do vm convidado no Windows 2012 R2 foi de apenas 7 minutos desde o início até a carga total do sistema em funcionamento, a máquina virtual funciona visualmente também rapidamente - obviamente, a SSD ajuda.Você pode colocar uma máquina virtual no tipo de cortroler de disco virtual IDE (sem conectar os drivers VirtIO), mas essa não é uma configuração recomendada - o desempenho será muito menor.Durante uma falha na energia de teste de um dos hosts do cluster, a HA funcionou, o sistema não travou, os recursos de disco estão acessíveis na rede e localmente, as máquinas virtuais que estavam no host desconectado foram reiniciadas em outros hosts (se houver memória suficiente),no entanto, depois de ligar a energia do terceiro host, o fato desagradável foi que o status do sistema foi mantido em Crítica por um tempo muito longo - não sei o que isso gera, mas o bom não é suficiente. (de 1 hora a 2). Por exemplo, o mesmo cluster VMWARE após conectar o host determina rapidamente seu status e se conecta novamente ao cluster.Em geral, deve-se notar que a interface do Prism para gerenciar um cluster do Nutanix CE possui uma interface bastante ruim (embora agradável). Somente configurações básicas estão disponíveis, mas, em geral, são suficientes à primeira vista, há algum tipo de análise gráfica personalizável, embora, é claro, seja muito mais fraca que no VCENTER.Ainda não está claro como fazer backup: afinal, nem os produtos da Symantec nem da Veeam oferecem suporte à virtualização KVM ... obviamente, por meio de instantâneos, mas e a recuperação granular de dados nesse caso (arquivo por arquivo).Visualmente, o Nutanix era muito mais rápido: na fase de cópia de imagens para seu sistema de armazenamento, na fase de instalação do sistema operacional em uma nova máquina virtual a partir da imagem, na fase de reinicialização da inicialização: quase instantaneamente tudo). Há um desejo de experimentar o Nutanix em uma configuração mais poderosa e não se esqueça de usar o VMWARE EXSi.Obviamente, não posso fornecer dados de desempenho específicos para os dois sistemas, mas você pode obter algumas informações sobre o "rake" no estágio de configuração. Se isso peço desculpas - a primeira nota sobre Habré.