Pico de computação antes do pico de petróleo?

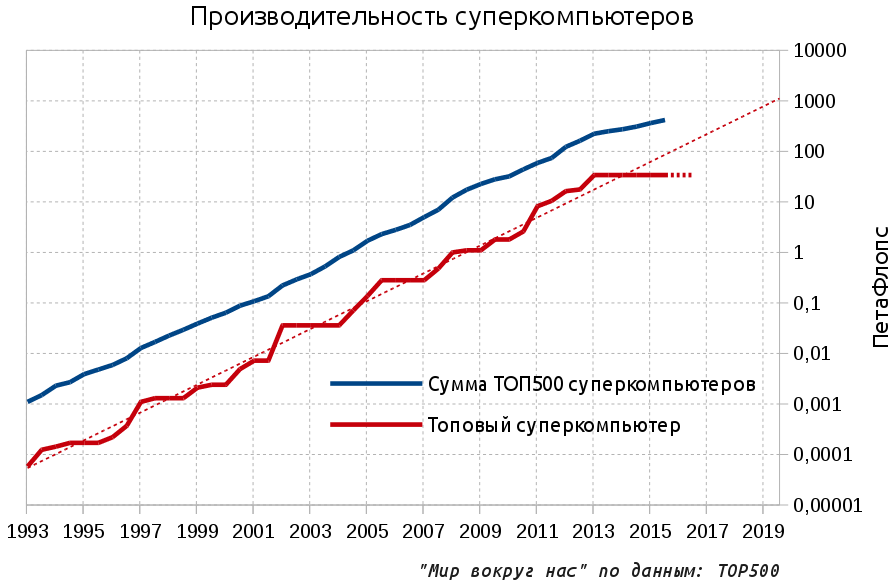

Hoje tentaremos o gênero de Cassandra popular na blogosfera - profecias negativas. Portanto, é "bem conhecido" que o inverno está próximo, a humanidade atingiu os limites do crescimento em tudo, e vivemos os últimos dias tranquilos antes do inevitável rolar para novos séculos escuros. A última fonte de otimismo tecnológico e o símbolo mais marcante do progresso, que se opôs nos últimos 20 anos a muitos processos estagnados no planeta, foi o rápido desenvolvimento da microeletrônica. Chegou a hora de rasgar as cobertas dessa área.Parece que o progresso está agora mais rápido do que nunca e qualquer usuário de smartphone irá falar sobre processadores cada vez mais rápidos que aparecem em novos modelos. Mas no extremo norte, já estava arrepiando a parede que nos protegia do recurso. Onde o desempenho máximo da microeletrônica é realmente necessário - na área de supercomputadores nas fronteiras mais avançadas - o progresso parou.Como você pode ver no gráfico, há três anos o desempenho do supercomputador principal (expresso em operações de ponto flutuante por segundo - FLOPS) não cresce. Além disso, se você observar os planos anunciados, poderá dizer com confiança que a situação não mudará pelo menos no próximo ano. Portanto, a estagnação do desempenho do supercomputador superior se estenderá até 2016: As linhas pontilhadas indicam a tendência de desenvolvimento exponencial e a previsão para o supercomputador de ponta para 2016 (estagnação). Brevemente sobre o material: no artigo, são usados os prefixos Pet e Axe. PetaFlops - 10 ^ 15 operações por segundo e o futuro necessário e discutido em mil vezes - ExaFlops, 10 ^ 18.Para continuar a tendência exponencial, os supercomputadores devem atingir a escala ExFlops em 2019 e agora apenas cerca de 100 PetFlops para 2018 - Aurora estão planejadas. Mas qual é exatamente o problema?Na minha experiência, mesmo muitos desenvolvedores profissionais de software e hardware não serão capazes de lhe dizer qual é a importância dos supercomputadores. No mundo moderno, no século da Internet difundida, enormes salões cheios de prateleiras de ferro e dedicados ao processamento de uma tarefa computacional complexa parecem ser o destino do passado romântico do início da era dos computadores nas décadas de 1960 e 1970. De fato, hoje os recursos de um único computador pessoal são suficientes para resolver muitos problemas complexos, e os servidores disponíveis comercialmente permitem atender às necessidades de grandes empresas. Mas também existem serviços populares de computação em nuvem que prometem infinitos recursos de computação por uma recompensa modesta.Mas, de fato, os supercomputadores são a única coisa que dá à humanidade de sete bilhões de bilhões de dias a oportunidade de continuar a se desenvolver e viver sem medo da maldição malthusiana.Todas as tarefas avançadas podem ser resolvidas apenas com a ajuda de um poder computacional muito grande e um supercomputador em que todos os componentes da tecnologia de computador são otimizados o máximo possível, essa é a ferramenta mais adequada para solucionar esses problemas. Além disso, a simulação direta por computador pode ser interpretada como o terceiro método científico de cognição, além da pesquisa teórica e experimental. Para não ser infundado, damos alguns exemplos.Sobre o óleo mãe, que durante muito tempo era quase impossível encontrar sem computadores poderosos, já escrevemose a conclusão foi categórica: de manhã um supercomputador no óleo da tarde, à noite um supercomputador no óleo da manhã. Vamos ver outros tópicos.AviaçãoNo projeto de novas aeronaves, a simulação por computador reduziu o número de testes físicos no túnel de vento de 77 unidades em 1979 para 11 em 1995 e, desde então, o valor permaneceu no mesmo nível. Algo por causa disso, nossos aviões permaneceram praticamente iguais onde estavam. A transição para uma simulação física fundamentalmente mais precisa, baseada na aplicação direta das equações de Navier-Stokes, requer capacidades computacionais da ordem de 50 exaflops, ou seja, 1000 vezes mais que o atual líder - o chinês Tianhe-2 da 33 PetaFlops. Ao mesmo tempo, o cálculo da aerodinâmica externa ainda é relativamente simples - mas, por exemplo, um mecanismo típico consiste em milhares de partes móveis e a modelagem de fluxos internos exigirá ainda mais poder computacional.

As linhas pontilhadas indicam a tendência de desenvolvimento exponencial e a previsão para o supercomputador de ponta para 2016 (estagnação). Brevemente sobre o material: no artigo, são usados os prefixos Pet e Axe. PetaFlops - 10 ^ 15 operações por segundo e o futuro necessário e discutido em mil vezes - ExaFlops, 10 ^ 18.Para continuar a tendência exponencial, os supercomputadores devem atingir a escala ExFlops em 2019 e agora apenas cerca de 100 PetFlops para 2018 - Aurora estão planejadas. Mas qual é exatamente o problema?Na minha experiência, mesmo muitos desenvolvedores profissionais de software e hardware não serão capazes de lhe dizer qual é a importância dos supercomputadores. No mundo moderno, no século da Internet difundida, enormes salões cheios de prateleiras de ferro e dedicados ao processamento de uma tarefa computacional complexa parecem ser o destino do passado romântico do início da era dos computadores nas décadas de 1960 e 1970. De fato, hoje os recursos de um único computador pessoal são suficientes para resolver muitos problemas complexos, e os servidores disponíveis comercialmente permitem atender às necessidades de grandes empresas. Mas também existem serviços populares de computação em nuvem que prometem infinitos recursos de computação por uma recompensa modesta.Mas, de fato, os supercomputadores são a única coisa que dá à humanidade de sete bilhões de bilhões de dias a oportunidade de continuar a se desenvolver e viver sem medo da maldição malthusiana.Todas as tarefas avançadas podem ser resolvidas apenas com a ajuda de um poder computacional muito grande e um supercomputador em que todos os componentes da tecnologia de computador são otimizados o máximo possível, essa é a ferramenta mais adequada para solucionar esses problemas. Além disso, a simulação direta por computador pode ser interpretada como o terceiro método científico de cognição, além da pesquisa teórica e experimental. Para não ser infundado, damos alguns exemplos.Sobre o óleo mãe, que durante muito tempo era quase impossível encontrar sem computadores poderosos, já escrevemose a conclusão foi categórica: de manhã um supercomputador no óleo da tarde, à noite um supercomputador no óleo da manhã. Vamos ver outros tópicos.AviaçãoNo projeto de novas aeronaves, a simulação por computador reduziu o número de testes físicos no túnel de vento de 77 unidades em 1979 para 11 em 1995 e, desde então, o valor permaneceu no mesmo nível. Algo por causa disso, nossos aviões permaneceram praticamente iguais onde estavam. A transição para uma simulação física fundamentalmente mais precisa, baseada na aplicação direta das equações de Navier-Stokes, requer capacidades computacionais da ordem de 50 exaflops, ou seja, 1000 vezes mais que o atual líder - o chinês Tianhe-2 da 33 PetaFlops. Ao mesmo tempo, o cálculo da aerodinâmica externa ainda é relativamente simples - mas, por exemplo, um mecanismo típico consiste em milhares de partes móveis e a modelagem de fluxos internos exigirá ainda mais poder computacional. Hidrodinâmica computacional aplicada às pás da turbina (esquerda) e à aeronave X-43 com número Mach = 7Energia termonuclearNo campo da física termonuclear, que é interessante escrita por um colega da tnenergy, o projeto da próxima geração de tokamaks é impossível sem o progresso na modelagem de plasma de alta temperatura em uma armadilha magnética. Atualmente, vários bilhões de partículas no espaço, com uma resolução de 131 milhões de pontos, estão participando dos modelos. Para essas escalas, os mais poderosos sistemas de pedidos da PetFlops são usados e bons resultados são obtidos, mas é claro que a precisão suficiente da simulação completa nos princípios básicos precisará ser aumentada para um modesto 13 milhões de vezes.

Hidrodinâmica computacional aplicada às pás da turbina (esquerda) e à aeronave X-43 com número Mach = 7Energia termonuclearNo campo da física termonuclear, que é interessante escrita por um colega da tnenergy, o projeto da próxima geração de tokamaks é impossível sem o progresso na modelagem de plasma de alta temperatura em uma armadilha magnética. Atualmente, vários bilhões de partículas no espaço, com uma resolução de 131 milhões de pontos, estão participando dos modelos. Para essas escalas, os mais poderosos sistemas de pedidos da PetFlops são usados e bons resultados são obtidos, mas é claro que a precisão suficiente da simulação completa nos princípios básicos precisará ser aumentada para um modesto 13 milhões de vezes. Modelagem do comportamento do plasma em um tokamakClima e climaA modelagem climática e as previsões meteorológicas precisas nos permitem planejar de maneira ideal nossas ações - a precisão das previsões aumenta com o crescimento do desempenho do supercomputador. No futuro, será possível prever chuvas e, consequentemente, inundações e fluxos de lama. Seca e falha de colheita.

Modelagem do comportamento do plasma em um tokamakClima e climaA modelagem climática e as previsões meteorológicas precisas nos permitem planejar de maneira ideal nossas ações - a precisão das previsões aumenta com o crescimento do desempenho do supercomputador. No futuro, será possível prever chuvas e, consequentemente, inundações e fluxos de lama. Seca e falha de colheita. Hoje, uma previsão do tempo de 4 dias é tão precisa quanto a previsão do tempo de um dia em 1980Previsões cada vez mais precisas requerem um modelo em escala planetária mais detalhado, e é necessária uma diminuição constante na célula de simulação. Atualmente, as células-modelo para previsões regionais de curto prazo têm dimensões de 10x10 km, e os modelos climáticos de longo prazo usam uma grade com células de centenas de km, enquanto é necessária uma escala de 1x1 km na superfície (10.000 vezes maior que agora) e 100 metros na vertical. Sim, com uma periodização de 1 segundo, o que por dois meses significa 5 milhões de segundos.Um exemplo de modelo moderno com uma célula de 300x300 km.

Hoje, uma previsão do tempo de 4 dias é tão precisa quanto a previsão do tempo de um dia em 1980Previsões cada vez mais precisas requerem um modelo em escala planetária mais detalhado, e é necessária uma diminuição constante na célula de simulação. Atualmente, as células-modelo para previsões regionais de curto prazo têm dimensões de 10x10 km, e os modelos climáticos de longo prazo usam uma grade com células de centenas de km, enquanto é necessária uma escala de 1x1 km na superfície (10.000 vezes maior que agora) e 100 metros na vertical. Sim, com uma periodização de 1 segundo, o que por dois meses significa 5 milhões de segundos.Um exemplo de modelo moderno com uma célula de 300x300 km. Medicina e biologia.Medicina não é excepção. Hoje, os supercomputadores de ponta são capazes de simular apenas partes ultra-pequenas individuais das células:

Medicina e biologia.Medicina não é excepção. Hoje, os supercomputadores de ponta são capazes de simular apenas partes ultra-pequenas individuais das células: Na figura, o resultado da modelagem da operação dos canais de íons na membrana celular dos supercomputadores de ponta - e apenas cerca de 100 mil moléculas estão envolvidas. Além disso, o número total de moléculas em uma célula humana é de bilhões, e as próprias células são quase quatrilhões (10 ^ 14). O processo de obter novos medicamentos e trazê-los ao mercado leva de 5 a 15 anos e agora se fala em novos conceitos no design de drag. Imagine o quanto você pode acelerar o processo e aumentar a eficácia dos medicamentos se modelar a situação de maneira abrangente - a partir do DNA do patógeno, que, de fato, contém todas as informações sobre ele e termina com o modelo do corpo humano, levando em consideração as características genéticas individuais.A lista real é muito, muito maior: a busca de materiais fundamentalmente novos com propriedades desejadas, astrofísica, energia nuclear e muito mais. Escrituração deexpositoresSurge a pergunta: se os benefícios são tão grandes, por que não investimos muito dinheiro em supercomputadores poderosos? O fato é que até agora houve um expoente do nosso lado, a saber, o expoente de Moore - a densidade de transistores dobra a cada 18-24 meses e, até muito recentemente, isso significava que a produtividade também dobra.Portanto, os estudantes de jogadores ficaram atormentados com a pergunta constante: "Preciso comprar um computador hoje por US $ 2.000 ou tomar algo mais simples por US $ 1.000?" De fato, pelos US $ 1000 restantes em 3-4 anos, será possível comprar um computador duas vezes mais poderoso. Isso não é surpreendente, porque uma função linear sempre perde exponencialmente e a multiplicação de custos produz, na melhor das hipóteses, a mesma multiplicação linear de desempenho, em vez de uma dependência da lei de potência no caso de um expoente. Como regra geral, o orçamento dos estudantes não era de borracha e a escolha recaiu sobre a segunda opção, mas às vezes eles queriam se envolver, eles aceitavam a opção de spread e, após alguns anos, olhavam maldosamente esse velho lixo.Um processo semelhante, mas em um ambiente muito mais sério, ocorreu durante as discussões de novos supercomputadores. Na maioria dos casos, foi escolhido um caminho mais moderado, mas produtivo. É significativo que, nos últimos 20 anos, apenas três computadores tenham custado mais de US $ 300 milhões e os três tenham sido construídos fora dos Estados Unidos: dois no Japão e um líder de hoje na China, em países que reivindicam liderança mundial. De fato, além dos benefícios reais, ter seu próprio supercomputador na primeira linha da classificação tornou-se uma questão de orgulho nacional em provar a existência da ciência avançada nacional.O fim do expositorDe ano para ano, são ouvidas exclamações de que a lei de Moore está próxima do fim e, até agora, parece ser todas as histórias de horror. Mas se desejar, você já pode discernir os cavaleiros individuais do apocalipse:

Na figura, o resultado da modelagem da operação dos canais de íons na membrana celular dos supercomputadores de ponta - e apenas cerca de 100 mil moléculas estão envolvidas. Além disso, o número total de moléculas em uma célula humana é de bilhões, e as próprias células são quase quatrilhões (10 ^ 14). O processo de obter novos medicamentos e trazê-los ao mercado leva de 5 a 15 anos e agora se fala em novos conceitos no design de drag. Imagine o quanto você pode acelerar o processo e aumentar a eficácia dos medicamentos se modelar a situação de maneira abrangente - a partir do DNA do patógeno, que, de fato, contém todas as informações sobre ele e termina com o modelo do corpo humano, levando em consideração as características genéticas individuais.A lista real é muito, muito maior: a busca de materiais fundamentalmente novos com propriedades desejadas, astrofísica, energia nuclear e muito mais. Escrituração deexpositoresSurge a pergunta: se os benefícios são tão grandes, por que não investimos muito dinheiro em supercomputadores poderosos? O fato é que até agora houve um expoente do nosso lado, a saber, o expoente de Moore - a densidade de transistores dobra a cada 18-24 meses e, até muito recentemente, isso significava que a produtividade também dobra.Portanto, os estudantes de jogadores ficaram atormentados com a pergunta constante: "Preciso comprar um computador hoje por US $ 2.000 ou tomar algo mais simples por US $ 1.000?" De fato, pelos US $ 1000 restantes em 3-4 anos, será possível comprar um computador duas vezes mais poderoso. Isso não é surpreendente, porque uma função linear sempre perde exponencialmente e a multiplicação de custos produz, na melhor das hipóteses, a mesma multiplicação linear de desempenho, em vez de uma dependência da lei de potência no caso de um expoente. Como regra geral, o orçamento dos estudantes não era de borracha e a escolha recaiu sobre a segunda opção, mas às vezes eles queriam se envolver, eles aceitavam a opção de spread e, após alguns anos, olhavam maldosamente esse velho lixo.Um processo semelhante, mas em um ambiente muito mais sério, ocorreu durante as discussões de novos supercomputadores. Na maioria dos casos, foi escolhido um caminho mais moderado, mas produtivo. É significativo que, nos últimos 20 anos, apenas três computadores tenham custado mais de US $ 300 milhões e os três tenham sido construídos fora dos Estados Unidos: dois no Japão e um líder de hoje na China, em países que reivindicam liderança mundial. De fato, além dos benefícios reais, ter seu próprio supercomputador na primeira linha da classificação tornou-se uma questão de orgulho nacional em provar a existência da ciência avançada nacional.O fim do expositorDe ano para ano, são ouvidas exclamações de que a lei de Moore está próxima do fim e, até agora, parece ser todas as histórias de horror. Mas se desejar, você já pode discernir os cavaleiros individuais do apocalipse: Acima estão cinco tendências para várias especificações de microprocessadores. A lei de Moore parece continuar: laranja indica o número de transistores por unidade de área com uma duplicação a cada 18-24 meses. Desde 2005, o parâmetro cresceu 100 vezes, mas não há muita alegria com ele - o desempenho de um núcleo é marcado em azul e o crescimento no mesmo período já é menor que 10 vezes. O restante dos transistores foi aumentar o número de núcleos que permitem tarefas de processamento em paralelo (preto).Em 2005, foi possível comprar um processador com uma velocidade de clock de 3,8 GHz, mas agora o processador Intel com uma frequência de clock acima de 4 GHz não comprava. Isso se refere diretamente ao gráfico: a frequência do processador, anteriormente responsável por metade do crescimento da produtividade, não mudou muito desde 2004 (verde), assim como o consumo de energia (vermelho), que se apoiava na possibilidade de dissipação de calor.Essas tendências são absolutamente simétricas na arquitetura dos supercomputadores. Se tomarmos o campeão chinês de hoje, veremos um dos mais altos indicadores de consumo de energia (18 MW), um grande número de núcleos de computação e até uma regressão ao preço do PetaFlops. Tudo isso permitiu construir um supercomputador apenas duas vezes mais produtivo que o concorrente anterior.Rejeite o expoente burguês por causa da linha comunista!

Acima estão cinco tendências para várias especificações de microprocessadores. A lei de Moore parece continuar: laranja indica o número de transistores por unidade de área com uma duplicação a cada 18-24 meses. Desde 2005, o parâmetro cresceu 100 vezes, mas não há muita alegria com ele - o desempenho de um núcleo é marcado em azul e o crescimento no mesmo período já é menor que 10 vezes. O restante dos transistores foi aumentar o número de núcleos que permitem tarefas de processamento em paralelo (preto).Em 2005, foi possível comprar um processador com uma velocidade de clock de 3,8 GHz, mas agora o processador Intel com uma frequência de clock acima de 4 GHz não comprava. Isso se refere diretamente ao gráfico: a frequência do processador, anteriormente responsável por metade do crescimento da produtividade, não mudou muito desde 2004 (verde), assim como o consumo de energia (vermelho), que se apoiava na possibilidade de dissipação de calor.Essas tendências são absolutamente simétricas na arquitetura dos supercomputadores. Se tomarmos o campeão chinês de hoje, veremos um dos mais altos indicadores de consumo de energia (18 MW), um grande número de núcleos de computação e até uma regressão ao preço do PetaFlops. Tudo isso permitiu construir um supercomputador apenas duas vezes mais produtivo que o concorrente anterior.Rejeite o expoente burguês por causa da linha comunista! As tropas cibernéticas chinesas removem os favoritos dos processadores Intel Xeon.Se os computadores são tão importantes, por que não continuar o caminho chinês e tornar o supercomputador maior e depois ainda maior? Você precisa entender que qualquer aumento de produtividade devido a um aumento linear de escala não é apenas um aumento no preço do dólar, mas também o mesmo aumento linear no consumo de energia. Se você pegar um monstro chinês com três milhões de núcleos e tentar escalá-lo do nível 33 do PetaFlops para o nível 30 do ExaFlops, precisará reservar para uso exclusivo duas dúzias de novos reatores nucleares, o que corresponde a todos os reatores que estão sendo construídos na China. Se ainda é possível, de alguma forma, apertar o cinto para puxar, o nível de 30 ZettaFlops com seus 20'000 reatores está fechado para nós para sempre.Há alguma saídaÉ possível continuar o expositor? Para os próximos anos - sim, ainda é possível. Em 2 a 3 anos, os supercomputadores sairão cerca de três vezes mais potentes que os chineses de ponta e com os melhores parâmetros de consumo de energia e custo do PetAflops. E o que vai acontecer a seguir?Pessoalmente, não sei ao certo, mas os especialistas não são muito otimistas. Por exemplo, um diretor da Microsoft visitou um fórum oficial no final de outubro sobre o desenvolvimento do futuro sistema ExFlops nos Estados Unidos. O fórum contou com a presença de todos os principais fabricantes de ferro, além de representantes de várias agências estaduais que desenvolvem e usam supercomputadores.Para citar :É óbvio para todos os participantes do fórum:

As tropas cibernéticas chinesas removem os favoritos dos processadores Intel Xeon.Se os computadores são tão importantes, por que não continuar o caminho chinês e tornar o supercomputador maior e depois ainda maior? Você precisa entender que qualquer aumento de produtividade devido a um aumento linear de escala não é apenas um aumento no preço do dólar, mas também o mesmo aumento linear no consumo de energia. Se você pegar um monstro chinês com três milhões de núcleos e tentar escalá-lo do nível 33 do PetaFlops para o nível 30 do ExaFlops, precisará reservar para uso exclusivo duas dúzias de novos reatores nucleares, o que corresponde a todos os reatores que estão sendo construídos na China. Se ainda é possível, de alguma forma, apertar o cinto para puxar, o nível de 30 ZettaFlops com seus 20'000 reatores está fechado para nós para sempre.Há alguma saídaÉ possível continuar o expositor? Para os próximos anos - sim, ainda é possível. Em 2 a 3 anos, os supercomputadores sairão cerca de três vezes mais potentes que os chineses de ponta e com os melhores parâmetros de consumo de energia e custo do PetAflops. E o que vai acontecer a seguir?Pessoalmente, não sei ao certo, mas os especialistas não são muito otimistas. Por exemplo, um diretor da Microsoft visitou um fórum oficial no final de outubro sobre o desenvolvimento do futuro sistema ExFlops nos Estados Unidos. O fórum contou com a presença de todos os principais fabricantes de ferro, além de representantes de várias agências estaduais que desenvolvem e usam supercomputadores.Para citar :É óbvio para todos os participantes do fórum:

A microeletrônica moderna baseada na tecnologia CMOS está chegando ao fim de suas capacidades.

Não há tecnologia alternativa que estará disponível nos próximos dez anos.Simplificando, nos próximos 10 anos o paradigma existente terminará e não temos outro paradigma para você . Source: https://habr.com/ru/post/pt387109/

All Articles