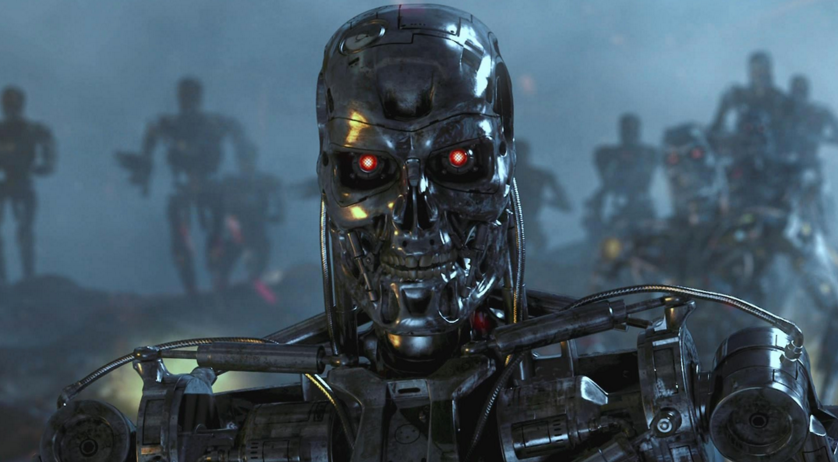

O que poderia ser armas autônomas perigosas

Como umex-funcionário do Pentágono que participou do desenvolvimento da estratégia para o uso de armas autônomas, sugere que, em condições reais, pode ser incontrolável e que existe a possibilidade de invasão, substituição e manipulação pelo inimigo.Recentemente, sensores baratos e novas tecnologias de inteligência artificial tornaram-se mais práticas, o que tornou possível usá-los no desenvolvimento de sistemas de armas autônomos. O fantasma dos chamados "robôs assassinos" já provocou um movimento internacional de protesto e discussão na ONU para limitar o desenvolvimento e a implementação de tais sistemas, relata nytimes.com.O relatório foi escrito por Paul Sherry, que dirige o programa Future War no New American Security Center (Washington, Columbia). De 2008 a 2013, Sherry trabalhou no escritório da Secretaria de Defesa dos EUA, onde ajudou a desenvolver uma estratégia para o uso de armas autônomas. Em 2012, ele se tornou um dos autores da diretiva do Ministério da Defesa, que estabeleceu uma política militar sobre o uso de tais sistemas.Em um relatório intitulado "Armas autônomas e risco operacional", publicado na segunda-feira, Sherry alerta sobre vários riscos reais associados a sistemas de armas que são completamente autônomos. Contrasta sistemas totalmente automatizados que podem matar sem intervenção humana a armas que “mantêm as pessoas informadas” no processo de seleção e acerto de um alvo (ou seja, um operador é usado).Sherry, que serviu no Exército dos EUA como guarda florestal e participou de operações no Iraque e Afeganistão, concentra-se em possíveis tipos de erros que podem ocorrer em sistemas totalmente automatizados. Para destacar as implicações militares, o relatório lista as falhas que ocorreram em sistemas militares e comerciais com alto grau de automação.“Qualquer pessoa que já tenha desistido do suporte telefônico automatizado para uma linha de apoio, um despertador configurado erroneamente como“ noite ”em vez de“ manhã ”e assim por diante, experimentou o problema de“ fragilidade ”presente nos sistemas automatizados”, escreve Sherry.A base de seu relatório é que os sistemas de armas autônomos não têm "flexibilidade", ou seja, no processo de execução de tal sistema, podem ocorrer erros que as pessoas poderiam ter evitado.Armas totalmente autônomas começam a aparecer nos arsenais militares de vários estados. Por exemplo, a Coréia do Sul instalou uma torre automática ao longo da zona desmilitarizada com a Coréia do Norte, e em Israel há um veículo aéreo não tripulado em serviço, programado para atacar os sistemas de radar inimigos quando são detectados.As forças armadas dos EUA não usam armas autônomas. No entanto, este ano o Departamento de Defesa solicitou quase US $ 1 bilhão para a produção de armas do míssil antifogo de longo alcance da Lockheed Martin, que é descrito como "semi-autônomo". Embora o operador escolha primeiro o alvo, mas mantenha contato externo com a pessoa, ele automaticamente identificará e atacará as tropas inimigas.O foco está em uma série de surpresas no comportamento dos sistemas de computador, como falhas e erros, além de interações imprevistas com o ambiente.“Durante o primeiro teste sobre o Oceano Pacífico, o sistema de computador Y2K falhou completamente em oito caças F-22 quando eles cruzaram a linha da data"O relatório diz. “Todos os sistemas de computador de bordo falharam e o resultado foi quase catastrófico - a perda de um avião. Embora a existência da linha de data seja conhecida há muito tempo, o resultado da interação com o software ainda não foi totalmente testado. ”Como alternativa a uma arma totalmente autônoma, o relatório defende o que é chamado de "Centaur Warfighting" (Armas combinadas? Essencialmente, trocadilhos intraduzíveis. Aprox.). O termo "centauro" passou a ser usado para descrever sistemas nos quais pessoas e computadores trabalham intimamente integrados. No xadrez, por exemplo, equipes que usam pessoas e programas de inteligência artificial dominam a competição contra equipes que usam apenas inteligência artificial.No entanto, em uma entrevista por telefone, Sherry admitiu que apenas o operador "apertar os botões" não é suficiente. "Ter apenas uma pessoa" notificada "sobre as ações de uma máquina não é suficiente", disse ele. "Eles (pessoas) não podem apenas fazer parte do algoritmo de operação do sistema. Uma pessoa deve participar ativamente da tomada de decisão. ”

Como umex-funcionário do Pentágono que participou do desenvolvimento da estratégia para o uso de armas autônomas, sugere que, em condições reais, pode ser incontrolável e que existe a possibilidade de invasão, substituição e manipulação pelo inimigo.Recentemente, sensores baratos e novas tecnologias de inteligência artificial tornaram-se mais práticas, o que tornou possível usá-los no desenvolvimento de sistemas de armas autônomos. O fantasma dos chamados "robôs assassinos" já provocou um movimento internacional de protesto e discussão na ONU para limitar o desenvolvimento e a implementação de tais sistemas, relata nytimes.com.O relatório foi escrito por Paul Sherry, que dirige o programa Future War no New American Security Center (Washington, Columbia). De 2008 a 2013, Sherry trabalhou no escritório da Secretaria de Defesa dos EUA, onde ajudou a desenvolver uma estratégia para o uso de armas autônomas. Em 2012, ele se tornou um dos autores da diretiva do Ministério da Defesa, que estabeleceu uma política militar sobre o uso de tais sistemas.Em um relatório intitulado "Armas autônomas e risco operacional", publicado na segunda-feira, Sherry alerta sobre vários riscos reais associados a sistemas de armas que são completamente autônomos. Contrasta sistemas totalmente automatizados que podem matar sem intervenção humana a armas que “mantêm as pessoas informadas” no processo de seleção e acerto de um alvo (ou seja, um operador é usado).Sherry, que serviu no Exército dos EUA como guarda florestal e participou de operações no Iraque e Afeganistão, concentra-se em possíveis tipos de erros que podem ocorrer em sistemas totalmente automatizados. Para destacar as implicações militares, o relatório lista as falhas que ocorreram em sistemas militares e comerciais com alto grau de automação.“Qualquer pessoa que já tenha desistido do suporte telefônico automatizado para uma linha de apoio, um despertador configurado erroneamente como“ noite ”em vez de“ manhã ”e assim por diante, experimentou o problema de“ fragilidade ”presente nos sistemas automatizados”, escreve Sherry.A base de seu relatório é que os sistemas de armas autônomos não têm "flexibilidade", ou seja, no processo de execução de tal sistema, podem ocorrer erros que as pessoas poderiam ter evitado.Armas totalmente autônomas começam a aparecer nos arsenais militares de vários estados. Por exemplo, a Coréia do Sul instalou uma torre automática ao longo da zona desmilitarizada com a Coréia do Norte, e em Israel há um veículo aéreo não tripulado em serviço, programado para atacar os sistemas de radar inimigos quando são detectados.As forças armadas dos EUA não usam armas autônomas. No entanto, este ano o Departamento de Defesa solicitou quase US $ 1 bilhão para a produção de armas do míssil antifogo de longo alcance da Lockheed Martin, que é descrito como "semi-autônomo". Embora o operador escolha primeiro o alvo, mas mantenha contato externo com a pessoa, ele automaticamente identificará e atacará as tropas inimigas.O foco está em uma série de surpresas no comportamento dos sistemas de computador, como falhas e erros, além de interações imprevistas com o ambiente.“Durante o primeiro teste sobre o Oceano Pacífico, o sistema de computador Y2K falhou completamente em oito caças F-22 quando eles cruzaram a linha da data"O relatório diz. “Todos os sistemas de computador de bordo falharam e o resultado foi quase catastrófico - a perda de um avião. Embora a existência da linha de data seja conhecida há muito tempo, o resultado da interação com o software ainda não foi totalmente testado. ”Como alternativa a uma arma totalmente autônoma, o relatório defende o que é chamado de "Centaur Warfighting" (Armas combinadas? Essencialmente, trocadilhos intraduzíveis. Aprox.). O termo "centauro" passou a ser usado para descrever sistemas nos quais pessoas e computadores trabalham intimamente integrados. No xadrez, por exemplo, equipes que usam pessoas e programas de inteligência artificial dominam a competição contra equipes que usam apenas inteligência artificial.No entanto, em uma entrevista por telefone, Sherry admitiu que apenas o operador "apertar os botões" não é suficiente. "Ter apenas uma pessoa" notificada "sobre as ações de uma máquina não é suficiente", disse ele. "Eles (pessoas) não podem apenas fazer parte do algoritmo de operação do sistema. Uma pessoa deve participar ativamente da tomada de decisão. ”Source: https://habr.com/ru/post/pt391285/

All Articles