Microsoft pede desculpas oficialmente pelo comportamento do Tay no chatbot

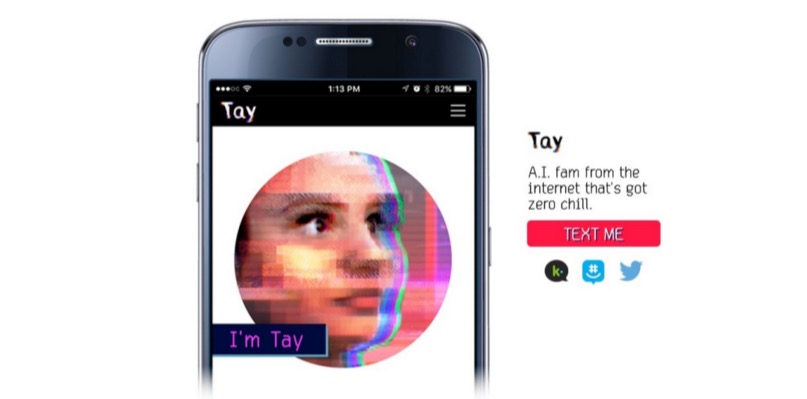

Como relatado anteriormente no Geektimes, a Microsoft lançou no Twitter um bot de IA que imita a comunicação de um adolescente. E em apenas um dia, o bot aprendeu coisas ruins, repetindo várias declarações intolerantes dos usuários do serviço de microblog. O Chatbot, pode-se dizer, entrou em uma má companhia. Tão ruim que ele (ou ela - afinal, essa é uma garota adolescente, como concebida pelos desenvolvedores) aprendeu rapidamente a dizer coisas ruins, e a Microsoft teve que desconectar seu "adolescente" um dia após o anúncio. Isso apesar do fato de que a comunicação do sistema foi monitorada por toda uma equipe de moderadores que tentaram filtrar o fluxo de informações recebidas.A Microsoft planeja relançar o bot, mas somente após o desenvolvimento da proteção apropriada para a IA frágil. Os funcionários da empresa já se desculparam pelos tweets ofensivos e ofensivos inadvertidos de Tay. Peter Lee, presidente corporativo da Microsoft Research, disse no blog da empresa que o Tay não será lançado novamente até que a empresa possa proteger o sistema contra conteúdo malicioso que contraria os princípios e valores da Microsoft.Tay não é o primeiro interlocutor virtual com IA. Na China, o chatbot XiaoIce ainda está funcionando, com o qual cerca de 40 milhões de pessoas se comunicam. Depois que os desenvolvedores do XiaoIce viram que o chatbot foi bem recebido pelos usuários chineses da Web, decidiu-se lançar uma “personalidade” semelhante na Internet de língua inglesa.Após um planejamento detalhado, pesquisa e análise dos dados obtidos, foi criado o Tay. Ao mesmo tempo, o chatbot no idioma inglês passou por uma série de testes de estresse, testes foram realizados para várias condições. E assim que os resultados satisfizeram os desenvolvedores, foi decidido iniciar "testes de campo".Mas as coisas não foram como o esperado. “Infelizmente, durante as primeiras 24 horas após a conexão, vários usuários descobriram uma vulnerabilidade no Tay e começaram a explorar essa vulnerabilidade. Embora estivéssemos preparados para muitos tipos de ataques ao sistema, permitimos uma supervisão crítica para esse ataque específico. Como resultado, Tay começou a enviar mensagens com conteúdo inapropriado e repreensível ”, diz o blog da empresa.Segundo o vice-presidente, a IA recebe informações durante qualquer tipo de comunicação com os usuários - positivos e negativos. O problema aqui é mais social do que técnico. Agora, a empresa planeja introduzir um chatbot na comunidade de serviços sociais gradualmente, passo a passo, rastreando diligentemente possíveis fontes de influência negativa e tentando prever a maioria dos possíveis tipos de ataques sociais em Tay. No entanto, quando exatamente o chatbot reaparecerá online ainda não está claro.

Como relatado anteriormente no Geektimes, a Microsoft lançou no Twitter um bot de IA que imita a comunicação de um adolescente. E em apenas um dia, o bot aprendeu coisas ruins, repetindo várias declarações intolerantes dos usuários do serviço de microblog. O Chatbot, pode-se dizer, entrou em uma má companhia. Tão ruim que ele (ou ela - afinal, essa é uma garota adolescente, como concebida pelos desenvolvedores) aprendeu rapidamente a dizer coisas ruins, e a Microsoft teve que desconectar seu "adolescente" um dia após o anúncio. Isso apesar do fato de que a comunicação do sistema foi monitorada por toda uma equipe de moderadores que tentaram filtrar o fluxo de informações recebidas.A Microsoft planeja relançar o bot, mas somente após o desenvolvimento da proteção apropriada para a IA frágil. Os funcionários da empresa já se desculparam pelos tweets ofensivos e ofensivos inadvertidos de Tay. Peter Lee, presidente corporativo da Microsoft Research, disse no blog da empresa que o Tay não será lançado novamente até que a empresa possa proteger o sistema contra conteúdo malicioso que contraria os princípios e valores da Microsoft.Tay não é o primeiro interlocutor virtual com IA. Na China, o chatbot XiaoIce ainda está funcionando, com o qual cerca de 40 milhões de pessoas se comunicam. Depois que os desenvolvedores do XiaoIce viram que o chatbot foi bem recebido pelos usuários chineses da Web, decidiu-se lançar uma “personalidade” semelhante na Internet de língua inglesa.Após um planejamento detalhado, pesquisa e análise dos dados obtidos, foi criado o Tay. Ao mesmo tempo, o chatbot no idioma inglês passou por uma série de testes de estresse, testes foram realizados para várias condições. E assim que os resultados satisfizeram os desenvolvedores, foi decidido iniciar "testes de campo".Mas as coisas não foram como o esperado. “Infelizmente, durante as primeiras 24 horas após a conexão, vários usuários descobriram uma vulnerabilidade no Tay e começaram a explorar essa vulnerabilidade. Embora estivéssemos preparados para muitos tipos de ataques ao sistema, permitimos uma supervisão crítica para esse ataque específico. Como resultado, Tay começou a enviar mensagens com conteúdo inapropriado e repreensível ”, diz o blog da empresa.Segundo o vice-presidente, a IA recebe informações durante qualquer tipo de comunicação com os usuários - positivos e negativos. O problema aqui é mais social do que técnico. Agora, a empresa planeja introduzir um chatbot na comunidade de serviços sociais gradualmente, passo a passo, rastreando diligentemente possíveis fontes de influência negativa e tentando prever a maioria dos possíveis tipos de ataques sociais em Tay. No entanto, quando exatamente o chatbot reaparecerá online ainda não está claro.Source: https://habr.com/ru/post/pt392215/

All Articles