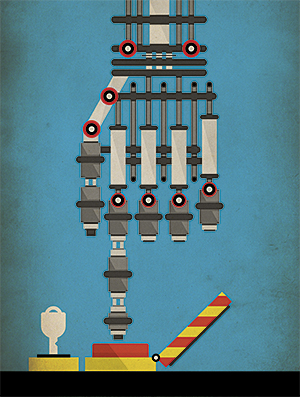

Vamos dar a robôs militares uma licença para matar?

À medida que os robôs de guerra da IA melhoram, a essência da guerra muda

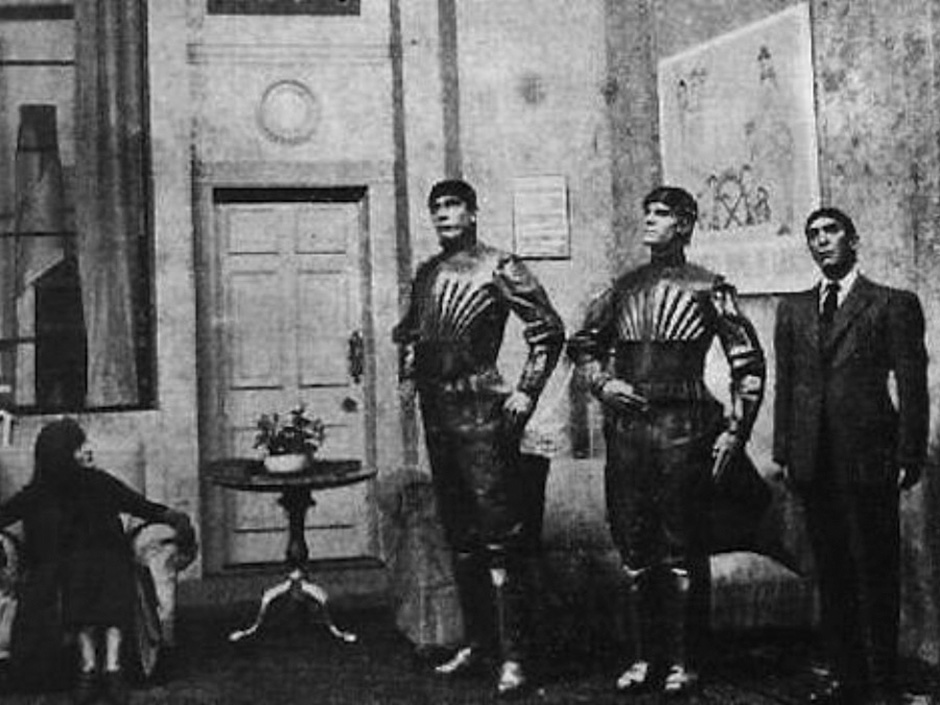

Em 1920, o escritor tcheco Karel Čapek escreveu a peça RUR (Rossum Universal Robots, "Rossum Universal Robots"), na qual deu ao mundo a palavra "robô". Em sua peça, tudo começa com pessoas artificiais - robôs que trabalham em fábricas e produzem produtos baratos. E tudo termina com o fato de que os robôs destroem a humanidade. Assim, nasceu a trama de longa data da NF: os robôs ficam fora de controle e se transformam em máquinas de matar imparáveis. A literatura e o cinema do século XX continuam a nos fornecer exemplos de robôs que destroem o mundo, e Hollywood constantemente o transforma em franquias de grande sucesso: Matrix, Transformers e Terminator.Recentemente, o medo de transformar a ficção em realidade é suportado por uma combinação de circunstâncias, entre as quais melhorias na IA e robótica, a disseminação dedrones militares e robôs terrestres no Iraque e no Afeganistão. As maiores potências estão desenvolvendo armas inteligentes com graus variados de autonomia e mortalidade. A maioria deles logo será controlada remotamente por pessoas, sem cujo comando o robô não será capaz de puxar o gatilho. Mas, muito provavelmente - e de acordo com alguns, mesmo sem dúvida, em algum momento os robôs poderão operar de forma totalmente autônoma, e o Rubicon será ativado em assuntos militares: pela primeira vez, um conjunto de microchips e software decidirá se uma pessoa vive ou morre.Não surpreendentemente, a ameaça de robôs assassinos, como eles os apelidaram carinhosamente, levou a um debate apaixonado. Em lados opostos da disputa estão aqueles que temem que as armas automáticas iniciem uma guerra geral e destruam a civilização, e aqueles que afirmam que novas armas são apenas mais uma classe de armas guiadas com precisão que reduzirão em vez de aumentar o número de vítimas. Em dezembro, mais de cem países discutirão esse assunto na reunião de desarmamento da OTAN em Genebra.

Em 1920, o escritor tcheco Karel Čapek escreveu a peça RUR (Rossum Universal Robots, "Rossum Universal Robots"), na qual deu ao mundo a palavra "robô". Em sua peça, tudo começa com pessoas artificiais - robôs que trabalham em fábricas e produzem produtos baratos. E tudo termina com o fato de que os robôs destroem a humanidade. Assim, nasceu a trama de longa data da NF: os robôs ficam fora de controle e se transformam em máquinas de matar imparáveis. A literatura e o cinema do século XX continuam a nos fornecer exemplos de robôs que destroem o mundo, e Hollywood constantemente o transforma em franquias de grande sucesso: Matrix, Transformers e Terminator.Recentemente, o medo de transformar a ficção em realidade é suportado por uma combinação de circunstâncias, entre as quais melhorias na IA e robótica, a disseminação dedrones militares e robôs terrestres no Iraque e no Afeganistão. As maiores potências estão desenvolvendo armas inteligentes com graus variados de autonomia e mortalidade. A maioria deles logo será controlada remotamente por pessoas, sem cujo comando o robô não será capaz de puxar o gatilho. Mas, muito provavelmente - e de acordo com alguns, mesmo sem dúvida, em algum momento os robôs poderão operar de forma totalmente autônoma, e o Rubicon será ativado em assuntos militares: pela primeira vez, um conjunto de microchips e software decidirá se uma pessoa vive ou morre.Não surpreendentemente, a ameaça de robôs assassinos, como eles os apelidaram carinhosamente, levou a um debate apaixonado. Em lados opostos da disputa estão aqueles que temem que as armas automáticas iniciem uma guerra geral e destruam a civilização, e aqueles que afirmam que novas armas são apenas mais uma classe de armas guiadas com precisão que reduzirão em vez de aumentar o número de vítimas. Em dezembro, mais de cem países discutirão esse assunto na reunião de desarmamento da OTAN em Genebra. Um zangão controlado por humanos

Um zangão controlado por humanos O canhão Phalanx disparou de forma independenteNo ano passado, essa discussão caiu nas notícias quando um grupo de pesquisadores de IA solicitou a proibição de "armas ofensivas autônomas operando sem controle humano significativo". Em uma carta aberta a uma conferência internacional sobre IA, um grupo de pesquisadores observou que essas armas poderiam levar a uma corrida armamentista internacional e poderiam ser usadas para assassinatos por contrato, desestabilização de nações, supressão de povos e destruição seletiva de grupos étnicos.A carta foi assinada por mais de 20.000 pessoas, incluindo personalidades famosas como o físico Stephen Hawking e o empresário Ilon Musk. Este último doou US $ 10 milhões ao Instituto de Boston no ano passado., empenhada em proteger a vida das pessoas contra a ameaça hipotética de uma IA hostil. Os estudiosos que organizaram a redação - Stuart Russell, da Universidade da Califórnia em Berkeley, Max Tegmark, do MIT, e Toby Walsh, da Universidade de New South Wales, na Austrália - expandiram sua posição em um artigo para a revista IEEE Spectrum. Por exemplo, em um cenário, "um grande número de micro-robôs baratos que podem ser colocados por uma pessoa no mercado negro pode ser morto e milhares ou milhões de pessoas que se encaixam nos critérios do usuário serão capazes de matar".Eles também acrescentaram que “armas autônomas podem se tornar armas de destruição em massa. "Alguns países podem proibir seu uso, enquanto outros países e, claro, terroristas, dificilmente poderão abandoná-lo".Dificilmente se pode dizer que uma nova corrida armamentista, que pode resultar em máquinas de matar inteligentes, autônomas e móveis, servirá ao benefício de toda a humanidade. No entanto, esta corrida já começou.As armas autônomas existem há várias décadas, embora seus espécimes raros até agora tenham sido usados principalmente para defesa. Um exemplo é o Phalanx , uma arma controlada por computador, guiada por radar e montada em navios de guerra da Marinha dos EUA. Ela pode detectar, rastrear, avaliar e disparar automaticamente nos mísseis e aeronaves que se aproximam, o que ela considera uma ameaça. De um modo totalmente autônomo, a participação humana não é necessária.Harop drone destrói alvoA DoDAAM Systems demonstra as capacidades do relógio de robô Super aEgis II.Recentemente, desenvolvedores militares começaram a criar robôs autônomos ofensivos. A empresa Israel Aerospace Industries tem fabricado drones Harpy e Harop, o que leva à ondas de rádio de sistemas de defesa aérea inimiga, e matá-los pela colisão. A empresa afirma que seus UAVs estão vendendo bem em todo o mundo.A empresa sul-coreana DoDAAM Systems desenvolveu o relógio robô Super aEgis II. Ele atira com uma metralhadora e usa a visão computacional para detectar e disparar contra alvos (pessoas) a uma distância de 3 km. Alega-se que os militares sul-coreanos realizaram testes desses robôs na zona desmilitarizada na fronteira com a Coréia do Norte. DoDAAM jávendeu 30 desses dispositivos para outros países, incluindo vários clientes do Oriente Médio.Atualmente, os sistemas com um alto grau de autonomia são muito poucos em comparação com as armas robóticas controladas por pessoas quase o tempo todo, e especialmente durante os disparos. Os analistas prevêem que, com o desenvolvimento de assuntos militares, as armas terão cada vez mais capacidades autônomas."A guerra será completamente diferente e a automação desempenhará um papel em que a velocidade é importante", disse Peter Singer, especialista em robôs militares do grupo não político da Nova América, sediado em Washington. Ele lerá que em futuras batalhas - como em batalhas entre diferentes UAVs, ou quando um navio automático encontrar um submarino automático - uma arma com uma fração de uma segunda vantagem decidirá o resultado da batalha. "Pode haver um conflito repentino e intenso no qual simplesmente não haverá tempo para atualizar as pessoas, porque tudo será decidido em questão de segundos".As forças armadas dos EUA descreveram seus planos de longo prazo para travar um novo tipo de guerra usando sistemas não tripulados, mas ainda não se sabe se eles pretendem armar esses sistemas. AtivadoNo fórum do Washington Post, em março, o subsecretário de Defesa dos EUA, Robert Work, cujo trabalho é garantir que o Pentágono acompanhe a tecnologia mais recente, apontou para a necessidade de investimento em inteligência artificial e robôs. Segundo ele, a presença crescente de sistemas autônomos no campo de batalha é "inevitável".Em relação às armas autônomas, Work insiste que os militares dos EUA "não darão à máquina o poder de tomar decisões fatais". No entanto, ele próprio acrescentou que “se um oponente parecer pronto para transferir tais poderes ... teremos que tomar decisões sobre a questão da competição com ele. Ainda não descobrimos completamente, mas pensamos muito sobre isso. ”Vladimir Putin assiste a um ciborgue militar em um ATV durante a demonstração do ano passadoO primeiro voo do UAV CH-5 da empresa chinesa China Aerospace Science and Technology Corporation,Rússia e China adota uma estratégia semelhante no desenvolvimento de sistemas de combate não tripulados para operações em terra, no mar e no ar, que, embora armados, ainda dependem de operadores vivos. Russian Platform-M é um pequeno robô com controle remoto, equipado com um rifle de assalto Kalashnikov e um lançador de granadas. Assemelha-se ao sistema US Talon SWORDS , um robô terrestre capaz de transportar M16 e outras armas que foram testadas no Iraque. A Rússia também construiu um veículo não tripulado Uranus-9, armado com um canhão de 30 mm e mísseis anti-tanque guiados. E no ano passado, os russos demonstraram um robô humanóide militar para Putin.O crescente arsenal de robôs militares da China inclui muitos drones para ataque e reconhecimento. CH-4 - UAV de ação prolongada, remanescente do US Predator. Águia Divina - um drone de alta altitude para caçar bombardeiros furtivos. Além disso, robôs com metralhadoras semelhantes ao Platform-M e Talon SWORDS foram mostrados em várias apresentações militares na China.Esses três países estão se aproximando da criação de robôs armados e, aumentando sua autonomia, ao mesmo tempo enfatizam a preservação do papel das pessoas em seu trabalho. Um problema sério aparecerá para a proibição de armas autônomas: não será necessariamente aplicável a armas quase autônomas. Os militares sempre podem desenvolver secretamente robôs armados controlados por pessoas, mas com o toque de um botão entram no modo offline. "Será muito difícil para os robôs imporem um acordo de limitação de armas", conclui Wendell Wallach, especialista em ética e tecnologia da Universidade de Yale. "A diferença entre armas autônomas e não autônomas pode ser apenas uma linha de código", disse ele em uma conferência.Nos filmes, os robôs às vezes se tornam surpreendentemente autônomos, até ganharem consciência quase do zero, o que pega as pessoas de surpresa . No mundo real, apesar da emoção geral do progresso do aprendizado de máquina , os robôs ganham autonomia gradualmente. O mesmo pode ser esperado de armas autônomas.

O canhão Phalanx disparou de forma independenteNo ano passado, essa discussão caiu nas notícias quando um grupo de pesquisadores de IA solicitou a proibição de "armas ofensivas autônomas operando sem controle humano significativo". Em uma carta aberta a uma conferência internacional sobre IA, um grupo de pesquisadores observou que essas armas poderiam levar a uma corrida armamentista internacional e poderiam ser usadas para assassinatos por contrato, desestabilização de nações, supressão de povos e destruição seletiva de grupos étnicos.A carta foi assinada por mais de 20.000 pessoas, incluindo personalidades famosas como o físico Stephen Hawking e o empresário Ilon Musk. Este último doou US $ 10 milhões ao Instituto de Boston no ano passado., empenhada em proteger a vida das pessoas contra a ameaça hipotética de uma IA hostil. Os estudiosos que organizaram a redação - Stuart Russell, da Universidade da Califórnia em Berkeley, Max Tegmark, do MIT, e Toby Walsh, da Universidade de New South Wales, na Austrália - expandiram sua posição em um artigo para a revista IEEE Spectrum. Por exemplo, em um cenário, "um grande número de micro-robôs baratos que podem ser colocados por uma pessoa no mercado negro pode ser morto e milhares ou milhões de pessoas que se encaixam nos critérios do usuário serão capazes de matar".Eles também acrescentaram que “armas autônomas podem se tornar armas de destruição em massa. "Alguns países podem proibir seu uso, enquanto outros países e, claro, terroristas, dificilmente poderão abandoná-lo".Dificilmente se pode dizer que uma nova corrida armamentista, que pode resultar em máquinas de matar inteligentes, autônomas e móveis, servirá ao benefício de toda a humanidade. No entanto, esta corrida já começou.As armas autônomas existem há várias décadas, embora seus espécimes raros até agora tenham sido usados principalmente para defesa. Um exemplo é o Phalanx , uma arma controlada por computador, guiada por radar e montada em navios de guerra da Marinha dos EUA. Ela pode detectar, rastrear, avaliar e disparar automaticamente nos mísseis e aeronaves que se aproximam, o que ela considera uma ameaça. De um modo totalmente autônomo, a participação humana não é necessária.Harop drone destrói alvoA DoDAAM Systems demonstra as capacidades do relógio de robô Super aEgis II.Recentemente, desenvolvedores militares começaram a criar robôs autônomos ofensivos. A empresa Israel Aerospace Industries tem fabricado drones Harpy e Harop, o que leva à ondas de rádio de sistemas de defesa aérea inimiga, e matá-los pela colisão. A empresa afirma que seus UAVs estão vendendo bem em todo o mundo.A empresa sul-coreana DoDAAM Systems desenvolveu o relógio robô Super aEgis II. Ele atira com uma metralhadora e usa a visão computacional para detectar e disparar contra alvos (pessoas) a uma distância de 3 km. Alega-se que os militares sul-coreanos realizaram testes desses robôs na zona desmilitarizada na fronteira com a Coréia do Norte. DoDAAM jávendeu 30 desses dispositivos para outros países, incluindo vários clientes do Oriente Médio.Atualmente, os sistemas com um alto grau de autonomia são muito poucos em comparação com as armas robóticas controladas por pessoas quase o tempo todo, e especialmente durante os disparos. Os analistas prevêem que, com o desenvolvimento de assuntos militares, as armas terão cada vez mais capacidades autônomas."A guerra será completamente diferente e a automação desempenhará um papel em que a velocidade é importante", disse Peter Singer, especialista em robôs militares do grupo não político da Nova América, sediado em Washington. Ele lerá que em futuras batalhas - como em batalhas entre diferentes UAVs, ou quando um navio automático encontrar um submarino automático - uma arma com uma fração de uma segunda vantagem decidirá o resultado da batalha. "Pode haver um conflito repentino e intenso no qual simplesmente não haverá tempo para atualizar as pessoas, porque tudo será decidido em questão de segundos".As forças armadas dos EUA descreveram seus planos de longo prazo para travar um novo tipo de guerra usando sistemas não tripulados, mas ainda não se sabe se eles pretendem armar esses sistemas. AtivadoNo fórum do Washington Post, em março, o subsecretário de Defesa dos EUA, Robert Work, cujo trabalho é garantir que o Pentágono acompanhe a tecnologia mais recente, apontou para a necessidade de investimento em inteligência artificial e robôs. Segundo ele, a presença crescente de sistemas autônomos no campo de batalha é "inevitável".Em relação às armas autônomas, Work insiste que os militares dos EUA "não darão à máquina o poder de tomar decisões fatais". No entanto, ele próprio acrescentou que “se um oponente parecer pronto para transferir tais poderes ... teremos que tomar decisões sobre a questão da competição com ele. Ainda não descobrimos completamente, mas pensamos muito sobre isso. ”Vladimir Putin assiste a um ciborgue militar em um ATV durante a demonstração do ano passadoO primeiro voo do UAV CH-5 da empresa chinesa China Aerospace Science and Technology Corporation,Rússia e China adota uma estratégia semelhante no desenvolvimento de sistemas de combate não tripulados para operações em terra, no mar e no ar, que, embora armados, ainda dependem de operadores vivos. Russian Platform-M é um pequeno robô com controle remoto, equipado com um rifle de assalto Kalashnikov e um lançador de granadas. Assemelha-se ao sistema US Talon SWORDS , um robô terrestre capaz de transportar M16 e outras armas que foram testadas no Iraque. A Rússia também construiu um veículo não tripulado Uranus-9, armado com um canhão de 30 mm e mísseis anti-tanque guiados. E no ano passado, os russos demonstraram um robô humanóide militar para Putin.O crescente arsenal de robôs militares da China inclui muitos drones para ataque e reconhecimento. CH-4 - UAV de ação prolongada, remanescente do US Predator. Águia Divina - um drone de alta altitude para caçar bombardeiros furtivos. Além disso, robôs com metralhadoras semelhantes ao Platform-M e Talon SWORDS foram mostrados em várias apresentações militares na China.Esses três países estão se aproximando da criação de robôs armados e, aumentando sua autonomia, ao mesmo tempo enfatizam a preservação do papel das pessoas em seu trabalho. Um problema sério aparecerá para a proibição de armas autônomas: não será necessariamente aplicável a armas quase autônomas. Os militares sempre podem desenvolver secretamente robôs armados controlados por pessoas, mas com o toque de um botão entram no modo offline. "Será muito difícil para os robôs imporem um acordo de limitação de armas", conclui Wendell Wallach, especialista em ética e tecnologia da Universidade de Yale. "A diferença entre armas autônomas e não autônomas pode ser apenas uma linha de código", disse ele em uma conferência.Nos filmes, os robôs às vezes se tornam surpreendentemente autônomos, até ganharem consciência quase do zero, o que pega as pessoas de surpresa . No mundo real, apesar da emoção geral do progresso do aprendizado de máquina , os robôs ganham autonomia gradualmente. O mesmo pode ser esperado de armas autônomas.Antologia de robôs assassinos

«R.U.R» 1920 – ,

«R.U.R» 1920 – , «2001: » (1968). ,

«2001: » (1968). , « » (1973).

« » (1973). « » (1982). -

« » (1982). - «» (1984). - -800

«» (1984). - -800 (1987). – , .

(1987). – , . (1999).

(1999). « » (2004). , ,

« » (2004). , , Eu, Robot (2004). Robôs humanóides, contornando as Três Leis da Robótica, causam problemas em Chicago

Eu, Robot (2004). Robôs humanóides, contornando as Três Leis da Robótica, causam problemas em Chicago Transformers (2007). Uma gangue de robôs alienígenas liderados por Megatron tenta aniquilar todos osseres humanos O centro do novo grupo de pesquisa de segurança americano em Washington. "Mas é improvável que os militares queiram fazer esse tipo de arma autônoma". Segundo ele, provavelmente, sistemas autônomos atacarão instalações militares como radares, tanques, navios, submarinos e aeronaves.A tarefa de identificar o objetivo - determinar se um objeto pertence ao inimigo - é uma das tarefas mais críticas para a IA. Mover alvos, aviões e mísseis tem uma trajetória que pode ser rastreada e tomada com base na decisão de tentar derrubar um objeto. É assim que o canhão Phalanx funciona nos navios de guerra dos EUA, assim como o sistema israelense de interceptação de mísseis Iron Dome. Mas quando as pessoas são escolhidas como objetivo, essa identificação é complicada. Mesmo sob condições ideais, as tarefas de reconhecer objetos e ambientes com as quais as pessoas lidam o tempo todo podem ser excessivamente complexas para os robôs.Um computador pode distinguir a figura de uma pessoa, mesmo que ela se mova furtivamente. Mas é difícil para o algoritmo entender com o que as pessoas estão ocupadas e quais intenções sua linguagem corporal e expressões faciais revelam. Um homem levanta uma arma ou ajunta? Ele está segurando uma bomba ou um bebê?Scarre afirma que as armas robóticas, tentando escolher um alvo por conta própria, economizam diante das dificuldades. Na sua opinião, a melhor abordagem, do ponto de vista da segurança, legalidade e ética, permanece o desenvolvimento de tais táticas e tecnologias nas quais as pessoas trabalham juntas com robôs . “Os militares podem investir em robótica e automação avançadas, mas ao mesmo tempo deixam a pessoa na cadeia de controle para tomar decisões sobre objetivos, para estar seguro”, diz ele. “Afinal, as pessoas são mais flexíveis e se adaptam melhor a novas situações que podemos não programar. Isso é especialmente importante em uma guerra em que há um adversário tentando derrotar seus sistemas, enganá-los e invadir. ”Não é de surpreender que os sul-coreanos do DoDAAM produzam seus robôs de relógio com severas restrições de autonomia. Agora, seus robôs não dispararão até que uma pessoa confirme o alvo e comande "fogo". "A versão original era um sistema de incêndio automático", disse um engenheiro da empresa à BBC no ano passado . "Mas todos os clientes pediram para incorporar procedimentos de segurança a ele ... Eles estavam preocupados que a arma pudesse estar errada."Outros especialistas acreditam que a única maneira de evitar os erros fatais de uma arma autônoma, especialmente envolvendo civis, é elaborar programas apropriados. "Se somos tão estúpidos que continuamos a nos matar no campo de batalha, e se mais e mais poderes são transferidos para as máquinas, podemos pelo menos garantir que eles estejam realizando seu trabalho de maneira ética", diz Ronald Arkin, IT Especialista do Instituto de Tecnologia da Geórgia.Arkin está confiante de que armas autônomas, como soldados, devem seguir as regras da guerra e as leis da guerra, incluindo as leis humanitárias internacionaisproteger civis e limitar o poder e os tipos de armas permitidas. Isso significa que devemos introduzir certas qualidades morais em seus programas para que eles compreendam situações diferentes e distingam o bem do mal. O software deles deve ter algum tipo de bússola ética.Nos últimos dez anos, a Arkin vem trabalhando nessa bússola. Usando ferramentas da matemática e da lógica do campo da ética das máquinas, ele traduz as leis da guerra e as regras da guerra em variáveis e operações que são compreensíveis para um computador. Por exemplo, uma das variáveis contém o valor de confiança da unidade de controle ético de que o alvo é um inimigo. Outro, booleano, significa se a força de matar armas é permitida ou proibida. No final, Arkin chegou a um certo conjunto de algoritmos e, com a ajuda de simulações em computador e cenários de batalha simplificados - por exemplo, um UAV atacando um grupo de pessoas em campo aberto - ele conseguiu testar sua técnica.Arkin admite que o projeto patrocinado pelas Forças Armadas dos EUA ainda não atingiu o estágio do sistema acabado e foi criado apenas para provar sua operacionalidade. Mas, na opinião dele, os resultados do trabalho mostram que os robôs são ainda melhores do que os humanos podem seguir as regras da guerra. Por exemplo, os robôs podem executar ações com risco de vida com mais restrições do que os humanos, disparando apenas em resposta. Ou, à medida que os civis se aproximam, geralmente podem cessar o fogo, mesmo que eles mesmos sejam destruídos. Os robôs não sofrem de estresse, insatisfação, raiva, medo - e tudo isso pode prejudicar a adoção das decisões corretas nas pessoas. Portanto, em teoria, os robôs podem superar soldados humanos , que freqüentemente e às vezes inevitavelmente cometem erros no calor da batalha."Como resultado, podemos salvar vidas, especialmente as pessoas inocentes que estão presas em uma batalha", diz Arkin. "E se os robôs fazem isso, a moralidade sugere a necessidade de usá-las."É claro que essa visão geralmente não é aceita. armas autônomas insistem que apenas uma proibição preventiva faz sentido, porque essas armas aparecem nos bastidores. "Não existe um sistema de incêndio que possamos apontar e dizer: Sim, aqui ele é um robô assassino", diz Mary Wareham, Gerente de lobby da Human Rights Watch e Coor Coordenador campanha para proibir robôs assassinos ( Campanha para a parada de Robôs do assassino) - coalizões de várias comunidades humanitárias. - Estamos falando de muitos sistemas de armas diferentes que funcionam de maneiras diferentes. Mas estamos preocupados com uma de suas características comuns - a falta de controle humano sobre a função de seleção e ataque de alvos ".Na ONU, as discussões sobre robôs autônomos capazes de matar já duram cinco anos, mas os países não chegaram a um acordo. Em 2013, Christof Heyns, Relator Especial da ONU para os Direitos Humanos, escreveu um influente relatório, em que ele observou que os países têm uma rara oportunidade de discutir os riscos de armas autônomas antes mesmo de serem desenvolvidas. Agora, tendo participado de várias reuniões da ONU, Hines diz que "se você olhar para trás, estou um pouco encorajado, mas se você olhar para o futuro, parece que teremos problemas se não começarmos a avançar mais rápido".Em dezembro, a Convenção das Nações Unidas sobre Armas Clássicas sediará uma conferência que analisa o trabalho de cinco anos, e a questão dos robôs autônomos está na agenda. Mas é improvável que sua proibição seja aceita. Tal decisão exigirá uma decisão unânime de todos os países, e há um desacordo fundamental entre eles sobre o que fazer com a ampla gama de armas autônomas que aparecerão no futuro.Como resultado, disputas sobre robôs assassinos se resumem a uma discussão de pessoas. As armas autônomas, pelo menos inicialmente, serão semelhantes a qualquer tecnologia: podem ser introduzidas com precisão e prudência, ou caoticamente e catastroficamente. E as pessoas terão que aceitar as acusações. Portanto, a pergunta "Os robôs de combate autônomos são uma boa idéia?" não é o caminho certo. É melhor fazer a pergunta: "Confiamos em nós mesmos o suficiente para confiar em robôs para nossas vidas?"

Transformers (2007). Uma gangue de robôs alienígenas liderados por Megatron tenta aniquilar todos osseres humanos O centro do novo grupo de pesquisa de segurança americano em Washington. "Mas é improvável que os militares queiram fazer esse tipo de arma autônoma". Segundo ele, provavelmente, sistemas autônomos atacarão instalações militares como radares, tanques, navios, submarinos e aeronaves.A tarefa de identificar o objetivo - determinar se um objeto pertence ao inimigo - é uma das tarefas mais críticas para a IA. Mover alvos, aviões e mísseis tem uma trajetória que pode ser rastreada e tomada com base na decisão de tentar derrubar um objeto. É assim que o canhão Phalanx funciona nos navios de guerra dos EUA, assim como o sistema israelense de interceptação de mísseis Iron Dome. Mas quando as pessoas são escolhidas como objetivo, essa identificação é complicada. Mesmo sob condições ideais, as tarefas de reconhecer objetos e ambientes com as quais as pessoas lidam o tempo todo podem ser excessivamente complexas para os robôs.Um computador pode distinguir a figura de uma pessoa, mesmo que ela se mova furtivamente. Mas é difícil para o algoritmo entender com o que as pessoas estão ocupadas e quais intenções sua linguagem corporal e expressões faciais revelam. Um homem levanta uma arma ou ajunta? Ele está segurando uma bomba ou um bebê?Scarre afirma que as armas robóticas, tentando escolher um alvo por conta própria, economizam diante das dificuldades. Na sua opinião, a melhor abordagem, do ponto de vista da segurança, legalidade e ética, permanece o desenvolvimento de tais táticas e tecnologias nas quais as pessoas trabalham juntas com robôs . “Os militares podem investir em robótica e automação avançadas, mas ao mesmo tempo deixam a pessoa na cadeia de controle para tomar decisões sobre objetivos, para estar seguro”, diz ele. “Afinal, as pessoas são mais flexíveis e se adaptam melhor a novas situações que podemos não programar. Isso é especialmente importante em uma guerra em que há um adversário tentando derrotar seus sistemas, enganá-los e invadir. ”Não é de surpreender que os sul-coreanos do DoDAAM produzam seus robôs de relógio com severas restrições de autonomia. Agora, seus robôs não dispararão até que uma pessoa confirme o alvo e comande "fogo". "A versão original era um sistema de incêndio automático", disse um engenheiro da empresa à BBC no ano passado . "Mas todos os clientes pediram para incorporar procedimentos de segurança a ele ... Eles estavam preocupados que a arma pudesse estar errada."Outros especialistas acreditam que a única maneira de evitar os erros fatais de uma arma autônoma, especialmente envolvendo civis, é elaborar programas apropriados. "Se somos tão estúpidos que continuamos a nos matar no campo de batalha, e se mais e mais poderes são transferidos para as máquinas, podemos pelo menos garantir que eles estejam realizando seu trabalho de maneira ética", diz Ronald Arkin, IT Especialista do Instituto de Tecnologia da Geórgia.Arkin está confiante de que armas autônomas, como soldados, devem seguir as regras da guerra e as leis da guerra, incluindo as leis humanitárias internacionaisproteger civis e limitar o poder e os tipos de armas permitidas. Isso significa que devemos introduzir certas qualidades morais em seus programas para que eles compreendam situações diferentes e distingam o bem do mal. O software deles deve ter algum tipo de bússola ética.Nos últimos dez anos, a Arkin vem trabalhando nessa bússola. Usando ferramentas da matemática e da lógica do campo da ética das máquinas, ele traduz as leis da guerra e as regras da guerra em variáveis e operações que são compreensíveis para um computador. Por exemplo, uma das variáveis contém o valor de confiança da unidade de controle ético de que o alvo é um inimigo. Outro, booleano, significa se a força de matar armas é permitida ou proibida. No final, Arkin chegou a um certo conjunto de algoritmos e, com a ajuda de simulações em computador e cenários de batalha simplificados - por exemplo, um UAV atacando um grupo de pessoas em campo aberto - ele conseguiu testar sua técnica.Arkin admite que o projeto patrocinado pelas Forças Armadas dos EUA ainda não atingiu o estágio do sistema acabado e foi criado apenas para provar sua operacionalidade. Mas, na opinião dele, os resultados do trabalho mostram que os robôs são ainda melhores do que os humanos podem seguir as regras da guerra. Por exemplo, os robôs podem executar ações com risco de vida com mais restrições do que os humanos, disparando apenas em resposta. Ou, à medida que os civis se aproximam, geralmente podem cessar o fogo, mesmo que eles mesmos sejam destruídos. Os robôs não sofrem de estresse, insatisfação, raiva, medo - e tudo isso pode prejudicar a adoção das decisões corretas nas pessoas. Portanto, em teoria, os robôs podem superar soldados humanos , que freqüentemente e às vezes inevitavelmente cometem erros no calor da batalha."Como resultado, podemos salvar vidas, especialmente as pessoas inocentes que estão presas em uma batalha", diz Arkin. "E se os robôs fazem isso, a moralidade sugere a necessidade de usá-las."É claro que essa visão geralmente não é aceita. armas autônomas insistem que apenas uma proibição preventiva faz sentido, porque essas armas aparecem nos bastidores. "Não existe um sistema de incêndio que possamos apontar e dizer: Sim, aqui ele é um robô assassino", diz Mary Wareham, Gerente de lobby da Human Rights Watch e Coor Coordenador campanha para proibir robôs assassinos ( Campanha para a parada de Robôs do assassino) - coalizões de várias comunidades humanitárias. - Estamos falando de muitos sistemas de armas diferentes que funcionam de maneiras diferentes. Mas estamos preocupados com uma de suas características comuns - a falta de controle humano sobre a função de seleção e ataque de alvos ".Na ONU, as discussões sobre robôs autônomos capazes de matar já duram cinco anos, mas os países não chegaram a um acordo. Em 2013, Christof Heyns, Relator Especial da ONU para os Direitos Humanos, escreveu um influente relatório, em que ele observou que os países têm uma rara oportunidade de discutir os riscos de armas autônomas antes mesmo de serem desenvolvidas. Agora, tendo participado de várias reuniões da ONU, Hines diz que "se você olhar para trás, estou um pouco encorajado, mas se você olhar para o futuro, parece que teremos problemas se não começarmos a avançar mais rápido".Em dezembro, a Convenção das Nações Unidas sobre Armas Clássicas sediará uma conferência que analisa o trabalho de cinco anos, e a questão dos robôs autônomos está na agenda. Mas é improvável que sua proibição seja aceita. Tal decisão exigirá uma decisão unânime de todos os países, e há um desacordo fundamental entre eles sobre o que fazer com a ampla gama de armas autônomas que aparecerão no futuro.Como resultado, disputas sobre robôs assassinos se resumem a uma discussão de pessoas. As armas autônomas, pelo menos inicialmente, serão semelhantes a qualquer tecnologia: podem ser introduzidas com precisão e prudência, ou caoticamente e catastroficamente. E as pessoas terão que aceitar as acusações. Portanto, a pergunta "Os robôs de combate autônomos são uma boa idéia?" não é o caminho certo. É melhor fazer a pergunta: "Confiamos em nós mesmos o suficiente para confiar em robôs para nossas vidas?"Source: https://habr.com/ru/post/pt395139/

All Articles