É possível introduzir ética no algoritmo dos robomobiles?

Pelo assassinato cometido por um robomóvel, o programa (e os programadores) serão julgados

Ano 2034. Um homem bêbado vagueia na calçada à noite, tropeça e cai em frente ao robomóvel, que o atinge e mata no local. Se houvesse uma pessoa ao volante de um carro, a morte seria reconhecida como um acidente, uma vez que a falha estaria no pedestre e nem um único motorista seria capaz de evitá-lo. Mas os padrões para o "motorista médio" (o termo " pessoa razoável " está presente na legislação estrangeira ) desapareceram na década de 2020, quando a disseminação de robomobiles reduziu o número de acidentes em 90%. Agora temos que falar sobre o "robô comum".A família da vítima está processando o fabricante de robomobiles, afirmando que, embora o carro não tenha tempo de frear, ele pode contornar um pedestre, atravessar um sólido duplo e colidir com um robomobile que se aproxima. A reconstrução do incidente com base em sensores de veículos robóticos confirma isso. O advogado do demandante, interrogando um desenvolvedor de software líder em automóveis, pergunta: "Por que o carro não foi embora?"Hoje, o tribunal não pergunta aos motoristas por que eles fizeram algo ou não. A questão é discutível, pois a pessoa está enganada - o motorista pode entrar em pânico, não pensar nisso, reagir por instinto. Mas quando o robô dirige o carro, a pergunta é "por quê?" bastante aceitável. Os padrões éticos das pessoas, que não são muito bem definidos nas leis, fazem muitas suposições diferentes às quais os engenheiros simplesmente não chegaram. O mais importante deles - uma pessoa pode entender quando você precisa se desviar da letra da lei para preservar seu espírito. Agora, os engenheiros precisam ensinar as máquinas e outros robôs a tomar decisões inteligentes.A informatização do processo de controle começou na década de 1970, quando surgiram os sistemas de travagem antibloqueio . Agora, todos os anos, há desenvolvimentos como direção automática, aceleração automática e frenagem de emergência. O teste de máquinas totalmente automáticas, embora com a participação de um motorista humano, já é permitido em alguns lugares na Grã-Bretanha, Holanda, Alemanha e Japão. Nos Estados Unidos, é permitido por lei em quatro estados e no Distrito de Columbia e, pelo menos, não é proibido nos demais. Google, Nissan e Ford afirmam que os robomobiles aparecerão em 5 a 10 anos.Veículos automáticos coletam informações ambientais de sensores - câmeras de vídeo, telêmetros ultrassônicos, radares, lidares. Na Califórnia, os robomobiles devem fornecer ao Departamento de Transportes todos os dados do sensor 30 segundos antes de qualquer colisão que já tenha acumulado o suficiente - incluindo a colisão causada pela máquina do Google . Os engenheiros têm a oportunidade de recuperar eventos na área de colisão com bastante precisão, usando registros do que a máquina pode capturar, as alternativas que considera e a lógica do comportamento. Pode-se fazer com que o computador repita seu raciocínio - da maneira que pode ser solicitado para tornar a pessoa que jogou o jogo ou o simulador de direção.Reguladores e litigantes serão capazes de manter padrões de segurança sobre-humanos para veículos robóticos e examinar minuciosamente colisões que ocorrerão de qualquer maneira - embora raramente. Fabricantes e programadores protegerão as ações de seus produtos de uma maneira que os motoristas de hoje nunca sonharam.Dirigir é sempre um risco, e as decisões relativas à sua distribuição entre motoristas, pedestres, ciclistas e propriedades contêm um componente ético. Para engenheiros e para todas as pessoas, é importante que o sistema de tomada de decisão da máquina pese as conseqüências éticas de suas ações.

Ano 2034. Um homem bêbado vagueia na calçada à noite, tropeça e cai em frente ao robomóvel, que o atinge e mata no local. Se houvesse uma pessoa ao volante de um carro, a morte seria reconhecida como um acidente, uma vez que a falha estaria no pedestre e nem um único motorista seria capaz de evitá-lo. Mas os padrões para o "motorista médio" (o termo " pessoa razoável " está presente na legislação estrangeira ) desapareceram na década de 2020, quando a disseminação de robomobiles reduziu o número de acidentes em 90%. Agora temos que falar sobre o "robô comum".A família da vítima está processando o fabricante de robomobiles, afirmando que, embora o carro não tenha tempo de frear, ele pode contornar um pedestre, atravessar um sólido duplo e colidir com um robomobile que se aproxima. A reconstrução do incidente com base em sensores de veículos robóticos confirma isso. O advogado do demandante, interrogando um desenvolvedor de software líder em automóveis, pergunta: "Por que o carro não foi embora?"Hoje, o tribunal não pergunta aos motoristas por que eles fizeram algo ou não. A questão é discutível, pois a pessoa está enganada - o motorista pode entrar em pânico, não pensar nisso, reagir por instinto. Mas quando o robô dirige o carro, a pergunta é "por quê?" bastante aceitável. Os padrões éticos das pessoas, que não são muito bem definidos nas leis, fazem muitas suposições diferentes às quais os engenheiros simplesmente não chegaram. O mais importante deles - uma pessoa pode entender quando você precisa se desviar da letra da lei para preservar seu espírito. Agora, os engenheiros precisam ensinar as máquinas e outros robôs a tomar decisões inteligentes.A informatização do processo de controle começou na década de 1970, quando surgiram os sistemas de travagem antibloqueio . Agora, todos os anos, há desenvolvimentos como direção automática, aceleração automática e frenagem de emergência. O teste de máquinas totalmente automáticas, embora com a participação de um motorista humano, já é permitido em alguns lugares na Grã-Bretanha, Holanda, Alemanha e Japão. Nos Estados Unidos, é permitido por lei em quatro estados e no Distrito de Columbia e, pelo menos, não é proibido nos demais. Google, Nissan e Ford afirmam que os robomobiles aparecerão em 5 a 10 anos.Veículos automáticos coletam informações ambientais de sensores - câmeras de vídeo, telêmetros ultrassônicos, radares, lidares. Na Califórnia, os robomobiles devem fornecer ao Departamento de Transportes todos os dados do sensor 30 segundos antes de qualquer colisão que já tenha acumulado o suficiente - incluindo a colisão causada pela máquina do Google . Os engenheiros têm a oportunidade de recuperar eventos na área de colisão com bastante precisão, usando registros do que a máquina pode capturar, as alternativas que considera e a lógica do comportamento. Pode-se fazer com que o computador repita seu raciocínio - da maneira que pode ser solicitado para tornar a pessoa que jogou o jogo ou o simulador de direção.Reguladores e litigantes serão capazes de manter padrões de segurança sobre-humanos para veículos robóticos e examinar minuciosamente colisões que ocorrerão de qualquer maneira - embora raramente. Fabricantes e programadores protegerão as ações de seus produtos de uma maneira que os motoristas de hoje nunca sonharam.Dirigir é sempre um risco, e as decisões relativas à sua distribuição entre motoristas, pedestres, ciclistas e propriedades contêm um componente ético. Para engenheiros e para todas as pessoas, é importante que o sistema de tomada de decisão da máquina pese as conseqüências éticas de suas ações.

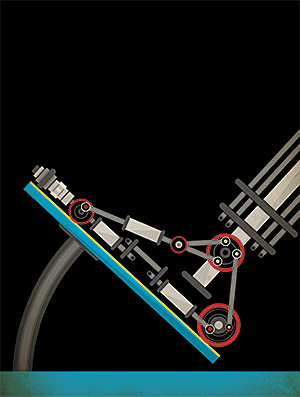

Colisão do Google Car com um ônibusA resposta usual a situações moralmente ambíguas é seguir a lei e minimizar os danos. A estratégia é atraente - não apenas permite que o desenvolvedor defenda facilmente as ações do carro (“Seguimos a lei completamente”), mas também transfere a responsabilidade na determinação da ética para os legisladores. Infelizmente, isso também sobrecarrega demais a lei.Por exemplo, na maioria dos estados, a lei baseia-se no senso comum dos motoristas e fala pouco sobre o comportamento antes de uma colisão. No exemplo descrito, o carro, seguindo estritamente a letra da lei, não atravessa o sólido duplo, arriscando uma colisão com um bêbado - embora exista apenas um robomóvel vazio do outro lado da estrada. A lei raramente faz exceções em situações específicas de emergência, como uma pessoa que cai na estrada - e se o fizer, como é o caso, por exemplo, na Virgínia, o texto da lei implica que atravessar um sólido duplo é legal até o acidente do carro ("Se esse movimento puder ser feito com segurança"). Nesse caso, os desenvolvedores terão que decidir - em quais casos será seguro atravessar o sólido duplo.Um Robomobile raramente terá 100% de certeza de que a estrada está vazia e você pode atravessar um sólido duplo sem medo. Ele avaliará o nível de confiança em 98% ou 99,99%. Os engenheiros precisarão decidir com antecedência qual nível de confiança será suficiente para atravessar um sólido duplo e como o valor aceitável pode variar dependendo do que o robomóvel está tentando evitar na estrada - é um saco de plástico ou um pedestre caído.Os robomobiles já estão tomando decisões sobre a possibilidade de violar a lei. Google admitidoque seus carros podem exceder a velocidade para permanecer no riacho - onde desacelerar é perigoso. A maioria das pessoas prefere exceder a velocidade em várias situações, por exemplo, ao tentar correr para o hospital. Chris Gerdes e Sarah Thornton, da Universidade de Stanford, são contra a estrita incorporação de leis nos algoritmos de tomada de decisão, pois os motoristas parecem considerar leis flexíveis o suficiente para medir o custo de quebrá-las em comparação com o ganho potencial em velocidade. Ninguém quer rastejar atrás de um ciclista por vários quilômetros devido ao fato de que seu carro se recusa a pedir pelo menos um pouco por um sólido duplo.E, mesmo estando dentro da lei, o robomóvel pode tomar muitas pequenas decisões que são sensíveis do ponto de vista da segurança. Normalmente, as faixas na rodovia têm quase o dobro da largura de um carro comum, e os motoristas podem usar essa largura para evitar lixo ou para se afastar de carros desiguais.Na patente de 2014, o Google desenvolve essa ideia e descreve como um robomóvel pode ser colocado em uma faixa para reduzir riscos. A empresa dá um exemplo de um robomóvel em uma estrada de três faixas com um caminhão à direita e um carro pequeno à esquerda. Para otimizar a segurança, o robomóvel deveria ter se movido um pouco para a esquerda, mais perto em uma pequena máquina.Parece saudável, e geralmente todo mundo faz - consciente ou inconscientemente. Mas questões éticas surgem. Movendo-se para a pequena máquina, o robomóvel reduziu o risco, mas o distribuiu de maneira desigual. Uma máquina pequena deve correr maior risco apenas porque é pequena? Se fosse uma questão de preferência para um motorista em particular, ele não significaria nada. Mas se essa redistribuição for formalizada e estendida a todos os robomobiles, as consequências serão mais graves.Em cada exemplo, o robomóvel leva em consideração vários valores - o valor do objeto que ele pode atingir e o valor do passageiro. As pessoas tomam decisões instintivamente e o robô o faz com base em uma estratégia de gerenciamento de risco cuidadosamente definida que define o risco como a quantidade de dano de um evento indesejável, multiplicado por sua probabilidade.Em 2014, o Google também patenteou um aplicativo de gerenciamento de riscos. A patente descreve uma máquina que pode decidir reconstruir para ver melhor o semáforo. Ou o carro pode decidir permanecer na pista para evitar o risco de uma colisão - por exemplo, devido a indicações de um sensor com defeito - mas, ao custo disso, haverá pouca visibilidade do semáforo. O resultado de qualquer uma das decisões recebe probabilidade atribuída, além de valor positivo ou negativo (vantagem ou perda). Cada valor é multiplicado pela probabilidade, e os valores obtidos podem ser somados. Se os benefícios superam as perdas o suficiente, a máquina manobra.O problema é que o risco de colisão é muito pequeno - o motorista médio nos EUA sofre um acidente uma vez a cada 257.000 quilômetros, ou uma vez a cada 12 anos ( na Rússia - uma vez a cada 1,6 anos). Talvez essa diferença se deva ao fato de que, nos Estados Unidos, as pessoas viajam com muito mais frequência na estrada - aprox. Portanto, mesmo começando a receber um fluxo enorme de dados dos robomobiles quando eles saem às ruas, seremos capazes de obter estimativas das probabilidades de vários eventos em breve.Estimar o custo do dano é ainda mais difícil. É fácil avaliar os danos materiais - as seguradoras têm uma vasta experiência nesse assunto -, mas lesões e mortes são outra questão. A história da apropriação da vida de uma pessoa de qualquer valor tem muitos anos e geralmente é expressa na quantidade de dinheiro que poderia ser gasta para impedir a vítima média. Uma melhoria de segurança, com 1% de chance de salvar a vida de 100 pessoas, é uma vítima comum. O Departamento de Transportes recomenda gastar US $ 9,1 milhões para evitar baixas. O número é derivado de dados de marketing, incluindo permissões que as pessoas exigem para trabalhos perigosos e os valores que as pessoas estão dispostas a gastar em equipamentos de segurança - por exemplo, alarmes de fumaça. Você precisa pesar não apenas a segurança, mas também a perda de mobilidade ou tempo,gasto na estrada, que o Departamento estima em US $ 26,44 por hora.Em palavras, tudo parece bonito. Mas a avaliação de riscos em vidas perdidas e o tempo gasto na estrada não inclui diferentes avaliações morais de como colocamos as pessoas em risco. Por exemplo, um robomóvel, avaliando a vida de todas as pessoas igualmente, teria que dar mais espaço a um motociclista sem capacete do que a um motociclista em plena marcha, uma vez que o primeiro terá menor probabilidade de sobreviver. Mas isso é injusto - é possível punir por cuidar de sua segurança?Outra diferença entre a ética de robôs e humanos é que a ética do primeiro pode ser distorcida pelos programadores, mesmo por um bom motivo. Imagine que o algoritmo ajustou o tamanho da zona-tampão para pedestres em diferentes áreas com base na análise do valor da compensação por reclamações registradas por pedestres em um acidente. Por um lado, é razoável, eficiente e bem-intencionado. Por outro lado, penalidades menores podem depender da renda média das pessoas em uma área específica. Então o algoritmo punirá os pobres, dando-lhes uma zona de buffer menor, aumentando assim um pouco o risco de serem derrubados.Há uma tentação de deixar de lado questões como as puramente acadêmicas, mas você não pode contorná-las, porque os programas encaram tudo literalmente. Você terá que avaliar as conseqüências das ações antes que elas precisem ser executadas - no estágio de desenvolvimento, e não no estágio de criação de patches para software.Em parte por causa disso, os pesquisadores usam situações hipotéticas nas quais uma máquina deve escolher entre dois males. Uma das tarefas mais famosas desse tipo é o problema de um carrinho.Um carrinho pesado não controlado é transportado sobre trilhos. No caminho, há cinco pessoas amarradas aos trilhos por um filósofo louco. Felizmente, você pode alternar a seta - e o carrinho seguirá uma rota diferente e alternativa. Infelizmente, há uma pessoa do lado, também amarrada a trilhos. Quais são suas ações?Você vai sacrificar uma vida por várias? Se não, por causa de sua inação, as pessoas ainda vão morrer, então como você pode lidar com essa contradição?Os livros foram escritos sobre os tópicos de tais experimentos e permitem testar sistemas simples e diretos que tratam de questões éticas e encontram áreas em que seria bom se aprofundar em algumas das nuances. Suponha que tenhamos programado um robomóvel para evitar pedestres a todo custo. Se um pedestre aparecer repentinamente em um túnel de duas faixas e o carro não puder frear a tempo, ela terá que desligar a faixa, mesmo que esteja no caminho de um ônibus com passageiros. A probabilidade de tal evento não é tão importante quanto o problema que expõe na lógica do carro-robô - que a absoluta superioridade do valor de um pedestre sobre todas as outras pessoas que usam a estrada pode ser muito perigosa.A ética em robótica é uma tarefa solucionável. Sabemos disso porque em outras áreas já encontramos a oportunidade de lidar com aproximadamente os mesmos riscos e benefícios com segurança e razoabilidade. Os órgãos doadores são distribuídos aos pacientes com base em uma métrica calculada a partir dos anos potenciais de vida e da qualidade de vida. Pessoas de profissões necessárias como agricultor e professor estão isentas de convocação militar.As tarefas dos robomobiles são mais complicadas. Eles precisam decidir rapidamente, com base em informações incompletas, em situações que os programadores podem não prever usando ética que deve ser incorporada ao algoritmo literalmente. Felizmente, as pessoas não esperam sabedoria sobre-humana delas - apenas uma justificativa racional para as ações de uma máquina que avalia questões éticas. A solução não deve ser perfeita - mas cuidadosa e que possa ser protegida.

Colisão do Google Car com um ônibusA resposta usual a situações moralmente ambíguas é seguir a lei e minimizar os danos. A estratégia é atraente - não apenas permite que o desenvolvedor defenda facilmente as ações do carro (“Seguimos a lei completamente”), mas também transfere a responsabilidade na determinação da ética para os legisladores. Infelizmente, isso também sobrecarrega demais a lei.Por exemplo, na maioria dos estados, a lei baseia-se no senso comum dos motoristas e fala pouco sobre o comportamento antes de uma colisão. No exemplo descrito, o carro, seguindo estritamente a letra da lei, não atravessa o sólido duplo, arriscando uma colisão com um bêbado - embora exista apenas um robomóvel vazio do outro lado da estrada. A lei raramente faz exceções em situações específicas de emergência, como uma pessoa que cai na estrada - e se o fizer, como é o caso, por exemplo, na Virgínia, o texto da lei implica que atravessar um sólido duplo é legal até o acidente do carro ("Se esse movimento puder ser feito com segurança"). Nesse caso, os desenvolvedores terão que decidir - em quais casos será seguro atravessar o sólido duplo.Um Robomobile raramente terá 100% de certeza de que a estrada está vazia e você pode atravessar um sólido duplo sem medo. Ele avaliará o nível de confiança em 98% ou 99,99%. Os engenheiros precisarão decidir com antecedência qual nível de confiança será suficiente para atravessar um sólido duplo e como o valor aceitável pode variar dependendo do que o robomóvel está tentando evitar na estrada - é um saco de plástico ou um pedestre caído.Os robomobiles já estão tomando decisões sobre a possibilidade de violar a lei. Google admitidoque seus carros podem exceder a velocidade para permanecer no riacho - onde desacelerar é perigoso. A maioria das pessoas prefere exceder a velocidade em várias situações, por exemplo, ao tentar correr para o hospital. Chris Gerdes e Sarah Thornton, da Universidade de Stanford, são contra a estrita incorporação de leis nos algoritmos de tomada de decisão, pois os motoristas parecem considerar leis flexíveis o suficiente para medir o custo de quebrá-las em comparação com o ganho potencial em velocidade. Ninguém quer rastejar atrás de um ciclista por vários quilômetros devido ao fato de que seu carro se recusa a pedir pelo menos um pouco por um sólido duplo.E, mesmo estando dentro da lei, o robomóvel pode tomar muitas pequenas decisões que são sensíveis do ponto de vista da segurança. Normalmente, as faixas na rodovia têm quase o dobro da largura de um carro comum, e os motoristas podem usar essa largura para evitar lixo ou para se afastar de carros desiguais.Na patente de 2014, o Google desenvolve essa ideia e descreve como um robomóvel pode ser colocado em uma faixa para reduzir riscos. A empresa dá um exemplo de um robomóvel em uma estrada de três faixas com um caminhão à direita e um carro pequeno à esquerda. Para otimizar a segurança, o robomóvel deveria ter se movido um pouco para a esquerda, mais perto em uma pequena máquina.Parece saudável, e geralmente todo mundo faz - consciente ou inconscientemente. Mas questões éticas surgem. Movendo-se para a pequena máquina, o robomóvel reduziu o risco, mas o distribuiu de maneira desigual. Uma máquina pequena deve correr maior risco apenas porque é pequena? Se fosse uma questão de preferência para um motorista em particular, ele não significaria nada. Mas se essa redistribuição for formalizada e estendida a todos os robomobiles, as consequências serão mais graves.Em cada exemplo, o robomóvel leva em consideração vários valores - o valor do objeto que ele pode atingir e o valor do passageiro. As pessoas tomam decisões instintivamente e o robô o faz com base em uma estratégia de gerenciamento de risco cuidadosamente definida que define o risco como a quantidade de dano de um evento indesejável, multiplicado por sua probabilidade.Em 2014, o Google também patenteou um aplicativo de gerenciamento de riscos. A patente descreve uma máquina que pode decidir reconstruir para ver melhor o semáforo. Ou o carro pode decidir permanecer na pista para evitar o risco de uma colisão - por exemplo, devido a indicações de um sensor com defeito - mas, ao custo disso, haverá pouca visibilidade do semáforo. O resultado de qualquer uma das decisões recebe probabilidade atribuída, além de valor positivo ou negativo (vantagem ou perda). Cada valor é multiplicado pela probabilidade, e os valores obtidos podem ser somados. Se os benefícios superam as perdas o suficiente, a máquina manobra.O problema é que o risco de colisão é muito pequeno - o motorista médio nos EUA sofre um acidente uma vez a cada 257.000 quilômetros, ou uma vez a cada 12 anos ( na Rússia - uma vez a cada 1,6 anos). Talvez essa diferença se deva ao fato de que, nos Estados Unidos, as pessoas viajam com muito mais frequência na estrada - aprox. Portanto, mesmo começando a receber um fluxo enorme de dados dos robomobiles quando eles saem às ruas, seremos capazes de obter estimativas das probabilidades de vários eventos em breve.Estimar o custo do dano é ainda mais difícil. É fácil avaliar os danos materiais - as seguradoras têm uma vasta experiência nesse assunto -, mas lesões e mortes são outra questão. A história da apropriação da vida de uma pessoa de qualquer valor tem muitos anos e geralmente é expressa na quantidade de dinheiro que poderia ser gasta para impedir a vítima média. Uma melhoria de segurança, com 1% de chance de salvar a vida de 100 pessoas, é uma vítima comum. O Departamento de Transportes recomenda gastar US $ 9,1 milhões para evitar baixas. O número é derivado de dados de marketing, incluindo permissões que as pessoas exigem para trabalhos perigosos e os valores que as pessoas estão dispostas a gastar em equipamentos de segurança - por exemplo, alarmes de fumaça. Você precisa pesar não apenas a segurança, mas também a perda de mobilidade ou tempo,gasto na estrada, que o Departamento estima em US $ 26,44 por hora.Em palavras, tudo parece bonito. Mas a avaliação de riscos em vidas perdidas e o tempo gasto na estrada não inclui diferentes avaliações morais de como colocamos as pessoas em risco. Por exemplo, um robomóvel, avaliando a vida de todas as pessoas igualmente, teria que dar mais espaço a um motociclista sem capacete do que a um motociclista em plena marcha, uma vez que o primeiro terá menor probabilidade de sobreviver. Mas isso é injusto - é possível punir por cuidar de sua segurança?Outra diferença entre a ética de robôs e humanos é que a ética do primeiro pode ser distorcida pelos programadores, mesmo por um bom motivo. Imagine que o algoritmo ajustou o tamanho da zona-tampão para pedestres em diferentes áreas com base na análise do valor da compensação por reclamações registradas por pedestres em um acidente. Por um lado, é razoável, eficiente e bem-intencionado. Por outro lado, penalidades menores podem depender da renda média das pessoas em uma área específica. Então o algoritmo punirá os pobres, dando-lhes uma zona de buffer menor, aumentando assim um pouco o risco de serem derrubados.Há uma tentação de deixar de lado questões como as puramente acadêmicas, mas você não pode contorná-las, porque os programas encaram tudo literalmente. Você terá que avaliar as conseqüências das ações antes que elas precisem ser executadas - no estágio de desenvolvimento, e não no estágio de criação de patches para software.Em parte por causa disso, os pesquisadores usam situações hipotéticas nas quais uma máquina deve escolher entre dois males. Uma das tarefas mais famosas desse tipo é o problema de um carrinho.Um carrinho pesado não controlado é transportado sobre trilhos. No caminho, há cinco pessoas amarradas aos trilhos por um filósofo louco. Felizmente, você pode alternar a seta - e o carrinho seguirá uma rota diferente e alternativa. Infelizmente, há uma pessoa do lado, também amarrada a trilhos. Quais são suas ações?Você vai sacrificar uma vida por várias? Se não, por causa de sua inação, as pessoas ainda vão morrer, então como você pode lidar com essa contradição?Os livros foram escritos sobre os tópicos de tais experimentos e permitem testar sistemas simples e diretos que tratam de questões éticas e encontram áreas em que seria bom se aprofundar em algumas das nuances. Suponha que tenhamos programado um robomóvel para evitar pedestres a todo custo. Se um pedestre aparecer repentinamente em um túnel de duas faixas e o carro não puder frear a tempo, ela terá que desligar a faixa, mesmo que esteja no caminho de um ônibus com passageiros. A probabilidade de tal evento não é tão importante quanto o problema que expõe na lógica do carro-robô - que a absoluta superioridade do valor de um pedestre sobre todas as outras pessoas que usam a estrada pode ser muito perigosa.A ética em robótica é uma tarefa solucionável. Sabemos disso porque em outras áreas já encontramos a oportunidade de lidar com aproximadamente os mesmos riscos e benefícios com segurança e razoabilidade. Os órgãos doadores são distribuídos aos pacientes com base em uma métrica calculada a partir dos anos potenciais de vida e da qualidade de vida. Pessoas de profissões necessárias como agricultor e professor estão isentas de convocação militar.As tarefas dos robomobiles são mais complicadas. Eles precisam decidir rapidamente, com base em informações incompletas, em situações que os programadores podem não prever usando ética que deve ser incorporada ao algoritmo literalmente. Felizmente, as pessoas não esperam sabedoria sobre-humana delas - apenas uma justificativa racional para as ações de uma máquina que avalia questões éticas. A solução não deve ser perfeita - mas cuidadosa e que possa ser protegida.Source: https://habr.com/ru/post/pt395143/

All Articles