Como o data center regional do estado foi criado

"Não é um lugar que pinta uma pessoa, mas uma pessoa é um lugar". Todos nós vemos regularmente resenhas de vários tipos de centros de processamento de dados (DPCs): grandes, pequenos, subaquáticos, árticos, inovadores, produtivos etc. No entanto, praticamente não há resenhas desses heróis invisíveis, que eles trabalham para o nosso bem nas masmorras estaduais, e mais ainda nas regiões. Portanto, quero compartilhar minha própria experiência na criação de um data center no território de Stavropol.

"Não é um lugar que pinta uma pessoa, mas uma pessoa é um lugar". Todos nós vemos regularmente resenhas de vários tipos de centros de processamento de dados (DPCs): grandes, pequenos, subaquáticos, árticos, inovadores, produtivos etc. No entanto, praticamente não há resenhas desses heróis invisíveis, que eles trabalham para o nosso bem nas masmorras estaduais, e mais ainda nas regiões. Portanto, quero compartilhar minha própria experiência na criação de um data center no território de Stavropol.Conhecimento

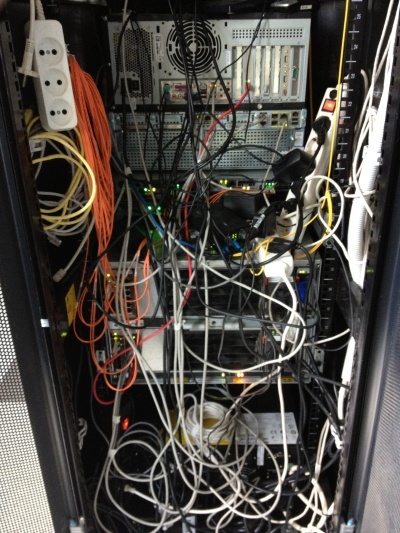

Era um dia quente de verão, como me lembro agora - 18 de junho de 2012. Naquele dia, entrando nas paredes do nosso futuro datacenter, vi exatamente essa imagem, que, francamente, me levou a um pequeno choque. Conheça o GKU SK "Centro Regional de Tecnologias da Informação" no início de sua existência. Todas as imagens são clicáveis. Parecia o único rack dentro do nosso futuro data center em junho de 2012.

Era uma organização bastante jovem. Sua principal tarefa no momento do início de minha atividade era o apoio ao gerenciamento eletrônico de documentos das autoridades públicas (OGV). Meu objetivo era criar um data center e uma organização que o servisse. Todos os sistemas de informações de estado existentes devem ter se mudado para o data center, bem como todos os recém-criados. Naquela época, houve um rápido crescimento de serviços públicos eletrônicos e a automação geral das autoridades públicas.Naquela época, não havia um entendimento específico do que era o governo eletrônico. O principal foi o entendimento de que “não é o lugar que colore a pessoa, mas a pessoa - o lugar”. Eu tinha uma equipe pequena, composta por mim, mas isso foi o suficiente para começar, principalmente porque a automação dos processos de rotina evita inchaços desnecessários da equipe. E é assim que o data center era antes da minha partida, em julho de 2014.

Meu objetivo era criar um data center e uma organização que o servisse. Todos os sistemas de informações de estado existentes devem ter se mudado para o data center, bem como todos os recém-criados. Naquela época, houve um rápido crescimento de serviços públicos eletrônicos e a automação geral das autoridades públicas.Naquela época, não havia um entendimento específico do que era o governo eletrônico. O principal foi o entendimento de que “não é o lugar que colore a pessoa, mas a pessoa - o lugar”. Eu tinha uma equipe pequena, composta por mim, mas isso foi o suficiente para começar, principalmente porque a automação dos processos de rotina evita inchaços desnecessários da equipe. E é assim que o data center era antes da minha partida, em julho de 2014. Antes de ingressar nesta organização, trabalhei como especialista líder no departamento de suporte de um dos principais bancos. E essa experiência foi muito útil para implementação no OGV . Em geral, gostei muito do setor bancário do ponto de vista da TI, mas essa é uma história diferente. Aqui, eu tinha que cumprir em certa medida as funções do "cardeal cinza": o engenheiro-chefe que estava ausente na equipe.O data center que eu crio não deve ser apenas confiável, mas desastroso, produtivo e barato. Parece-me que é por isso que fui convidado a trabalhar aqui, porque primeiro tive que conseguir o uso efetivo do que já está lá. E os integradores tiveram apenas uma sugestão: se você me der mais dinheiro ... Incluindo é por isso que eu não recorri aos serviços de integradores, etc.Como todos os recursos realmente foram transferidos para nossa "nuvem" - tivemos que introduzir o conceito de "nuvem pública privada", devido ao fato de que o aparato conceitual existente, consistindo em "nuvens públicas" e "privadas", não satisfazia completamente a lógica de fornecer recursos. Do lado de fora, havia uma "nuvem privada"; do lado de dentro, uma "nuvem pública", mas apenas para o UGA. Nesse sentido, havia alguns recursos de licenciamento de software.Consegui decidir alguns momentos conceituais antes de vir para a organização, eles tinham que ser dados como garantidos. O projeto foi desenvolvido em estreita colaboração com IBM, Microsoft, Cisco. Por que exatamente esses fornecedores? Para mim - foi assim que aconteceu historicamente. Eu me arrependo? Nem um pouco! Outros fornecedores poderiam ser usados? Obviamente, por exemplo, DELL, HP ou qualquer outro, bem como suas combinações arbitrárias.Como uma plataforma de virtualização foi adquirida - VMWare, na época 5 versões. Acho que aqui todos concordam que a escolha é praticamente incontestável, porque outros não forneceram recursos semelhantes à tolerância a falhas.Durante a auditoria inicial da capacidade disponível em racks pela cidade, encontrei um par de chassis IBM BladeCenter: E e H. O chassi estava equipado com blades HS22, que estavam longe do pior, um meio difícil na época. A condição, é claro, era um pouco deplorável; os indicadores de erro de gravação eram especialmente irritantes. Vista de um dos racks disponíveis em junho de 2012. Preste atenção à instalação de equipamentos "prontos para uso", especialmente equipamentos da Cisco.

Antes de ingressar nesta organização, trabalhei como especialista líder no departamento de suporte de um dos principais bancos. E essa experiência foi muito útil para implementação no OGV . Em geral, gostei muito do setor bancário do ponto de vista da TI, mas essa é uma história diferente. Aqui, eu tinha que cumprir em certa medida as funções do "cardeal cinza": o engenheiro-chefe que estava ausente na equipe.O data center que eu crio não deve ser apenas confiável, mas desastroso, produtivo e barato. Parece-me que é por isso que fui convidado a trabalhar aqui, porque primeiro tive que conseguir o uso efetivo do que já está lá. E os integradores tiveram apenas uma sugestão: se você me der mais dinheiro ... Incluindo é por isso que eu não recorri aos serviços de integradores, etc.Como todos os recursos realmente foram transferidos para nossa "nuvem" - tivemos que introduzir o conceito de "nuvem pública privada", devido ao fato de que o aparato conceitual existente, consistindo em "nuvens públicas" e "privadas", não satisfazia completamente a lógica de fornecer recursos. Do lado de fora, havia uma "nuvem privada"; do lado de dentro, uma "nuvem pública", mas apenas para o UGA. Nesse sentido, havia alguns recursos de licenciamento de software.Consegui decidir alguns momentos conceituais antes de vir para a organização, eles tinham que ser dados como garantidos. O projeto foi desenvolvido em estreita colaboração com IBM, Microsoft, Cisco. Por que exatamente esses fornecedores? Para mim - foi assim que aconteceu historicamente. Eu me arrependo? Nem um pouco! Outros fornecedores poderiam ser usados? Obviamente, por exemplo, DELL, HP ou qualquer outro, bem como suas combinações arbitrárias.Como uma plataforma de virtualização foi adquirida - VMWare, na época 5 versões. Acho que aqui todos concordam que a escolha é praticamente incontestável, porque outros não forneceram recursos semelhantes à tolerância a falhas.Durante a auditoria inicial da capacidade disponível em racks pela cidade, encontrei um par de chassis IBM BladeCenter: E e H. O chassi estava equipado com blades HS22, que estavam longe do pior, um meio difícil na época. A condição, é claro, era um pouco deplorável; os indicadores de erro de gravação eram especialmente irritantes. Vista de um dos racks disponíveis em junho de 2012. Preste atenção à instalação de equipamentos "prontos para uso", especialmente equipamentos da Cisco. Como sistema de armazenamento, uma prateleira DS3512, conectada oticamente, com unidades de 2 TB instaladas, foi instalada em um site. Em outro site, a prateleira DS3512 e DS3524 foi instalada.No site de backup, o espaço livre foi alocado para que o VMWare não fosse iniciado sem intervenção manual: ele detectou outras cópias instaladas e parou, iniciando apenas com a chave correspondente. A distribuição em si foi de acordo com o princípio: cada máquina virtual possui seu próprio LUN. Quando era necessário alocar espaço adicional à máquina virtual, mas no LUN existente, não era ... Ossites foram conectados entre si por uma fina rede de dados com uma largura de 1 Gbit / s. Não havia rede dedicada para a mesma virtualização e tráfego de serviço.Após uma breve revisão e auditoria da infraestrutura de TI (e foi breve, já que praticamente não havia infraestrutura), conclui-se que tenho um exemplo clássico de como fazê-lo. Não havia esquemas, nem documentação de acompanhamento, até as senhas dos administradores estavam longe de serem conhecidas, elas precisavam ser redefinidas e restauradas.Eu decidi trabalhar.

Como sistema de armazenamento, uma prateleira DS3512, conectada oticamente, com unidades de 2 TB instaladas, foi instalada em um site. Em outro site, a prateleira DS3512 e DS3524 foi instalada.No site de backup, o espaço livre foi alocado para que o VMWare não fosse iniciado sem intervenção manual: ele detectou outras cópias instaladas e parou, iniciando apenas com a chave correspondente. A distribuição em si foi de acordo com o princípio: cada máquina virtual possui seu próprio LUN. Quando era necessário alocar espaço adicional à máquina virtual, mas no LUN existente, não era ... Ossites foram conectados entre si por uma fina rede de dados com uma largura de 1 Gbit / s. Não havia rede dedicada para a mesma virtualização e tráfego de serviço.Após uma breve revisão e auditoria da infraestrutura de TI (e foi breve, já que praticamente não havia infraestrutura), conclui-se que tenho um exemplo clássico de como fazê-lo. Não havia esquemas, nem documentação de acompanhamento, até as senhas dos administradores estavam longe de serem conhecidas, elas precisavam ser redefinidas e restauradas.Eu decidi trabalhar.Início da jornada

Em uma organização tão séria no futuro, no momento da minha chegada da infraestrutura de TI, não havia absolutamente nada: um comutador inteligente único, uma rede ponto a ponto, recursos compartilhados em todos os locais de trabalho ... Em geral, tudo é exatamente como você imagina a situação na região.Consequentemente, a infraestrutura da empresa foi criada rapidamente inicialmente. Pelo que foi pedido tudo o que estava disponível naquele momento. Armado com um testador de rede, encontrei e assinei todos os fios. Porque no momento da fiação, não havia plano de trabalhos - em algum lugar, em vez de telefones, havia PCs, em algum lugar não havia fios suficientes e muitos outros "encantos" padrão.Infelizmente, ao projetar a sala do servidor para o futuro data center, ninguém construiu um piso elevado ou uma bandeja de arame sob o teto. Naturalmente, não havia mais dinheiro para ambos, então tive que trazer a beleza por conta própria.Como ninguém me permitiu simplesmente encurtar os fios naquele momento: "de repente, você precisa mover o rack para o canto mais distante da sala, e então?" - Eu tive que fazer a 110ª cruz sob o teto, a partir da qual já abaixamos os fios no rack. Para que, em caso de movimento do rack, os fios curtos possam ser removidos da cruz, instalando os mais longos lá. Vista do 110º painel transversal da parede durante a instalação, bem como uma faca para a terminação dos fios. Também foi imediatamente determinado que os cabos de manobra seriam codificados por cores, uma vez que havia apenas um cabo azul e vermelho, a telefonia precisava ser vermelha e tudo na rede era azul. Tipo de rack antes e depois da instalação.

No rack, encontrei um PBX de escritório Panasonic KX-NCP500 equipado com 4 linhas de extensão da cidade e 8. Eu estava menos interessado nas linhas telefônicas internas; mesmo assim, era um PBX IP: gradualmente transferi tudo para o VOIP. Como não tinha uma experiência séria na configuração do PABX, tive que mexer um pouco. Apenas entender a necessidade de criar seu próprio servidor STUN valeu a pena ...

Também foi imediatamente determinado que os cabos de manobra seriam codificados por cores, uma vez que havia apenas um cabo azul e vermelho, a telefonia precisava ser vermelha e tudo na rede era azul. Tipo de rack antes e depois da instalação.

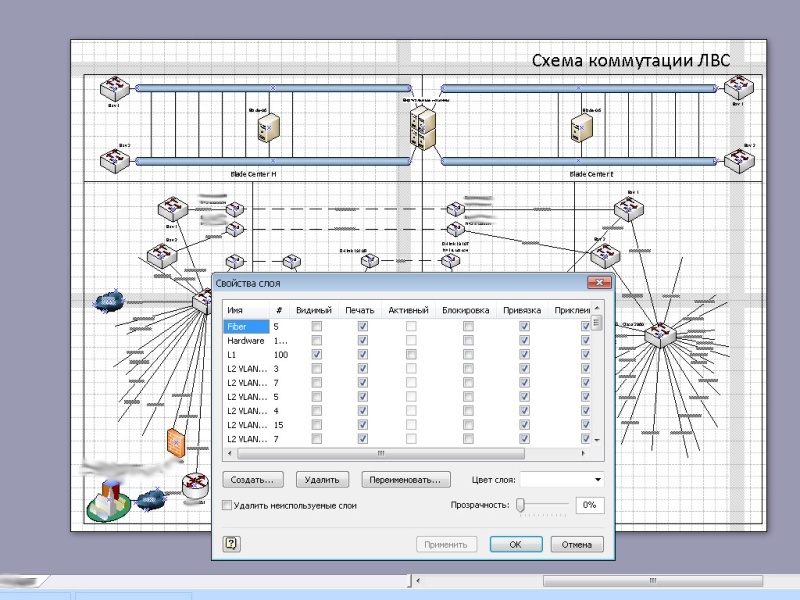

No rack, encontrei um PBX de escritório Panasonic KX-NCP500 equipado com 4 linhas de extensão da cidade e 8. Eu estava menos interessado nas linhas telefônicas internas; mesmo assim, era um PBX IP: gradualmente transferi tudo para o VOIP. Como não tinha uma experiência séria na configuração do PABX, tive que mexer um pouco. Apenas entender a necessidade de criar seu próprio servidor STUN valeu a pena ... Como tal, a organização não tinha sua própria rede; todos os computadores estavam localizados em uma intranet grande. Não me convinha, como uma pessoa que não tinha conhecimento em primeira mão de segurança da informação: na extremidade da rede, instalei e configurei um roteador baseado no FreeBSD e segmentei a própria rede para que eu pudesse controlar totalmente o inter-funcionamento. Com essa abordagem, geralmente apenas um segmento sofre.Sobre a própria rede OGV , ficou claro apenas que ela existia em algum lugar. Eu tive que restaurar toda a topologia de rede com base nas configurações do equipamento, esboçar e documentar cuidadosamente. As configurações gradualmente assumiram uma forma humana; a descrição e a lógica de nomes apareceram.Depois de quase seis meses, finalmente encontrei a documentação na rede OGV. Infelizmente, porém, era 90% inconsistente com o que era de fato. Foi fabricado com uma qualidade muito alta, foi um dos poucos documentos em que foi possível trabalhar. Mas ninguém, a julgar pelas configurações, funcionou.Conforme a rede foi examinada, atualizei todos os nós, pois quase todos os equipamentos tinham um software muito desatualizado instalado. Em algum lugar isso não era necessário, mas em algum lugar corrigiu os problemas existentes. As visualizações antiga (esquerda, 2012) e nova (direita, 2016) da página principal do site.

Como tal, a organização não tinha sua própria rede; todos os computadores estavam localizados em uma intranet grande. Não me convinha, como uma pessoa que não tinha conhecimento em primeira mão de segurança da informação: na extremidade da rede, instalei e configurei um roteador baseado no FreeBSD e segmentei a própria rede para que eu pudesse controlar totalmente o inter-funcionamento. Com essa abordagem, geralmente apenas um segmento sofre.Sobre a própria rede OGV , ficou claro apenas que ela existia em algum lugar. Eu tive que restaurar toda a topologia de rede com base nas configurações do equipamento, esboçar e documentar cuidadosamente. As configurações gradualmente assumiram uma forma humana; a descrição e a lógica de nomes apareceram.Depois de quase seis meses, finalmente encontrei a documentação na rede OGV. Infelizmente, porém, era 90% inconsistente com o que era de fato. Foi fabricado com uma qualidade muito alta, foi um dos poucos documentos em que foi possível trabalhar. Mas ninguém, a julgar pelas configurações, funcionou.Conforme a rede foi examinada, atualizei todos os nós, pois quase todos os equipamentos tinham um software muito desatualizado instalado. Em algum lugar isso não era necessário, mas em algum lugar corrigiu os problemas existentes. As visualizações antiga (esquerda, 2012) e nova (direita, 2016) da página principal do site. Também foi desenvolvido um site, ao mesmo tempo em que seus próprios servidores de nomes, hospedagem virtual e serviço de correio foram criados. Desconfio de organizações em que os funcionários têm endereços para correspondência em serviços claramente públicos, especialmente em agências governamentais.Em geral, os primeiros dois meses de trabalho passaram, eu acho, muito proveitosos.

Também foi desenvolvido um site, ao mesmo tempo em que seus próprios servidores de nomes, hospedagem virtual e serviço de correio foram criados. Desconfio de organizações em que os funcionários têm endereços para correspondência em serviços claramente públicos, especialmente em agências governamentais.Em geral, os primeiros dois meses de trabalho passaram, eu acho, muito proveitosos.Primeira etapa

Inicialmente, o data center, exceto o trabalho do fluxo de trabalho interdepartamental, não era mais usado para nada. Sem dúvida, o gerenciamento de documentos é uma das partes mais importantes do trabalho das autoridades estaduais. Muitas vezes, justamente devido à complexidade do fluxo de trabalho, muitos problemas surgem no trabalho de nosso estado, e é o fluxo de trabalho eletrônico que é a saída dessa situação.Penso que a pergunta mais interessante é: em que trabalha o governo eletrônico no data center?O datacenter em si consiste em vários sites geograficamente distribuídos, portanto, o conceito de tolerância a desastres é implementado e o trabalho está em andamento 24/7/365. Os locais foram interconectados pelo tronco principal de 32 fibras monomodo.O núcleo do data center são os blades IBM HS22 e HS23 (agora Lenovo), que são distribuídos em pares pelas plataformas. Cada chassi acomoda 14 lâminas; no estágio inicial, cinco lâminas foram instaladas.Cada blade possui dois processadores, se não me engano, E5650 (6 núcleos, cache de 12MB), RAM para os olhos de 192 GB. Blades sem discos, por dentro, decidi instalar o USB-flash com uma imagem VMWare para maximizar a separação de desempenho e armazenamento, os logs são gravados em um armazenamento comum, a ligação ascendente de cada blade é de 2 Gb / s. O uplink pode ser aumentado para 10 Gbit / s instalando o switch apropriado no chassi e uma placa de rede em cada blade. Nosso tronco principal de 32 fibras. Como o OS - VMWare vSphere (quando saí, era 5.5) Standard. Em uma versão mais avançada, eu não entendi o ponto: a funcionalidade proposta era suficiente em excesso. E o que estava faltando - você poderia escrever a si mesmo.No futuro, o número de blades foi aumentado devido aos servidores IBM HS23 um pouco mais poderosos.A redundância de energia em cada local era diferente, mas não inferior a duas fontes de energia. Além disso, em cada rack, há UPSs instalados adicionalmente que alimentam o rack, em pares: as fontes de alimentação dos dispositivos são alimentadas por fontes diferentes. Pode ser desnecessário, mas houve alguns momentos em que os no-breaks montados em rack vieram em socorro. Não há muito, mas não há muita redundância em tais sistemas.O resfriamento também foi variado. No local principal, eram condicionadores de ar industriais montados na parede com uma unidade de balanceamento. A temperatura foi mantida em 21 graus. Em outro local, estes eram condicionadores de ar de piso industrial e um suprimento de ar subterrâneo. A IBM o SVC . Controlador do nosso sistema de armazenamento.

O sistema de armazenamento é escalável, com base no controlador IBM SVC , o que permitiu obter redundância do mesmo RAID 6 + 1, redundância ao longo de vários caminhos, conexão entre unidades via ótica de uplink 8Gb / s. Qualquer parte do data center pode, a qualquer momento, entrar em operação autônoma no caso de um acidente ou manutenção de rotina. Quase todos os recursos físicos são virtualizados em um data center em funcionamento: o armazenamento é virtualizado com base no IBM

Como o OS - VMWare vSphere (quando saí, era 5.5) Standard. Em uma versão mais avançada, eu não entendi o ponto: a funcionalidade proposta era suficiente em excesso. E o que estava faltando - você poderia escrever a si mesmo.No futuro, o número de blades foi aumentado devido aos servidores IBM HS23 um pouco mais poderosos.A redundância de energia em cada local era diferente, mas não inferior a duas fontes de energia. Além disso, em cada rack, há UPSs instalados adicionalmente que alimentam o rack, em pares: as fontes de alimentação dos dispositivos são alimentadas por fontes diferentes. Pode ser desnecessário, mas houve alguns momentos em que os no-breaks montados em rack vieram em socorro. Não há muito, mas não há muita redundância em tais sistemas.O resfriamento também foi variado. No local principal, eram condicionadores de ar industriais montados na parede com uma unidade de balanceamento. A temperatura foi mantida em 21 graus. Em outro local, estes eram condicionadores de ar de piso industrial e um suprimento de ar subterrâneo. A IBM o SVC . Controlador do nosso sistema de armazenamento.

O sistema de armazenamento é escalável, com base no controlador IBM SVC , o que permitiu obter redundância do mesmo RAID 6 + 1, redundância ao longo de vários caminhos, conexão entre unidades via ótica de uplink 8Gb / s. Qualquer parte do data center pode, a qualquer momento, entrar em operação autônoma no caso de um acidente ou manutenção de rotina. Quase todos os recursos físicos são virtualizados em um data center em funcionamento: o armazenamento é virtualizado com base no IBM SVC ; recursos de processador e RAM são virtualizados com base no VMWare vSphere. Se usarmos a virtualização para usar a VLAN em comutadores, podemos assumir que a infraestrutura de rede também seja virtualizada.Quase todo o equipamento que suporta controle remoto, conectei à rede e configurei. Em locais remotos, tudo funciona, inclusive através de tomadas elétricas controladas (que apareceram mais tarde, no segundo estágio); portanto, no caso de falha de qualquer equipamento sem controle remoto, ele pode ser redefinido por energia.O data center foi criado em várias etapas. A primeira fase incluiu colocar em ordem e criar uma infraestrutura de nuvem. O objetivo original era criar uma camada de armazenamento virtualizado com base no IBM SVC .À medida que o plano estava sendo implementado, os servidores anteriormente localizados em organizações de terceiros começaram a se mudar para o nosso site. Por isso, movemos vários servidores IBM antigos com serviços operacionais que consumiram e aqueceram mais de um chassi BladeCenter. Obviamente, gradualmente, os serviços deles foram para a "nuvem". Tipo de racks no editor.

A primeira coisa é o plano. Naquele momento, eu já podia trabalhar como quisesse (mesmo assim, já havia alguns projetos concluídos e já ganhava a confiança de que havia trabalhos sem falhas). Portanto, a princípio montei as estantes no editor, discutindo e discutindo simultaneamente comigo mesma. O processo de montagem de equipamentos em um rack.

SVC ; recursos de processador e RAM são virtualizados com base no VMWare vSphere. Se usarmos a virtualização para usar a VLAN em comutadores, podemos assumir que a infraestrutura de rede também seja virtualizada.Quase todo o equipamento que suporta controle remoto, conectei à rede e configurei. Em locais remotos, tudo funciona, inclusive através de tomadas elétricas controladas (que apareceram mais tarde, no segundo estágio); portanto, no caso de falha de qualquer equipamento sem controle remoto, ele pode ser redefinido por energia.O data center foi criado em várias etapas. A primeira fase incluiu colocar em ordem e criar uma infraestrutura de nuvem. O objetivo original era criar uma camada de armazenamento virtualizado com base no IBM SVC .À medida que o plano estava sendo implementado, os servidores anteriormente localizados em organizações de terceiros começaram a se mudar para o nosso site. Por isso, movemos vários servidores IBM antigos com serviços operacionais que consumiram e aqueceram mais de um chassi BladeCenter. Obviamente, gradualmente, os serviços deles foram para a "nuvem". Tipo de racks no editor.

A primeira coisa é o plano. Naquele momento, eu já podia trabalhar como quisesse (mesmo assim, já havia alguns projetos concluídos e já ganhava a confiança de que havia trabalhos sem falhas). Portanto, a princípio montei as estantes no editor, discutindo e discutindo simultaneamente comigo mesma. O processo de montagem de equipamentos em um rack.

A instalação foi realizada de acordo com os padrões, melhores práticas e recomendações descritas, inclusive no IBM RedBook. É claro que, pela primeira vez, meu “vamos ler a documentação” foi ridicularizado, mas após o “método científico de cutucada”, os servidores se recusaram a se encaixar, porque para um a distância entre os guias é muito grande, para o outro é muito pequeno redbook tamanhos padrão para a montagem de racks, depois que tudo se juntou pela primeira vez. A primeira etapa do data center, junho de 2013. No fundo está o pandeiro do Administrador Supremo.

A instalação foi realizada de acordo com os padrões, melhores práticas e recomendações descritas, inclusive no IBM RedBook. É claro que, pela primeira vez, meu “vamos ler a documentação” foi ridicularizado, mas após o “método científico de cutucada”, os servidores se recusaram a se encaixar, porque para um a distância entre os guias é muito grande, para o outro é muito pequeno redbook tamanhos padrão para a montagem de racks, depois que tudo se juntou pela primeira vez. A primeira etapa do data center, junho de 2013. No fundo está o pandeiro do Administrador Supremo. Naquela época, quase um ano já se passara desde que eu trabalhava nessa organização em benefício do Estado. Para este ano, nunca recorremos aos serviços de integradores ou de outros contratados. Não vou dissimular, várias vezes pedi ajuda de colegas da IBM com perguntas sobre seus equipamentos e resolvemos juntos os problemas que surgiram, pelos quais muitos agradecem a eles.O data center já nessa fase se tornou indicativo e recebia visitantes regularmente para demonstrar como a infraestrutura de TI deveria funcionar e parecer. Isso não deve parecer com a infraestrutura de TI. A foto foi tirada no segundo dia do meu trabalho, 2012.

Naquela época, quase um ano já se passara desde que eu trabalhava nessa organização em benefício do Estado. Para este ano, nunca recorremos aos serviços de integradores ou de outros contratados. Não vou dissimular, várias vezes pedi ajuda de colegas da IBM com perguntas sobre seus equipamentos e resolvemos juntos os problemas que surgiram, pelos quais muitos agradecem a eles.O data center já nessa fase se tornou indicativo e recebia visitantes regularmente para demonstrar como a infraestrutura de TI deveria funcionar e parecer. Isso não deve parecer com a infraestrutura de TI. A foto foi tirada no segundo dia do meu trabalho, 2012. No processo de implementação do data center, ficou claro para mim que os recursos precisavam ser entregues com eficiência aos consumidores - órgãos governamentais. Além disso, alguns sistemas de informações escritas "originais" que foram movidos para a nuvem geraram quantidades muito grandes de informações pela rede.O acesso exclusivo pela Internet não parecia uma boa idéia, porque não oferecia velocidade de acesso suficiente. E expandir a conexão com a Internet em todos os grupos públicos é um procedimento extremamente caro. Portanto, decidiu-se implantar nossa própria rede: economicamente, do ponto de vista da segurança, isso se mostrou muito mais rentável do que alugar canais de comunicação do mesmo Rostelecom.Por que isso não foi feito inicialmente? A resposta é simples: não havia especialistas qualificados para este trabalho, apenas contratados externos. E eles procuram se conectar à terceirização.Nesse ponto, eu tive que planejar e construir a infraestrutura do provedor. Ao mesmo tempo, muitas redes OGV precisavam ser auditadas . Obviamente, em alguns OGVs havia serviços de TI bastante fortes (por exemplo, no Ministério das Finanças, no Ministério da Defesa, no aparato governamental e outros). Mas havia também francamente fracos, onde eles nem podiam comprimir o fio. Eu tive que me submeter tão completamente, já que a qualificação permitia.Portanto, em particular, eu tive que desenvolver uma arquitetura de rede típica do OGVqual deles teve que lutar. Padronização e tipificação são a chave para uma operação eficaz. De acordo com meus cálculos preliminares, deveria haver pelo menos 100-150 objetos de administração por pessoa em nossa organização. Um dos suprimentos de equipamentos da Cisco.

Obviamente, na rede em construção, além das tecnologias óbvias de VLAN, outras tecnologias modernas foram usadas para facilitar a administração: OSPF, VTP, PVST, MSTP, HSRP, QoS, etc. Obviamente, eu queria aumentar a redundância de estado, mas, infelizmente, o ASR não tinha recursos de hardware suficientes. Infelizmente, não funcionou para acessar o MPLS. Sim, e não havia necessidade. À medida que a rede se expandia, comecei a assumir o controle dos equipamentos OGV

No processo de implementação do data center, ficou claro para mim que os recursos precisavam ser entregues com eficiência aos consumidores - órgãos governamentais. Além disso, alguns sistemas de informações escritas "originais" que foram movidos para a nuvem geraram quantidades muito grandes de informações pela rede.O acesso exclusivo pela Internet não parecia uma boa idéia, porque não oferecia velocidade de acesso suficiente. E expandir a conexão com a Internet em todos os grupos públicos é um procedimento extremamente caro. Portanto, decidiu-se implantar nossa própria rede: economicamente, do ponto de vista da segurança, isso se mostrou muito mais rentável do que alugar canais de comunicação do mesmo Rostelecom.Por que isso não foi feito inicialmente? A resposta é simples: não havia especialistas qualificados para este trabalho, apenas contratados externos. E eles procuram se conectar à terceirização.Nesse ponto, eu tive que planejar e construir a infraestrutura do provedor. Ao mesmo tempo, muitas redes OGV precisavam ser auditadas . Obviamente, em alguns OGVs havia serviços de TI bastante fortes (por exemplo, no Ministério das Finanças, no Ministério da Defesa, no aparato governamental e outros). Mas havia também francamente fracos, onde eles nem podiam comprimir o fio. Eu tive que me submeter tão completamente, já que a qualificação permitia.Portanto, em particular, eu tive que desenvolver uma arquitetura de rede típica do OGVqual deles teve que lutar. Padronização e tipificação são a chave para uma operação eficaz. De acordo com meus cálculos preliminares, deveria haver pelo menos 100-150 objetos de administração por pessoa em nossa organização. Um dos suprimentos de equipamentos da Cisco.

Obviamente, na rede em construção, além das tecnologias óbvias de VLAN, outras tecnologias modernas foram usadas para facilitar a administração: OSPF, VTP, PVST, MSTP, HSRP, QoS, etc. Obviamente, eu queria aumentar a redundância de estado, mas, infelizmente, o ASR não tinha recursos de hardware suficientes. Infelizmente, não funcionou para acessar o MPLS. Sim, e não havia necessidade. À medida que a rede se expandia, comecei a assumir o controle dos equipamentos OGV , ajustando-o simultaneamente como deveria. No processo de conectar administrações em toda a região, tive que realizar um trabalho de divulgação e educação e ajudar colegas nas administrações distrital e rural.A ligação total entre os sites no primeiro estágio foi de apenas alguns gigabits. Mas eu já aloquei um canal para o vSphere funcionar.A própria rede acabou sendo altamente distribuída geograficamente, incluindo um número bastante grande de nós remotos conectados via VPN L2 / L3.É claro que muito poderia ser resolvido com investimentos financeiros sérios, mas consegui com o que tenho. Muitas vezes, o equipamento disponível era usado de maneira ineficiente, então eu apenas encontrei lugares melhores para ele. Especialmente no primeiro ano de vida, todos estavam muito céticos sobre as perspectivas de implementação deste projeto.Porém, após o primeiro ano, quando, graças à nossa organização, foram mostradas economias diretas e indiretas no orçamento de dezenas de milhões de rublos, e a atitude mudou drasticamente. Um dos diagramas de rede. A maioria dos nós, por razões óbvias, está oculta.

, ajustando-o simultaneamente como deveria. No processo de conectar administrações em toda a região, tive que realizar um trabalho de divulgação e educação e ajudar colegas nas administrações distrital e rural.A ligação total entre os sites no primeiro estágio foi de apenas alguns gigabits. Mas eu já aloquei um canal para o vSphere funcionar.A própria rede acabou sendo altamente distribuída geograficamente, incluindo um número bastante grande de nós remotos conectados via VPN L2 / L3.É claro que muito poderia ser resolvido com investimentos financeiros sérios, mas consegui com o que tenho. Muitas vezes, o equipamento disponível era usado de maneira ineficiente, então eu apenas encontrei lugares melhores para ele. Especialmente no primeiro ano de vida, todos estavam muito céticos sobre as perspectivas de implementação deste projeto.Porém, após o primeiro ano, quando, graças à nossa organização, foram mostradas economias diretas e indiretas no orçamento de dezenas de milhões de rublos, e a atitude mudou drasticamente. Um dos diagramas de rede. A maioria dos nós, por razões óbvias, está oculta.

Segunda etapa

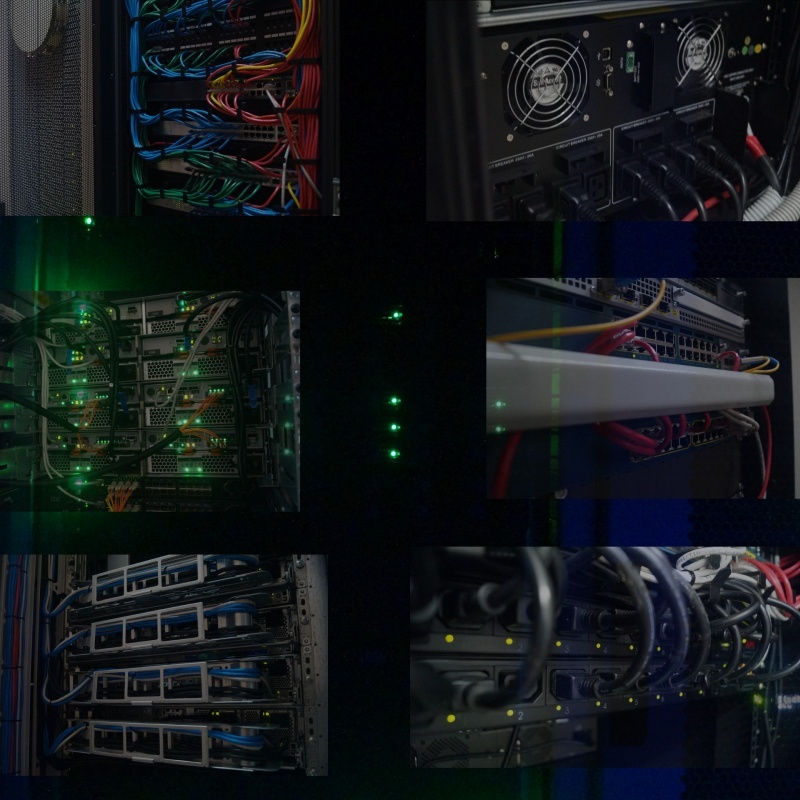

No segundo estágio, já tivemos que aumentar as capacidades de hardware do nosso data center. A expansão de capacidades exigiu uma mudança de chassi do modelo E para H, reinstalação de racks existentes. O espaço em disco foi aumentado aumentando o número de prateleiras do disco rígido. Prateleiras com discos rígidos IBM DS3512 e a prateleira DS3524 são visíveis na parte superior.

Vários outros servidores físicos foram transferidos para nós. O número de máquinas virtuais aumentou significativamente. Uma ferramenta de backup baseada na biblioteca de fitas IBM TS3200 foi adicionada. Em primeiro plano, está a biblioteca de fitas IBM TS3200.

Naturalmente, iniciei a instalação de novos equipamentos com planejamento preliminar. Aqui já teve que modelar prateleiras de ambos os lados. Planejando a expansão do data center.

A mudança foi concluída o mais rápido possível. Como naquela época a virtualização estava funcionando totalmente, o processo de movimentação era absolutamente imperceptível, porque antes de mover e desconectar o equipamento em um site, todos os servidores virtuais migravam para outro e, no final do trabalho, tudo voltava ao normal.Obviamente, além do site principal, também foi feita uma ordem no site de reserva. Ao mesmo tempo, graças a um sistema de backup em pleno funcionamento, finalmente foi possível restaurar a ordem no local. Tipo de racks após a expansão do recurso, 2014.

A mudança foi concluída o mais rápido possível. Como naquela época a virtualização estava funcionando totalmente, o processo de movimentação era absolutamente imperceptível, porque antes de mover e desconectar o equipamento em um site, todos os servidores virtuais migravam para outro e, no final do trabalho, tudo voltava ao normal.Obviamente, além do site principal, também foi feita uma ordem no site de reserva. Ao mesmo tempo, graças a um sistema de backup em pleno funcionamento, finalmente foi possível restaurar a ordem no local. Tipo de racks após a expansão do recurso, 2014. E desde então, nosso data center já havia se tornado exemplar, e decidi prestar atenção aos detalhes: as unidades gratuitas disponíveis estavam cobertas com molduras pretas e, onde era necessária ventilação, eram instalados painéis perfurados. Até os parafusos de fixação que prendem o equipamento no rack, removi e pintei de preto da lata de spray. Um pouco, mas legal. Tipo de racks no site de reserva durante a instalação (esquerda) e no final (direita).

Para livrar-se dos conversores de mídia espalhados por todo o lado, foi adquirido um par de chassis D-Link DMC-1000, incluindo fornecendo conversores de mídia de energia de backup devido ao par de fontes de alimentação.

E desde então, nosso data center já havia se tornado exemplar, e decidi prestar atenção aos detalhes: as unidades gratuitas disponíveis estavam cobertas com molduras pretas e, onde era necessária ventilação, eram instalados painéis perfurados. Até os parafusos de fixação que prendem o equipamento no rack, removi e pintei de preto da lata de spray. Um pouco, mas legal. Tipo de racks no site de reserva durante a instalação (esquerda) e no final (direita).

Para livrar-se dos conversores de mídia espalhados por todo o lado, foi adquirido um par de chassis D-Link DMC-1000, incluindo fornecendo conversores de mídia de energia de backup devido ao par de fontes de alimentação. Ao mesmo tempo, estavam em andamento trabalhos para modernizar a rede. Fechei o anel do núcleo da rede de transmissão de dados a uma velocidade de 20 Gbit / s entre sites. Ao otimizar o equipamento existente, a rede de serviço para a operação da infraestrutura virtual adquiriu um uplink de 10 Gb / s, o que possibilitou a migração de quase todos os blades ao mesmo tempo, com largura de banda suficiente.A compatibilidade do equipamento SNR com os equipamentos Cisco e Brocade existentes acabou sendo muito agradável. É claro que uma vez a presença de equipamentos Brocade no chassi foi uma surpresa desagradável para mim, porque eu não tinha que trabalhar com ele antes. Felizmente, porém, o conhecimento dos princípios da rede nos permitiu lidar rapidamente com ela.Uma parte importante do trabalho, considero a precisão da execução. Tudo não deve apenas funcionar bem, mas também ter uma boa aparência. Quanto mais ordem no trabalho, maior a confiabilidade. Foi uma sorte que nenhum de mim tivesse essa abordagem para trabalhar, portanto, junto com um de nossos colegas nas estantes, fui colocado em ordem, acho, uma ordem exemplar. Deve haver ordem em todos os lugares.

Ao mesmo tempo, estavam em andamento trabalhos para modernizar a rede. Fechei o anel do núcleo da rede de transmissão de dados a uma velocidade de 20 Gbit / s entre sites. Ao otimizar o equipamento existente, a rede de serviço para a operação da infraestrutura virtual adquiriu um uplink de 10 Gb / s, o que possibilitou a migração de quase todos os blades ao mesmo tempo, com largura de banda suficiente.A compatibilidade do equipamento SNR com os equipamentos Cisco e Brocade existentes acabou sendo muito agradável. É claro que uma vez a presença de equipamentos Brocade no chassi foi uma surpresa desagradável para mim, porque eu não tinha que trabalhar com ele antes. Felizmente, porém, o conhecimento dos princípios da rede nos permitiu lidar rapidamente com ela.Uma parte importante do trabalho, considero a precisão da execução. Tudo não deve apenas funcionar bem, mas também ter uma boa aparência. Quanto mais ordem no trabalho, maior a confiabilidade. Foi uma sorte que nenhum de mim tivesse essa abordagem para trabalhar, portanto, junto com um de nossos colegas nas estantes, fui colocado em ordem, acho, uma ordem exemplar. Deve haver ordem em todos os lugares.

Enquanto isso

Paralelamente à criação física do data center e da rede OGV , houve um desenvolvimento de software para o funcionamento do governo eletrônico, no qual também tive a oportunidade de participar. Tanto em termos de implementação e implantação, como em termos de suporte ideológico. Pelo apoio de uma verdadeira ideologia, muito obrigado à liderança da época.Eu regularmente tinha que auditar bancos de dados, levar os desenvolvedores a usar índices em bancos de dados, capturar consultas com muitos recursos e otimizar gargalos. Um dos sistemas, exceto chaves primárias, não tinha mais índices. O resultado - no início da operação intensiva, o desempenho do banco de dados começou a se deteriorar acentuadamente, precisando plantar índices por conta própria.Graças à intervenção oportuna no processo de desenvolvimento, todos os sistemas estatais desenvolvidos foram criados em várias plataformas. E onde não havia necessidade urgente de usar o Windows como base, tudo funcionava sob o controle da família de sistemas Linux. Como se viu, o principal obstáculo para a criação de aplicativos de plataforma cruzada foi o uso de notação não universal em caminhos de escrita. Muitas vezes, depois de substituir uma barra por outra, o sistema estatal tornou-se abruptamente multiplataforma.Como a rede criada cobria, de uma forma ou de outra, quase todo o OGV , eu estava pronto para começar a fornecer conectividade à Internet, filtrar tráfego, proteção antivírus e impedir ataques externos e internos ao OGV. Em particular, isso deveria fornecer economias orçamentárias significativas devido ao uso mais eficiente da largura de banda do canal.Tendo criado um serviço de suporte técnico unificado para a OGV , planejei criar empregos de alta tecnologia, para concentrar em nossa organização as principais forças para suporte qualificado, deixando técnicos em campo, melhorando simultaneamente o nível de especialistas em campo, organizando conferências e seminários on-line, retiros ...O terceiro estágio da modernização do data center foi o mais interessante para mim. No final do segundo estágio, foi estabelecido um diálogo com a Elbrus, desenvolvedora de processadores domésticos, o acesso à bancada de testes e ficou claro que pelo menos um terço da funcionalidade dos sistemas operacionais pode ser transferido para a plataforma de hardware doméstica! No próximo ano de 2015, seria lançada uma nova versão de hardware do processador doméstico ... O orçamento para o próximo ano incluía a soma da compra de servidores ...

Resumir

Mas meus sonhos de transferir serviços públicos para uma plataforma doméstica de hardware não estavam destinados a se tornar realidade (como outros planos), porque fui forçado a mudar meu trabalho para não menos interessante, mas mais bem pago. É uma pena, é claro, eu acho que poderia dar um bom impulso para a implementação da plataforma de hardware doméstica. Além disso, isso foi antes da onda de substituição de importações.No final de minha carreira nesta organização, com base em nosso data center, eu consegui planejar, criar, implantar ou participar da criação de:No total, mais de 120 servidores virtuais estavam trabalhando em nossos 7 pares de servidores físicos, usando cerca de 30 a 40% dos recursos de CPU e RAM, cerca de 50% do sistema de armazenamento. No total, naquela época, nossa equipe contava com 30 a 35 pessoas, incluindo toda a equipe administrativa e gerencial, serviço de processamento de chamadas.Eficiência de uso, tenho certeza, no rosto.Na verdade, você ainda pode contar muito em detalhes sobre a formação de quase cada um dos serviços, para obter um volume bastante pesado de memórias.Agradecimentos

- Em primeiro lugar, a você, caro leitor, por ler neste lugar.

- Minha esposa por ajuda e apoio.

- À gerência da Instituição Pública Estadual SK "Centro Regional de Tecnologias da Informação" pela confiança depositada.

- Gestão do Ministério da Indústria, Energia e Comunicações do Território de Stavropol para apoio administrativo.

- Todos os colegas que tiveram a sorte de trabalhar na época.

Source: https://habr.com/ru/post/pt395197/

All Articles