AI gera sons realistas nas filmagens

Funcionários do Instituto de Ciência da Computação e Inteligência Artificial do Massachusetts (CSAIL) e do Google Research projetaram uma rede neural que aprendeu a tocar seqüências de vídeo arbitrárias , gerando sons realistas e prevendo as propriedades dos objetos. O programa analisa o vídeo, reconhece objetos, seus movimentos e tipo de contato - choque, deslizamento, atrito e assim por diante. Com base nessas informações, gera um som que uma pessoa em 40% dos casos considera mais realista do que o real.Os cientistas sugerem que esse desenvolvimento será amplamente utilizado no cinema e na televisão para gerar efeitos sonoros a partir de uma sequência de vídeo sem som. Além disso, pode ser útil para treinar robôs para entender melhor as propriedades do mundo.Os sons ambientais dizem muito sobre as propriedades dos objetos circundantes; portanto, no processo de auto-aprendizado, os futuros robôs podem agir como crianças - tocar objetos, experimentá-los por toque, enfiar um pedaço de pau neles, tentar se mover, levantar. Nesse caso, o robô recebe feedback, reconhecendo as propriedades do objeto - seu peso, elasticidade e assim por diante.O som emitido por um objeto em contato também carrega informações importantes sobre as propriedades do objeto. “Quando você desliza o dedo sobre um copo de vinho, o som emitido corresponde à quantidade de líquido derramado no copo”, explica o estudante graduado Andrew Owens , principal autor de um artigo científico publicado, que ainda não está pronto para uma revista científica, mas apenas publicadopublicamente disponível em arXiv.org. A apresentação do trabalho científico ocorrerá na conferência anual sobre visão de máquina e reconhecimento de padrões (CVPR) em Las Vegas neste mês.Os cientistas selecionaram 977 vídeos nos quais as pessoas realizam ações com objetos ao redor, consistindo de vários materiais: arranhe, bata-os com um pau, etc. No total, os vídeos continham 46.577 ações. Os alunos do CSAIL marcaram manualmente todas as ações, indicando o tipo de material, o local de contato, o tipo de ação (choque / arranhão / outro) e o tipo de reação do material ou objeto (deformação, forma estática, movimento rígido, etc.). Vídeos com som foram usados para treinar a rede neural e tags colocadas manualmente foram usadas apenas para analisar o resultado do treinamento da rede neural, mas não para treiná-la..

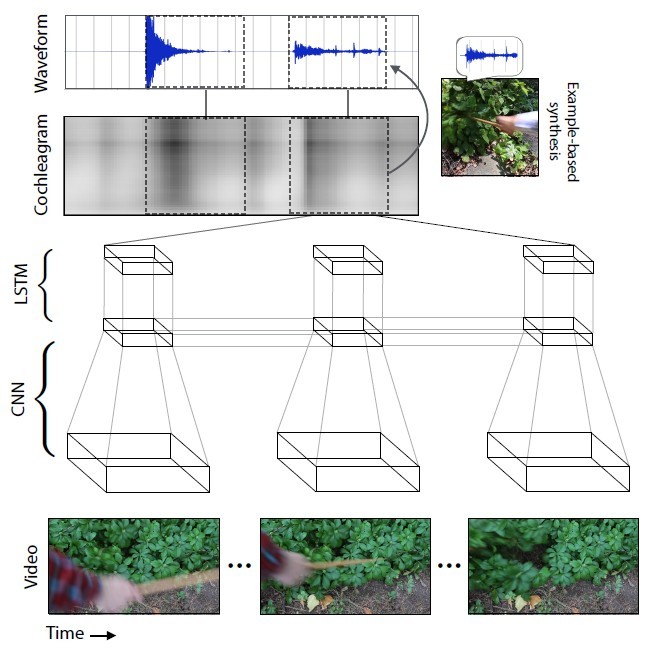

Funcionários do Instituto de Ciência da Computação e Inteligência Artificial do Massachusetts (CSAIL) e do Google Research projetaram uma rede neural que aprendeu a tocar seqüências de vídeo arbitrárias , gerando sons realistas e prevendo as propriedades dos objetos. O programa analisa o vídeo, reconhece objetos, seus movimentos e tipo de contato - choque, deslizamento, atrito e assim por diante. Com base nessas informações, gera um som que uma pessoa em 40% dos casos considera mais realista do que o real.Os cientistas sugerem que esse desenvolvimento será amplamente utilizado no cinema e na televisão para gerar efeitos sonoros a partir de uma sequência de vídeo sem som. Além disso, pode ser útil para treinar robôs para entender melhor as propriedades do mundo.Os sons ambientais dizem muito sobre as propriedades dos objetos circundantes; portanto, no processo de auto-aprendizado, os futuros robôs podem agir como crianças - tocar objetos, experimentá-los por toque, enfiar um pedaço de pau neles, tentar se mover, levantar. Nesse caso, o robô recebe feedback, reconhecendo as propriedades do objeto - seu peso, elasticidade e assim por diante.O som emitido por um objeto em contato também carrega informações importantes sobre as propriedades do objeto. “Quando você desliza o dedo sobre um copo de vinho, o som emitido corresponde à quantidade de líquido derramado no copo”, explica o estudante graduado Andrew Owens , principal autor de um artigo científico publicado, que ainda não está pronto para uma revista científica, mas apenas publicadopublicamente disponível em arXiv.org. A apresentação do trabalho científico ocorrerá na conferência anual sobre visão de máquina e reconhecimento de padrões (CVPR) em Las Vegas neste mês.Os cientistas selecionaram 977 vídeos nos quais as pessoas realizam ações com objetos ao redor, consistindo de vários materiais: arranhe, bata-os com um pau, etc. No total, os vídeos continham 46.577 ações. Os alunos do CSAIL marcaram manualmente todas as ações, indicando o tipo de material, o local de contato, o tipo de ação (choque / arranhão / outro) e o tipo de reação do material ou objeto (deformação, forma estática, movimento rígido, etc.). Vídeos com som foram usados para treinar a rede neural e tags colocadas manualmente foram usadas apenas para analisar o resultado do treinamento da rede neural, mas não para treiná-la.. A rede neural analisou as características do som que correspondem a cada tipo de interação com os objetos - volume, tom e outras características. Durante o treinamento, o sistema estudou o vídeo quadro a quadro, analisou o som nesse quadro e encontrou uma correspondência com o som mais semelhante no banco de dados já acumulado. O mais importante era ensinar a rede neural a esticar o som em quadros.

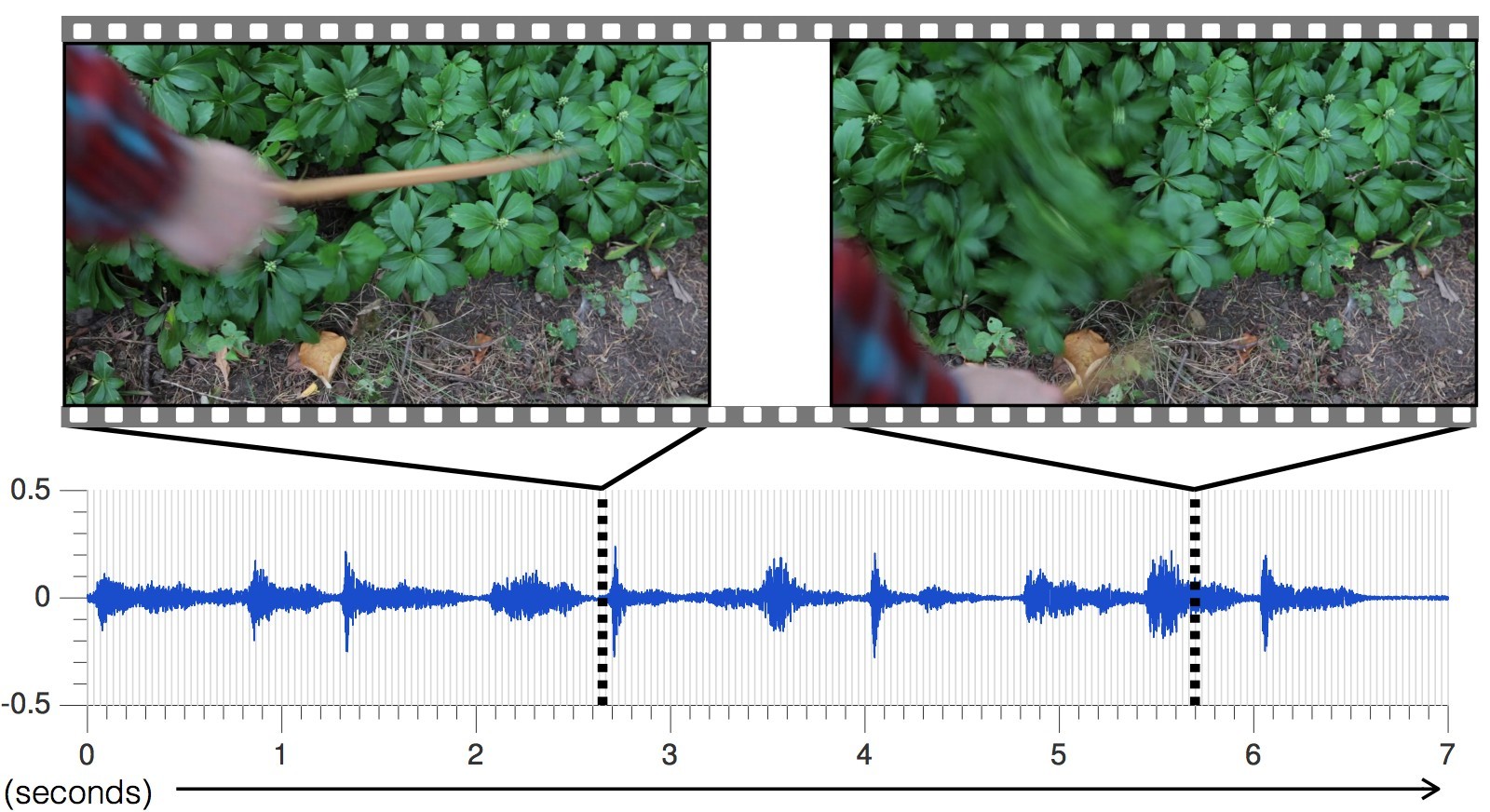

A rede neural analisou as características do som que correspondem a cada tipo de interação com os objetos - volume, tom e outras características. Durante o treinamento, o sistema estudou o vídeo quadro a quadro, analisou o som nesse quadro e encontrou uma correspondência com o som mais semelhante no banco de dados já acumulado. O mais importante era ensinar a rede neural a esticar o som em quadros. A cada novo vídeo, a precisão da previsão de sons aumentava.O som gerado pela rede neural para diferentes cenas, em comparação com o real

A cada novo vídeo, a precisão da previsão de sons aumentava.O som gerado pela rede neural para diferentes cenas, em comparação com o real , resultando em uma rede neural aprendida a prever com precisão os sons mais diversos com todas as nuances: de bater pedras a farfalhar hera."As abordagens atuais dos pesquisadores no campo da inteligência artificial concentram-se em apenas um dos cinco sentidos: especialistas em visão de máquina estudam imagens visuais, especialistas em reconhecimento de fala estudam som e assim por diante", diz Abhinav Gupta, professor assistente de robótica na Universidade Carnegie - Mellon. "Este estudo é um passo na direção certa que imita o processo de aprendizado da mesma maneira que as pessoas, integrando som e visão".Para testar a eficácia da IA, os cientistas realizaram um estudo on-line no Amazon Mechanical Turk, cujos participantes foram convidados a comparar duas opções para o som de um vídeo em particular e determinar qual som é real e o que não é.Como resultado do experimento, a IA conseguiu enganar as pessoas em 40% dos casos . No entanto, de acordo com alguns comentaristas dos fóruns , não é tão difícil enganar uma pessoa, porque uma parte significativa do conhecimento sobre a imagem sonora do mundo é obtida pelas pessoas modernas em filmes e jogos de computador. A gama de sons para filmes e jogos é composta por especialistas, usando coleções de amostras padrão. Ou seja, ouvimos constantemente sobre a mesma coisa.Em um experimento online, em dois de cinco casos, as pessoas pensaram que o som gerado pelo programa era mais realista do que o som real do vídeo. Este é um resultado melhor do que outros métodos para sintetizar sons realistas.

, resultando em uma rede neural aprendida a prever com precisão os sons mais diversos com todas as nuances: de bater pedras a farfalhar hera."As abordagens atuais dos pesquisadores no campo da inteligência artificial concentram-se em apenas um dos cinco sentidos: especialistas em visão de máquina estudam imagens visuais, especialistas em reconhecimento de fala estudam som e assim por diante", diz Abhinav Gupta, professor assistente de robótica na Universidade Carnegie - Mellon. "Este estudo é um passo na direção certa que imita o processo de aprendizado da mesma maneira que as pessoas, integrando som e visão".Para testar a eficácia da IA, os cientistas realizaram um estudo on-line no Amazon Mechanical Turk, cujos participantes foram convidados a comparar duas opções para o som de um vídeo em particular e determinar qual som é real e o que não é.Como resultado do experimento, a IA conseguiu enganar as pessoas em 40% dos casos . No entanto, de acordo com alguns comentaristas dos fóruns , não é tão difícil enganar uma pessoa, porque uma parte significativa do conhecimento sobre a imagem sonora do mundo é obtida pelas pessoas modernas em filmes e jogos de computador. A gama de sons para filmes e jogos é composta por especialistas, usando coleções de amostras padrão. Ou seja, ouvimos constantemente sobre a mesma coisa.Em um experimento online, em dois de cinco casos, as pessoas pensaram que o som gerado pelo programa era mais realista do que o som real do vídeo. Este é um resultado melhor do que outros métodos para sintetizar sons realistas. Na maioria das vezes, a IA enganou os participantes do experimento com sons de materiais como folhas e sujeira, porque esses sons são mais complexos e não tão "limpos" quanto os feitos, por exemplo, por madeira ou metal.Voltando ao treinamento da rede neural, como subproduto do estudo, verificou-se que o algoritmo pode distinguir entre materiais macios e duros com uma precisão de 67%, simplesmente prevendo o som deles. Em outras palavras, o robô pode olhar para o caminho do asfalto e a grama à sua frente - e concluir que o asfalto é duro e a grama é macia. O robô saberá disso pelo som previsto, sem pisar no asfalto e na grama. Depois, ele pode ir onde quiser - e testar seus sentimentos, verificando com o banco de dados e, se necessário, fazendo correções na biblioteca de amostras de som. Dessa forma, no futuro, os robôs estudarão e dominarão o mundo ao seu redor.No entanto, os pesquisadores ainda têm muito trabalho a fazer para melhorar a tecnologia. A rede neural agora é frequentemente confundida com o movimento rápido de objetos, sem cair no momento exato do contato. Além disso, a IA só pode gerar som com base no contato direto gravado em vídeo, e há tantos sons ao nosso redor que não se baseiam no contato visual: o barulho das árvores, o zumbido de um ventilador no computador. "O que seria realmente legal é simular um som que não está tão intimamente relacionado às imagens", diz Andrew Owens.

Na maioria das vezes, a IA enganou os participantes do experimento com sons de materiais como folhas e sujeira, porque esses sons são mais complexos e não tão "limpos" quanto os feitos, por exemplo, por madeira ou metal.Voltando ao treinamento da rede neural, como subproduto do estudo, verificou-se que o algoritmo pode distinguir entre materiais macios e duros com uma precisão de 67%, simplesmente prevendo o som deles. Em outras palavras, o robô pode olhar para o caminho do asfalto e a grama à sua frente - e concluir que o asfalto é duro e a grama é macia. O robô saberá disso pelo som previsto, sem pisar no asfalto e na grama. Depois, ele pode ir onde quiser - e testar seus sentimentos, verificando com o banco de dados e, se necessário, fazendo correções na biblioteca de amostras de som. Dessa forma, no futuro, os robôs estudarão e dominarão o mundo ao seu redor.No entanto, os pesquisadores ainda têm muito trabalho a fazer para melhorar a tecnologia. A rede neural agora é frequentemente confundida com o movimento rápido de objetos, sem cair no momento exato do contato. Além disso, a IA só pode gerar som com base no contato direto gravado em vídeo, e há tantos sons ao nosso redor que não se baseiam no contato visual: o barulho das árvores, o zumbido de um ventilador no computador. "O que seria realmente legal é simular um som que não está tão intimamente relacionado às imagens", diz Andrew Owens.Source: https://habr.com/ru/post/pt395243/

All Articles