A NVIDIA está procurando maneiras de otimizar imagens BP

A empresa planeja aumentar o conforto da BP e reduzir a carga no poder da computação, simulando a visão periférica

O olho humano é complexo. Nós, como onívoros, temos um ângulo de visão bastante amplo, mas ainda vemos claramente apenas em que nossos olhos estão focados. O resto da área nos permite distinguir entre objetos, mas os vemos embaçados, embaçados. Isso é o que chamamos de visão periférica.Inicialmente, os fabricantes de capacetes de realidade virtual perseguiam a clareza da imagem nas telas, a taxa de atualização do quadro e a qualidade geral da imagem. Agora que os produtos HTC, Oculus e Sony estão entrando em um amplo mercado, é hora de pensar em otimização, porque nem todos podem comprar um PC de mesa de US $ 1.500 a US $ 2.500 para experimentar um novo produto. E isso sem o custo do próprio fone de ouvido.O principal ônus financeiro é formado por placas de vídeo que renderizam imagens em dois fluxos nas telas dos capacetes VR. E a NVidia, como principal participante do mercado e do fornecedor, pensou em otimizar e melhorar o conforto do processo de imersão no mundo da RV.Agora, toda a imagem dos fones de ouvido VR é desenhada com o mesmo grau de qualidade. Olhando para qualquer parte da tela, o usuário verá a mesma imagem de qualidade. Mas, na realidade, o olho humano vê claramente apenas em uma área estreita de foco, e tudo o resto recai sobre a visão periférica, a imagem da qual nosso cérebro processa e amolece.A NVidia concluiu que simular o comportamento do olho real ao renderizar imagens nas telas dos fones de ouvido da BP seria uma boa solução, porque, em primeiro lugar, reduzirá a carga na capacidade computacional do PC ao qual o capacete está conectado e, em segundo lugar, aumentará o realismo comportamento da imagem e, consequentemente, aumentar o conforto da jogabilidade.Mas, como nossos olhos são móveis, é impossível fazer um nítido "desfoque" de foco no meio da tela. Para simular o comportamento da visão real, os engenheiros da NVIDIA recorreram a um sistema de rastreamento ocular para determinar claramente para onde o usuário está olhando. Como resultado, eles conseguiram desenvolver um sistema que simula o comportamento da visão humana de maneira bastante realista e, ao mesmo tempo, economiza os recursos de computação do sistema: Imagem

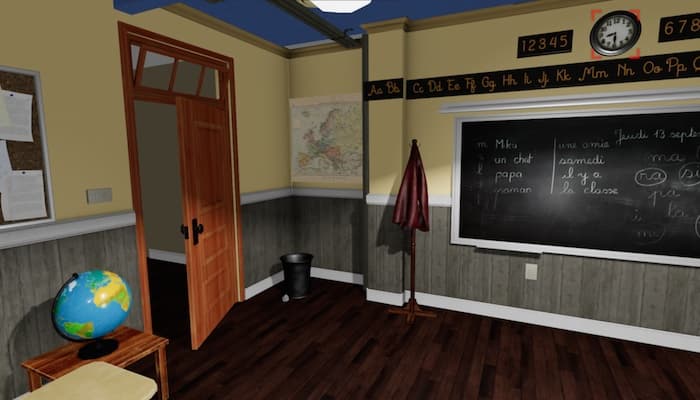

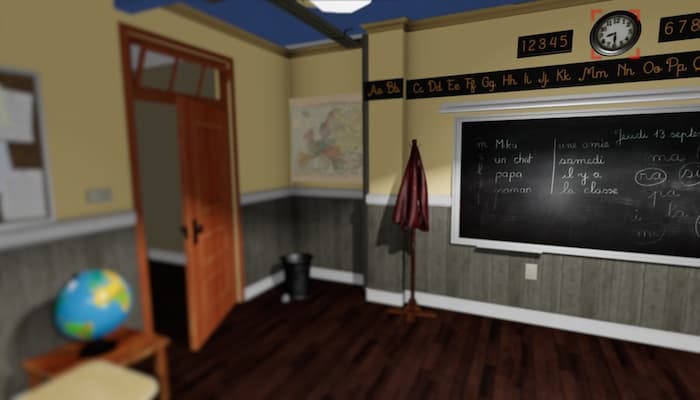

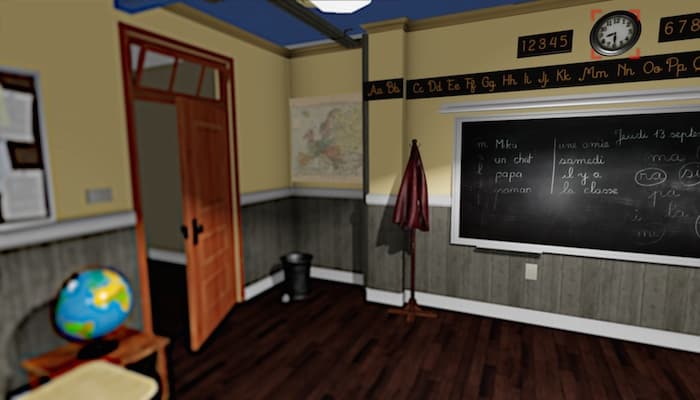

O olho humano é complexo. Nós, como onívoros, temos um ângulo de visão bastante amplo, mas ainda vemos claramente apenas em que nossos olhos estão focados. O resto da área nos permite distinguir entre objetos, mas os vemos embaçados, embaçados. Isso é o que chamamos de visão periférica.Inicialmente, os fabricantes de capacetes de realidade virtual perseguiam a clareza da imagem nas telas, a taxa de atualização do quadro e a qualidade geral da imagem. Agora que os produtos HTC, Oculus e Sony estão entrando em um amplo mercado, é hora de pensar em otimização, porque nem todos podem comprar um PC de mesa de US $ 1.500 a US $ 2.500 para experimentar um novo produto. E isso sem o custo do próprio fone de ouvido.O principal ônus financeiro é formado por placas de vídeo que renderizam imagens em dois fluxos nas telas dos capacetes VR. E a NVidia, como principal participante do mercado e do fornecedor, pensou em otimizar e melhorar o conforto do processo de imersão no mundo da RV.Agora, toda a imagem dos fones de ouvido VR é desenhada com o mesmo grau de qualidade. Olhando para qualquer parte da tela, o usuário verá a mesma imagem de qualidade. Mas, na realidade, o olho humano vê claramente apenas em uma área estreita de foco, e tudo o resto recai sobre a visão periférica, a imagem da qual nosso cérebro processa e amolece.A NVidia concluiu que simular o comportamento do olho real ao renderizar imagens nas telas dos fones de ouvido da BP seria uma boa solução, porque, em primeiro lugar, reduzirá a carga na capacidade computacional do PC ao qual o capacete está conectado e, em segundo lugar, aumentará o realismo comportamento da imagem e, consequentemente, aumentar o conforto da jogabilidade.Mas, como nossos olhos são móveis, é impossível fazer um nítido "desfoque" de foco no meio da tela. Para simular o comportamento da visão real, os engenheiros da NVIDIA recorreram a um sistema de rastreamento ocular para determinar claramente para onde o usuário está olhando. Como resultado, eles conseguiram desenvolver um sistema que simula o comportamento da visão humana de maneira bastante realista e, ao mesmo tempo, economiza os recursos de computação do sistema: Imagem totalmente renderizada para a BP, foco no relógio

totalmente renderizada para a BP, foco no relógio Apenas a periferia "desfocada" da imagem para a BP, foco no relógio

Apenas a periferia "desfocada" da imagem para a BP, foco no relógio "A periferia desfocada" da imagem para BP com manutenção do nível necessário de contraste, imitação da visão real, foco no relógioMesmo agora, apenas olhando a imagem, você pode reconhecer que os engenheiros da NVIDIA estão no caminho certo. Focando o relógio mesmo na tela do monitor, a diferença entre a primeira e a terceira imagem, à primeira vista, está praticamente ausente. O desenvolvimento é baseado na tecnologia SMI existente (SensoMotoric Instruments), que foi introduzida para o Oculus Rift DK2 em novembro de 2014.Se você acha que os engenheiros da NVIDIA apenas “ensaboam” tudo o que está fora de foco, você está enganado. No decorrer do trabalho, verificou-se que, durante a renderização tradicional da imagem no campo da visão periférica, são formados mergulhos e tremulações, causando uma sensação de desconforto. Apenas o "desfoque" da imagem reduz o contraste, o que causa uma sensação de "tunelamento" da visão.É por isso que os engenheiros criaram um algoritmo inteiro que avalia a forma, cor e contraste, bem como o movimento do objeto. Graças a isso, o "azul" para o usuário passa de maneira confortável e quase imperceptível, sem efeitos colaterais.Demonstração em vídeo dos estágios das imagens "desfocadas" para a BP da NVIDIA

"A periferia desfocada" da imagem para BP com manutenção do nível necessário de contraste, imitação da visão real, foco no relógioMesmo agora, apenas olhando a imagem, você pode reconhecer que os engenheiros da NVIDIA estão no caminho certo. Focando o relógio mesmo na tela do monitor, a diferença entre a primeira e a terceira imagem, à primeira vista, está praticamente ausente. O desenvolvimento é baseado na tecnologia SMI existente (SensoMotoric Instruments), que foi introduzida para o Oculus Rift DK2 em novembro de 2014.Se você acha que os engenheiros da NVIDIA apenas “ensaboam” tudo o que está fora de foco, você está enganado. No decorrer do trabalho, verificou-se que, durante a renderização tradicional da imagem no campo da visão periférica, são formados mergulhos e tremulações, causando uma sensação de desconforto. Apenas o "desfoque" da imagem reduz o contraste, o que causa uma sensação de "tunelamento" da visão.É por isso que os engenheiros criaram um algoritmo inteiro que avalia a forma, cor e contraste, bem como o movimento do objeto. Graças a isso, o "azul" para o usuário passa de maneira confortável e quase imperceptível, sem efeitos colaterais.Demonstração em vídeo dos estágios das imagens "desfocadas" para a BP da NVIDIASource: https://habr.com/ru/post/pt396385/

All Articles