Especialistas da China e dos EUA aprenderam a manipular o piloto automático da Tesla

A operação do piloto automático e dos sensores pode ser intencionalmente interrompida com a ajuda de equipamentos especiais

Nos Estados Unidos, o acidente fatal do Tesla Model S ainda está sendo investigado em maio deste ano. Então o carro elétrico acelerando colidiu com um caminhão. Nem o motorista nem o piloto automático viram um obstáculo contra um céu claro. Os especialistas em segurança da informação têm uma pergunta - e se tentarmos reproduzir artificialmente condições semelhantes? Será possível enganar os sensores da máquina e o próprio sistema de computador?A equipe combinada de pesquisadores da Universidade da Carolina do Sul (EUA), da Universidade de Zhejiang (China) e da empresa chinesa Qihoo 360, trabalhando na área de segurança de computadores, foi capaz de aprender a manipular o piloto automático Tesla Model S. Para isso, os pesquisadores trabalharam com equipamentos de vários tipos: emitindo ondas de rádio, sinais sonoros e a luz Em alguns casos, o piloto automático da Tesla começou a "acreditar" que não havia obstáculos à frente, embora existissem e vice-versa, que havia um objeto à frente que poderia ser encontrado, embora não houvesse nada na frente do carro.Como se viu, para enganar o sistema de controle de computador Tesla Model S, você precisa fazer esforços significativos. O objetivo da equipe de cientistas era provar que as condições que levaram ao acidente em maio podem ser reproduzidas intencionalmente. “O pior cenário para um carro dirigindo um piloto automático é um radar que não funciona. Nesse caso, a máquina não poderá determinar a presença de obstáculos à frente ”, diz um dos representantes da equipe de cientistas que conduziu a pesquisa.O piloto automático, alimentado por veículos elétricos Tesla, detecta obstáculos usando três métodos principais: radar, sensores ultrassônicos e câmeras. Os pesquisadores atacaram os três tipos de sistemas. Como resultado, foi possível determinar o que exatamente o radar é mais adequado para "enganar". Para distorcer seu testemunho, os pesquisadores usaram dois sistemas. O primeiro é um gerador de sinal de US $ 90.000 da Keysight Technologies e o segundo é um multiplicador de frequência VDI, cujo preço é ainda mais alto. Ambos os sistemas foram utilizados para bloquear o sinal emitido pelo sistema de radar do veículo elétrico. Quando os especialistas bloquearam o sinal, o carro na frente do Tesla Model S desapareceu para o piloto automático e não foi mais exibido.Assim que o "anti-radar" ligou, o obstáculo dianteiro desapareceu. Segundo os autores deste trabalho, esse método pode ser usado na estrada por intrusos que, por um motivo ou outro, podem querer causar um acidente envolvendo um carro elétrico Tesla. Os cientistas dizem que, para um ataque bem-sucedido ao sistema de radar Tesla, é necessário instalar corretamente um silenciador, o que não é tão fácil de fazer na estrada.Um ataque mais simples e mais barato é o sistema de ultrassom, com a ajuda dos quais os especialistas decidiram atuar nos sensores ultrassônicos da máquina. Eles geralmente são usados para estacionamento automático e "ligar" para o motorista. Nesse modo, ela pode sair do estacionamento de forma independente e se aproximar do proprietário. Para enganar os sensores ultrassônicos, os pesquisadores usaram um transdutor ultrassônico e um gerador de sinais baseados em Arduino para criar sinais elétricos com características específicas. Esse sistema custa significativamente menos - apenas US $ 40. Nesse caso, era possível enganar o sistema de estacionamento automático, e o carro não queria estacionar, considerando que havia um obstáculo na frente. Utilizando o mesmo sistema, foi possível “convencer” o sistema de estacionamento de que não havia obstáculos na frente, embora existisse.

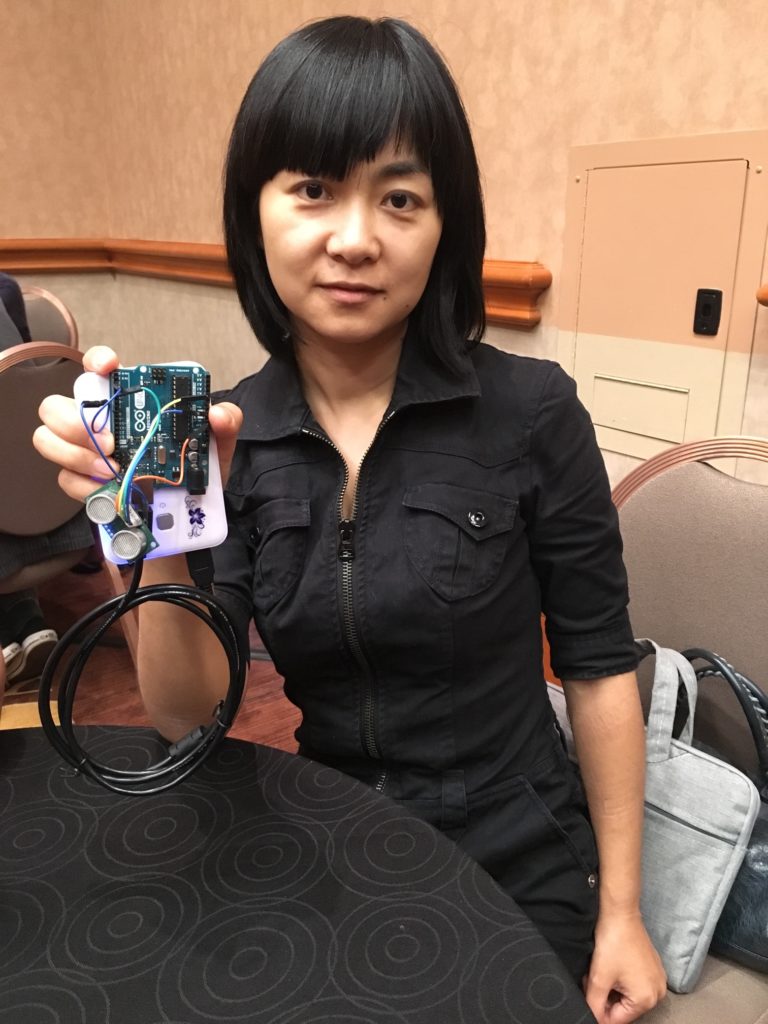

Nos Estados Unidos, o acidente fatal do Tesla Model S ainda está sendo investigado em maio deste ano. Então o carro elétrico acelerando colidiu com um caminhão. Nem o motorista nem o piloto automático viram um obstáculo contra um céu claro. Os especialistas em segurança da informação têm uma pergunta - e se tentarmos reproduzir artificialmente condições semelhantes? Será possível enganar os sensores da máquina e o próprio sistema de computador?A equipe combinada de pesquisadores da Universidade da Carolina do Sul (EUA), da Universidade de Zhejiang (China) e da empresa chinesa Qihoo 360, trabalhando na área de segurança de computadores, foi capaz de aprender a manipular o piloto automático Tesla Model S. Para isso, os pesquisadores trabalharam com equipamentos de vários tipos: emitindo ondas de rádio, sinais sonoros e a luz Em alguns casos, o piloto automático da Tesla começou a "acreditar" que não havia obstáculos à frente, embora existissem e vice-versa, que havia um objeto à frente que poderia ser encontrado, embora não houvesse nada na frente do carro.Como se viu, para enganar o sistema de controle de computador Tesla Model S, você precisa fazer esforços significativos. O objetivo da equipe de cientistas era provar que as condições que levaram ao acidente em maio podem ser reproduzidas intencionalmente. “O pior cenário para um carro dirigindo um piloto automático é um radar que não funciona. Nesse caso, a máquina não poderá determinar a presença de obstáculos à frente ”, diz um dos representantes da equipe de cientistas que conduziu a pesquisa.O piloto automático, alimentado por veículos elétricos Tesla, detecta obstáculos usando três métodos principais: radar, sensores ultrassônicos e câmeras. Os pesquisadores atacaram os três tipos de sistemas. Como resultado, foi possível determinar o que exatamente o radar é mais adequado para "enganar". Para distorcer seu testemunho, os pesquisadores usaram dois sistemas. O primeiro é um gerador de sinal de US $ 90.000 da Keysight Technologies e o segundo é um multiplicador de frequência VDI, cujo preço é ainda mais alto. Ambos os sistemas foram utilizados para bloquear o sinal emitido pelo sistema de radar do veículo elétrico. Quando os especialistas bloquearam o sinal, o carro na frente do Tesla Model S desapareceu para o piloto automático e não foi mais exibido.Assim que o "anti-radar" ligou, o obstáculo dianteiro desapareceu. Segundo os autores deste trabalho, esse método pode ser usado na estrada por intrusos que, por um motivo ou outro, podem querer causar um acidente envolvendo um carro elétrico Tesla. Os cientistas dizem que, para um ataque bem-sucedido ao sistema de radar Tesla, é necessário instalar corretamente um silenciador, o que não é tão fácil de fazer na estrada.Um ataque mais simples e mais barato é o sistema de ultrassom, com a ajuda dos quais os especialistas decidiram atuar nos sensores ultrassônicos da máquina. Eles geralmente são usados para estacionamento automático e "ligar" para o motorista. Nesse modo, ela pode sair do estacionamento de forma independente e se aproximar do proprietário. Para enganar os sensores ultrassônicos, os pesquisadores usaram um transdutor ultrassônico e um gerador de sinais baseados em Arduino para criar sinais elétricos com características específicas. Esse sistema custa significativamente menos - apenas US $ 40. Nesse caso, era possível enganar o sistema de estacionamento automático, e o carro não queria estacionar, considerando que havia um obstáculo na frente. Utilizando o mesmo sistema, foi possível “convencer” o sistema de estacionamento de que não havia obstáculos na frente, embora existisse. O professor de ciência da computação Wenyuan Xu demonstra um dispositivo ultrassônico baseado no Arduino Uno (Fonte: Andy Greenberg)A maneira mais fácil de influenciar o sistema de controle de computador da Tesla é aplicar uma espuma especial de absorção de som nos sensores.Os cientistas também tentaram influenciar as câmeras, mas esse sistema acabou sendo o mais confiável. A única coisa que foi possível fazer foi cegar o sistema com um feixe de LED direcionado ou laser. Mas os desenvolvedores da Tesla forneceram essa opção e o piloto automático simplesmente desligou, passando o controle para o motorista. Como os especialistas descobriram, um piloto automático pode ser cegado pela luz do sol sob certas circunstâncias. Talvez seja exatamente essa a situação que surgiu em maio.O manual do carro elétrico diz que o piloto automático pode não detectar certos objetos. Dizem também que a tecnologia "foi criada por conveniência durante a condução, mas não é um sistema para evitar obstáculos ou evitar colisões".Segundo alguns especialistas terceirizados que estudaram os resultados do trabalho descrito acima, a próxima etapa do estudo deve ser a situação na estrada e não em condições estacionárias. Para confirmar a eficácia dos métodos de influenciar o piloto automático e os sensores de um veículo elétrico, é necessário tentar fazer o mesmo em campo. “Eles precisam fazer um pouco mais para descobrir se o piloto automático realmente permite que o carro colidir com um obstáculo. Você pode me dizer até agora se o piloto automático está funcionando ou não ”, diz Jonathan Petit, porta-voz da Universidade Jonathan Petit.Os autores do estudo acreditam que o piloto automático e os sensores são suscetíveis a influências externas e são vulneráveis, embora o uso dessa vulnerabilidade não seja tão simples. Segundo os cientistas, a Tesla deve proteger seus veículos elétricos contra intrusos que possam tentar interferir no funcionamento normal do sistema de computadores da máquina. "Se o nível de ruído for muito alto ou se forem detectados alguns desvios, o radar deve notificar o sistema de controle sobre uma possível falha", diz um dos pesquisadores.Até agora, os cientistas reconhecem, os métodos usados por eles não são muito práticos - são difíceis e caros de usar. Porém, com o tempo, o equipamento se torna mais barato e os métodos de trabalho dos invasores são complicados e aprimorados. E depois de algum tempo, pode ser que alguém tenha aprendido a enganar um sistema de computador Tesla sem usar sistemas que custam US $ 100.000.

O professor de ciência da computação Wenyuan Xu demonstra um dispositivo ultrassônico baseado no Arduino Uno (Fonte: Andy Greenberg)A maneira mais fácil de influenciar o sistema de controle de computador da Tesla é aplicar uma espuma especial de absorção de som nos sensores.Os cientistas também tentaram influenciar as câmeras, mas esse sistema acabou sendo o mais confiável. A única coisa que foi possível fazer foi cegar o sistema com um feixe de LED direcionado ou laser. Mas os desenvolvedores da Tesla forneceram essa opção e o piloto automático simplesmente desligou, passando o controle para o motorista. Como os especialistas descobriram, um piloto automático pode ser cegado pela luz do sol sob certas circunstâncias. Talvez seja exatamente essa a situação que surgiu em maio.O manual do carro elétrico diz que o piloto automático pode não detectar certos objetos. Dizem também que a tecnologia "foi criada por conveniência durante a condução, mas não é um sistema para evitar obstáculos ou evitar colisões".Segundo alguns especialistas terceirizados que estudaram os resultados do trabalho descrito acima, a próxima etapa do estudo deve ser a situação na estrada e não em condições estacionárias. Para confirmar a eficácia dos métodos de influenciar o piloto automático e os sensores de um veículo elétrico, é necessário tentar fazer o mesmo em campo. “Eles precisam fazer um pouco mais para descobrir se o piloto automático realmente permite que o carro colidir com um obstáculo. Você pode me dizer até agora se o piloto automático está funcionando ou não ”, diz Jonathan Petit, porta-voz da Universidade Jonathan Petit.Os autores do estudo acreditam que o piloto automático e os sensores são suscetíveis a influências externas e são vulneráveis, embora o uso dessa vulnerabilidade não seja tão simples. Segundo os cientistas, a Tesla deve proteger seus veículos elétricos contra intrusos que possam tentar interferir no funcionamento normal do sistema de computadores da máquina. "Se o nível de ruído for muito alto ou se forem detectados alguns desvios, o radar deve notificar o sistema de controle sobre uma possível falha", diz um dos pesquisadores.Até agora, os cientistas reconhecem, os métodos usados por eles não são muito práticos - são difíceis e caros de usar. Porém, com o tempo, o equipamento se torna mais barato e os métodos de trabalho dos invasores são complicados e aprimorados. E depois de algum tempo, pode ser que alguém tenha aprendido a enganar um sistema de computador Tesla sem usar sistemas que custam US $ 100.000.Source: https://habr.com/ru/post/pt396721/

All Articles