Inteligência artificial tem problemas de linguagem

Máquinas com reconhecimento de idioma seriam muito úteis. Mas não sabemos como construí-los.

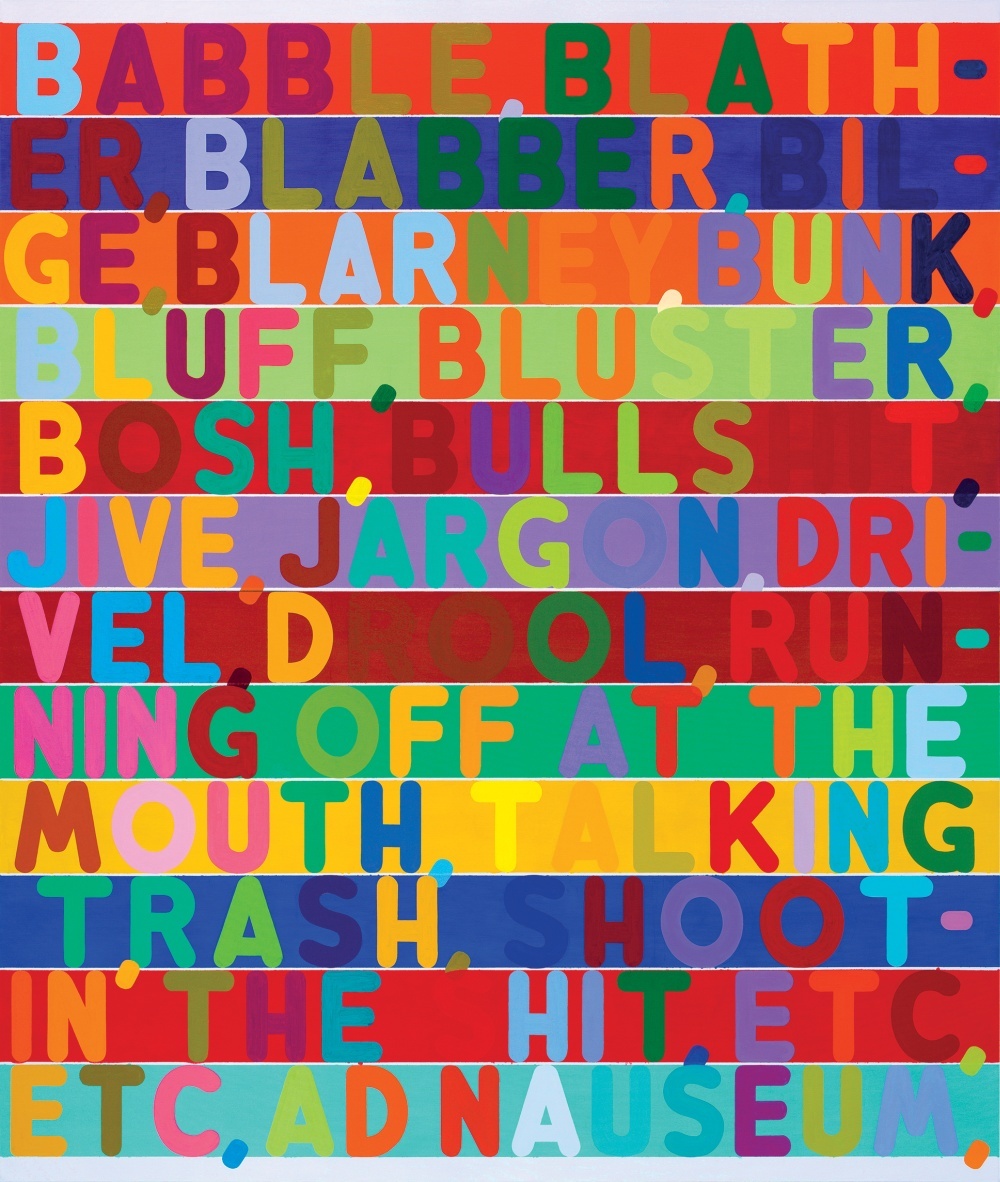

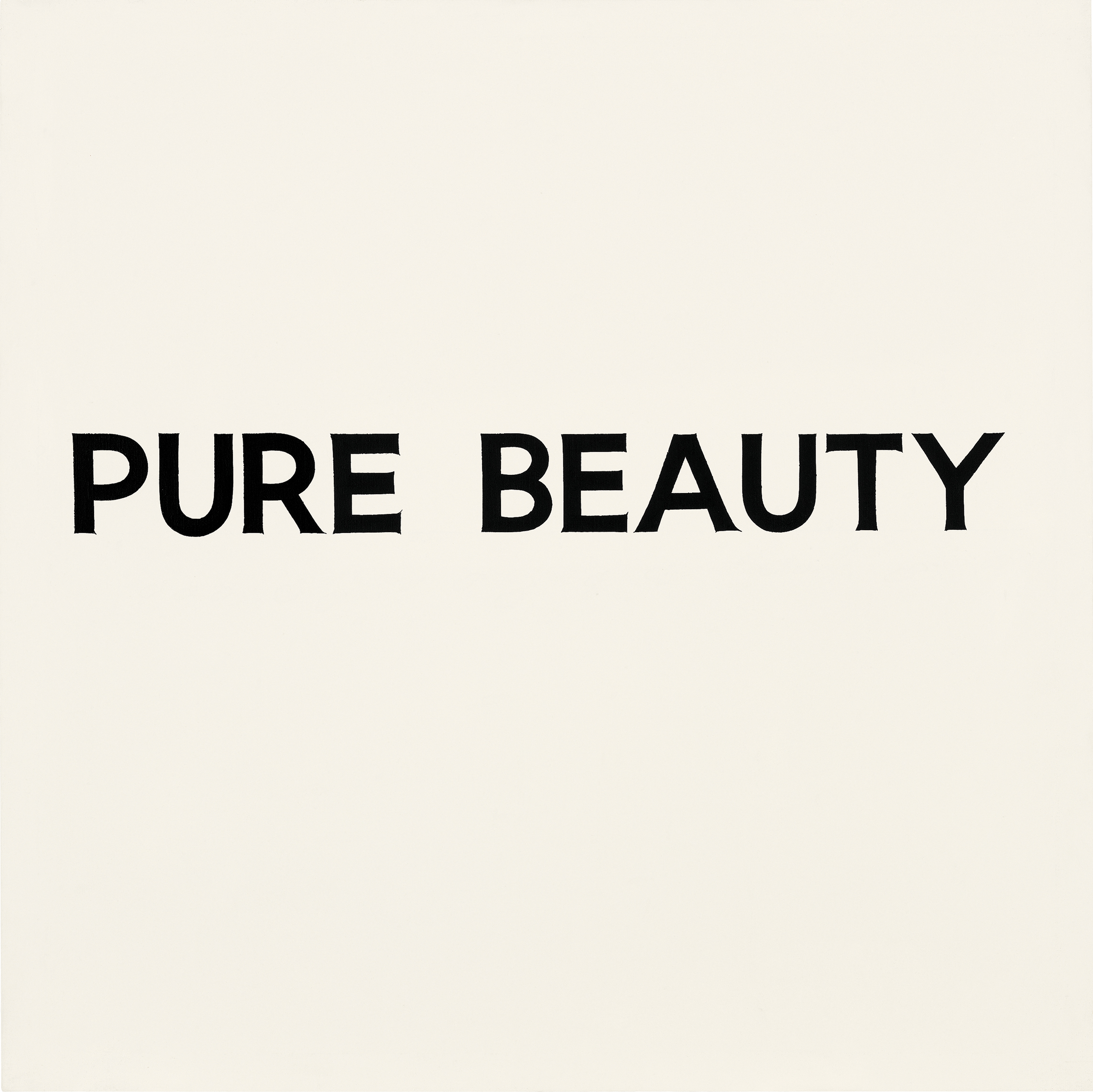

Sobre as ilustrações do artigo: uma das dificuldades na compreensão de uma linguagem pelos computadores é o fato de que muitas vezes o significado das palavras depende do contexto e até da aparência das letras e palavras. Nas imagens apresentadas no artigo, vários artistas demonstram o uso de várias dicas visuais que transmitem uma carga semântica que ultrapassa os limites das próprias letras.No meio de um jogo tenso de go, que estava ocorrendo em Seul, na Coréia do Sul, entre Lee Sedol, um dos melhores jogadores de todos os tempos, e AlphaGo, uma IA criada pelo Google, o programa fez um movimento misterioso que demonstrou sua estranha superioridade sobre um rival humano.No movimento 37, AlphaGo decidiu colocar a pedra preta em uma posição estranha à primeira vista. Tudo correu ao ponto de ela ter perdido um território significativo - um erro de iniciante em um jogo construído sobre o controle do espaço no tabuleiro. Dois comentaristas de televisão estavam discutindo se eles entenderam corretamente o curso do computador e se ele quebrou. Aconteceu que, apesar da contradição do senso comum, a 37ª ação permitiu à AlphaGo construir uma estrutura intransponível no centro do quadro. O programa do Google venceu essencialmente o jogo com uma jogada em que ninguém pensaria.Vitória do AlphaGotambém impressionante, porque o antigo jogo de ir era frequentemente visto como um teste de inteligência intuitiva. Suas regras são simples. Dois jogadores se revezam colocando pedras pretas ou brancas na interseção das linhas horizontais e verticais do tabuleiro, tentando cercar as pedras do oponente e removê-las do tabuleiro. Mas jogar bem é incrivelmente difícil.Se os jogadores de xadrez são capazes de calcular o jogo vários passos à frente, rapidamente se torna uma tarefa inimaginavelmente difícil, além disso, não há gambits clássicos no jogo. Também não há uma maneira fácil de avaliar os benefícios e, mesmo para um jogador experiente, pode ser difícil explicar por que ele fez essa jogada. Por esse motivo, é impossível escrever um conjunto simples de regras que seriam seguidas por um programa em execução no nível de especialista.AlphaGo não foi ensinado a jogar go. O programa analisou centenas de milhares de jogos e jogou milhões de partidas sozinho. Entre as várias técnicas de IA, ela usou o método cada vez mais popular conhecido como aprendizado profundo. É baseado em cálculos matemáticos, cujo método é inspirado na maneira como camadas interconectadas de neurônios no cérebro são ativadas ao processar novas informações. O programa aprendeu a si mesmo durante muitas horas de prática, aprimorando gradualmente um senso intuitivo de estratégia. E o fato de ela ter conseguido derrotar uma das melhores jogadoras do mundo é um novo marco em inteligência de máquina e IA.

Sobre as ilustrações do artigo: uma das dificuldades na compreensão de uma linguagem pelos computadores é o fato de que muitas vezes o significado das palavras depende do contexto e até da aparência das letras e palavras. Nas imagens apresentadas no artigo, vários artistas demonstram o uso de várias dicas visuais que transmitem uma carga semântica que ultrapassa os limites das próprias letras.No meio de um jogo tenso de go, que estava ocorrendo em Seul, na Coréia do Sul, entre Lee Sedol, um dos melhores jogadores de todos os tempos, e AlphaGo, uma IA criada pelo Google, o programa fez um movimento misterioso que demonstrou sua estranha superioridade sobre um rival humano.No movimento 37, AlphaGo decidiu colocar a pedra preta em uma posição estranha à primeira vista. Tudo correu ao ponto de ela ter perdido um território significativo - um erro de iniciante em um jogo construído sobre o controle do espaço no tabuleiro. Dois comentaristas de televisão estavam discutindo se eles entenderam corretamente o curso do computador e se ele quebrou. Aconteceu que, apesar da contradição do senso comum, a 37ª ação permitiu à AlphaGo construir uma estrutura intransponível no centro do quadro. O programa do Google venceu essencialmente o jogo com uma jogada em que ninguém pensaria.Vitória do AlphaGotambém impressionante, porque o antigo jogo de ir era frequentemente visto como um teste de inteligência intuitiva. Suas regras são simples. Dois jogadores se revezam colocando pedras pretas ou brancas na interseção das linhas horizontais e verticais do tabuleiro, tentando cercar as pedras do oponente e removê-las do tabuleiro. Mas jogar bem é incrivelmente difícil.Se os jogadores de xadrez são capazes de calcular o jogo vários passos à frente, rapidamente se torna uma tarefa inimaginavelmente difícil, além disso, não há gambits clássicos no jogo. Também não há uma maneira fácil de avaliar os benefícios e, mesmo para um jogador experiente, pode ser difícil explicar por que ele fez essa jogada. Por esse motivo, é impossível escrever um conjunto simples de regras que seriam seguidas por um programa em execução no nível de especialista.AlphaGo não foi ensinado a jogar go. O programa analisou centenas de milhares de jogos e jogou milhões de partidas sozinho. Entre as várias técnicas de IA, ela usou o método cada vez mais popular conhecido como aprendizado profundo. É baseado em cálculos matemáticos, cujo método é inspirado na maneira como camadas interconectadas de neurônios no cérebro são ativadas ao processar novas informações. O programa aprendeu a si mesmo durante muitas horas de prática, aprimorando gradualmente um senso intuitivo de estratégia. E o fato de ela ter conseguido derrotar uma das melhores jogadoras do mundo é um novo marco em inteligência de máquina e IA. Poucas horas após a 37ª jogada, o AlphaGo venceu o jogo e começou a liderar por 2-0 em uma partida de cinco jogos. Depois disso, Sedol ficou na frente de uma multidão de jornalistas e fotógrafos e pediu desculpas educadamente por decepcionar a humanidade. "Eu fiquei sem palavras", disse ele, piscando sob as rajadas de flash.O incrível sucesso do AlphaGo mostra quanto progresso foi feito na IA nos últimos anos, após décadas de desespero e desafios descritos como "o inverno da IA". O aprendizado profundo permite que as máquinas aprendam sozinhas como executar tarefas complexas, cuja solução alguns anos atrás não poderia ser imaginada sem a participação da inteligência humana. Os robôs já estão aparecendo no horizonte. Num futuro próximo, os sistemas de aprendizado profundo ajudarão a diagnosticar doenças e fornecerão recomendações de tratamento.Mas, apesar desses avanços impressionantes, uma das principais possibilidades não é dada de forma alguma pela IA: a linguagem. Sistemas como Siri e IBM Watson podem reconhecer comandos verbais e escritos simples e responder a perguntas simples, mas não conseguem manter uma conversa ou realmente entender as palavras usadas. Para a IA mudar nosso mundo, isso deve mudar.Embora o AlphaGo não fale, ele possui uma tecnologia que pode proporcionar uma melhor compreensão do idioma. No Google, Facebook, Amazon e laboratórios de ciências, os pesquisadores estão tentando resolver esse problema teimoso usando as mesmas ferramentas de IA - incluindo aprendizado profundo - responsáveis pelo sucesso do AlphaGo e pelo ressurgimento da IA. O sucesso deles determinará o escopo e as propriedades do que já está começando a se transformar em uma revolução da IA. Isso determinará o nosso futuro - teremos máquinas fáceis de se comunicar ou sistemas com IA permanecerão misteriosas caixas-pretas, embora mais autônomas. "Não há como criar um sistema semelhante ao humano com IA, a menos que seja baseado na linguagem", disse Josh Tenenbaum, professor de ciências cognitivas e computação do MIT. "Esta é uma das coisas mais óbvias que definem a inteligência humana."Talvez as mesmas tecnologias que permitiram o AlphaGo vencer a partida permitam que os computadores dominem o idioma, ou então algo mais será necessário. Mas sem entender o idioma, o impacto da IA será diferente. Obviamente, ainda teremos programas irrealisticamente poderosos e inteligentes como o AlphaGo. Mas nosso relacionamento com a IA não será tão próximo e provavelmente não será tão amigável. “A maior questão desde o início da pesquisa foi:“ E se você tiver dispositivos inteligentes em termos de eficiência, mas que não sejam como nós em termos de falta de empatia por quem somos? ”, Diz Terry Winograd, Honrado. professor da Universidade de Stanford. "Você pode imaginar máquinas que não são baseadas na inteligência humana, trabalhar com big data e controlar o mundo."

Poucas horas após a 37ª jogada, o AlphaGo venceu o jogo e começou a liderar por 2-0 em uma partida de cinco jogos. Depois disso, Sedol ficou na frente de uma multidão de jornalistas e fotógrafos e pediu desculpas educadamente por decepcionar a humanidade. "Eu fiquei sem palavras", disse ele, piscando sob as rajadas de flash.O incrível sucesso do AlphaGo mostra quanto progresso foi feito na IA nos últimos anos, após décadas de desespero e desafios descritos como "o inverno da IA". O aprendizado profundo permite que as máquinas aprendam sozinhas como executar tarefas complexas, cuja solução alguns anos atrás não poderia ser imaginada sem a participação da inteligência humana. Os robôs já estão aparecendo no horizonte. Num futuro próximo, os sistemas de aprendizado profundo ajudarão a diagnosticar doenças e fornecerão recomendações de tratamento.Mas, apesar desses avanços impressionantes, uma das principais possibilidades não é dada de forma alguma pela IA: a linguagem. Sistemas como Siri e IBM Watson podem reconhecer comandos verbais e escritos simples e responder a perguntas simples, mas não conseguem manter uma conversa ou realmente entender as palavras usadas. Para a IA mudar nosso mundo, isso deve mudar.Embora o AlphaGo não fale, ele possui uma tecnologia que pode proporcionar uma melhor compreensão do idioma. No Google, Facebook, Amazon e laboratórios de ciências, os pesquisadores estão tentando resolver esse problema teimoso usando as mesmas ferramentas de IA - incluindo aprendizado profundo - responsáveis pelo sucesso do AlphaGo e pelo ressurgimento da IA. O sucesso deles determinará o escopo e as propriedades do que já está começando a se transformar em uma revolução da IA. Isso determinará o nosso futuro - teremos máquinas fáceis de se comunicar ou sistemas com IA permanecerão misteriosas caixas-pretas, embora mais autônomas. "Não há como criar um sistema semelhante ao humano com IA, a menos que seja baseado na linguagem", disse Josh Tenenbaum, professor de ciências cognitivas e computação do MIT. "Esta é uma das coisas mais óbvias que definem a inteligência humana."Talvez as mesmas tecnologias que permitiram o AlphaGo vencer a partida permitam que os computadores dominem o idioma, ou então algo mais será necessário. Mas sem entender o idioma, o impacto da IA será diferente. Obviamente, ainda teremos programas irrealisticamente poderosos e inteligentes como o AlphaGo. Mas nosso relacionamento com a IA não será tão próximo e provavelmente não será tão amigável. “A maior questão desde o início da pesquisa foi:“ E se você tiver dispositivos inteligentes em termos de eficiência, mas que não sejam como nós em termos de falta de empatia por quem somos? ”, Diz Terry Winograd, Honrado. professor da Universidade de Stanford. "Você pode imaginar máquinas que não são baseadas na inteligência humana, trabalhar com big data e controlar o mundo."Conversando com carros

Alguns meses após o triunfo do AlphaGo, fui ao Vale do Silício, o coração do boom da IA. Eu queria me encontrar com pesquisadores que fizeram um progresso significativo nas aplicações práticas da IA e estão tentando dar às máquinas uma compreensão da linguagem.Comecei com Vinohrad, que vive em um subúrbio no extremo sul do campus de Stanford, em Palo Alto, não muito longe da sede do Google, Facebook e Apple. Seus cabelos grisalhos encaracolados e bigode grosso dão a ele a aparência de um cientista respeitável, e ele infecta com entusiasmo.Em 1968, Grapes fez uma das primeiras tentativas de ensinar as máquinas a falar. Como um prodígio matemático apaixonado pela linguagem, ele veio ao novo laboratório do MIT AI para se formar. Ele decidiu criar um programa que se comunica com as pessoas através da entrada de texto na linguagem cotidiana. Naquela época, não parecia um objetivo tão ousado. Foram dados grandes passos no desenvolvimento da IA, e outras equipes do MIT construíram sofisticados sistemas de visão computacional e manipuladores robóticos. "Havia um sentimento de possibilidades desconhecidas e ilimitadas", lembra ele. Mas nem todos acreditavam que a linguagem era tão fácil de conquistar. Alguns críticos, incluindo o influente linguista e professor do MIT Noam Chomsky, pensaram que seria muito difícil para os pesquisadores de IA ensinar máquinas a entender, uma vez que a mecânica da linguagem em humanos era muito pouco compreendida. Grapes lembra de uma festa na qual um estudante Chomsky se afastou dele depois de ouvir que ele estava trabalhando em um laboratório de IA.Mas há razões para otimismo. Joseph Weizenbaum, professor do MIT de descendência alemã, fez o primeiro programa de chatbot há alguns anos. O nome dela era ELIZA e ela foi programada para responder como um psicólogo a partir de desenhos animados, repetindo partes importantes das declarações ou fazendo perguntas inspiradoras para continuar a conversa. Se você disser a ela que estava com raiva de sua mãe, o programa pode dizer: "O que mais vem à sua mente quando você pensa em sua mãe?". Um truque barato que funcionou surpreendentemente bem. Weisenbaum ficou chocado quando alguns indivíduos começaram a verificar seus segredos sombrios com seu carro.As uvas queriam fazer algo que pudesse convencer convincentemente que ele entendia a língua. Ele começou reduzindo o escopo do problema. Ele criou um ambiente virtual simples, o "mundo dos blocos", que consiste em um conjunto de objetos fictícios em uma mesa fictícia. Ele então criou um programa com o nome SHRDLU, que pode analisar todos os substantivos, verbos e regras gramaticais simples necessárias para se comunicar neste mundo virtual simplificado. SHRDLU (uma palavra sem sentido composta de uma linha de letras do teclado do linótipo) poderia descrever objetos, responder perguntas sobre seus relacionamentos e mudar o mundo do bloco em resposta aos comandos de entrada. Ela até tinha uma certa memória e, se você pedisse para ela mover o “cone vermelho” e depois escrevia sobre um determinado cone, ela assumiu que você tinha em mente esse cone vermelho e não qualquer outro.

Mas nem todos acreditavam que a linguagem era tão fácil de conquistar. Alguns críticos, incluindo o influente linguista e professor do MIT Noam Chomsky, pensaram que seria muito difícil para os pesquisadores de IA ensinar máquinas a entender, uma vez que a mecânica da linguagem em humanos era muito pouco compreendida. Grapes lembra de uma festa na qual um estudante Chomsky se afastou dele depois de ouvir que ele estava trabalhando em um laboratório de IA.Mas há razões para otimismo. Joseph Weizenbaum, professor do MIT de descendência alemã, fez o primeiro programa de chatbot há alguns anos. O nome dela era ELIZA e ela foi programada para responder como um psicólogo a partir de desenhos animados, repetindo partes importantes das declarações ou fazendo perguntas inspiradoras para continuar a conversa. Se você disser a ela que estava com raiva de sua mãe, o programa pode dizer: "O que mais vem à sua mente quando você pensa em sua mãe?". Um truque barato que funcionou surpreendentemente bem. Weisenbaum ficou chocado quando alguns indivíduos começaram a verificar seus segredos sombrios com seu carro.As uvas queriam fazer algo que pudesse convencer convincentemente que ele entendia a língua. Ele começou reduzindo o escopo do problema. Ele criou um ambiente virtual simples, o "mundo dos blocos", que consiste em um conjunto de objetos fictícios em uma mesa fictícia. Ele então criou um programa com o nome SHRDLU, que pode analisar todos os substantivos, verbos e regras gramaticais simples necessárias para se comunicar neste mundo virtual simplificado. SHRDLU (uma palavra sem sentido composta de uma linha de letras do teclado do linótipo) poderia descrever objetos, responder perguntas sobre seus relacionamentos e mudar o mundo do bloco em resposta aos comandos de entrada. Ela até tinha uma certa memória e, se você pedisse para ela mover o “cone vermelho” e depois escrevia sobre um determinado cone, ela assumiu que você tinha em mente esse cone vermelho e não qualquer outro. SHRDLU tornou-se a bandeira do tremendo progresso na IA. Mas era apenas uma ilusão. Quando Vinogrado tentou expandir o mundo dos blocos do programa, as regras necessárias para dar conta de palavras e dificuldades gramaticais adicionais se tornaram incontroláveis. Apenas alguns anos depois, ele se rendeu e deixou o campo da IA, concentrando-se em outros estudos. "As restrições eram muito mais fortes do que pareciam na época", diz ele.Grapes decidiu que, com as ferramentas disponíveis na época, era impossível ensinar a máquina a entender verdadeiramente o idioma. O problema, de acordo com Hubert Dreyfus, professor de filosofia da Universidade da Califórnia em Berkeley, expresso por ele em 1972, O que os computadores não podem fazer, é que muitas ações humanas exigem compreensão instintiva que não pode ser definido por um conjunto de regras simples. Por isso, antes do início da partida entre Sedol e AlphaGo, muitos especialistas duvidavam que as máquinas fossem capazes de dominar o jogo de ir.

SHRDLU tornou-se a bandeira do tremendo progresso na IA. Mas era apenas uma ilusão. Quando Vinogrado tentou expandir o mundo dos blocos do programa, as regras necessárias para dar conta de palavras e dificuldades gramaticais adicionais se tornaram incontroláveis. Apenas alguns anos depois, ele se rendeu e deixou o campo da IA, concentrando-se em outros estudos. "As restrições eram muito mais fortes do que pareciam na época", diz ele.Grapes decidiu que, com as ferramentas disponíveis na época, era impossível ensinar a máquina a entender verdadeiramente o idioma. O problema, de acordo com Hubert Dreyfus, professor de filosofia da Universidade da Califórnia em Berkeley, expresso por ele em 1972, O que os computadores não podem fazer, é que muitas ações humanas exigem compreensão instintiva que não pode ser definido por um conjunto de regras simples. Por isso, antes do início da partida entre Sedol e AlphaGo, muitos especialistas duvidavam que as máquinas fossem capazes de dominar o jogo de ir. Mas enquanto Dreyfus estava provando seu argumento, vários pesquisadores estavam desenvolvendo uma abordagem que, no final, daria às máquinas o tipo de inteligência de que precisavam. Inspirados pela neurociência, eles experimentaram redes neurais artificiais - camadas de simulações matemáticas de neurônios que podem ser treinadas para serem ativadas em resposta a determinados dados de entrada. No início, esses sistemas funcionavam impossivelmente devagar e a abordagem foi rejeitada como impraticável para lógica e raciocínio. No entanto, um recurso importante das redes neurais era a capacidade de aprender o que não foi programado manualmente e, posteriormente, acabou sendo útil para tarefas simples, como reconhecimento de manuscrito. Essa habilidade encontrou uso comercial nos anos 90 para ler números de cheques. Os defensores do método estavam confiantes de que, com o tempo, as redes neurais permitiriam que as máquinas fizessem muito mais.Eles alegaram que algum dia essa tecnologia ajudará e reconhecerá o idioma.Nos últimos anos, as redes neurais se tornaram mais complexas e poderosas. A abordagem floresceu graças às principais melhorias matemáticas e, mais importante, ao hardware mais rápido do computador e ao advento de grandes quantidades de dados. Em 2009, pesquisadores da Universidade de Toronto mostraram que redes de aprendizado profundo multicamadas podem reconhecer a fala com precisão de registro. E em 2012, o mesmo grupo venceu a competição de visão de máquina usando um algoritmo de aprendizado profundo que mostrou uma precisão incrível.Uma rede neural de aprendizado profundo reconhece objetos em imagens com um truque simples. A camada de neurônios simulados recebe entrada como uma imagem e alguns dos neurônios são ativados em resposta à intensidade de pixels individuais. O sinal resultante passa por muitas camadas de neurônios interconectados antes de atingir a camada de saída, que sinaliza a observação de um objeto. Uma técnica matemática chamada “retropropagação” é usada para ajustar a sensibilidade dos neurônios da rede para criar a resposta correta. É este passo que dá ao sistema a oportunidade de aprender. Camadas diferentes na rede respondem a propriedades como bordas, cores ou textura. Hoje, esses sistemas são capazes de reconhecer objetos, animais ou rostos com precisão que rivaliza com os humanos.Existe um problema óbvio com a aplicação da tecnologia de aprendizado profundo no idioma. As palavras são caracteres arbitrários, e é assim que elas diferem essencialmente das imagens. Duas palavras podem ter um significado semelhante e conter letras completamente diferentes. E a mesma palavra pode significar coisas diferentes, dependendo do contexto.Na década de 1980, os pesquisadores tiveram a ideia complicada de transformar uma linguagem em um tipo de problema que uma rede neural pode lidar. Eles mostraram que as palavras podem ser representadas como vetores matemáticos, o que nos permite calcular a semelhança de palavras relacionadas. Por exemplo, "barco" e "água" estão próximos no espaço vetorial, embora pareçam diferentes. Pesquisadores da Universidade de Montreal, liderados por Yoshua Bengio e outra equipe do Google, usaram essa idéia para criar redes nas quais cada palavra em uma frase é usada para criar uma representação mais complexa. Geoffrey Hinton, professor da Universidade de Toronto e um importante pesquisador de aprendizado profundo que também trabalha para o Google, chama isso de "vetor mental".Usando duas dessas redes, você pode traduzir de um idioma para outro com excelente precisão. E combinando esses tipos de redes com a que reconhece objetos nas imagens, você pode obter legendas surpreendentemente precisas.

Mas enquanto Dreyfus estava provando seu argumento, vários pesquisadores estavam desenvolvendo uma abordagem que, no final, daria às máquinas o tipo de inteligência de que precisavam. Inspirados pela neurociência, eles experimentaram redes neurais artificiais - camadas de simulações matemáticas de neurônios que podem ser treinadas para serem ativadas em resposta a determinados dados de entrada. No início, esses sistemas funcionavam impossivelmente devagar e a abordagem foi rejeitada como impraticável para lógica e raciocínio. No entanto, um recurso importante das redes neurais era a capacidade de aprender o que não foi programado manualmente e, posteriormente, acabou sendo útil para tarefas simples, como reconhecimento de manuscrito. Essa habilidade encontrou uso comercial nos anos 90 para ler números de cheques. Os defensores do método estavam confiantes de que, com o tempo, as redes neurais permitiriam que as máquinas fizessem muito mais.Eles alegaram que algum dia essa tecnologia ajudará e reconhecerá o idioma.Nos últimos anos, as redes neurais se tornaram mais complexas e poderosas. A abordagem floresceu graças às principais melhorias matemáticas e, mais importante, ao hardware mais rápido do computador e ao advento de grandes quantidades de dados. Em 2009, pesquisadores da Universidade de Toronto mostraram que redes de aprendizado profundo multicamadas podem reconhecer a fala com precisão de registro. E em 2012, o mesmo grupo venceu a competição de visão de máquina usando um algoritmo de aprendizado profundo que mostrou uma precisão incrível.Uma rede neural de aprendizado profundo reconhece objetos em imagens com um truque simples. A camada de neurônios simulados recebe entrada como uma imagem e alguns dos neurônios são ativados em resposta à intensidade de pixels individuais. O sinal resultante passa por muitas camadas de neurônios interconectados antes de atingir a camada de saída, que sinaliza a observação de um objeto. Uma técnica matemática chamada “retropropagação” é usada para ajustar a sensibilidade dos neurônios da rede para criar a resposta correta. É este passo que dá ao sistema a oportunidade de aprender. Camadas diferentes na rede respondem a propriedades como bordas, cores ou textura. Hoje, esses sistemas são capazes de reconhecer objetos, animais ou rostos com precisão que rivaliza com os humanos.Existe um problema óbvio com a aplicação da tecnologia de aprendizado profundo no idioma. As palavras são caracteres arbitrários, e é assim que elas diferem essencialmente das imagens. Duas palavras podem ter um significado semelhante e conter letras completamente diferentes. E a mesma palavra pode significar coisas diferentes, dependendo do contexto.Na década de 1980, os pesquisadores tiveram a ideia complicada de transformar uma linguagem em um tipo de problema que uma rede neural pode lidar. Eles mostraram que as palavras podem ser representadas como vetores matemáticos, o que nos permite calcular a semelhança de palavras relacionadas. Por exemplo, "barco" e "água" estão próximos no espaço vetorial, embora pareçam diferentes. Pesquisadores da Universidade de Montreal, liderados por Yoshua Bengio e outra equipe do Google, usaram essa idéia para criar redes nas quais cada palavra em uma frase é usada para criar uma representação mais complexa. Geoffrey Hinton, professor da Universidade de Toronto e um importante pesquisador de aprendizado profundo que também trabalha para o Google, chama isso de "vetor mental".Usando duas dessas redes, você pode traduzir de um idioma para outro com excelente precisão. E combinando esses tipos de redes com a que reconhece objetos nas imagens, você pode obter legendas surpreendentemente precisas.Significado da vida

Sentado em uma sala de conferências no coração da movimentada sede do Google em Mountain View, Califórnia, um dos pesquisadores da empresa que desenvolveu essa abordagem, Quoc Le, discute a idéia de uma máquina capaz de suportar uma conversa real. As ambições de Lee explicam como as máquinas de falar podem ser úteis. "Eu preciso de uma maneira de simular pensamentos em um carro", diz ele. "E se você quiser fingir ser um pensamento, pode perguntar ao carro o que ela está pensando." O Google já está ensinando a seus computadores o básico do idioma. Em maio, a empresa lançou o sistema Parsey McParseface, que pode reconhecer sintaxe, substantivos, verbos e outros elementos de texto. É fácil ver como a compreensão de um idioma pode ajudar uma empresa. O algoritmo de pesquisa do Google uma vez simplesmente rastreava palavras-chave e links entre páginas da web. Agora, o sistema RankBrain lê o texto das páginas para entender seu significado e melhorar os resultados da pesquisa. Lee quer levar essa idéia ainda mais longe. Adaptando o sistema, que se mostrou útil para traduções e assinaturas de fotos, ele e seus colegas criaram o Smart Reply, que lê o conteúdo das cartas no Gmail e oferece respostas possíveis. Eles também criaram um programa que aprendeu através do bate-papo de suporte do Google para responder a perguntas técnicas simples.Lee criou recentemente um programa que pode gerar respostas decentes para perguntas difíceis. Ela treinou em diálogos de 18.900 filmes. Algumas respostas assustadoramente atingiram a marca. Por exemplo, Lee perguntou: "Qual é o propósito da vida?" E o programa respondeu: "A serviço do bem maior". "Essa é uma boa resposta", ele lembra com um sorriso. "Talvez melhor do que eu me responderia."Há apenas um problema que se torna aparente quando se olha para mais respostas do sistema. Quando Lee perguntou: "Quantas pernas tem um gato?", O sistema respondeu: "Acho que quatro". Então ele perguntou: “Quantas pernas tem uma centopéia?” E recebeu a estranha resposta “Oito”. De fato, o programa de Lee não entende do que ele está falando. Ela entende que algumas combinações de símbolos são combinadas, mas não entende o mundo real. Ela não sabe como é uma centopéia ou como ela se move. Isso ainda é uma ilusão de inteligência, sem senso comum, que as pessoas dão como certa. Os sistemas de aprendizado profundo são bastante instáveis nesse sentido. Um sistema do Google que cria legendas para imagens às vezes comete erros estranhos, por exemplo, descreve um sinal de trânsito como uma geladeira com comida.Por uma estranha coincidência, o vizinho de Terry Vinohrad em Palo Alto acabou sendo um homem que pode ajudar os computadores a entender melhor o verdadeiro significado das palavras. Fei-Fei Li, diretora do Laboratório de Inteligência Artificial de Stanford, estava em licença de maternidade durante minha visita, mas ela me convidou para casa e orgulhosamente me apresentou a seu bebê de três meses, Phoenix. "Observe que ela olha para você mais do que para mim", disse Lee quando o Phoenix me encarou. - Isso é porque você é novo; é um reconhecimento facial precoce ".Durante a maior parte de sua carreira, Lee estudou aprendizado de máquina e visão computacional. Há vários anos, sob sua liderança, foi feita uma tentativa de criar um banco de dados de milhões de imagens de objetos, cada um dos quais assinado com as palavras-chave correspondentes. Mas Lee acredita que as máquinas precisam de uma compreensão mais complicada do que está acontecendo no mundo, e este ano sua equipe lançou outro banco de dados com imagens, anotações às quais era muito mais rico. Para cada foto, as pessoas faziam dezenas de assinaturas: “Cachorro de skate”, “O cachorro tem um pelo grosso e ondulado”, “Estrada com rachaduras” e assim por diante. Eles esperam que os sistemas de aprendizado de máquina aprendam a entender o mundo físico. "A parte lingüística do cérebro recebe muita informação, inclusive do sistema visual", diz Lee. "Uma parte importante da IA será a integração desses sistemas."Esse processo está mais próximo de ensinar as crianças a conectar palavras com objetos, relacionamentos e ações. Mas a analogia com ensinar as pessoas não vai longe demais. As crianças não precisam ver um cachorro em um skate para imaginá-lo ou descrevê-lo em palavras. Lee acredita que as ferramentas atuais para IA e aprendizado de máquina não serão suficientes para criar uma IA real. "Não será apenas um aprendizado profundo com um grande conjunto de dados", diz ela. "Nós, humanos, nos saímos muito mal com cálculos de big data, mas muito bem com abstrações e criatividade".Ninguém sabe como dotar as máquinas dessas qualidades humanas e se isso é possível. Existe algo exclusivamente humano nessas qualidades que não permite que a IA as possua?Especialistas em ciências cognitivas, como Tenenbaum, do MIT, acreditam que as redes neurais atuais carecem de componentes críticos da mente - independentemente do tamanho dessas redes. As pessoas são capazes de aprender relativamente rápido em quantidades relativamente pequenas de dados e têm a capacidade integrada de simular efetivamente um mundo tridimensional. “A linguagem é construída sobre outras possibilidades, provavelmente mais profundas e presentes nos bebês antes mesmo de começarem a dominar a linguagem: percepção visual do mundo, trabalho com nosso aparato motor, entendimento da física do mundo e das intenções de outras criaturas”, diz Tenenbaum.Se ele estiver certo, sem tentar simular o processo de aprendizado humano, criar modelos mentais e psicológicos, será muito difícil recriar o entendimento da linguagem na IA.

O Google já está ensinando a seus computadores o básico do idioma. Em maio, a empresa lançou o sistema Parsey McParseface, que pode reconhecer sintaxe, substantivos, verbos e outros elementos de texto. É fácil ver como a compreensão de um idioma pode ajudar uma empresa. O algoritmo de pesquisa do Google uma vez simplesmente rastreava palavras-chave e links entre páginas da web. Agora, o sistema RankBrain lê o texto das páginas para entender seu significado e melhorar os resultados da pesquisa. Lee quer levar essa idéia ainda mais longe. Adaptando o sistema, que se mostrou útil para traduções e assinaturas de fotos, ele e seus colegas criaram o Smart Reply, que lê o conteúdo das cartas no Gmail e oferece respostas possíveis. Eles também criaram um programa que aprendeu através do bate-papo de suporte do Google para responder a perguntas técnicas simples.Lee criou recentemente um programa que pode gerar respostas decentes para perguntas difíceis. Ela treinou em diálogos de 18.900 filmes. Algumas respostas assustadoramente atingiram a marca. Por exemplo, Lee perguntou: "Qual é o propósito da vida?" E o programa respondeu: "A serviço do bem maior". "Essa é uma boa resposta", ele lembra com um sorriso. "Talvez melhor do que eu me responderia."Há apenas um problema que se torna aparente quando se olha para mais respostas do sistema. Quando Lee perguntou: "Quantas pernas tem um gato?", O sistema respondeu: "Acho que quatro". Então ele perguntou: “Quantas pernas tem uma centopéia?” E recebeu a estranha resposta “Oito”. De fato, o programa de Lee não entende do que ele está falando. Ela entende que algumas combinações de símbolos são combinadas, mas não entende o mundo real. Ela não sabe como é uma centopéia ou como ela se move. Isso ainda é uma ilusão de inteligência, sem senso comum, que as pessoas dão como certa. Os sistemas de aprendizado profundo são bastante instáveis nesse sentido. Um sistema do Google que cria legendas para imagens às vezes comete erros estranhos, por exemplo, descreve um sinal de trânsito como uma geladeira com comida.Por uma estranha coincidência, o vizinho de Terry Vinohrad em Palo Alto acabou sendo um homem que pode ajudar os computadores a entender melhor o verdadeiro significado das palavras. Fei-Fei Li, diretora do Laboratório de Inteligência Artificial de Stanford, estava em licença de maternidade durante minha visita, mas ela me convidou para casa e orgulhosamente me apresentou a seu bebê de três meses, Phoenix. "Observe que ela olha para você mais do que para mim", disse Lee quando o Phoenix me encarou. - Isso é porque você é novo; é um reconhecimento facial precoce ".Durante a maior parte de sua carreira, Lee estudou aprendizado de máquina e visão computacional. Há vários anos, sob sua liderança, foi feita uma tentativa de criar um banco de dados de milhões de imagens de objetos, cada um dos quais assinado com as palavras-chave correspondentes. Mas Lee acredita que as máquinas precisam de uma compreensão mais complicada do que está acontecendo no mundo, e este ano sua equipe lançou outro banco de dados com imagens, anotações às quais era muito mais rico. Para cada foto, as pessoas faziam dezenas de assinaturas: “Cachorro de skate”, “O cachorro tem um pelo grosso e ondulado”, “Estrada com rachaduras” e assim por diante. Eles esperam que os sistemas de aprendizado de máquina aprendam a entender o mundo físico. "A parte lingüística do cérebro recebe muita informação, inclusive do sistema visual", diz Lee. "Uma parte importante da IA será a integração desses sistemas."Esse processo está mais próximo de ensinar as crianças a conectar palavras com objetos, relacionamentos e ações. Mas a analogia com ensinar as pessoas não vai longe demais. As crianças não precisam ver um cachorro em um skate para imaginá-lo ou descrevê-lo em palavras. Lee acredita que as ferramentas atuais para IA e aprendizado de máquina não serão suficientes para criar uma IA real. "Não será apenas um aprendizado profundo com um grande conjunto de dados", diz ela. "Nós, humanos, nos saímos muito mal com cálculos de big data, mas muito bem com abstrações e criatividade".Ninguém sabe como dotar as máquinas dessas qualidades humanas e se isso é possível. Existe algo exclusivamente humano nessas qualidades que não permite que a IA as possua?Especialistas em ciências cognitivas, como Tenenbaum, do MIT, acreditam que as redes neurais atuais carecem de componentes críticos da mente - independentemente do tamanho dessas redes. As pessoas são capazes de aprender relativamente rápido em quantidades relativamente pequenas de dados e têm a capacidade integrada de simular efetivamente um mundo tridimensional. “A linguagem é construída sobre outras possibilidades, provavelmente mais profundas e presentes nos bebês antes mesmo de começarem a dominar a linguagem: percepção visual do mundo, trabalho com nosso aparato motor, entendimento da física do mundo e das intenções de outras criaturas”, diz Tenenbaum.Se ele estiver certo, sem tentar simular o processo de aprendizado humano, criar modelos mentais e psicológicos, será muito difícil recriar o entendimento da linguagem na IA.Explique

O escritório de Noah Goodman, no Departamento de Psicologia de Stanford, está quase vazio, com exceção de algumas pinturas asráticas em uma das paredes e várias plantas cobertas de vegetação. Goodman rabiscou algo em seu laptop no momento da minha chegada, colocando os pés descalços sobre a mesa. Andamos pelo campus iluminado pelo sol para comprar café gelado. “A peculiaridade da linguagem é que ela se baseia não apenas em uma grande quantidade de informações sobre a linguagem, mas também na compreensão universal do mundo ao nosso redor e essas duas áreas de conhecimento estão implicitamente relacionadas entre si”, explica ele.Goodman e seus alunos desenvolveram a linguagem de programação Webppl, que pode ser usada para dotar computadores de bom senso probabilístico, o que é bastante importante nas conversas. Uma versão experimental é capaz de reconhecer o jogo de palavras e a outra é hipérbole. Se ela disser que algumas pessoas precisam passar a "eternidade" esperando por uma mesa em um restaurante, ela decidirá automaticamente que o significado literal dessa palavra nesse caso é improvável e que as pessoas provavelmente esperarão muito tempo e ficarão irritadas. O sistema ainda não pode ser chamado de inteligência verdadeira, mas mostra como novas abordagens podem ajudar os programas de IA a falar um pouco mais vivamente.O exemplo de Goodman também mostra como será difícil ensinar um idioma às máquinas. Compreender o significado do termo “eternidade” em um determinado contexto é um exemplo do que os sistemas de IA terão que aprender, e isso é realmente uma coisa bastante simples e rudimentar.No entanto, apesar da complexidade e complexidade da tarefa, os sucessos iniciais dos pesquisadores que usam o aprendizado profundo para reconhecer imagens ou jogar o jogo dão esperança de que estamos à beira de um avanço no campo da linguagem. Nesse caso, esse avanço chegou bem a tempo. Se a IA se tornar uma ferramenta universal, ajudar as pessoas a complementar e fortalecer sua própria inteligência e executar tarefas em um modo de simbiose sem problemas, então a linguagem é a chave para alcançar esse estado. Especialmente se os sistemas de IA usarem cada vez mais aprendizado profundo e outras tecnologias para auto-programação."Em geral, os sistemas de aprendizado profundo estão impressionados", disse John Leonard, professor de veículos robóticos do MIT. "Por outro lado, o trabalho deles é muito difícil de entender."A Toyota, que estuda várias tecnologias de direção autônoma, lançou um projeto de pesquisa no MIT liderado por Gerald Sussman, especialista em IA e linguagens de programação, com o objetivo de desenvolver um sistema de direção autônoma que possa explicar por que, em algum momento ou outra ação. A maneira óbvia de dar tal explicação seria verbal. "Criar sistemas com conhecimento é um grande desafio", diz Leonard, que dirige outro projeto da Toyota no MIT. "Mas, sim, o ideal seria que eles dessem não apenas uma resposta, mas uma explicação."Algumas semanas depois de voltar da Califórnia, eu me encontrei com David Silver, pesquisador do Google DeepMind e desenvolvedor do AlphaGo. Ele falou sobre a partida contra o Sedol em uma conferência científica em Nova York. Silver explicou que quando o programa no segundo jogo tomou uma decisão decisiva, sua equipe ficou surpresa não menos que as outras. Eles só podiam ver que o AlphaGo previa as chances de ganhar, e essa previsão não mudou muito após a 37ª jogada. Poucos dias depois, depois de analisar cuidadosamente o jogo, a equipe fez uma descoberta: digerindo os jogos anteriores, o programa calculou que um jogador humano poderia fazer tal jogada com uma probabilidade de 1 em 10.000. .Então, de certa forma, o carro sabia que esse movimento atingiria o ponto fraco de Sedol.Silver disse que o Google está considerando várias maneiras de comercializar essa tecnologia, incluindo assistentes inteligentes e ferramentas de assistência médica. Após a palestra, perguntei a ele sobre a importância de poder se comunicar com a IA que controla esses sistemas. "Uma pergunta interessante", disse ele após uma pausa. - Para algumas aplicações, isso pode ser útil. Por exemplo, na área da saúde, pode ser importante saber por que uma decisão específica foi tomada. ”De fato, a IA está se tornando cada vez mais complexa e confusa e é muito difícil imaginar como trabalharemos com eles sem linguagem - sem a capacidade de perguntar: "Por quê?". Além disso, a capacidade de se comunicar facilmente com os computadores os tornaria mais úteis e pareceriam mágicos. Afinal, a linguagem é a melhor maneira de entender o mundo e interagir com ele. Está na hora dos carros nos alcançarem.Source: https://habr.com/ru/post/pt396977/

All Articles