O iBrain já está aqui - e já está no seu telefone

Visão exclusiva da Apple sobre IA e Machine Learning

30 de julho de 2014 A Síria [Siri] transplantou o cérebro.Três anos antes, a Apple foi a primeira das maiores empresas de tecnologia a implantar um assistente de IA no sistema operacional. A Siri se tornou uma adaptação de um aplicativo de terceiros adquirido pela empresa. Ao mesmo tempo que o aplicativo em 2010, a empresa desenvolvedora foi adquirida. As primeiras análises da tecnologia foram entusiasmadas, mas nos meses e anos seguintes, os usuários começaram a incomodar suas falhas. Muitas vezes, ela reconheceu incorretamente comandos.Portanto, a Apple transferiu o sistema de reconhecimento de voz da Siri para trabalhar usando uma rede neural para usuários dos Estados Unidos no dia mencionado em julho (no resto do mundo, em 15 de agosto de 2014). Algumas das técnicas anteriores permaneceram operacionais - incluindo “modelos Markov ocultos” -, mas agora o sistema é baseado em técnicas de aprendizado de máquina, como redes neurais profundas (DNNs), redes neurais convolucionais, memória de longo prazo a curto prazo, memória de longo prazo, redes recorrentes com gateways e n-gramas. Após a atualização, a Siri parecia a mesma, mas o aprendizado profundo veio em seu socorro.E como costuma acontecer com atualizações ocultas, a Apple não a anuncia. Se os usuários perceberem, isso é uma redução no número de erros. A Apple afirma que os resultados na melhoria da precisão foram surpreendentes.

30 de julho de 2014 A Síria [Siri] transplantou o cérebro.Três anos antes, a Apple foi a primeira das maiores empresas de tecnologia a implantar um assistente de IA no sistema operacional. A Siri se tornou uma adaptação de um aplicativo de terceiros adquirido pela empresa. Ao mesmo tempo que o aplicativo em 2010, a empresa desenvolvedora foi adquirida. As primeiras análises da tecnologia foram entusiasmadas, mas nos meses e anos seguintes, os usuários começaram a incomodar suas falhas. Muitas vezes, ela reconheceu incorretamente comandos.Portanto, a Apple transferiu o sistema de reconhecimento de voz da Siri para trabalhar usando uma rede neural para usuários dos Estados Unidos no dia mencionado em julho (no resto do mundo, em 15 de agosto de 2014). Algumas das técnicas anteriores permaneceram operacionais - incluindo “modelos Markov ocultos” -, mas agora o sistema é baseado em técnicas de aprendizado de máquina, como redes neurais profundas (DNNs), redes neurais convolucionais, memória de longo prazo a curto prazo, memória de longo prazo, redes recorrentes com gateways e n-gramas. Após a atualização, a Siri parecia a mesma, mas o aprendizado profundo veio em seu socorro.E como costuma acontecer com atualizações ocultas, a Apple não a anuncia. Se os usuários perceberem, isso é uma redução no número de erros. A Apple afirma que os resultados na melhoria da precisão foram surpreendentes. Vice-presidente sênior de software e serviços da Internet, Eddie Kew“Foi um daqueles momentos em que a melhoria foi tão significativa que tivemos que verificar novamente os resultados para garantir que ninguém colocasse o separador decimal em outro lugar”, diz Eddie Kew. Vice-presidente sênior de programas e serviços da Internet.A história da transformação de Siri, descrita pela primeira vez neste artigo, pode surpreender os especialistas em IA. Não porque as redes neurais melhoraram o sistema, mas porque a Apple fez tudo silenciosamente. Até recentemente, quando a empresa aumentou seu recrutamento de especialistas em IA e adquiriu algumas empresas especializadas, os observadores consideravam a Apple atrasada na competição mais emocionante do nosso tempo: a corrida para explorar os ricos recursos da IA. Como a Apple sempre relutou em compartilhar informações sobre o que estava acontecendo a portas fechadas, os especialistas em IA não suspeitaram que a empresa estivesse envolvida em aprendizado de máquina. "A Apple não faz parte da comunidade", disse Jerry Kaplan, o curso de história da IA de Stanford. "A Apple é a NSA no mundo da IA". Mas os especialistas em IA pensaram que, se a Apple estivesse fazendo a IA tão a sério quanto o Google ou o Facebook, isso seria conhecido."As melhores pessoas no Google, Facebook e Microsoft são aprendizado de máquina", diz Oren Etzioni, do Allen Institute of AI. - Sim, a Apple contratou alguém. Mas me chame de cinco principais especialistas em IA da Apple? Eles têm reconhecimento de fala, mas não está claro onde mais o aprendizado de máquina os ajuda. Mostre-me onde o MO é usado no seu produto! ”"Eu mesmo estou no Missouri", diz Etzioni, que realmente nasceu em Israel. "Mostre-me."Recentemente, a Apple mostrou onde o aprendizado de máquina é usado em seus produtos - mas não para Etzoni, mas para mim. Passei a maior parte do dia na sala de reuniões One Infinite Loop, em Cupertino, recebendo informações básicas sobre o trabalho da empresa com IA e MO de executivos da Apple (Kew, Phil Schiller, vice-presidente sênior de marketing internacional e Craig Federigi, vice-presidente sênior de desenvolvimento de software) e dois cientistas cujo trabalho foi fundamental para o desenvolvimento da Síria. Sentamos e eles me deram um conteúdo de duas páginas listando produtos e serviços da Apple usando a tecnologia da máquina - aqueles que já estavam se preparando para a liberação ou já estavam saindo - como um tópico para discussão.Mensagem: Já estamos aqui. Nós não somos inferiores a ninguém. Mas fazemos do nosso jeito.Se você usa um iPhone, encontra a AI da Apple, e não apenas na versão aprimorada do Siri. Você o encontra quando o telefone identifica um chamador que não está na sua lista de contatos (mas que escreveu um e-mail recentemente). Ou quando você passa o dedo pela tela para exibir uma lista de aplicativos, entre os quais há uma alta probabilidade de que você queira abrir depois disso. Ou quando você recebe um lembrete de que não adicionou ao calendário. Ou quando um ponto aparece no mapa com o hotel que você reservou e você ainda não dirigiu em seu endereço. Ou quando o telefone aponta para o local onde você estacionou, mas você não perguntou a ele. Todos esses recursos apareceram ou foram bastante aprimorados pelo uso de aprendizado profundo e redes neurais.

Vice-presidente sênior de software e serviços da Internet, Eddie Kew“Foi um daqueles momentos em que a melhoria foi tão significativa que tivemos que verificar novamente os resultados para garantir que ninguém colocasse o separador decimal em outro lugar”, diz Eddie Kew. Vice-presidente sênior de programas e serviços da Internet.A história da transformação de Siri, descrita pela primeira vez neste artigo, pode surpreender os especialistas em IA. Não porque as redes neurais melhoraram o sistema, mas porque a Apple fez tudo silenciosamente. Até recentemente, quando a empresa aumentou seu recrutamento de especialistas em IA e adquiriu algumas empresas especializadas, os observadores consideravam a Apple atrasada na competição mais emocionante do nosso tempo: a corrida para explorar os ricos recursos da IA. Como a Apple sempre relutou em compartilhar informações sobre o que estava acontecendo a portas fechadas, os especialistas em IA não suspeitaram que a empresa estivesse envolvida em aprendizado de máquina. "A Apple não faz parte da comunidade", disse Jerry Kaplan, o curso de história da IA de Stanford. "A Apple é a NSA no mundo da IA". Mas os especialistas em IA pensaram que, se a Apple estivesse fazendo a IA tão a sério quanto o Google ou o Facebook, isso seria conhecido."As melhores pessoas no Google, Facebook e Microsoft são aprendizado de máquina", diz Oren Etzioni, do Allen Institute of AI. - Sim, a Apple contratou alguém. Mas me chame de cinco principais especialistas em IA da Apple? Eles têm reconhecimento de fala, mas não está claro onde mais o aprendizado de máquina os ajuda. Mostre-me onde o MO é usado no seu produto! ”"Eu mesmo estou no Missouri", diz Etzioni, que realmente nasceu em Israel. "Mostre-me."Recentemente, a Apple mostrou onde o aprendizado de máquina é usado em seus produtos - mas não para Etzoni, mas para mim. Passei a maior parte do dia na sala de reuniões One Infinite Loop, em Cupertino, recebendo informações básicas sobre o trabalho da empresa com IA e MO de executivos da Apple (Kew, Phil Schiller, vice-presidente sênior de marketing internacional e Craig Federigi, vice-presidente sênior de desenvolvimento de software) e dois cientistas cujo trabalho foi fundamental para o desenvolvimento da Síria. Sentamos e eles me deram um conteúdo de duas páginas listando produtos e serviços da Apple usando a tecnologia da máquina - aqueles que já estavam se preparando para a liberação ou já estavam saindo - como um tópico para discussão.Mensagem: Já estamos aqui. Nós não somos inferiores a ninguém. Mas fazemos do nosso jeito.Se você usa um iPhone, encontra a AI da Apple, e não apenas na versão aprimorada do Siri. Você o encontra quando o telefone identifica um chamador que não está na sua lista de contatos (mas que escreveu um e-mail recentemente). Ou quando você passa o dedo pela tela para exibir uma lista de aplicativos, entre os quais há uma alta probabilidade de que você queira abrir depois disso. Ou quando você recebe um lembrete de que não adicionou ao calendário. Ou quando um ponto aparece no mapa com o hotel que você reservou e você ainda não dirigiu em seu endereço. Ou quando o telefone aponta para o local onde você estacionou, mas você não perguntou a ele. Todos esses recursos apareceram ou foram bastante aprimorados pelo uso de aprendizado profundo e redes neurais. O reconhecimento de rosto funciona com redes neuraisComo dizem meus palestrantes, o MO já é usado em todos os produtos e serviços da empresa. A Apple usa treinamento aprofundado para identificar fraudadores na loja da Apple, aumentar a vida útil da bateria e filtrar os comentários mais úteis dos testadores beta. O MO ajuda a Apple a escolher as notícias para você. Determina se os usuários do Apple Watch praticam esportes ou simplesmente andam de um lado para o outro. Ele reconhece rostos e lugares de fotografias. Determina se é melhor interromper uma conexão Wi-Fi fraca e mudar para comunicações móveis. Ela até sabe como fazer um filme, combinando fotos e vídeos em um pequeno filme com o toque de um botão. Os concorrentes da empresa estão fazendo o mesmo, mas, de acordo com seus diretores, esses recursos de IA não podem funcionar tão bem, enquanto protegem a privacidade dos usuários tanto quanto na Apple.E, claro, nenhum deles faz produtos como os da Apple.A IA não é nova para a empresa. Já na década de 1990, eles usaram algumas técnicas de MO em programas que reconheciam a caligrafia (lembra de Newton?). Os remanescentes dessas tentativas podem ser encontrados nos programas atuais que convertem caracteres chineses manuscritos em texto ou reconhecem a entrada de letra por texto no Apple Watch. Ambas as oportunidades foram desenvolvidas pela mesma equipe de especialistas do Ministério da Defesa. Certamente, antes, o aprendizado de máquina funcionava mais primitivamente, e poucas pessoas conheciam o aprendizado profundo. Hoje, essas tecnologias estão no auge e a Apple está se arrepiando em resposta às alegações de que seu MO não é muito sério. E aqui os líderes da empresa falam sobre isso com mais detalhes.

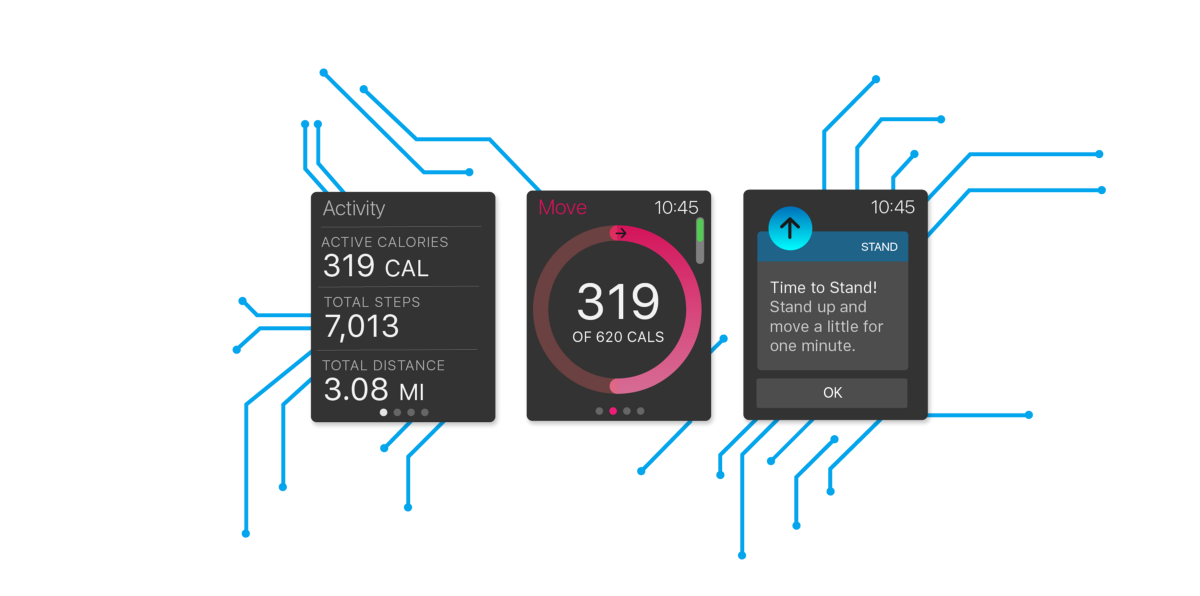

O reconhecimento de rosto funciona com redes neuraisComo dizem meus palestrantes, o MO já é usado em todos os produtos e serviços da empresa. A Apple usa treinamento aprofundado para identificar fraudadores na loja da Apple, aumentar a vida útil da bateria e filtrar os comentários mais úteis dos testadores beta. O MO ajuda a Apple a escolher as notícias para você. Determina se os usuários do Apple Watch praticam esportes ou simplesmente andam de um lado para o outro. Ele reconhece rostos e lugares de fotografias. Determina se é melhor interromper uma conexão Wi-Fi fraca e mudar para comunicações móveis. Ela até sabe como fazer um filme, combinando fotos e vídeos em um pequeno filme com o toque de um botão. Os concorrentes da empresa estão fazendo o mesmo, mas, de acordo com seus diretores, esses recursos de IA não podem funcionar tão bem, enquanto protegem a privacidade dos usuários tanto quanto na Apple.E, claro, nenhum deles faz produtos como os da Apple.A IA não é nova para a empresa. Já na década de 1990, eles usaram algumas técnicas de MO em programas que reconheciam a caligrafia (lembra de Newton?). Os remanescentes dessas tentativas podem ser encontrados nos programas atuais que convertem caracteres chineses manuscritos em texto ou reconhecem a entrada de letra por texto no Apple Watch. Ambas as oportunidades foram desenvolvidas pela mesma equipe de especialistas do Ministério da Defesa. Certamente, antes, o aprendizado de máquina funcionava mais primitivamente, e poucas pessoas conheciam o aprendizado profundo. Hoje, essas tecnologias estão no auge e a Apple está se arrepiando em resposta às alegações de que seu MO não é muito sério. E aqui os líderes da empresa falam sobre isso com mais detalhes. "Nos últimos cinco anos, temos observado o crescimento dessa área na empresa", diz Phil Schiller. "Nossos dispositivos estão ficando mais inteligentes e mais rápidos e mais rápidos, especialmente com o uso dos chips da série A que desenvolvemos. O back-end está ficando mais inteligente, mais rápido e tudo o que fazemos é conectado entre si." Isso nos permite usar cada vez mais técnicas de MO, porque muito precisa ser aprendido, mas já está disponível para nós. ”E embora a Apple esteja lutando para usar o MO ao máximo, os diretores enfatizam que esse processo não é nada de especial. Os chefes de Cupertin veem no aprendizado profundo e o MO apenas outra tecnologia de um fluxo de tecnologias inovadoras sucessivas. Sim, sim, está mudando o mundo, mas não mais do que outros avanços, como telas sensíveis ao toque, telas planas ou OOP. Do ponto de vista da Apple, a MO não é a última fronteira, apesar da opinião de outras empresas. "Afinal, não se pode dizer que, nos últimos anos, não houve outras tecnologias críticas para mudar os princípios de nossa interação com os dispositivos", diz Kew. E ninguém na empresa quer chegar perto de discutir tópicos assustadores que invariavelmente surgem ao mencionar a IA. E, como seria de esperar, a Apple não confirma se está trabalhando em veículos robóticos ou em sua versão do Netflix.Mas a equipe indicou claramente que a Apple não está trabalhando na Skynet."Usamos essas tecnologias para o que desejamos há muito tempo e com melhor qualidade do que era possível antes", diz Schiller. - E por coisas novas que não poderíamos fazer. Essa tecnologia se tornará um método da Apple para atingir metas à medida que evolui dentro da empresa e devido à forma como fabricamos nossos produtos. ”Mas durante o briefing, fica claro como a IA mudou bastante os métodos de uso do ecossistema da Apple. Os especialistas em IA acreditam que a Apple é limitada, pois não possui seu próprio mecanismo de pesquisa (que poderia fornecer dados para o treinamento de redes neurais) e sua convicção inflexível da necessidade de proteger as informações do usuário (dados que de outra forma poderiam ser usados). Mas acontece que a Apple já descobriu como superar esses dois obstáculos.E qual é o tamanho desse cérebro, um cache dinâmico que fornece MO no iPhone? Fiquei surpreso ao receber essa pergunta. Seu tamanho é de cerca de 200 MB, dependendo da quantidade de informações pessoais armazenadas (os dados antigos são sempre excluídos). Isso inclui informações sobre o uso de aplicativos, interação com pessoas, processamento de redes neurais, geração de voz e "modelagem de eventos em linguagem natural". Ele também contém dados usados para redes neurais que trabalham com reconhecimento de padrões, rostos e classificação de cenas.E, de acordo com a Apple, tudo isso é feito de forma que suas configurações, preferências e movimentos permaneçam privados.E, embora eles não tenham me explicado tudo sobre o uso da IA na empresa, consegui descobrir como a empresa espalha a experiência no MO entre os funcionários da organização. O talento da região de Moscou é compartilhado em toda a empresa; está disponível para todos os desenvolvedores que são incentivados a usar esse conhecimento para resolver problemas e inventar novas oportunidades para produtos específicos. "Não temos uma organização dedicada, o Templo MO, na Apple", diz Craig Federigi. "Estamos tentando manter as informações mais próximas das equipes que as usam para criar a experiência certa para o usuário".Quantas pessoas na empresa estão trabalhando no MO? "Muito", diz Federigi, depois de pensar um pouco. (Se você pensou que ele iria me dizer a quantidade exata, você não conhece a Apple). É interessante que as pessoas que não eram especialistas nesse assunto antes de ingressar na empresa também estejam desenvolvendo na Apple. "Contratamos pessoas versadas em matemática, estatística, programação, criptografia", diz Federigi. - Acontece que muitos desses talentos são perfeitamente transformados em MO. Embora hoje, é claro, contratemos especialistas na região de Moscou, também levamos pessoas com as inclinações e talentos necessários. ”

"Nos últimos cinco anos, temos observado o crescimento dessa área na empresa", diz Phil Schiller. "Nossos dispositivos estão ficando mais inteligentes e mais rápidos e mais rápidos, especialmente com o uso dos chips da série A que desenvolvemos. O back-end está ficando mais inteligente, mais rápido e tudo o que fazemos é conectado entre si." Isso nos permite usar cada vez mais técnicas de MO, porque muito precisa ser aprendido, mas já está disponível para nós. ”E embora a Apple esteja lutando para usar o MO ao máximo, os diretores enfatizam que esse processo não é nada de especial. Os chefes de Cupertin veem no aprendizado profundo e o MO apenas outra tecnologia de um fluxo de tecnologias inovadoras sucessivas. Sim, sim, está mudando o mundo, mas não mais do que outros avanços, como telas sensíveis ao toque, telas planas ou OOP. Do ponto de vista da Apple, a MO não é a última fronteira, apesar da opinião de outras empresas. "Afinal, não se pode dizer que, nos últimos anos, não houve outras tecnologias críticas para mudar os princípios de nossa interação com os dispositivos", diz Kew. E ninguém na empresa quer chegar perto de discutir tópicos assustadores que invariavelmente surgem ao mencionar a IA. E, como seria de esperar, a Apple não confirma se está trabalhando em veículos robóticos ou em sua versão do Netflix.Mas a equipe indicou claramente que a Apple não está trabalhando na Skynet."Usamos essas tecnologias para o que desejamos há muito tempo e com melhor qualidade do que era possível antes", diz Schiller. - E por coisas novas que não poderíamos fazer. Essa tecnologia se tornará um método da Apple para atingir metas à medida que evolui dentro da empresa e devido à forma como fabricamos nossos produtos. ”Mas durante o briefing, fica claro como a IA mudou bastante os métodos de uso do ecossistema da Apple. Os especialistas em IA acreditam que a Apple é limitada, pois não possui seu próprio mecanismo de pesquisa (que poderia fornecer dados para o treinamento de redes neurais) e sua convicção inflexível da necessidade de proteger as informações do usuário (dados que de outra forma poderiam ser usados). Mas acontece que a Apple já descobriu como superar esses dois obstáculos.E qual é o tamanho desse cérebro, um cache dinâmico que fornece MO no iPhone? Fiquei surpreso ao receber essa pergunta. Seu tamanho é de cerca de 200 MB, dependendo da quantidade de informações pessoais armazenadas (os dados antigos são sempre excluídos). Isso inclui informações sobre o uso de aplicativos, interação com pessoas, processamento de redes neurais, geração de voz e "modelagem de eventos em linguagem natural". Ele também contém dados usados para redes neurais que trabalham com reconhecimento de padrões, rostos e classificação de cenas.E, de acordo com a Apple, tudo isso é feito de forma que suas configurações, preferências e movimentos permaneçam privados.E, embora eles não tenham me explicado tudo sobre o uso da IA na empresa, consegui descobrir como a empresa espalha a experiência no MO entre os funcionários da organização. O talento da região de Moscou é compartilhado em toda a empresa; está disponível para todos os desenvolvedores que são incentivados a usar esse conhecimento para resolver problemas e inventar novas oportunidades para produtos específicos. "Não temos uma organização dedicada, o Templo MO, na Apple", diz Craig Federigi. "Estamos tentando manter as informações mais próximas das equipes que as usam para criar a experiência certa para o usuário".Quantas pessoas na empresa estão trabalhando no MO? "Muito", diz Federigi, depois de pensar um pouco. (Se você pensou que ele iria me dizer a quantidade exata, você não conhece a Apple). É interessante que as pessoas que não eram especialistas nesse assunto antes de ingressar na empresa também estejam desenvolvendo na Apple. "Contratamos pessoas versadas em matemática, estatística, programação, criptografia", diz Federigi. - Acontece que muitos desses talentos são perfeitamente transformados em MO. Embora hoje, é claro, contratemos especialistas na região de Moscou, também levamos pessoas com as inclinações e talentos necessários. ” Craig Federigi, vice-presidente sênior de desenvolvimento de software, ouve Alex Acero, diretor sênior da SiriEmbora Federigi não diga isso, essa abordagem pode ser necessária: a propensão da empresa ao sigilo pode colocá-la em desvantagem em comparação com os concorrentes que incentivam seus melhores programadores a divulgar os resultados da pesquisa. "Nossos métodos aumentam a dispersão da seleção natural - aqueles que precisam de trabalho em equipe e o lançamento de excelentes produtos, sobretudo contra aqueles que mais precisam publicar", diz Federigi. Se os pesquisadores fizerem um avanço no campo enquanto aprimoram os produtos da Apple, isso é bom. "Mas para nós, o resultado final será o principal", diz Kew.Algumas pessoas talentosas entram na empresa após a aquisição. "Recentemente, compramos 20 a 30 pequenas empresas por ano, estamos contratando mão de obra", diz Kew. Quando a Apple compra uma empresa que trabalha com inteligência artificial, isso não acontece porque "há uma multidão de pesquisadores de MO aqui, vamos obter um estábulo deles", diz Federigi. "Procuramos pessoas talentosas, mas focadas em criar uma ótima experiência para o usuário".A aquisição mais recente é a Turi, uma empresa sediada em Seattle que a Apple comprou por US $ 200 milhões. Eles construíram um kit de ferramentas para MOs comparável ao TensorFlow do Google, e essa aquisição levou a rumores de que a Apple usaria essa tecnologia para fins semelhantes, tanto para si quanto para desenvolvedores. Os diretores não confirmam ou negam essas informações. "Alguns de seus resultados combinaram muito bem com a Apple, tanto em termos de tecnologia quanto de pessoas", diz Kew. Em alguns anos, provavelmente descobriremos o que aconteceu, como foi quando a Siri começou a demonstrar os recursos preditivos do Cue (não relacionado a Eddie), o produto da startup com o mesmo nome que a Apple comprou em 2013.Independentemente da origem do talento, a infraestrutura de IA da Apple permite o desenvolvimento de produtos e recursos que não seriam possíveis de outra maneira. Ela está mudando o programa de desenvolvimento de produtos da empresa. "Não há fim na lista de ideias interessantes da Apple", diz Schiller. - MO nos permite recorrer a coisas que no passado não tocávamos. Ele se funde no processo de tomada de decisão sobre produtos com os quais lidaremos no futuro. ”Um exemplo é o Apple Pencil, que funciona com o Apple Pencil. Para que essa caneta de alta tecnologia funcionasse, a empresa teve que resolver o problema - quando as pessoas escrevem na tela, a parte inferior da palma da mão passa pela tela sensível ao toque, o que leva ao aparecimento de cliques espúrios. Usando o modelo MO para eliminar esses toques, a empresa conseguiu ensinar a tela a distinguir rolagem, toque e entrada da caneta. “Se isso não funcionar 100%, este papel de gravação não é adequado para mim e o Lápis é um produto ruim”, diz Federigi. Se você gosta de Pencil, agradeça a MO por isso.Talvez a melhor medida do progresso da MO em uma empresa seja sua compra mais importante, a Siri. Ele se origina no ambicioso programa DARPA para o desenvolvimento de assistentes inteligentes, após o qual vários cientistas fundaram a empresa para criar um aplicativo usando essa tecnologia. Steve Jobs pessoalmente convenceu os fundadores da empresa a vender a Apple em 2010 e insistiu que o Siri fosse integrado ao sistema operacional. Seu lançamento foi um dos destaques da apresentação do iPhone 4S em outubro de 2011. Agora está funcionando não apenas quando o usuário mantém o botão home ou murmura “Hey Siri” (o próprio MO também usa esse recurso, permitindo que o iPhone ouça éter, sem colocar muita bateria). A inteligência da Siri está embutida no Apple Brain e funciona mesmo quando não diz nada.Kew descreve os quatro componentes de um produto principal: reconhecimento de fala, entendimento da linguagem natural, execução de comandos e recall. "O MoE afetou todas essas áreas com muita força", diz ele.

Craig Federigi, vice-presidente sênior de desenvolvimento de software, ouve Alex Acero, diretor sênior da SiriEmbora Federigi não diga isso, essa abordagem pode ser necessária: a propensão da empresa ao sigilo pode colocá-la em desvantagem em comparação com os concorrentes que incentivam seus melhores programadores a divulgar os resultados da pesquisa. "Nossos métodos aumentam a dispersão da seleção natural - aqueles que precisam de trabalho em equipe e o lançamento de excelentes produtos, sobretudo contra aqueles que mais precisam publicar", diz Federigi. Se os pesquisadores fizerem um avanço no campo enquanto aprimoram os produtos da Apple, isso é bom. "Mas para nós, o resultado final será o principal", diz Kew.Algumas pessoas talentosas entram na empresa após a aquisição. "Recentemente, compramos 20 a 30 pequenas empresas por ano, estamos contratando mão de obra", diz Kew. Quando a Apple compra uma empresa que trabalha com inteligência artificial, isso não acontece porque "há uma multidão de pesquisadores de MO aqui, vamos obter um estábulo deles", diz Federigi. "Procuramos pessoas talentosas, mas focadas em criar uma ótima experiência para o usuário".A aquisição mais recente é a Turi, uma empresa sediada em Seattle que a Apple comprou por US $ 200 milhões. Eles construíram um kit de ferramentas para MOs comparável ao TensorFlow do Google, e essa aquisição levou a rumores de que a Apple usaria essa tecnologia para fins semelhantes, tanto para si quanto para desenvolvedores. Os diretores não confirmam ou negam essas informações. "Alguns de seus resultados combinaram muito bem com a Apple, tanto em termos de tecnologia quanto de pessoas", diz Kew. Em alguns anos, provavelmente descobriremos o que aconteceu, como foi quando a Siri começou a demonstrar os recursos preditivos do Cue (não relacionado a Eddie), o produto da startup com o mesmo nome que a Apple comprou em 2013.Independentemente da origem do talento, a infraestrutura de IA da Apple permite o desenvolvimento de produtos e recursos que não seriam possíveis de outra maneira. Ela está mudando o programa de desenvolvimento de produtos da empresa. "Não há fim na lista de ideias interessantes da Apple", diz Schiller. - MO nos permite recorrer a coisas que no passado não tocávamos. Ele se funde no processo de tomada de decisão sobre produtos com os quais lidaremos no futuro. ”Um exemplo é o Apple Pencil, que funciona com o Apple Pencil. Para que essa caneta de alta tecnologia funcionasse, a empresa teve que resolver o problema - quando as pessoas escrevem na tela, a parte inferior da palma da mão passa pela tela sensível ao toque, o que leva ao aparecimento de cliques espúrios. Usando o modelo MO para eliminar esses toques, a empresa conseguiu ensinar a tela a distinguir rolagem, toque e entrada da caneta. “Se isso não funcionar 100%, este papel de gravação não é adequado para mim e o Lápis é um produto ruim”, diz Federigi. Se você gosta de Pencil, agradeça a MO por isso.Talvez a melhor medida do progresso da MO em uma empresa seja sua compra mais importante, a Siri. Ele se origina no ambicioso programa DARPA para o desenvolvimento de assistentes inteligentes, após o qual vários cientistas fundaram a empresa para criar um aplicativo usando essa tecnologia. Steve Jobs pessoalmente convenceu os fundadores da empresa a vender a Apple em 2010 e insistiu que o Siri fosse integrado ao sistema operacional. Seu lançamento foi um dos destaques da apresentação do iPhone 4S em outubro de 2011. Agora está funcionando não apenas quando o usuário mantém o botão home ou murmura “Hey Siri” (o próprio MO também usa esse recurso, permitindo que o iPhone ouça éter, sem colocar muita bateria). A inteligência da Siri está embutida no Apple Brain e funciona mesmo quando não diz nada.Kew descreve os quatro componentes de um produto principal: reconhecimento de fala, entendimento da linguagem natural, execução de comandos e recall. "O MoE afetou todas essas áreas com muita força", diz ele. Chefe de Engenharia Avançada Tom Gruber e Siri Guru, Alex AceroA Siri está envolvida no chefe do departamento de desenvolvimento avançado Tom Grubber, que chegou à Apple junto com a principal aquisição (os co-fundadores da empresa deixaram a Apple em 2011). Ele diz que, mesmo antes de as redes neurais serem aplicadas à Siri, elas recebiam uma quantidade enorme de dados vindos da base de usuários. No futuro, esses dados serviram como a chave para o treinamento de redes neurais. "Steve disse que passaremos de um aplicativo piloto para centenas de milhões de pessoas em uma noite, sem testes beta", diz ele. - De repente teremos usuários. Disseram-nos como as pessoas chamariam coisas relacionadas ao nosso aplicativo. Esta foi a primeira revolução. E então redes neurais apareceram. ”A transição da Siri para redes neurais que processam o reconhecimento de fala coincidiu com a chegada de vários especialistas em IA, incluindo Alex Acero, agora chefe da equipe de tecnologia da fala. Acero iniciou sua carreira em reconhecimento de fala na Apple no início dos anos 90 e depois passou muitos anos na Microsoft Research. "Gostei muito de trabalhar lá, publiquei muito trabalho", diz ele. "Mas quando o Siri apareceu, eu disse: 'Esta é uma chance de tornar realidade as redes neurais profundas, de trazê-las de um estado em que cem pessoas leem sobre elas, para um estado em que milhões as usam". Em outras palavras, pertencia exatamente ao tipo de cientistas que a Apple procurava - colocando o produto acima das publicações.Quando a Acero entrou na empresa há três anos, a Apple ainda estava no processo de obtenção de licenças para a maioria das tecnologias de fala da Siri de fabricantes terceirizados, e essa situação deve mudar em breve. Federigi observa que a Apple está constantemente trabalhando nesse padrão. “Quando fica claro que o campo tecnológico é necessário para nossa capacidade de lançar um novo produto ao longo do tempo, aumentamos nossa capacidade interna de produzir o que queremos. Para tornar um produto excelente, precisamos ser totalmente proficientes em tecnologia e inovar internamente. A fala é um ótimo exemplo de como usamos as oportunidades disponíveis externamente para dar início ao projeto. ”A equipe começou a treinar a rede neural para substituir o Siri original. "Tivemos a fazenda de GPU mais legal, trabalhando o tempo todo", diz Acero. "E colocamos um monte de dados nele". A versão de julho de 2014 provou que todo esse tempo do processador não foi desperdiçado."O número de erros caiu pela metade em todos os idiomas e, em alguns casos, até mais", diz Acero. "Principalmente graças ao aprendizado profundo e à nossa otimização - não apenas o algoritmo em si, mas de acordo com o contexto de seu trabalho no produto final."A menção do produto final não é acidental. A Apple não é a primeira a usar o treinamento em rede neural profunda no reconhecimento de fala. Mas a Apple alega ter a vantagem de controlar todo o sistema de desenvolvimento e entrega de produtos. Como a Apple fabrica os chips, Acero teve a oportunidade de trabalhar com sua equipe de desenvolvimento e engenheiros que criaram firmware para dispositivos para maximizar o desempenho das redes neurais. As necessidades da equipe de desenvolvimento da Siri até influenciaram o design do iPhone."Não é apenas silício", acrescenta Federigi. - O número de microfones no dispositivo, onde estão localizados. Como configuramos hardware e microfones, e um conjunto de software que processa o som. A interação das partes é importante. Essa é uma enorme vantagem sobre quem simplesmente escreveu um software e vê o que ele faz. ”Outra vantagem: quando uma rede neural funciona em um produto, ela pode ser adaptada como base da tecnologia para outros fins. O MO, ajudando a Siri a entendê-lo, se transforma em um mecanismo de gravação de ditados. Como resultado do trabalho da Siri, as pessoas descobrem que seus e-mails e mensagens terão mais significado se abandonarem o teclado na tela, clicarem no ícone do microfone e falarem em voz alta.O segundo componente do Siri, mencionado por Kew, é o entendimento da linguagem natural. A Siri começou a usar o MO para entender as intenções do usuário em novembro de 2014 e lançou uma versão de aprendizado profundo um ano depois. E, como no reconhecimento de fala, o MO melhorou a experiência do usuário - especialmente em termos de uma interpretação mais flexível dos comandos. Por exemplo, Kew pega um iPhone e liga para a Siri. "Envie a Jane vinte dólares através da Square Cash", diz ele. Uma mensagem aparece na tela com uma descrição de sua solicitação. Então ele tenta definir a tarefa de uma maneira diferente: "jogue vinte da minha esposa". O resultado é o mesmo.A Apple alega que, sem essas melhorias no Siri, seria improvável que a versão atual do Apple TV, com controle de voz sofisticado, fosse possível. As versões anteriores do Siri faziam você falar de forma clara e separada, a versão MO cobrada não apenas oferece opções específicas de um enorme catálogo de filmes e músicas, mas também entende os conceitos. "Mostre-me um bom suspense com Tom Hanks." (Se a Siri fosse realmente inteligente, ela teria excluído o Código Da Vinci). "Essa oportunidade antes do advento dessa tecnologia não poderia ter sido fornecida", diz Federigi.O iOS 10 está programado para ser lançado neste outono e a voz da Siri será o último dos quatro componentes transformados pelo MO. As redes neurais profundas substituíram as implementações anteriores feitas sob licença. De fato, as réplicas da Siri são selecionadas no banco de dados de registros coletados no centro de voz e cada sentença é coletada em partes. De acordo com Grubber, o aprendizado de máquina suaviza os cantos e faz com que a Siri pareça mais uma pessoa real.A Acero realiza uma demonstração - a primeira voz familiar da Siri, com notas semelhantes a robôs aos quais estamos acostumados. Depois, um novo, dizendo "Olá, como posso ajudá-lo?", Com uma fluidez cativante. Qual a diferença? "Aprendizagem profunda, bebê", diz ele.Parece um bom detalhe, mas uma voz mais natural pode levar a grandes mudanças. "As pessoas confiam em uma voz melhor melhor", diz Grubber. - A melhor voz atrai o usuário e o encoraja a usar com mais frequência. O efeito de retorno está aumentando. ”O desejo de usar o Siri, e todas as melhorias feitas graças ao MO, estão se tornando ainda mais importantes, porque a Apple finalmente abre o Siri para desenvolvedores de terceiros - e os críticos da empresa acreditam que era hora de fazer isso há muito tempo. Muitos observaram que a Apple, cujas dezenas de parceiros Siri, está atrás de sistemas como o Alexa da Amazon, ostentando milhares de recursos fornecidos por desenvolvedores de terceiros. A Apple diz que compará-los está incorreta porque os usuários da Amazon precisam expressar seus desejos em um idioma especial. A Siri incluirá, naturalmente, coisas como SquareCash ou Uber. (Outro concorrente, Viv - criado por outros co-fundadores da Siri - também promete integração com serviços de terceiros quando a data de lançamento ainda não foi anunciada).Talvez o maior desafio para o desenvolvimento do MO seja conseguir, se necessário, aderir aos princípios de privacidade do usuário. A empresa criptografa seus dados, para que ninguém, nem os advogados da Apple, possam lê-los (até o FBI, mesmo com um mandado). E a empresa se orgulha de não coletar dados do usuário para fins publicitários.Embora essa austeridade seja louvável do ponto de vista dos usuários, não ajuda a atrair os melhores talentos de IA para a empresa. "Especialistas em MO precisam de dados", disse um ex-funcionário da Apple que trabalha para uma empresa especializada em IA. "Mas em uma posição de privacidade, a Apple o obriga a trabalhar com uma mão só." Você pode argumentar se isso é certo ou errado, mas, como resultado, a Apple não tem uma reputação de especialistas em IA muito legais. ”Existem dois problemas. O primeiro é o processamento de informações pessoais em sistemas baseados em MO. Quando os dados pessoais de um usuário passam por um processo de processamento de rede neural, o que acontece com essas informações? O segundo problema envolve a coleta das informações necessárias para treinar redes neurais para reconhecer o comportamento. Como isso pode ser feito sem coletar informações pessoais do usuário?A Apple acredita que tem soluções. "Algumas pessoas pensam que não podemos fazer isso com a IA porque não temos dados", diz Kew. "Mas encontramos maneiras de obter os dados de que precisamos, mantendo a privacidade". Assim.A Apple resolve o primeiro problema, aproveitando a capacidade de controlar software e hardware. As informações mais pessoais permanecem dentro do Apple Brain. "Armazenamos as coisas mais sensíveis em que o MO acontece localmente em relação ao dispositivo", diz Federigi. Como exemplo, ele fornece previsões de aplicativos a serem executados, ícones que aparecem ao deslizar a tela para a direita. Essas previsões são baseadas em muitos fatores, alguns dos quais dependem apenas do seu comportamento. E eles funcionam - Federigi diz que 90% das vezes as pessoas encontram o que precisam nessas previsões. Todos os cálculos realizados pela Apple diretamente no telefone.Além disso, o dispositivo armazena, possivelmente, as informações mais pessoais recebidas pela empresa: palavras usadas por pessoas no teclado do iPhone QuickType. Usando um sistema de treinamento de rede neural que monitora sua entrada, a Apple pode reconhecer eventos e momentos importantes, como informações sobre viagens aéreas, contatos, reuniões - mas as informações em si permanecem no seu telefone. Mesmo em backups armazenados na nuvem, ele é diluído de tal maneira que você não pode obtê-lo com apenas uma cópia de backup. "Não queremos que essas informações sejam armazenadas em nossos servidores", diz Federigi. "A Apple não precisa conhecer seus hábitos, nem onde e quando você vai."A Apple está tentando minimizar as informações armazenadas. Federigi deu um exemplo no qual você pode ter uma conversa e alguém mencionará um termo adequado para pesquisa. Outras empresas poderiam analisar toda a conversa na nuvem para encontrar esses termos, mas o dispositivo Apple pode reconhecê-los para que os dados não saiam do usuário - porque o sistema está constantemente procurando correspondências na base de conhecimento armazenada no telefone (faz parte de 200 MB "Cérebro").“A base é compacta, mas abrangente, com centenas de milhares de locais e objetos. Nós localizamos porque sabemos onde você está ”, diz Federigi. Todos os aplicativos da Apple acessam o banco de dados, incluindo o mecanismo de pesquisa Spotlight, Maps e Safari. Ajuda a corrigir erros automaticamente. "E funciona constantemente em segundo plano", diz ele.A partir do iOS 10, a Apple utilizará a nova tecnologia de privacidade diferenciada, que permite informações de crowdsourcing para que não possa identificar indivíduos. Podem ser palavras que ganharam popularidade que não estão no banco de dados, links que oferecem respostas mais relevantes para consultas ou uma maneira de usar determinados emojis. "Normalmente, no setor, é habitual enviar todas as palavras e símbolos que você digita para os servidores da empresa, para que eles se aprofundem neles e notem algo interessante", diz Federigi. "Criptografamos informações de e para, para não o fazermos." Embora a privacidade diferenciada tenha se originado na comunidade de pesquisa, a Apple está tentando apresentá-la às massas. "Estamos transferindo do departamento de pesquisa para um bilhão de usuários", diz Kew.E, embora esteja claro que a MO mudou os produtos da Apple, ainda não está claro se ela mudou a própria empresa. Em certo sentido, a abordagem usando MO está em conflito com o espírito da empresa. A Apple monitora cuidadosamente a experiência do usuário, até sensores que medem a condutividade na tela. Tudo é planejado com antecedência e codificado com precisão. Porém, ao usar o MO, os engenheiros precisam dar um passo atrás e dar ao software a oportunidade de procurar soluções por conta própria. A Apple pode se adaptar à realidade moderna, em que sistemas com MO podem participar do design do produto?"Esta é a causa de muita controvérsia na empresa", diz Federigi. - Estamos acostumados a oferecer uma experiência muito ponderada e controlada, na qual controlamos todas as dimensões de como o sistema se comunica com o usuário. Quando você começa a treinar um sistema com base em um grande conjunto de dados sobre o comportamento humano, os resultados obtidos podem não coincidir com a ideia do designer. Eles aparecem com base em dados. ”Mas a Apple não vai recuar, diz Schiller. "Embora essas tecnologias, é claro, influenciem o desenvolvimento de produtos, no final, as usamos para produzir produtos melhores".Como resultado, a Apple pode não fazer anúncios de cabeçalho sobre a imersão no MO, mas usará o máximo de MO possível para melhorar os produtos. O cérebro do seu telefone prova isso."Um usuário típico experimenta aprendizado profundo diariamente, e isso ilustra o que você gosta nos produtos Apple", diz Schiller. "Os momentos mais legais são tão sutis que você só pensa neles depois de um terceiro encontro com eles e depois para e exclama: 'Como isso é possível?"Skynet vai esperar.

Chefe de Engenharia Avançada Tom Gruber e Siri Guru, Alex AceroA Siri está envolvida no chefe do departamento de desenvolvimento avançado Tom Grubber, que chegou à Apple junto com a principal aquisição (os co-fundadores da empresa deixaram a Apple em 2011). Ele diz que, mesmo antes de as redes neurais serem aplicadas à Siri, elas recebiam uma quantidade enorme de dados vindos da base de usuários. No futuro, esses dados serviram como a chave para o treinamento de redes neurais. "Steve disse que passaremos de um aplicativo piloto para centenas de milhões de pessoas em uma noite, sem testes beta", diz ele. - De repente teremos usuários. Disseram-nos como as pessoas chamariam coisas relacionadas ao nosso aplicativo. Esta foi a primeira revolução. E então redes neurais apareceram. ”A transição da Siri para redes neurais que processam o reconhecimento de fala coincidiu com a chegada de vários especialistas em IA, incluindo Alex Acero, agora chefe da equipe de tecnologia da fala. Acero iniciou sua carreira em reconhecimento de fala na Apple no início dos anos 90 e depois passou muitos anos na Microsoft Research. "Gostei muito de trabalhar lá, publiquei muito trabalho", diz ele. "Mas quando o Siri apareceu, eu disse: 'Esta é uma chance de tornar realidade as redes neurais profundas, de trazê-las de um estado em que cem pessoas leem sobre elas, para um estado em que milhões as usam". Em outras palavras, pertencia exatamente ao tipo de cientistas que a Apple procurava - colocando o produto acima das publicações.Quando a Acero entrou na empresa há três anos, a Apple ainda estava no processo de obtenção de licenças para a maioria das tecnologias de fala da Siri de fabricantes terceirizados, e essa situação deve mudar em breve. Federigi observa que a Apple está constantemente trabalhando nesse padrão. “Quando fica claro que o campo tecnológico é necessário para nossa capacidade de lançar um novo produto ao longo do tempo, aumentamos nossa capacidade interna de produzir o que queremos. Para tornar um produto excelente, precisamos ser totalmente proficientes em tecnologia e inovar internamente. A fala é um ótimo exemplo de como usamos as oportunidades disponíveis externamente para dar início ao projeto. ”A equipe começou a treinar a rede neural para substituir o Siri original. "Tivemos a fazenda de GPU mais legal, trabalhando o tempo todo", diz Acero. "E colocamos um monte de dados nele". A versão de julho de 2014 provou que todo esse tempo do processador não foi desperdiçado."O número de erros caiu pela metade em todos os idiomas e, em alguns casos, até mais", diz Acero. "Principalmente graças ao aprendizado profundo e à nossa otimização - não apenas o algoritmo em si, mas de acordo com o contexto de seu trabalho no produto final."A menção do produto final não é acidental. A Apple não é a primeira a usar o treinamento em rede neural profunda no reconhecimento de fala. Mas a Apple alega ter a vantagem de controlar todo o sistema de desenvolvimento e entrega de produtos. Como a Apple fabrica os chips, Acero teve a oportunidade de trabalhar com sua equipe de desenvolvimento e engenheiros que criaram firmware para dispositivos para maximizar o desempenho das redes neurais. As necessidades da equipe de desenvolvimento da Siri até influenciaram o design do iPhone."Não é apenas silício", acrescenta Federigi. - O número de microfones no dispositivo, onde estão localizados. Como configuramos hardware e microfones, e um conjunto de software que processa o som. A interação das partes é importante. Essa é uma enorme vantagem sobre quem simplesmente escreveu um software e vê o que ele faz. ”Outra vantagem: quando uma rede neural funciona em um produto, ela pode ser adaptada como base da tecnologia para outros fins. O MO, ajudando a Siri a entendê-lo, se transforma em um mecanismo de gravação de ditados. Como resultado do trabalho da Siri, as pessoas descobrem que seus e-mails e mensagens terão mais significado se abandonarem o teclado na tela, clicarem no ícone do microfone e falarem em voz alta.O segundo componente do Siri, mencionado por Kew, é o entendimento da linguagem natural. A Siri começou a usar o MO para entender as intenções do usuário em novembro de 2014 e lançou uma versão de aprendizado profundo um ano depois. E, como no reconhecimento de fala, o MO melhorou a experiência do usuário - especialmente em termos de uma interpretação mais flexível dos comandos. Por exemplo, Kew pega um iPhone e liga para a Siri. "Envie a Jane vinte dólares através da Square Cash", diz ele. Uma mensagem aparece na tela com uma descrição de sua solicitação. Então ele tenta definir a tarefa de uma maneira diferente: "jogue vinte da minha esposa". O resultado é o mesmo.A Apple alega que, sem essas melhorias no Siri, seria improvável que a versão atual do Apple TV, com controle de voz sofisticado, fosse possível. As versões anteriores do Siri faziam você falar de forma clara e separada, a versão MO cobrada não apenas oferece opções específicas de um enorme catálogo de filmes e músicas, mas também entende os conceitos. "Mostre-me um bom suspense com Tom Hanks." (Se a Siri fosse realmente inteligente, ela teria excluído o Código Da Vinci). "Essa oportunidade antes do advento dessa tecnologia não poderia ter sido fornecida", diz Federigi.O iOS 10 está programado para ser lançado neste outono e a voz da Siri será o último dos quatro componentes transformados pelo MO. As redes neurais profundas substituíram as implementações anteriores feitas sob licença. De fato, as réplicas da Siri são selecionadas no banco de dados de registros coletados no centro de voz e cada sentença é coletada em partes. De acordo com Grubber, o aprendizado de máquina suaviza os cantos e faz com que a Siri pareça mais uma pessoa real.A Acero realiza uma demonstração - a primeira voz familiar da Siri, com notas semelhantes a robôs aos quais estamos acostumados. Depois, um novo, dizendo "Olá, como posso ajudá-lo?", Com uma fluidez cativante. Qual a diferença? "Aprendizagem profunda, bebê", diz ele.Parece um bom detalhe, mas uma voz mais natural pode levar a grandes mudanças. "As pessoas confiam em uma voz melhor melhor", diz Grubber. - A melhor voz atrai o usuário e o encoraja a usar com mais frequência. O efeito de retorno está aumentando. ”O desejo de usar o Siri, e todas as melhorias feitas graças ao MO, estão se tornando ainda mais importantes, porque a Apple finalmente abre o Siri para desenvolvedores de terceiros - e os críticos da empresa acreditam que era hora de fazer isso há muito tempo. Muitos observaram que a Apple, cujas dezenas de parceiros Siri, está atrás de sistemas como o Alexa da Amazon, ostentando milhares de recursos fornecidos por desenvolvedores de terceiros. A Apple diz que compará-los está incorreta porque os usuários da Amazon precisam expressar seus desejos em um idioma especial. A Siri incluirá, naturalmente, coisas como SquareCash ou Uber. (Outro concorrente, Viv - criado por outros co-fundadores da Siri - também promete integração com serviços de terceiros quando a data de lançamento ainda não foi anunciada).Talvez o maior desafio para o desenvolvimento do MO seja conseguir, se necessário, aderir aos princípios de privacidade do usuário. A empresa criptografa seus dados, para que ninguém, nem os advogados da Apple, possam lê-los (até o FBI, mesmo com um mandado). E a empresa se orgulha de não coletar dados do usuário para fins publicitários.Embora essa austeridade seja louvável do ponto de vista dos usuários, não ajuda a atrair os melhores talentos de IA para a empresa. "Especialistas em MO precisam de dados", disse um ex-funcionário da Apple que trabalha para uma empresa especializada em IA. "Mas em uma posição de privacidade, a Apple o obriga a trabalhar com uma mão só." Você pode argumentar se isso é certo ou errado, mas, como resultado, a Apple não tem uma reputação de especialistas em IA muito legais. ”Existem dois problemas. O primeiro é o processamento de informações pessoais em sistemas baseados em MO. Quando os dados pessoais de um usuário passam por um processo de processamento de rede neural, o que acontece com essas informações? O segundo problema envolve a coleta das informações necessárias para treinar redes neurais para reconhecer o comportamento. Como isso pode ser feito sem coletar informações pessoais do usuário?A Apple acredita que tem soluções. "Algumas pessoas pensam que não podemos fazer isso com a IA porque não temos dados", diz Kew. "Mas encontramos maneiras de obter os dados de que precisamos, mantendo a privacidade". Assim.A Apple resolve o primeiro problema, aproveitando a capacidade de controlar software e hardware. As informações mais pessoais permanecem dentro do Apple Brain. "Armazenamos as coisas mais sensíveis em que o MO acontece localmente em relação ao dispositivo", diz Federigi. Como exemplo, ele fornece previsões de aplicativos a serem executados, ícones que aparecem ao deslizar a tela para a direita. Essas previsões são baseadas em muitos fatores, alguns dos quais dependem apenas do seu comportamento. E eles funcionam - Federigi diz que 90% das vezes as pessoas encontram o que precisam nessas previsões. Todos os cálculos realizados pela Apple diretamente no telefone.Além disso, o dispositivo armazena, possivelmente, as informações mais pessoais recebidas pela empresa: palavras usadas por pessoas no teclado do iPhone QuickType. Usando um sistema de treinamento de rede neural que monitora sua entrada, a Apple pode reconhecer eventos e momentos importantes, como informações sobre viagens aéreas, contatos, reuniões - mas as informações em si permanecem no seu telefone. Mesmo em backups armazenados na nuvem, ele é diluído de tal maneira que você não pode obtê-lo com apenas uma cópia de backup. "Não queremos que essas informações sejam armazenadas em nossos servidores", diz Federigi. "A Apple não precisa conhecer seus hábitos, nem onde e quando você vai."A Apple está tentando minimizar as informações armazenadas. Federigi deu um exemplo no qual você pode ter uma conversa e alguém mencionará um termo adequado para pesquisa. Outras empresas poderiam analisar toda a conversa na nuvem para encontrar esses termos, mas o dispositivo Apple pode reconhecê-los para que os dados não saiam do usuário - porque o sistema está constantemente procurando correspondências na base de conhecimento armazenada no telefone (faz parte de 200 MB "Cérebro").“A base é compacta, mas abrangente, com centenas de milhares de locais e objetos. Nós localizamos porque sabemos onde você está ”, diz Federigi. Todos os aplicativos da Apple acessam o banco de dados, incluindo o mecanismo de pesquisa Spotlight, Maps e Safari. Ajuda a corrigir erros automaticamente. "E funciona constantemente em segundo plano", diz ele.A partir do iOS 10, a Apple utilizará a nova tecnologia de privacidade diferenciada, que permite informações de crowdsourcing para que não possa identificar indivíduos. Podem ser palavras que ganharam popularidade que não estão no banco de dados, links que oferecem respostas mais relevantes para consultas ou uma maneira de usar determinados emojis. "Normalmente, no setor, é habitual enviar todas as palavras e símbolos que você digita para os servidores da empresa, para que eles se aprofundem neles e notem algo interessante", diz Federigi. "Criptografamos informações de e para, para não o fazermos." Embora a privacidade diferenciada tenha se originado na comunidade de pesquisa, a Apple está tentando apresentá-la às massas. "Estamos transferindo do departamento de pesquisa para um bilhão de usuários", diz Kew.E, embora esteja claro que a MO mudou os produtos da Apple, ainda não está claro se ela mudou a própria empresa. Em certo sentido, a abordagem usando MO está em conflito com o espírito da empresa. A Apple monitora cuidadosamente a experiência do usuário, até sensores que medem a condutividade na tela. Tudo é planejado com antecedência e codificado com precisão. Porém, ao usar o MO, os engenheiros precisam dar um passo atrás e dar ao software a oportunidade de procurar soluções por conta própria. A Apple pode se adaptar à realidade moderna, em que sistemas com MO podem participar do design do produto?"Esta é a causa de muita controvérsia na empresa", diz Federigi. - Estamos acostumados a oferecer uma experiência muito ponderada e controlada, na qual controlamos todas as dimensões de como o sistema se comunica com o usuário. Quando você começa a treinar um sistema com base em um grande conjunto de dados sobre o comportamento humano, os resultados obtidos podem não coincidir com a ideia do designer. Eles aparecem com base em dados. ”Mas a Apple não vai recuar, diz Schiller. "Embora essas tecnologias, é claro, influenciem o desenvolvimento de produtos, no final, as usamos para produzir produtos melhores".Como resultado, a Apple pode não fazer anúncios de cabeçalho sobre a imersão no MO, mas usará o máximo de MO possível para melhorar os produtos. O cérebro do seu telefone prova isso."Um usuário típico experimenta aprendizado profundo diariamente, e isso ilustra o que você gosta nos produtos Apple", diz Schiller. "Os momentos mais legais são tão sutis que você só pensa neles depois de um terceiro encontro com eles e depois para e exclama: 'Como isso é possível?"Skynet vai esperar.Source: https://habr.com/ru/post/pt397331/

All Articles