Obrigado pela memória: como a memória barata muda a computação

A DRAM do início da Micron com capacidade de 1 Mbit deRAM (memória de acesso aleatório, memória de acesso aleatório) está presente em qualquer sistema de computador, desde pequenos controladores integrados a servidores industriais. Os dados são armazenados na SRAM (RAM estática) ou DRAM (RAM dinâmica) enquanto o processador estiver trabalhando com eles. Com a queda nos preços da RAM, o modelo para mover dados entre a RAM e um local de armazenamento permanente pode desaparecer.A RAM é fortemente influenciada pelas flutuações do mercado, mas a longo prazo, seu valor diminui. Em 2000, um gigabyte de memória custa mais de US $ 1000 e agora custa apenas US $ 5. Isso nos permite imaginar uma arquitetura de sistema completamente diferente.Os bancos de dados geralmente são armazenados em discos, de onde as informações necessárias são lidas na memória, se necessário, e depois processadas. Geralmente, acredita-se que a quantidade de memória em um sistema é várias ordens de magnitude menor que o volume de discos - por exemplo, gigabytes versus terabytes. Porém, com o aumento da memória, torna-se mais eficiente carregar mais dados na memória, reduzindo o número de leituras e gravações. Com uma diminuição no custo da RAM, torna-se possível carregar o banco de dados inteiro na memória, executar operações neles e gravá-los novamente. Agora chegamos ao ponto em que alguns bancos de dados não são gravados no disco e permanecem constantemente na memória.

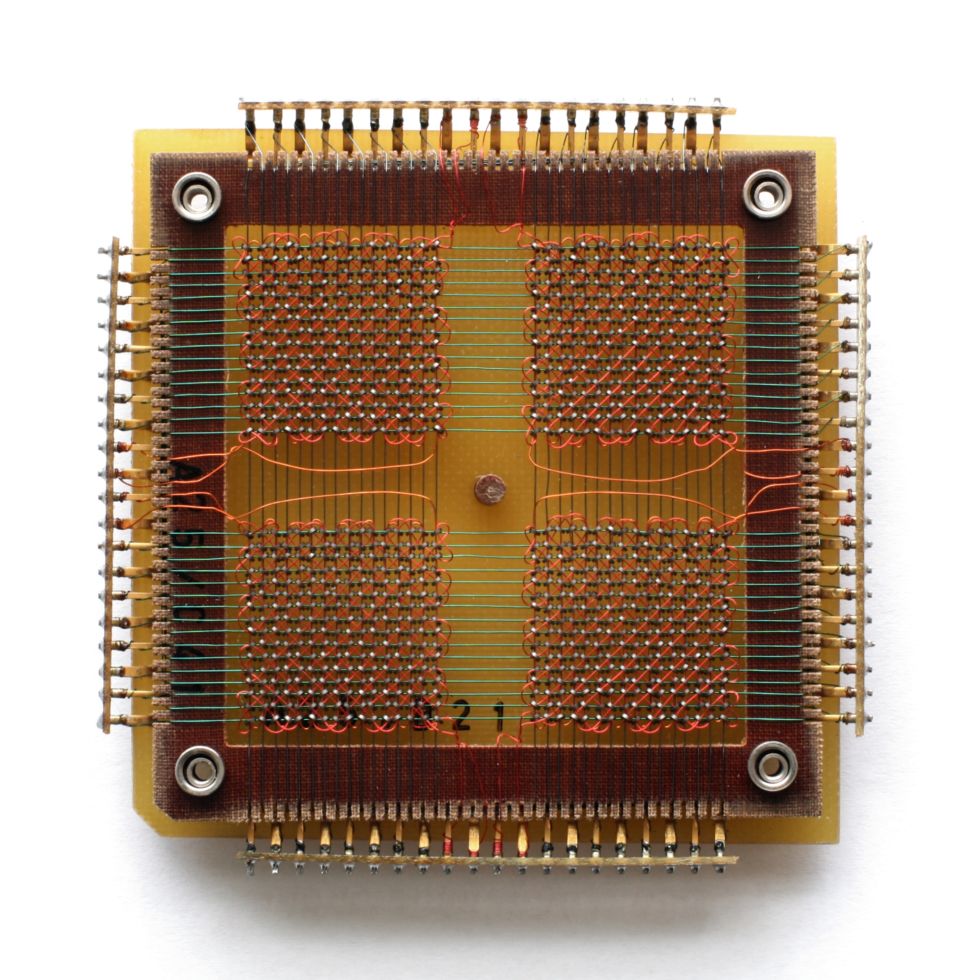

A DRAM do início da Micron com capacidade de 1 Mbit deRAM (memória de acesso aleatório, memória de acesso aleatório) está presente em qualquer sistema de computador, desde pequenos controladores integrados a servidores industriais. Os dados são armazenados na SRAM (RAM estática) ou DRAM (RAM dinâmica) enquanto o processador estiver trabalhando com eles. Com a queda nos preços da RAM, o modelo para mover dados entre a RAM e um local de armazenamento permanente pode desaparecer.A RAM é fortemente influenciada pelas flutuações do mercado, mas a longo prazo, seu valor diminui. Em 2000, um gigabyte de memória custa mais de US $ 1000 e agora custa apenas US $ 5. Isso nos permite imaginar uma arquitetura de sistema completamente diferente.Os bancos de dados geralmente são armazenados em discos, de onde as informações necessárias são lidas na memória, se necessário, e depois processadas. Geralmente, acredita-se que a quantidade de memória em um sistema é várias ordens de magnitude menor que o volume de discos - por exemplo, gigabytes versus terabytes. Porém, com o aumento da memória, torna-se mais eficiente carregar mais dados na memória, reduzindo o número de leituras e gravações. Com uma diminuição no custo da RAM, torna-se possível carregar o banco de dados inteiro na memória, executar operações neles e gravá-los novamente. Agora chegamos ao ponto em que alguns bancos de dados não são gravados no disco e permanecem constantemente na memória. chip de Megabit de Carl Zeiss

chip de Megabit de Carl Zeiss Até 1975, a RAM tem memória de núcleo

Até 1975, a RAM tem memória de núcleo chip de 4 megabits a EPROM, apagável utilizando luz ultravioleta dirigido pela janela

chip de 4 megabits a EPROM, apagável utilizando luz ultravioleta dirigido pela janela Um grupo de moderno DRAMvelocidade de acesso à memória é medida em nanossegundos, e os tempos de acesso ao disco são medidos em milissegundos - ou seja, , a memória é um milhão de vezes mais rápida. A velocidade de transferência de dados na memória, é claro, não é um milhão de vezes mais rápida - são gigabytes por segundo versus várias centenas de megabytes por segundo para hard hard - mas pelo menos a velocidade da RAM excede a velocidade das unidades em uma ordem de magnitude.No mundo real, as diferenças não são tão sérias, mas ler os dados de um disco na RAM e gravá-los novamente é um gargalo sério, além de ser um campo para que os erros apareçam. O desaparecimento desta etapa leva a uma simplificação das instruções, um aumento na simplicidade e eficiência.Com a queda nos preços da RAM em grandes empresas e data centers, tornou-se popular fornecer aos servidores terabytes de memória. Mas, além do tamanho, o banco de dados na memória geralmente não deseja ser mantido por razões de confiabilidade. A RAM perde o conteúdo quando uma falta de energia ou sistema é comprometido. Esses problemas são encontrados ao tentar cumprir o padrão de confiabilidade do banco de dados ACID (atomicidade, consistência, isolamento, durabilidade - atomicidade, coerência, isolamento, durabilidade).Problemas podem ser evitados com moldes e logs. Assim como você pode fazer backups de bancos de dados a partir de discos, os bancos de dados na memória podem ser copiados para o armazenamento. A criação de conversões impede que outros processos leiam dados; portanto, a frequência dos pontos de interrupção é um compromisso entre velocidade e confiabilidade. E isso, por sua vez, pode ser suavizado registrando transações ou registrando, gravando alterações de dados, para que um estado posterior possa ser recriado a partir de uma cópia anterior. Ainda assim, quando o banco de dados está completamente na memória, uma certa porcentagem de redundância é perdida.Os programas para gerenciar bancos de dados em memória (IMDBS) permitem criar sistemas híbridos nos quais algumas tabelas de banco de dados estão na memória e outras ficam em disco. Isso é melhor que o armazenamento em cache e é conveniente nos casos em que não faz sentido manter o banco de dados inteiro na memória.Os bancos de dados podem ser compactados, especialmente em sistemas com colunas que armazenam tabelas como conjuntos de colunas em vez de linhas. A maioria das tecnologias de compactação prefere que os dados vizinhos sejam do mesmo tipo, e as colunas nas tabelas quase sempre contêm dados do mesmo tipo. E embora a compactação envolva aumentar a carga na computação, o armazenamento de colunas é adequado para consultas complexas em conjuntos de dados muito grandes - é por isso que usuários e cientistas de big data estão interessados neles .Em larga escala, empresas como o Google mudaram para a RAM para que um grande número de consultas de pesquisa seja processado a uma velocidade aceitável. Também há problemas para fornecer acesso a grandes quantidades de memória, uma vez que a quantidade de RAM conectada a uma placa-mãe é limitada e a organização do acesso compartilhado gera atrasos adicionais.

Um grupo de moderno DRAMvelocidade de acesso à memória é medida em nanossegundos, e os tempos de acesso ao disco são medidos em milissegundos - ou seja, , a memória é um milhão de vezes mais rápida. A velocidade de transferência de dados na memória, é claro, não é um milhão de vezes mais rápida - são gigabytes por segundo versus várias centenas de megabytes por segundo para hard hard - mas pelo menos a velocidade da RAM excede a velocidade das unidades em uma ordem de magnitude.No mundo real, as diferenças não são tão sérias, mas ler os dados de um disco na RAM e gravá-los novamente é um gargalo sério, além de ser um campo para que os erros apareçam. O desaparecimento desta etapa leva a uma simplificação das instruções, um aumento na simplicidade e eficiência.Com a queda nos preços da RAM em grandes empresas e data centers, tornou-se popular fornecer aos servidores terabytes de memória. Mas, além do tamanho, o banco de dados na memória geralmente não deseja ser mantido por razões de confiabilidade. A RAM perde o conteúdo quando uma falta de energia ou sistema é comprometido. Esses problemas são encontrados ao tentar cumprir o padrão de confiabilidade do banco de dados ACID (atomicidade, consistência, isolamento, durabilidade - atomicidade, coerência, isolamento, durabilidade).Problemas podem ser evitados com moldes e logs. Assim como você pode fazer backups de bancos de dados a partir de discos, os bancos de dados na memória podem ser copiados para o armazenamento. A criação de conversões impede que outros processos leiam dados; portanto, a frequência dos pontos de interrupção é um compromisso entre velocidade e confiabilidade. E isso, por sua vez, pode ser suavizado registrando transações ou registrando, gravando alterações de dados, para que um estado posterior possa ser recriado a partir de uma cópia anterior. Ainda assim, quando o banco de dados está completamente na memória, uma certa porcentagem de redundância é perdida.Os programas para gerenciar bancos de dados em memória (IMDBS) permitem criar sistemas híbridos nos quais algumas tabelas de banco de dados estão na memória e outras ficam em disco. Isso é melhor que o armazenamento em cache e é conveniente nos casos em que não faz sentido manter o banco de dados inteiro na memória.Os bancos de dados podem ser compactados, especialmente em sistemas com colunas que armazenam tabelas como conjuntos de colunas em vez de linhas. A maioria das tecnologias de compactação prefere que os dados vizinhos sejam do mesmo tipo, e as colunas nas tabelas quase sempre contêm dados do mesmo tipo. E embora a compactação envolva aumentar a carga na computação, o armazenamento de colunas é adequado para consultas complexas em conjuntos de dados muito grandes - é por isso que usuários e cientistas de big data estão interessados neles .Em larga escala, empresas como o Google mudaram para a RAM para que um grande número de consultas de pesquisa seja processado a uma velocidade aceitável. Também há problemas para fornecer acesso a grandes quantidades de memória, uma vez que a quantidade de RAM conectada a uma placa-mãe é limitada e a organização do acesso compartilhado gera atrasos adicionais.Vida após RAM

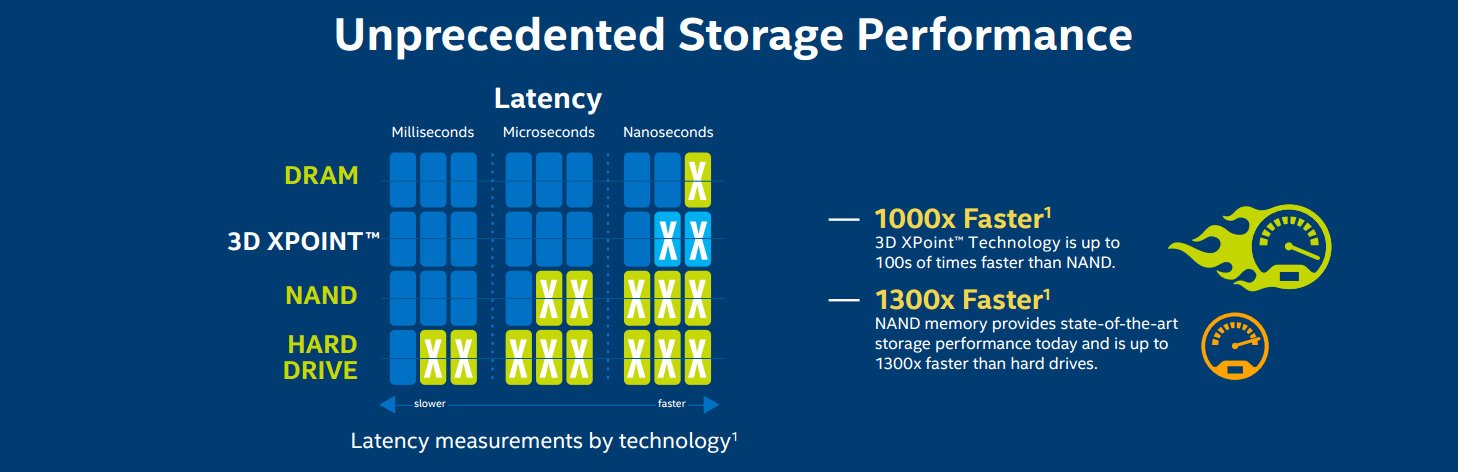

Mas você não pode garantir que trabalhar com dados na memória seja o futuro do processamento de dados. Um método alternativo é o uso de RAM não volátil (RAM não volátil, NVRAM), familiar aos usuários na forma de SSDs , oferecendo uma arquitetura compatível com os sistemas de disco. Agora eles rodam com memória flash NAND, que oferece altas velocidades de leitura e gravação em comparação com discos rígidos mecânicos. Mas ela tem seus próprios problemas. A memória flash requer tensões relativamente altas para registrar dados e degenera gradualmente, contra os quais algoritmos especiais são chamados a combater, levando a uma desaceleração gradual na operação. O custo da memória e armazenamento ao longo do tempo (dólares por megabyte)Como você pode ver no gráfico, com o tempo, o custo das unidades diminui aproximadamente o mesmo que o custo da RAM. O custo decrescente dos SSDs levou à sua distribuição em data centers e locais de trabalho, mas até agora não está claro qual é o futuro dessa tecnologia. Um estudo do Google publicado em fevereiro de 2016, com base em seis anos de uso, concluiu que a memória flash é muito menos confiável que os discos rígidos - por exemplo, produz erros fatais - embora exija substituições mais raras. E os SSDs para uso corporativo não diferem em qualidade das opções do consumidor.Mas novos tipos de NVRAM já estão aparecendo. A RAM ferroelétrica (FRAM) era uma vez substituída pela RAM e pelas unidades flash em dispositivos móveis, mas agora a atenção mudou para a RAM magnetoresistiva (MRAM). Em termos de velocidade, ele se aproxima da RAM e o atraso de acesso é de 50 nanossegundos - é mais lento que 10 ns na DRAM, mas 1000 vezes mais rápido que os microssegundos na NAND.

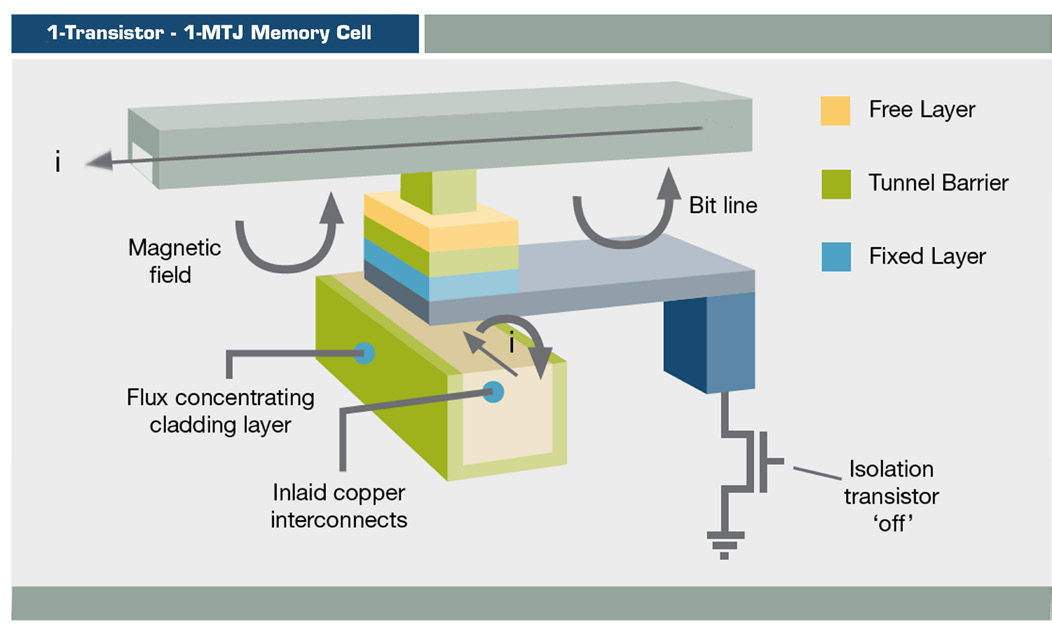

O custo da memória e armazenamento ao longo do tempo (dólares por megabyte)Como você pode ver no gráfico, com o tempo, o custo das unidades diminui aproximadamente o mesmo que o custo da RAM. O custo decrescente dos SSDs levou à sua distribuição em data centers e locais de trabalho, mas até agora não está claro qual é o futuro dessa tecnologia. Um estudo do Google publicado em fevereiro de 2016, com base em seis anos de uso, concluiu que a memória flash é muito menos confiável que os discos rígidos - por exemplo, produz erros fatais - embora exija substituições mais raras. E os SSDs para uso corporativo não diferem em qualidade das opções do consumidor.Mas novos tipos de NVRAM já estão aparecendo. A RAM ferroelétrica (FRAM) era uma vez substituída pela RAM e pelas unidades flash em dispositivos móveis, mas agora a atenção mudou para a RAM magnetoresistiva (MRAM). Em termos de velocidade, ele se aproxima da RAM e o atraso de acesso é de 50 nanossegundos - é mais lento que 10 ns na DRAM, mas 1000 vezes mais rápido que os microssegundos na NAND. Esquema MRAM O MRAMarmazena informações usando orientação magnética em vez de carga elétrica, usando uma estrutura de filme fino e uma junção de túnel magnético. A mudança de MRAM já é usada em produtos como os arrays de armazenamento EqualLogic da Dell, mas até agora apenas para registro no diário.O MRAM de transferência de rotação (ST-MRAM) usa uma estrutura mais complexa que potencialmente permite um aumento na densidade. Agora, a Everspin está lançando-a no mercado, lançada recentemente na NASDAQ com o código MRAM. Outras empresas que exploram essa oportunidade são Crocus, Micron, Qualcomm, Samsung, Spin Transfer Technologies (STT) e Toshiba.

Esquema MRAM O MRAMarmazena informações usando orientação magnética em vez de carga elétrica, usando uma estrutura de filme fino e uma junção de túnel magnético. A mudança de MRAM já é usada em produtos como os arrays de armazenamento EqualLogic da Dell, mas até agora apenas para registro no diário.O MRAM de transferência de rotação (ST-MRAM) usa uma estrutura mais complexa que potencialmente permite um aumento na densidade. Agora, a Everspin está lançando-a no mercado, lançada recentemente na NASDAQ com o código MRAM. Outras empresas que exploram essa oportunidade são Crocus, Micron, Qualcomm, Samsung, Spin Transfer Technologies (STT) e Toshiba. Memória XPoint 3D

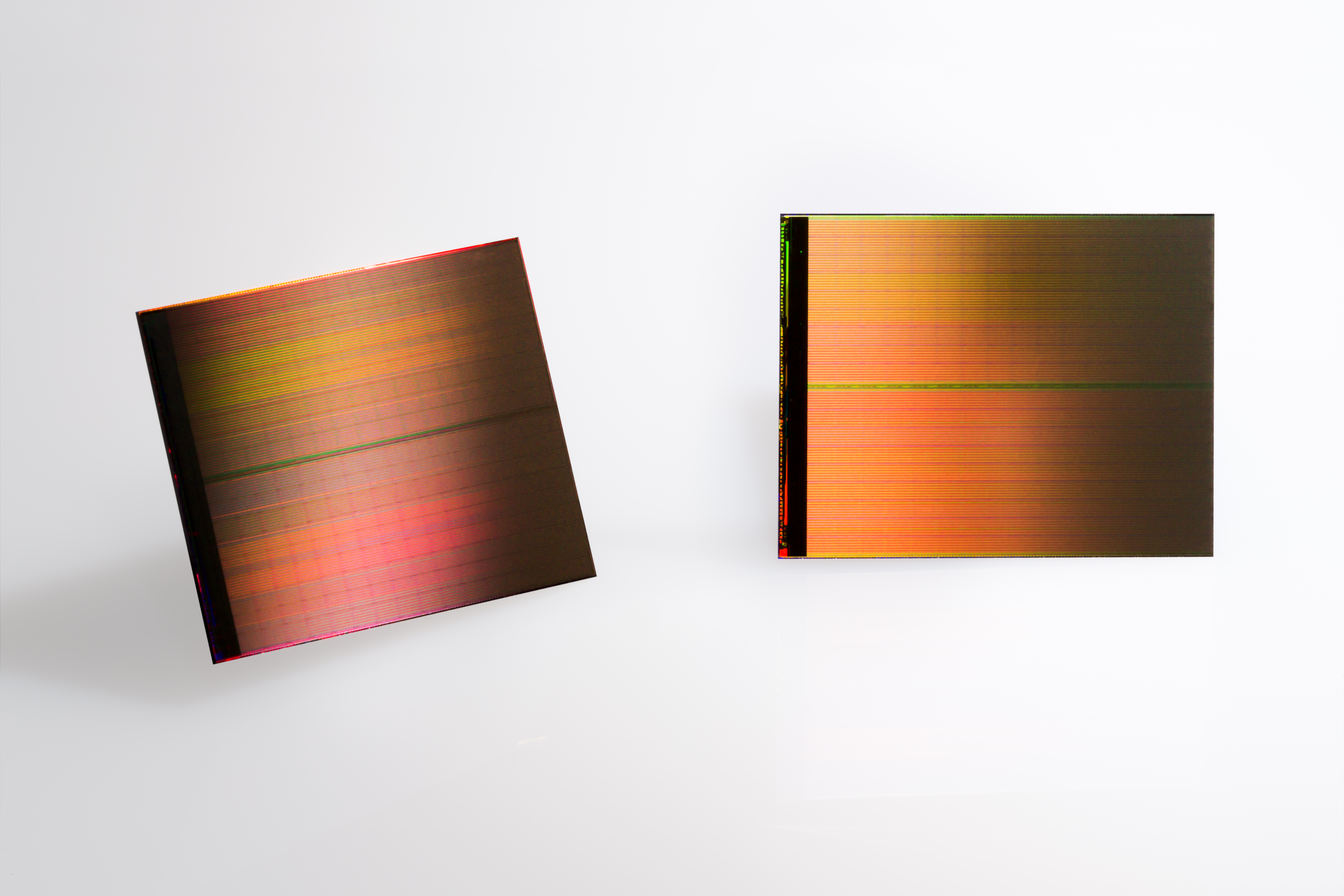

Memória XPoint 3D Dois chips XPoint 3D de 128GB

Dois chips XPoint 3D de 128GB Diagrama para Intel / Micron Comparação de velocidade 3D XPoint 3D

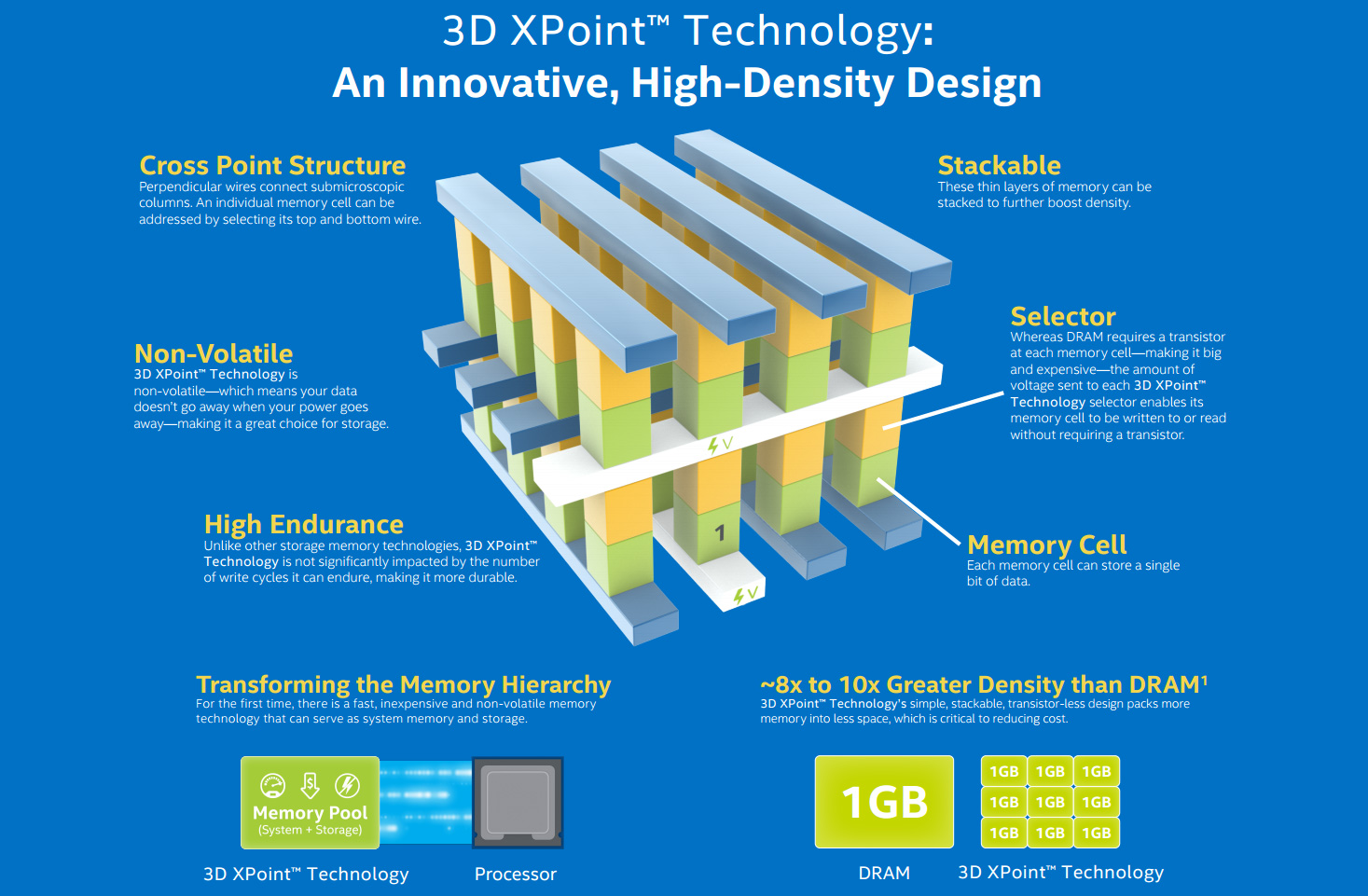

Diagrama para Intel / Micron Comparação de velocidade 3D XPoint 3D Enquanto isso, a Intel está trabalhando com a Micron em um tipo de NVRAM chamado 3D XPoint (pronunciado "ponto cruzado"). Esta forma de memória de mudança de fase (PCM), conhecida como RAM resistiva (ReRAM), foi tornada pública em 2015. "3D" significa a possibilidade de construção de várias camadas de memória. A Intel acredita que o XPoint pode executar 1.000 vezes mais rápido que o NAND e ter 10 vezes mais capacidade, embora recentemente essas alegações tenham diminuído levemente. O preço deve estar entre flash e DRAM. Por isso, é pouco provável que se enraíze nas residências, mas em larga escala pode substituir a RAM e o SSD.A IBM também trabalha com memória de mudança de fase. Como a Intel, sua tecnologia é baseada no vidro de calcogeneto usado em mídia ótica regravável. Usando a eletricidade para transformar o material de um estado amorfo em um dos três cristalinos, a empresa possui uma inovação em capacidades que permitirá reduzir o custo de memória que o DRAM.A corrida da RAM afetará todos os níveis de desenvolvimento do computador. Aumentar a memória de 8 para 16 GB em desktops de usuário final acelerará a multitarefa e aumentará a eficiência de programas que exigem memória.Nos ultrabooks, os SSDs já são a norma e as crescentes capacidades já os tornam candidatos à substituição de discos rígidos. A próxima geração de NAND tridimensional(V-NAND, vertical) promete maior eficiência e densidade de gravação. A Samsung prevê que até 2020 haverá SSDs de 512 GB para os usuários finais ao preço do parafuso de terabyte de hoje.Para empresas de médio porte e instituições acadêmicas, RAM mais barata significa melhor análise com os dados na memória - se o software acompanhar isso. O SAP HANA é um banco de dados em memória, uma plataforma para o amplo uso de soluções na nuvem e no local, que permite que empresas menores trabalhem com big data. IBM e Oracle têm bancos de dados semelhantes.A RAM democratiza a tecnologia - a tecnologia se torna mais barata e a diferença entre grandes e pequenas organizações é apagada.

Enquanto isso, a Intel está trabalhando com a Micron em um tipo de NVRAM chamado 3D XPoint (pronunciado "ponto cruzado"). Esta forma de memória de mudança de fase (PCM), conhecida como RAM resistiva (ReRAM), foi tornada pública em 2015. "3D" significa a possibilidade de construção de várias camadas de memória. A Intel acredita que o XPoint pode executar 1.000 vezes mais rápido que o NAND e ter 10 vezes mais capacidade, embora recentemente essas alegações tenham diminuído levemente. O preço deve estar entre flash e DRAM. Por isso, é pouco provável que se enraíze nas residências, mas em larga escala pode substituir a RAM e o SSD.A IBM também trabalha com memória de mudança de fase. Como a Intel, sua tecnologia é baseada no vidro de calcogeneto usado em mídia ótica regravável. Usando a eletricidade para transformar o material de um estado amorfo em um dos três cristalinos, a empresa possui uma inovação em capacidades que permitirá reduzir o custo de memória que o DRAM.A corrida da RAM afetará todos os níveis de desenvolvimento do computador. Aumentar a memória de 8 para 16 GB em desktops de usuário final acelerará a multitarefa e aumentará a eficiência de programas que exigem memória.Nos ultrabooks, os SSDs já são a norma e as crescentes capacidades já os tornam candidatos à substituição de discos rígidos. A próxima geração de NAND tridimensional(V-NAND, vertical) promete maior eficiência e densidade de gravação. A Samsung prevê que até 2020 haverá SSDs de 512 GB para os usuários finais ao preço do parafuso de terabyte de hoje.Para empresas de médio porte e instituições acadêmicas, RAM mais barata significa melhor análise com os dados na memória - se o software acompanhar isso. O SAP HANA é um banco de dados em memória, uma plataforma para o amplo uso de soluções na nuvem e no local, que permite que empresas menores trabalhem com big data. IBM e Oracle têm bancos de dados semelhantes.A RAM democratiza a tecnologia - a tecnologia se torna mais barata e a diferença entre grandes e pequenas organizações é apagada. Data Center do Google com servidores personalizados

Data Center do Google com servidores personalizados Sequoia Supercomputer

Sequoia Supercomputer

Supercomputador Sunway TaihuLight, o computador mais rápido do mundo, 93 petaflops

Supercomputador Sunway TaihuLight, o computador mais rápido do mundo, 93 petaflops Titan, o supercomputador mais rápido dos EUA

Titan, o supercomputador mais rápido dos EUA EcoPod HP data center Porúltimo, mas não menos importante , o ponto é a necessidade de memória para supercomputadores. O chinês Sunway TaihuLight SC mais rápido de hoje contém 1.300 TB de DDR3 DRAM, que é relativamente pequeno por sua velocidade de 93 petaflops (operações de quatrilhão de pontos flutuantes por segundo). Em particular, por isso, seu consumo de energia é de apenas 15,3 MW, mas isso pode se tornar um fator limitante.Agora todos estão se esforçando para obter o prefixo exaflops, ou 1000 petaflops. O computador japonês pós-K, desenvolvido por Riken e Fujitsu, estará pronto em 2020 e incluirá o Hybrid Memory Cube da Micron, uma implementação de DRAM em várias camadas e, possivelmente, também usará o 3D XPoint NVRAM. O projeto europeu NEXTGenIO no Edinburgh Supercomputer Centre pretende alcançar exaflops até 2022, também usando o 3D XPoint.Nos EUA, o Exascale Computing Project, desenvolvido como parte da iniciativa NSCI, deve apresentar dois supercomputadores de velocidade semelhante até 2023. Sua arquitetura ainda está sendo desenvolvida, mas como a velocidade e a eficiência energética são uma prioridade, a RAM terá um papel central nela.

EcoPod HP data center Porúltimo, mas não menos importante , o ponto é a necessidade de memória para supercomputadores. O chinês Sunway TaihuLight SC mais rápido de hoje contém 1.300 TB de DDR3 DRAM, que é relativamente pequeno por sua velocidade de 93 petaflops (operações de quatrilhão de pontos flutuantes por segundo). Em particular, por isso, seu consumo de energia é de apenas 15,3 MW, mas isso pode se tornar um fator limitante.Agora todos estão se esforçando para obter o prefixo exaflops, ou 1000 petaflops. O computador japonês pós-K, desenvolvido por Riken e Fujitsu, estará pronto em 2020 e incluirá o Hybrid Memory Cube da Micron, uma implementação de DRAM em várias camadas e, possivelmente, também usará o 3D XPoint NVRAM. O projeto europeu NEXTGenIO no Edinburgh Supercomputer Centre pretende alcançar exaflops até 2022, também usando o 3D XPoint.Nos EUA, o Exascale Computing Project, desenvolvido como parte da iniciativa NSCI, deve apresentar dois supercomputadores de velocidade semelhante até 2023. Sua arquitetura ainda está sendo desenvolvida, mas como a velocidade e a eficiência energética são uma prioridade, a RAM terá um papel central nela.Source: https://habr.com/ru/post/pt398373/

All Articles