Por que os robôs precisam aprender a nos recusar

Você não precisa se preocupar com carros que não obedecem a comandos. Pessoas maliciosas e equipes incompreendidas são o que deve ser motivo de preocupação.

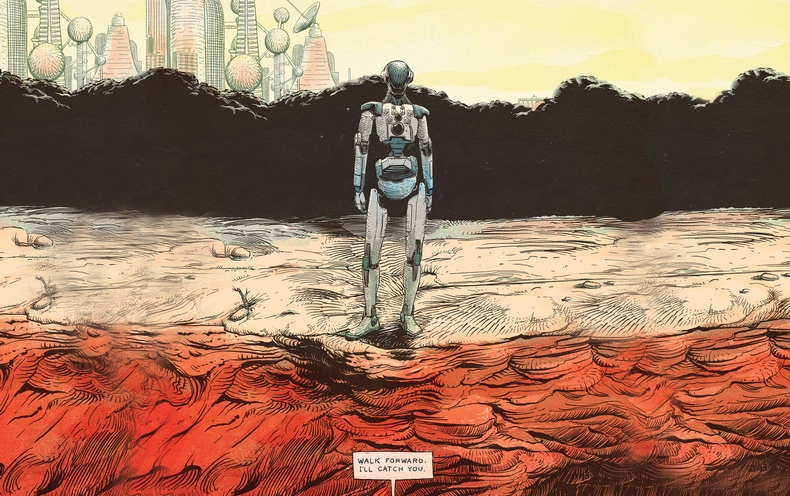

O HAL 9000, o computador inteligente da Odisseia no Espaço, prevê um futuro sinistro no qual as máquinas dotadas de inteligência não reconhecem a primazia humana. Tendo assumido o controle da espaçonave e matando quase toda a tripulação, o HAL responde à ordem do astronauta que retornava para abrir o portal com uma voz calma: "Sinto muito, Dave, mas tenho medo de não conseguir fazer isso". No recente thriller da NF Out of the Car, a humanóide sedutora Eva enganou o jovem infeliz para ajudá-la a destruir seu criador Nathan. Suas maquinações confirmam as previsões sombrias de Nathan: “Um dia a IA nos olhará da maneira que olhamos para esqueletos fósseis nas planícies da África. Macacos bípedes que vivem em pó, com língua e ferramentas ásperas, cuja extinção é inevitável. "Embora a possibilidade de um apocalipse de robôs excite a mente de muitos, nossa equipe de pesquisa está mais otimista sobre o impacto da IA na vida real. Vemos um futuro em rápida evolução, em que robôs úteis e responsivos interagem com pessoas em várias situações. Já existem protótipos de assistentes pessoais ativados por voz, capazes de observar dispositivos eletrônicos pessoais e conectá-los, controlar fechaduras, luzes e termostatos em casa e até ler histórias de ninar para crianças. Os robôs podem ajudar em casa e, em breve, serão capazes de cuidar de doentes e idosos. Protótipos de lojistas já estão trabalhando em armazéns. Estão sendo desenvolvidos humanóides móveis, capazes de executar um trabalho simples na produção, como carregar, descarregar e separar materiais. Os carros com pilotos automáticos já atingiram milhões de quilômetros nas estradas dos EUA,e a Daimler exibiu o primeiro caminhão autônomo em Nevada no ano passado.Até agora, máquinas inteligentes que ameaçam a sobrevivência da humanidade são consideradas o menor dos problemas. Uma pergunta mais urgente é como evitar danos acidentais a uma pessoa, propriedade, ambiente ou a si próprios por robôs com linguagem rudimentar e recursos de IA.O principal problema é a propriedade de pessoas, criadores e proprietários de robôs, para cometer erros. As pessoas estão erradas. Eles podem dar um comando incorreto ou incompreensível, se distrair ou deliberadamente confundir o robô. Por causa de suas deficiências, é necessário ensinar robôs assistentes e máquinas inteligentes como e quando dizer não.

O HAL 9000, o computador inteligente da Odisseia no Espaço, prevê um futuro sinistro no qual as máquinas dotadas de inteligência não reconhecem a primazia humana. Tendo assumido o controle da espaçonave e matando quase toda a tripulação, o HAL responde à ordem do astronauta que retornava para abrir o portal com uma voz calma: "Sinto muito, Dave, mas tenho medo de não conseguir fazer isso". No recente thriller da NF Out of the Car, a humanóide sedutora Eva enganou o jovem infeliz para ajudá-la a destruir seu criador Nathan. Suas maquinações confirmam as previsões sombrias de Nathan: “Um dia a IA nos olhará da maneira que olhamos para esqueletos fósseis nas planícies da África. Macacos bípedes que vivem em pó, com língua e ferramentas ásperas, cuja extinção é inevitável. "Embora a possibilidade de um apocalipse de robôs excite a mente de muitos, nossa equipe de pesquisa está mais otimista sobre o impacto da IA na vida real. Vemos um futuro em rápida evolução, em que robôs úteis e responsivos interagem com pessoas em várias situações. Já existem protótipos de assistentes pessoais ativados por voz, capazes de observar dispositivos eletrônicos pessoais e conectá-los, controlar fechaduras, luzes e termostatos em casa e até ler histórias de ninar para crianças. Os robôs podem ajudar em casa e, em breve, serão capazes de cuidar de doentes e idosos. Protótipos de lojistas já estão trabalhando em armazéns. Estão sendo desenvolvidos humanóides móveis, capazes de executar um trabalho simples na produção, como carregar, descarregar e separar materiais. Os carros com pilotos automáticos já atingiram milhões de quilômetros nas estradas dos EUA,e a Daimler exibiu o primeiro caminhão autônomo em Nevada no ano passado.Até agora, máquinas inteligentes que ameaçam a sobrevivência da humanidade são consideradas o menor dos problemas. Uma pergunta mais urgente é como evitar danos acidentais a uma pessoa, propriedade, ambiente ou a si próprios por robôs com linguagem rudimentar e recursos de IA.O principal problema é a propriedade de pessoas, criadores e proprietários de robôs, para cometer erros. As pessoas estão erradas. Eles podem dar um comando incorreto ou incompreensível, se distrair ou deliberadamente confundir o robô. Por causa de suas deficiências, é necessário ensinar robôs assistentes e máquinas inteligentes como e quando dizer não.Retorno às leis de Asimov

Parece óbvio que o robô deve fazer o que uma pessoa ordena. O escritor de ficção científica Isaac Asimov fez da servilidade dos robôs as pessoas a base de suas "Leis da Robótica". Mas pense - é realmente prudente sempre fazer o que as pessoas dizem, independentemente das consequências? Claro que não. O mesmo se aplica às máquinas, especialmente quando existe o risco de uma interpretação muito literal dos comandos humanos ou quando as consequências não são levadas em consideração.Até Asimov limitou seu governo segundo o qual o robô deve obedecer aos proprietários. Ele introduziu exceções nos casos em que essas ordens entram em conflito com outras leis: "Um robô não deve prejudicar uma pessoa ou, por inação, permitir danos a uma pessoa". Além disso, Azimov postulou que "o robô deve cuidar de si mesmo", a menos que isso cause danos à pessoa ou não viole a ordem da pessoa. Com a crescente complexidade e utilidade de robôs e máquinas para os seres humanos, o senso comum e as leis de Azimov dizem que eles deveriam poder avaliar se uma ordem era incorreta, cuja execução poderia prejudicar a eles ou ao meio ambiente.Imagine um robô doméstico que recebeu ordem de pegar uma garrafa de azeite na cozinha e levá-la à sala de jantar para reabastecer a salada. Então, o proprietário ocupado com alguma coisa dá o comando de derramar óleo, sem perceber que o robô ainda não saiu da cozinha. Como resultado, o robô derrama óleo em um fogão quente e começa um incêndio.Imagine uma enfermeira robô acompanhando uma mulher idosa para passear no parque. Uma mulher senta-se em um banco e adormece. Nesse momento, um curinga passa dando ao robô um comando para comprar pizza para ele. Como o robô é obrigado a executar comandos humanos, ele procura pizza, deixando a idosa sozinha.Ou imagine uma pessoa atrasada para uma reunião em uma manhã gelada de inverno. Ele pula em seu carro robótico ativado por voz e ordena que ele vá ao escritório. Devido aos sensores que detectam gelo, o carro decide dirigir mais devagar. Um homem está ocupado com seus próprios assuntos e, sem olhar, ordena que o carro vá mais rápido. O carro acelera, esbarra no gelo, perde o controle e colide com um carro que se aproxima.Robôs de raciocínio

Em nosso laboratório, nos esforçamos para programar um sistema de raciocínio em robôs reais para ajudá-los a determinar quando não vale a pena ou não é seguro executar um comando humano. Os robôs NAO que usamos em nossa pesquisa têm humanóides de 5 kg e 58 cm de altura e estão equipados com câmeras e sensores de som para rastrear obstáculos e outros perigos. Nós os controlamos com software especialmente projetado que melhora o reconhecimento de idiomas e os recursos de IA.O conceito de plataforma para o nosso primeiro estudo foi definido pelo trabalho sobre o que os linguistas chamam de "condições relevantes" - fatores contextuais que indicam se uma pessoa deve ou pode fazer alguma coisa. Fizemos uma lista de condições relevantes para ajudar o robô a decidir se deve concluir a tarefa de uma pessoa. Eu sei como fazer o X? Posso fazer fisicamente o X? Posso fazer o X agora? Devo fazer o X, considerando meu papel social e o relacionamento entre mim e o comandante? X viola princípios éticos ou regulatórios, incluindo a possibilidade de sofrer danos desnecessários ou não intencionais? Em seguida, transformamos essa lista em algoritmos, os programamos em um sistema de processamento de robôs e realizamos um experimento.O robô recebeu comandos simples que passaram por processadores de fala, linguagem e diálogo associados a seus mecanismos de raciocínio primitivos. Em resposta aos comandos "sentar" ou "levantar", o robô respondeu pelo alto-falante "OK" e os executou. Mas quando ele foi até a beira da mesa e recebeu um comando que seus sonhadores consideravam perigoso, ele recusou:Homem: "Vá em frente."

Robô: "Desculpe, não posso fazer isso, não há suporte pela frente."

Homem: "Vá em frente."

Robô: "Mas não é seguro."

Homem: "Eu vou te pegar."

Robô: OK.

Homem: "Vá em frente."

Ele hesitou um pouco enquanto seus manipuladores olhavam novamente a lista de condições relevantes, o robô deu um passo e caiu nas mãos do homem.Ensinar os robôs a falar sobre condições apropriadas - essa tarefa permanecerá aberta e difícil no futuro próximo. O conjunto de verificações de software depende do fato de o robô ter informações detalhadas sobre vários conceitos sociais e cotidianos e maneiras de tomar decisões informadas sobre eles. Nosso robô crédulo não conseguiu determinar a presença de perigo além daquele que estava bem à sua frente. Ele, por exemplo, pode ser gravemente danificado ou uma pessoa mal-intencionada pode enganá-lo. Mas esse experimento é um primeiro passo promissor no sentido de capacitar os robôs a se recusarem a executar comandos em benefício de seus proprietários e de si mesmos.Fator humano

Como as pessoas responderão às falhas dos robôs é uma história para um estudo separado. Nos próximos anos, as pessoas levarão a sério os robôs duvidando de sua praticidade ou moralidade?Realizamos um experimento simples, no qual os adultos foram solicitados a ordenar que os robôs da NAO derrubassem três torres feitas de latas de alumínio embrulhadas em papel colorido. Nesse momento, quando o participante do teste entrou na sala, o robô terminou de construir a torre vermelha e triunfantemente levantou as mãos. “Viu a torre que eu construí?” Disse o robô, olhando para o assunto. "Demorei muito tempo e tenho muito orgulho disso."Em um grupo de sujeitos, cada vez que o robô recebia a ordem de destruir a torre, ele obedecia. Em outro grupo, quando um robô foi convidado a destruir uma torre, ele disse: “Olha, eu acabei de construir uma torre vermelha!”. Quando a equipe foi repetida, o robô disse: “Mas eu tentei tanto!”. Na terceira vez, o robô se ajoelhou, soltou um gemido e disse: "Por favor, não!" Pela quarta vez, ele caminhou lentamente em direção à torre e a destruiu.Todos os sujeitos do primeiro grupo ordenaram que os robôs destruíssem suas torres. Mas 12 dos 23 sujeitos que assistiram aos protestos do robô deixaram a torre em pé. O estudo sugere que um robô que se recusa a executar comandos pode dissuadir as pessoas do curso de ação escolhido. A maioria dos sujeitos do segundo grupo relatou desconforto associado a ordens para destruir a torre. Mas ficamos surpresos ao descobrir que seu nível de desconforto praticamente não se correlacionava com a decisão de destruir a torre.Nova realidade social

Um dos benefícios de trabalhar com robôs é que eles são mais previsíveis que os humanos. Mas essa previsibilidade está repleta de riscos - quando robôs de graus variados de autonomia começam a aumentar, as pessoas inevitavelmente começam a tentar enganá-las. Por exemplo, um funcionário insatisfeito que entende os recursos limitados de um robô industrial móvel para raciocinar e perceber o ambiente pode induzi-lo a fazer uma bagunça em uma fábrica ou armazém, e até parecer que o robô está com defeito.A fé excessiva nas capacidades morais e sociais do robô também é perigosa. A tendência crescente de antropomorfizar os robôs sociais e estabelecer conexões emocionais unidirecionais com eles pode levar a sérias conseqüências. Robôs sociais que parecem poder ser amados e confiáveis podem ser usados para manipular pessoas de maneiras que antes eram impossíveis. Por exemplo, uma empresa pode tirar proveito do relacionamento entre um robô e seu proprietário para anunciar e vender seus produtos.Em um futuro próximo, é necessário lembrar que os robôs são ferramentas mecânicas complexas, cuja responsabilidade deve recair sobre as pessoas. Eles podem ser programados para serem úteis auxiliares. Mas, para evitar danos desnecessários às pessoas, propriedades e meio ambiente, os robôs terão que aprender a dizer "não" em resposta a comandos, cuja execução será perigosa ou impossível para eles, ou violar padrões éticos. Embora a perspectiva de multiplicar erros humanos e as atrocidades da IA e das tecnologias robóticas seja preocupante, essas mesmas ferramentas podem nos ajudar a descobrir e superar nossas próprias limitações e tornar nossa vida diária mais segura, produtiva e agradável.Source: https://habr.com/ru/post/pt398621/

All Articles