Estudos mostram que modelos de computador, conhecidos como redes neurais usadas em um número crescente de aplicações, podem aprender a reconhecer seqüências de dados usando os mesmos algoritmos que o cérebro humano.

O cérebro resolve seu problema canônico - treinamento - ajustando muitos de seus compostos de acordo com um conjunto desconhecido de regras. Para revelar essas regras, os cientistas começaram a desenvolver modelos de computador 30 anos atrás, tentando reproduzir o processo de aprendizado. Hoje, em um número crescente de experiências, fica claro que esses modelos se comportam de maneira muito semelhante ao cérebro real em determinadas tarefas. Os pesquisadores dizem que essa semelhança sugere um ajuste básico entre os algoritmos de aprendizado do cérebro e do computador.

O algoritmo usado pelo modelo de computador é chamado de

máquina de Boltzmann . Foi

inventado por Jeffrey Hinton e Terry Seinowski em 1983 [de fato, em

1985 - aprox. transl.]. Parece muito promissor como uma simples explicação teórica de vários processos que ocorrem no cérebro - desenvolvimento, formação de memória, reconhecimento de objetos e sons, ciclos de sono e vigília.

"Esta é a melhor oportunidade que temos hoje para entender o cérebro", diz Sue Becker, professora de psicologia, neurobiologia e comportamento da Universidade. McMaster em Hamilton, Ontário. "Não conheço um modelo que descreva uma gama mais ampla de fenômenos relacionados ao aprendizado e à estrutura cerebral".

Hinton, pioneiro no campo da IA, sempre quis entender as regras pelas quais o cérebro aprimora a comunicação ou a enfraquece - ou seja, o algoritmo de aprendizado. "Decidi que, para entender algo, ele precisa ser construído", diz ele. Seguindo a abordagem reducionista dos físicos, ele planeja criar modelos simples de computador do cérebro usando diferentes algoritmos de aprendizado e ver "quais funcionarão", diz Hinton, professor em parte de ciência da computação na Universidade de Toronto e em parte no Google.

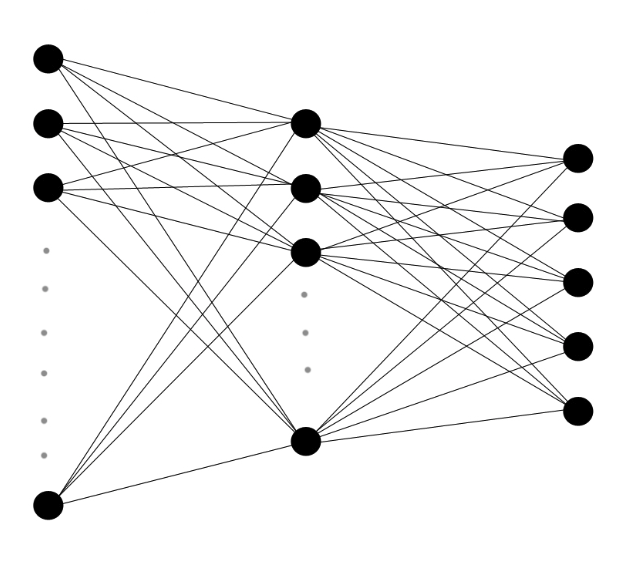

As redes neurais multicamadas consistem em camadas de neurônios artificiais com conexões ponderadas entre elas. Envio aos dados recebidos uma cascata de sinais em camadas, e o algoritmo determina a alteração nos pesos de cada conexão.

As redes neurais multicamadas consistem em camadas de neurônios artificiais com conexões ponderadas entre elas. Envio aos dados recebidos uma cascata de sinais em camadas, e o algoritmo determina a alteração nos pesos de cada conexão.Nas décadas de 1980 e 1990, Hinton, bisneto da lógica do século XIX, George Boole, cujo trabalho formou a base da ciência da computação moderna, inventou vários algoritmos de aprendizado de máquina. Algoritmos que controlam como um computador aprende com dados são usados em modelos de computador chamados "redes neurais artificiais" - redes de neurônios virtuais interconectados que transmitem sinais para seus vizinhos, ativando ou desativando, ou "ativando". Quando os dados são alimentados na rede, isso leva a uma cascata de respostas, e o algoritmo, com base na imagem dessas respostas, escolhe aumentar ou diminuir o peso das conexões ou sinapses entre cada par de neurônios.

Durante décadas, muitos modelos de computadores da Hinton estão vegetando. Mas, graças aos avanços na potência do processador, ao progresso no entendimento do cérebro e dos algoritmos, as redes neurais estão desempenhando um papel cada vez maior na neurobiologia. Sejnowski [Sejnowski], chefe do Laboratório de Informática de Neurobiologia do Instituto de Pesquisa Biológica. Salka, em La Jolla, Califórnia, diz: “Trinta anos atrás, tínhamos idéias muito rudes; agora estamos começando a testar alguns deles. "

Máquinas cerebrais

As primeiras tentativas de Hinton de reproduzir o cérebro eram limitadas. Os computadores podem executar seus algoritmos de aprendizado em pequenas redes neurais, mas os modelos de dimensionamento sobrecarregam muito rapidamente os processadores. Em 2005, Hinton descobriu que, se você dividir as redes neurais em camadas e executar os algoritmos separadamente em cada camada, repetindo aproximadamente a estrutura e o desenvolvimento do cérebro, o processo se tornará mais eficiente.

Embora Hinton tenha publicado sua descoberta em

duas revistas conhecidas , as redes neurais estavam fora de moda na época e ele "lutava para atrair as pessoas", disse Lee Deng, pesquisador principal da Microsoft Research. No entanto, Deng conhecia Hinton e decidiu testar seu método de "aprendizado profundo" em 2009, reconhecendo rapidamente seu potencial. Nos anos seguintes, os algoritmos de aprendizado são usados na prática em um número crescente de aplicativos, como o assistente pessoal do Google Now ou o recurso de pesquisa por voz nos telefones Microsoft Windows.

Um dos algoritmos mais promissores, a máquina de Boltzmann, recebeu o nome do físico austríaco do século 19 Ludwig Boltzmann, que desenvolveu um ramo da física que lida com um grande número de partículas, conhecido como mecânica estatística. Boltzmann descobriu uma equação que fornece a probabilidade de um gás molecular ter uma certa energia quando atinge o equilíbrio. Se você substituir as moléculas por neurônios, o resultado tenderá para a mesma equação.

As sinapses de rede começam com uma distribuição aleatória de pesos, e os pesos são gradualmente ajustados de acordo com um procedimento bastante simples: o circuito de resposta gerado no processo de recebimento de dados (como imagens ou sons) pela máquina é comparado com o circuito de resposta aleatória da máquina que ocorre quando os dados não são inseridos.

Joffrey Hinton acredita que a melhor abordagem para entender os processos de aprendizado no cérebro é construir computadores que aprendam da mesma maneira.

Joffrey Hinton acredita que a melhor abordagem para entender os processos de aprendizado no cérebro é construir computadores que aprendam da mesma maneira.Cada sinapse virtual rastreia os dois conjuntos estatísticos. Se os neurônios conectados a ele são mais frequentemente acionados em uma seqüência próxima ao receber dados do que durante uma operação aleatória, o peso da sinapse aumenta em um valor proporcional à diferença. Mas se dois neurônios são mais frequentemente desencadeados juntos durante operação aleatória, a sinapse que os liga é considerada muito forte e enfraquecida.

A versão mais comumente usada da máquina Boltzmann funciona melhor após o "treinamento", tendo processado milhares de dados de amostra sequencialmente em cada camada. Primeiro, a camada inferior da rede recebe dados brutos na forma de imagens ou sons e, à maneira das células da retina, os neurônios são acionados se detectarem contrastes em sua área de dados, como mudar da claro para a escura. Seu desencadeamento pode desencadear o desencadeamento de neurônios associados a eles, dependendo do peso da sinapse que os conecta. Como o disparo de pares de neurônios virtuais é constantemente comparado com estatísticas de fundo, conexões significativas entre neurônios aparecem e se intensificam gradualmente. Pesos de sinapses são especificados e categorias de sons e imagens são incorporadas às conexões. Cada camada subseqüente é treinada de maneira semelhante, usando dados da camada abaixo dela.

Se você alimentar uma imagem de um carro para uma rede neural treinada para detectar certos objetos nas imagens, a camada inferior funcionará se detectar um contraste que indica uma face ou um ponto final. Esses sinais irão para neurônios de nível superior que determinam ângulos, partes das rodas, etc. No nível superior, os neurônios são acionados apenas reagindo à imagem do carro.

"A mágica do que está acontecendo na web é que ela pode resumir", diz Yann LeCun, diretor do Data Science Center da Universidade de Nova York. "Se você mostrar a ela um carro que ela nunca viu antes, e se o carro tiver algumas formas e recursos comuns às máquinas mostradas a ela durante o treinamento, ela poderá determinar que se trata de um carro".

As redes neurais aceleraram recentemente seu desenvolvimento graças ao modo multicamada Hinton, ao uso de chips de computador de alta velocidade para processamento de gráficos e ao crescimento explosivo no número de imagens e gravações de voz disponíveis para treinamento. As redes são capazes de reconhecer corretamente 88% das palavras no idioma falado em inglês, enquanto a pessoa média reconhece 96%. Eles podem detectar carros e milhares de outros objetos em imagens com precisão semelhante e, nos últimos anos, assumiram uma posição dominante nas competições de aprendizado de máquina.

Construindo um cérebro

Ninguém sabe como descobrir diretamente as regras pelas quais o cérebro é treinado, mas há muitas coincidências indiretas entre o comportamento do cérebro e a máquina de Boltzmann.

Ambos são treinados sem supervisão, usando apenas padrões existentes nos dados. "Sua mãe não conta um milhão de vezes sobre o que é mostrado na figura", diz Hinton. - Você precisa aprender a reconhecer as coisas sem o conselho de outras pessoas. Depois de estudar as categorias, eles informam os nomes dessas categorias. Então, as crianças aprendem sobre cães e gatos e depois aprendem que os cães são chamados de "cães" e os gatos são chamados de "gatos".

O cérebro adulto não é tão flexível quanto o jovem, assim como a máquina de Boltzmann, tendo treinado para 100.000 imagens de carros, não mudará muito depois de ver outra. Suas sinapses já têm os pesos certos para categorizar carros. Mas o treinamento não termina. Novas informações podem ser integradas na estrutura das máquinas cerebrais e Boltzmann.

Nas últimas duas décadas, um estudo da atividade cerebral em um sonho forneceu a primeira evidência de que o cérebro usa um algoritmo semelhante ao algoritmo de Boltzmann para incorporar novas informações e memórias em sua estrutura. Os neurocientistas sabem há muito tempo que o sono desempenha um papel importante na consolidação da memória e ajuda a integrar novas informações. Em 1995, Hinton e colegas

sugeriram que o sono desempenha o papel de um nível básico no algoritmo, denotando a atividade dos neurônios na ausência de dados de entrada.

"Durante o sono, você apenas descobre a frequência básica dos neurônios", diz Hinton. - Você descobre a correlação do trabalho deles no caso em que o sistema trabalha por conta própria. E então, se os neurônios se correlacionarem mais, apenas aumente os pesos entre eles. E se menos, reduza o peso. "

No nível da sinapse, "esse algoritmo pode ser fornecido de várias maneiras", diz Sezhnowski, consultor da administração presidencial como parte da

iniciativa BRAIN , um estudo com uma doação de US $ 100 milhões projetada para desenvolver novas técnicas de pesquisa cerebral.

Ele diz que é mais fácil para o cérebro trabalhar com o algoritmo de Boltzmann, passando de criar sinapses durante o dia para diminuí-las à noite.

Giulio Tononi , chefe do Centro de Estudos do Sono e Consciência da Universidade de Wisconsin-Madison, descobriu que a expressão gênica nas sinapses as altera de acordo com esta hipótese: genes envolvidos no crescimento de sinapses são mais ativos durante o dia e genes envolvidos na contração sinapses - à noite.

Em outra opção, "a linha de base pode ser calculada em um sonho e, em seguida, alterações em relação a ela podem ser feitas durante o dia", diz Sezhnowski. Em seu laboratório, modelos detalhados de sinapses e as redes que eles suportam são construídos para determinar como eles coletam estatísticas sobre padrões de vigília e sono e quando a força das sinapses muda para mostrar essa diferença.

Dificuldades com o cérebro

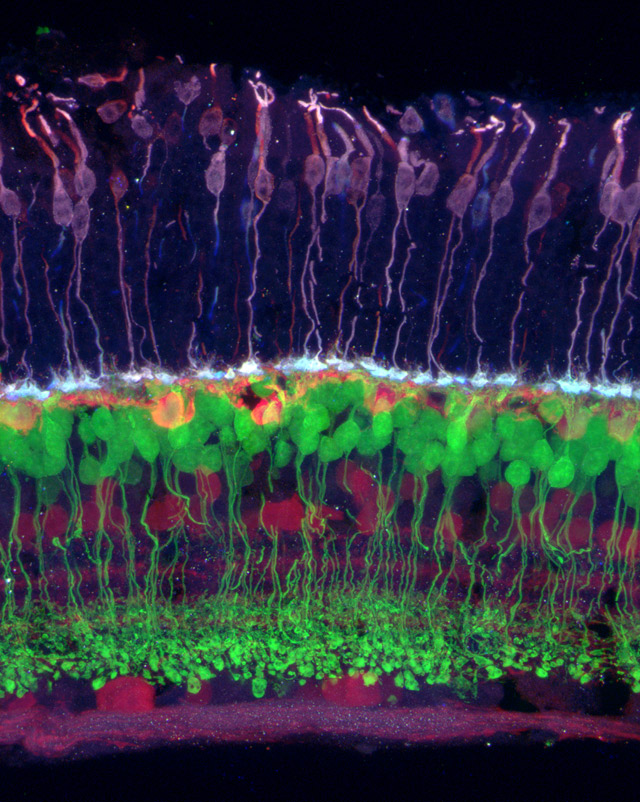

Imagem da retina na qual diferentes tipos de células são indicados por cores diferentes. Sensível à cor (violeta) conecta-se à horizontal (laranja), que se conecta à bipolar (verde) e outras - às células da retina e gânglio (púrpura).

Imagem da retina na qual diferentes tipos de células são indicados por cores diferentes. Sensível à cor (violeta) conecta-se à horizontal (laranja), que se conecta à bipolar (verde) e outras - às células da retina e gânglio (púrpura).O algoritmo de Boltzmann pode ser um dos muitos usados pelo cérebro para ajustar as sinapses. Nos anos 90, vários grupos independentes desenvolveram um modelo teórico de como o sistema visual codifica eficientemente o fluxo de informações que entra na retina. A teoria postulou que nas camadas inferiores do córtex visual existe um processo de "codificação dispersa", semelhante à compressão da imagem, como resultado do qual os estágios finais do sistema visual funcionam com mais eficiência.

As previsões do modelo passam gradualmente por testes cada vez mais rigorosos. Em um

artigo publicado na PLOS Computational Biology, neurocientistas computacionais da Grã-Bretanha e Austrália descobriram que quando as redes neurais que usam o algoritmo de codificação dispersa Products of Experts, inventado por Hinton, inventado por Hinton em 2002 processam os mesmos dados visuais incomuns que os gatos vivos recebem (por exemplo, gatos e redes neurais estudam imagens listradas), seus neurônios produzem conexões incomuns quase idênticas.

"Quando a informação chega ao córtex visual, pensamos que o cérebro a apresenta como um código disperso", disse Bruno Olshausen, neurocientista computacional e diretor do Centro Redwood de Neurobiologia Teórica da Universidade da Califórnia-Berkeley, que ajudou a desenvolver teoria de codificação dispersa. "Como se uma máquina Boltzmann estivesse na sua cabeça e tentando entender as conexões que existem entre os elementos do código disperso".

Olshausen e a equipe usaram modelos de redes neurais das camadas mais altas do córtex visual para mostrar como o cérebro é capaz de

manter uma percepção estável das informações visuais, apesar do movimento das imagens. Em outro

estudo, eles descobriram que a atividade dos neurônios no córtex visual de gatos assistindo a um filme em preto e branco é muito bem descrita pela máquina de Boltzmann.

Uma das possíveis aplicações deste trabalho é a criação de próteses neuro, por exemplo, uma retina artificial. Se você observar como "a informação é formatada no cérebro, você pode entender como estimular o cérebro a fazê-lo pensar que está vendo uma imagem", diz Olshausen.

Sezhnowski diz que a compreensão dos algoritmos de crescimento e redução de sinapses permitirá que os pesquisadores os alterem e aprendam como o funcionamento da rede neural é interrompido. "Então eles podem ser comparados com os problemas conhecidos das pessoas", diz ele. - Quase todos os transtornos mentais podem ser explicados por problemas com sinapses. Se pudermos entender melhor as sinapses, podemos entender como o cérebro funciona normalmente, como processa informações, como aprende e o que dá errado se, por exemplo, você desenvolver esquizofrenia. ”

A abordagem para estudar o cérebro usando redes neurais contrasta fortemente com a abordagem do

Projeto Cérebro Humano . Este é o plano divulgado pelo neurocientista suíço Henry Marcram para criar uma simulação precisa do cérebro humano usando um supercomputador. Diferentemente da abordagem de Hinton, que começa com um modelo bastante simplificado e segue o caminho da complicação gradual, Markram quer incluir imediatamente a maior quantidade possível de dados, até moléculas individuais, e espera que, como resultado, ele tenha total funcionalidade e consciência.

O projeto recebeu financiamento de US $ 1,3 bilhão da Comissão Europeia, mas Hinton acredita que essa mega-simulação falhará, ficando presa em muitas partes móveis que ninguém entende ainda.

Além disso, Hinton não acredita que o cérebro possa ser entendido apenas por suas imagens. Esses dados devem ser usados para criar e refinar algoritmos. "O pensamento teórico e a pesquisa no espaço dos algoritmos de aprendizado são necessários para criar uma teoria como" a máquina de Boltzmann, ele diz. O próximo passo para Hinton é o desenvolvimento de algoritmos para treinar ainda mais redes neurais semelhantes ao cérebro, nas quais as sinapses conectam neurônios dentro de uma camada, e não apenas entre camadas diferentes. "O objetivo principal é entender os benefícios que podem ser obtidos complicando os cálculos em cada estágio", diz ele.

A hipótese é que mais conexões levarão a laços nas costas mais fortes, os quais, segundo Olshausen, provavelmente ajudarão o cérebro a "preencher os detalhes ausentes". As camadas superiores interferem com o trabalho dos neurônios das camadas inferiores que lidam com informações parciais. "Tudo isso está intimamente relacionado à consciência", diz ele.

O cérebro humano ainda é muito mais complexo do que qualquer modelo. É maior, mais denso, mais eficiente, possui mais interconexões e neurônios complexos - e trabalha simultaneamente com vários algoritmos. Olshausen sugere que entendamos cerca de 15% da atividade do córtex visual. Embora os modelos estejam avançando, a neurociência ainda é "semelhante à física antes de Newton", diz ele. No entanto, ele está confiante de que o processo de trabalhar com base nesses algoritmos poderá algum dia explicar o enigma principal do cérebro - como os dados dos órgãos sensoriais são transformados em um senso subjetivo da realidade. A consciência, diz Olshausen, "é algo que emerge da realidade, uma máquina Boltzmann muito complexa".